RunPod: servicio en la nube de GPU diseñado para IA con SD de arranque en frío rápido y pago por segundo

Últimos recursos sobre IAPublicado hace 1 año Círculo de intercambio de inteligencia artificial 54.6K 00

Introducción general

RunPod es una plataforma de computación en la nube diseñada específicamente para la IA, con el objetivo de proporcionar a desarrolladores, investigadores y empresas una solución integral para el desarrollo, entrenamiento y escalado de modelos de IA. La plataforma integra recursos de GPU bajo demanda, razonamiento sin servidor, escalado automático y mucho más para proporcionar un potente soporte en todas las fases de los proyectos de IA.La filosofía central de RunPod es simplificar el proceso de desarrollo de IA, permitiendo a los usuarios centrarse en la innovación de modelos sin tener que preocuparse demasiado por cuestiones de infraestructura.

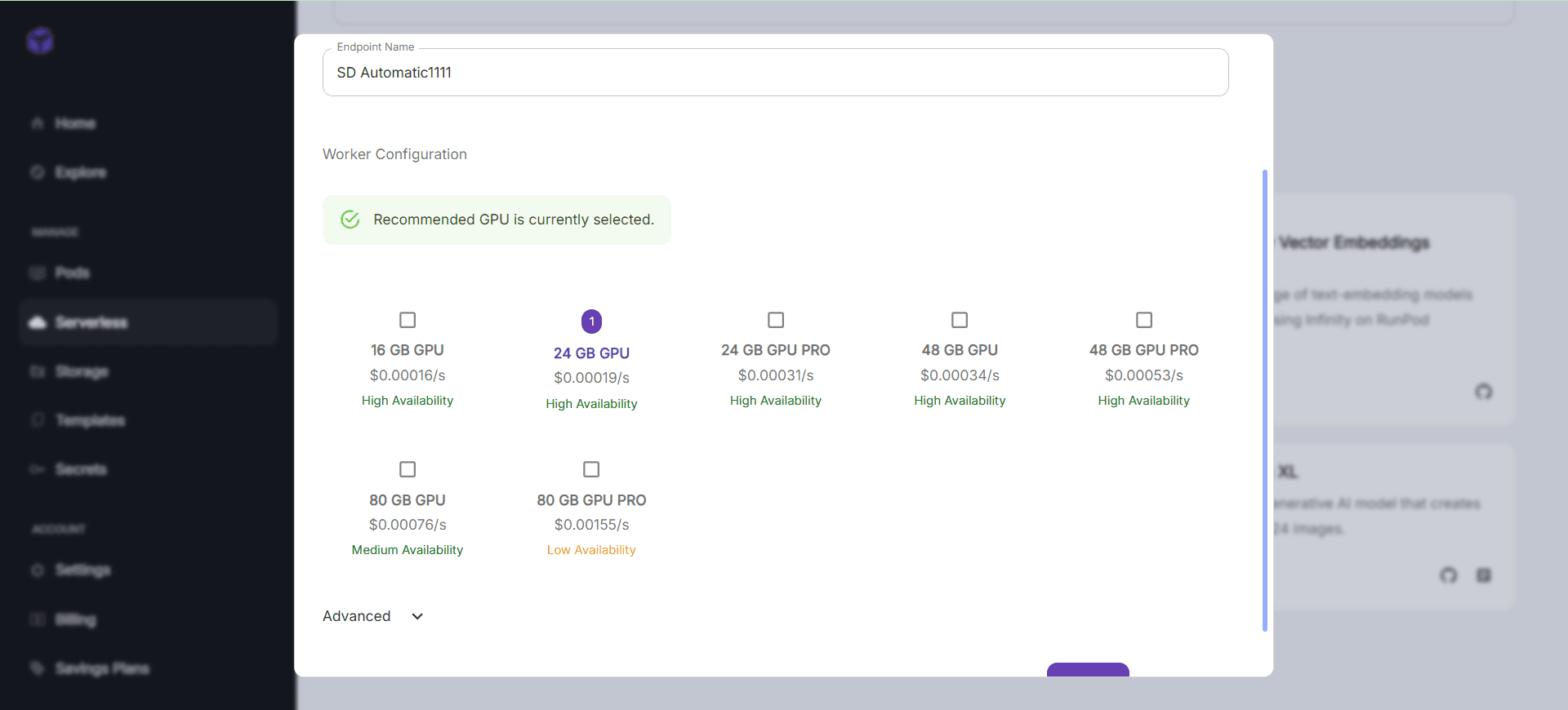

Pague sólo en el momento de la solicitud y arranque en frío rápido, adecuado para servicios de baja frecuencia y requiere un funcionamiento de alta calidad. Mientras tanto, la clase de procesamiento del lenguaje natural de grandes modelos lingüísticos admite el pago por tokens.

Lista de funciones

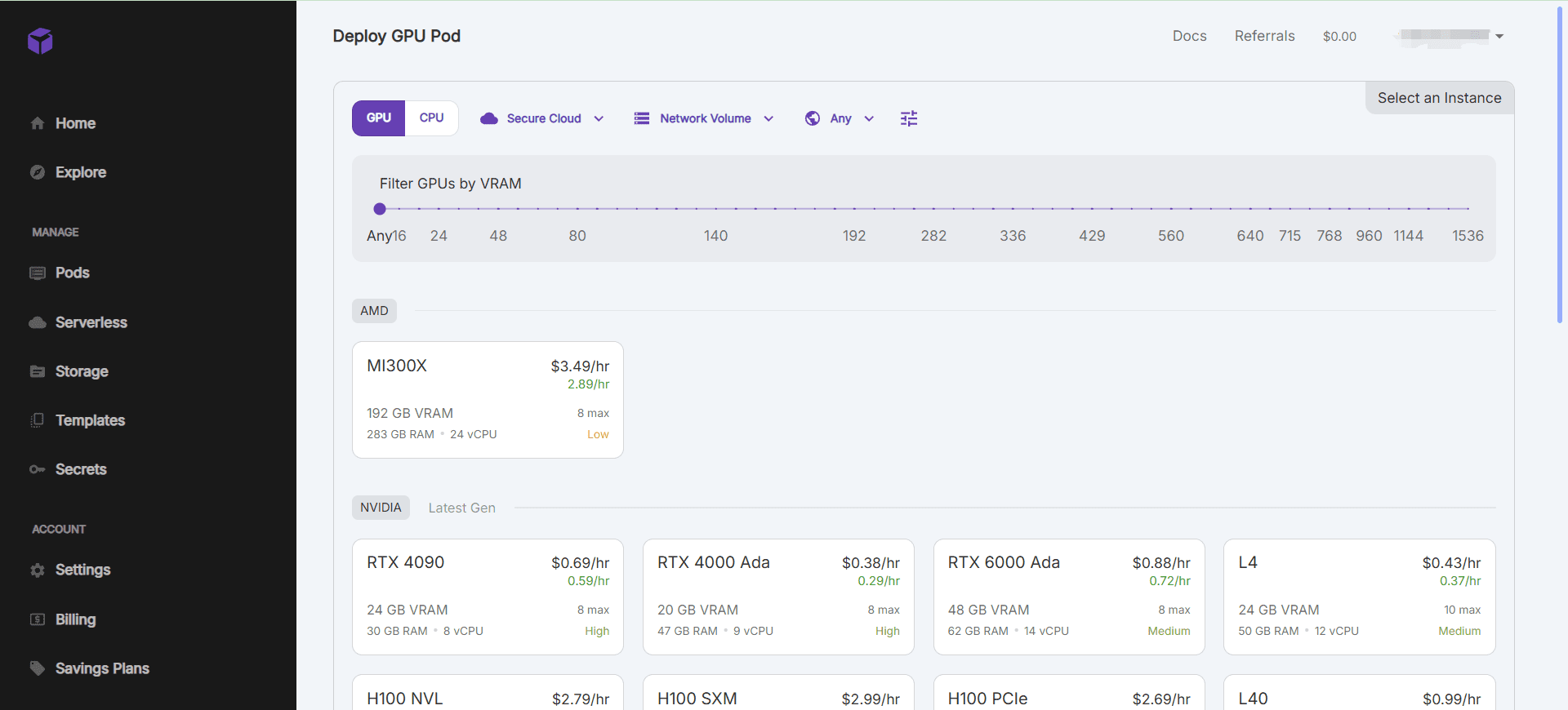

- Recursos de GPU a la cartaPuesta en marcha rápida de instancias de GPU y compatibilidad con varios modelos de GPU para satisfacer distintos requisitos aritméticos.

- Razonamiento sin servidorEscala automáticamente las capacidades de razonamiento para gestionar eficazmente las cargas de trabajo cambiantes.

- Integración del entorno de desarrolloEntorno de desarrollo de IA preconfigurado compatible con las herramientas y marcos de aprendizaje profundo más utilizados.

- Gestión y almacenamiento de datos: Solución integrada de almacenamiento de datos con mecanismos eficaces de transferencia y acceso a los datos.

- Colaboración y control de versionesFunciones de desarrollo en equipo : Admite el desarrollo en equipo y ofrece funciones de versionado de modelos.

Utilizar la ayuda

Instalación y uso

- Creación de una instancia de GPU::

- Una vez conectado, vaya a la página de la consola y haga clic en "Crear Pod".

- Seleccione el modelo de GPU y la configuración deseados y haga clic en "Crear" para iniciar la instancia.

- Una vez iniciada la instancia, puede operarse a través de SSH o de una conexión de terminal web.

- Utilización de entornos preconfigurados::

- RunPod ofrece una amplia gama de entornos de desarrollo de IA preconfigurados, como PyTorch, TensorFlow, etc.

- Al crear una instancia, puede seleccionar la plantilla de entorno deseada e iniciar rápidamente el desarrollo del proyecto.

- gestión de datos::

- RunPod ofrece una solución integrada de almacenamiento de datos para gestionar conjuntos de datos en la consola.

- Permite cargar, descargar y compartir datos para garantizar la seguridad y la protección de la privacidad.

- Colaboración y control de versiones::

- Apoya el desarrollo de equipos de colaboración, los miembros del equipo pueden ser invitados a trabajar juntos en proyectos.

- Ofrece la función de gestión de versiones de modelos, que facilita el seguimiento y la gestión de las distintas versiones de los modelos.

- Razonamiento sin servidor::

- RunPod es compatible con la arquitectura sin servidor y escala automáticamente las capacidades de inferencia.

- Los puntos finales de la API pueden configurarse en la consola para habilitar los servicios de inferencia en línea para los modelos.

flujo de trabajo

- Ejemplo de GPU de inicio rápido::

- Acceda a la consola y seleccione "Crear Pod".

- Seleccione el modelo de GPU y la configuración deseados y haga clic en "Crear".

- Una vez iniciada la instancia, se opera a través de SSH o una conexión de terminal web.

- Utilización de entornos preconfigurados::

- Al crear una instancia, seleccione la plantilla de entorno deseada.

- Tras conectar la instancia, puede utilizar directamente el entorno de desarrollo preconfigurado para desarrollar proyectos.

- gestión de datos::

- Gestione conjuntos de datos en la consola para cargar, descargar y compartir datos.

- Garantizar la seguridad de los datos y la protección de la privacidad.

- Colaboración y control de versiones::

- Invite a los miembros del equipo a trabajar juntos en proyectos y utilice las funciones de control de versiones para realizar un seguimiento y gestionar las versiones de los modelos.

- Razonamiento sin servidor::

- Configure los puntos finales de la API en la consola para habilitar los servicios de inferencia en línea para los modelos.

- Amplíe automáticamente las capacidades de inferencia para gestionar eficazmente las cargas de trabajo cambiantes.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...