RAG: Aumento de la recuperación

Base de conocimientos de IAPublicado hace 2 años Círculo de intercambio de inteligencia artificial 62.1K 00

RAG (Retrieve Augmented Generation) es una técnica de optimización de los resultados de los modelos lingüísticos extensos (LLM) basada en información procedente de bases de conocimiento autorizadas. Esta técnica mejora la calidad de los resultados y garantiza su pertinencia, precisión y utilidad en diversos contextos ampliando la funcionalidad de los LLM para que hagan referencia a la base de conocimientos interna de un dominio u organización concretos a la hora de generar respuestas.

Optimización de grandes modelos lingüísticos (LLM)

Los grandes modelos lingüísticos (LLM) suelen entrenarse en conjuntos de datos a gran escala con miles de millones de parámetros para generar resultados brutos en tareas como responder preguntas, traducir idiomas y completar frases. Sin embargo, el hecho de que los datos de entrenamiento de los LLM sean estáticos y tengan una fecha límite de actualización de sus conocimientos hace posible que los modelos proporcionen información incorrecta cuando faltan respuestas o que emitan respuestas obsoletas o ambiguas cuando responden a una consulta que requiere acceso a información específica actualizada. Además, también es posible que las respuestas de los LLM procedan de fuentes no autorizadas o produzcan respuestas incorrectas debido a confusiones terminológicas, es decir, un mismo término puede referirse a contenidos diferentes en distintas fuentes de datos.

La solución de RAG

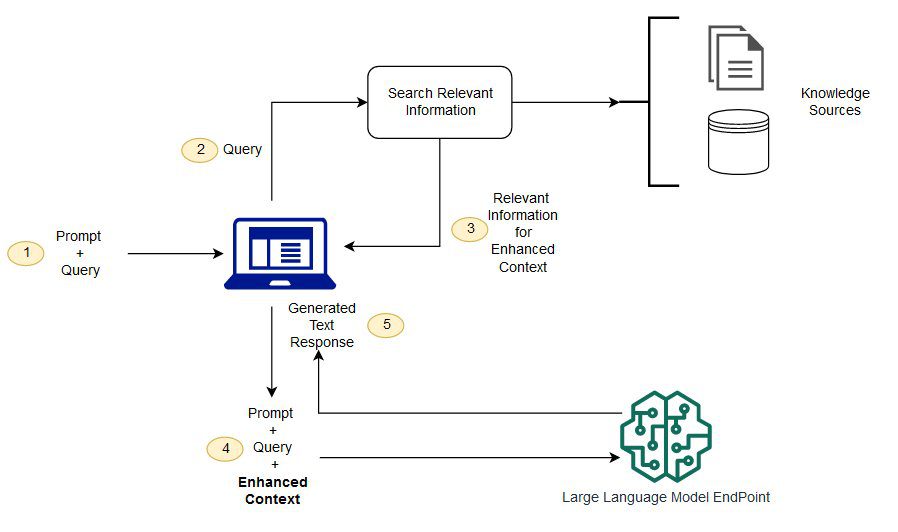

RAG aborda el problema anterior dirigiendo a los LLM para que recuperen información relevante de fuentes de conocimiento predefinidas y autorizadas. El modelo base suele entrenarse fuera de línea y no tiene acceso a los datos generados una vez finalizado el entrenamiento. Los LLM suelen entrenarse con corpus de dominios muy generales y, por tanto, son menos eficientes a la hora de procesar tareas específicas de un dominio.El modelo RAG es capaz de recuperar información de datos distintos a los del modelo base y aumentar las pistas añadiendo al contexto los datos relevantes recuperados.

Para más información sobre la arquitectura del modelo GAR, consulteRetrieval-Enhanced Generation of Knowledge-Intensive NLP Tasks..

Ventajas de la Generación Aumentada de Recuperación (RAG)

Mediante el uso de RAG, se pueden obtener datos de una serie de fuentes de datos externas (por ejemplo, repositorios de documentos, bases de datos o API) para aumentar las pistas. El proceso comienza con la transformación de los documentos y las consultas de los usuarios en un formato compatible para la búsqueda de relevancia. La compatibilidad de formatos en este contexto significa que necesitamos utilizar un modelo de lenguaje de incrustación para transformar la colección de documentos (que puede considerarse una base de conocimientos) y la consulta enviada por el usuario en una representación numérica para la comparación y la búsqueda.La principal tarea del modelo RAG es comparar la incrustación de la consulta del usuario con los vectores de la base de conocimientos.

A continuación, las indicaciones mejoradas se envían al modelo base, donde las indicaciones originales del usuario se combinan con el contexto pertinente de documentos similares de la base de conocimientos. También puede actualizar de forma asíncrona la base de conocimientos y sus representaciones incrustadas asociadas para mejorar aún más la eficacia y precisión del modelo GAR.

Retos para el GAR

Aunque la RAG ofrece una forma de optimizar grandes modelos lingüísticos para abordar a fondo los retos de la recuperación de información y la respuesta a preguntas en la práctica, aún se enfrenta a una serie de problemas y desafíos.

1. Exactitud y fiabilidad de las fuentes de datos

En los modelos de generación de aumento de la recuperación, la precisión y actualización de la fuente de datos es fundamental. Si la fuente de datos contiene información incorrecta, desactualizada o no validada, puede dar lugar a respuestas incorrectas o de baja calidad generadas por la GAR. Por lo tanto, garantizar la calidad de las fuentes de datos es un reto que hay que afrontar y resolver continuamente.

2. Eficacia de la recuperación

Aunque la RAG puede funcionar eficazmente en grandes conjuntos de datos, puede tener problemas de eficiencia cuando la base de conocimientos es grande o la consulta compleja. Dado que encontrar información relevante en una gran cantidad de datos es una tarea que requiere mucho tiempo y cálculo, optimizar la eficiencia del algoritmo de recuperación también es un reto para la GAR.

3. Capacidad de generalización

Los modelos GAR pueden ser especialmente sensibles a datos y consultas específicos, y algunos problemas pueden parecer más difíciles de adoptar estrategias sensatas y eficaces, lo que a menudo requiere modelos con una buena capacidad de generalización. Las cuestiones y los retos que hay que abordar a la hora de entrenar modelos para manejar una variedad de consultas y fuentes de datos son bastante complejos.

4. Tratamiento heterogéneo de datos

En la práctica, los datos no siempre existen en forma de documentos, sino también de otras formas, como imágenes, audio y vídeo. También es un gran reto hacer que RAG maneje estas formas de datos para la recuperación y las referencias cruzadas entre una gama más amplia de fuentes de conocimiento.

Para hacer frente a los retos anteriores es necesario encontrar un equilibrio entre la potencia de la GAR y sus posibles problemas, de modo que se pueda garantizar su rendimiento en diversas aplicaciones del mundo real.

Para más detalles, consulte el siguiente cuaderno de muestra:

Referencia importante: https://docs.aws.amazon.com/pdfs/sagemaker/latest/dg/sagemaker-dg.pdf#jumpstart-foundation-models-customize-rag

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...