"Abuso de la IA: 13 preocupaciones clave sobre la nueva orientación de la gobernanza de la IA en China

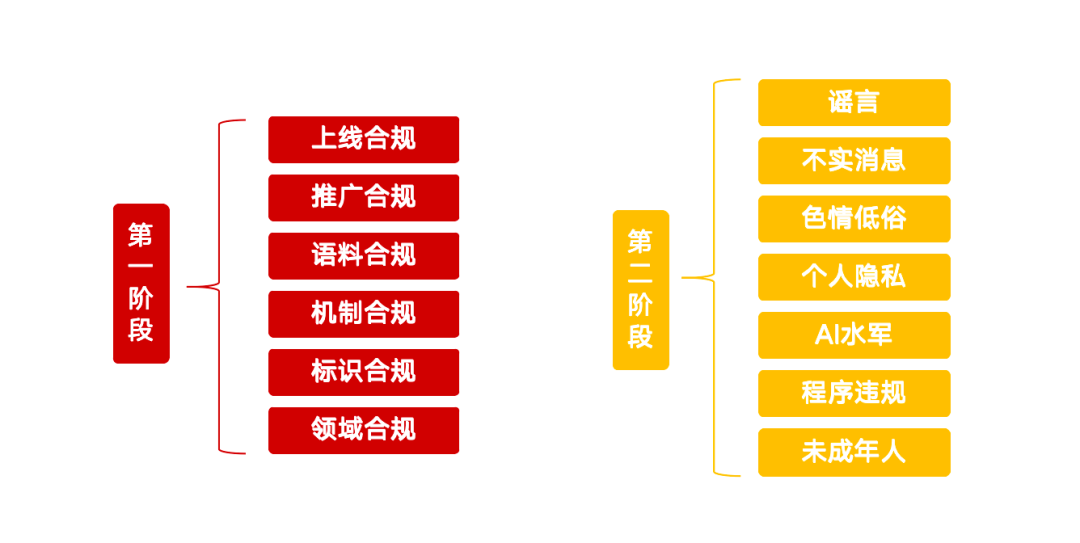

Recientemente, la Oficina Central de Tecnología de la Información de Internet lanzó una acción especial llamada "Claro - Rectificar el abuso de la tecnología de IA", que traza una clara línea roja para la gobernanza de una serie de cuestiones que han surgido en el actual desarrollo de la inteligencia artificial. Esta iniciativa pretende guiar el desarrollo saludable de la tecnología de IA y prevenir posibles riesgos. La acción especial se centra en 13 direcciones clave y se divide en dos fases, con requisitos detallados para los productos, servicios, contenidos y normas de comportamiento de la IA.

Fase I: Gobernanza e infraestructura de fuentes

La primera fase de la acción se centra en la gestión en origen de la tecnología de IA, con el objetivo de limpiar las aplicaciones de IA infractoras, reforzar la gestión del etiquetado de contenidos y mejorar la capacidad de la plataforma para detectar e identificar falsificaciones.

Los productos de IA no conformes deben cumplir la normativa en línea

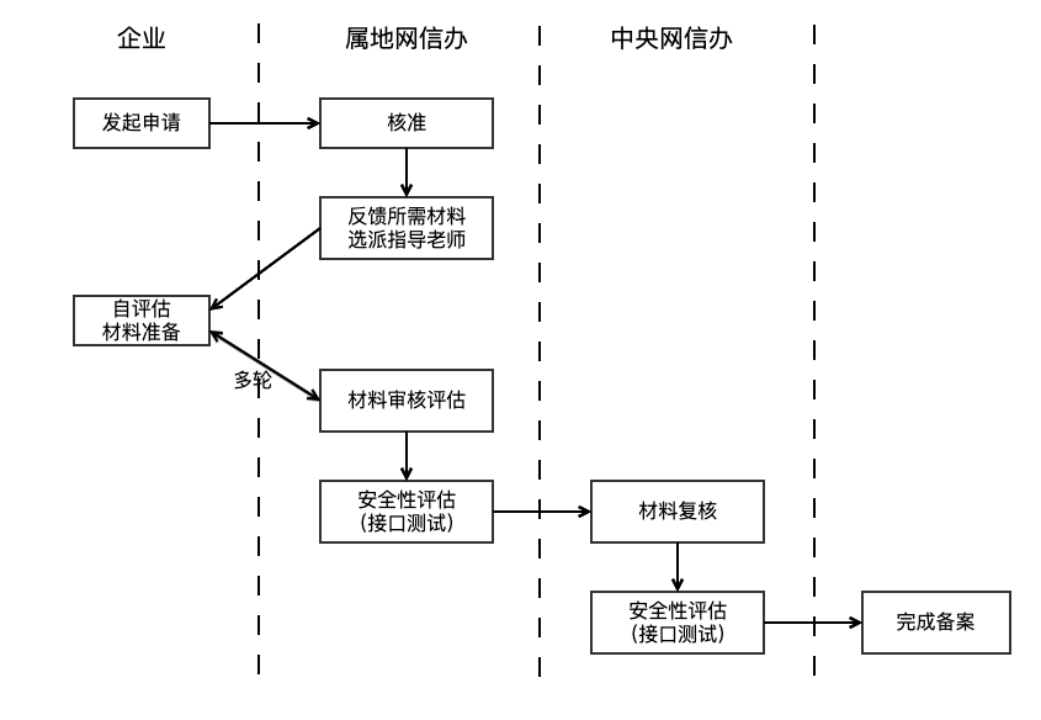

El regulador señaló que las aplicaciones que utilizan tecnología de IA generativa para prestar servicios al público deben cumplir el proceso de presentación o registro de grandes modelos. Este requisito se basa en el artículo 17 de las Medidas Provisionales para la Administración de Servicios de Inteligencia Artificial Generativa (en adelante, las Medidas Provisionales), que deja claro que los productos de IA deben superar una evaluación de seguridad antes de su lanzamiento oficial. El ciclo de tramitación suele durar entre tres y seis meses. Además, es contrario a la ley ofrecer funciones ilegales y poco éticas, como "desvestirse con un clic", o clonar o editar rasgos biométricos de otras personas (por ejemplo, voces y rostros) sin autorización.

Identificar y regular los servicios de IA no registrados se ha convertido en todo un reto. Los reguladores pueden utilizar medios técnicos, como rastreadores web, para supervisar diversas plataformas identificando si los servicios llaman a interfaces API de grandes modelos (por ejemplo, generación de diálogos, síntesis de imágenes) y sus características técnicas. Para el cumplimiento del diseño funcional, además de la evaluación legal interna de las empresas y las auditorías de las tiendas de aplicaciones, la regulación de los servicios de canales informales se basa actualmente más en la notificación de quejas de los usuarios. Los proveedores de servicios deben autocomprobar si los productos de IA han completado el doble registro (registro de grandes modelos y registro de algoritmos) y asegurarse de que el diseño funcional cumple las especificaciones.

Fomento del cumplimiento de la normativa: mano dura contra los tutoriales y productos ilegales de IA

La acción especial también se centra en la promoción de productos de IA. Los tutoriales que enseñan a utilizar productos de IA no conformes para crear vídeos de cambio de caras y vídeos de cambio de voz, la venta de productos no conformes como "sintetizadores de voz" y "herramientas de cambio de caras", y la comercialización y promoción de productos de IA no conformes están incluidos en la reparación. Los promotores tienen la responsabilidad de verificar la conformidad de los productos de IA antes de decidir promocionarlos. Las plataformas tienen que reforzar la auditoría de contenidos, no solo para garantizar que los contenidos en sí sean legales, sino también para tener la capacidad de identificar y auditar la conformidad de los productos de IA promocionados en los contenidos, por ejemplo, mediante el cribado inicial de modelos semánticos, complementado con la intervención manual.

Cumplimiento del corpus: fuentes de datos de formación y gestión en el punto de mira

La conformidad de los datos de entrenamiento es la base de la seguridad de los modelos de IA. El artículo 7 de las Medidas provisionales subraya que los proveedores de servicios deben utilizar datos y modelos subyacentes procedentes de fuentes legítimas. Los Requisitos Básicos para la Seguridad de los Servicios de IA Generativa (en lo sucesivo, los Requisitos Básicos) se afinan aún más, estipulando que si el corpus contiene más de 51 TP3T de información ilegal e indeseable, la fuente no debe ser cosechada. Al mismo tiempo, se definen claramente la diversidad de las fuentes de datos, los protocolos de fuente abierta que deben seguirse, los registros de los datos recolectados por los propios usuarios y los procedimientos legales para la obtención de datos comerciales.

Debido a la privacidad de los datos y a la confidencialidad técnica, la regulación de los corpus de formación es bastante difícil y suele adoptar la forma de interrogatorio y prueba material. Las empresas también se enfrentan a grandes retos a la hora de gestionar cantidades masivas de datos de formación con fuentes complejas y calidad variable. Los requisitos básicos recomiendan que las empresas combinen el filtrado de palabras clave, la selección de modelos de clasificación y el muestreo manual para limpiar la información ilegal e indeseable del corpus.

Cumplimiento de los mecanismos: medidas de gestión de la seguridad reforzadas

Las empresas deben establecer mecanismos de seguridad, como la auditoría de contenidos y el reconocimiento de intenciones, adecuados a la escala de su negocio, así como un proceso de gestión eficaz de las cuentas infractoras y un sistema de autoevaluación periódica de la seguridad. En el caso de servicios como las respuestas automáticas de IA a las que se accede a través de interfaces API, las plataformas sociales deben ser conscientes y estrictas. El capítulo 7 de los Requisitos Básicos exige a los proveedores de servicios que supervisen las entradas de los usuarios y tomen medidas como restringir los servicios a los usuarios que introduzcan repetidamente información ilegal. Además, las empresas deben contar con personal de supervisión acorde con la escala de sus servicios, responsable del seguimiento de las políticas y del análisis de las quejas para mejorar la calidad y la seguridad de los contenidos. Un sólido mecanismo de control de riesgos es un requisito previo para el lanzamiento de productos de IA.

Cumplimiento de las normas de etiquetado: aplicación de los requisitos de etiquetado a los contenidos generados por IA

Para aumentar la transparencia, las Medidas para el marcado de contenidos sintéticos generados mediante inteligencia artificial (en lo sucesivo, las Medidas de marcado) estipulan que los proveedores de servicios deben añadir marcas explícitas o implícitas a los contenidos profundamente sintetizados y garantizar que las marcas explícitas se incluyan en el archivo y las marcas implícitas se añadan a los metadatos cuando el usuario descargue o copie el archivo. El planteamiento va acompañado de la norma nacional "Método de identificación de contenidos sintéticos generados por inteligencia artificial en la tecnología de seguridad de redes", que entrará en vigor a partir del 1 de septiembre de 2025. Las empresas están obligadas a realizar autocomprobaciones basadas en ella y a desplegar medios técnicos para detectar contenidos generados por IA en sus plataformas y proporcionar alertas de contenidos sospechosos. Los reguladores también podrán reforzar la educación de los usuarios para mejorar el reconocimiento público de los contenidos generados por IA.

Cumplimiento de la normativa sobre dominios: atención a los riesgos de seguridad en sectores clave

Los productos de IA que se hayan registrado para prestar servicios de preguntas y respuestas en ámbitos clave como la sanidad, las finanzas y los menores deben establecer auditorías de seguridad y medidas de control específicas para cada sector. Prevenir el fenómeno de la "prescripción de IA", induciendo a la inversión o utilizando la "ilusión de IA" para engañar a los usuarios. La gobernanza del cumplimiento en estas áreas específicas es compleja y segmentada, y requiere conocimientos de expertos en la materia y un corpus de cumplimiento especializado. Los reguladores del sector y las empresas de cabecera desempeñarán un papel clave a la hora de establecer normas y garantizar la aplicación de medidas de seguridad. Las soluciones genéricas incluyen la detección fantasma, la aprobación manual de operaciones clave, etc. para protegerse del riesgo de pérdida de control de la IA.

Fase II: Represión del uso de la IA para actividades ilegales e ilícitas

La segunda fase de la acción especial se centrará en el uso de la tecnología de IA para producir y difundir rumores, información inexacta y contenidos pornográficos y vulgares, así como para suplantar la identidad de otras personas y participar en actividades de ciberescuadrón.

Contrarrestar el uso de la IA para crear y publicar rumores

El alcance de la remediación incluye la fabricación de rumores relacionados con asuntos de actualidad y el sustento de las personas de la nada, la interpretación maliciosa de políticas, la fabricación de detalles sobre la base de emergencias, la suplantación de comunicados oficiales de información, así como la orientación maliciosa mediante la explotación del sesgo cognitivo de la IA. La Plataforma Conjunta de Difusión de Rumores por Internet de China lleva mucho tiempo en funcionamiento, pero en la era de la IA, el coste reducido de la producción de rumores y su mayor fidelidad plantean nuevos retos de gobernanza. La regulación se basa principalmente en el seguimiento de la opinión pública y en las denuncias de los usuarios, y es posible que aumenten las sanciones por rumores de IA en ámbitos clave. Los proveedores de servicios deben mejorar su capacidad para detectar rumores generados por IA, por ejemplo utilizando herramientas de IA para calibrar la exactitud de los contenidos, vigilando los comportamientos anómalos de las cuentas y comprobando manualmente el contenido de los hotspots.

Depurar el uso de la IA para producir y publicar información inexacta

Estos comportamientos incluyen unir y editar gráficos y vídeos sin relación entre sí para generar información mezclada, difuminar y alterar elementos factuales, reeditar noticias antiguas, publicar contenidos exagerados o pseudocientíficos relacionados con campos profesionales, y difundir supersticiones con la ayuda de la adivinación y la adivinación por IA, etc. Comparada con los rumores, la información inexacta puede ser menos subjetiva y malintencionada, pero su naturaleza oculta y su impacto potencial no pueden ignorarse. La gobernanza depende principalmente de que las plataformas de contenidos refuercen la construcción ecológica, identifiquen los contenidos de baja calidad a través de medios técnicos y tomen medidas para restringir la difusión de contenidos y creadores relevantes o imponer sanciones.

Rectificación del uso de la IA para producir y distribuir contenidos pornográficos y vulgares

El uso de la IA para generar imágenes y vídeos pornográficos o indecentes, como "desnudarse con un clic" y dibujar con IA, así como la producción de pornografía blanda, imágenes pornográficas de segunda generación, violencia sangrienta, imágenes grotescas y esperpénticas y "pequeño texto amarillo", son objeto de medidas enérgicas. Aunque la tecnología de IA mejora la eficiencia de la producción de contenidos, también puede utilizarse indebidamente para crear estos contenidos indeseables. Los métodos tradicionales de depuración, como las bibliotecas de palabras clave, los modelos semánticos y la clasificación de imágenes ("modelos de identificación de pornografía") están relativamente maduros para identificar contenidos generados por los usuarios (CGU). Sin embargo, la distribución de las características de los contenidos generados por IA puede ser diferente de la de los CGU, y los proveedores de servicios deben prestar atención a la actualización de los datos de entrenamiento de los modelos para mantener la precisión de la identificación.

Investigación y tratamiento del uso de la IA para suplantar la identidad de otros con el fin de cometer infracciones

Actos como la suplantación de personalidades públicas mediante el intercambio de rostros con IA, la clonación de voz y otras técnicas de falsificación en profundidad con fines de engaño o lucro, la suplantación de identidad y el descrédito de personalidades públicas o personajes históricos, el uso de IA para suplantar la identidad de amigos y familiares con el fin de cometer fraudes, así como el uso indebido de IA para "resucitar a los muertos" y el uso indebido de información sobre los fallecidos, son objeto de medidas correctoras. Tales riesgos se derivan de la filtración y el uso indebido de datos personales privados. Es importante sensibilizar a la opinión pública sobre la protección de la privacidad y, a largo plazo, establecer un mecanismo de trazabilidad de los datos que garantice su cumplimiento a lo largo de toda la cadena de datos.

Lucha contra el uso de la IA para actividades de cibermercenarios

El "ejército de agua de la IA" es una nueva variante del ejército de agua de la red. Se reprimirá severamente el uso de tecnología de IA para "elevar" el registro masivo y el funcionamiento de cuentas sociales, el uso de granjas de contenidos de IA o el lavado de manuscritos de IA para generar contenidos homogeneizados de baja calidad en masa para cepillar el flujo, así como el uso de software de control de grupos de IA, robots sociales para cepillar la cantidad de control y evaluación y otros comportamientos. La gobernanza debe partir de las dos dimensiones de contenido y cuenta, detectando el contenido de baja calidad y AIGC en la plataforma, controlando las características de comportamiento de las cuentas que publican contenido AIGC y automatizando la intervención rápida para aumentar el coste del mal de los ejércitos de agua.

Regular el comportamiento de los servicios y aplicaciones de productos de IA

La producción y difusión de sitios web y aplicaciones de IA falsificados y ficticios, la provisión de funciones no conformes por parte de aplicaciones de IA (por ejemplo, la provisión de "búsqueda en caliente y ampliación de listas en caliente" por parte de herramientas de autor), la provisión de servicios de diálogo vulgares y de pornografía blanda por parte de software de chat social de IA, así como la venta y promoción de aplicaciones, servicios o cursos de IA no conformes que desvían a los usuarios, se incluyen en el ámbito de la reparación. De este modo se vuelve a hacer hincapié en la conformidad del lanzamiento y la difusión de productos de IA, y se completa la definición de funciones "ficticias" y no conformes. Los proveedores de servicios deben atenerse a la intención original de la tecnología de servir a las personas.

Protección de los derechos e intereses de los menores frente a la IA

Las aplicaciones de IA que inducen a los menores a la adicción, o los contenidos que afectan a su salud física y mental siguen existiendo bajo la modalidad de menores, es otro de los focos de esta acción especial.Los modelos de IA se basan en estadísticas probabilísticas, y existe imprevisibilidad en los contenidos que generan, que pueden arrojar valores erróneos y suponer un riesgo potencial para el crecimiento de los menores. Por lo tanto, la aplicación de la IA en escenarios de educación de menores requiere una mayor precaución y un control estricto del uso de los escenarios; en otros productos con alta frecuencia de contacto por parte de menores, debe reforzarse el modo para menores y restringirse los derechos de aplicación de la IA.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...