Pieces OS: Conversión inversa de Pieces-OS GRPC a interfaz OpenAI (fallida)

Últimos recursos sobre IAActualizado hace 1 año Círculo de intercambio de inteligencia artificial 51.6K 00

Introducción general

Pieces-OS es un proyecto de código abierto , tiene como objetivo Pieces-OS GRPC arroyos inversa y convertir a la interfaz API estándar OpenAI , el apoyo a Claude , GPT , Gemini . el proyecto es desarrollado por Nekohy , basado en el protocolo GPL-3.0 de código abierto , principalmente para el aprendizaje y la comunicación , no para uso comercial . El proyecto proporciona una variedad de compatibilidad de modelos , y es compatible con Vercel despliegue de un solo clic .

dirección inversa piezas Despliegue gratuito en un minuto de interfaces API compatibles con los modelos Claude, GPT y Gemini. Proporcioneir a la versión.

Lista de funciones

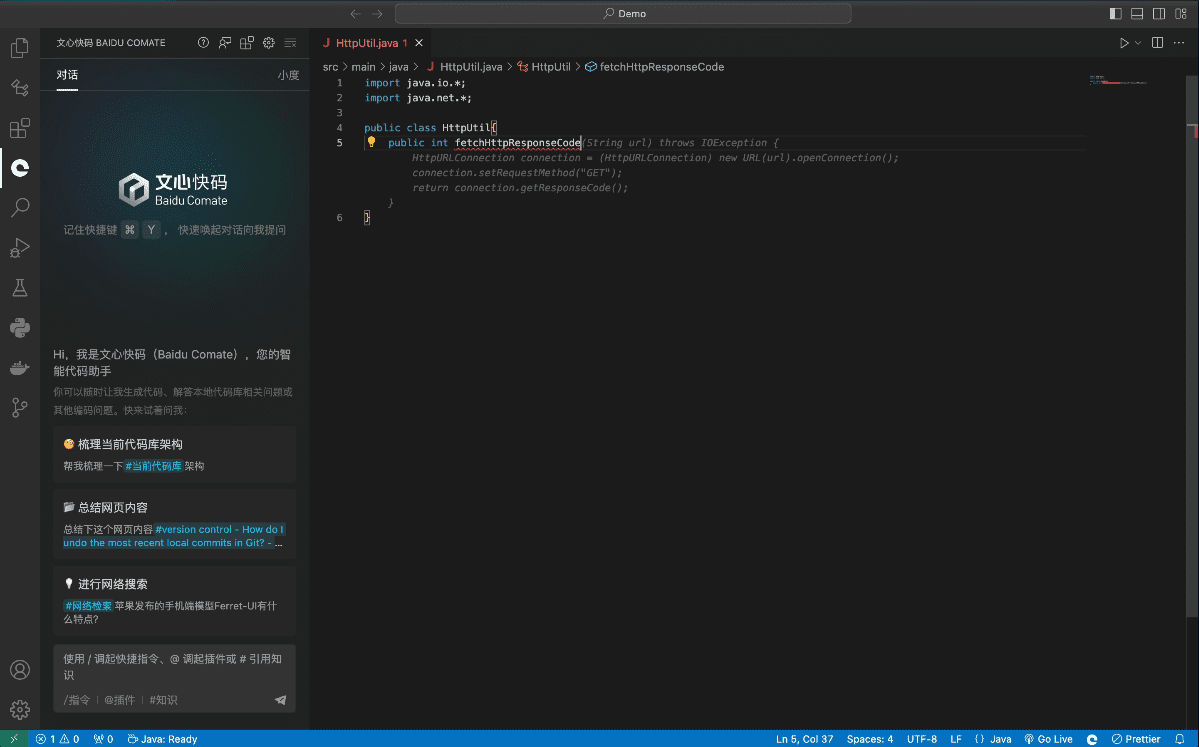

- Inversión de flujo GRPCConvierte flujos GRPC de Pieces-OS a la interfaz estándar OpenAI.

- Compatibilidad con varios modelos: Compatible Claude serie GPT, serie Gemini y muchos otros modelos.

- Despliegue en un clic: Apoyo Implantación de la plataforma Vercel con un solo clicque es fácil de construir rápidamente para los usuarios.

- Configuración del modelo de nube: Proporcionar perfiles de modelos de nube para que los usuarios puedan extraer y utilizar diferentes modelos según sus necesidades.

- Gestión de solicitudes APIGestión de rutas de prefijo, claves, reintentos, etc. para peticiones API configurando variables de entorno.

Utilizar la ayuda

Proceso de instalación

- proyecto de clonación: Uso

git clonepara clonar el proyecto localmente.git clone https://github.com/Nekohy/pieces-os.git - Instalación de dependencias: Vaya al directorio del proyecto e instale

package.jsonBibliotecas de dependencia definidas en elcd pieces-os npm install - procedimiento de activación: Aplicación

node index.jsInicie el procedimiento.node index.js

Proceso de utilización

- Obtener una lista de modelos: Obtenga la lista de modelos disponibles con el siguiente comando.

curl --request GET 'http://127.0.0.1:8787/v1/models' --header 'Content-Type: application/json' - Enviar solicitud: Utilice el siguiente comando para enviar una solicitud de chat.

curl --request POST 'http://127.0.0.1:8787/v1/chat/completions' --header 'Content-Type: application/json' --data '{ "messages": [ { "role": "user", "content": "你好!" } ], "model": "gpt-4o", "stream": true }'

Configuración de variables de entorno

- API_PREFIX: Ruta de prefijo para las peticiones API, el valor por defecto es

'/'. - CLAVE_APIClave para la solicitud API, por defecto una cadena vacía.

- MAX_RETRY_COUNTNúmero máximo de reintentos, por defecto es

3. - RETRY_DELAY: tiempo de reintento en milisegundos, el valor por defecto es

5000(5 segundos). - PUERTO: el puerto en el que escucha el servicio, el valor por defecto es

8787.

Configuración del modelo

El proyecto ofrece perfiles para múltiples modelos cloud_model.jsonEl usuario puede extraer y utilizar diferentes modelos según sus necesidades. Por ejemplo:

- Serie Claude::

claude-3-5-sonnet@20240620yclaude-3-haiku@20240307etc. - Serie GPT::

gpt-3.5-turboygpt-4ygpt-4-turboetc. - Serie Géminis::

gemini-1.5-flashygemini-1.5-proetc.

Cómo utilizarlo una vez desplegado

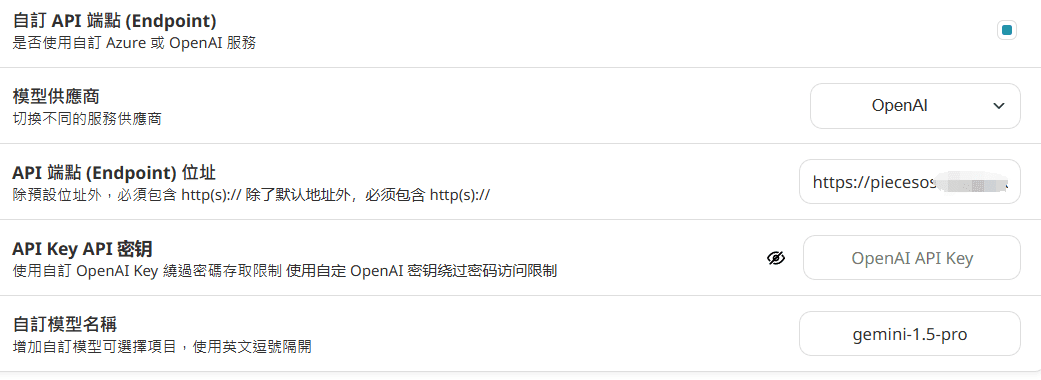

Configurado en nextchat:

Rellene el nombre de dominio directamente, no lo añada después de la URL/v1/models y /v1/chat/completions

API_KEY no está configurado en Vercel, entonces no se requiere ninguna entrada.

Configuración en traducción inmersiva: (no recomendada por problemas de concurrencia)

https://你的域名/v1/chat/completions

Si apikey no está configurado, rellene los espacios en blanco.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...