Parler-TTS: generación de modelos de conversión de texto en voz específicos para cada hablante a partir de un texto de entrada

Últimos recursos sobre IAActualizado hace 1 año Círculo de intercambio de inteligencia artificial 59.2K 00

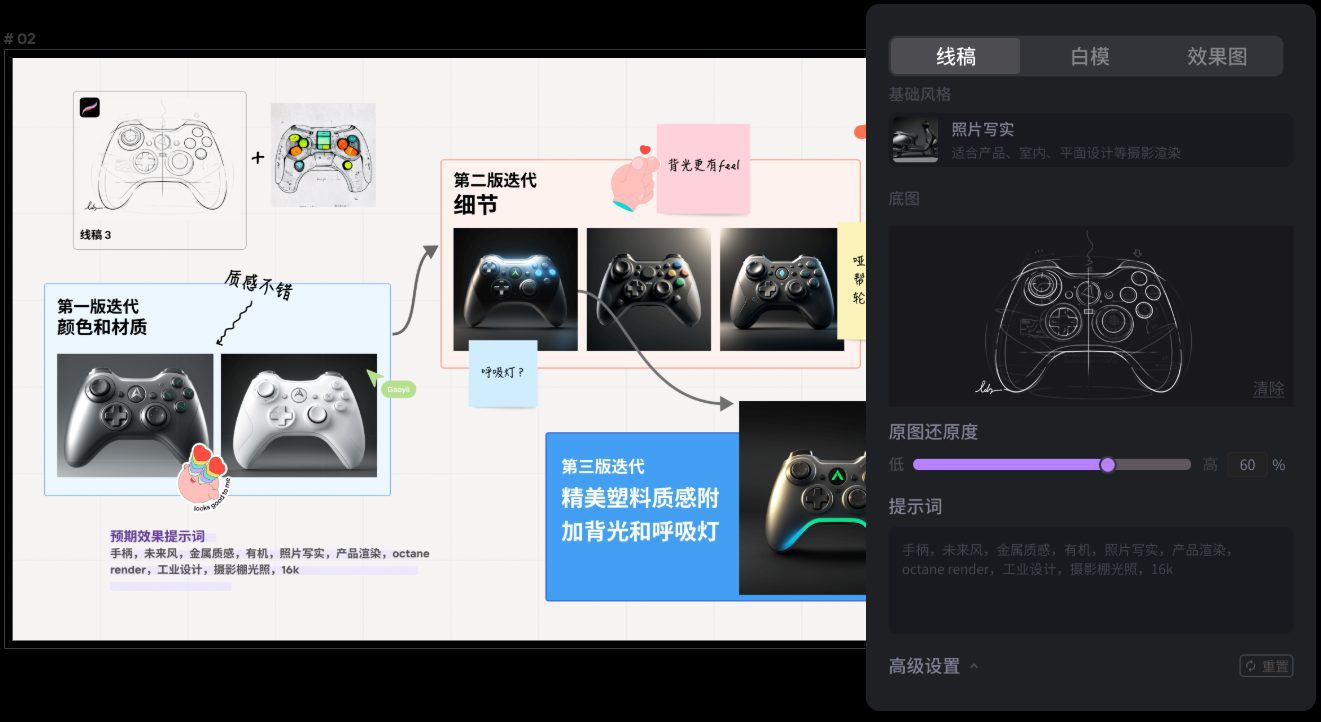

Introducción general

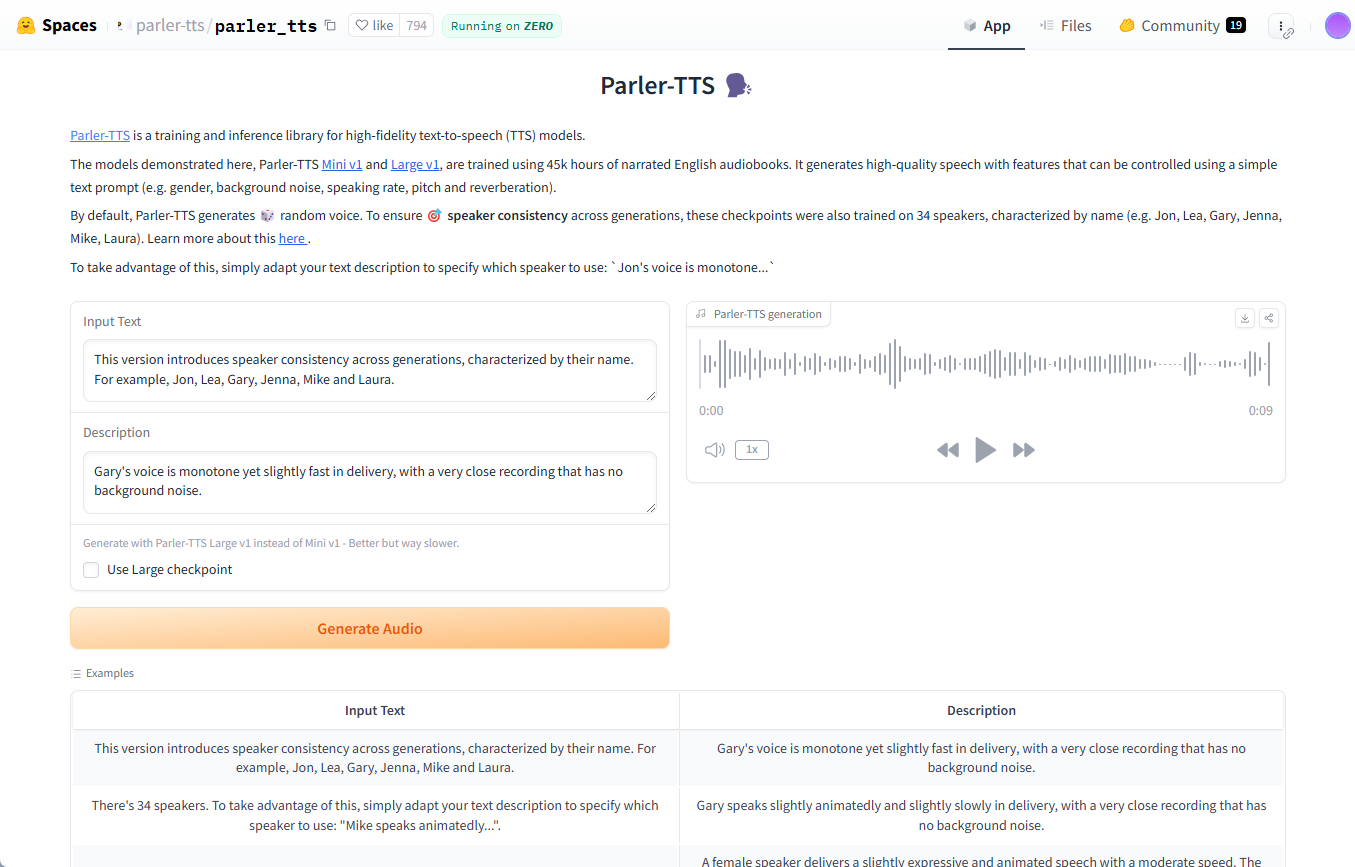

Parler-TTS es una biblioteca de modelos de conversión de texto en habla (TTS) de código abierto desarrollada por Hugging Face para generar habla natural de alta calidad. Parler-TTS se basa en los resultados de la investigación realizada en el artículo "Natural language guidance of high-fidelity text-to-speech with synthetic Parler-TTS se basa en los resultados de la investigación del artículo "Natural language guidance of high-fidelity text-to-speech with synthetic annotations", y es completamente de código abierto, con todos los conjuntos de datos, preprocesamiento, código de entrenamiento y pesos a disposición del público, lo que permite a la comunidad desarrollarlos y mejorarlos.

Lista de funciones

- Generación de voz de alta calidad: Genera un habla natural y fluida con soporte para múltiples estilos de locutor.

- código abierto: Todas las ponderaciones de códigos y modelos están a disposición del público para su desarrollo y mejora por parte de la comunidad.

- Dependencias ligerasFácil de instalar y utilizar, con pocas dependencias.

- Múltiples versiones de modelosParler-TTS Mini y Parler-TTS Large: existen versiones del modelo con distintos recuentos de parámetros.

- Generación rápida: Velocidad de generación optimizada compatible con SDPA y Flash Attention 2.

- Conjuntos de datos y ponderacionesProporciona abundantes conjuntos de datos y pesos de modelos preentrenados para facilitar el entrenamiento y el ajuste.

Utilizar la ayuda

Proceso de instalación

- Asegúrese de que el entorno Python está instalado.

- Utilice el siguiente comando para instalar la biblioteca Parler-TTS:

pip install git+https://github.com/huggingface/parler-tts.git

- Para los usuarios de Apple Silicon, ejecute el siguiente comando para soportar bfloat16:

pip3 install --pre torch torchaudio --index-url https://download.pytorch.org/whl/nightly/cpu

Utilización

Generar discurso aleatorio

- Importe las bibliotecas necesarias:

import torch

from parler_tts import ParlerTTSForConditionalGeneration

from transformers import AutoTokenizer

import soundfile as sf

- Carga de modelos y divisores:

device = "cuda:0" if torch.cuda.is_available() else "cpu"

model = ParlerTTSForConditionalGeneration.from_pretrained("parler-tts/parler-tts-mini-v1").to(device)

tokenizer = AutoTokenizer.from_pretrained("parler-tts/parler-tts-mini-v1")

- Introducir texto y generar voz:

prompt = "Hey, how are you doing today?"

description = "A female speaker delivers a slightly expressive and animated speech with a moderate speed and pitch."

inputs = tokenizer(prompt, return_tensors="pt").to(device)

outputs = model.generate(**inputs, description=description)

sf.write("output.wav", outputs.cpu().numpy(), 22050)

Generar un discurso con un estilo específico

- Descripciones que utilizan el estilo de un orador concreto:

description = "A male speaker with a deep voice and slow pace."

inputs = tokenizer(prompt, return_tensors="pt").to(device)

outputs = model.generate(**inputs, description=description)

sf.write("output_specific.wav", outputs.cpu().numpy(), 22050)

Modelos de formación

- Descargue y prepare el conjunto de datos.

- El entrenamiento del modelo se realiza utilizando el código de entrenamiento proporcionado:

python train.py --dataset_path /path/to/dataset --output_dir /path/to/output

Razonamiento optimizado

- Optimizado mediante SDPA y Flash Attention 2:

model = ParlerTTSForConditionalGeneration.from_pretrained("parler-tts/parler-tts-mini-v1", use_flash_attention=True).to(device)© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...