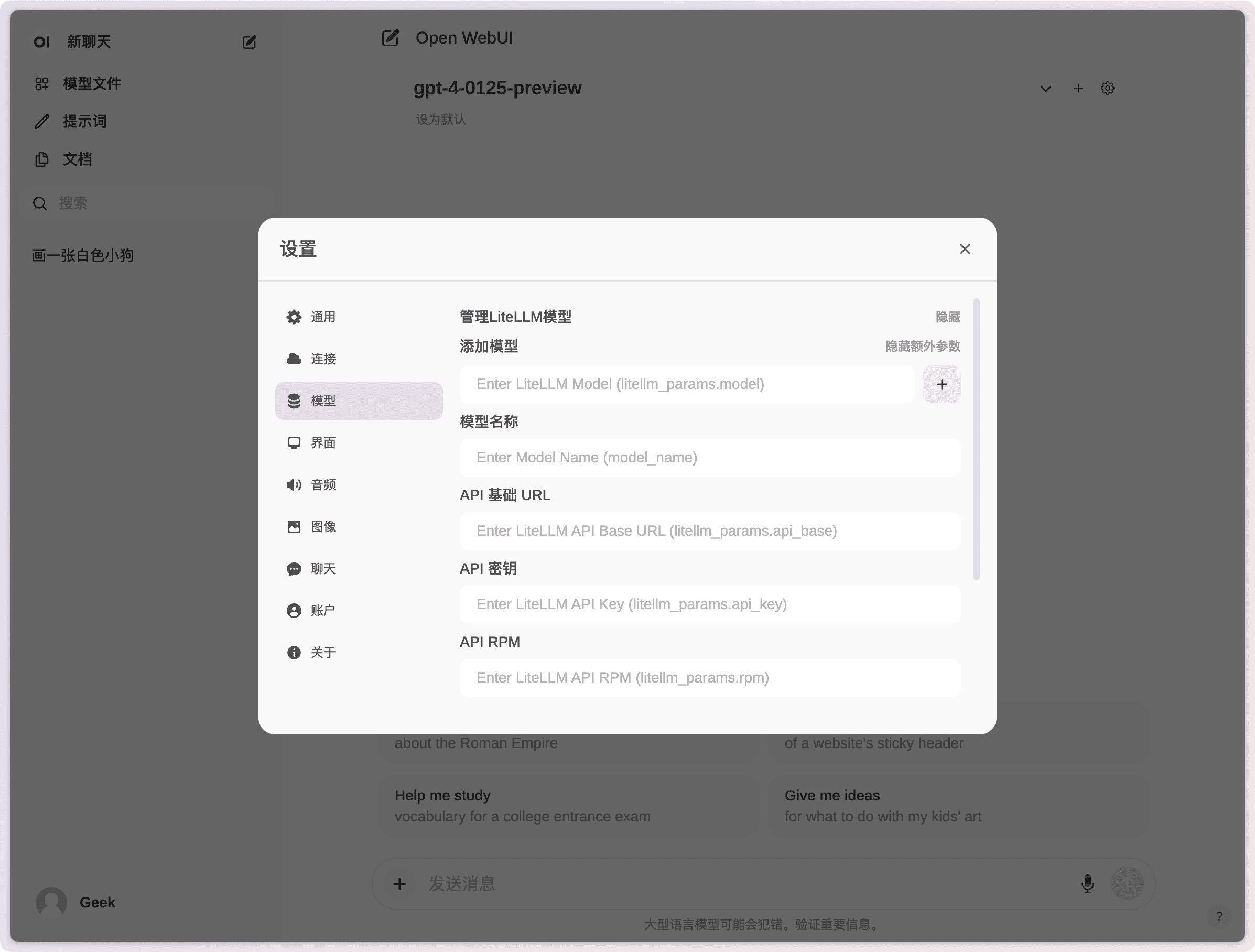

Open WebUI: AI Chat WebUI alojado localmente

Últimos recursos sobre IAActualizado hace 1 año Círculo de intercambio de inteligencia artificial 84.4K 00

Introducción general

Open WebUI (anteriormente conocida como Ollama WebUI) es una interfaz de usuario interactiva y amigable diseñada para LLMs (Large Language Models). Es escalable, rica en características, y se ejecuta completamente fuera de línea. características sobresalientes de Open WebUI incluyen diseño de interfaz chatty, alta capacidad de respuesta, fácil configuración usando Docker o Kubernetes, resaltado de código, soporte Markdown y LaTeX, integración RAG local y remota, funcionalidad de llamada de voz/video, integración de generación de imágenes, ¡y muchas más! funciones, y mucho más.

Acerca de OpenWebUI:

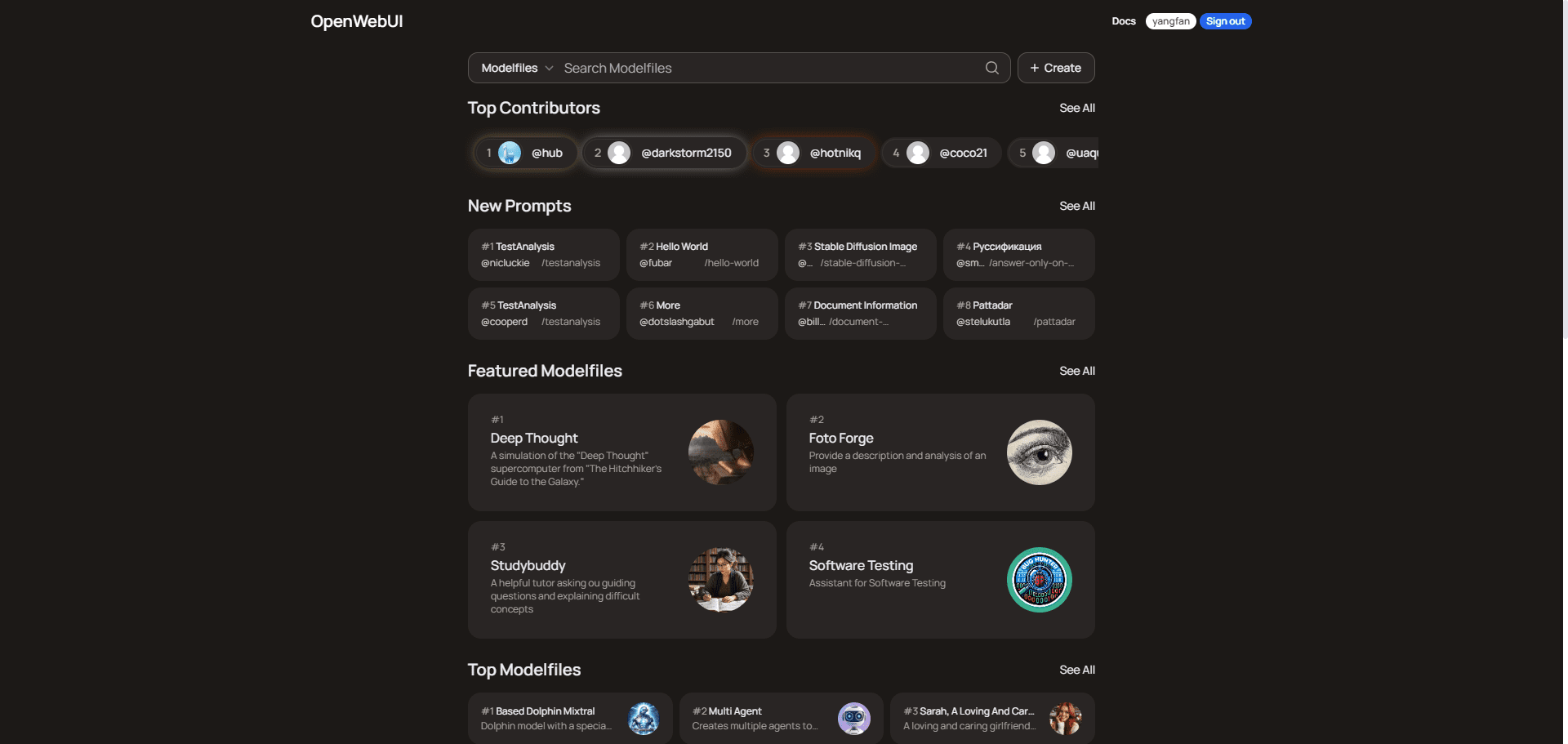

OpenWebUI es una plataforma de la comunidad de usuarios que proporciona archivos de modelos polivalentes que abarcan la programación, la escritura, la productividad, la educación, los negocios y el análisis de datos. Los usuarios pueden explorar y descargar estos archivos de modelos para mejorar la eficacia de sus tareas y proyectos. La plataforma cuenta con más de 15.000 usuarios y se basa en clasificaciones de colaboradores y registros de chat inteligentes compartidos para la comunicación y el aprendizaje.

Para conocer el método de despliegue gratuito en la nube, consulte Despliegue de un conjunto personalizado de herramientas de chat en miniatura en ordenadores de bajo perfil En esta sección, encontrarás una descripción del despliegue de Koyeb de Open WebUI.

Lista de funciones

- Instalación perfectaFácil instalación a través de Docker o Kubernetes, con soporte para Ollama e imágenes etiquetadas CUDA.

- Integración API: Fácil integración con API compatibles con OpenAI y compatibilidad con múltiples modelos de diálogo.

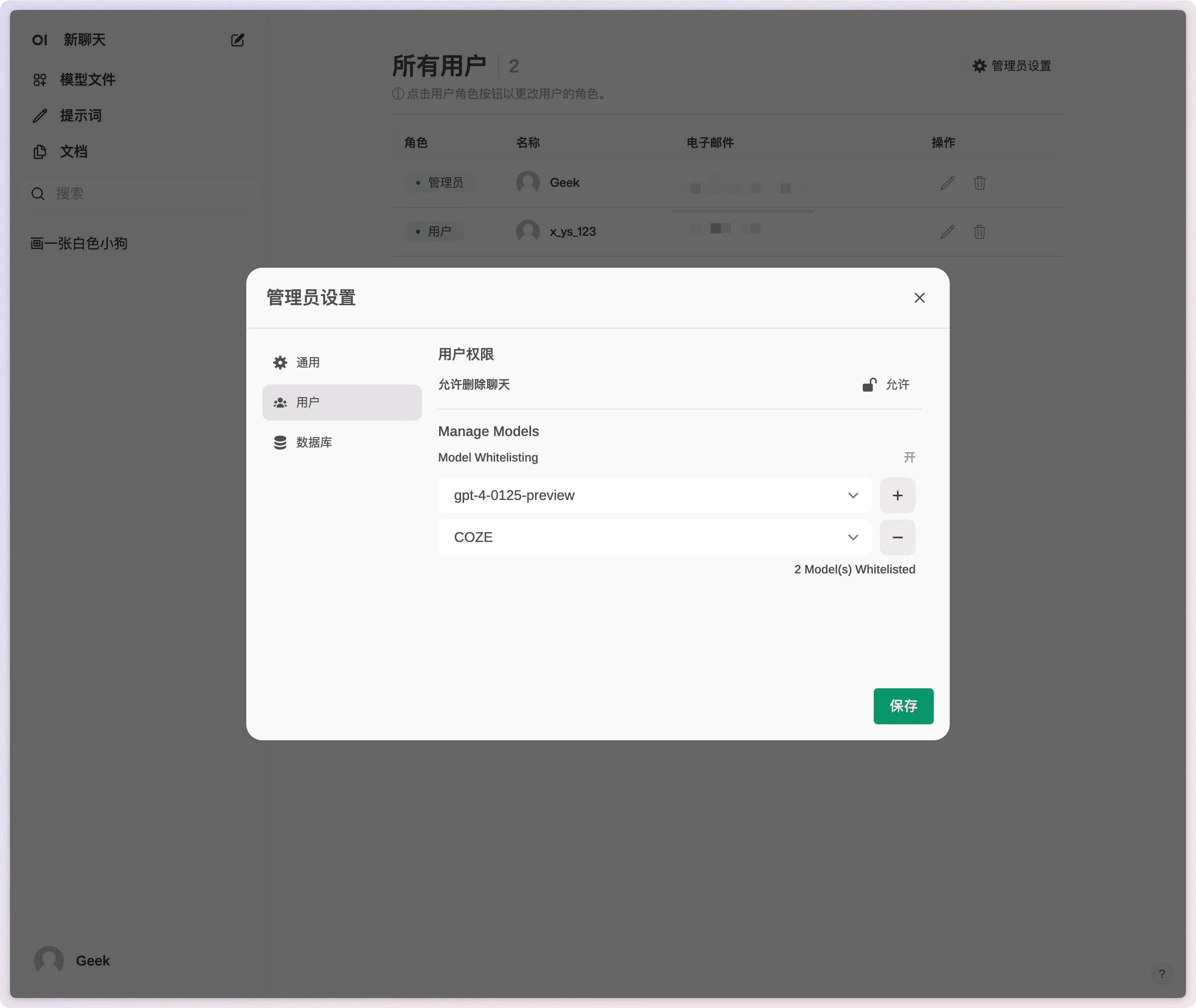

- Permisos detallados y grupos de usuariosLos administradores pueden crear funciones y permisos de usuario detallados para garantizar un entorno de usuario seguro.

- diseño adaptable: Disfruta de una experiencia fluida en ordenadores de sobremesa, portátiles y dispositivos móviles.

- Aplicaciones web progresivas (PWA)Proporcionar una experiencia similar a la de una aplicación nativa en dispositivos móviles, con posibilidad de acceso sin conexión.

- Compatibilidad con Markdown y LaTeXProporcionar funciones completas de Markdown y LaTeX para mejorar la experiencia interactiva.

- Llamadas de voz/vídeo: Integración de voz manos libres y videollamadas para un entorno de chat más dinámico.

- constructor de modelosCree fácilmente modelos Ollama y añada funciones/agentes personalizados a través de la interfaz web.

- Integración local del GAR: Compatibilidad con Retrieval Augmented Generation (RAG) para integrar perfectamente la interacción con documentos en la experiencia de chat.

- Integración de la generación de imágenesCompatible con la API AUTOMATIC1111, ComfyUI y DALL-E de OpenAI para enriquecer la experiencia de chat.

- diálogo multimodelo (matemáticas)Interactúa con varios modelos al mismo tiempo, aprovechando sus puntos fuertes para ofrecer la mejor respuesta posible.

- Control de acceso basado en funciones (RBAC)Garantizar un acceso seguro, en el que sólo el personal autorizado tenga acceso a Ollama y a los permisos de creación y extracción de modelos.

- Soporte multilingüeSoporte de internacionalización: se proporciona soporte de internacionalización para que los usuarios puedan elegir su idioma preferido.

- Soporte para plug-insIntegración perfecta de lógica personalizada y bibliotecas Python a través del marco de plugins Pipelines.

Utilizar la ayuda

Proceso de instalación

Instalación con Docker

- Tirar de los espejosEjecuta el siguiente comando en un terminal para extraer la última imagen Docker de Open WebUI del registro de contenedores de GitHub:

docker pull ghcr.io/open-webui/open-webui:main - Contenedores en funcionamiento: Ejecute el contenedor con la configuración predeterminada para garantizar el almacenamiento persistente de los datos:

docker run -d -p 3000:8080 -v open-webui:/app/backend/data --name open-webui ghcr.io/open-webui/open-webui:main- mapeo de volumen: Garantiza el almacenamiento persistente de los datos para evitar que se pierdan cuando se reinicie el contenedor.

- asignación de puertosExponer la WebUI al puerto 3000 en la máquina local.

Instalación con Python

- Instalación de Open WebUIAsegúrese de utilizar Python 3.11 para evitar problemas de compatibilidad. Ejecute el siguiente comando en el terminal:

pip install open-webui - Ejecutar Open WebUIUna vez completada la instalación, ejecute el siguiente comando para iniciar Open WebUI:

open-webui serveEsto iniciará el servidor Open WebUI, que puedes encontrar en http://localhost:8080访问.

Guía de funcionamiento

Llamadas de voz/vídeo

- iniciar una llamadaPulse el botón Llamada de voz o Videollamada en la pantalla Chat para seleccionar un contacto e iniciar la llamada.

- control de llamadas: Durante una llamada, puedes utilizar los botones de control de la interfaz para silenciar y colgar.

Generación de imágenes

- Seleccione la herramienta de generación de imágenes: Selecciona AUTOMATIC1111 API, ComfyUI o OpenAI's DALL-E en la pantalla de chat.

- Entrada DescripciónIntroduzca la descripción de la imagen en la casilla de entrada y pulse el botón Generar.

- Ver resultadosLa imagen generada se mostrará en la interfaz de chat y el usuario podrá guardarla o compartirla.

Integración local del GAR

- Carga de documentos: Utiliza el comando # en la interfaz de chat para cargar documentos o añadir archivos a la biblioteca de documentos.

- recuperarEl chat: Introduzca una consulta en el chat y el sistema recuperará automáticamente la información pertinente de los documentos cargados y generará una respuesta.

problemas comunes

- problema de conectividadSi tiene problemas de conexión, asegúrese de que el contenedor Docker tiene acceso al servidor Ollama. Utilice el siguiente comando para resolverlo:

docker run -d --network=host -v open-webui:/app/backend/data -e OLLAMA_BASE_URL=http://127.0.0.1:11434 --name open-webui --restart always ghcr.io/open-webui/open-webui:main - Actualización de la instalación de DockerUtilice Watchtower para actualizar su instalación local de Docker a la última versión:

docker run --rm --volume /var/run/docker.sock:/var/run/docker.sock containrrr/watchtower --run-once open-webui

Desplegar Open WebUI en un clic en Cuddleface

https://codeberg.org/fossandroid/Open-WebUI.git

https://linux.do/t/topic/274417

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...