Los modelos de próxima generación de OpenAI se topan con un gran cuello de botella, según revela un antiguo científico jefe

Orion, el modelo de gran lenguaje de próxima generación de OpenAI, puede estar encontrándose con un cuello de botella sin precedentes. Según The Information, los empleados de OpenAI afirman que las mejoras de rendimiento del modelo Orion no han estado a la altura de las expectativas, y que las mejoras de calidad son "mucho menores" que las de la actualización de GPT-3 a GPT-4.

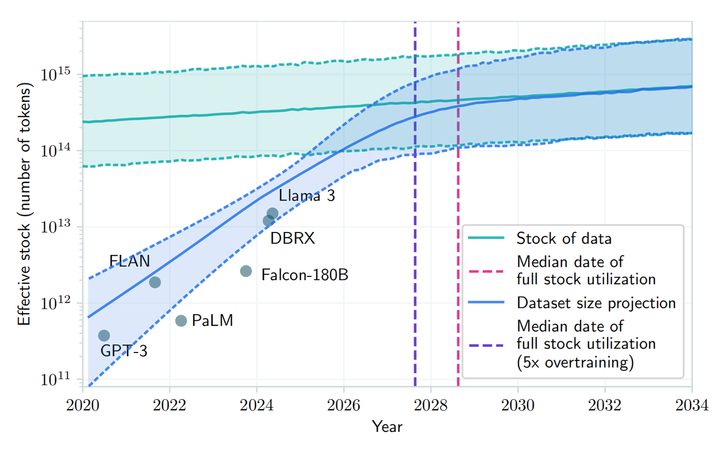

Además, Orion no es tan estable como su predecesor GPT-4 en determinadas tareas. A pesar de las mayores capacidades lingüísticas de Orion, es posible que el rendimiento de programación no supere al de GPT-4. La disminución de los recursos para el entrenamiento de textos de alta calidad y otros datos ha hecho más difícil encontrar datos de entrenamiento de alta calidad, lo que ha ralentizado el desarrollo de los Grandes Modelos Lingüísticos (LLM).

No sólo eso, sino que el entrenamiento futuro será aún más intensivo desde el punto de vista computacional, en términos de dinero e incluso de electricidad, lo que significa que el coste de desarrollar Orion y los grandes modelos lingüísticos posteriores aumentará significativamente. El investigador de openAI Noam Brown declaró recientemente en la conferencia TED AI que los modelos más avanzados pueden ser "económicamente inviables":

¿Realmente vamos a gastar cientos de miles de millones o billones de dólares formando modelos? En algún momento, la ley de la escala se romperá.

OpenAI ha creado un equipo de fundación, dirigido por Nick Ryder, para estudiar cómo hacer frente a la creciente escasez de datos de entrenamiento y cuánto durarán las leyes de escalado de los grandes modelos.

Noam Brown

Las leyes de escalado son uno de los supuestos básicos de la IA: mientras haya más datos aprendibles y más potencia de cálculo para impulsar el proceso de entrenamiento, el rendimiento de un gran modelo lingüístico puede seguir mejorando al mismo ritmo. En pocas palabras, la ley de la escala describe la relación entre la entrada de recursos (cantidad de datos, potencia de cálculo, tamaño del modelo) y el rendimiento del modelo. Es decir, hasta qué punto mejora el rendimiento cuando se invierten más recursos en el modelo lingüístico grande.

Por ejemplo, el entrenamiento de un gran modelo lingüístico puede compararse con la fabricación de un coche: al principio la fábrica es pequeña, con unas pocas máquinas y unos pocos trabajadores, y en ese momento cada máquina o trabajador adicional supone un aumento significativo de la producción porque los recursos adicionales se traducen directamente en productividad. Sin embargo, a medida que la fábrica crece, el aumento de la producción por máquina o trabajador adicional disminuye, posiblemente debido a una mayor complejidad de la gestión o a una colaboración menos eficaz de los trabajadores.

Cuando una fábrica alcanza cierto tamaño, añadir más máquinas o trabajadores puede dar lugar a un aumento más limitado de la producción, momento en el que la fábrica puede estar acercándose a los límites de sus recursos, como el suministro de tierra y la logística. En este punto, la fábrica puede estar acercándose a los límites de sus recursos, como el terreno, el suministro de energía y la logística, y una mayor inversión ya no puede aportar un aumento equivalente de la capacidad de producción. Éste es exactamente el dilema al que se enfrenta el modelo de Orion: a medida que aumenta el tamaño del modelo (de forma similar a cuando se añaden más máquinas y trabajadores), la mejora del rendimiento del modelo es muy significativa en las fases inicial y media, pero en las fases posteriores, aunque se aumente el tamaño del modelo o la cantidad de datos de entrenamiento, la mejora del rendimiento se hace menor. Es lo que se conoce como "toparse con el muro".

Según un artículo publicado en arXiv, se prevé que el desarrollo de grandes modelos lingüísticos podría agotar los recursos públicos de texto humano entre 2026 y 2032 debido a la creciente demanda y la limitada disponibilidad de datos públicos de texto humano. A pesar de señalar que existen "problemas económicos" con la futura formación de modelos, Norm Brown se opone a lo anterior, argumentando que "el desarrollo de la IA no se va a ralentizar a corto plazo".

En general, los investigadores de OpenAI comparten esta opinión y, aunque la ley de la escala puede ralentizarse, el desarrollo general de la IA no se verá afectado de forma significativa por la optimización de los tiempos de inferencia y las mejoras posteriores al entrenamiento.El CEO de Meta, Mark Zuckerberg, el CEO de OpenAI, Sam Altman, y otros CEO desarrolladores de IA El CEO de Meta, Mark Zuckerberg, el CEO de OpenAI, Sam Altman, y otros CEO de desarrolladores de IA también han declarado públicamente que aún no se han alcanzado los límites tradicionales de la ley del escalado y que siguen desarrollando costosos centros de datos para mejorar el rendimiento de los modelos preentrenados.

Peter Welinder, vicepresidente de productos de OpenAI, también ha declarado en las redes sociales que "la gente subestima el poder de la computación en tiempo de prueba". La computación en tiempo de prueba (TTC) es un concepto de aprendizaje automático que se refiere a la computación que se produce cuando un modelo se despliega para hacer inferencias o predicciones sobre nuevos datos de entrada, separada de la computación que se produce durante el entrenamiento. La fase de entrenamiento es el proceso mediante el cual el modelo aprende patrones de datos, mientras que la fase de prueba es el proceso mediante el cual el modelo se aplica a tareas del mundo real.

Los modelos tradicionales de aprendizaje automático suelen predecir nuevas instancias de datos sin cálculos adicionales una vez que han sido entrenados y desplegados. Sin embargo, algunos modelos más complejos, como ciertos tipos de modelos de aprendizaje profundo, pueden requerir computación adicional en el momento de la prueba (tiempo de inferencia). el modelo "o1" desarrollado por OpenAI emplea este tipo de patrón de inferencia. El sector de la IA en su conjunto se está centrando en la fase de optimización del modelo una vez completado el entrenamiento inicial.

Peter Welinder

Ilya Sutskever, uno de los cofundadores de OpenAI, admitió en una entrevista reciente con Reuters que la mejora de la eficacia de la fase de preentrenamiento, que utiliza grandes cantidades de datos sin etiquetar para entrenar a los modelos de IA en la comprensión de patrones y estructuras lingüísticas, se ha estancado. "La década de 2010 fue la era de la expansión, y ahora estamos de vuelta a la era de la exploración y el descubrimiento una vez más", dijo. También señaló: "Mejorar la precisión es más importante que nunca".

El lanzamiento de Orion está previsto para 2025, y OpenAI lo ha bautizado con el nombre de "Orion" en lugar de "GPT-5", insinuando quizá toda una nueva revolución. Aunque actualmente es "difícil de producir" debido a limitaciones teóricas, aún se espera que este recién bautizado "recién nacido" suponga una oportunidad transformadora para el macromodelado de IA.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...