OpenAI lanza una nueva generación de API de modelos de audio, una importante actualización de la tecnología de interacción por voz

OpenAI acaba de anunciar el lanzamiento de su nueva generación de API de modelado de audio, diseñadas para que los desarrolladores puedan crear asistentes de voz más potentes e inteligentes. Esta iniciativa se considera un gran avance en el campo de la tecnología de interacción por voz, y señala que la interacción por voz entre el ser humano y el ordenador dará paso a una nueva fase más natural y eficiente.

La versión incluye dos actualizaciones clave: un modelo de voz a texto más avanzado y un modelo de texto a voz más expresivo que, según OpenAI, establece un nuevo punto de referencia en cuanto a precisión y fiabilidad, especialmente en escenarios difíciles con acentos complejos, entornos ruidosos y velocidades de habla variables. Las mejoras de rendimiento son especialmente significativas en escenarios difíciles, como acentos complejos, entornos ruidosos y velocidades de habla variables. Esto significa que el nuevo modelo mejorará drásticamente la calidad y eficacia de la transcripción en aplicaciones como los centros de atención al cliente y la transcripción de actas de reuniones.

Por primera vez, OpenAI permite a los desarrolladores dar instrucciones a los modelos de texto a voz para que hablen de una manera determinada. Por ejemplo, los desarrolladores pueden configurar el modelo para que "hable como un agente de atención al cliente empático", lo que da a los asistentes de voz un margen de personalización sin precedentes. Esta capacidad abre nuevas puertas a una gran variedad de escenarios, desde un servicio de atención al cliente más humano hasta una narración creativa más expresiva.

OpenAI lanzó su primer modelo de audio, Whisper, en 2022 y desde entonces ha seguido invirtiendo en mejorar la inteligencia, precisión y fiabilidad del modelo. Este lanzamiento de un nuevo modelo de audio es la culminación de ese largo esfuerzo. Ahora, los desarrolladores pueden crear sistemas de voz a texto más precisos, así como sonidos de texto a voz más distintivos y vívidos a través de la API.

Nueva generación de modelos de conversión de voz a texto: gpt-4o-transcribe y gpt-4o-mini-transcribe

OpenAI ha lanzado dos nuevos modelos, gpt-4o-transcribe y gpt-4o-mini-transcribe, que son más nuevos que los anteriores. Susurro muestran mejoras significativas en la tasa de error de palabras (WER), el reconocimiento de idiomas y la precisión.

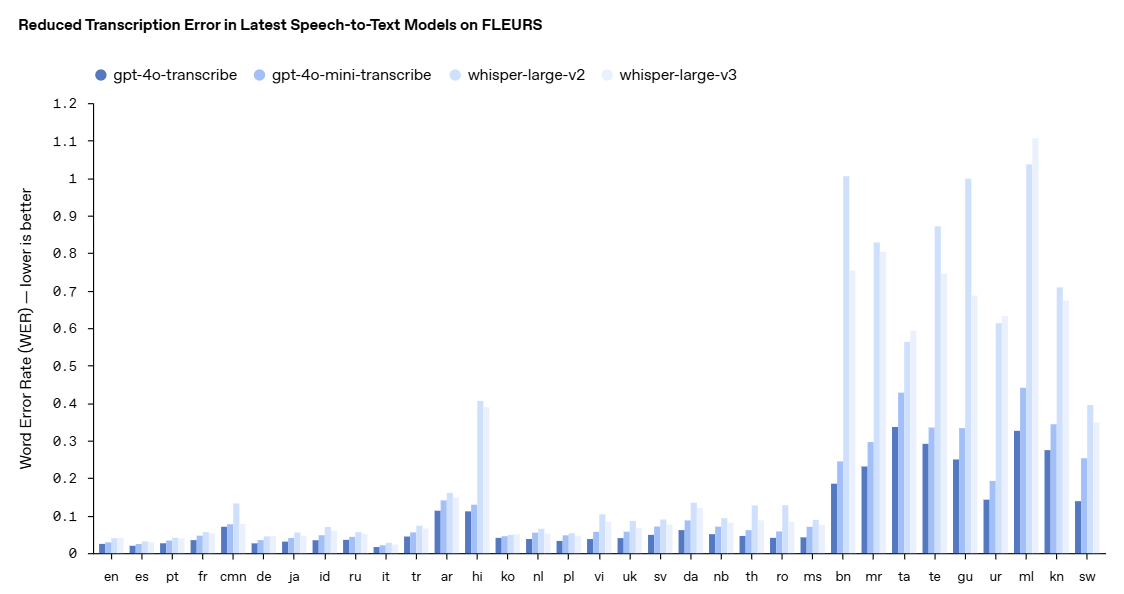

- La tasa de error de palabra (WER) mide la precisión de un modelo de reconocimiento del habla calculando el porcentaje de palabras transcritas incorrectamente en comparación con una transcripción de referencia: cuanto más baja sea la WER, mejor, menos errores. Nuestro último modelo de conversión de voz a texto obtiene una WER baja en varias pruebas de referencia, como FLEURS (Learning Evaluation of Speech Universal Representation with Small Samples), una prueba de referencia multilingüe del habla que abarca más de 100 idiomas y utiliza muestras de audio transcritas manualmente. Estos resultados demuestran una mayor precisión en la transcripción y una mayor cobertura lingüística. Como se muestra aquí, nuestro modelo supera sistemáticamente a Whisper v2 y Whisper v3 en todas las evaluaciones lingüísticas.

gpt-4o-transcribe ha demostrado una tasa de error de palabra superior a la del modelo Whisper en una serie de pruebas de referencia acreditadas. OpenAI afirma que estas mejoras son el resultado de innovaciones específicas en el aprendizaje por refuerzo y el entrenamiento provisional a gran escala con conjuntos de datos de audio diversos y de alta calidad.

Como resultado, los nuevos modelos de voz a texto son más capaces de captar los matices del habla, reducir los errores de reconocimiento y mejorar la fiabilidad de la transcripción, especialmente cuando se trata de situaciones complejas como acentos, entornos ruidosos y velocidades de habla variables. Estos modelos están actualmente abiertos para su uso en la API de conversión de voz a texto.

Para demostrar la mejora del rendimiento de forma más visual, OpenAI cita FLEURS (Few-shot Learning Evaluation of Universal Resultados de la prueba comparativa Representaciones del habla (FLEURS), una prueba comparativa del habla multilingüe que abarca más de 100 idiomas y utiliza muestras de audio transcritas manualmente. Los resultados muestran que el nuevo modelo de OpenAI presenta tasas de error de palabras inferiores a las de Whisper v2 y Whisper v3 en evaluaciones multilingües, lo que demuestra una mayor precisión de transcripción y una cobertura lingüística más amplia.

Nueva generación de modelos de conversión de texto en voz: gpt-4o-mini-tts

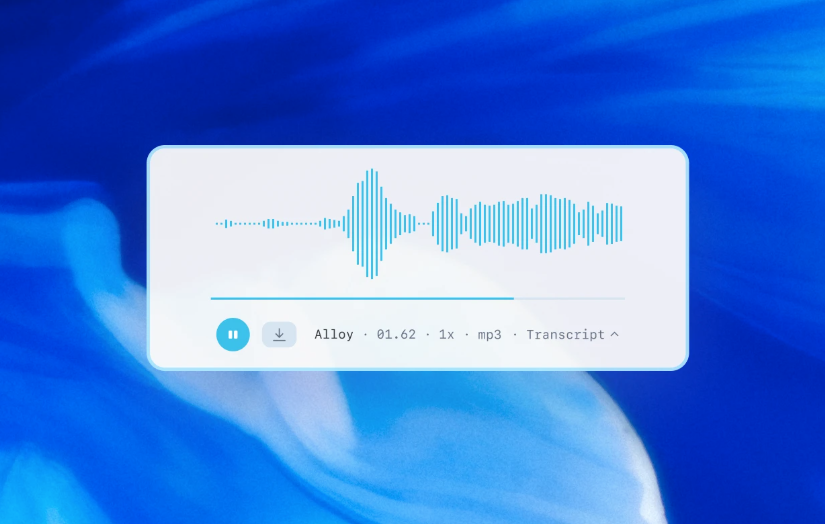

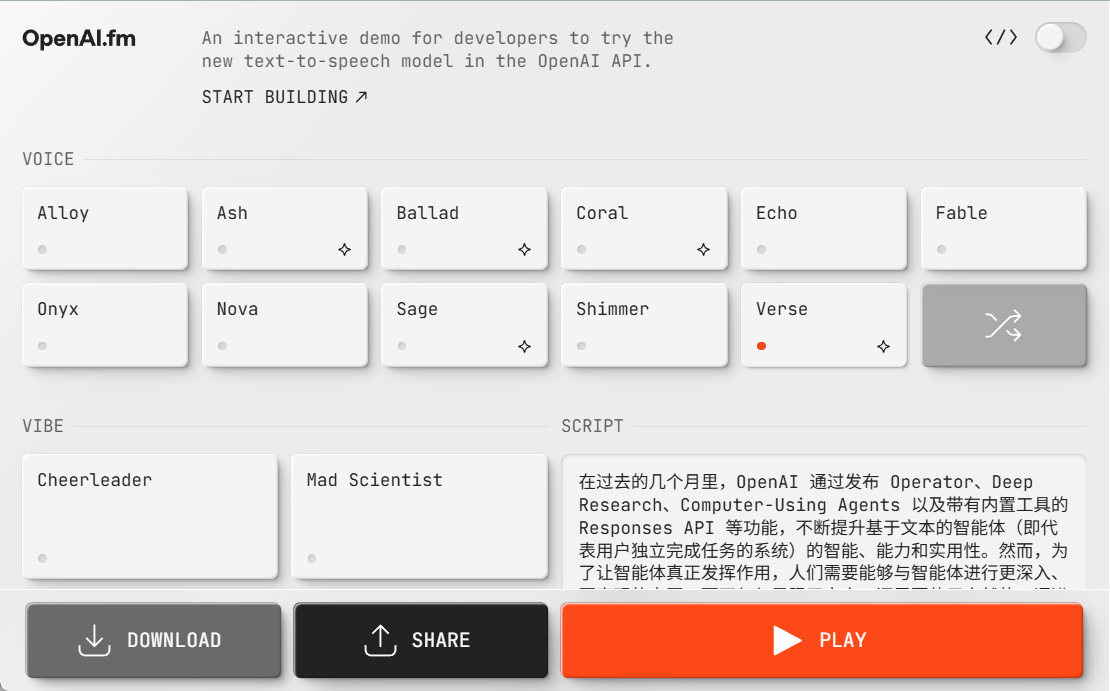

Además del modelo de voz a texto, OpenAI también ha presentado el nuevo modelo de voz a texto gpt-4o-mini-tts, cuya característica más destacada es su mayor capacidad de control. Los desarrolladores no sólo pueden controlar lo que dice el modelo, sino también darle instrucciones sobre cómo decirlo. Esta capacidad aporta más personalización a la experiencia del usuario, con aplicaciones que van desde la atención al cliente hasta los contenidos creativos. El modelo también está disponible en la API de texto a voz. Tenga en cuenta que estos modelos de texto a voz se limitan actualmente a voces sintetizadas preestablecidas, que OpenAI supervisa para garantizar que sean coherentes con las preconfiguraciones sintetizadas.

Echa un vistazo a gpt-4o-mini-tts aquí.

https://www.openai.fm/

La innovación tecnológica del modelo

OpenAI revela que los nuevos modelos de audio se basan en las arquitecturas GPT-4o y GPT-4o-mini y se han preentrenado a escala utilizando conjuntos de datos específicamente orientados al audio, lo que resulta fundamental para optimizar el rendimiento de los modelos. Este enfoque específico permite a los modelos comprender mejor las sutilezas del habla y destacar en diversas tareas relacionadas con el audio.

Además, OpenAI ha mejorado sus técnicas de refinamiento de conocimientos para permitir la transferencia de conocimientos de grandes modelos de audio a modelos pequeños y eficientes. Al aprovechar métodos avanzados de autojuego, su conjunto de datos de refinamiento capta con eficacia la dinámica real del diálogo y reproduce escenarios reales de interacción entre el usuario y el asistente. Esto ayuda a que el modelo pequeño ofrezca una calidad de diálogo y una capacidad de respuesta excelentes.

Para el modelado de voz a texto, OpenAI ha adoptado un paradigma basado en el aprendizaje por refuerzo (RL) para llevar la precisión de la transcripción al siguiente nivel. Este enfoque mejora significativamente la precisión y reduce la alucinación, lo que hace que su solución de voz a texto sea más competitiva en escenarios complejos de reconocimiento del habla.

Estos avances tecnológicos representan los últimos progresos en el campo del modelado de audio, donde OpenAI combina enfoques innovadores con mejoras prácticas destinadas a aumentar el rendimiento de las aplicaciones de voz.

Apertura del API y perspectivas de futuro

Estos nuevos modelos de audio ya están disponibles para todos los desarrolladores. Para los desarrolladores que ya utilizan modelos de texto para crear experiencias de diálogo, la integración de los modelos de voz a texto y de texto a voz es la forma más sencilla de crear asistentes de voz, y OpenAI también ha lanzado la integración con el SDK de Agents para simplificar el proceso de desarrollo. Para los desarrolladores que deseen crear experiencias de voz a voz de baja latencia, OpenAI recomienda utilizar los modelos de voz a voz de la API Realtime.

De cara al futuro, OpenAI tiene previsto seguir invirtiendo más en la inteligencia y precisión de sus modelos de audio y explorar formas de permitir a los desarrolladores introducir sonidos personalizados para crear experiencias más personalizadas, garantizando al mismo tiempo el cumplimiento de sus normas de seguridad. Además, OpenAI está dialogando activamente con responsables políticos, investigadores, desarrolladores y creativos sobre los retos y oportunidades que puede presentar el sonido sintetizado.OpenAI está entusiasmada con las aplicaciones innovadoras que los desarrolladores crearán utilizando estas capacidades de audio mejoradas, y afirma que seguirá invirtiendo en otras modalidades, incluido el vídeo, para ayudar a los desarrolladores a crear experiencias de inteligencia multimodal.

La publicación por OpenAI de una nueva generación de API de modelos de audio ha inyectado sin duda una nueva vitalidad al desarrollo de la tecnología de interacción por voz. Con el progreso continuo de la tecnología y los escenarios de aplicación cada vez más ricos, tenemos motivos para creer que el futuro del mundo digital será más "capaz de escuchar y hablar", y la interacción persona-ordenador será más natural y fluida.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...