Ollama: despliegue nativo con un solo clic de grandes modelos lingüísticos de código abierto

Últimos recursos sobre IAActualizado hace 1 año Círculo de intercambio de inteligencia artificial 84.8K 00

Ollama Introducción general

ollama es un marco ligero para ejecutar modelos lingüísticos nativos, que permite a los usuarios construir y ejecutar fácilmente grandes modelos lingüísticos. Ofrece múltiples opciones de inicio rápido e instalación, soporta Docker, e incluye un rico conjunto de bibliotecas para que los usuarios elijan. Es fácil de usar, proporciona una API REST, y tiene una variedad de plugins y extensiones que se integran con la comunidad.

ollama es una herramienta de línea de comandos pura para ordenadores personales, recomendada para desplegar interfaces de chat locales, tales como: Open WebUI, Lobe Chat, NextChat.

Modifique el directorio de instalación por defecto: https://github.com/ollama/ollama/issues/2859

Lista de características de Ollama

Rápida puesta en marcha de grandes modelos lingüísticos

Compatible con macOS, Windows y Linux

Proporciona bibliotecas como ollama-python, ollama-js, etc.

Incluida Llama 2. MistralModelo preconstruido Gemma et al.

Admite instalaciones locales y en Docker

Proporcionar funciones de modelo personalizadas

Soporte para convertir modelos de GGUF y PyTorch

Proporcionar guía de funcionamiento CLI

Proporcionar compatibilidad con la API REST

Comandos ollama más utilizados

Modelo pull: ollama pull llama3.1

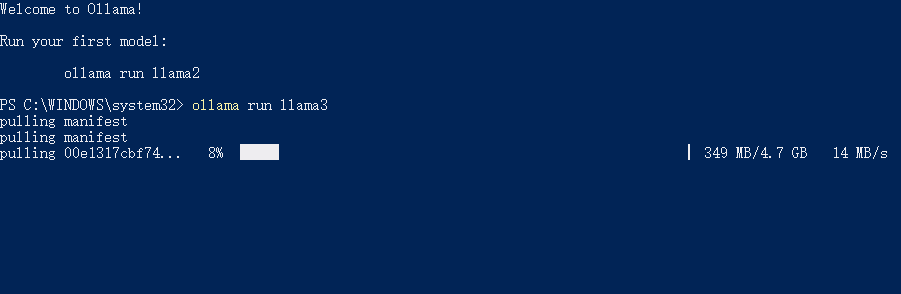

Modelo en ejecución: llama run llama3.1

Borrar modelo: llama rm llama3.1

Lista de todos los modelos disponibles: lista ollama

Dirección del servicio API de consulta: ollama serve (por defecto http://localhost:11434/)

Ayuda Ollama

Guías y scripts de instalación disponibles en el sitio web de ollama y en la página de GitHub

Instalación mediante la imagen Docker suministrada

Creación, extracción, eliminación y copia de modelos mediante operaciones CLI

Inicialización y ejecución de una compilación local

Ejecutar el modelo e interactuar con él

Algunos de los modelos compatibles con Ollama

| Modelo | Parámetros | Talla | Descargar |

|---|---|---|---|

| Llama 2 | 7B | 3,8 GB | ollama run llama2 |

| Mistral | 7B | 4,1 GB | ollama run mistral |

| Delfín Phi | 2.7B | 1,6 GB | ollama run dolphin-phi |

| Phi-2 | 2.7B | 1,7 GB | ollama run phi |

| Chat neuronal | 7B | 4,1 GB | ollama run neural-chat |

| Starling | 7B | 4,1 GB | ollama run starling-lm |

| Código Llama | 7B | 3,8 GB | ollama run codellama |

| Llama 2 sin censura | 7B | 3,8 GB | ollama run llama2-uncensored |

| Llama 2 13B | 13B | 7,3 GB | ollama run llama2:13b |

| Llama 2 70B | 70B | 39 GB | ollama run llama2:70b |

| Orca Mini | 3B | 1,9 GB | ollama run orca-mini |

| Vicuña | 7B | 3,8 GB | ollama run vicuna |

| LLaVA | 7B | 4,5 GB | ollama run llava |

| Gemma | 2B | 1,4 GB | ollama run gemma:2b |

| Gemma | 7B | 4,8 GB | ollama run gemma:7b |

Ollama Descargar

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...