muAgent: un nuevo marco de orquestación de agentes impulsado por LLM y EKG (conocimiento del sector)

Últimos recursos sobre IAActualizado hace 1 año Círculo de intercambio de inteligencia artificial 47.4K 00

Introducción general

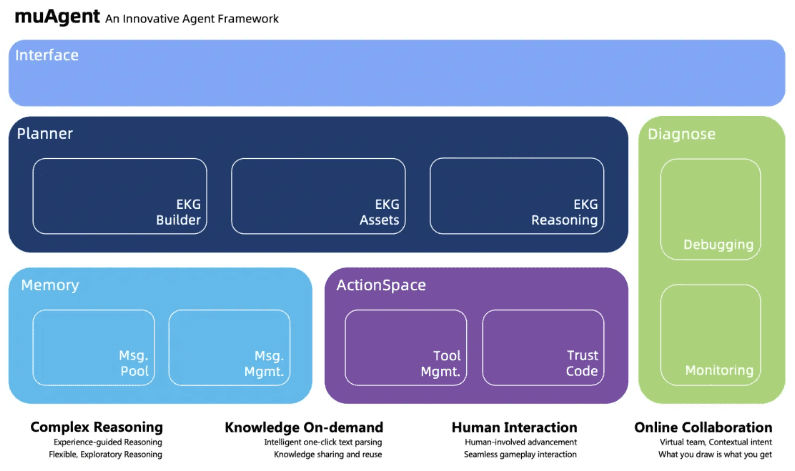

muAgent es un innovador marco de multiinteligentsia desarrollado por Ant Group. El marco ayuda a los usuarios a ejecutar varios Procedimientos Operativos Estándar (SOPs) complejos bajo guía humana a través de canvas drag-and-drop y escritura de texto simple, en colaboración con multi-intelligentsia, llamadas a funciones, intérpretes de código y otras tecnologías. Actualmente, el marco se ha validado en varios escenarios DevOps complejos en Ant Group.

Proporciona funciones de despliegue con un solo clic, incluida la orquestación de agentes basada en KG, el registro y la gestión de herramientas/agentes basados en Java y la interfaz de usuario de productos front-end editable mediante arrastrar y soltar.

Esta es ahora una versión beta. En cuanto se mejore la versión v1.0+, publicaremos la imagen v1.0+ para su descarga.

Para facilitarle la comprensión de toda la cadena CoAgent, adoptamos la forma de un Flujo para explicar en detalle cómo construir un CoAgent mediante la configuración.

Lista de funciones

- inferencia compleja: Admite capacidades de razonamiento multinivel para la ejecución de tareas complejas.

- Colaboración en líneaFunciones de colaboración en línea para facilitar la interacción en tiempo real entre los miembros del equipo.

- interacción humana: Mejorar la precisión y eficacia de la ejecución de tareas mediante la interacción persona-ordenador.

- Conocimientos prácticos: Un diseño basado en grafos de conocimiento que proporciona una adquisición y aplicación instantánea del conocimiento.

Utilizar la ayuda

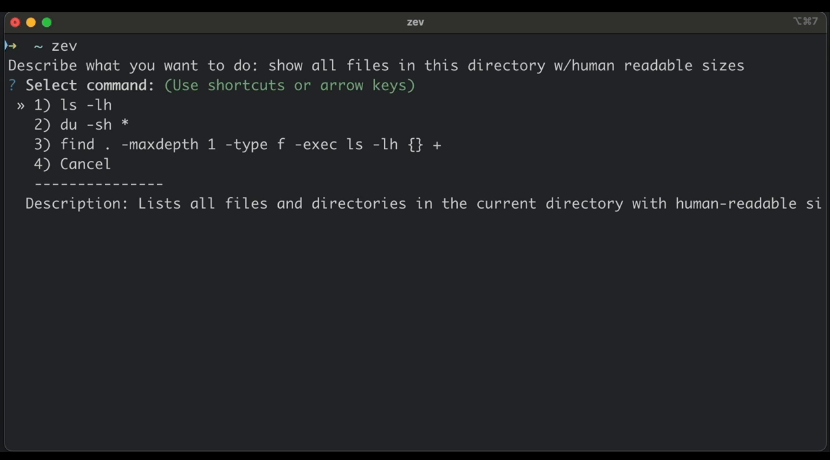

Proceso de instalación

- Clonación del código base: Uso

git clonepara clonar el repositorio GitHub de CodeFuse-muAgent. - Acceso al catálogo: Uso

cd CodeFuse-muAgentVaya al catálogo de proyectos. - Creación de una red Docker: Ejecutar

docker network create ekg-netCrear una red Docker. - Iniciar el servicio de contenedores: Ejecutar

docker-compose up -dInicie todos los servicios de contenedor, lo que puede llevar algún tiempo. - servicio de accesoAbrir en el navegador

https://localhost:8000Acceso a los servicios.

Proceso de utilización

- Configuración de LLM e incrustación de modelosConfigure el modelo lingüístico y el modelo de incrustación pertinentes en función del documento.

- Creación de equipos virtuales: Cree equipos virtuales y escenarios mediante la función de arrastrar y soltar basada en lienzos y la creación de texto.

- Aplicación de los PNTEjecutar procesos SOP complejos mediante la colaboración multiinteligencia bajo dirección humana.

- Depuración y optimización: Utilice herramientas de depuración visual para encontrar y corregir rápidamente errores en los procesos.

- gestión del conocimiento: Gestiona y recupera los mensajes necesarios para diversos escenarios mediante un diseño unificado del pool de mensajes.

Pasos detallados

- Creación de equipos virtualesArrastre y suelte los nodos relevantes en el lienzo para configurar la intención de escena y los nodos semánticos.

- aplicación del mandato: Seleccione la tarea a realizar y el sistema la ejecutará automáticamente según el proceso preestablecido.

- Optimización de la depuración: Visualice los registros y mensajes de error durante la ejecución en la interfaz de depuración y realice los ajustes pertinentes.

- recuperación de conocimientos: Utilice la función de búsqueda de conocimientos integrada para encontrar rápidamente los puntos de conocimiento y las instrucciones de funcionamiento pertinentes.

Descripción del proyecto

Con el fin de mejorar el rendimiento de los modelos de gran tamaño en términos de precisión de la inferencia, han surgido en la industria una serie de innovadores modelos de gran tamaño del lenguaje (LLM). Desde los primeros CoT, ToT y GoT, estos enfoques siguen ampliando los límites de las capacidades de los LLM. Cuando nos enfrentamos a problemas complejos, podemos ReAct proceso para seleccionar, invocar y ejecutar la retroalimentación de la herramienta al tiempo que permite múltiples rondas de uso de la herramienta y la ejecución de múltiples pasos.

Sin embargo, para escenarios más complejos, como el desarrollo de código complejo, un agente LLM de una sola función claramente no está a la altura. Como resultado, la comunidad ha empezado a desarrollar juegos de combinación multiagente, como proyectos centrados en metaGPT, GPT-Engineer, chatDev y otras áreas de desarrollo, así como proyectos centrados en automatizar la construcción de agentes y diálogos de agentes. AutoGen Proyecto.

Tras un análisis en profundidad de estos marcos, se constata que la mayoría de los marcos de Agente presentan un alto grado de acoplamiento global, y su facilidad de uso y extensibilidad son deficientes. Es difícil implementar un escenario específico en un escenario predefinido, pero es difícil ampliar el escenario.

Por lo tanto, queremos construir un marco Multi-Agente extensible y fácil de usar para apoyar a ChatBot en el acceso a la información de la base de conocimientos, y al mismo tiempo, ayudar en el trabajo diario de oficina, análisis de datos, desarrollo, operación y mantenimiento, y otras tareas generales.

El marco Mutli-Agent de este proyecto se inspira en los mejores diseños de varios marcos, como el marco metaGPT grupo de mensajes en autogen, selector de agentes en autogen, etc.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...