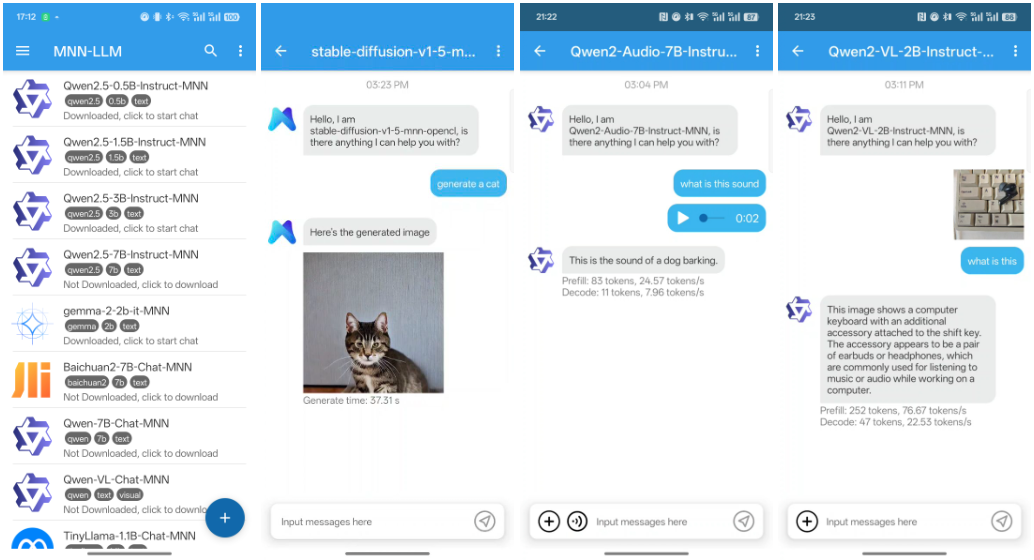

MNN-LLM-Android: modelado lingüístico multimodal MNN para Android

Últimos recursos sobre IAActualizado hace 1 año Círculo de intercambio de inteligencia artificial 72.1K 00

Introducción general

MNN (Mobile Neural Network) es un marco de aprendizaje profundo eficiente y ligero desarrollado por Alibaba y optimizado para dispositivos móviles.MNN no solo permite la inferencia rápida en dispositivos móviles, sino que también admite tareas multimodales, como la generación de texto, la generación de imágenes y el procesamiento de audio, etc.MNN se ha integrado en varias aplicaciones de Alibaba, como Taobao, Tmall, Youku, Nail y Idle Fish, que abarcan más de 70 escenarios de uso, como la transmisión en directo, la captura de vídeos cortos, la recomendación de búsquedas y la búsqueda de imágenes de productos.

Lista de funciones

- apoyo multimodal: Admite una amplia gama de tareas, como generación de texto, generación de imágenes y procesamiento de audio.

- Optimización de la inferencia de la CPU: Consigue un excelente rendimiento de inferencia de la CPU en dispositivos móviles.

- Marco ligeroEl marco está diseñado para ser ligero y adaptarse a las limitaciones de recursos de los dispositivos móviles.

- ampliamente utilizado: Está integrado en varias aplicaciones de Alibaba, cubriendo una amplia gama de escenarios empresariales.

- código abiertoSe proporciona el código fuente abierto completo y la documentación para facilitar la integración y el desarrollo secundario.

Utilizar la ayuda

Proceso de instalación

- Descarga e instalaciónClona el código del proyecto desde un repositorio de GitHub.

git clone https://github.com/alibaba/MNN.git cd MNN

2. **编译项目**:根据项目提供的README文档,配置编译环境并编译项目。

```bash

mkdir build

cd build

cmake ..

make -j4

- Integración en aplicaciones Android: Integre los archivos de biblioteca compilados en el proyecto Android modificando el archivo

build.gradlepara la configuración.

Utilización

capacidad multimodal

MNN admite diversas tareas multimodales, como la generación de texto, la generación de imágenes y el procesamiento de audio. A continuación se ofrecen ejemplos de cómo utilizar estas funciones:

- Generación de textoGeneración de textos mediante modelos lingüísticos preformados.

import MNN interpreter = MNN.Interpreter("text_model.mnn") session = interpreter.createSession() input_tensor = interpreter.getSessionInput(session) # 输入文本进行预处理 input_data = preprocess_text("输入文本") input_tensor.copyFrom(input_data) interpreter.runSession(session) output_tensor = interpreter.getSessionOutput(session) output_data = output_tensor.copyToHostTensor() result = postprocess_text(output_data) print(result) - Generación de imágenes: Generación de imágenes mediante modelos generativos preentrenados.

import MNN interpreter = MNN.Interpreter("image_model.mnn") session = interpreter.createSession() input_tensor = interpreter.getSessionInput(session) # 输入数据进行预处理 input_data = preprocess_image("输入图像") input_tensor.copyFrom(input_data) interpreter.runSession(session) output_tensor = interpreter.getSessionOutput(session) output_data = output_tensor.copyToHostTensor() result = postprocess_image(output_data) print(result) - procesamiento de audio: Generación o procesamiento de audio utilizando modelos de audio preentrenados.

import MNN interpreter = MNN.Interpreter("audio_model.mnn") session = interpreter.createSession() input_tensor = interpreter.getSessionInput(session) # 输入音频数据进行预处理 input_data = preprocess_audio("输入音频") input_tensor.copyFrom(input_data) interpreter.runSession(session) output_tensor = interpreter.getSessionOutput(session) output_data = output_tensor.copyToHostTensor() result = postprocess_audio(output_data) print(result)

Procedimiento de funcionamiento detallado

- Creación de instancias de razonamientoInicializa el modelo MNN y crea una sesión de inferencia.

import MNN interpreter = MNN.Interpreter("model.mnn") session = interpreter.createSession() - Preprocesamiento de datos de entradaPreprocesamiento de los datos de entrada según el tipo de modelo.

input_tensor = interpreter.getSessionInput(session) input_data = preprocess_data("输入数据") input_tensor.copyFrom(input_data) - razonamiento ejecutivo: Ejecuta la sesión de razonamiento.

interpreter.runSession(session) - Tratamiento posterior de los datos de salida: Obtenga la salida y postprocésela.

output_tensor = interpreter.getSessionOutput(session) output_data = output_tensor.copyToHostTensor() result = postprocess_data(output_data) print(result)

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...