MiniMax Primer MiniMax-01 de código abierto, 4M de contexto superlargo, nueva arquitectura, desafío Transformer

"ME" más "introducción a gran escala sin precedentes en entornos de producción". rayo Atención", más "refactorización de software e ingeniería desde el framework hasta el nivel CUDA", ¿qué obtienes?

La respuesta es un nuevo modelo que aúne las capacidades de los modelos superiores y eleve la longitud del contexto al nivel de los 4 millones de tokens.

El 15 de enero, la empresa de macromodelado MiniMax presentó oficialmente su nueva serie de modelos, largamente anunciada: MiniMax-01, que consta del macromodelo lingüístico de base MiniMax-Text-01 y del macromodelo visual multimodal MiniMax-VL-01, desarrollado integrando sobre él un modelo ViT ligero.

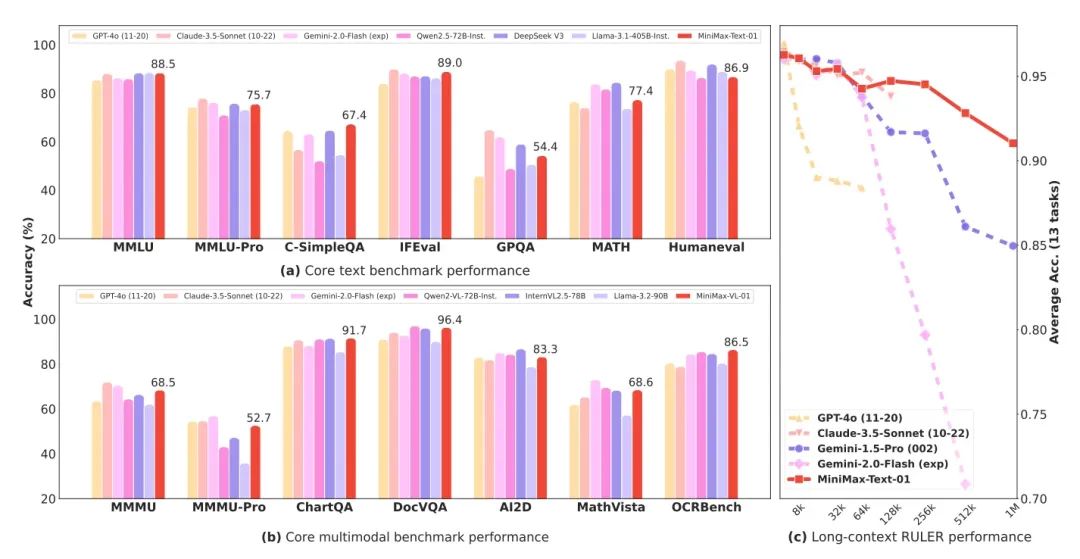

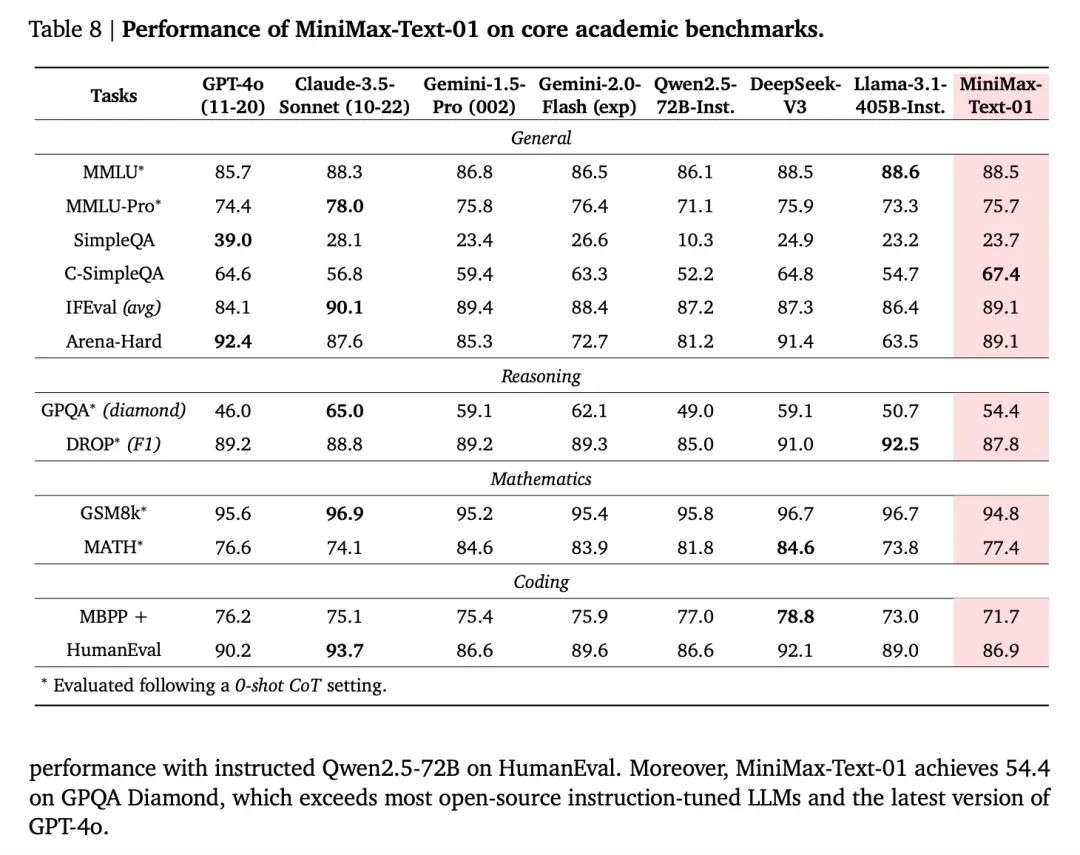

MiniMax-01 es un modelo MoE (Mixed Expert) con 456.000 millones de parámetros totales y 32 Expertos, que está a la par con GPT-4o y Claude 3.5 sonnet en términos de potencia combinada en varios conjuntos de revisión de la corriente principal, mientras que al mismo tiempo tiene 20-32 veces la longitud de contexto de los mejores modelos actuales, y con longitudes de entrada más largas, es también el modelo con el decaimiento de rendimiento más largo. es el modelo con el declive de rendimiento más lento. Es decir, es un contexto real de 4 millones de tokens.

- Macromodelo lingüístico básico MiniMax-Text-01, macromodelo visual multimodal MiniMax-VL-01

- La nueva arquitectura de atención de Lightning, de cuadrada a lineal, reduce drásticamente los costes de inferencia

- Código abierto pesado, parámetros de modelo de texto de hasta 456.000 millones, 32 expertos

- Contexto ultra-ultra-largo de 4 millones de palabras y rendimiento a la altura de los mejores modelos extranjeros.

- Se han publicado el modelo, el código y el informe técnico, ¡muy sinceramente!

Tanto la experiencia web como la API ya están disponibles en línea y comercialmente en la dirección que figura al final del artículo.

Nuevas tecnologías: Atención relámpago

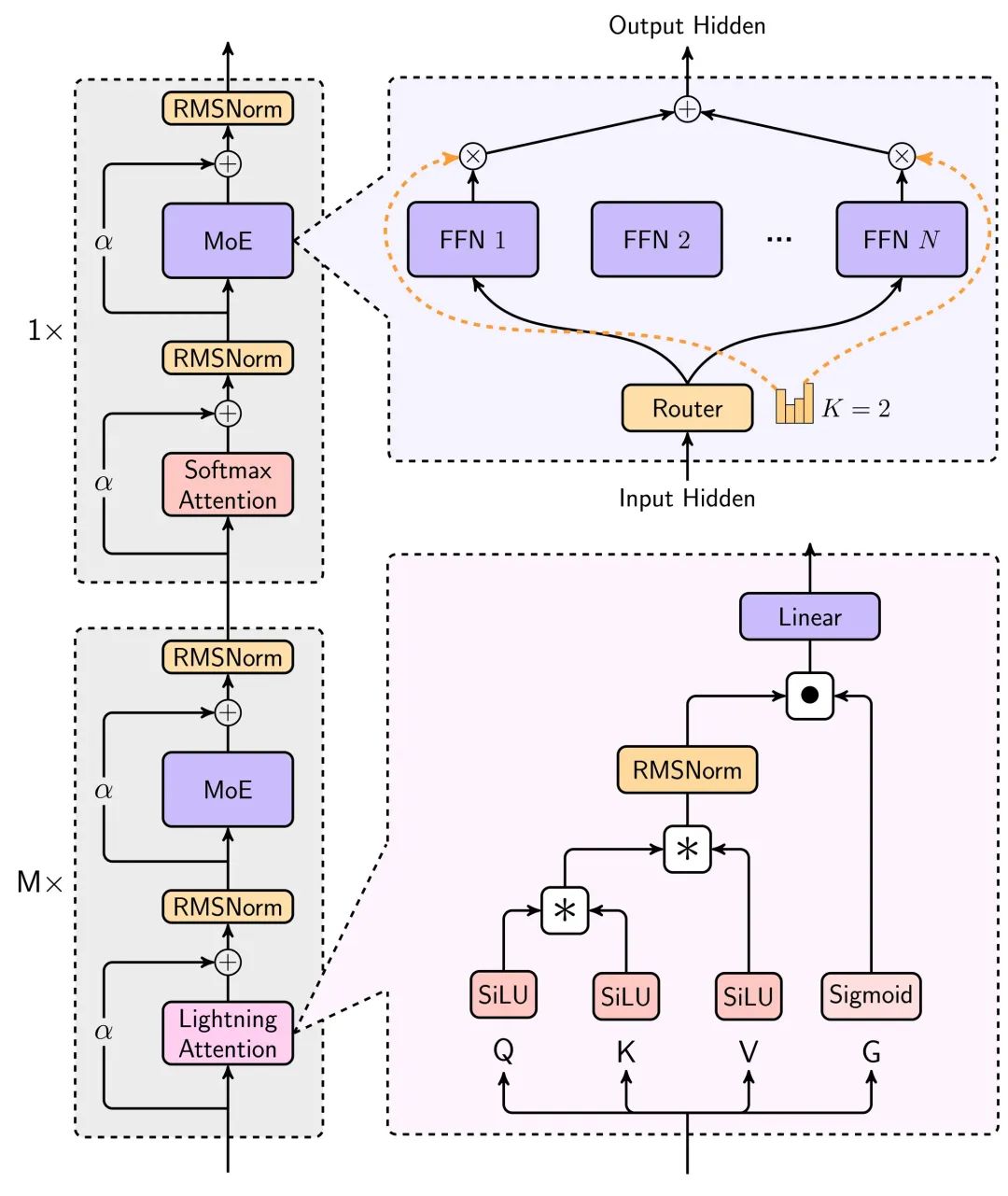

Lo más sorprendente de este modelo es la nueva arquitectura de atención lineal.

Todos sabemos que en el uso real de AI, texto largo es crucial, la larga memoria de chat de caracteres, AI Codificación para escribir código, Agente para completar una variedad de tareas, que escenario es inseparable del texto largo.

Los grandes modelos han ido bajando de precio, pero cuanto mayor es el contexto en el que se utilizan, más lentos y caros se vuelven.

La raíz de este problema es Transformador La arquitectura tiene una complejidad computacional cuadrática. El consumo aritmético del razonamiento aumenta exponencialmente a medida que aumenta el contexto.

Esta vez, el nuevo modelo de MiniMax utiliza el mecanismo de atención Lightning, un mecanismo de atención lineal que puede reducir significativamente el tiempo de cálculo e inferencia para textos largos.

Los principales diagramas arquitectónicos de esta modelización pueden verse en el informe técnico.

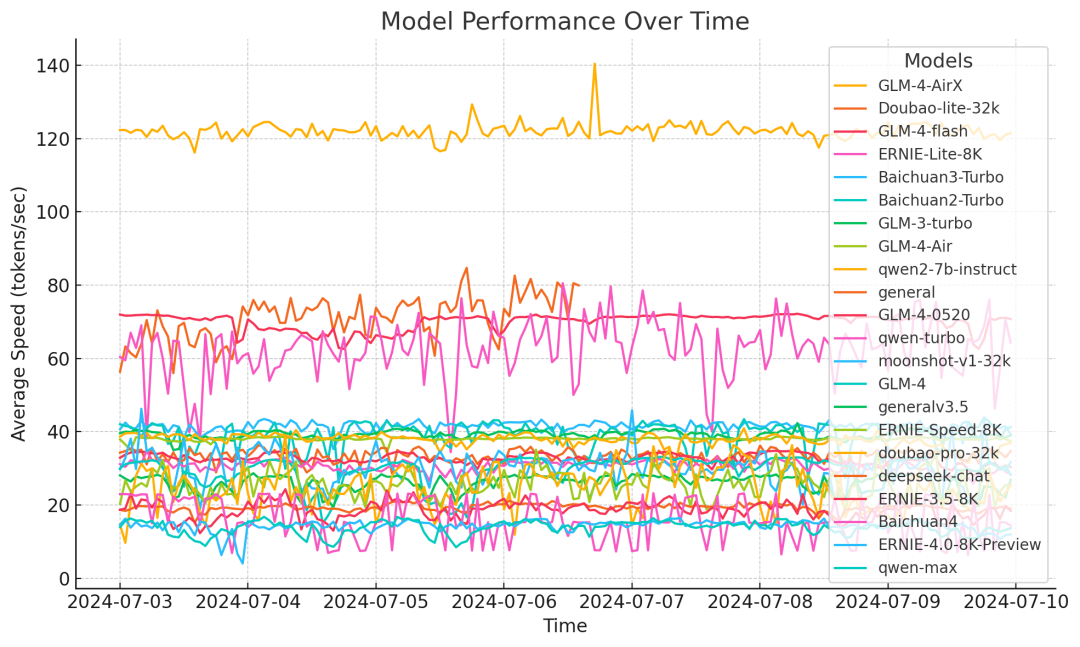

La reducción del consumo de recursos de inferencia del modelo gracias a esta arquitectura es enorme, como puede verse en el siguiente gráfico de comparación de tiempos de inferencia para textos largos, en el que se utiliza la atención lineal para permitir que los tiempos de inferencia aumenten lentamente de forma casi lineal, en lugar de exponencial, a medida que aumenta el contexto.

Encontrará una descripción más detallada en el informe técnico que figura al final del artículo.

El cálculo se reduce, el precio baja y el rendimiento no puede perderse durante mucho tiempo para que el texto sea realmente utilizable.

El gráfico siguiente muestra el rendimiento de Text-1 en el conjunto de evaluación de textos muy largos, donde supera sorprendentemente al intervalo de longitudes de 512K+. Géminis 2.0 Flash.

Otro punto muy interesante del informe técnico es que la capacidad de aprendizaje en contexto del modelo, que aumenta gradualmente a medida que mejora el contexto, puede ser de gran ayuda para la escritura de IA, así como para tareas que requieren memorias largas.

En general, la aplicación del mecanismo de atención Lightning hace que la usabilidad del texto largo para modelos grandes aumente drásticamente, y el precio tiene posibilidades de bajar otro orden de magnitud, en el futuro, merece mucho la pena.

Modelo de rendimiento, nivelación de la primera línea

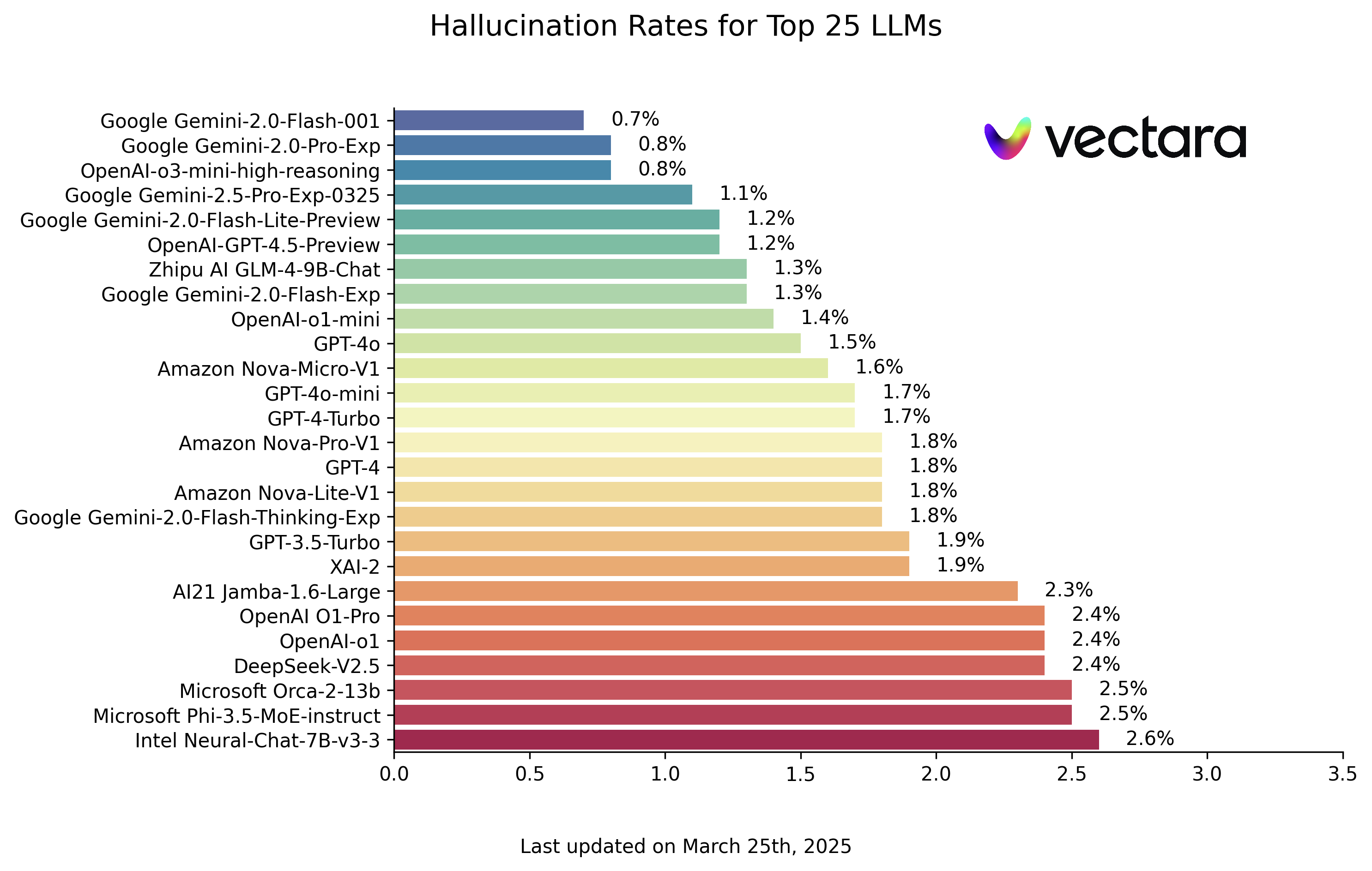

En cuanto a las métricas de rendimiento del modelo, como modelo de código abierto, alcanza a los mejores modelos de código cerrado del extranjero en muchas métricas.

Y como el modelo cuenta con la retroalimentación de la plataforma Conch para su optimización e iteración, la experiencia del usuario en escenarios reales también está garantizada.

El uso oficial de los escenarios de uso de los usuarios reales para construir un conjunto de pruebas, se puede ver que el rendimiento en escenarios reales es también muy brillante, especialmente prominentes escenarios son tres: la escritura creativa, pruebas de conocimientos, texto largo.

Además, el modelo de comprensión visual MiniMax-VL-01 rendimiento, básicamente en todos los índices para igualar o superar los modelos superiores en el extranjero, especialmente práctico OCR y escenas de gráficos.

Próximo momento Transformer

Cuando las iteraciones generacionales de los modelos dejan de ser feroces, la longitud del contexto y el razonamiento lógico se convierten en las dos direcciones más enfocadas.

En términos de contexto, Gemini fue en su día el más largo. Además, el director general de DeepMind, Demsi Hassabis, ha revelado que, dentro de Google, el modelo Gemini ya ha alcanzado 10 millones de longitudes de token en experimentos y se cree que con el tiempo "alcanzará longitudes infinitas", pero lo que está impidiendo que Gemini lo haga ahora es su coste correspondiente. Pero lo que impide a Gemini hacerlo ahora es su coste correspondiente. En una entrevista reciente, dijo que Deepmind tiene ahora un nuevo enfoque para resolver este problema de costes.

Por tanto, quien consiga aumentar primero la longitud del contexto y reducir al mismo tiempo el coste, probablemente tendrá las de ganar. A juzgar por los resultados demostrados por MiniMax-01, realmente ha conseguido una mejora cualitativa de la eficacia.

En este exhaustivo informe técnico, la eficiencia en el uso del hardware puede apreciarse en una estadística: por inferencia, MiniMax alcanza 75% MFU en GPU H20. Es una cifra bastante alta.

MFU (Machine FLOPs Utilization) se refiere a la utilización real de la potencia de cálculo del hardware (FLOPs, es decir, operaciones en coma flotante por segundo) por parte de un modelo durante su funcionamiento. En resumen, MFU describe si un modelo aprovecha al máximo el rendimiento del hardware. Un alto grado de utilización conlleva sin duda ventajas económicas.

El MiniMax 01 es sin duda una de las escasas sorpresas en el reciente debate sobre la muerte.Otro que ha generado mucho debate recientemente es DeepSeek V3. Como ya se ha mencionado, dos direcciones importantes hoy en día, una en inferencia y otra en contextos más largos, están representadas por Deepseek V3 y MiniMax-01 cada una.

Curiosamente, en lo que respecta a la ruta técnica, en cierta medida ambos están optimizando el mecanismo central de atención en Transformer que sentó las bases para el auge actual, y es una refactorización audaz, hardware y software en uno. deepSeek V3 se ha descrito como ordeñar las tarjetas de Nvidia hasta dejarlas secas, y es crucial para la capacidad de MiniMax de lograr un MFU de inferencia tan alto que también están Optimizan directamente el marco de entrenamiento y el hardware.

Según el informe de MiniMax, han desarrollado un kernel CUDA para la atención lineal directamente por su cuenta, paso a paso y en profundidad, desde cero, y han desarrollado varios marcos de trabajo complementarios con este fin para optimizar el uso eficiente de los recursos de la GPU. Ambas compañías han logrado sus objetivos gracias a una mayor integración de las capacidades de hardware y software.

Otra observación interesante es que estas dos empresas destacadas son empresas que ya han invertido en la investigación y el desarrollo de la tecnología de grandes modelos antes de la aparición de ChatGPT, y lo sorprendente de estos dos modelos no es en el modo de "ponerse al día con GPT4" que estamos acostumbrados a ver en el pasado, sino que, de acuerdo con su propio juicio sobre la evolución de la tecnología, hicieron fuertes inversiones e incluso algunas apuestas en innovación, y entregaron la respuesta después de una serie de trabajo sostenido y sólido. En lugar de ello, basándose en su propio juicio sobre la evolución de la tecnología, realizaron fuertes inversiones e incluso algunas apuestas en innovación, y entregaron la respuesta tras una serie de trabajo sólido y sostenido.

Y ninguna de estas respuestas es sólo para ellos mismos, todos están tratando de demostrar que algún concepto que alguna vez estuvo atascado en el laboratorio puede tener el efecto que promete cuando se despliega a escala en escenarios del mundo real, y al hacerlo, permite que más personas continúen optimizándolo.

Recuerda a cuando apareció Transformer.

Cuando el mecanismo de Atención también se había hecho viral en el laboratorio, pero la polémica seguía abierta, fue Google, que creía en su potencial, quien realmente amontonó la aritmética y los recursos para llevarlo de un experimento teórico a algo real implantado a gran escala. Lo siguiente es que la gente acudió en masa a la ruta probada hacia la prosperidad actual.

Con Transformer apilando más capas unas sobre otras y utilizando más potencia, y el MiniMax-01 de hoy intentando revisar el viejo mecanismo de atención, todo es un poco déjà vu. Incluso el famoso título del artículo "Attention is all you need" (La atención es todo lo que necesitas), dado por un investigador de Google para enfatizar el mecanismo de atención, es perfecto para MiniMax: la atención lineal es todo lo que necesitas - - - - - - - - - - -La atención es todo lo que necesitas.

"Actualmente, el modelo aún conserva 1/8 de la atención softmax normal. Estamos trabajando en arquitecturas más eficientes que acabarán eliminando por completo la atención softmax, lo que permitirá lograr ventanas de contexto ilimitadas sin sobrecarga computacional."

Precio del modelo

Entrada: 1 $/millón ficha

Rendimiento: 8 $/millón de fichas

Básicamente úsalo con los ojos cerrados.

Recursos de modelización

Código:https://github.com/MiniMax-AI/MiniMax-01

Modelos:https://huggingface.co/MiniMaxAI/MiniMax-Text-01, https://huggingface.co/MiniMaxAI/MiniMax-VL-01

Informe técnico:https://filecdn.minimax.chat/_Arxiv_MiniMax_01_Report.pdf

Lado web:https://hailuo.ai

API. https://www.minimaxi.com/

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...