Ming-UniAudio - Modelo de generación multimodal de audio unificado de código abierto Ant

Últimos recursos sobre IAPublicado hace 5 meses Círculo de intercambio de inteligencia artificial 32.1K 00

¿Qué es Ming-UniAudio?

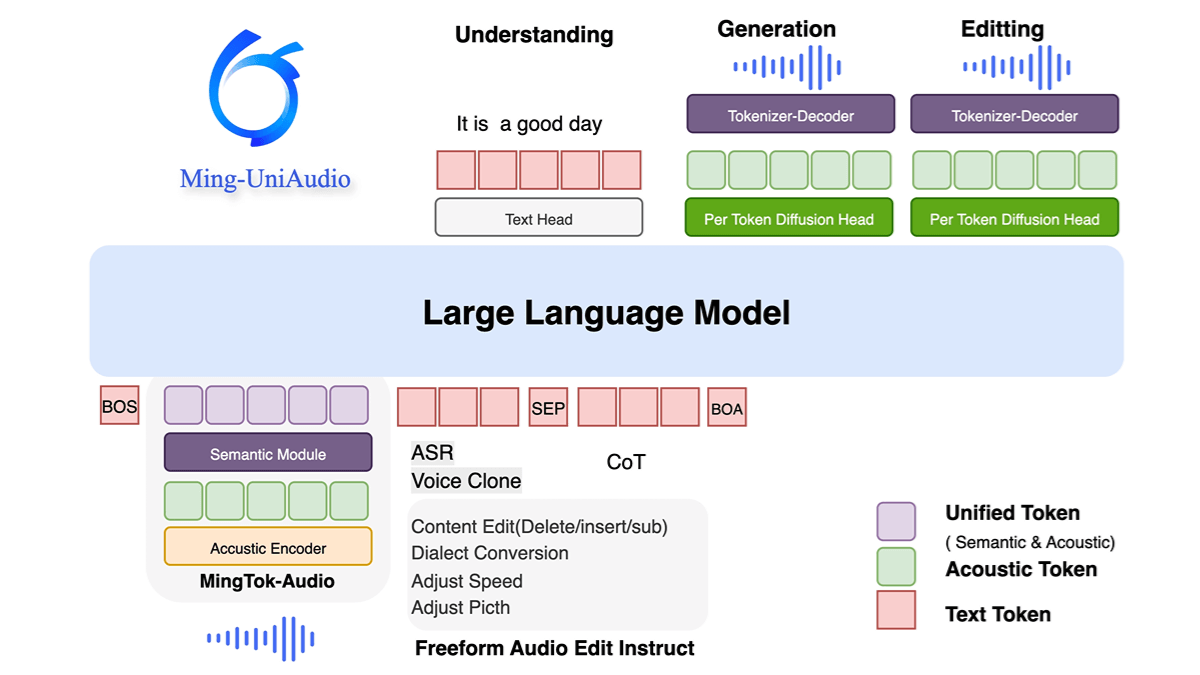

Ming-UniAudio es el modelo de generación multimodal de audio unificado de código abierto de Ant Group que admite entrada y salida mixta de texto, audio, imagen y vídeo. Adopta la arquitectura Multi-scale Transformer and Mixed Expert (MoE) y gestiona eficazmente la información multimodal mediante un mecanismo de enrutamiento que tiene en cuenta la modalidad, lo que mejora significativamente la eficiencia computacional. El modelo ofrece buenos resultados en tareas de síntesis del habla, clonación de huellas vocales, generación multidialectal y transmodalidad de audio y texto, y es capaz de generar información de alta calidad en tiempo real. La función de código abierto proporciona una solución escalable para que la comunidad investigadora promueva el desarrollo de la tecnología multimodal y la innovación de las aplicaciones prácticas.

Características de Ming-UniAudio

- Tratamiento multimodal unificado: Admite la entrada y generación mixta de audio, texto, imágenes y vídeo para un modelado e interacción unificados en todas las modalidades.

- Síntesis y clonación de voz de extremo a extremoGeneración de voz de alta calidad, clonación multidialectal y personalización de la huella vocal.

- Entrenamiento conjunto multimisiónProcessing multiple audio types through discrete sequence tokenisation, combined with LLM for joint training and fine-tuning, adapted to unseen tasks.

- Arquitectura informática eficiente: Adopción de una estructura de transformador multiescala para optimizar el diseño del códec y mejorar la eficiencia y la calidad de la generación.

Principales ventajas de Ming-UniAudio

- Capacidad unificada de procesamiento multimodal: Admite la entrada y generación mixta de audio, texto, imágenes y vídeo, lo que permite un modelado e interacción unificados en todas las modalidades a través de un único modelo, sin necesidad de depender de varios modelos independientes.

- Arquitectura informática eficienteEl diseño multiescala de Transformador y MoE (Mixed Expert), combinado con mecanismos de enrutamiento específicos para cada modalidad, mejora significativamente la eficiencia computacional y la utilización de recursos.

- Síntesis y clonación de voz de alta calidadEl descodificador de audio avanzado integrado admite la generación de voz en varios dialectos, la personalización de la huella vocal y la respuesta en tiempo real, y destaca por la naturalidad y adaptabilidad del habla.

- Cooptimización multitareaOptimización simultánea de tareas perceptivas y generativas mediante la tokenización de secuencias discretas y estrategias de entrenamiento por fases, alcanzando niveles punteros en pruebas de referencia como la comprensión de audio y la generación de textos.

- Código abierto y escalabilidad: Código y pesos del modelo totalmente abiertos para apoyar la investigación y el desarrollo ulteriores en la comunidad, y promover la popularización de la tecnología multimodal y la innovación en las aplicaciones.

¿Cuál es la página web oficial de Ming-UniAudio?

- Página web del proyecto:: https://xqacmer.github.io/Ming-Unitok-Audio.github.io/

- Repositorio Github:: https://github.com/inclusionAI/Ming-UniAudio

- Biblioteca de modelos HuggingFace:: https://huggingface.co/inclusionAI/Ming-UniAudio-16B-A3B

Personas para las que Ming-UniAudio es adecuado

- Investigación y desarrollo de IA: Se necesita un modelo multimodal unificado para las tareas de procesamiento y generación de híbridos de audio, texto, imagen y vídeo.

- Aplicadores de tecnología vocal: Centrado en la síntesis del habla, la clonación de voces y la generación multidialectal, por ejemplo, asistentes inteligentes, creadores de contenidos de audio.

- Equipo de productos multimodales: Buscar arquitecturas informáticas eficientes y soluciones de código abierto para integrar capacidades perceptivas y generativas en aplicaciones del mundo real.

- Demanda de optimización de recursos informáticosPreocupación por la eficacia del modelo, necesidad de utilizar el ME con mecanismos de encaminamiento modal para mejorar la utilización de los recursos.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...