WebGPU de razonamiento de Llama 3.2: ejecución de Llama-3.2 en un navegador

Introducción general

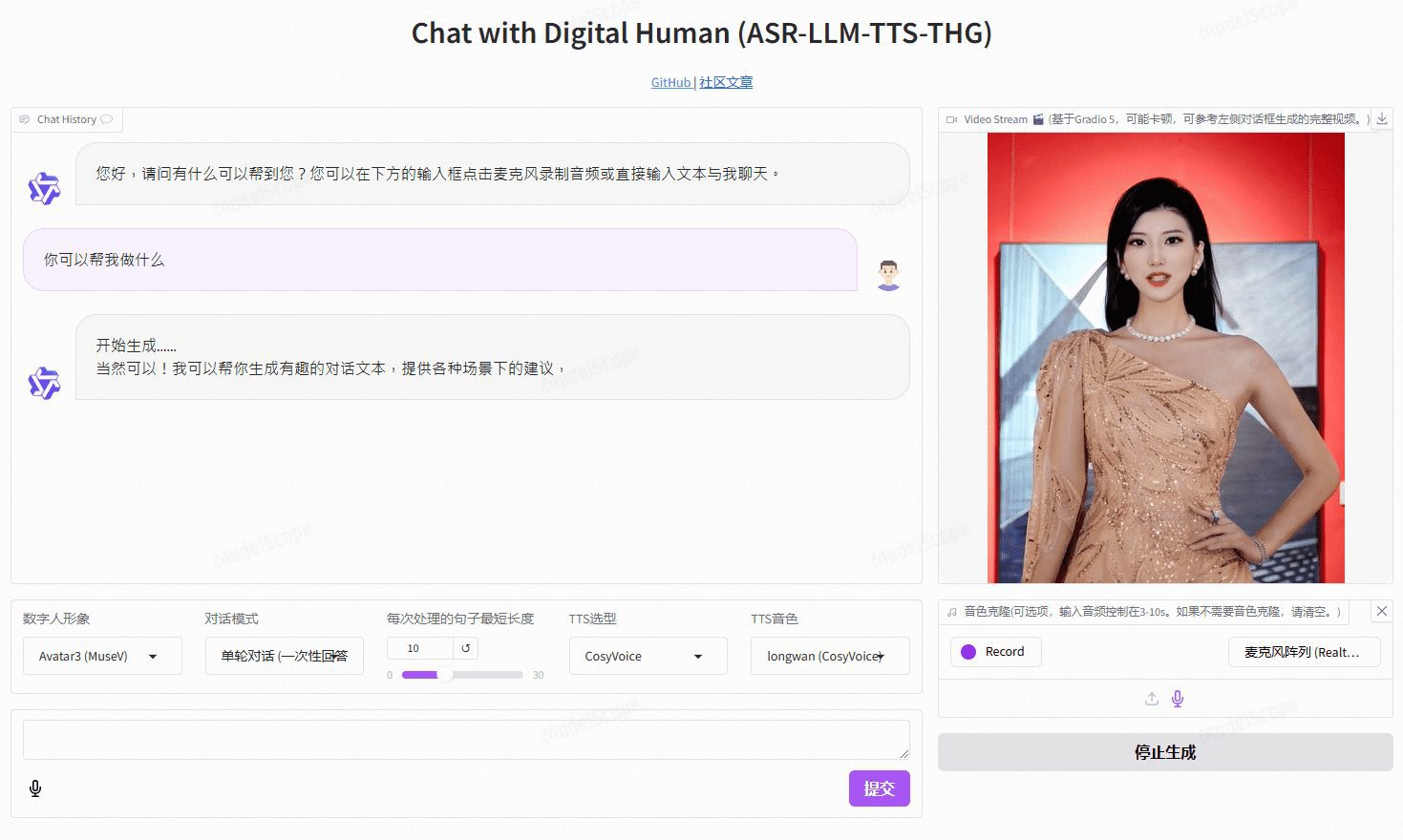

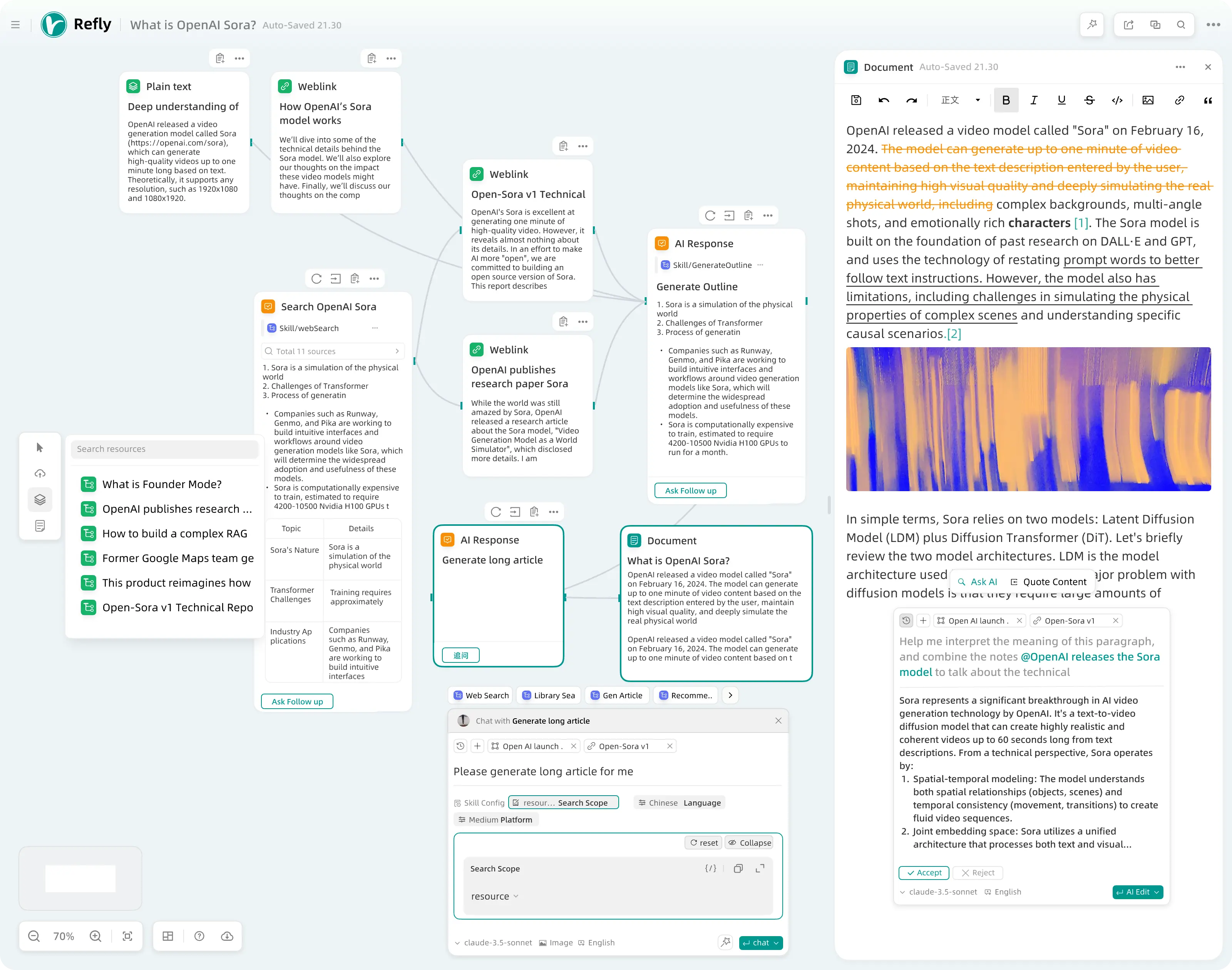

Transformers.js es una biblioteca JavaScript proporcionada por Hugging Face diseñada para ejecutar modelos de aprendizaje automático de última generación directamente en el navegador sin soporte de servidor. La biblioteca es funcionalmente equivalente a la biblioteca de transformadores de Hugging Face para Python y admite una amplia gama de modelos y tareas preentrenados, incluidos el procesamiento del lenguaje natural, la visión por ordenador y el procesamiento de audio. El ejemplo "llama-3.2-reasoning-webgpu" de este proyecto está diseñado para demostrar las capacidades de razonamiento del modelo LLama-3.2 en la WebGPU, permitiendo a los usuarios experimentar el razonamiento eficiente de modelos lingüísticos directamente en el navegador. Este ejemplo no sólo demuestra el estado del arte de la tecnología, sino que también proporciona información sobre cómo se puede aprovechar la potencia computacional de los navegadores modernos para manejar tareas complejas de IA.

Lista de funciones

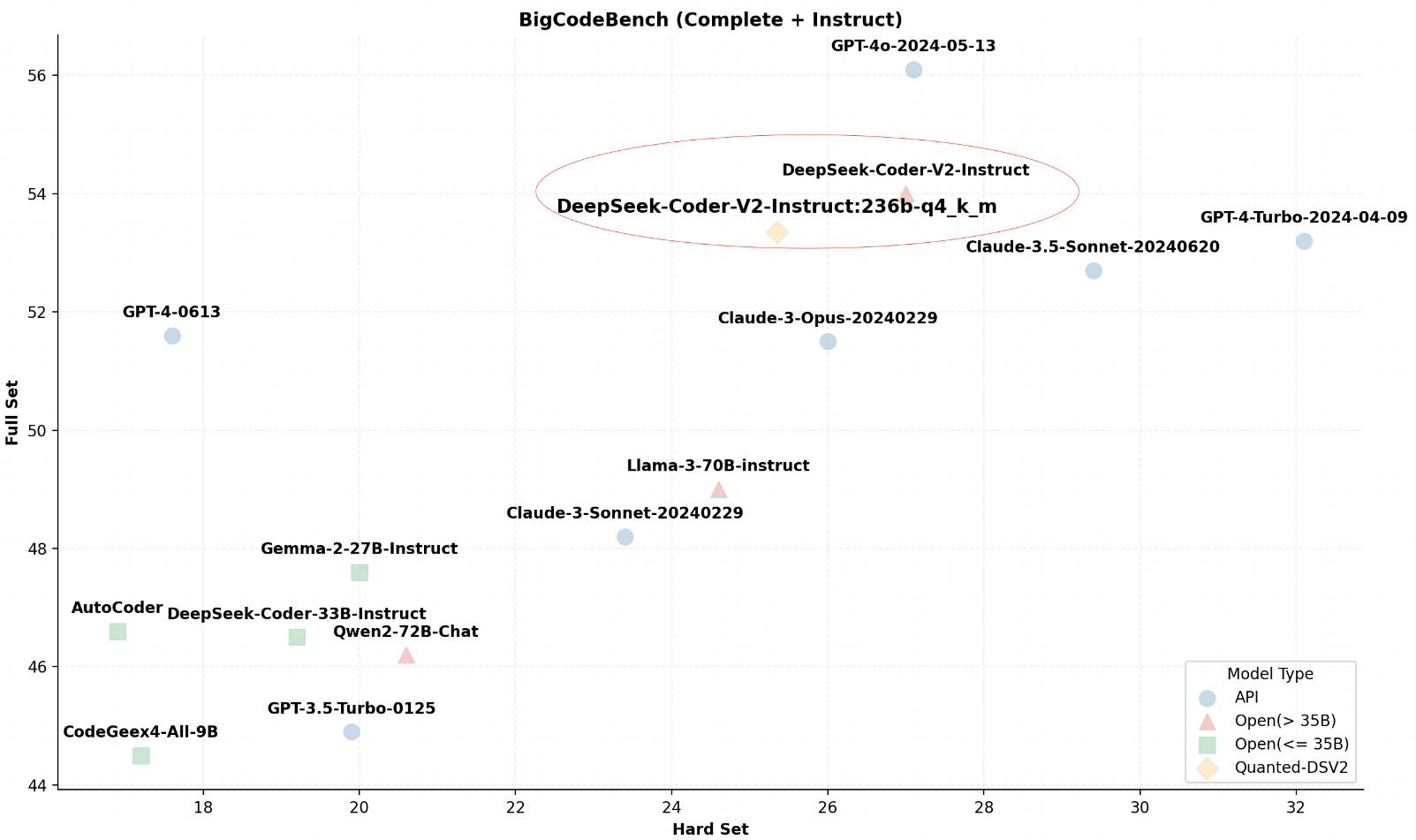

- Ejecución del modelo LLama-3.2 en un navegadorAprovechamiento de la tecnología WebGPU para la inferencia eficiente de modelos.

- Demostración del rendimiento de WebGPU: Destaca la superioridad de las WebGPU comparando el rendimiento en distintos dispositivos.

- Proporcionar una experiencia de usuario interactivaLos usuarios pueden interactuar con el modelo a través de una interfaz sencilla, introduciendo texto y obteniendo los resultados de la inferencia del modelo.

- Ejemplos de código y tutorialesIncluye ejemplos completos de código e instrucciones para configurar y ejecutar el modelo LLama-3.2.

Utilizar la ayuda

Entorno de instalación y configuración

Dado que este ejemplo se ejecuta en un entorno de navegador, no es necesario realizar ningún paso de instalación especial, pero sí debes asegurarte de que tu navegador es compatible con WebGPU.A continuación se indican los pasos para utilizarlo:

- Comprobación de la compatibilidad del navegador::

- Al abrir la página de muestra, el navegador comprueba automáticamente si la WebGPU es compatible y, si no lo es, la página muestra un aviso apropiado.

- WebGPU es compatible actualmente con las últimas versiones de Chrome, Edge y Firefox. Para los usuarios de Safari, puede ser necesario activar funciones experimentales específicas.

- Visite la página de muestras::

- Acceso directo a través de un enlace en GitHub

llama-3.2-reasoning-webgpuLa página de ejemplo del

- Acceso directo a través de un enlace en GitHub

ejemplo de uso

- Modelos de carga::

- Una vez cargada la página, se iniciará automáticamente la carga del modelo LLama-3.2. El proceso de carga puede tardar unos minutos en función de la velocidad de Internet y el rendimiento del dispositivo.

- texto introducido::

- Una vez cargada la página, verás un cuadro de introducción de texto. Introduzca en ese cuadro el texto sobre el que desea razonar.

- proceso de razonamiento::

- Haga clic en el botón "Razonar" y el modelo empezará a procesar sus datos. Tenga en cuenta que el proceso de razonamiento puede llevar algún tiempo, dependiendo de la longitud y complejidad del texto.

- Ver resultados::

- El modelo LLama-3.2 genera resultados de inferencia a partir de la información introducida por el usuario, que puede ser una respuesta a una pregunta, una traducción o algún tipo de procesamiento del texto.

- Depuración y control del rendimiento::

- Al realizar la inferencia, la página puede mostrar estadísticas de rendimiento, como la velocidad de inferencia (tokens por segundo, TPS). Esto le ayuda a comprender las capacidades de la WebGPU y el rendimiento del dispositivo actual.

Más estudios y exploraciones

- Estudio del código fuentePara hacerse una idea de lo que está pasando, puede consultar el código fuente en GitHub (especialmente la sección

worker.js) para saber cómo funciona el modelo en el navegador. - Modificaciones y aportaciones: Si estás interesado, puedes clonar este proyecto para realizar cambios o contribuir con nuevas funcionalidades. El proyecto utiliza el Reaccione y Vite, y si está familiarizado con estas herramientas, puede desarrollar con relativa facilidad.

advertencia

- Compatibilidad con navegadoresAsegúrate de que tu navegador está actualizado para disfrutar de la mejor experiencia.

- dependencia del rendimientoComo la inferencia tiene lugar en el lado del cliente, el rendimiento se ve afectado por el hardware del dispositivo (especialmente la GPU).

- empresa privadaLa privacidad de los datos: todo el procesamiento de datos se realiza localmente y no se carga en un servidor, protegiendo así la privacidad de los datos de los usuarios.

Con estos pasos e instrucciones, podrás explorar y utilizar plenamente este proyecto de ejemplo para experimentar el avance de la tecnología de IA en tu navegador.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...