Evaluación comparativa multimodal de la inteligencia artificial generativa entre dispositivos con Nexa Compressed Inference

Resumen ejecutivo

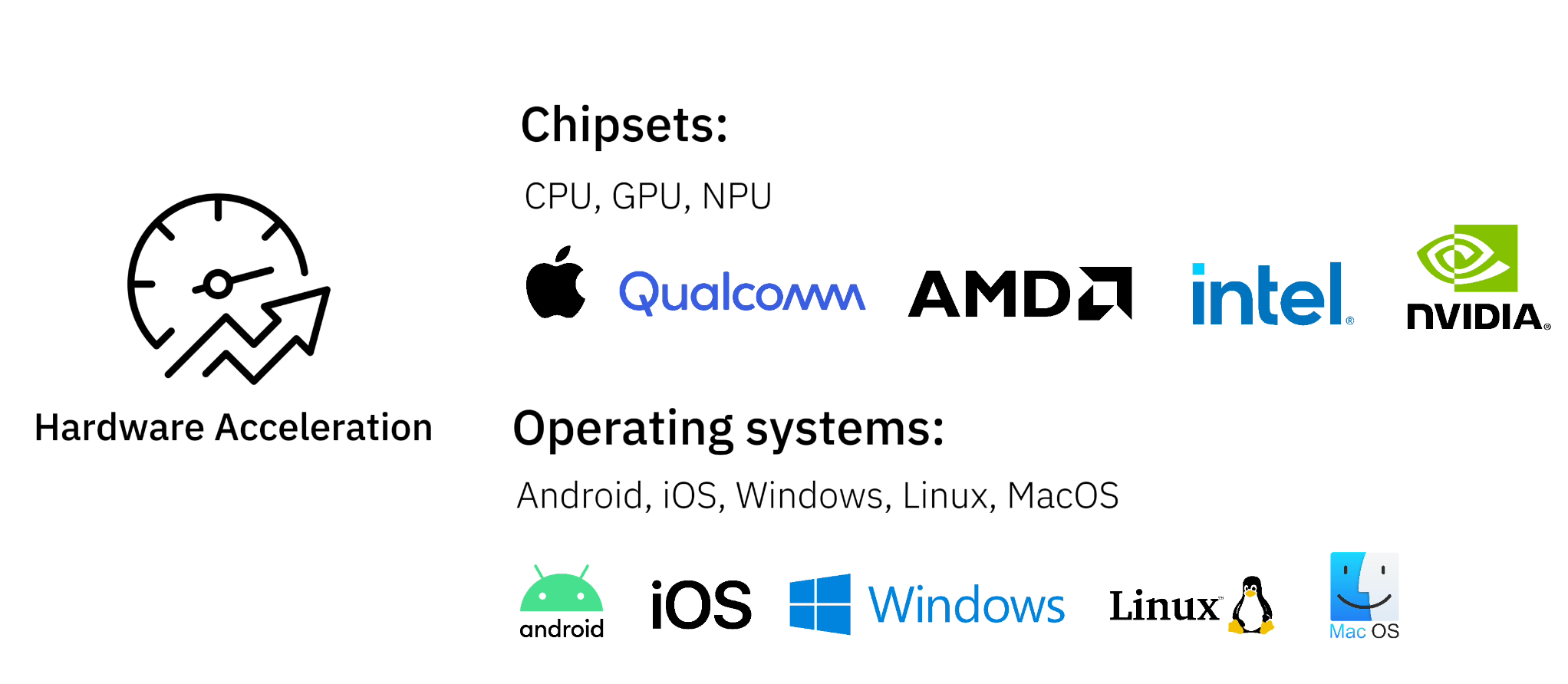

Nexa Native Inference Framework hace que la implantación de modelos generativos de IA en el dispositivo sea fluida y eficiente. La tecnología es compatible con una amplia gama de chipsets, incluidos AMD, Qualcomm, Intel, NVIDIA y chips propios, y es compatible con los principales sistemas operativos. Proporcionamos datos de referencia para modelos de IA generativa en una variedad de tareas comunes, cada una probada al nivel de rendimiento TOPS en diferentes tipos de dispositivos.

Puntos fuertes:

- capacidad multimodal - respaldoTexto, audio, vídeo y visualesTareas generativas similares a la IA

- Amplia compatibilidad de hardware - Ejecuta modelos de IA en PC, portátiles, dispositivos móviles y sistemas integrados.

- rendimiento líder - Con NexaQuant, nuestro marco de inferencia avanzada, los modelos se ejecutan 2,5 veces más rápido y requieren 4 veces menos memoria y almacenamiento, manteniendo al mismo tiempo una gran precisión.

¿Por qué IA en el lado final?

Implantar modelos de IA directamente en el dispositivo tiene varias ventajas sobre depender de API en la nube:

- Privacidad y seguridad - La conservación de datos en el dispositivo garantiza la confidencialidad

- reducir costes - Sin necesidad de pagar por costosos razonamientos basados en la nube

- Velocidad y respuesta - Razonamiento de baja latencia sin depender de la red

- capacidad offline - Las aplicaciones de IA pueden seguir utilizándose en zonas de baja conectividad

Con la tecnología de inferencia de bordes de Nexa, los desarrolladores pueden ejecutar eficazmente modelos generativos de IA en una amplia gama de dispositivos con un consumo mínimo de recursos.

Nuevas tendencias en aplicaciones multimodales de IA

Nexa AI Apoyo a la implantación en el extremoIA multimodalque permite a las aplicaciones manejar e integrar múltiples tipos de datos:

- Texto AI - Chatbots, resúmenes de documentos, asistentes de programación

- IA de voz a voz - Traducción de voz en tiempo real, asistente de voz con inteligencia artificial

- Visión AI - Detección de objetivos, descripción de imágenes, procesamiento OCR de documentos

Esto se consigue mediante el uso deNexaQuantNuestros modelos multimodales consiguen una compresión y una aceleración excelentes manteniendo el máximo rendimiento.

Pruebas comparativas de rendimiento de tareas de IA generativa en distintos dispositivos

Proporcionamos datos de pruebas comparativas para modelos de IA generativa en una variedad de tareas comunes, cada una probada al nivel de rendimiento TOPS en diferentes tipos de dispositivos. Si tienes un dispositivo y un caso de uso específicos, puedes consultar dispositivos con un rendimiento similar para estimar la potencia de procesamiento:

Tareas de IA generativa cubiertas:

- Voz a voz

- Texto a texto

- De visual a texto

Cubre el tipo de equipo:

- Chips para portátiles modernos - Optimizado para el procesamiento nativo de IA en ordenadores de sobremesa y portátiles

- chip insignia para móviles - Modelos de inteligencia artificial en teléfonos inteligentes y tabletas

- sistema integrado (~4 TOPS) - Dispositivos de bajo consumo para aplicaciones Edge Computing

Evaluación comparativa de voz a voz

Evaluación de las capacidades de interacción verbal en tiempo real con modelos lingüísticos - ProcesamientoLa entrada de audio genera una salida de audio

| Tipo de equipo | Chips y dispositivos | Retraso (TTFT) | velocidad de descodificación | Memoria pico media |

|---|---|---|---|---|

| Chips para portátiles modernos (GPU) | GPU Apple M3 Pro | 0,67 segundos | 20,46 fichas/segundo | ~990MB |

| Chips para portátiles modernos (iGPU) | iGPU AMD Ryzen AI 9 HX 370 (Radeon 890M) | 1,01 segundos | 19,28 fichas/segundo | ~990MB |

| Chips para portátiles modernos (CPU) | Intel Core Ultra 7 268V | 1,89 segundos | 11,88 fichas/segundo | ~990MB |

| Chip CPU móvil insignia | Qualcomm Snapdragon 8 Gen 3 (Samsung S24) | 1,45 segundos | 9,13 token/segundo | ~990MB |

| CPU de sistema IoT integrado | Raspberry Pi 4 Modelo B | 6,9 segundos. | 4,5 fichas/segundo | ~990MB |

Evaluación comparativa de voz a voz mediante Moshi con NexaQuant

Evaluación comparativa de texto a texto

valoraciónGenerar texto a partir de un texto introducidoRendimiento del modelo de IA

| Tipo de equipo | Chips y dispositivos | Retraso inicial (TTFT) | velocidad de descodificación | Memoria pico media |

|---|---|---|---|---|

| Chips para portátiles modernos (GPU) | GPU Apple M3 Pro | 0,12 segundos | 49,01 ficha/segundo | ~2580 MB |

| Chips para portátiles modernos (iGPU) | iGPU AMD Ryzen AI 9 HX 370 (Radeon 890M) | 0,19 segundos | 30,54 fichas/segundo | ~2580 MB |

| Chips para portátiles modernos (CPU) | Intel Core Ultra 7 268V | 0,63 segundos | 14,35 fichas/segundo | ~2580 MB |

| Chip CPU móvil insignia | Qualcomm Snapdragon 8 Gen 3 (Samsung S24) | 0,27 segundos | 10,89 fichas/segundo | ~2580 MB |

| CPU de sistema IoT integrado | Raspberry Pi 4 Modelo B | 1,27 segundos | 5,31 token/segundo | ~2580 MB |

Evaluación comparativa de texto a texto mediante llama-3.2 con NexaQuant

Evaluación comparativa de visual a texto

Evaluar la IA Analizar las entradas visualesCapacidad para generar respuestas, extraer información visual clave y guiar dinámicamente la herramienta.Entrada visual, salida de texto

| Tipo de equipo | Chips y dispositivos | Retraso inicial (TTFT) | velocidad de descodificación | Memoria pico media |

|---|---|---|---|---|

| Chips para portátiles modernos (GPU) | GPU Apple M3 Pro | 2,62 segundos | 86,77 fichas/segundo | ~1093MB |

| Chips para portátiles modernos (iGPU) | iGPU AMD Ryzen AI 9 HX 370 (Radeon 890M) | 2,14 segundos | 83,41 fichas/segundo | ~1093MB |

| Chips para portátiles modernos (CPU) | Intel Core Ultra 7 268V | 9,43 segundos | 45,65 fichas/segundo | ~1093MB |

| Chip CPU móvil insignia | Qualcomm Snapdragon 8 Gen 3 (Samsung S24) | 7,26 segundos. | 27,66 fichas/segundo | ~1093MB |

| CPU de sistema IoT integrado | Raspberry Pi 4 Modelo B | 22,32 segundos | 6,15 fichas/segundo | ~1093MB |

Benchmarking visual-textual mediante OmniVLM con NexaQuant

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...