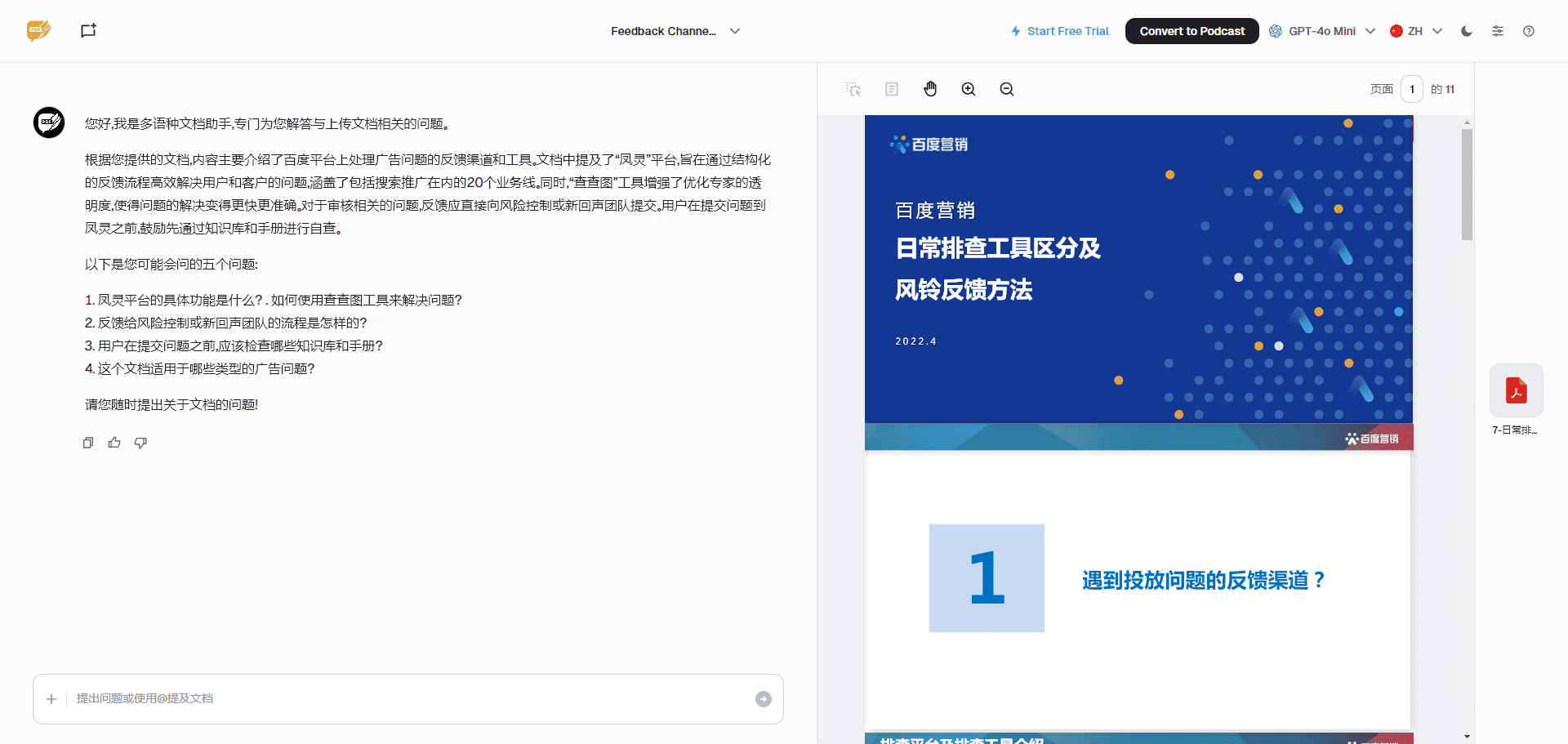

Klee: ejecución local de macromodelos de IA en el escritorio y gestión de una base de conocimientos privada

Últimos recursos sobre IAActualizado hace 1 año Círculo de intercambio de inteligencia artificial 70.2K 00

Introducción general

Klee es una aplicación de escritorio de código abierto diseñada para ayudar a los usuarios a ejecutar localmente grandes modelos lingüísticos (LLM) de código abierto con gestión privada y segura de bases de conocimiento y capacidades de toma de notas en Markdown. Se basa en Ollama Construido con tecnología LlamaIndex, Klee permite a los usuarios descargar y ejecutar modelos de IA con operaciones sencillas, y todo el procesamiento de datos se realiza localmente sin necesidad de conectarse a Internet o subirlos a la nube, lo que garantiza la privacidad y la seguridad. Klee ofrece una interfaz de usuario intuitiva para Windows, MacOS y Linux, que facilita tanto a desarrolladores técnicos como a usuarios ocasionales la generación de textos, el análisis de documentos y la organización del conocimiento. Klee es actualmente de código abierto en GitHub y ha sido bien recibido por la comunidad, que puede descargarlo, personalizarlo o participar en su desarrollo.

Lista de funciones

- Descargue y ejecute grandes modelos lingüísticos en un clic: Descargue y ejecute LLM de código abierto directamente desde Ollama a través de la interfaz, sin tener que configurar manualmente el entorno.

- Gestión de la base de conocimientos localesSoporte para cargar archivos y carpetas para construir un índice de conocimiento privado y ponerlo a disposición de la IA para su consulta.

- Generación de notas Markdown: Guarda automáticamente los resultados de los diálogos o análisis de IA en formato Markdown para facilitar la documentación y la edición.

- Uso totalmente offlineNo se requiere conexión a Internet, todas las funciones se ejecutan localmente y no se recopilan datos del usuario.

- Soporte multiplataforma: Compatible con sistemas Windows, MacOS y Linux para una experiencia coherente.

- Código abierto y personalizableSe proporciona el código fuente completo para que el usuario pueda modificar las funciones o participar en las contribuciones de la comunidad.

Utilizar la ayuda

Proceso de instalación

La instalación de Klee se divide en dos partes: cliente (klee-client) y servidor (klee-service), a continuación se detallan los pasos:

1. Requisitos del sistema

- sistema operativoWindows 7+, macOS 15.0+ o Linux.

- dependencia del software::

- Node.js 20.x o posterior.

- Yarn 1.22.19 o posterior.

- Python 3.x (se requiere en el servidor, se recomienda 3.12+).

- Git (para clonar repositorios).

- requisitos de hardwareAl menos 8 GB de RAM; se recomiendan 16 GB o más para ejecutar modelos más grandes.

2. Instalar el cliente (klee-client)

- Clonar repositorio de clientes::

Se ejecuta en el terminal:

git clone https://github.com/signerlabs/klee-client.git

cd klee-client

- Instalación de dependencias::

yarn install

- Configuración de variables de entorno::

- Copie el archivo de ejemplo:

cp .env.example .env - compilador

.envla configuración por defecto es la siguiente:VITE_USE_SUPABASE=false VITE_OLLAMA_BASE_URL=http://localhost:11434 VITE_REQUEST_PREFIX_URL=http://localhost:6190Si el puerto o la dirección del servidor son diferentes, ajuste el

VITE_REQUEST_PREFIX_URL.

- Funcionamiento en modo de desarrollo::

yarn dev

Esto iniciará el Servidor de Desarrollo Vite y la aplicación Electron.

5. Aplicación de envasado (opcional)::

yarn build

El archivo empaquetado se encuentra en dist Catálogo.

6. Firma MacOS (opcional)::

- compilador

.envAñade un ID de Apple y la información del equipo:APPLEID=your_apple_id@example.com APPLEIDPASS=your_password APPLETEAMID=your_team_id - estar en movimiento

yarn buildA continuación, puede generar una solicitud firmada.

3. Instalación del servidor (klee-service)

- Clonar el repositorio del servidor::

git clone https://github.com/signerlabs/klee-service.git

cd klee-service

- Creación de un entorno virtual::

- Ventanas:

python -m venv venv venv\Scripts\activate - MacOS/Linux:

python3 -m venv venv source venv/bin/activate

- Instalación de dependencias::

pip install -r requirements.txt

- Inicio de los servicios::

python main.py

El puerto por defecto es 6190, si necesitas cambiarlo:

python main.py --port 自定义端口号

Es necesario mantener el servicio en funcionamiento una vez iniciado.

4. Descargar versión precompilada (opcional)

- entrevistas Publicaciones en GitHubDescargue el paquete de instalación correspondiente a su sistema.

- Descomprímelo y ejecútalo directamente, sin necesidad de compilarlo manualmente.

Funciones principales

Ejecute grandes modelos lingüísticos con un solo clic

- lanzar una aplicación::

- Asegúrate de que el servidor está funcionando y abre la aplicación cliente.

- Descargar modelos::

- Seleccione un modelo compatible con Ollama (por ejemplo, LLaMA, Mistral) en la interfaz.

- Haz clic en el botón "Descargar" y Klee descargará automáticamente el modelo a nivel local.

- modelo operativo::

- Una vez finalizada la descarga, haga clic en "Ejecutar" para cargar el modelo en la memoria.

- Introduce una pregunta o comando en el cuadro de diálogo y haz clic en "Enviar" para obtener una respuesta.

- advertencia::

- Cargar el modelo por primera vez puede tardar unos minutos, dependiendo del tamaño del modelo y del rendimiento del hardware.

- Si no hay respuesta, compruebe si el servidor se está ejecutando en la carpeta

http://localhost:6190.

Gestión de la base de conocimientos locales

- Cargar archivos::

- Haga clic en la opción "Conocimiento" de la interfaz.

- Admite la función de arrastrar y soltar o la selección manual de archivos/carpetas (admite PDF, TXT, etc.).

- Crear un índice::

- Tras la carga, LlamaIndex genera automáticamente un índice para el archivo.

- Una vez finalizada la indexación, la IA puede recuperar el contenido del documento.

- Consulta de la base de conocimientos::

- Marque "Utilizar la base de conocimientos" en la pantalla de diálogo e introduzca su pregunta.

- La IA generará respuestas en conjunción con el contenido de la base de conocimientos.

- Gestión de la base de conocimientos::

- Puede eliminar o actualizar archivos en la pantalla Conocimiento.

Generación de notas Markdown

- Guardar notas::

- Cuando la IA responda, haz clic en el botón "Guardar como nota".

- El sistema guarda automáticamente el contenido en formato Markdown.

- Notas de gestión::

- Ver todas las notas en la pantalla Notas.

- Permite editar, exportar (guardar como archivo .md) o eliminar.

- Escenarios de uso::

- Ideal para registrar resultados de análisis de inteligencia artificial, notas de estudio o resúmenes de trabajo.

Funciones destacadas

Uso totalmente offline

- método operativo::

- Una vez instalado, todas las funciones funcionarán sin necesidad de red.

- Descargar el modelo y desconectar de internet y sigue funcionando bien.

- seguridad de los datos::

- Klee no recoge ningún dato del usuario y todos los archivos y conversaciones se almacenan únicamente a nivel local.

- Los registros se utilizan únicamente con fines de depuración y no se suben a servidores externos.

Código abierto y contribuciones comunitarias

- Obtener código fuente::

- entrevistas Repositorios de GitHubDescargue el código.

- Modo de contribución::

- Envíe una solicitud de extracción para añadir una función o corregir un error.

- Participar en los debates de GitHub Issues para optimizar la documentación o promover las aplicaciones.

- Métodos personalizados::

- Modificar el lado del servidor para que admita otros modelos o API.

- Ajuste de la interfaz de cliente, necesidad de estar familiarizado con Reaccione y Electron.

Recomendaciones de uso

- optimización del rendimientoPara ejecutar modelos de gran tamaño (p. ej., 13B parámetros), se recomienda disponer de más de 16 GB de RAM o aceleración por GPU.

- Selección de modelosEl modelo más pequeño (por ejemplo, el parámetro 7B) puede seleccionarse para probarlo por primera vez.

- Preguntasen GitHub o Discordia Busca ayuda.

Con estos pasos, los usuarios pueden instalar y utilizar rápidamente Klee para disfrutar de la comodidad de la IA localizada.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...