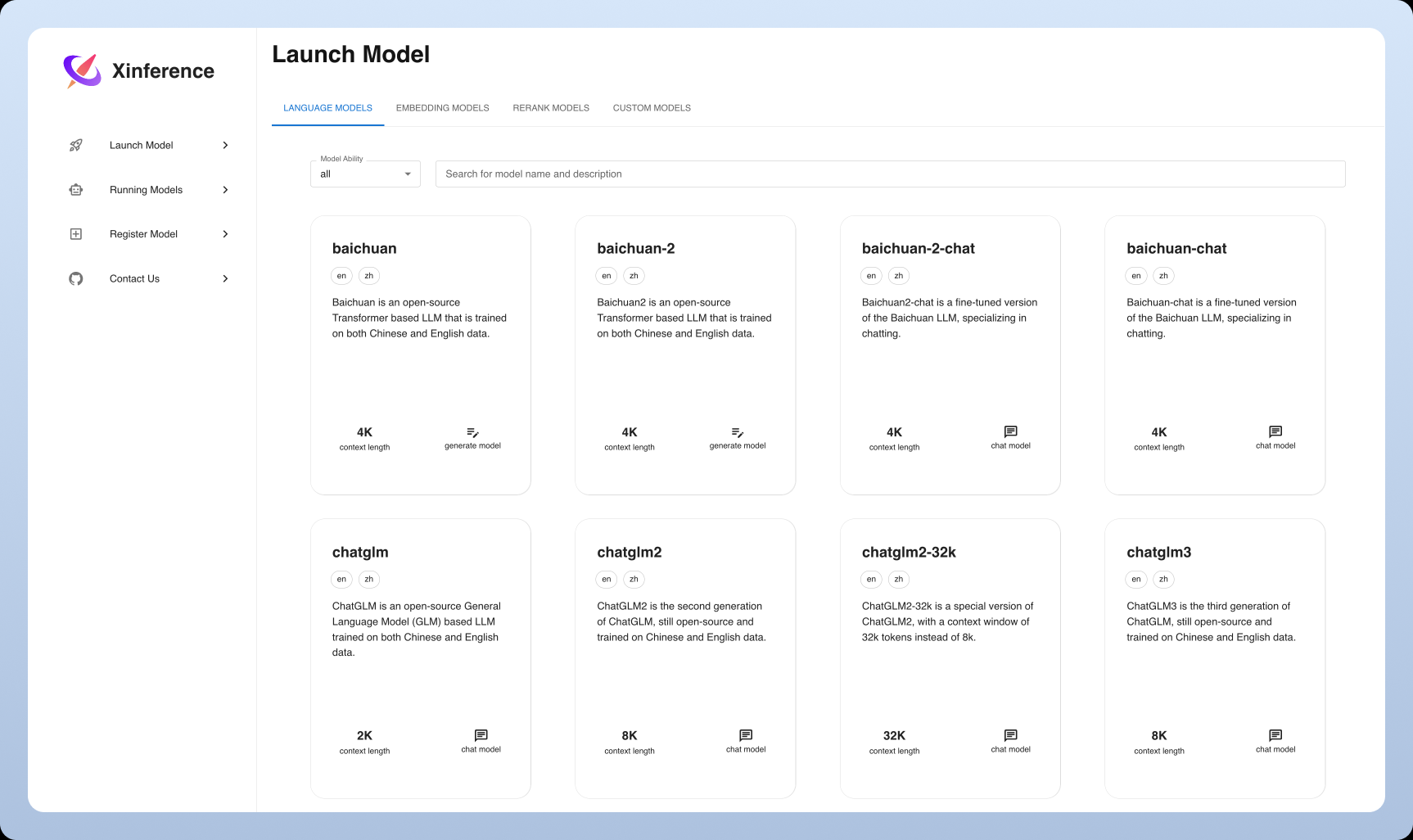

Xinference: fácil despliegue y servicio de modelos de IA distribuidos

Introducción general

Xorbits Inference (o Xinference para abreviar) es una biblioteca potente y versátil centrada en proporcionar despliegue distribuido y servicio de modelos de lenguaje, modelos de reconocimiento de voz y modelos multimodales. Con Xorbits Inference, los usuarios pueden desplegar y servir fácilmente sus propios modelos o modelos avanzados incorporados con un solo comando. Ya sea en la nube, en un servidor local o en un ordenador personal, Xorbits Inference se ejecuta de manera eficiente. La biblioteca está especialmente indicada para investigadores, desarrolladores y científicos de datos, para ayudarles a aprovechar todo el potencial de los modelos de IA de vanguardia.

Lista de funciones

- implantación distribuidaPermite el despliegue distribuido, lo que permite distribuir sin problemas las tareas de inferencia de modelos entre varios dispositivos o máquinas.

- servicio de modelado: Agilización del proceso de servicio de grandes modelos lingüísticos, modelos de reconocimiento del habla y modelos multimodales.

- Despliegue con un solo mandoDespliegue y mantenimiento de modelos con un solo comando, tanto para entornos experimentales como de producción.

- Utilización de hardware heterogéneo: Intelligence aprovecha el hardware heterogéneo, incluidas GPU y CPU, para acelerar las tareas de inferencia de modelos.

- Interfaces y API flexiblesProporcionar una variedad de interfaces para interactuar con el modelo, soportando RPC, RESTful API (compatible con OpenAI API), CLI y WebUI.

- Modelos avanzados integrados: Compatibilidad integrada con una amplia gama de modelos de código abierto de última generación, que los usuarios pueden utilizar directamente para realizar experimentos.

Utilizar la ayuda

Proceso de instalación

- Preparación medioambientalAsegúrese de que Python 3.7 o posterior está instalado.

- Instalación de Xorbits Inference::

pip install xorbits-inference

- Verificar la instalaciónUna vez finalizada la instalación, puede comprobar que la instalación se ha realizado correctamente utilizando el siguiente comando:

xinference --version

Normas de uso

modelo de despliegue

- Modelos de cargaUtiliza el siguiente comando para cargar un modelo pre-entrenado:

xinference load-model --model-name <模型名称>

Ejemplo:

xinference load-model --model-name gpt-3

- Inicio de los servicios: Después de cargar el modelo, inicie el servicio:

xinference serve --model-name <模型名称>

Ejemplo:

xinference serve --model-name gpt-3

- Llamada a la APIUna vez iniciado el servicio, puede invocarse a través de una API RESTful:

curl -X POST http://localhost:8000/predict -d '{"input": "你好"}'

Utilizar el modelo integrado

Xorbits Inference tiene soporte incorporado para una amplia gama de modelos avanzados que pueden ser utilizados directamente por el usuario para realizar experimentos. Por ejemplo:

- modelo lingüístico: por ejemplo, GPT-3, BERT, etc.

- modelo de reconocimiento del hablapor ejemplo, DeepSpeech, etc.

- modelo multimodal: por ejemplo, CLIP, etc.

implantación distribuida

Xorbits Inference soporta el despliegue distribuido, permitiendo a los usuarios distribuir sin problemas las tareas de inferencia de modelos a través de múltiples dispositivos o máquinas. Los pasos se describen a continuación:

- Configuración de un entorno distribuidoInstale Xorbits Inference en cada nodo y configure la conexión de red.

- Inicio de los servicios distribuidos: Inicia los servicios distribuidos en el nodo maestro:

xinference serve --distributed --nodes <节点列表>

Ejemplo:

xinference serve --distributed --nodes "node1,node2,node3"

- Llamada a la API distribuidaEl despliegue de nodo único: similar a los despliegues de nodo único, se invoca a través de una API RESTful:

curl -X POST http://<主节点IP>:8000/predict -d '{"input": "你好"}'

problemas comunes

- ¿Cómo actualizo el modelo? Utilice el siguiente comando para actualizar el modelo:

xinference update-model --model-name <模型名称>

- ¿Cómo puedo ver los registros? Utilice el siguiente comando para ver el registro de servicio:

xinference logs --model-name <模型名称>© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...