Inception Labs lanza el primer modelo comercial de difusión de grandes lenguajes

Inception Labs presenta la familia Mercury de modelos lingüísticos difusos de gran tamaño (dLLM), que son hasta 10 veces más rápidos y baratos que los LLM existentes, lo que lleva el modelado lingüístico a nuevas fronteras de inteligencia y velocidad.

centro

- Inception Labs ha lanzado oficialmente la familia Mercury de modelos lingüísticos difusos de gran tamaño (dLLM), que marca el nacimiento de una nueva generación de LLM y anuncia un nuevo nivel de tecnología de generación de texto rápida y de alta calidad.

- Mercury es 10 veces más rápido que los actuales LLM de velocidad optimizada. En las GPU NVIDIA H100, los modelos Mercury funcionan a más de 1.000 tokens/segundo, una velocidad que antes sólo era posible con chips personalizados.

- modelo de generación de código Codificador Mercury Ahora en parque infantil Inception Labs proporciona acceso a modelos de código y modelos genéricos para clientes empresariales a través de API e implantaciones nativas.

La visión de Inception Labs - Difusión que capacita a la próxima generación de LLMs

Los grandes modelos lingüísticos (LLM) actuales suelen utilizar un modelo autorregresivo, lo que significa que se escriben como la escritura humana, de izquierda a derecha, de uno en uno ficha Generación de texto. Esta generación es intrínsecamente en serie: hay que generar los tokens anteriores antes de poder generar los siguientes, y cada token generado requiere evaluar una red neuronal con miles de millones de parámetros. Las empresas de LLM líderes del sector apuestan por un mayor cómputo del tiempo de inferencia para mejorar las capacidades de inferencia y corrección de errores de sus modelos, pero la generación de largos procesos de inferencia también está provocando que se disparen los costes de inferencia y aumente la latencia, lo que en última instancia dificulta el uso de los productos. Es imperativo un cambio de paradigma para que las soluciones de IA de alta calidad sean verdaderamente ubicuas.

Los modelos de difusión ofrecen la posibilidad de ese cambio de paradigma. Estos modelos utilizan un proceso de generación "de grueso a fino". Como se muestra en el vídeo, la salida del modelo comienza con ruido puro y se optimiza progresivamente en varios pasos de "eliminación de ruido".

A diferencia de los modelos autorregresivos, los modelos de difusión no están limitados a considerar únicamente lo que se ha producido anteriormente. Esto les permite inferir y estructurar mejor las respuestas. Además, como los modelos de difusión son capaces de optimizar continuamente sus resultados, pueden corregir eficazmente los errores y reducir las ilusiones. Gracias a estas ventajas, los modelos de difusión son el motor principal de muchas de las soluciones de IA más destacadas en la generación de vídeo, imagen y audio, como Sora, Midjourney y Riffusion, por citar algunas. Sin embargo, los intentos de aplicar modelos de difusión a datos discretos, como texto y código, nunca habían tenido éxito hasta ahora. Hasta Mercury, esa situación estaba completamente rota.

Mercury Coder - 1000+ Tokens/Segundo, ¡Inteligencia de vanguardia al alcance de tu mano!

Inception Labs se complace en anunciar el lanzamiento de Mercury Coder, el primer dLLM disponible públicamente.

Mercury Coder supera los límites de las capacidades de la IA: es entre 5 y 10 veces más rápido que la actual generación de LLM y ofrece respuestas de alta calidad a un coste mucho menor.Mercury Coder es el resultado de la investigación pionera del equipo fundador de Inception Labs, que no sólo fue pionero en el modelado de difusión de imágenes, sino que también coinventó muchas tecnologías básicas de IA generativa, como la Optimización de Preferencia Directa (OPD) y los Transformadores de Decisión. Mercury Coder es el resultado de la investigación pionera del equipo fundador de Inception Labs, que no sólo fue pionero en el modelado de difusión de imágenes, sino que también coinventó varias tecnologías básicas de IA generativa, como la Optimización de Preferencia Directa (OPD), la Atención Flash y los Transformadores de Decisión.

dLLM puede utilizarse como sustituto directo de los LLM autorregresivos existentes y es compatible con todos los escenarios de aplicación, incluidos RAG (Retrieval Augmentation Generation), uso de herramientas y flujos de trabajo de agentes. dLLM no genera respuestas token a token cuando se recibe una consulta de usuario. Al recibir una consulta de usuario, dLLM no genera la respuesta token a token, sino que genera la respuesta de forma gruesa a fina, como se muestra en la animación anterior. El modelo Transformer (utilizado en Mercury Coder) ha sido entrenado en una gran cantidad de datos, y es capaz de optimizar la calidad de la respuesta de forma global, modificando múltiples tokens en paralelo para mejorar los resultados de forma continua. El modelo transformador (utilizado en Mercury Coder) se ha entrenado sobre una gran cantidad de datos para optimizar la calidad de la respuesta de forma global y modificar múltiples tokens en paralelo para mejorar continuamente los resultados.

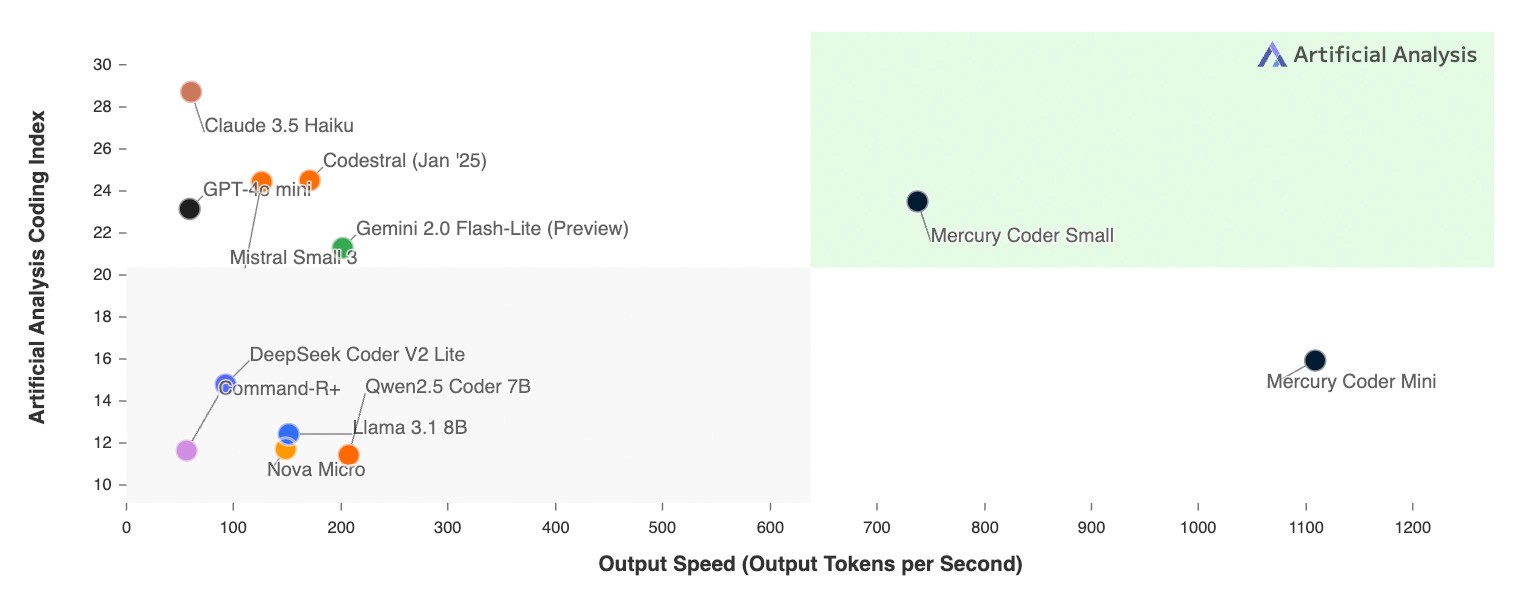

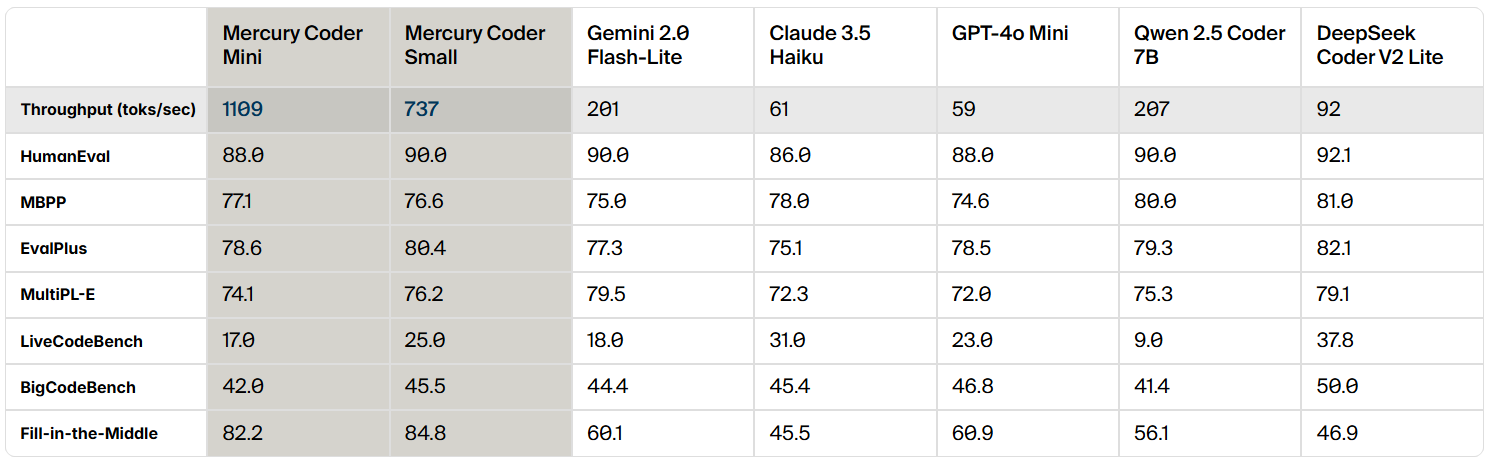

Mercury Coder es un dLLM optimizado para la generación de código, y en las evaluaciones comparativas de código estándar Mercury Coder sobresale en una amplia gama de evaluaciones comparativas, superando a menudo al GPT-4o Mini y al Claude 3.5 Los modelos autorregresivos de velocidad optimizada, como Haiku, también son hasta 10 veces más rápidos.

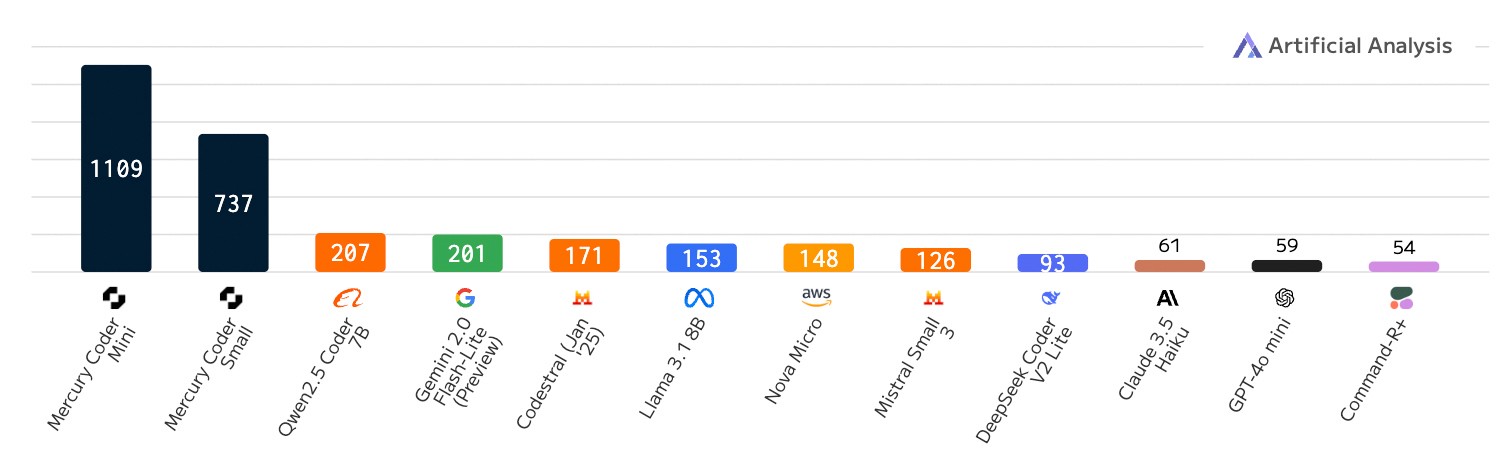

La característica exclusiva de dLLM es su increíble velocidad. Mientras que incluso los modelos autorregresivos de velocidad optimizada se ejecutan a un máximo de 200 tokens/segundo, Mercury Coder lo hace a más de 1.000 tokens/segundo en una GPU NVIDIA H100 de propósito general, es decir, 5 veces más rápido. Mercury Coder es incluso 20 veces más rápido que algunos modelos de frontera, que pueden funcionar a menos de 50 tokens/seg.

Antes, sólo el hardware dedicado como Groq, Cerebras y SambaNova podía alcanzar rendimientos como dLLM. Las mejoras algorítmicas de Mercury Coder y la aceleración por hardware van de la mano, y en chips más rápidos, los aumentos de velocidad se acumulan aún más.

Comparación de velocidades: número de tokens emitidos por segundo; cargas de trabajo de escritura de código.

Aún más emocionante es que los desarrolladores prefieren la función de completado de código de Mercury Coder. En el Copiloto En las pruebas comparativas de Arena, Mercury Coder Mini empató en el segundo puesto, superando a modelos de velocidad optimizada como GPT-4o Mini y Gemini-1.5-Flash, e incluso igualando el rendimiento de modelos más grandes como GPT-4o. Al mismo tiempo, Mercury Coder es también el modelo más rápido, unas cuatro veces más que GPT-4o Mini.

Inception Labs te invita a experimentar por ti mismo la potencia de Mercury Coder.Inception Labs se ha asociado con Lambda Labs en la parque infantil La plataforma le proporciona un acceso de prueba a Mercury Coder. Experimente cómo Mercury Coder genera código de alta calidad en una fracción del tiempo, como se muestra en el siguiente vídeo.

¿Qué significa esto para las aplicaciones de IA?

Los primeros en adoptar Mercury dLLM, incluidos los líderes del mercado en atención al cliente, generación de código y automatización empresarial, están pasando con éxito del modelo base autorregresivo estándar a Mercury dLLM como sustitución directa. Este cambio se traduce directamente en una mejor experiencia del usuario y menores costes. En escenarios de aplicaciones sensibles a la latencia, los socios a menudo han tenido que elegir modelos más pequeños y menos capaces en el pasado para cumplir con los estrictos requisitos de latencia. Ahora, gracias al rendimiento superior de dLLM, estos socios pueden utilizar modelos más grandes y potentes sin dejar de cumplir sus requisitos originales de coste y velocidad.

Inception Labs proporciona acceso a la familia de modelos Mercury a través de una API y una implantación local. Los modelos Mercury son totalmente compatibles con el hardware, los conjuntos de datos y los procesos de ajuste fino supervisado (SFT) y alineación (RLHF) existentes.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...