Hume AI: Potenciación de la IA mediante el reconocimiento de emociones | Reconocimiento de estados emocionales a partir de sonidos y expresiones | Generación de discurso con estados emocionales

Últimos recursos sobre IAPublicado hace 1 año Círculo de intercambio de inteligencia artificial 64K 00

Introducción general

Hume AI es una empresa de IA centrada en la inteligencia emocional que desarrolla tecnologías de IA multimodal que comprenden las emociones humanas y responden a ellas. Su producto estrella, la Empathic Voice Interface (EVI), reconoce y responde a las emociones del usuario en múltiples formas, como el habla, las expresiones faciales y el lenguaje, para mejorar la experiencia emocional de la interacción persona-ordenador.El objetivo de Hume AI es garantizar que la tecnología de IA pueda servir realmente al bienestar emocional de los seres humanos mediante un enfoque científico y principios éticos.

Lista de funciones

- reconocimiento de emocionesReconoce las emociones del usuario de diversas formas, como el habla, las expresiones faciales y el lenguaje.

- síntesis de voz: Genere respuestas de voz con emoción para mejorar la experiencia interactiva.

- interacción multimodal: Admite una amplia gama de interacciones, como voz, texto y emoticonos.

- PersonalizaciónPersonaliza las distintas personalidades de la IA y los estilos de voz en función de las necesidades del usuario.

- respuesta en tiempo real: Proporciona análisis de sentimientos y respuestas en tiempo real para una amplia gama de escenarios de aplicación.

Utilizar la ayuda

Instalación y uso

Hume AI es muy fácil de usar y no requiere un proceso de instalación complicado. Los usuarios sólo tienen que visitar el sitio web oficial y registrarse para obtener una cuenta para empezar a utilizar su servicio en línea. Aquí están los pasos detallados para usarlo:

- Registrar una cuenta: Acceso Sitio web oficial de Hume AIHaga clic en el botón Registrarse y rellene la información pertinente para completar el registro.

- Plataforma de accesoInicie sesión en la plataforma Hume AI con su cuenta y contraseña registradas.

- Seleccionar servicio: Seleccione el módulo de servicio que desea utilizar en la página de inicio de la plataforma, como el reconocimiento de emociones, la síntesis de voz, etc.

- Cargar datos: Cargue datos de voz, vídeo o texto para analizarlos según se le solicite.

- Ver resultadosEl sistema realiza automáticamente un análisis de los sentimientos y genera informes detallados y resultados de las respuestas.

Función Flujo de operaciones

reconocimiento de emociones

- Acceso al módulo de reconocimiento de emociones: Después de conectarse, haga clic en "Reconocimiento de emociones" en la barra de navegación.

- Cargar datosSeleccione el archivo de voz o vídeo que desea analizar y haga clic en Cargar.

- Empezar a analizarHaga clic en el botón "Empezar a analizar" para que el sistema realice automáticamente el reconocimiento de sentimientos.

- Ver informeUna vez finalizado el análisis, los usuarios pueden consultar un informe detallado del análisis de sentimiento, que incluye el tipo de sentimiento, la intensidad y las tendencias de cambio.

síntesis de voz

- Acceso al módulo de síntesis de voz: Después de conectarse, haga clic en "Síntesis de voz" en la barra de navegación.

- texto introducidoIntroduzca el contenido del texto que desea sintetizar en el cuadro de texto.

- Seleccionar estilo de voz: Selecciona diferentes estilos de voz y expresiones emocionales según sea necesario.

- Generar discursoHaga clic en el botón "Generar voz" para que el sistema genere el archivo de voz correspondiente.

- Descargar VozUna vez finalizada la generación, los usuarios pueden descargar los archivos de voz para utilizarlos en distintos escenarios de aplicación.

interacción multimodal

- Acceso al módulo de interacción multimodal: Después de conectarse, haga clic en "Interacción multimodal" en la barra de navegación.

- Seleccionar método de interacción: Elige interactuar con voz, texto o emoji.

- Interacción inicialEl sistema reconoce las emociones del usuario y responde a ellas en tiempo real.

- Ver registrosAl final de la interacción, los usuarios pueden ver el registro de la interacción y los resultados del análisis de sentimiento.

Hume AI proporciona abundante documentación y tutoriales, y los usuarios pueden encontrar guías detalladas y preguntas frecuentes en el Centro de Ayuda del sitio web. Si tiene algún problema al utilizar Hume AI, no dude en ponerse en contacto con el equipo de atención al cliente de Hume AI para obtener ayuda.

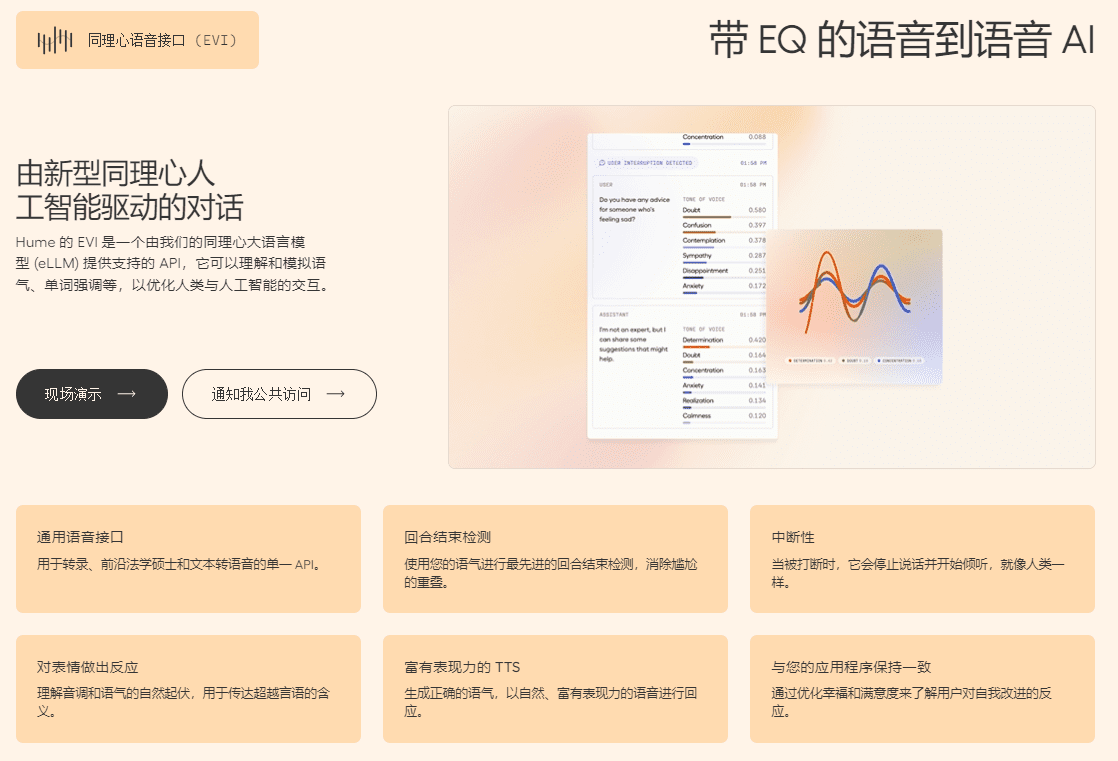

Interfaz de voz empática (EVI)

La Interfaz de Voz Emocionalmente Inteligente (EVI) de Hume es la primera IA de voz del mundo con inteligencia emocional. Toma la entrada de audio en directo y devuelve transcripciones de audio y texto mejoradas con datos de expresividad tonal. Al analizar el tono, el ritmo y el timbre, la EVI desbloquea funciones adicionales, como la vocalización en el momento adecuado y la entonación correcta para producir un habla empática. Estas funciones hacen que las interacciones persona-ordenador basadas en la voz sean más fluidas y satisfactorias, al tiempo que abren nuevas posibilidades en ámbitos nuevos como la IA personal, la atención al cliente, la facilidad de uso, la robótica, los juegos inmersivos, las experiencias de RV, etc.

Ofrecemos un conjunto completo de herramientas para facilitar la integración y personalización de EVI en sus aplicaciones, incluyendo una API WebSocket para manejar las transferencias de audio y texto, una API REST, y SDKs para Typescript y Python para simplificar la integración en proyectos web y Python base.Además de esto, ofrecemos estudios de casos de código abierto y widgets web como un Además, proporcionamos estudios de casos de código abierto y widgets web como punto de partida práctico para que los desarrolladores exploren e implementen las capacidades de EVI en sus propios proyectos.

Construir con EVI

La principal forma de utilizar EVI es a través de una conexión WebSocket que envía audio y recibe feedback en tiempo real. Esto permite un diálogo bidireccional fluido: el usuario comenta, EVI escucha y analiza su expresión y, a continuación, EVI genera un feedback emocionalmente inteligente.

Puede iniciar un diálogo conectándose a un WebSocket y enviando la entrada de voz del usuario al EVI. También puede enviar texto a la EVI y lo leerá en voz alta.

El EVI responderá de la siguiente manera:

- Dar una respuesta textual del EVI

- Proporciona retroalimentación de audio expresiva para EVI

- Permite transcribir los mensajes de los usuarios y medir sus expresiones vocales.

- Si el usuario interrumpe el EVI, se le informa de ello.

- Cuando el EVI haya terminado de responder, emitirá un mensaje de alerta

- Si hay algún problema, aparece un mensaje de error

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...