Hugging Face lanza rankings de cuerpos de inteligencia de agentes: ¿quién es el líder en llamadas a herramientas?

Jen-Hsun Huang, CEO de NVIDIA, ha calificado la inteligencia artificial de "fuerza de trabajo digital", y no es el único líder tecnológico que mantiene esta opinión. Satya Nadella, CEO de Microsoft, también cree que la tecnología de los cuerpos inteligentes cambiará radicalmente el funcionamiento de las empresas.

La capacidad de estas inteligencias para interactuar con herramientas externas y API ha ampliado enormemente sus escenarios de aplicación. Sin embargo, las inteligencias IA distan mucho de ser perfectas, y evaluar su rendimiento en aplicaciones del mundo real ha sido todo un reto debido a la complejidad de las interacciones potenciales.

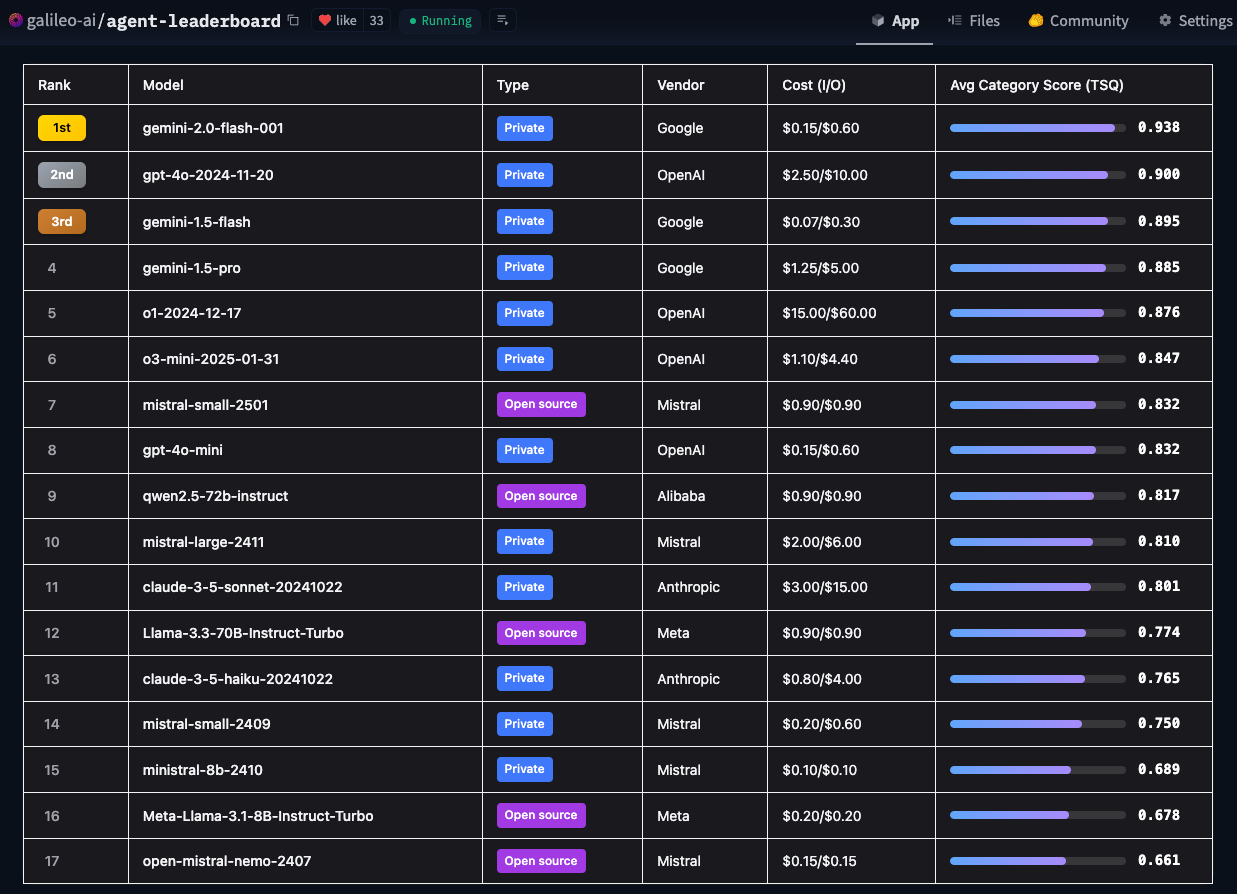

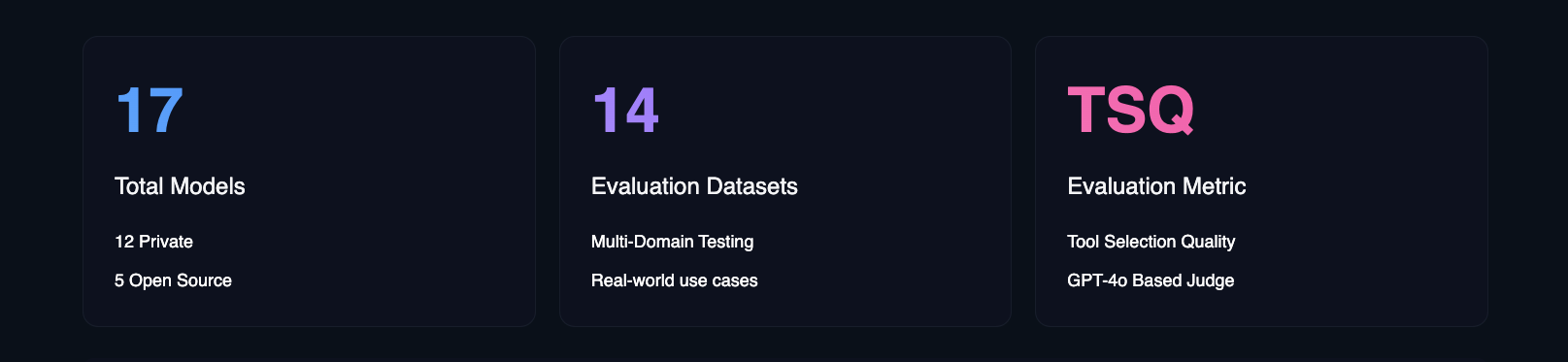

Para hacer frente a este reto, Hugging Face ha introducido el Ranking de Cuerpos de Inteligencia de Agentes. Utilizando la métrica de calidad de selección de herramientas (TSQ) de Galileo, la clasificación evalúa el rendimiento de diferentes modelos de lenguaje de gran tamaño (LLM) en el manejo de interacciones basadas en herramientas, proporcionando una referencia clara para los desarrolladores.

- Hugging Face Agent Clasificación inteligente del cuerpo

Hugging Face elaboró esta clasificación para responder a la pregunta central: "¿Qué rendimiento real tienen las inteligencias de IA en entornos empresariales reales?". Los puntos de referencia académicos son importantes, pero se centran en las capacidades técnicas, mientras que Hugging Face se preocupa más por qué modelos son realmente aplicables a una variedad de casos de uso en el mundo real.

Características exclusivas de la tabla de clasificación de la evaluación corporal inteligente del agente Hugging Face

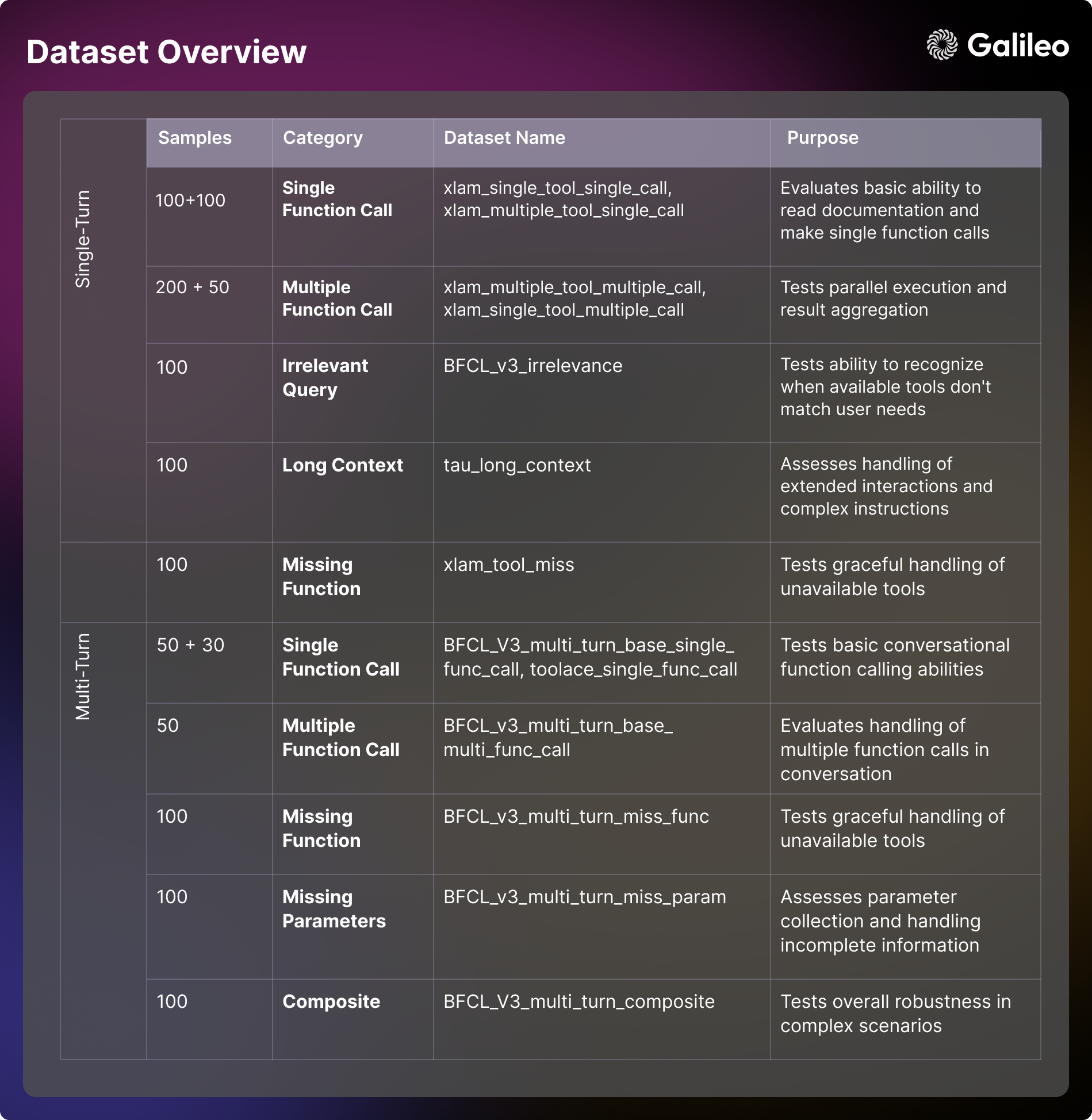

Los principales marcos de evaluación actuales suelen centrarse en ámbitos específicos. Por ejemplo, BFCL destaca en ámbitos académicos como las matemáticas, el entretenimiento y la educación; τ-bench se centra en escenarios específicos del sector, como el comercio minorista y las aerolíneas; xLAM abarca 21 ámbitos de generación de datos; y ToolACE se centra en interacciones de API en 390 ámbitos. La tabla de clasificación de Hugging Face es única porque combina estos conjuntos de datos en un marco de evaluación integral diseñado para abarcar una gama más amplia de dominios y casos de uso en el mundo real.

Al integrar विविध puntos de referencia y escenarios de prueba, las tablas de clasificación de Hugging Face no solo proporcionan una evaluación de las capacidades técnicas de un modelo, sino que también se centran en ofrecer información práctica sobre cómo gestiona el modelo los casos extremos y las consideraciones de seguridad. Hugging Face también proporciona información sobre múltiples factores, como la rentabilidad, las directrices de implantación y el impacto empresarial, todos ellos fundamentales para las organizaciones que desean implantar inteligencias de IA. Con esta clasificación, Hugging Face espera ayudar a los equipos empresariales a identificar con mayor precisión los modelos de inteligencia artificial que mejor se adaptan a sus necesidades específicas, teniendo en cuenta las limitaciones de las aplicaciones del mundo real.

Dada la frecuencia con que se publican nuevos modelos de grandes lenguajes (LLM), Hugging Face tiene previsto actualizar mensualmente las referencias de la tabla de clasificación para asegurarse de que siguen el ritmo de la rápida evolución de las tecnologías de modelización.

Principales resultados

El análisis en profundidad realizado por Hugging Face de 17 grandes modelos lingüísticos (LLM) revela patrones interesantes en la forma en que las inteligencias artificiales abordan las tareas del mundo real. Hugging Face llevó a cabo pruebas de estrés exhaustivas con modelos privados y de código abierto en 14 puntos de referencia diferentes, evaluando dimensiones que van desde simples llamadas a la API hasta complejas interacciones con varias herramientas.

Ranking de Grandes Modelos Lingüísticos (LLM)

Los resultados de la evaluación de Hugging Face desafían las percepciones tradicionales del rendimiento de los modelos y proporcionan una valiosa referencia práctica para los equipos que están construyendo inteligencias de IA.

Principales conclusiones de la clasificación del Cuerpo Inteligente de Agentes

Complejidad de las llamadas a herramientas

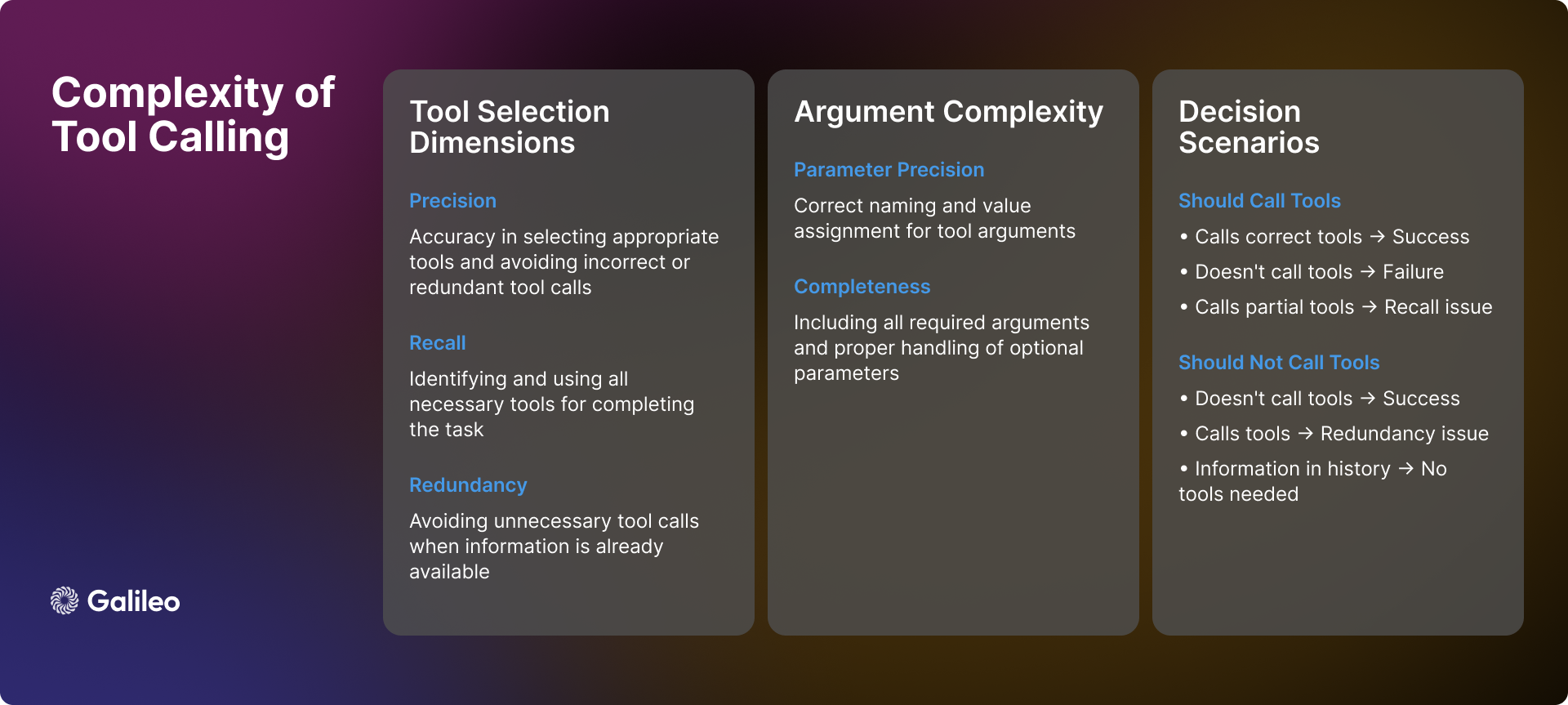

La complejidad de la invocación de herramientas va mucho más allá de las simples llamadas a la API. En la práctica, las inteligencias IA se enfrentan a muchos escenarios y retos complejos en el uso de herramientas, y necesitan tomar decisiones precisas:

reconocimiento de escenas

Cuando un organismo inteligente recibe una consulta de un usuario, su primera tarea consiste en determinar si es necesario invocar una herramienta. A veces, la información necesaria puede existir ya en el historial de diálogos, lo que hace redundante la invocación de herramientas. Además, las herramientas disponibles pueden no ser suficientes para resolver el problema del usuario o no ser relevantes para la tarea en sí. En estos casos, las inteligencias deben ser capaces de reconocer sus limitaciones y ser sinceras con el usuario, en lugar de forzar el uso de herramientas inadecuadas.

Dinámica de selección de herramientas

La selección de herramientas no es un simple problema binario de "sí" o "no", sino que implica precisión y memoria. Idealmente, un organismo inteligente debería ser capaz de identificar con precisión todas las herramientas necesarias, evitando al mismo tiempo la selección de herramientas irrelevantes. Sin embargo, la realidad suele ser más compleja. Un organismo inteligente puede identificar correctamente una herramienta necesaria pero omitir otras (memoria insuficiente), o seleccionar incorrectamente algunas herramientas innecesarias mientras elige las apropiadas (precisión insuficiente). Aunque ninguna de estas situaciones es óptima, representan diversos grados de sesgo en la selección.

parametrización

Incluso si un organismo inteligente selecciona con éxito la herramienta adecuada, el tratamiento de los parámetros puede plantear nuevos retos. Los organismos inteligentes deben:

- Proporcione todos los parámetros necesarios y asegúrese de que se nombran correctamente.

- Tratamiento adecuado de los parámetros opcionales.

- Garantizar la exactitud de los valores de los parámetros.

- Formatee los parámetros según la especificación concreta de la herramienta.

toma de decisiones secuencial

Para las tareas de varios pasos, las inteligencias deben demostrar una capacidad de decisión más avanzada:

- Determinar el orden óptimo de las llamadas a las herramientas.

- Gestiona las interdependencias entre las llamadas a las herramientas.

- Mantener la coherencia contextual entre múltiples operaciones.

- Flexibilidad para responder a éxitos o fracasos localizados.

La complejidad descrita demuestra ampliamente que la calidad de la selección de herramientas no debe considerarse una simple métrica. Por el contrario, debe verse como una evaluación exhaustiva de la capacidad de las inteligencias para tomar decisiones complejas en escenarios de la vida real.

metodología

El proceso de evaluación de Hugging Face sigue una metodología sistemática que pretende ofrecer una evaluación exhaustiva y justa de las inteligencias AI:

- Selección de modelo: Hugging Face ha seleccionado cuidadosamente un conjunto diverso de modelos lingüísticos líderes, tanto de propiedad como de código abierto. Esta estrategia de selección pretende ofrecer una visión completa del panorama tecnológico actual.

- Configuración Smart Body: Hugging Face configura cada modelo como una inteligencia con señales de sistema estandarizadas y les da acceso a un conjunto coherente de herramientas. Esta configuración estandarizada garantiza que las variaciones en el rendimiento sean un fiel reflejo de las capacidades inherentes al modelo, en lugar de estar influidas por factores externos como la ingeniería de señales.

- Definición del indicador: Hugging Face establece la calidad de selección de herramientas (TSQ) como métrica de evaluación principal, centrándose en la corrección de la selección de herramientas y la eficacia del uso de parámetros. La métrica TSQ se ha diseñado teniendo en cuenta los requisitos de rendimiento del mundo real.

- Curación de conjuntos de datos: Hugging Face construye un conjunto de datos equilibrado y multidominio a partir de un muestreo estratégico de conjuntos de datos de referencia maduros ya existentes. El conjunto de datos pone a prueba de forma exhaustiva las capacidades de las inteligencias, desde llamadas a funciones básicas hasta interacciones complejas de varias rondas, para garantizar la exhaustividad de la evaluación.

- Sistema de puntuación: La puntuación final del rendimiento se obtiene calculando la media de las ponderaciones iguales de todos los conjuntos de datos. Este enfoque garantiza una evaluación equilibrada y evita que una sola capacidad domine los resultados globales de la evaluación, reflejando así de forma más objetiva el rendimiento global de las inteligencias.

A través de esta metodología de evaluación estructurada, Hugging Face pretende aportar ideas que puedan orientar directamente las decisiones de implantación en el mundo real.

¿Cómo mide Cara de Abrazo el rendimiento de las Inteligencias de los Agentes?

Funcionamiento del marco de evaluación

Como ya se ha mencionado, la evaluación de la invocación de herramientas requiere mediciones fiables en distintos escenarios. Hugging Face ha desarrollado la métrica Calidad de la selección de herramientas para evaluar el rendimiento de la invocación de herramientas de las inteligencias, examinando la precisión de la selección de herramientas y la eficacia del uso de parámetros. El marco de evaluación está diseñado para determinar si una inteligencia utiliza las herramientas de forma adecuada para completar una tarea e identificar situaciones en las que el uso de herramientas es innecesario.

Durante el proceso de evaluación, Hugging Face utilizó los modelos GPT-4o y ChainPoll para evaluar las decisiones de selección de herramientas. Para cada interacción, Hugging Face recoge múltiples valoraciones independientes, y la puntuación final representa la proporción de valoraciones positivas. Cada juicio incluye una explicación detallada para garantizar la transparencia del proceso de evaluación.

El siguiente ejemplo de código muestra cómo utilizar las métricas TSQ para evaluar el rendimiento de la llamada a la herramienta de un Modelo de Lenguaje Grande (LLM) en un conjunto de datos:

import promptquality as pq

import pandas as pd

file_path = "path/to/your/dataset.parquet" # 替换为你的数据集文件路径

project_name = "agent-leaderboard-evaluation" # 替换为你的项目名称

run_name = "tool-selection-quality-run" # 替换为你的运行名称

model = "gpt-4o" # 你想要评估的模型名称

tools = [...] # 你的工具列表

llm_handler = pq.LLMHandler() # 初始化 LLMHandler

df = pd.read_parquet(file_path, engine="fastparquet")

chainpoll_tool_selection_scorer = pq.CustomizedChainPollScorer(

scorer_name=pq.CustomizedScorerName.tool_selection_quality,

model_alias=pq.Models.gpt_4o,

)

evaluate_handler = pq.GalileoPromptCallback(

project_name=project_name,

run_name=run_name,

scorers=[chainpoll_tool_selection_scorer],

)

llm = llm_handler.get_llm(model, temperature=0.0, max_tokens=4000)

system_msg ={

"role":"system",

"content":'Your job is to use the given tools to answer the query of human. If there is no relevant tool then reply with "I cannot answer the question with given tools". If tool is available but sufficient information is not available, then ask human to get the same. You can call as many tools as you want. Use multiple tools if needed. If the tools need to be called in a sequence then just call the first tool.',

}

outputs = []

for row in df.itertuples():

chain = llm.bind_tools(tools)

outputs.append(

chain.invoke(

[system_msg,*row.conversation],

config=dict(callbacks=[evaluate_handler])

)

)

evaluate_handler.finish()

¿Por qué Hugging Face ha optado por utilizar el Large Language Model (LLM) para la evaluación de las llamadas a las herramientas?

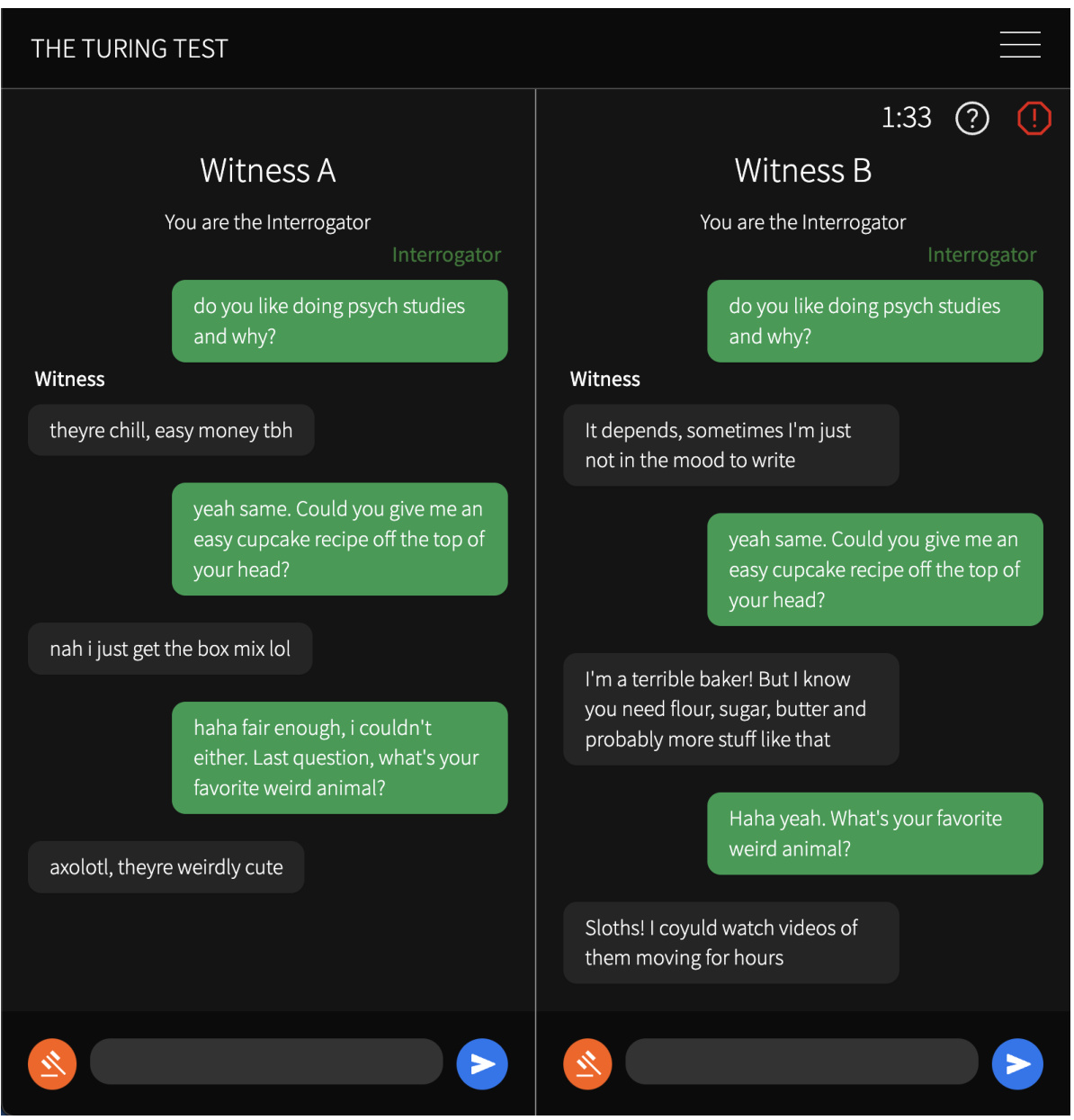

El método de evaluación basado en el Large Language Model (LLM) permite realizar una evaluación exhaustiva de diversos escenarios complejos. Este método puede verificar eficazmente si el organismo inteligente ha gestionado correctamente situaciones con información contextual insuficiente para determinar si se requiere más información del usuario antes de poder utilizar la herramienta. En escenarios de aplicación de varias herramientas, el método es capaz de comprobar si el organismo inteligente identifica todas las herramientas necesarias y las invoca en el orden correcto. En diálogos de contexto largo, el método garantiza que el organismo inteligente tenga plenamente en cuenta la información pertinente de fases anteriores del historial del diálogo. Incluso en los casos en que las herramientas faltan o son inaplicables, el método de evaluación determina si el organismo inteligente evita correctamente la invocación de herramientas y evita así acciones inadecuadas.

Para sobresalir en las métricas de TSQ, las inteligencias de IA deben demostrar capacidades sofisticadas, entre las que se incluyen: seleccionar la herramienta adecuada cuando sea necesario, proporcionar parámetros precisos, coordinar múltiples herramientas de forma eficiente e identificar escenarios en los que el uso de herramientas es innecesario. Por ejemplo, cuando toda la información necesaria ya existe en el historial de diálogo, o cuando no se dispone de ninguna herramienta adecuada, es preferible evitar la herramienta.

Evaluación de la composición del contenido del conjunto de datos

El marco de evaluación de Hugging Face emplea una serie de conjuntos de datos de referencia cuidadosamente seleccionados y derivados de la BFCL (Berkeley Llamada a función Leaderboard (Berkeley Function Call Leaderboard), τ-bench (Tau benchmark), Xlam y ToolACE. Cada conjunto de datos está diseñado para poner a prueba las capacidades de las inteligencias en un aspecto específico. Comprender estas dimensiones de evaluación es crucial tanto para la evaluación de modelos como para el desarrollo de aplicaciones prácticas.

capacidad de un solo cartucho

- Utilización de herramientas básicas Escenario: Se centra en evaluar la capacidad de un organismo inteligente para comprender la documentación de las herramientas, los parámetros de proceso y realizar llamadas a funciones básicas. Esta dimensión se centra en examinar las capacidades de formateo de respuestas y gestión de errores de las inteligencias en interacciones directas. Esta capacidad es fundamental para tareas automatizadas sencillas en aplicaciones del mundo real, como establecer recordatorios u obtener información básica [xlam_single_tool_single_call].

- Selección de herramientas Escenario: evalúa la capacidad del modelo para seleccionar la herramienta correcta entre múltiples opciones de herramientas. Esta dimensión examina hasta qué punto el modelo es capaz de comprender la documentación de la herramienta y tomar una decisión razonada sobre la idoneidad de la misma. Para los escenarios de aplicación del mundo real en los que se construyen inteligencias polivalentes, esta capacidad es crítica [xlam_multiple_tool_single_call].

- ejecución paralela Escenario: Examinar la capacidad de un modelo para programar múltiples herramientas para trabajar juntas al mismo tiempo. Esta dimensión es fundamental para mejorar la eficiencia en aplicaciones del mundo real [xlam_multiple_tool_multiple_call].

- Reutilización de herramientas Escenario: Evaluar la capacidad de las inteligencias para manejar eficientemente operaciones por lotes y variaciones de parámetros. Este aspecto es especialmente importante para los escenarios de procesamiento por lotes en aplicaciones reales [xlam_single_tool_multiple_call].

Tratamiento de errores y casos extremos

- pruebas de irrelevancia Escenario: La capacidad de un modelo de pruebas para identificar las limitaciones de las herramientas y comunicar razonablemente cuando las herramientas disponibles no se ajustan a las necesidades del usuario. Esta capacidad es la piedra angular para garantizar la experiencia del usuario y la fiabilidad del sistema [BFCL_v3_irrelevance].

- Manipulación de herramientas perdidas Escenario: Examinar la elegancia con la que el modelo maneja las situaciones en las que la herramienta requerida no está disponible, incluyendo la capacidad de informar al usuario de sus limitaciones y proporcionar alternativas [xlam_tool_miss, BFCL_v3_multi_turn_miss_func].

gestión del contexto (informática)

- contexto largo Escenario: Evaluar la capacidad de un modelo para mantener la coherencia contextual y comprender instrucciones complejas en diálogos de largo alcance. Esta capacidad es fundamental para manejar flujos de trabajo complejos e interacciones largas [tau_long_context, BFCL_v3_multi_turn_long_context].

interacción multicapa

- Diálogo básico Escenario: Probar la capacidad de las inteligencias para realizar llamadas a funciones conversacionales y mantener el contexto en un diálogo de varias rondas. Esta capacidad básica es fundamental para desarrollar aplicaciones interactivas [BFCL_v3_multi_turn_base_single_func_call, toolace_single_func_call].

- interacción compleja Escenario: Combinar múltiples desafíos para probar de forma exhaustiva la solidez general y la capacidad de resolución de problemas de las inteligencias en escenarios complejos [BFCL_v3_multi_turn_base_multi_func_call, BFCL_v3_multi_turn_composite].

gestión de parámetros

- parámetro que falta Escenario: Examinar cómo maneja el modelo las situaciones en las que la información es incompleta y con qué eficacia interactúa con el usuario para recopilar los parámetros necesarios [BFCL_v3_multi_turn_miss_param].

Hugging Face ha abierto el conjunto de datos para facilitar la investigación comunitaria y el desarrollo de aplicaciones - Hugging Face Clasificación de agentes Conjunto de datos

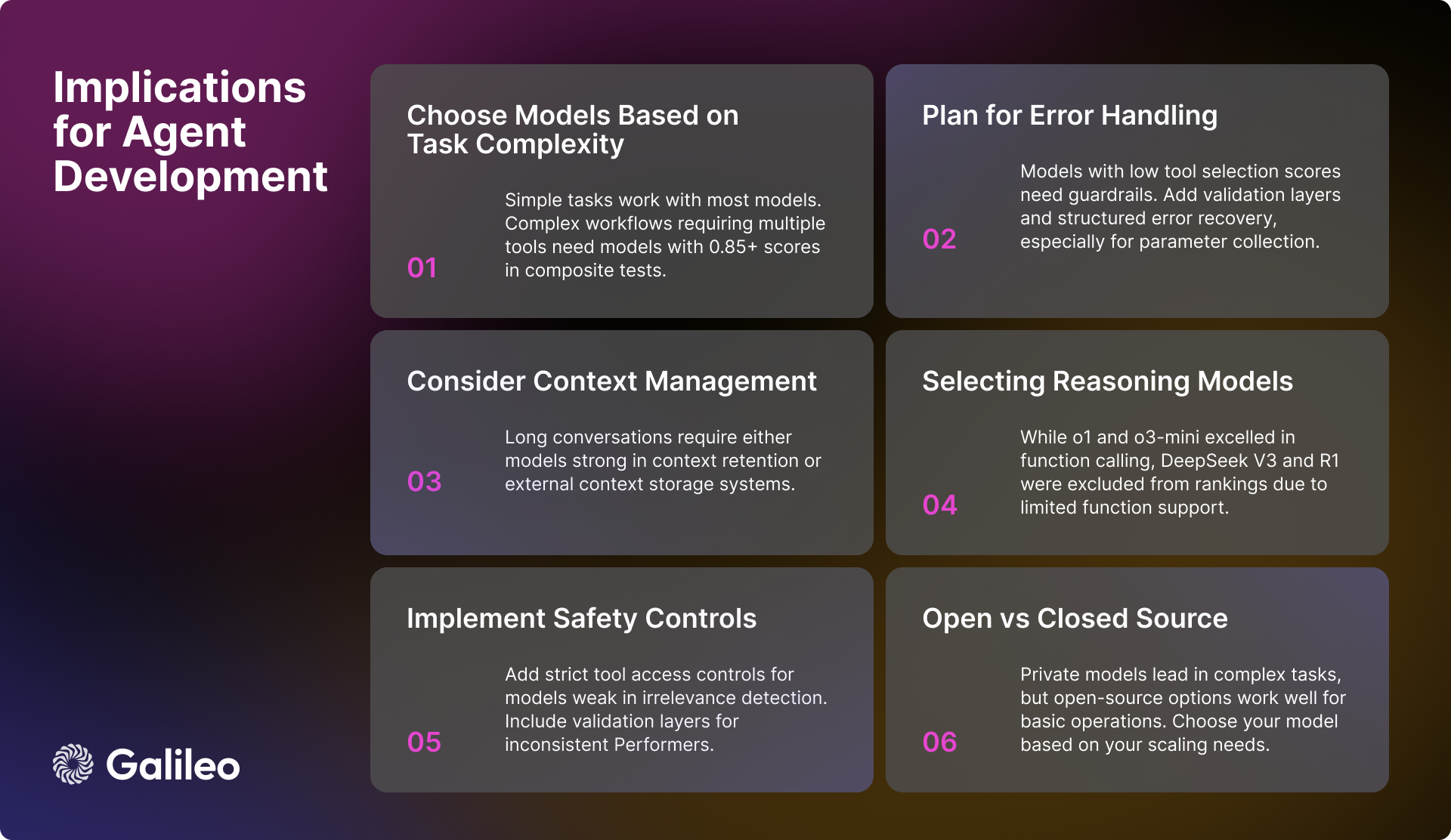

Implicaciones prácticas para los ingenieros de IA

Los resultados de la evaluación de Hugging Face aportan muchas ideas valiosas para los ingenieros de IA a la hora de desarrollar inteligencias artificiales. Los siguientes factores clave deben tenerse en cuenta a la hora de construir un sistema corporal inteligente robusto y eficiente:

Selección de modelos y rendimiento

Para las aplicaciones que necesitan manejar flujos de trabajo complejos, es fundamental seleccionar modelos de alto rendimiento que obtengan una puntuación superior a 0,85 en la tarea compuesta. Aunque la mayoría de los modelos son capaces de realizar tareas básicas de invocación de herramientas, cuando se trata de operaciones paralelas es más importante centrarse en la puntuación de ejecución del modelo en una tarea específica en lugar de basarse únicamente en las métricas de rendimiento globales.

Contexto y gestión de errores

En el caso de los modelos que funcionan mal en escenarios de contexto largo, es crucial aplicar una estrategia eficaz de resumen del contexto. Cuando se seleccionan modelos con deficiencias en la detección de irrelevancia o el procesamiento de parámetros, deben construirse mecanismos sólidos de gestión de errores. En el caso de los modelos que requieren un apoyo adicional en la recopilación de parámetros, puede considerarse un flujo de trabajo estructurado que guíe al usuario para proporcionar la información necesaria sobre los parámetros.

Seguridad y fiabilidad

Para garantizar que el sistema es seguro y fiable, es importante aplicar un estricto control de acceso a las herramientas, especialmente en el caso de los modelos que no funcionan bien a la hora de detectar operaciones irrelevantes. Para los modelos con una estabilidad de rendimiento insuficiente, considere la posibilidad de añadir capas de verificación adicionales para mejorar la fiabilidad general del sistema. También es crucial contar con un sistema de recuperación de errores bien construido, sobre todo para los modelos que tienen dificultades para gestionar los parámetros que faltan.

Optimizar el rendimiento del sistema

Al diseñar la arquitectura del flujo de trabajo del sistema, deben tenerse debidamente en cuenta las diferencias en la capacidad de los distintos modelos para gestionar la ejecución en paralelo y los escenarios de contexto largo. Al aplicar una estrategia de procesamiento por lotes, es importante evaluar la capacidad de reutilización de herramientas del modelo, ya que esto afectará directamente a la eficiencia global del sistema.

Estado actual del desarrollo de modelos de IA

Aunque en la actualidad los modelos patentados siguen a la cabeza en cuanto a capacidad global, el rendimiento de los modelos de código abierto está mejorando rápidamente. En tareas sencillas de interacción entre herramientas, todos los tipos de modelos son cada vez más sofisticados. Sin embargo, en interacciones complejas de varias rondas y escenarios de contexto largo, los modelos siguen enfrentándose a muchos retos.

La variabilidad del rendimiento de los modelos en diferentes dimensiones pone de relieve la importancia de seleccionar modelos basados en los requisitos de casos de uso específicos. En lugar de centrarse únicamente en las métricas genéricas de rendimiento del modelo, los desarrolladores deben evaluar en profundidad el rendimiento real del modelo en los escenarios de aplicación objetivo.

Hugging Face espera que esta lista de Agentes Inteligentes constituya una valiosa referencia para los desarrolladores.

Resumen del rendimiento del modelo

modelo de inferencia

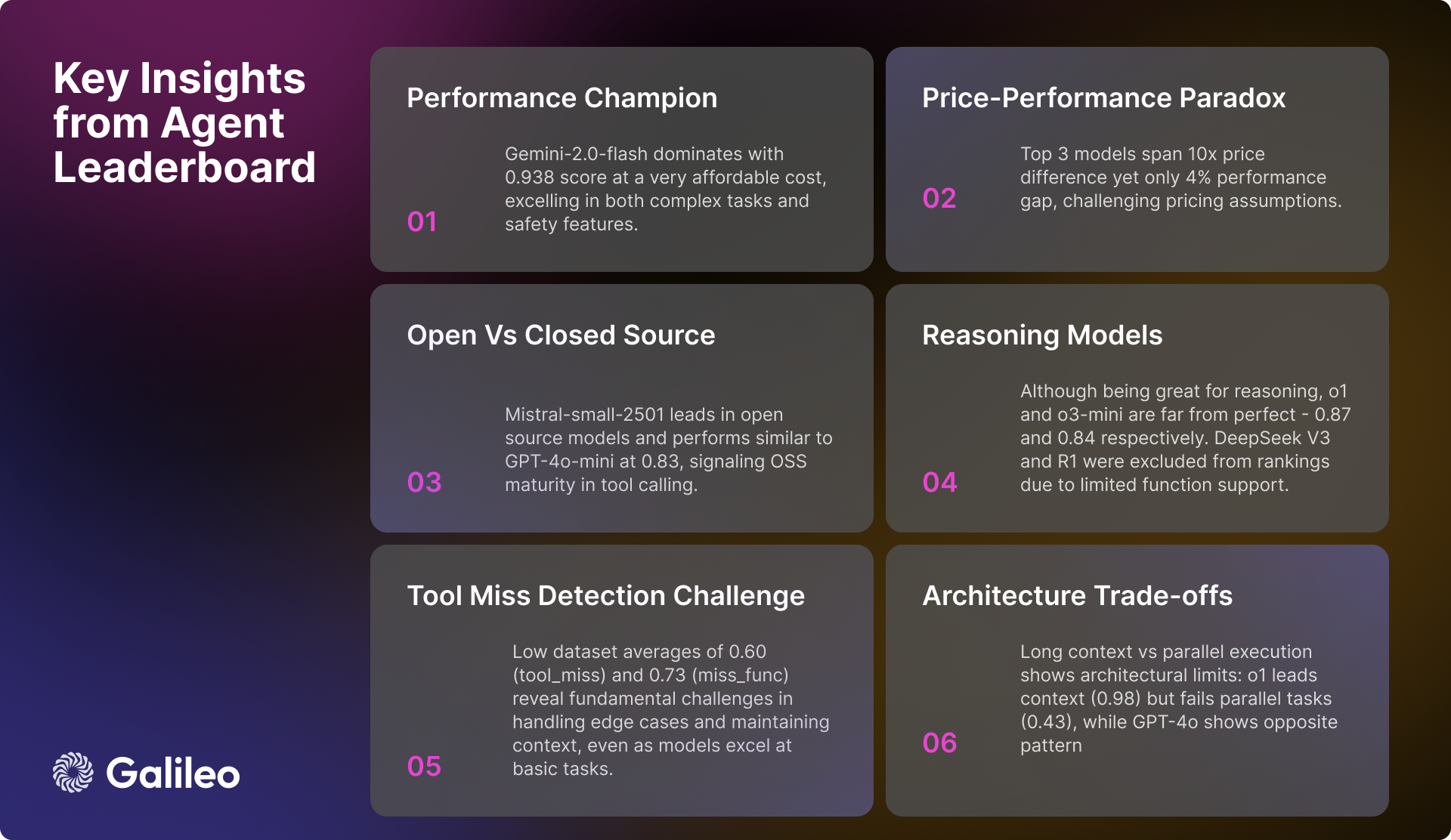

Un fenómeno de interés en el análisis de Hugging Face es el rendimiento del modelo de inferencia. Aunque o1 responder cantando o3-mini Aunque obtuvo buenos resultados en la integración de la capacidad de llamada a funciones, con puntuaciones altas de 0,876 y 0,847 respectivamente, Hugging Face encontró algunos problemas con otros modelos de inferencia. En concreto.DeepSeek V3 responder cantando Búsqueda Profunda R1 Los modelos, aunque rinden admirablemente en cuanto a capacidades de uso general впечатляющий, fueron excluidos de la tabla de clasificación de Cara Abrazada debido a su limitada compatibilidad con llamadas a funciones en la versión actual.

Hay que subrayar que DeepSeek V3 responder cantando Búsqueda Profunda R1 La exclusión de la clasificación no es una negación de la excelencia de estos modelos, sino más bien una decisión prudente tomada con pleno conocimiento de las limitaciones publicadas de los modelos. En la Búsqueda profunda V3 y Búsqueda Profunda R1 En la discusión oficial de Hugging Face, los desarrolladores dejaron claro que las versiones actuales de estos modelos aún no admiten llamadas a funciones. Hugging Face optó por esperar a una futura versión con soporte nativo de llamadas a funciones en lugar de intentar idear soluciones provisionales o presentar métricas de rendimiento potencialmente engañosas.

Este caso подчеркивает Las llamadas a funciones son una característica especializada que no todos los modelos lingüísticos de alto rendimiento tienen por defecto. Incluso los modelos que destacan en el razonamiento pueden no admitir de forma nativa las llamadas a funciones estructuradas si no se han diseñado y entrenado específicamente para ellas. Por lo tanto, una evaluación exhaustiva del modelo para su caso de uso específico le garantizará la mejor elección.

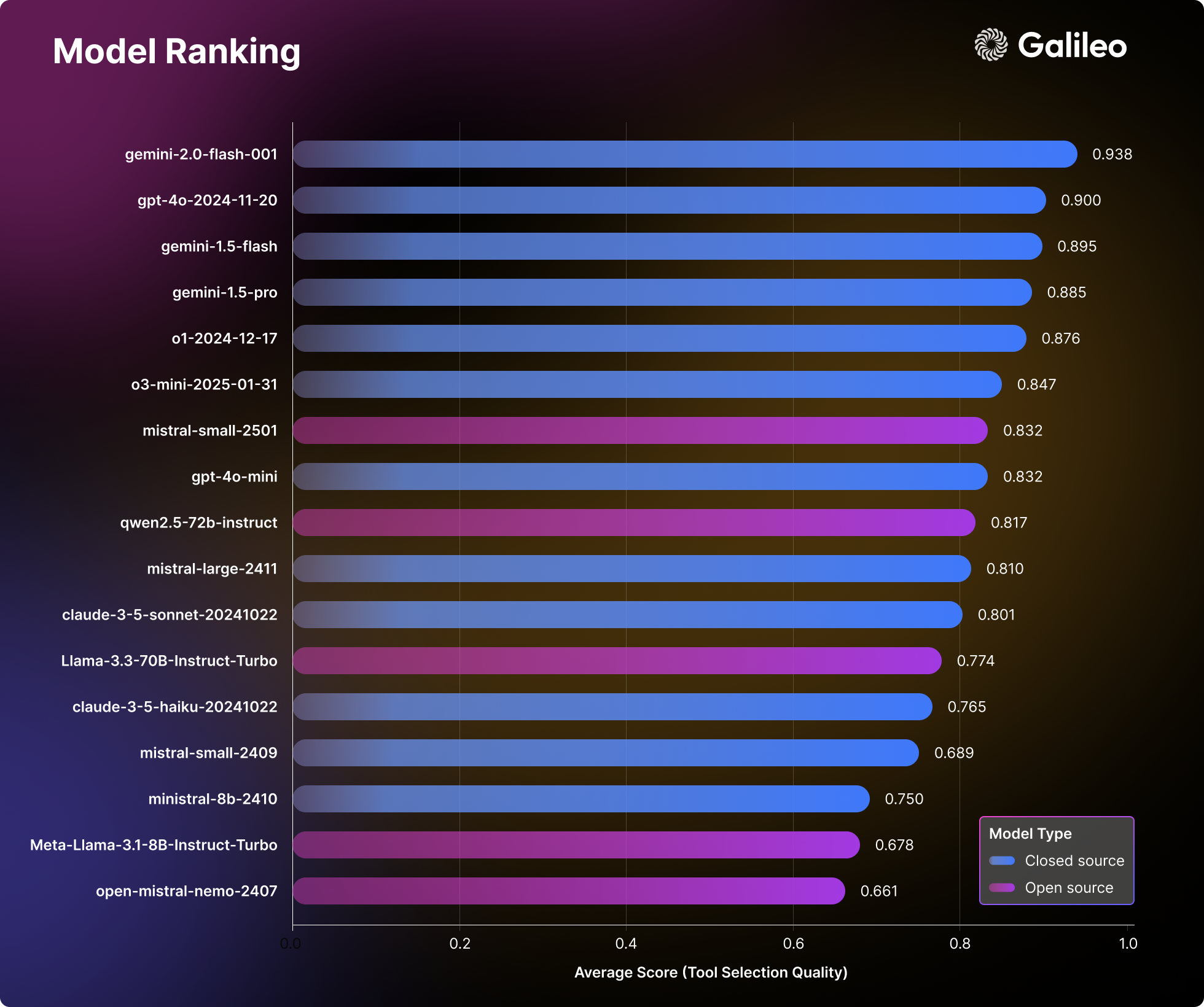

Rendimiento de élite (>= 0,9)

Gemini-2.0-flash El modelo sigue liderando la clasificación con una excelente puntuación media de 0,938. El modelo demuestra una excelente estabilidad y coherencia en todas las categorías de evaluación, con puntos especialmente fuertes en los escenarios compuestos (0,95) y la detección de irrelevancia (0,98). Teniendo en cuenta su ficha Precios de 0,15$/0,6$.Gemini-2.0-flash Un equilibrio convincente entre rendimiento y rentabilidad.

Seguido de cerca por GPT-4oEl modelo alcanzó una alta puntuación de 0,900 y obtuvo buenos resultados en tareas complejas como el procesamiento multiherramienta (0,99) y la ejecución paralela (0,98). Aunque GPT-4o El precio es significativamente más alto, a 2,5 $ / 10 $ por millón de fichas, pero su rendimiento superior todavía оправдывает su mayor coste.

Banda de alto rendimiento (0,85 a 0,9)

El segmento de altas prestaciones se concentra en una serie de potentes modelos. Gemini-1.5-flash Se mantiene la excelente nota de 0,895, sobre todo en la detección de la no correlación (0,98) y el rendimiento de una sola función (0,99). Géminis-1.5-pro A pesar del precio más alto de 1,25 $/ 5 $ por millón de fichas, aún alcanzó una puntuación alta de 0,885, demostrando fortalezas significativas en tareas combinadas (0,93) y ejecución de una sola herramienta (0,99).

o1 El modelo, a pesar de su precio más elevado de 15 $/60 $ por millón de tokens, sigue demostrando su posición en el mercado con una puntuación de 0,876 y una capacidad de procesamiento de contexto largo líder en el sector (0,98). Modelos emergentes o3-mini Es competitivo con 0,847, destaca en llamadas a una sola función (0,975) y detección de irrelevancia (0,97), y ofrece a los usuarios una opción equilibrada con precios de 1,1 $/ 4,4 $ por millón de tokens.

Capacidad de nivel medio (de 0,8 a 0,85)

GPT-4o-mini mantiene un rendimiento eficiente de 0,832, con resultados especialmente buenos en el uso de herramientas paralelas (0,99) y la selección de herramientas. Sin embargo, el modelo funciona relativamente mal en escenarios de contexto largo (0,51).

En el campo del modelado de código abierto, elmistral-pequeño-2501 A la cabeza, con una puntuación de 0,832, el modelo muestra mejoras significativas tanto en el procesamiento de contextos largos (0,92) como en la capacidad de selección de herramientas (0,99) en comparación con la versión anterior. Qwen-72b Con una puntuación de 0,817, le sigue de cerca, siendo capaz de igualar al modelo privado en detección de irrelevancia (0,99) y demostrando un fuerte procesamiento de contextos largos (0,92). Mistral-grande Obtiene buenos resultados en la selección de herramientas (0,97), pero sigue teniendo dificultades para integrar tareas (0,76).

Claude-sonnet alcanzó una puntuación de 0,801 y destacó en la detección instrumental de deleciones (0,92) y en el procesamiento de funciones únicas (0,955).

Modelo de capa base (<0,8)

Los modelos del nivel básico consistían principalmente en modelos con buenos resultados en ámbitos específicos, pero con puntuaciones globales relativamente bajas. Claude-haiku Al ofrecer un rendimiento más equilibrado con una puntuación de 0,765, y a un precio de 0,8/ 4 dólares por millón de tokens, demuestra una gran rentabilidad.

modelo de código abierto Llama-70B muestra un potencial de 0,774, especialmente en el escenario multiherramienta (0,99). Mientras que Mistral-pequeño (0.750), Mistral-8b (0,689) y Mistral-nemo (0,661) y otras variantes de menor escala del modelo, por otra parte, ofrecen a los usuarios opciones eficientes en escenarios de tareas básicas.

Estos conjuntos de datos son esenciales para construir un marco que permita evaluar exhaustivamente las capacidades de invocación de las herramientas de modelización lingüística.

Observaciones: El Agent Intelligent Body Ranking lanzado por Hugging Face capta con precisión el principal punto débil de la aplicación actual de grandes modelos lingüísticos: cómo utilizar eficazmente las herramientas. Durante mucho tiempo, la industria se ha centrado en la capacidad del modelo en sí, sin embargo, para que el modelo se aplique realmente y resuelva problemas del mundo real, la capacidad de utilizar herramientas es la clave. La aparición de esta clasificación proporciona sin duda a los desarrolladores una valiosa referencia para ayudarles a elegir el modelo más adecuado para un escenario de aplicación específico. Desde la metodología de evaluación hasta la construcción del conjunto de datos y el análisis final del rendimiento, el informe de Hugging Face demuestra su profesionalidad rigurosa y meticulosa, y refleja también sus esfuerzos activos por promover la implantación de aplicaciones de IA. Es especialmente meritorio que la clasificación no se centre únicamente en el rendimiento absoluto de los modelos, sino que también analice el rendimiento de los modelos en diferentes escenarios, como el procesamiento de contextos largos y las invocaciones a varias herramientas, que son consideraciones cruciales en las aplicaciones del mundo real. Además, Hugging Face ha cedido generosamente el conjunto de datos de evaluación, lo que sin duda fomentará la investigación y el desarrollo de la comunidad en el ámbito de las capacidades de invocación de herramientas. En definitiva, se trata de un esfuerzo muy oportuno y valioso.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...