HiOllama: una interfaz de chat limpia para interactuar con los modelos nativos de Ollama

Últimos recursos sobre IAActualizado hace 1 año Círculo de intercambio de inteligencia artificial 47.5K 00

Introducción general

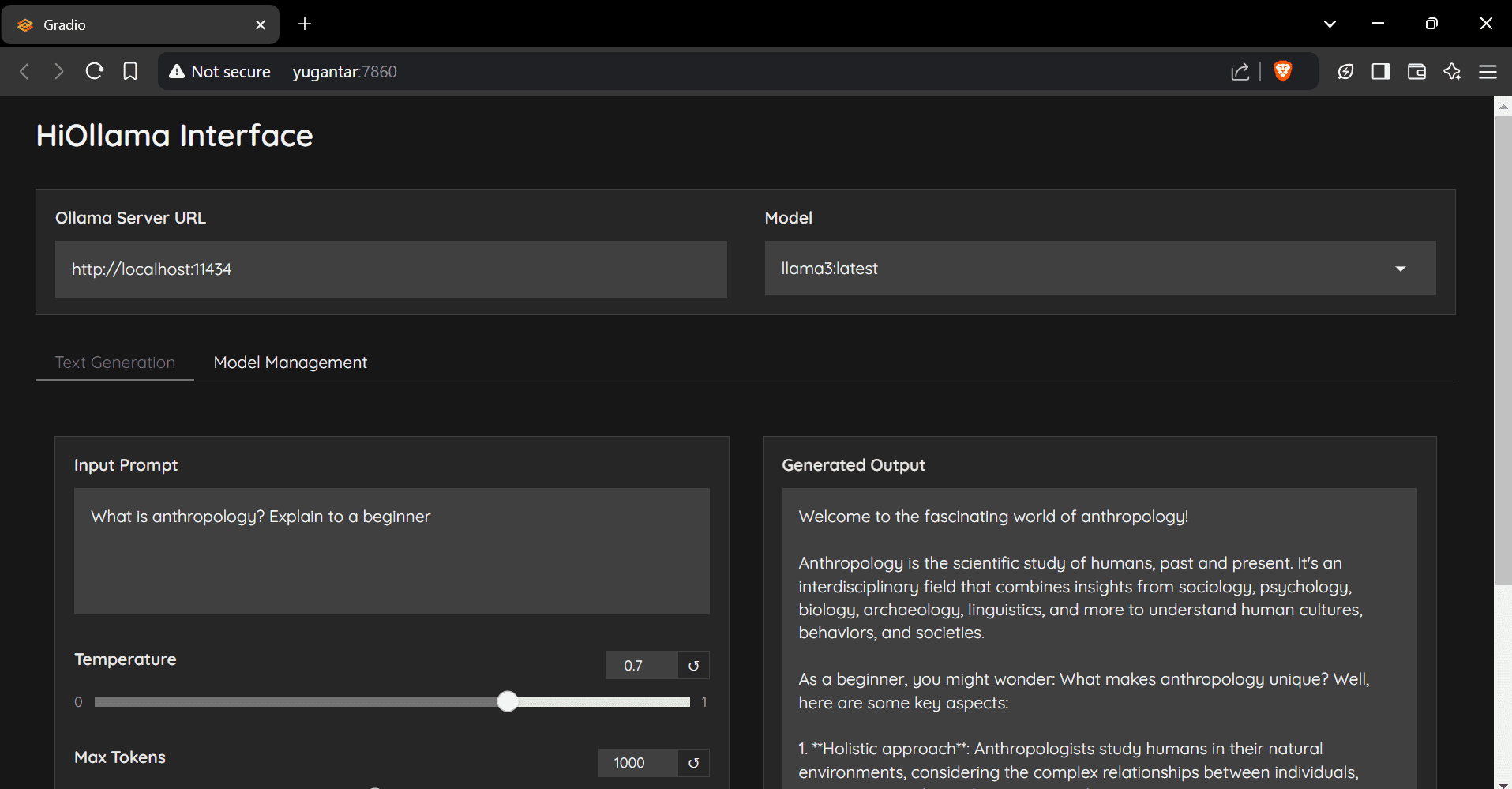

HiOllama es una interfaz fácil de usar basada en Python y Gradio diseñada para interactuar con los modelos de Ollama. Proporciona una interfaz web sencilla e intuitiva que admite funciones de generación de texto en tiempo real y gestión de modelos. Los usuarios pueden ajustar parámetros como la temperatura y el número máximo de tokens, y admite la gestión de múltiples modelos Ollama y la configuración personalizada de la URL del servidor.

RECOMENDACIÓN: Ollama Vs. Abrir WebUI La integración es más sencilla, pero los costes de implantación son ligeramente superiores.

Lista de funciones

- Interfaz web sencilla e intuitiva

- Generación de texto en tiempo real

- Parámetros ajustables (temperatura, número máximo de fichas)

- Funciones de gestión de modelos

- Compatibilidad con varios modelos de Ollama

- Configuración personalizada de la URL del servidor

Utilizar la ayuda

Pasos de la instalación

- Almacén de clonación:

git clone https://github.com/smaranjitghose/HiOllama.git cd HiOllama - Crear y activar un entorno virtual:

- Ventanas.

python -m venv env .\env\Scripts\activate - Linux/Mac.

python3 -m venv env source env/bin/activate

- Ventanas.

- Instale los paquetes necesarios:

pip install -r requirements.txt - Instale Ollama (si no está ya instalado):

- Linux/Mac.

curl -fsSL https://ollama.ai/install.sh | sh - Ventanas.

Instale primero WSL2 y, a continuación, ejecute el comando anterior.

- Linux/Mac.

Pasos de uso

- Inicie el servicio Ollama:

ollama serve - Corre HiOllama:

python main.py - Abra su navegador y vaya a

http://localhost:7860

Guía de inicio rápido

- Seleccione un modelo en el menú desplegable.

- Introduzca el mensaje en el área de texto.

- Ajuste la temperatura y el número máximo de fichas según sea necesario.

- Haga clic en "Generar" para obtener la respuesta.

- Utilice la opción Gestión de modelos para introducir nuevos modelos.

configure

La configuración por defecto puede establecerse enmain.pyModificado en:

DEFAULT_OLLAMA_URL = "http://localhost:11434"

DEFAULT_MODEL_NAME = "llama3"

problemas comunes

- error de conexión: Asegúrese de que Ollama se está ejecutando (

ollama serve), compruebe que la URL del servidor es correcta y asegúrese de que el puerto 11434 es accesible. - Modelo no encontradoPrimero tira del modelo:

ollama pull model_nameconsulte los modelos disponibles:ollama list. - conflicto portuario: en

main.pyCambie el puerto enapp.launch(server_port=7860) # 更改为其他端口

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...