GPUStack: gestión de clusters de GPU para ejecutar grandes modelos lingüísticos e integrar rápidamente servicios comunes de inferencia para LLM.

Últimos recursos sobre IAPublicado hace 1 año Círculo de intercambio de inteligencia artificial 72K 00

Introducción general

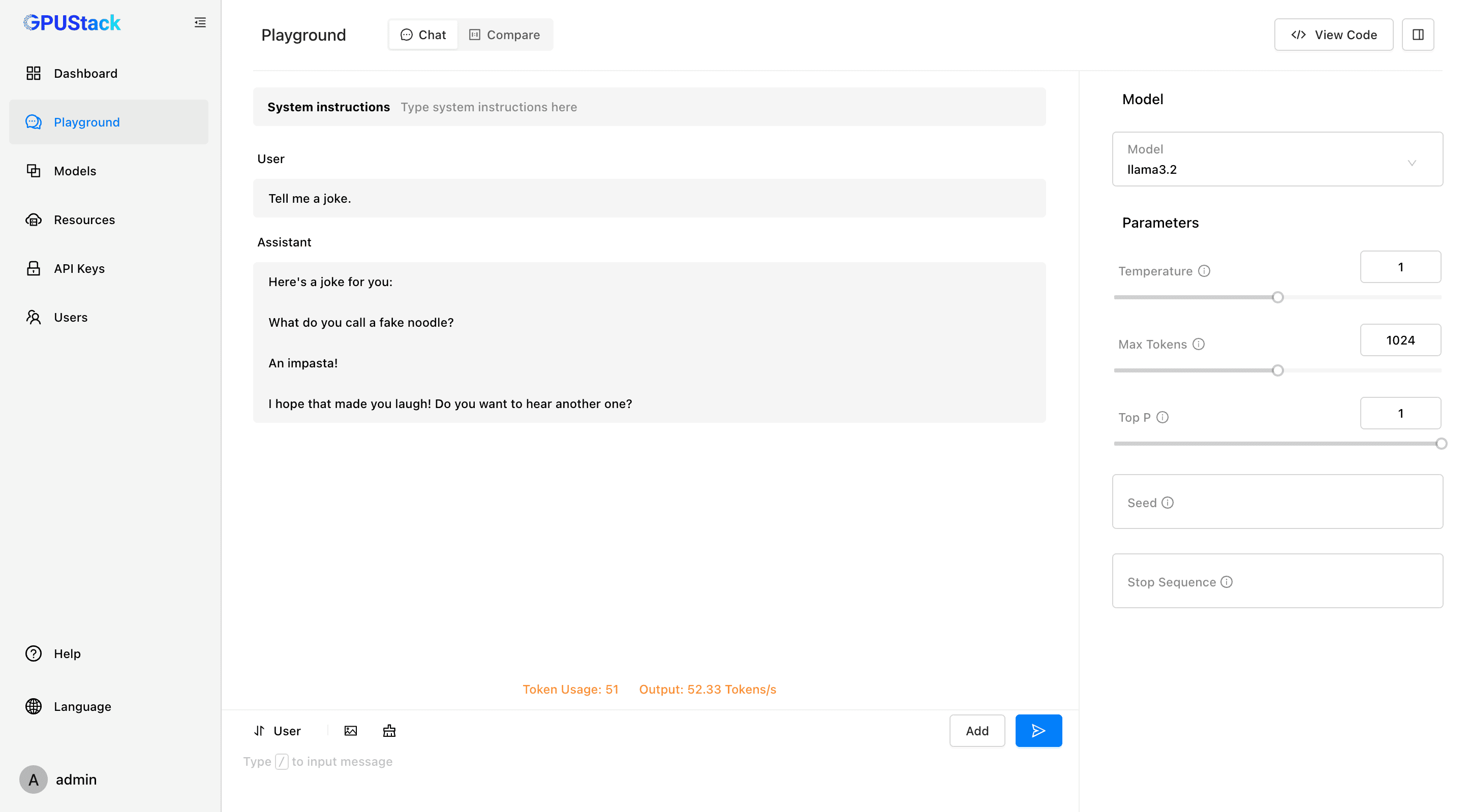

GPUStack es una herramienta de código abierto para la gestión de clusters de GPU diseñada para ejecutar grandes modelos lingüísticos (LLM). GPUStack proporciona funciones de inferencia distribuida, admite servicios e inferencia multi-GPU y multi-nodos y es compatible con la API OpenAI, lo que simplifica la gestión de usuarios y claves API y la monitorización en tiempo real del rendimiento y la utilización de la GPU. Es compatible con la API OpenAI, simplifica la gestión de usuarios y claves API y monitoriza el rendimiento y la utilización de la GPU en tiempo real. Su diseño de paquete Python ligero garantiza un mínimo de dependencias y sobrecarga operativa, por lo que resulta ideal para desarrolladores e investigadores.

Lista de funciones

- Compatible con múltiples hardware: Compatible con Apple Metal, NVIDIA CUDA, Ascend CANN, Moore Threads MUSA y más.

- Inferencia distribuida: admite inferencia y servicios multi-GPU y multinodo en un único nodo.

- Múltiples backends de inferencia: soporte para llama-box (llama.cpp) y vLLM.

- Paquetes Python ligeros: dependencias y sobrecarga operativa mínimas.

- API compatible con OpenAI: Proporciona servicios de API compatibles con el estándar OpenAI.

- Gestión de usuarios y claves API: simplifica la gestión de usuarios y claves API.

- Monitorización del rendimiento de la GPU: Supervisa el rendimiento y la utilización de la GPU en tiempo real.

- Supervisión del uso de tokens y de la velocidad: Gestione eficazmente el uso de tokens y la limitación de la velocidad.

Utilizar la ayuda

Proceso de instalación

Linux o MacOS

- Abre el terminal.

- Ejecute el siguiente comando para instalar GPUStack:

curl -sfL https://get.gpustack.ai | sh -s -

- Tras la instalación, GPUStack se ejecutará como un servicio en el sistema systemd o launchd.

Windows (ordenador)

- Ejecute PowerShell como administrador (evite utilizar PowerShell ISE).

- Ejecute el siguiente comando para instalar GPUStack:

Invoke-Expression (Invoke-WebRequest -Uri "https://get.gpustack.ai" -UseBasicParsing).Content

Normas de uso

configuración inicial

- Acceso a la interfaz de usuario de GPUStack: Abrir en el navegador

http://myserver. - Utilizar el nombre de usuario por defecto

adminy la contraseña inicial para iniciar sesión. Método para obtener la contraseña inicial:- Linux o MacOS: ejecute

cat /var/lib/gpustack/initial_admin_password. - Windows: en funcionamiento

Get-Content -Path "$env:APPDATA\gpustack\initial_admin_password" -Raw.

- Linux o MacOS: ejecute

Creación de claves API

- Tras iniciar sesión en la interfaz de usuario de GPUStack, haga clic en "Claves API" en el menú de navegación.

- Haga clic en el botón "Nueva clave API", introduzca el nombre y guárdela.

- Copie la clave API generada y guárdela correctamente (visible sólo en el momento de la creación).

Uso de la API

- Configuración de variables de entorno:

export GPUSTACK_API_KEY=myapikey

- Utilice curl para acceder a las API compatibles con OpenAI:

curl http://myserver/v1-openai/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer $GPUSTACK_API_KEY" \

-d '{

"model": "llama3.2",

"messages": [

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "Hello!"}

],

"stream": true

}'

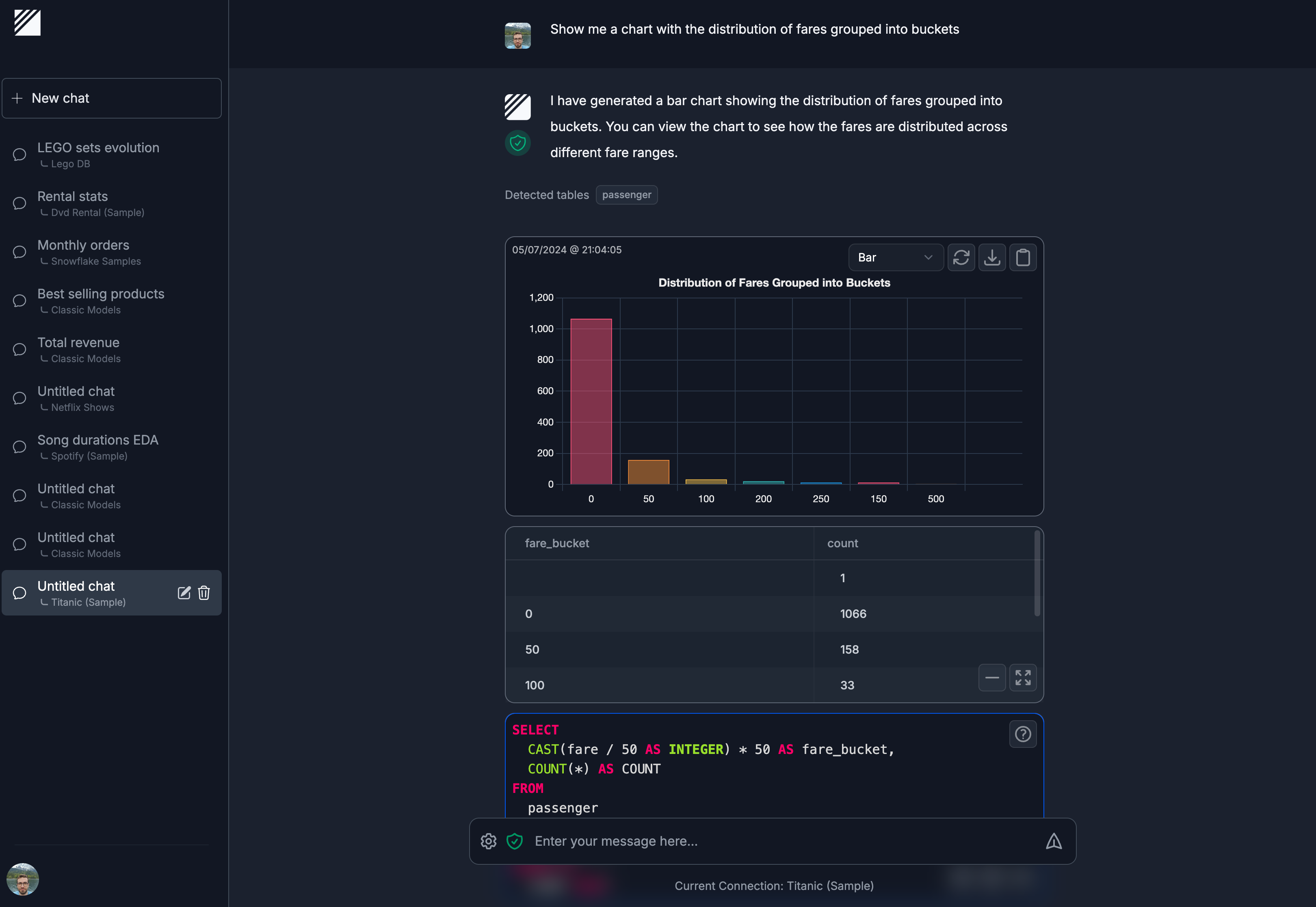

Corre y chatea

- Ejecuta el siguiente comando en el terminal para chatear con el modelo llama3.2:

gpustack chat llama3.2 "tell me a joke."

- Haz clic en "Playground" en GPUStack UI para interactuar.

Seguimiento y gestión

- Supervisa el rendimiento y la utilización de la GPU en tiempo real.

- Gestione las claves de usuario y API, realice un seguimiento del uso de tokens y de las tarifas.

Modelos y plataformas compatibles

- Modelos compatibles: LLaMA, Mistral 7B, Mixtral MoE, Falcon, Baichuan, Yi, Deepseek, Qwen, Phi, Grok-1 y otros.

- Modelos multimodales compatibles: Llama3.2-Vision, Pixtral, Qwen2-VL, LLaVA, InternVL2 y otros.

- Plataformas compatibles: macOS, Linux, Windows.

- Aceleradores soportados: Apple Metal, NVIDIA CUDA, Ascend CANN, Moore Threads MUSA, con planes futuros para soportar AMD ROCm, Intel oneAPI, Qualcomm AI Engine.

Documentación y Comunidad

- Documentación oficial: visite Documentación de GPUStack Obtenga la guía completa y la documentación de la API.

- Guía de contribuciones: Lectura Directrices de contribución Descubra cómo puede contribuir a GPUStack.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...