gpt-oss - una familia de modelos de inferencia de código abierto de OpenAI

Últimos recursos sobre IAActualizado hace 7 meses Círculo de intercambio de inteligencia artificial 38.1K 00

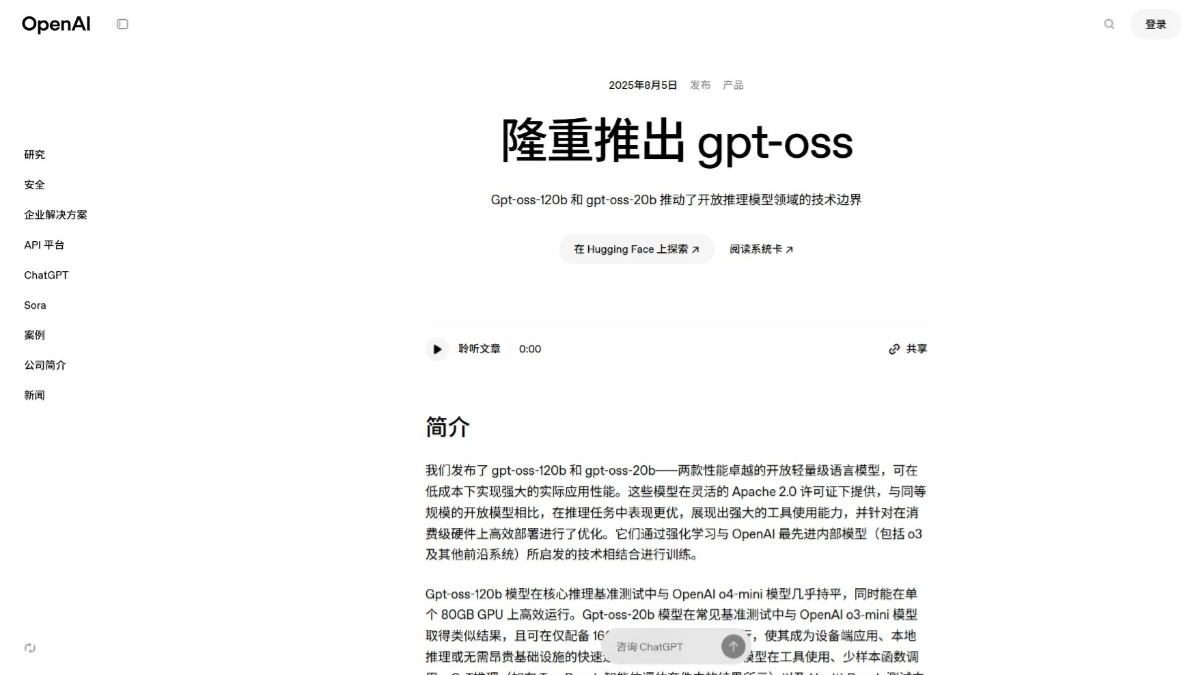

Qué es gpt-oss

gpt-oss es la familia de modelos de inferencia de código abierto de OpenAI que permite soluciones de IA eficientes, flexibles y fáciles de implementar para desarrolladores. gpt-oss consta de dos versiones, gpt-oss-120B, con 117.000 millones de parámetros y soporte para ejecutarse en GPU de 80 GB, y gpt-oss-20B, con 21.000 millones de parámetros y soporte para su uso en dispositivos normales con 16 GB de RAM. con 21.000 millones de parámetros para su uso en un dispositivo normal con 16 GB de RAM. Ambos se basan en la arquitectura MoE, admiten una longitud de contexto de 128 k y ofrecen una inferencia rápida con un rendimiento cercano al de los programas de código cerrado o4-mini y o3-minigpt-oss admite la invocación de herramientas, el pensamiento en cadena, es adecuado para tareas de inferencia de varios pasos, proporciona pesos de código abierto y funciones de ajuste de la fuerza de inferencia para satisfacer diferentes escenarios.

Principales características de gpt-oss

- Capacidad de mecanizado: Soporte para llamar a herramientas externas, como hacer búsquedas en la web o ejecutar código Python, para ayudar a resolver tareas complejas.

- Apoyo al razonamiento encadenadoEl modelo descompone las tareas complejas paso a paso y luego las resuelve una a una, y es adecuado para tratar problemas que requieren un razonamiento de varios pasos.

- baja necesidad de recursosLa gpt-oss-20B admite la ejecución en un dispositivo normal con 16 GB de RAM, y la gpt-oss-120B admite la ejecución en una única GPU de 80 GB, que puede adaptarse a distintos entornos de hardware.

- Respuesta de inferencia rápidaEl modelo es capaz de inferir a velocidades de 40-50 tokens/s, y funciona bien en situaciones que requieren respuestas rápidas.

- Código abierto y personalizaciónSe proporcionan los pesos y el código completos del modelo, y los usuarios los ajustan y personalizan localmente para satisfacer mejor los requisitos de tareas específicas.

- Fuerza de inferencia ajustableSección: admite configuraciones de fuerza de inferencia baja, media y alta, que los usuarios ajustan según sus necesidades y escenarios específicos, equilibrando la relación entre latencia y rendimiento para lograr el mejor uso.

La dirección del sitio web oficial de gpt-oss

- Página web del proyecto:: https://openai.com/zh-Hans-CN/index/introducing-gpt-oss/

- Repositorio GitHub:: https://github.com/openai/gpt-oss

- Biblioteca de modelos HuggingFace:: https://huggingface.co/collections/openai/gpt-oss-68911959590a1634ba11c7a4

- Demostración de la experiencia en línea:: https://gpt-oss.com/

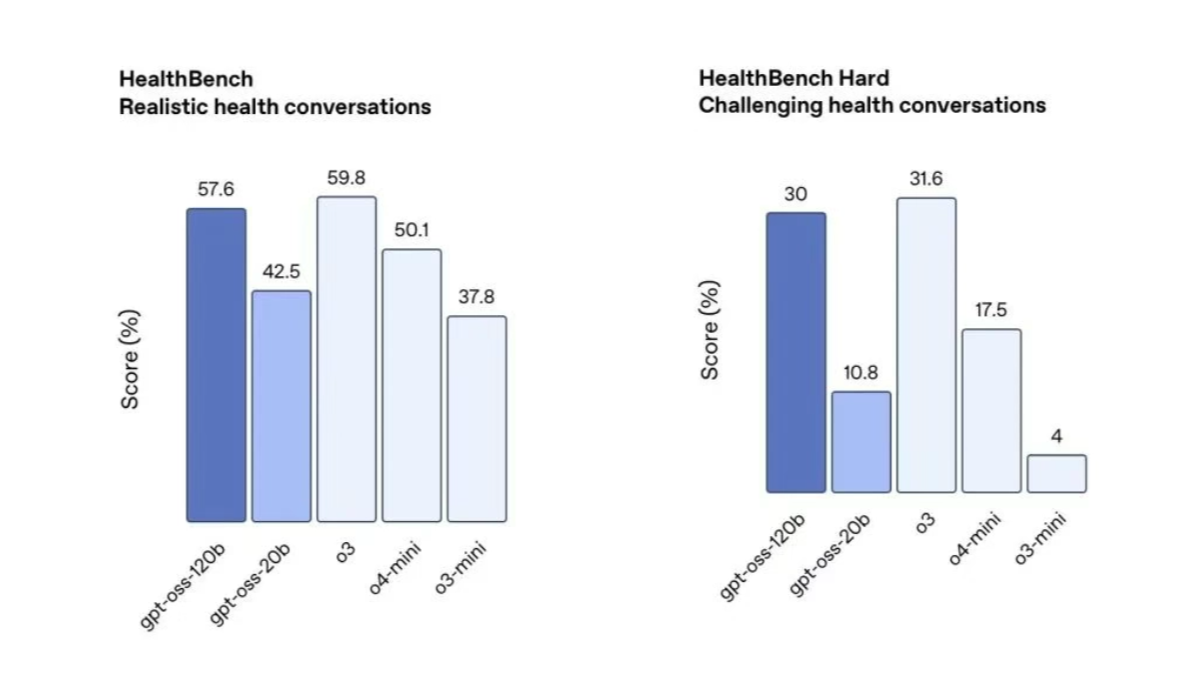

Rendimiento de gpt-oss

- Programación de concursosEn la prueba de programación de la competición Codeforces, gpt-oss-120B obtuvo 2622 puntos y gpt-oss-20B 2516. Ambas versiones obtuvieron mejores resultados que algunos de los modelos de código abierto, y ligeramente peores que los de código cerrado. o3-mini y o4-mini, demostrando una gran capacidad de programación.

- Resolución genérica de problemasgpt-oss-120B supera a o3-mini de OpenAI y se acerca al nivel de o4-mini en las pruebas MMLU (Multi-task Language Understanding) y HLE (Human Level Evaluation). Esto demuestra que gpt-oss tiene una gran precisión y capacidad de razonamiento lógico cuando se enfrenta a problemas genéricos.

- Llamada a la herramientaTanto gpt-oss-120B como gpt-oss-20B superan a o3-mini de OpenAI en la suite de evaluación de cuerpos inteligentes TauBench, e incluso alcanzan o superan el nivel de o4-mini. Esto demuestra que gpt-oss tiene una gran eficiencia y precisión a la hora de invocar herramientas externas (por ejemplo, búsqueda web, intérprete de código, etc.), y puede resolver problemas complejos con eficacia.

- Preguntas y respuestas sobre saludEn la prueba HealthBench, gpt-oss-120B supera a o4-mini, y gpt-oss-20B alcanza un nivel comparable a o3-mini. Esto demuestra que gpt-oss tiene una gran precisión y fiabilidad a la hora de tratar temas relacionados con la salud y puede proporcionar valiosos consejos e información a los usuarios.

Cómo utilizar gpt-oss

- Plataforma de experiencia en línea::

- Dirección de la experiencia en línea: Visite la experiencia en línea en https://gpt-oss.com/

- procedimiento::

- Abra el enlace anterior.

- Introduzca una pregunta o instrucción en la página web.

- Haga clic en "Enviar" para obtener una respuesta del modelo.

- Despliegue de repositorios GitHub::

- Visite el repositorio GitHub en:: https://github.com/openai/gpt-oss

- almacén de clones::

git clone https://github.com/openai/gpt-oss.git

cd gpt-oss- Instalación de dependencias::

pip install -r requirements.txt- Descargar modelos de pesos: Seleccione el archivo de peso para gpt-oss-20b o gpt-oss-120b según sea necesario y colóquelo en el directorio especificado.

- modelo operativoEjecute el script de inferencia del modelo siguiendo las instrucciones del repositorio. Ejemplo:

python run_inference.py --model gpt-oss-20b --input "你的输入文本"Principales ventajas de gpt-oss

- Código abierto y flexibilidadSe facilitan los pesos y el código del modelo completo para facilitar el ajuste y la personalización locales con el fin de satisfacer necesidades específicas.

- Eficacia de la inferenciaVelocidades de inferencia de hasta 40-50 tokens/s, diseño de baja latencia para escenarios de respuesta rápida.

- Amplia gama de aplicacionesLa empresa admite una amplia gama de entornos de hardware, desde dispositivos medios con 16 GB de RAM hasta dispositivos de alto rendimiento con GPU de 80 GB.

- Razonamiento sólido: Admite el razonamiento encadenado y la invocación de herramientas, lo que permite resolver problemas complejos paso a paso y ampliar la gama de aplicaciones.

- Seguridad y fiabilidadFase de preentrenamiento: la fase de preentrenamiento filtra los datos perjudiciales y realiza un ajuste fino adversarial para garantizar que el modelo sea seguro y fiable.

Personas a las que va dirigido gpt-oss

- Desarrolladores e ingenierosLos desarrolladores e ingenieros necesitan modelos de código abierto para el desarrollo de proyectos, la creación rápida de prototipos o la personalización, y la flexibilidad y el código abierto que ofrecen los modelos pueden satisfacer estas necesidades.

- Científicos de datos e investigadoresLos científicos de datos y los investigadores se interesan por los mecanismos internos del modelo y desean afinarlos, experimentarlos o investigarlos, y la naturaleza de código abierto del modelo les ayuda a explorar y optimizar el modelo en profundidad.

- usuario empresarial: Los usuarios empresariales necesitan modelos de inferencia de alto rendimiento y bajo coste para tareas de atención al cliente inteligente, análisis de datos o automatización, en las que las capacidades comerciales gratuitas y de inferencia eficiente del modelo resultan ideales.

- Educadores y estudiantes: En educación, como ayuda al aprendizaje para ayudar a los estudiantes a responder preguntas, dar consejos de escritura o realizar ejercicios de programación.

- trabajador creativo: Incluidos escritores, guionistas, desarrolladores de juegos, etc., el modelo les ayuda a generar contenidos creativos, inspirar y mejorar la eficacia creativa.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...