Google lanza el modelo Gemma 3 QAT: los mejores modelos de IA llegan a las GPU de consumo

Tras el lanzamiento el mes pasado de una nueva generación de modelos abiertos Gemma 3 Google ha ampliado recientemente su ecosistema de modelos con una nueva versión optimizada para Quantization-Aware Training (QAT). Gemma 3 se ha utilizado anteriormente en BF16 La precisión es inferior a la de una única GPU de gama alta (por ejemplo. NVIDIA H100La versión QAT está diseñada para reducir significativamente los requisitos de memoria de los modelos, manteniendo al mismo tiempo la mayor calidad de salida posible, lo que permite ejecutar potentes modelos de IA en un hardware de mayor calidad para el consumidor. Y la versión QAT está diseñada para reducir significativamente los requisitos de memoria del modelo, manteniendo al mismo tiempo la mayor calidad de salida posible, lo que permite a los modelos de IA potentes ejecutarse en hardware de grado más consumidor.

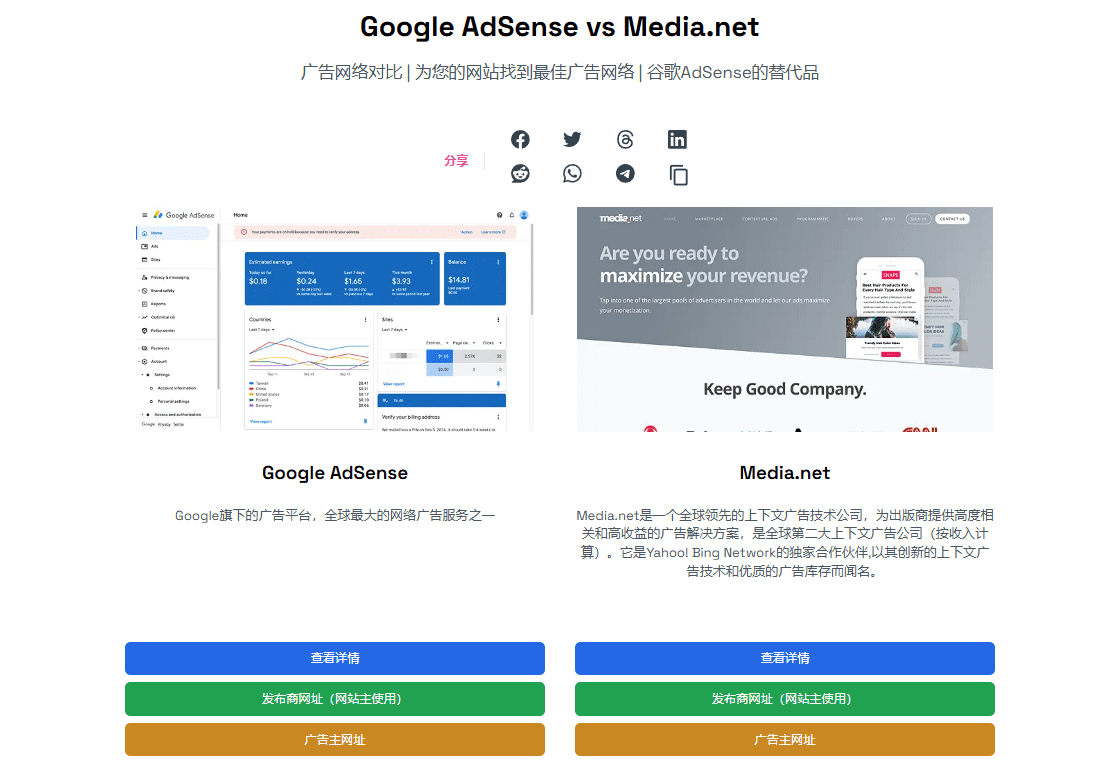

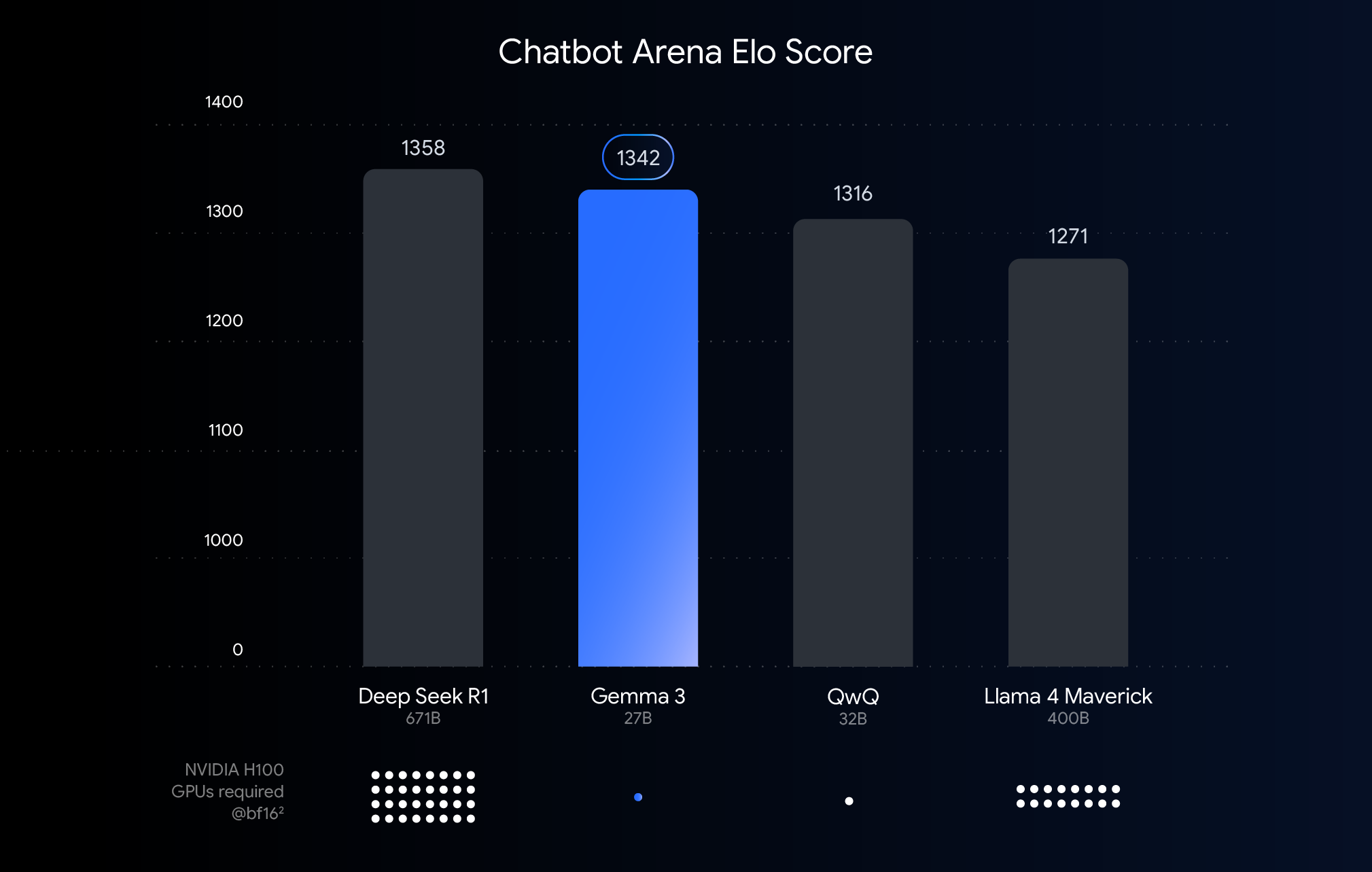

Este gráfico clasifica los modelos de IA en función de las puntuaciones Elo de Chatbot Arena, donde las puntuaciones más altas representan una mayor preferencia del usuario. Los puntos indican lo que el modelo necesita para funcionar NVIDIA H100 El número estimado de GPUs.

Comprender los umbrales de rendimiento, precisión y cuantificación

El gráfico anterior muestra una comparación del rendimiento (puntuaciones Elo) de grandes modelos lingüísticos publicados recientemente. Las barras más altas indican que los modelos obtienen mejores resultados en las comparaciones anónimas realizadas por evaluadores humanos. En la parte inferior del gráfico se indica el rendimiento en el BF16 necesarios para ejecutar cada modelo con el tipo de datos NVIDIA H100 Número estimado de GPU.

opción BF16 La comparación se debe a que se trata de un formato numérico de uso común para muchas inferencia de modelos a gran escala, que representa parámetros de modelos almacenados con una precisión de 16 bits. En el caso del formato unificado BF16 Las comparaciones bajo la configuración ayudan a evaluar las capacidades inherentes del propio modelo en la misma configuración de inferencia, excluyendo las variables introducidas por hardware diferente o técnicas de optimización como la cuantificación.

Cabe señalar que, aunque el gráfico utiliza BF16 hacer una comparación justa, pero en el despliegue real de modelos muy grandes, para reducir la enorme demanda de hardware (por ejemplo, el número de procesadores gráficos), a menudo es necesario utilizar un sistema como el FP8 y otros formatos de menor precisión, lo que puede exigir un compromiso entre rendimiento y viabilidad.

Romper las barreras del hardware: hacer más accesible la IA

Aunque Gemma 3 funciona bien en hardware de gama alta para despliegues en la nube y escenarios de investigación, los comentarios de los usuarios indican claramente que el mercado espera poder utilizar las capacidades de Gemma 3 en el hardware existente. Impulsar la adopción de potentes tecnologías de IA significa que los modelos deben ejecutarse de forma eficiente en GPU de consumo, habituales en ordenadores de sobremesa, portátiles e incluso dispositivos móviles. La ejecución local de modelos de gran tamaño no sólo mejora la privacidad de los datos, reduce la latencia de la red y admite aplicaciones offline, sino que también ofrece más margen para la personalización por parte del usuario.

Tecnología QAT: la clave para equilibrar rendimiento y accesibilidad

Las técnicas de cuantificación son fundamentales para alcanzar este objetivo. En los modelos de IA, la cuantificación pretende reducir la precisión de los números (es decir, los parámetros del modelo) utilizados en el almacenamiento y cálculo del modelo. Esto es similar a comprimir una imagen reduciendo el número de colores utilizados en ella. En comparación con el uso de 16 bits por número (BF16), la cuantificación puede utilizar menos bits, por ejemplo 8 bits (int8) o incluso de 4 bits (int4).

adopción int4 Esto significa que cada dígito está representado por sólo 4 bits y que el tamaño de los datos es menor que el del BF16 Reducido en un factor de 4. Los métodos tradicionales de cuantificación (por ejemplo, la cuantificación post-entrenamiento PTQ) se suelen realizar después de que el modelo haya sido entrenado, lo que es fácil de implementar pero puede conducir a una degradación significativa del rendimiento. La técnica QAT utilizada por Google es diferente.

QAT introduce un paso de cuantificación durante el entrenamiento del modelo para simular operaciones de baja precisión. Este enfoque permite que el modelo se adapte al entorno de baja precisión mientras aún está en entrenamiento, lo que le permite mantener mejor la precisión durante la cuantificación posterior, permitiendo modelos más pequeños y rápidos. En concreto, Google aplicó aproximadamente 5.000 pasos de QAT al modelo Gemma 3, centrándose en la probabilidad de un punto de control no cuantificado. De este modo, se afirma que tras cuantificar a Q4_0 La perplejidad, una medida del poder predictivo del modelo, disminuye en 54% cuando el formato (utilizando la llama.cpp (Evaluación).

Efecto significativo: el uso de VRAM se reduce drásticamente.

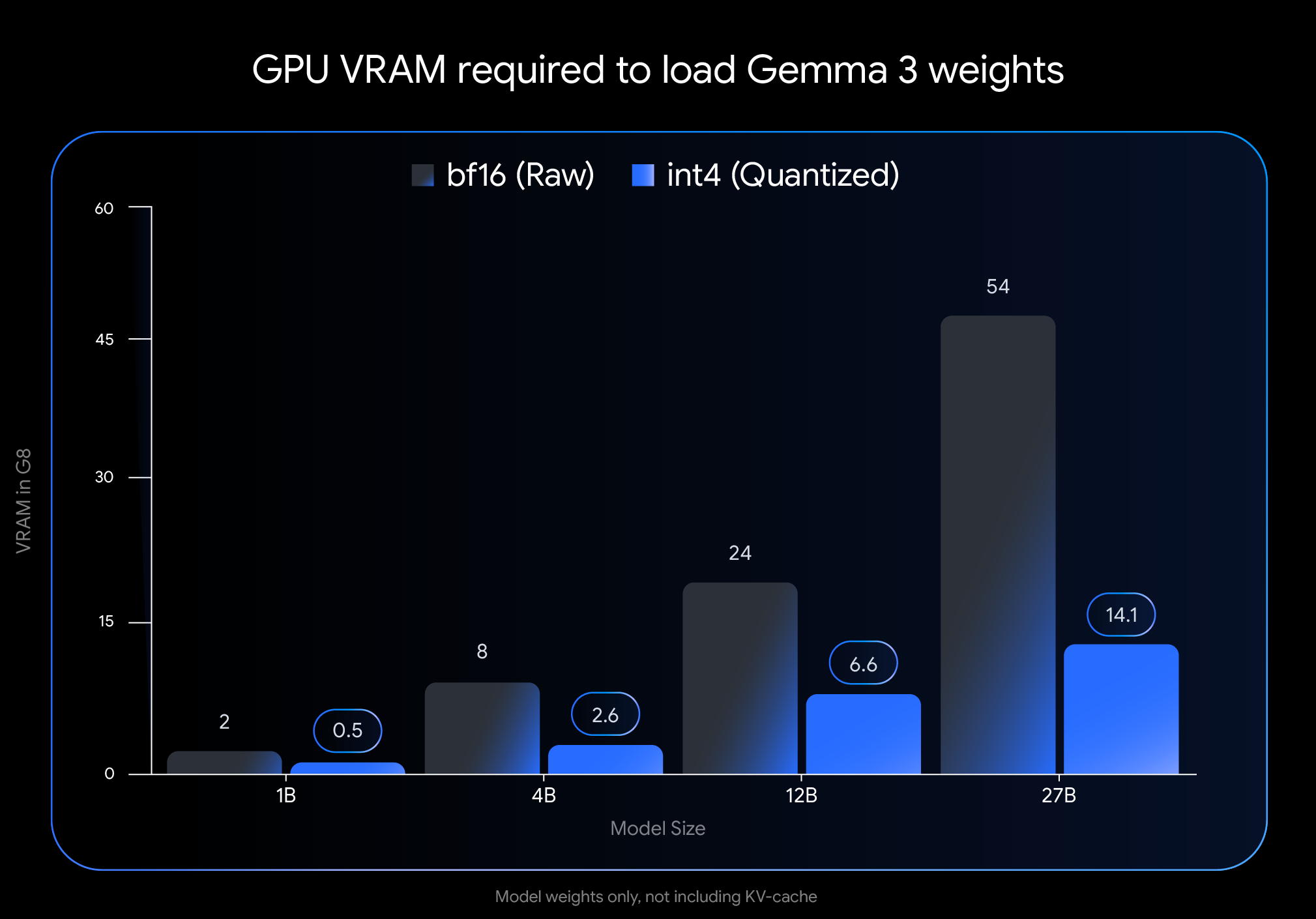

int4 El impacto de la cuantificación es significativo, especialmente en términos de la cantidad de memoria de vídeo (VRAM) necesaria para cargar los pesos del modelo:

- Gemma 3 27B. A partir de 54 GB (

BF16) a 14,1 GB (int4) - Gemma 3 12B. A partir de 24 GB (

BF16) Reducción a 6,6 GB (int4) - Gemma 3 4B. A partir de 8 GB (

BF16) Reducido a 2,6 GB (int4) - Gemma 3 1B. A partir de 2 GB (

BF16) a 0,5 GB (int4)

Precaución. Estos datos representan sólo la VRAM necesaria para cargar los pesos del modelo. La ejecución del modelo también requiere VRAM adicional para la caché KV, que almacena la información del contexto de diálogo, cuyo tamaño depende de la longitud del contexto.

Ejecuta Gemma 3 en tu dispositivo

La drástica reducción de los requisitos de memoria gráfica hace posible ejecutar modelos más grandes y potentes en hardware de consumo ampliamente disponible:

- Gemma 3 27B (

int4): Ahora es fácil de ejecutar en una sola clase de escritorio de 24 GB de VRAMNVIDIA RTX 3090o tarjetas gráficas similares, los usuarios pudieron ejecutar localmente la variante Gemma 3 más grande de Google. - Gemma 3 12B (

int4): La capacidad de funcionar en GPU de portátiles con 8 GB de VRAM (como elNVIDIA RTX 4060 Laptop GPULa empresa también aporta potentes capacidades de IA a los dispositivos portátiles. - Modelos más pequeños (4B, 1B). Proporciona una mayor accesibilidad a los sistemas con recursos más limitados, incluidos algunos dispositivos móviles.

Fácil integración con las principales herramientas

Para facilitar a los usuarios el uso de estos modelos en sus propios flujos de trabajo, Google ha puesto a disposición de los usuarios la herramienta Hugging Face responder cantando Kaggle El funcionario int4 responder cantando Q4_0 Modelos QAT no cuantificados. Al mismo tiempo, Google se ha asociado con varias herramientas de desarrollo populares para que los usuarios puedan probar sin problemas los puntos de control cuantificados basados en QAT:

- Ollama. Todos los modelos Gemma 3 QAT son compatibles de forma nativa y se ejecutan rápidamente con un simple comando.

- Estudio LM. Proporciona una interfaz fácil de usar para descargar y ejecutar fácilmente los modelos QAT de Gemma 3 en su escritorio.

- MLX. utilice

MLXEl marco está enApple SiliconInferencia eficiente y óptima de los modelos QAT de Gemma 3 en la - Gemma.cpp. Una implementación C++ específica de Google para una inferencia eficiente en la CPU.

- llama.cpp. Compatibilidad nativa con modelos QAT en formato GGUF para facilitar la integración en los flujos de trabajo existentes.

Más opciones cuantitativas en el Gemmaverse Ecology

Además del modelo QAT publicado oficialmente, los activos Gemmaverse La comunidad también ofrece muchas alternativas. Estos sistemas suelen utilizar técnicas de cuantificación posterior a la formación (PTQ), que son utilizadas por los Bartowski, Unsloth, GGML y otras contribuciones de los miembros de la comunidad, y en Hugging Face Disponible en. La exploración de estas opciones comunitarias ofrece a los usuarios una gama más amplia de opciones de compromiso entre el tamaño del modelo, la velocidad y la calidad para satisfacer necesidades específicas.

¡Empieza ya!

Llevar el rendimiento de la IA de vanguardia a un hardware de fácil acceso es un paso fundamental para democratizar el desarrollo de la IA. Con los modelos Gemma 3 optimizados a través de QAT, los usuarios pueden aprovechar las capacidades de IA de vanguardia en su propio ordenador de sobremesa o portátil. Esto no solo reduce la barrera para que desarrolladores e investigadores exploren modelos lingüísticos a gran escala, sino que también señala el potencial de aplicaciones de IA más potentes.

Explore modelos cuantitativos y empiece a construirlos:

- Uso en PC

OllamaCorriendo:https://ollama.com/library/gemma3 - existe

Hugging Faceresponder cantandoKaggleBusca el modelo en: - Funciona en dispositivos móviles (a través de

Google AI Edge):https://developers.googleblog.com/en/gemma-3-on-mobile-and-web-with-google-ai-edge/

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...