GLM Edge: Smart Spectrum lanza modelos de gran lenguaje y modelos de comprensión multimodal para plataformas móviles, de automóvil y PC

Últimos recursos sobre IAPublicado hace 1 año Círculo de intercambio de inteligencia artificial 53K 00

Introducción general

GLM-Edge es una serie de grandes modelos de lenguaje y modelos de comprensión multimodal diseñados para dispositivos finales de la Universidad de Tsinghua (Smart Spectrum Light Language). Estos modelos incluyen GLM-Edge-1.5B-Chat, GLM-Edge-4B-Chat, GLM-Edge-V-2B y GLM-Edge-V-5B para plataformas de teléfono móvil, automóvil y PC, respectivamente.Los modelos de la serie GLM-Edge se centran en la facilidad de despliegue práctico y la velocidad de inferencia manteniendo un alto rendimiento, y destacan en las plataformas Qualcomm Snapdragon e Intel en particular. Los modelos de la serie GLM-Edge se centran en la facilidad de implantación práctica y la velocidad de inferencia, manteniendo al mismo tiempo un rendimiento eficaz, especialmente en las plataformas Qualcomm Snapdragon e Intel. Los usuarios pueden descargar y utilizar estos modelos a través de Huggingface, ModelScope, etc., y realizar la inferencia del modelo mediante varios backends de inferencia (por ejemplo, transformadores, OpenVINO, vLLM).

GLM Modelo de texto de extremo de borde

Modelo visual GLM Edge

Lista de funciones

- Múltiples opciones de modelos: Proporciona modelos de diálogo y modelos de comprensión multimodal a diferentes escalas de parámetros para una amplia gama de dispositivos finales.

- Razonamiento eficienteLograr velocidades de inferencia eficientes en plataformas Qualcomm Snapdragon e Intel con soporte para esquemas de cuantificación híbridos.

- Soporte multiplataformaLos modelos están disponibles para su descarga en Huggingface, ModelScope y otras plataformas, y admiten una amplia gama de backends de inferencia.

- Fácil de desplegar: Proporciona una guía detallada de instalación y uso para que los usuarios puedan empezar a trabajar rápidamente.

- Ayuda al ajusteTutoriales y archivos de configuración para ayudar a los usuarios a ajustar sus modelos según sus necesidades específicas.

Utilizar la ayuda

Instalación de dependencias

Asegúrate de que tienes la versión 3.10 o superior de Python. E instala las dependencias como se indica a continuación:

pip install -r requirements.txt

razonamiento modelizado

Proporcionamos vLLM, OpenVINO y transformadores para la inferencia back-end, y puede ejecutar los modelos ejecutando los siguientes comandos:

python cli_demo.py --backend transformers --model_path THUDM/glm-edge-1.5b-chat --precision bfloat16

python cli_demo.py --backend vllm --model_path THUDM/glm-edge-1.5b-chat --precision bfloat16

python cli_demo.py --backend ov --model_path THUDM/glm-edge-1.5b-chat-ov --precision int4

Nota: El modelo de versión de OpenVINO necesita ser convertido, por favor vaya a la página correspondiente para ejecutar el código de conversión:

python convert_chat.py --model_path THUDM/glm-edge-1.5b-chat --precision int4

python convert.py --model_path THUDM/glm-edge-v-2b --precision int4

Ajuste del modelo

Proporcionamos código para el ajuste fino del modelo; consulte el tutorial de ajuste fino. A continuación se indican los pasos básicos para el ajuste fino:

- Prepare el conjunto de datos y configure los parámetros de entrenamiento.

- Ejecute el script de ajuste:

OMP_NUM_THREADS=1 torchrun --standalone --nnodes=1 --nproc_per_node=8 finetune.py data/AdvertiseGen/ THUDM/glm-edge-4b-chat configs/lora.yaml

- Si necesita seguir afinando desde el punto de guardado, puede añadir un cuarto parámetro:

python finetune.py data/AdvertiseGen/ THUDM/glm-edge-4b-chat configs/lora.yaml yes

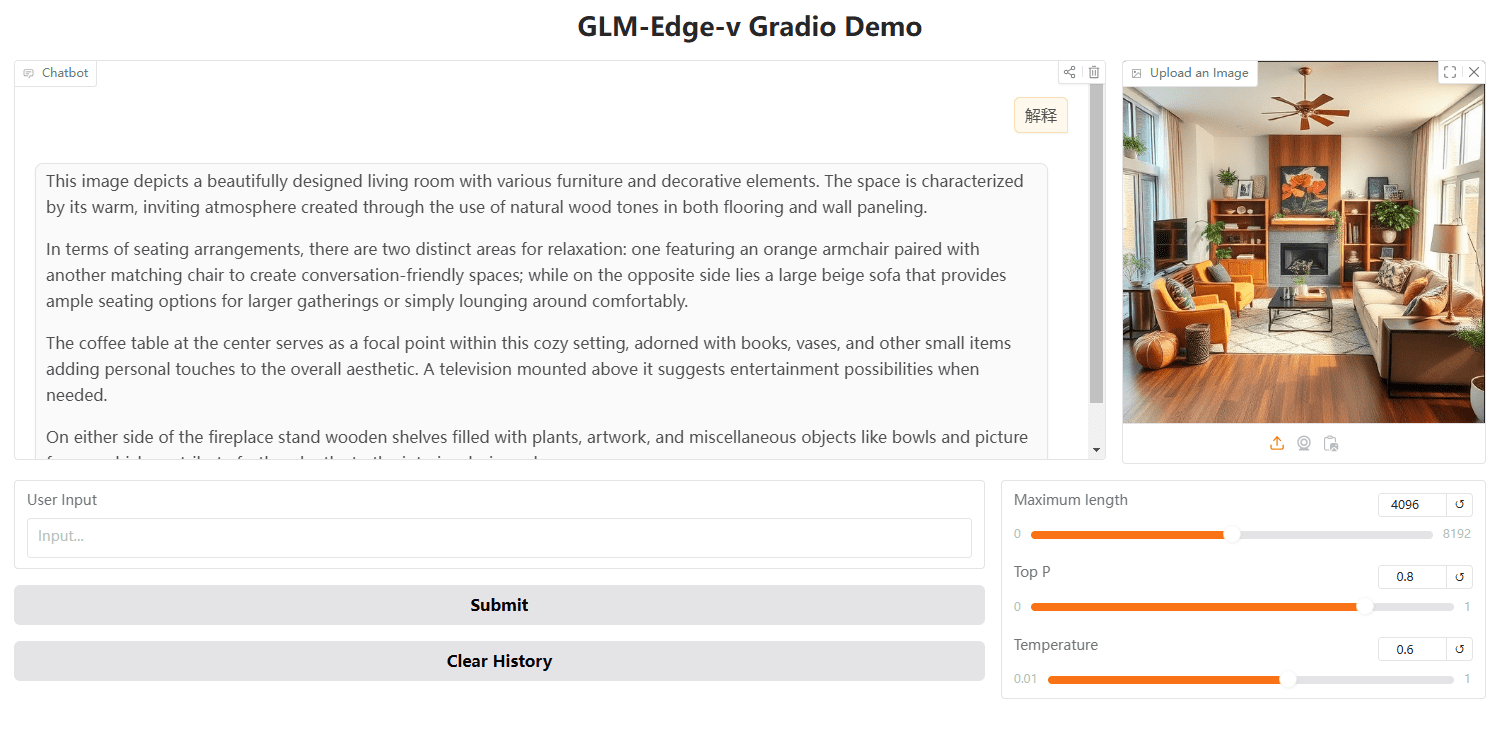

Iniciar la WebUI con Gradio

También puedes utilizar Gradio para lanzar la WebUI:

python cli_demo.py --backend transformers --model_path THUDM/glm-edge-1.5b-chat --precision bfloat16

Razonamiento con la API de OpenAI

import openai

client = openai.Client(api_key="your_api_key", base_url="http://<XINFERENCE_HOST>:<XINFERENCE_PORT>/v1")

output = client.chat.completions.create(

model="glm-edge-v",

messages=[

{"role": "user", "content": "describe this image"},

{"role": "image_url", "image_url": {"url": "img.png"}}

],

max_tokens=512,

temperature=0.7

)

print(output)© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...