FunClip: edición inteligente de contenidos de vídeo en cortometrajes, extracción/recorte preciso de clips de vídeo de forma sencilla

Últimos recursos sobre IAActualizado hace 1 año Círculo de intercambio de inteligencia artificial 98.6K 00

Introducción general

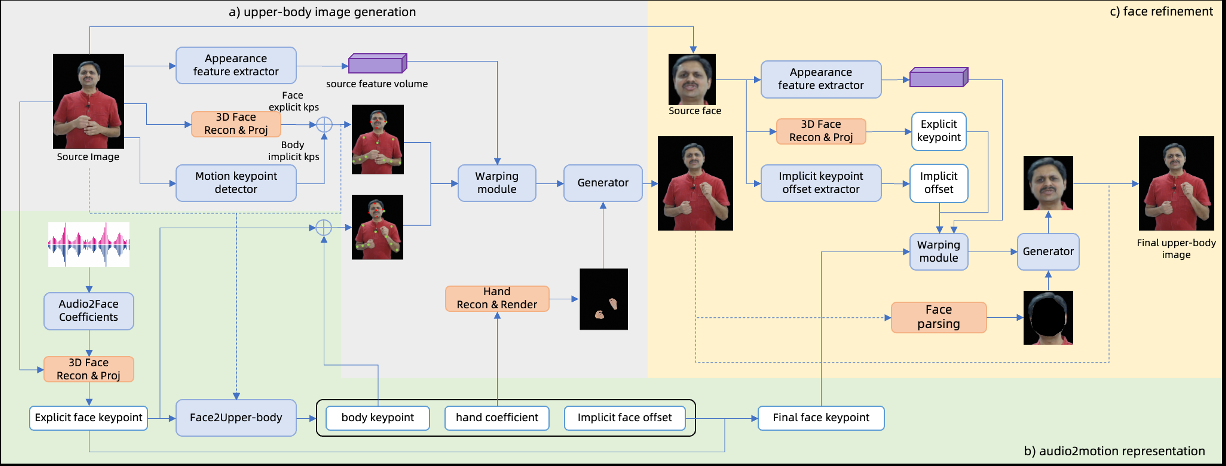

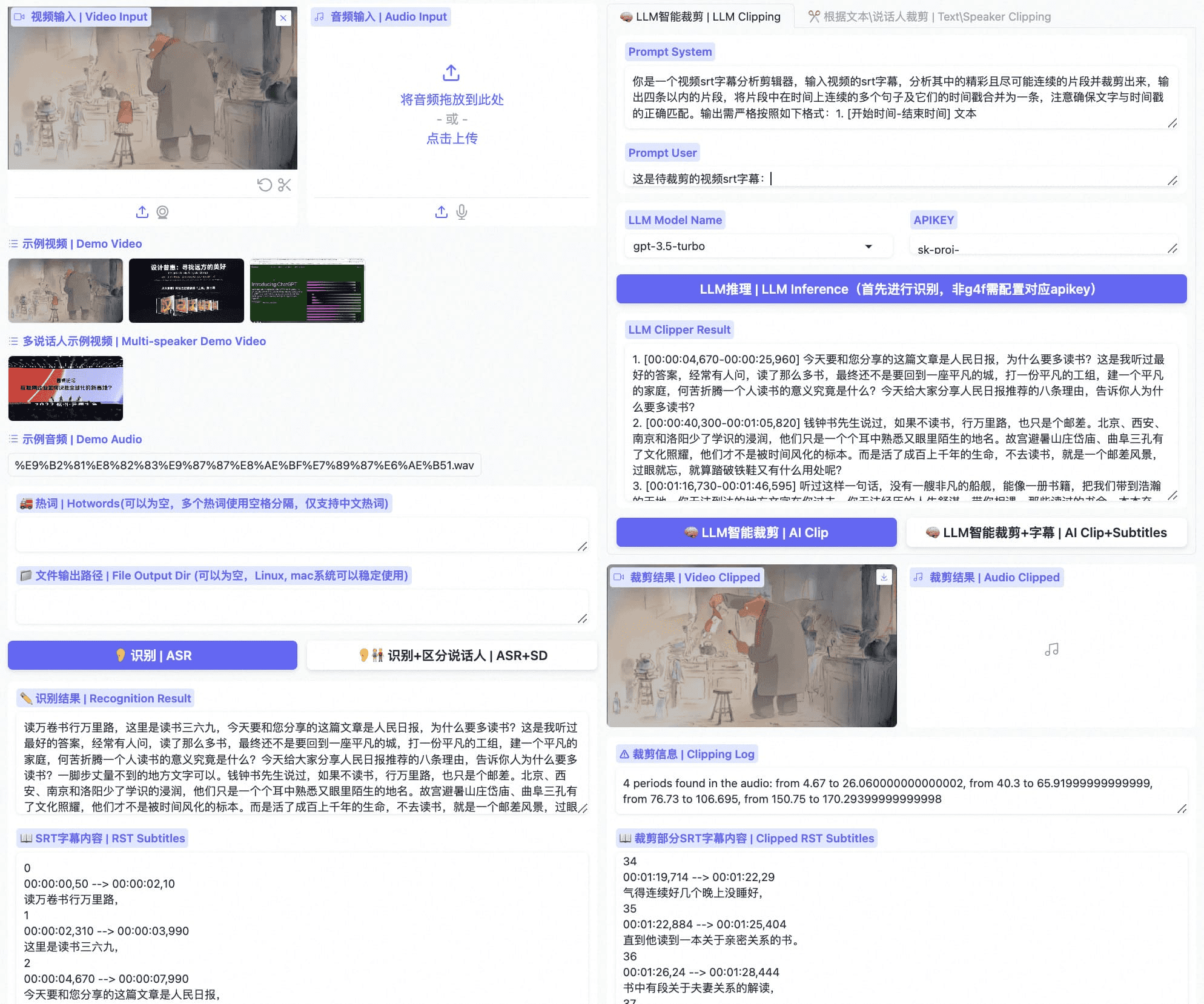

FunClip es una herramienta automatizada de edición de vídeo de código abierto desarrollada por el TONGYI Speech Lab del Alibaba Dharma Institute. La herramienta integra el modelo industrial de reconocimiento del habla Paraformer-Large, que puede identificar con precisión el contenido del habla en el vídeo y convertirlo en texto. La particularidad es que FunClip admite la edición inteligente a través de Large Language Modelling (LLM) e integra el reconocimiento de locutores para identificar automáticamente a los distintos hablantes. Los usuarios pueden seleccionar los clips de texto que les interesen y exportar los clips de vídeo correspondientes con un solo clic mediante una sencilla operación de interfaz. La herramienta admite la edición libre de varios segmentos y puede generar automáticamente archivos de subtítulos SRT completos y subtítulos para los segmentos de destino, proporcionando a los usuarios una experiencia de procesamiento de vídeo sencilla y cómoda. La última versión es compatible con el reconocimiento bilingüe y proporciona ricas funciones de incrustación y exportación de subtítulos, lo que la convierte en una herramienta de procesamiento de vídeo de código abierto potente y fácil de usar.

FunClip Optimizado - Privado-ASR

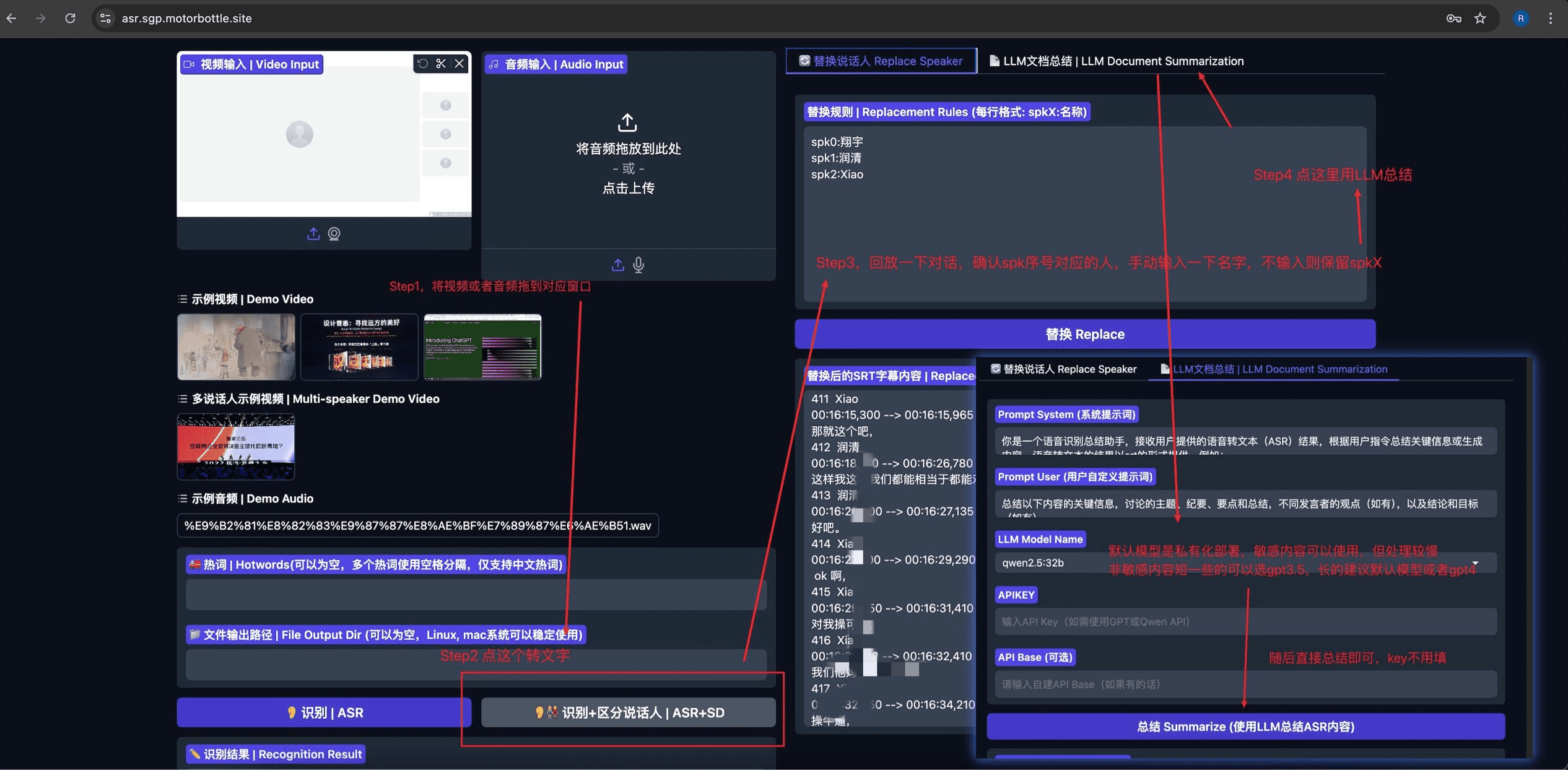

Privado-ASR Basado en proyectos de código abierto FunClip Modificado para integrar el reconocimiento automático del habla (ASR), la separación de locutores, la edición de subtítulos SRT y el resumen basado en LLM. El proyecto utiliza Gradio Ofrece una interfaz de usuario intuitiva y fácil de usar.

Lista de funciones

- Reconocimiento preciso del habla: integración del modelo de código abierto Paraformer-Large de Alibaba, compatible con el reconocimiento del habla en chino e inglés.

- LLM Intelligent Clip: admite el análisis inteligente de contenidos y la determinación automática de puntos de clip mediante un amplio modelo lingüístico.

- Reconocimiento de locutores: integración del modelo de reconocimiento de locutores CAM++, capaz de reconocer automáticamente la identidad de distintos locutores.

- Personalización de palabras en caliente: la función de personalización de palabras en caliente de SeACo-Paraformer es compatible para mejorar la precisión del reconocimiento de palabras específicas.

- Edición multisegmento: admite la selección libre de varios segmentos de texto para la edición por lotes.

- Generación de subtítulos: Genera automáticamente subtítulos SRT de vídeo completo y subtítulos de clip de destino.

- Soporte bilingüe: admite reconocimiento y edición de vídeo en chino e inglés

- Implantación local: código totalmente abierto, compatibilidad con la implantación local, protección de la privacidad y seguridad de los datos

- Interfaz fácil de usar: basada en el marco de desarrollo Gradio, proporciona una interfaz web sencilla e intuitiva.

Utilizar la ayuda

1. Instalación y despliegue

Instalación básica del entorno

- Clonar el repositorio de código:

git clone https://github.com/alibaba-damo-academy/FunClip.git

cd FunClip

- Instale las dependencias de Python:

pip install -r ./requirements.txt

Instalación opcional de funciones (para subtítulos incrustados)

Para utilizar la función de incrustación de subtítulos, es necesario instalar ffmpeg e imagemagick:

- Ubuntu:

apt-get -y update && apt-get -y install ffmpeg imagemagick

sed -i 's/none/read,write/g' /etc/ImageMagick-6/policy.xml

- MacOS:

brew install imagemagick

sed -i 's/none/read,write/g' /usr/local/Cellar/imagemagick/7.1.1-8_1/etc/ImageMagick-7/policy.xml

- Ventanas:

- Descargue e instale imagemagick desde el sitio web oficial: https://imagemagick.org/script/download.php#windows

- Busque la ruta de instalación de Python y cambie la directiva

site-packages\moviepy\config_defaults.pyha dado en el clavoIMAGEMAGICK_BINARYRuta de instalación de imagemagick - Descargue el archivo de fuentes:

wget https://isv-data.oss-cn-hangzhou.aliyuncs.com/ics/MaaS/ClipVideo/STHeitiMedium.ttc -O font/STHeitiMedium.ttc

2. Modalidades de utilización

A. Uso local del servicio Gradio

- Inicie el servicio:

python funclip/launch.py

# 使用 -l en 参数支持英文识别

# 使用 -p xxx 设置端口号

# 使用 -s True 开启公共访问

- entrevistas

localhost:7860Siga los pasos que se indican a continuación:

- Paso 1: Cargar archivos de vídeo

- Paso 2: Copie el clip de texto deseado en el área "Text to Clip".

- Paso 3: Ajuste la configuración de los subtítulos según sea necesario

- Paso 4: Haz clic en "Clip" o "Clip and Generate Subtitles" para editar.

B. LLM Clips inteligentes

- Una vez finalizado el reconocimiento, seleccione el modelo lingüístico grande y configure apikey

- Haz clic en el botón "Inferencia LLM" y el sistema combinará automáticamente los subtítulos de vídeo con las claves preestablecidas.

- Haga clic en el botón "AI Clip" para extraer automáticamente las marcas de tiempo para la edición basándose en la salida del modelo de lenguaje de gran tamaño.

- El resultado de un gran modelo lingüístico puede optimizarse modificando las palabras clave.

C. Uso de la línea de comandos

- Reconocimiento de voz:

python funclip/videoclipper.py --stage 1 \

--file examples/video.mp4 \

--output_dir ./output

- Videoclip:

python funclip/videoclipper.py --stage 2 \

--file examples/video.mp4 \

--output_dir ./output \

--dest_text '待剪辑文本' \

--start_ost 0 \

--end_ost 100 \

--output_file './output/res.mp4'

Además, los usuarios pueden experimentar FunClip a través de las siguientes plataformas en línea:

- Espacio ModelScope:Espacio FunClip@Modelscope

- Espacio HuggingFace:FunClip@Cara Abrazada Espacio

Si tienes problemas de uso, puedes obtener ayuda de la comunidad a través del grupo de pin o del grupo WeChat que proporciona el proyecto.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...