FunASR: kit de herramientas de reconocimiento del habla de código abierto, separación de hablantes/reconocimiento del habla en diálogos multipersona

Últimos recursos sobre IAPublicado hace 1 año Círculo de intercambio de inteligencia artificial 139.7K 00

Introducción general

FunASR es un conjunto de herramientas de reconocimiento del habla de código abierto desarrollado por el Instituto Dharma de Alibaba para tender un puente entre la investigación académica y las aplicaciones industriales. Es compatible con una amplia gama de funciones de reconocimiento del habla, como el reconocimiento del habla (ASR), la detección de extremos de voz (VAD), la recuperación de puntuación, el modelado del lenguaje, la verificación de hablantes, la separación de hablantes y el reconocimiento del habla en diálogos entre varias personas.

Admite una gran variedad de formatos de entrada de audio y vídeo, puede identificar decenas de horas de audio y vídeo de larga duración en texto con puntuación, admite cientos de solicitudes de transcripción simultánea Admite chino, inglés, japonés, cantonés y coreano.

Experiencia en línea: https://www.funasr.com/

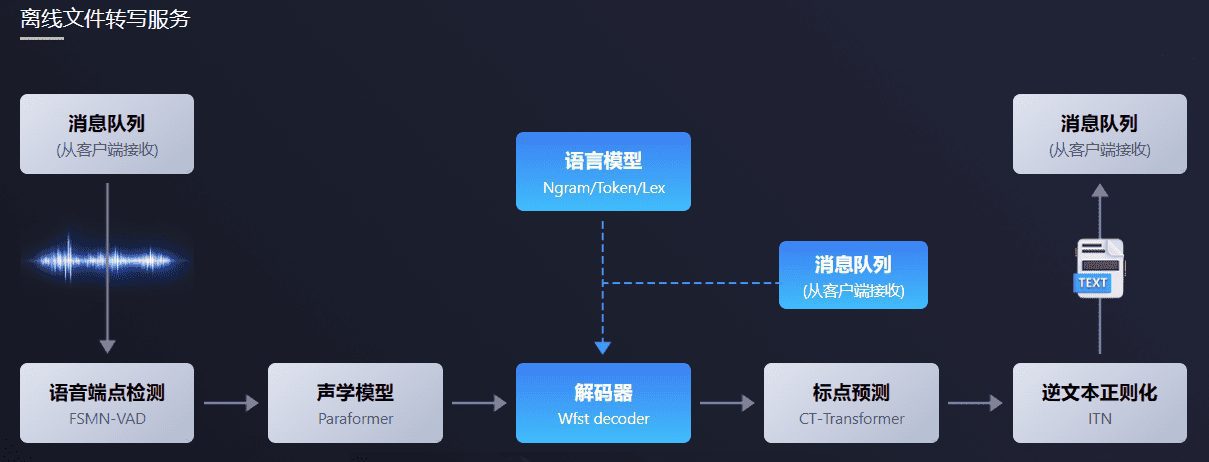

El paquete de software de transcripción de archivos sin conexión FunASR proporciona un potente servicio de transcripción de archivos sin conexión de voz. Con un completo enlace de reconocimiento del habla, que combina la detección de extremos del habla, el reconocimiento del habla, la puntuación y otros modelos, puede reconocer docenas de horas de audio y vídeo de larga duración como texto puntuado, y admite cientos de solicitudes de transcripción simultánea. El resultado es un texto puntuado con marcas de tiempo a nivel de palabra y compatible con ITN y palabras clave definidas por el usuario. Integración en el servidor con ffmpeg y compatibilidad con diversos formatos de entrada de audio y vídeo. El paquete proporciona html, python, c++, java y c# y otros lenguajes de programación cliente , el usuario puede utilizar directamente y un mayor desarrollo.

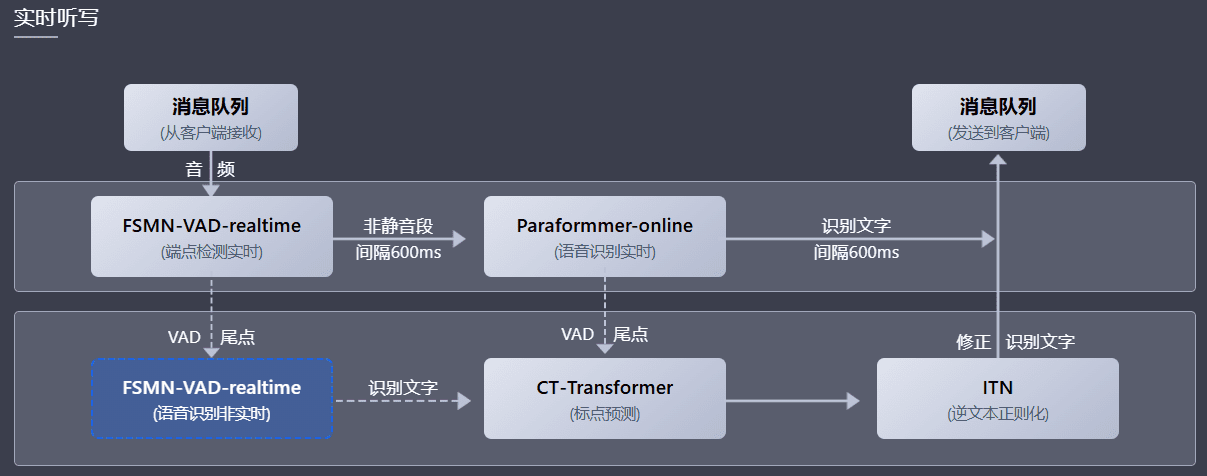

El paquete de software de dictado de voz en tiempo real FunASR integra versiones en tiempo real de modelos de detección de extremos de voz, reconocimiento de voz, reconocimiento de voz, modelos de predicción de puntuación, etc. Gracias a la sinergia multimodelo, no sólo puede realizar el dictado de voz a texto en tiempo real, sino también corregir el texto de salida con transcripción de alta precisión al final de la frase, el texto de salida con puntuación y la compatibilidad con solicitudes múltiples. Según los distintos escenarios de usuario, admite tres modos de servicio: servicio de dictado de voz en tiempo real (online), transcripción de frases en tiempo no real (offline) y colaboración integrada en tiempo real y no real (2pass). El paquete de software ofrece diversos lenguajes de programación, como html, python, c++, java y el cliente c#, que los usuarios pueden utilizar directamente y seguir desarrollando.

Lista de funciones

- Reconocimiento de voz (ASR): admite el reconocimiento de voz sin conexión y en tiempo real.

- Detección del punto final de la voz (VAD): detecta el principio y el final de la señal de voz.

- Recuperación de puntuación: añade puntuación automáticamente para mejorar la legibilidad del texto.

- Modelos lingüísticos: admite la integración de varios modelos lingüísticos.

- Verificación del orador: verifica la identidad del orador.

- Separación de hablantes: distinguir el habla de distintos hablantes.

- Reconocimiento de voz para varias conversaciones: admite el reconocimiento de voz para varias conversaciones simultáneas.

- Inferencia y ajuste de modelos: ofrece funciones de inferencia y ajuste de modelos preentrenados.

Utilizar la ayuda

Proceso de instalación

- Preparación medioambiental::

- Asegúrese de que Python 3.7 o superior está instalado.

- Instale las bibliotecas de dependencias necesarias:

pip install -r requirements.txt

- Descargar modelos::

- Descargue modelos preentrenados de ModelScope o HuggingFace:

git clone https://github.com/modelscope/FunASR.git cd FunASR

- Descargue modelos preentrenados de ModelScope o HuggingFace:

- Entorno de configuración::

- Configurar variables de entorno:

export MODEL_DIR=/path/to/your/model

- Configurar variables de entorno:

Proceso de utilización

- reconocimiento de voz::

- Utiliza la línea de comandos para el reconocimiento de voz:

python recognize.py --model paraformer --input your_audio.wav - Reconocimiento de voz mediante código Python:

from funasr import AutoModel model = AutoModel.from_pretrained("paraformer") result = model.recognize("your_audio.wav") print(result)

- Utiliza la línea de comandos para el reconocimiento de voz:

- detección de terminales de voz::

- Utilice la línea de comandos para la detección de terminales de voz:

python vad.py --model fsmn-vad --input your_audio.wav - Detección de terminales de voz mediante código Python:

from funasr import AutoModel vad_model = AutoModel.from_pretrained("fsmn-vad") vad_result = vad_model.detect("your_audio.wav") print(vad_result)

- Utilice la línea de comandos para la detección de terminales de voz:

- Recuperación de la puntuación::

- Utilice la línea de comandos para recuperar la puntuación:

python punctuate.py --model ct-punc --input your_text.txt - Recuperación de la puntuación mediante código Python:

from funasr import AutoModel punc_model = AutoModel.from_pretrained("ct-punc") punc_result = punc_model.punctuate("your_text.txt") print(punc_result)

- Utilice la línea de comandos para recuperar la puntuación:

- Verificación del orador::

- Utilice la línea de comandos para verificar el altavoz:

python verify.py --model speaker-verification --input your_audio.wav - Verificación de altavoces mediante código Python:

from funasr import AutoModel verify_model = AutoModel.from_pretrained("speaker-verification") verify_result = verify_model.verify("your_audio.wav") print(verify_result)

- Utilice la línea de comandos para verificar el altavoz:

- Reconocimiento de voz multihabla::

- Reconocimiento de voz para diálogos multijugador mediante la línea de comandos:

python multi_asr.py --model multi-talker-asr --input your_audio.wav - Reconocimiento de voz para conversaciones entre varias personas mediante código Python:

from funasr import AutoModel multi_asr_model = AutoModel.from_pretrained("multi-talker-asr") multi_asr_result = multi_asr_model.recognize("your_audio.wav") print(multi_asr_result)

- Reconocimiento de voz para diálogos multijugador mediante la línea de comandos:

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...