El analista Alberto Romero especula: en realidad la GPT-5 de OpenAI llega con mucho retraso

¡Empecemos el nuevo año de forma emocionante!

- Puede ser generado por GPT-5

¿Y si te dijera que la GPT-5 es real? No sólo es real, sino que ya está dando forma al mundo de maneras que no puedes ver. He aquí una hipótesis: OpenAI ha desarrollado la GPT-5, pero la mantiene internamente porque el retorno de la inversión es mucho mayor que abrirla a millones de personas. ChatGPT usuarios. Y lo que es más, el ROI que obtienen de la Dinero no. Más bien, es otra cosa. Como puedes ver, la idea es bastante simple; el reto es encadenar las pistas que apuntan a ella. Este artículo profundiza en por qué creo que esas pistas acaban conectándose.

Descargo de responsabilidad por adelantado: esto es pura especulación. Todas las pruebas son de dominio público, pero no hay filtraciones ni rumores internos que confirmen que estoy en lo cierto. De hecho, estoy construyendo esta teoría a través de este artículo, no sólo compartiéndola. No dispongo de información privilegiada y, aunque la tuviera, estoy sujeto a un acuerdo de confidencialidad. Esta hipótesis es convincente porque lógico . Sinceramente, ¿qué más necesito para poner en marcha esta máquina de rumores?

Creerlo o no depende de usted. Aunque me equivoque -y al final sabremos la respuesta-, creo que es un divertido juego de detectives. Le invito a especular en la sección de comentarios, pero por favor, hágalo de forma constructiva y reflexiva. Por favor, asegúrese de leer primero todo el artículo. Por lo demás, todo debate es bienvenido.

I. La misteriosa desaparición de Opus 3.5

Antes de explorar GPT-5, tenemos que mencionar a su primo lejano igualmente desaparecido: Anthropic's Claude Opus 3.5.

Como sabes, los tres principales laboratorios de IA -OpenAI, Google DeepMind y Anthropic- ofrecen carteras de modelos que cubren el espectro precio/latencia versus rendimiento. openAI tiene GPT-4o, GPT-4o mini, así como o1 y o1-mini; Google DeepMind ofrece Géminis Ultra, Pro y Flash; Anthropic tiene Claude Opus, Sonnet y Haiku, y el objetivo es claro: cubrir el mayor número posible de perfiles de clientes. Algunos buscan el máximo rendimiento sin importar el coste, mientras que otros necesitan soluciones asequibles y adecuadas. Todo tiene sentido.

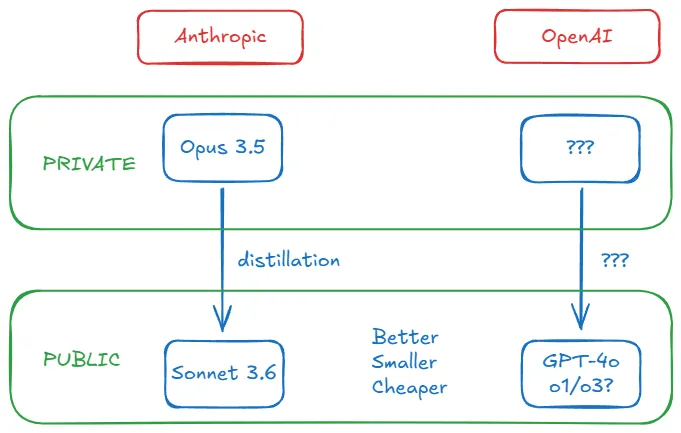

Pero en octubre de 2024 ocurrió algo extraño. Mientras todo el mundo esperaba Antrópico Cuando lanzaron Claude Opus 3.5 como respuesta a GPT-4o (que salió en mayo de 2024), el 22 de octubre sacaron una versión actualizada de Claude Sonnet 3.5 (que pasó a llamarse Sonnet 3.6), que desapareció, dejando a Anthropic sin un producto en competencia directa con GPT-4o. GPT-4o. Extraño, ¿verdad? He aquí un rápido vistazo a la cronología de Opus 3.5:

- El 28 de octubre, escribí en mi artículo de revisión semanal: "[Hay] rumores de que Sonnet 3.6 es... . un punto de control intermedio generado durante el esperado fallo de entrenamiento de Opus 3.5". El mismo día, apareció un post en el subforo r/ClaudeAI, "Claude 3.5 Opus ha sido obsoleto", con un enlace a la página de modelos antrópicos - todavía no hay rastro de Opus 3.5. Se especula con que esta medida se ha tomado para mantener la confianza de los inversores antes de una nueva ronda de financiación.

- El 11 de noviembre, el director general de Anthropic, Dario Amodei, dejó caer en el podcast de Lex Fridman que Opus 3.5: "Aunque no podemos dar una fecha exacta, seguimos planeando lanzar Claude 3.5 Opus" La redacción es cautelosamente ambigua, pero eficaz.

- El 13 de noviembre, Bloomberg confirmó los primeros rumores de que "Una vez finalizado el entrenamiento, Anthropic descubrió que Opus 3.5 superaba a la versión anterior en las evaluaciones, pero el impulso no estuvo a la altura de las expectativas dado el tamaño del modelo y el coste de construcción de la ejecución". Darío no dio una fecha, aparentemente porque los resultados no fueron satisfactorios a pesar de que el entrenamiento de Opus 3.5 no falló. Nótese que se centra en Relación coste-rendimiento No sólo rendimiento.

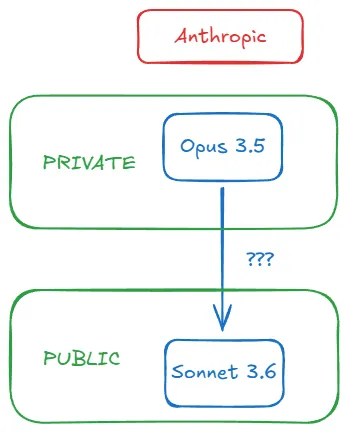

- El 11 de diciembre, el experto en semiconductores Dylan Patel y su equipo de Semianalysis dieron la última vuelta de tuerca, ofreciendo la siguiente explicación: "Anthropic completa la formación de Claude 3.5 Opus y obtiene buenos resultados... ... pero no lo lanzaron. Porque cambiaron a Generación de datos de síntesis con Claude 3.5 Opus que mejora significativamente el Sonnet Claude 3.5 mediante modelado de bonificación".

En resumen, Anthropic sí entrenó a Claude Opus 3.5, y le quitaron el nombre porque los resultados no fueron suficientemente buenos. dario cree que los resultados podrían haberse mejorado con un proceso de entrenamiento diferente, y evita la cita. Bloomberg confirma que supera a los modelos existentes, pero que el coste de inferencia (el coste para el usuario de utilizar el modelo) es inasequible, y el equipo de Dylan revela la conexión entre Sonnet 3.6 y el desaparecido Opus 3.5: este último se utilizó para generar internamente datos sintéticos para mejorar el rendimiento del primero.

Todo el proceso puede esquematizarse del siguiente modo:

II. ¿Mejor, más pequeño y más barato?

El proceso de utilizar un modelo sólido y caro para generar datos que aumenten un modelo ligeramente más débil pero más económico se denomina destilación. Se trata de una práctica habitual. La técnica permite a los laboratorios de IA superar las limitaciones del preentrenamiento por sí solo y aumentar el rendimiento de modelos más pequeños.

Existen diferentes métodos de destilación, pero no entraremos en ello. Lo fundamental es recordar que un modelo sólido como "maestro" puede hacer que el modelo "alumno" pase de [pequeño, barato, rápido] + (después de un decimal o una fracción) ligeramente inferior a Transformado en [pequeño, barato, rápido] + formidable . La destilación convierte los modelos fuertes en minas de oro.Dylan explica por qué esto tiene sentido para la combinación Opus 3.5-Sonnet 3.6 de Anthropic:

(El coste de inferencia (del nuevo Sonnet sobre el antiguo) no ha cambiado significativamente, pero el rendimiento del modelo ha mejorado. Por qué molestarse en lanzar 3.5 Opus desde una perspectiva de costes cuando se puede obtener 3.5 Sonnet mediante post-entrenamiento con 3.5 Opus?

Volviendo a la cuestión de los costes: la destilación controla los gastos de inferencia al tiempo que mejora el rendimiento. Esto aborda directamente el problema central señalado por Bloomberg, y Anthropic decidió no lanzar Opus 3.5 no sólo por sus mediocres resultados, sino también por su mayor valor interno. (Dylan señala que este es el motivo por el que la comunidad de código abierto está alcanzando rápidamente a GPT-4: están sacando oro directamente de la mina de oro de OpenAI).

La revelación más sorprendente... El Soneto 3.6 no sólo es excelente, sino que alcanza el nivel superior . Más allá de GPT-4o. El modelo de gama media de Anthropic supera al buque insignia de OpenAI destilando a través de Opus 3.5 (y probablemente por otras razones; cinco meses es tiempo suficiente en IA). De repente, la percepción del alto coste como sinónimo de alto rendimiento empezó a desmoronarse.

¿Qué ha pasado con la era de "cuanto más grande, mejor", que Sam Altman, CEO de OpenAI, advierte que se ha acabado? Ya escribí sobre ello. Cuando los principales laboratorios se volvieron herméticos, dejaron de compartir los números de los parámetros. Los tamaños de los parámetros dejaron de ser fiables y, con buen criterio, pasamos a centrarnos en el rendimiento de las pruebas de referencia. el último tamaño de los parámetros de OpenAI disponible públicamente fue de 175.000 millones para GPT-3 en 2020. los rumores de junio de 2023 sugerían que GPT-4 era un modelo experto híbrido con aproximadamente 1,8 billones de parámetros. una evaluación detallada posterior realizada por Semianalysis confirmó que GPT-4 tenía 1,76 billones de parámetros, en julio de 2023. una evaluación detallada posterior de Semianalysis confirmó que GPT-4 tenía 1,76 billones de parámetros, en julio de 2023.

Hasta diciembre de 2024 -dentro de un año y medio- Ege Erdil, investigador de EpochAI, una organización centrada en el impacto futuro de la IA, estima que los tamaños de los parámetros de los modelos de frontera, incluidos GPT-4o y Sonnet 3.6, son significativamente menores que los de GPT-4 (aunque ambos modelos superan a GPT-4):

... Los modelos fronterizos actuales, como la primera generación de GPT-4o y Claude 3.5 Sonnet, pueden ser un orden de magnitud más pequeños que GPT-4, con 4o en torno a 200.000 millones de parámetros y 3.5 Sonnet en torno a 400.000 millones ... Aunque la rugosidad de la estimación puede dar lugar a errores de hasta un factor de dos.

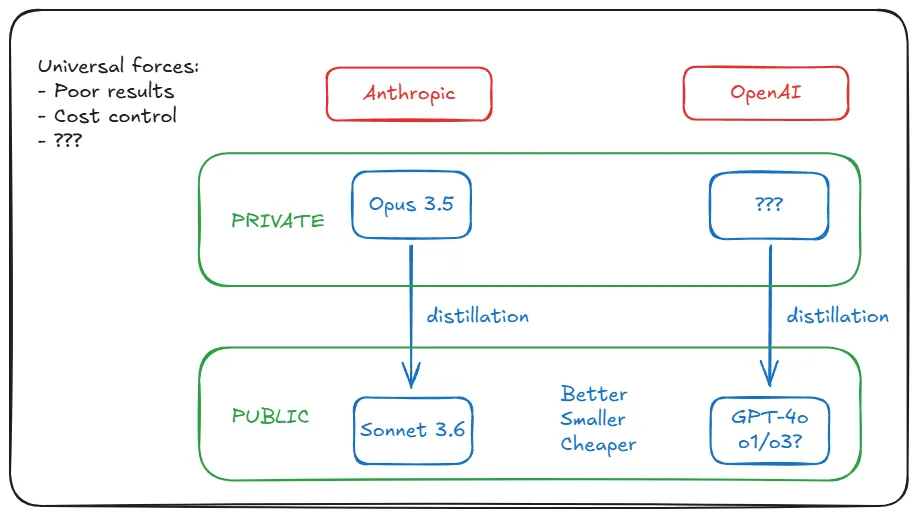

Explica en profundidad cómo ha llegado a esa cifra sin que el laboratorio revele detalles arquitectónicos, pero eso no nos importa. La cuestión es que la niebla se está despejando: Anthropic y OpenAI parecen seguir trayectorias similares. Sus últimos modelos no sólo son mejores, sino también más pequeños y baratos que sus predecesores. Sabemos que Anthropic lo consigue destilando Opus 3.5. Pero, ¿qué ha hecho OpenAI?

III. Los laboratorios de IA se mueven por el universalismo

Se podría pensar que la estrategia de destilación de Anthropic se debe a una situación única, a saber, los malos resultados de entrenamiento de Opus 3.5. Pero la realidad es que la situación de Anthropic no es única. Pero la realidad es que la situación de Anthropic no es única, y los últimos resultados de entrenamiento de Google DeepMind y OpenAI son igualmente insatisfactorios. (Nótese que resultados pobres no es lo mismo que El modelo es peor. ) Las razones no nos importan: rendimientos decrecientes debidos a la insuficiencia de datos, limitaciones inherentes a la arquitectura Transformer, estancamiento de la ley de escalado previa al entrenamiento, etc. En cualquier caso, el contexto particular de Anthropic es en realidad universal.

Pero recuerde lo que informa Bloomberg: las métricas de rendimiento son tan buenas como el coste. ¿Se trata de otro factor compartido? Sí, y Ege explica por qué: el aumento de la demanda tras el boom de ChatGPT/GPT-4. La IA generativa se está extendiendo a un ritmo que dificulta a los laboratorios sostener las pérdidas de una expansión continuada. Esto les obligó a reducir los costes de inferencia (el entrenamiento es una sola vez, los costes de inferencia crecen con el volumen de usuarios y el uso). Si 300 millones de usuarios utilizan el producto cada semana, los gastos operativos podrían ser de repente fatales.

Los factores que llevaron a Anthropic a mejorar Sonnet 3.6 con la destilación están afectando a OpenAI con una intensidad exponencial. La destilación es eficaz porque convierte estos dos retos omnipresentes en fortalezas: resolver el problema del coste de inferencia proporcionando modelos pequeños, al tiempo que no se liberan modelos grandes para evitar la reacción del público contra un rendimiento mediocre.

Ege cree que OpenAI podría optar por la alternativa: el sobreentrenamiento. Es decir, entrenar más datos con modelos más pequeños en un estado no óptimo desde el punto de vista informático: "Cuando la inferencia es una parte importante del gasto del modelo, es mejor... entrenar más tokens con modelos más pequeños". Pero el sobreentrenamiento ya no es factible. Pero el sobreentrenamiento ya no es factible; AI Labs se ha quedado sin datos de preentrenamiento de alta calidad, como han reconocido recientemente Elon Musk e Ilya Sutskever.

Volviendo a la destilación, Ege concluye: "Creo que es probable que tanto el GPT-4o como el Claude 3.5 Sonnet hayan sido destilados de modelos más grandes".

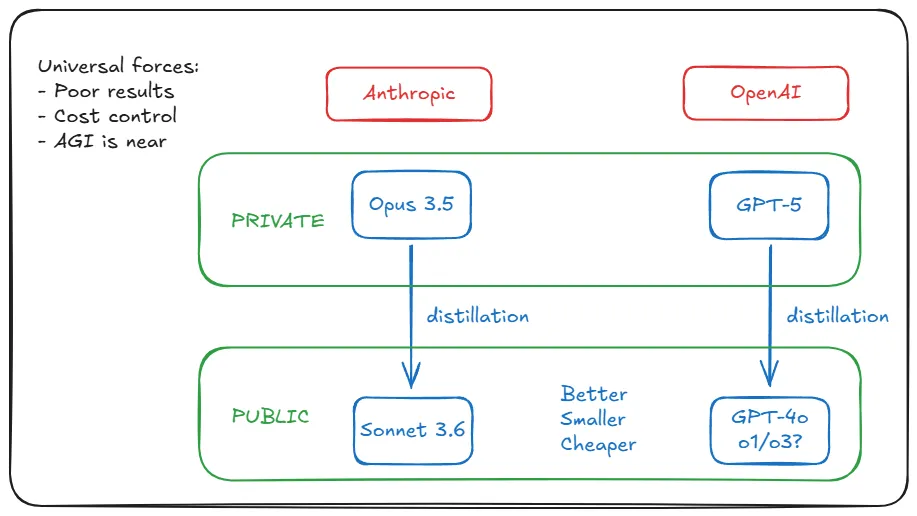

Todas las pistas hasta este punto indican que OpenAI está haciendo lo que hizo Anthropic con Opus 3.5 (entrenar y esconder) de la misma manera (destilación) y por las mismas razones (pobres resultados/control de costes). Esto es un descubrimiento. Pero he aquí la cuestión: Opus 3.5 pero ¿Dónde se esconden los homólogos de OpenAI? ¿Está escondida en el sótano de la empresa? ¿Te atreves a adivinar su nombre?

IV. Los pioneros deben despejar el camino

Abro el análisis examinando el evento Opus 3.5 de Anthropic, que es más transparente en su información. A continuación, establezco un puente entre el concepto de destilación y OpenAI, explicando que las mismas fuerzas subyacentes que impulsan a Anthropic también actúan sobre OpenAI, pero nuestra teoría se topa con un nuevo obstáculo: como pionera, OpenAI puede enfrentarse a obstáculos que Anthropic aún no ha encontrado.

Por ejemplo, los requisitos de hardware para entrenar GPT-5. Sonnet 3.6 es comparable a GPT-4o, pero se lanzó cinco meses después. Debemos suponer que GPT-5 está a un nivel superior: es más potente y más grande. No sólo el coste de razonamiento, sino también el de formación es mayor. Los costes de formación podrían ascender a 500 millones de dólares. ¿Es posible lograrlo con el hardware existente?

Ege vuelve a desvelarse: es posible. No es realista ofrecer semejante armatoste a 300 millones de usuarios, pero la formación no es un problema:

En principio, el hardware existente es suficiente para soportar modelos mucho mayores que GPT-4: por ejemplo, un modelo de 100 billones de parámetros que sea 50 veces mayor que GPT-4, con un coste de inferencia de unos 3.000 dólares/millón de tokens de salida, y una tasa de salida de 10-20 tokens/segundo. Pero para que esto sea factible, los grandes modelos deben crear un valor económico significativo para los clientes.

Pero ni siquiera Microsoft, Google o Amazon (los propietarios de OpenAI, DeepMind y Anthropic, respectivamente) pueden permitirse este tipo de inferencia. La solución es sencilla: si planean poner billones de modelos paramétricos a disposición del público, tendrían que "crear un valor económico significativo". Así que no lo hacen.

Entrenaron el modelo. Han encontrado "mejores prestaciones que los productos existentes". Pero tienen que aceptar que "no ha mejorado lo suficiente como para justificar el enorme coste de mantenerlo en funcionamiento". (¿Le suena familiar? El Wall Street Journal informó hace un mes sobre la GPT-5 en términos sorprendentemente similares a los del informe de Bloomberg sobre Opus 3.5.)

Informan de resultados mediocres (con flexibilidad para ajustar la narrativa). Reténgalos internamente como modelos de profesores para destilar modelos de alumnos. Luego libere a estos últimos. Obtenemos Sonnet 3.6 y GPT-4o, o1, etc. y nos alegramos de su calidad barata. Las expectativas para Opus 3.5 y GPT-5 siguen intactas, aunque nos impacientemos cada vez más. Su mina de oro sigue brillando.

V. ¡Seguro que tiene más razones, Sr. Altman!

V. ¡Claro que tiene más razones, Sr. Altman!

Cuando llegué tan lejos en mi investigación, todavía no estaba plenamente convencido. Es cierto que todas las pruebas sugieren que es totalmente plausible para OpenAI, pero todavía hay una brecha entre "plausible" o incluso "plausible" y "real". No voy a llenar ese vacío por ti, al fin y al cabo es sólo especulación. Pero puedo reforzar aún más el argumento.

¿Existen más pruebas de que OpenAI esté operando de esta manera? ¿Existen más razones para que retrasen la publicación de GPT-5 aparte del bajo rendimiento y las crecientes pérdidas, y qué información podemos extraer de las declaraciones públicas de los ejecutivos de OpenAI sobre GPT-5? ¿No se arriesgan a dañar su reputación retrasando repetidamente el lanzamiento del modelo? Después de todo, OpenAI es la cara de la revolución de la IA, y Anthropic opera a su sombra.Anthropic puede permitirse operar de esta manera, pero ¿qué pasa con OpenAI? Quizás no sin un precio.

Hablando de dinero, indaguemos en algunos detalles relevantes sobre la asociación de OpenAI con Microsoft. Primero, el hecho bien conocido: los artículos de AGI. En la entrada del blog de OpenAI sobre su estructura, tienen cinco cláusulas de gobierno que definen cómo funcionan, su relación con las organizaciones sin ánimo de lucro, su relación con su junta directiva y su relación con Microsoft. La quinta cláusula define la AGI como "un sistema altamente autónomo capaz de superar a los humanos en la mayoría de los esfuerzos económicamente valiosos" y establece que una vez que el Consejo de Administración de OpenAI declare que la AGI ha sido implementada, "el sistema quedará excluido de la licencia de propiedad intelectual y otros términos comerciales con Microsoft, que están sujetos únicamente a los términos de la licencia de Microsoft y otros términos comerciales". otros términos comerciales con Microsoft, que sólo se aplican a la tecnología anterior a AGI".

Ni que decir tiene que ninguna de las dos empresas quiere que la asociación se rompa. openAI establece las condiciones, pero hace todo lo posible por evitar tener que cumplirlas. Una forma de hacerlo es retrasar el lanzamiento de sistemas que podrían etiquetarse como AGI. "Pero GPT-5 no es AGI", dirás. Y he aquí un segundo hecho que casi nadie conoce: OpenAI y Microsoft tienen una definición secreta de AGI que, aunque irrelevante a efectos científicos, define legalmente su asociación: AGI es un "sistema de IA capaz de generar al menos 100.000 millones de dólares en beneficios". AGI es un sistema de IA "capaz de generar al menos 100.000 millones de dólares de beneficios".

Si OpenAI retrasara hipotéticamente el lanzamiento con el pretexto de que la GPT-5 no estaba lista, conseguiría otra cosa además de controlar los costes y evitar una reacción pública: evitaría anunciar si cumple o no el umbral para ser clasificada como AGI. Aunque 100.000 millones de dólares es una cifra asombrosa, nada impide que los clientes ambiciosos obtengan además esa cantidad de beneficios. Por otro lado, seamos claros: si OpenAI predice que GPT-5 generará 100.000 millones de dólares en ingresos recurrentes al año, no les importará activar la cláusula AGI y separarse de Microsoft.

La mayor parte de la reacción pública ante el hecho de que OpenAI no publicara la GPT-5 se basó en la suposición de que no la publicaban porque no era lo suficientemente buena. Aunque esto fuera cierto, ningún escéptico se para a pensar que OpenAI podría tener un mejor caso de uso interno que externo. Hay una gran diferencia entre crear un gran modelo y crear un gran modelo que pueda servir a 300 millones de personas de forma barata. Si no puedes hacerlo, no lo harás. Pero, de nuevo, si innecesario Hazlo y no lo harás. Antes nos proporcionaban sus mejores modelos porque necesitaban nuestros datos. Ya no es tan necesario. Y ya no persiguen nuestro dinero. Ese es el negocio de Microsoft, no el suyo. Quieren AGI, luego ASI. Quieren dejar un legado.

VI. Por qué esto lo cambia todo

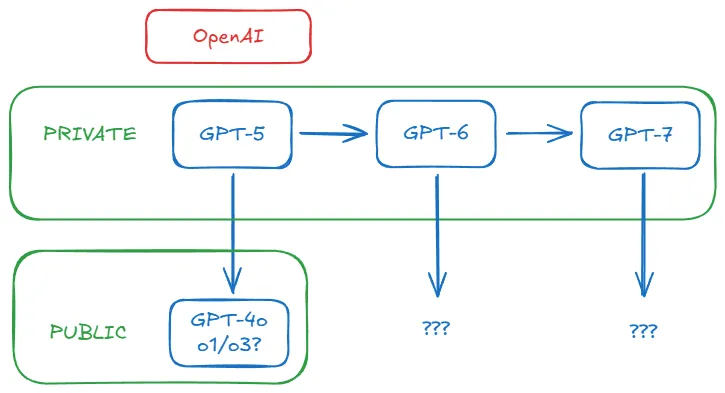

Nos acercamos al final. Creo que he expuesto suficientes argumentos para construir una tesis sólida: es muy probable que OpenAI ya disponga de GPT-5 internamente, al igual que Anthropic tiene Opus 3.5. Es incluso posible que OpenAI nunca lance una GPT-5. El público mide ahora el rendimiento en términos de o1/o3, no sólo de GPT-4o o Claude Sonnet 3.6. Con OpenAI explorando la ley del escalado en las pruebas, el listón que hay que superar para la GPT-5 sigue subiendo. ¿Cómo es posible que lancen una GPT-5 que realmente supere a las o1, o3 y a los próximos modelos de la serie o, especialmente si las están lanzando a un ritmo tan rápido? Además, ya no necesitan nuestro dinero ni nuestros datos.

La formación de nuevos modelos base - GPT-5, GPT-6 y posteriores - siempre tuvo sentido internamente para OpenAI, pero no necesariamente como producto. Probablemente eso se haya acabado. El único objetivo importante para ellos ahora es seguir generando mejores datos para la próxima generación de modelos. A partir de ahora, el modelo base funcionará en segundo plano, ayudando a otros modelos a lograr hazañas que no podrían conseguir por sí solos, como un anciano solitario que transmite sabiduría desde una cueva secreta, sólo que esta cueva es un centro de datos gigante. Le veamos o no, experimentaremos las consecuencias de su sabiduría.

Incluso si GPT-5 se lanza finalmente, este hecho parece de repente casi irrelevante. Si OpenAI y Anthropic consiguen despegar Superación recursiva (aunque todavía con participación humana), entonces ya no importará lo que nos den públicamente. Se adelantarán cada vez más, del mismo modo que el universo se expande tan rápido que la luz de las galaxias lejanas ya no puede alcanzarnos.

Quizá por eso OpenAI saltó de o1 a o3 en sólo tres meses. También por eso están saltando a o4 y o5. Quizá por eso están tan entusiasmados últimamente en las redes sociales. Porque han implementado un nuevo y mejorado modo de funcionamiento.

¿De verdad crees que estar cerca de la AGI significa que podrás utilizar IA cada vez más poderosa? ¿Que liberarán todos los avances para que los utilicemos? Por supuesto que no lo creerán. Lo decían en serio cuando dijeron por primera vez que sus modelos les llevarían tan lejos que nadie más sería capaz de alcanzarles. Cada nueva generación de modelos es un motor de velocidad de escape. Desde la estratosfera, han dicho adiós.

Queda por ver si volverán.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...