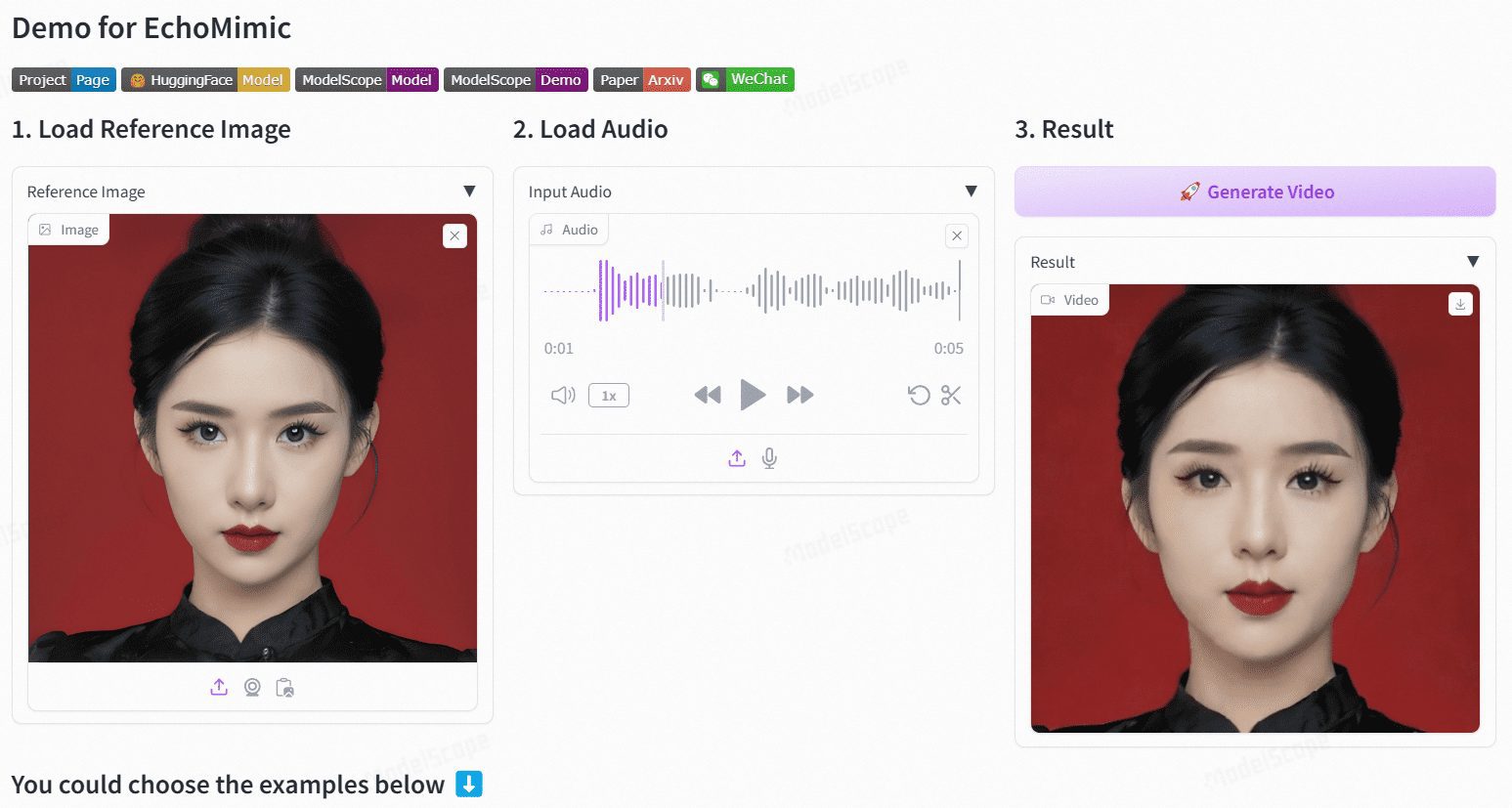

EchoMimic: retratos sonoros para generar vídeos parlantes (instalador acelerado de EchoMimicV2)

Últimos recursos sobre IAActualizado hace 1 año Círculo de intercambio de inteligencia artificial 52.5K 00

Introducción general

EchoMimic es un proyecto de código abierto cuyo objetivo es generar animaciones de retratos realistas basadas en audio. Desarrollado por la división Terminal Technologies de Ant Group, el proyecto utiliza condiciones de puntos marcadores editables para generar vídeos de retratos dinámicos combinando audio y puntos marcadores faciales.EchoMimic se ha comparado exhaustivamente en múltiples conjuntos de datos públicos y propios, demostrando su rendimiento superior en evaluaciones cuantitativas y cualitativas.

La versión EchoMimicV2 optimiza la velocidad de inferencia, añade acciones gestuales, recomendado.

Dirección demo: https://www.modelscope.cn/studios/BadToBest/BadToBest V2: https://huggingface.co/spaces/fffiloni/echomimic-v2

Lista de funciones

- Animación del controlador de audio: Genera animaciones de retratos realistas con entrada de audio.

- Animación dirigida por puntos de marcador: Genera animaciones de retratos estables utilizando puntos de marcador faciales.

- Controlador de audio + marcador: Combina audio y marcadores faciales seleccionados para generar animaciones de retratos más naturales.

- Soporte multilingüe: Admite entrada de audio en chino, inglés y otros idiomas.

- Razonamiento eficienteLos modelos y procesos optimizados mejoran notablemente la velocidad de inferencia.

Utilizar la ayuda

Proceso de instalación

- Descargar código::

git clone https://github.com/BadToBest/EchoMimic cd EchoMimic - Configuración del entorno Python::

- Se recomienda utilizar conda para crear un entorno virtual:

conda create -n echomimic python=3.8 conda activate echomimic - Instale los paquetes de dependencia:

pip install -r requirements.txt

- Se recomienda utilizar conda para crear un entorno virtual:

- Descargar y descomprimir ffmpeg-static::

- Descargue ffmpeg-static y descomprímalo, luego configure la variable de entorno:

export FFMPEG_PATH=/path/to/ffmpeg-4.4-amd64-static

- Descargue ffmpeg-static y descomprímalo, luego configure la variable de entorno:

- Descargar las pesas de preentrenamiento::

- Descargue los pesos del modelo preentrenado adecuados según la descripción del proyecto.

Proceso de utilización

- Ejecutar la Interfaz Web::

- Inicie la interfaz web:

python webgui.py - Visite el servidor local para ver la interfaz y cargar archivos de audio para la generación de animaciones.

- Inicie la interfaz web:

- razonamiento en línea de comandos::

- Utilice los siguientes comandos para generar animaciones de retratos basadas en audio:

python infer_audio2vid.py --audio_path /path/to/audio --output_path /path/to/output - Razonamiento en conjunción con señales:

python infer_audio2vid_pose.py --audio_path /path/to/audio --landmark_path /path/to/landmark --output_path /path/to/output

- Utilice los siguientes comandos para generar animaciones de retratos basadas en audio:

- Optimización de modelos::

- El uso del modelo y el pipeline optimizados puede mejorar significativamente la velocidad de inferencia, por ejemplo, de 7 min/240 fps a 50 seg/240 fps en GPUs V100.

advertencia

- Asegúrese de que la versión de Python y la versión de CUDA utilizadas son coherentes con los requisitos del proyecto.

- Si encuentra problemas durante su uso, puede consultar el archivo README del proyecto o enviar una incidencia a GitHub para obtener ayuda.

Instalador de Windows con un solo clic

Enlace: https://pan.quark.cn/s/cc973b142d41

Código del extracto: 5T57

Descarga acelerada de EchoMimicV2

Quark: https://pan.quark.cn/s/12acd147a758

Baidu: https://pan.baidu.com/s/1z8tiuGtN29luQ7Cg2zHJ8Q?pwd=9e8x

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...