DeepSeek lanza la comprensión multimodal unificada y los modelos generativos: de JanusFlow a Janus-Pro

JanusFlow Lectura rápida

DeepSeek El equipo ha dado a conocer otro nuevo modelo, lanzando Janus-Pro, un innovador marco multimodal en las primeras horas del día 28, que es un modelo unificado capaz de manejar tareas de comprensión y generación multimodal simultáneamente. Construido sobre DeepSeek-LLM-1.5b-base/DeepSeek-LLM-7b-base, el modelo admite la entrada de imágenes de 384 x 384 y utiliza un tokenizador específico para la generación de imágenes. La característica más importante es la división de la codificación visual en canales separados, al tiempo que se mantiene un único transformador arquitectura de procesamiento.

Este diseño innovador no sólo resuelve el problema de los papeles contradictorios de los modelos tradicionales en los codificadores visuales, sino que también hace que todo el sistema sea más flexible. En la práctica, Janus-Pro supera a los modelos unificados anteriores e incluso rivaliza con los modelos basados en tareas específicas en algunas tareas. Superó a DALL-E 3 de OpenAI y a Stable Diffusion en las pruebas GenEval y DPG-Bench.

La gama de modelos Janus, que comenzó con el JanusFlowcon el objetivo de construirUn marco unificado para la comprensión y generación multimodalLa idea central es combinar un modelo autorregresivo de lenguaje (LLM) con un modelo de generación de flujo rectificado. La idea central es combinar un modelo autorregresivo de lenguaje (LLM) con un modelo de generación de flujo rectificado, con el objetivo de lograr en un único modelo una comprensión visual superior y una capacidad de generación de imágenes de alta calidad.Janus-Pro Como versión avanzada de Janus, el rendimiento del modelo Janus se ha mejorado aún más mediante optimizaciones exhaustivas en la estrategia de entrenamiento, el tamaño de los datos y las dimensiones del modelo, y ha logrado avances significativos en varias pruebas de referencia. En este artículo, revisamos sistemáticamente la evolución del modelo Janus desde JanusFlow hasta Janus-Pro, centrándonos en su funcionalidad, características de los parámetros y mejoras clave.

1. JanusFlow: la piedra angular de la arquitectura unificada

dirección del papel:: https://arxiv.org/pdf/2411.07975

JanusFlow La principal innovación es suArquitectura minimalista unificadaIntegra inteligentemente el modelo modificado de generación de flujos en el marco del LLM autorregresivo sin necesidad de realizar complejas modificaciones en la estructura del LLM. Las principales características de esta arquitectura son:

- Corrección de la generación de imágenes en streaming: JanusFlow utiliza un modelo de flujo modificado para la generación de imágenes, partiendo de ruido gaussiano, prediciendo iterativamente los vectores de velocidad para actualizar la representación del espacio latente de la imagen y, en última instancia, generando imágenes de alta calidad mediante un descodificador. Este enfoque evita la limitación de los métodos tradicionales, en los que el LLM sólo actúa como generador condicional y carece de capacidad de generación directa.

- Codificador visual desacoplado: Para optimizar el rendimiento del modelo unificado, JanusFlow utiliza el métodoCodificador desacopladose utilizan codificadores visuales independientes para la tarea de comprensión y la tarea de generación, respectivamente:

- Comprender los codificadores (fenc): Utilización de SigLIP-Parche grande/16 que se encarga de extraer las características semánticas de las imágenes para mejorar la comprensión multimodal.

- Generar codificador (genc) y decodificador (gdec): entrenamiento scratch ConvNeXt módulo dedicado a las tareas de generación de imágenes para optimizar la calidad de la generación.

- Mecanismos de alineación de la representación: Durante el proceso de formación para la unificación, JanusFlow introducealineación de caracteresmecanismo que alinea las representaciones intermedias de los módulos de generación y comprensión, mejorando así la coherencia semántica y la consistencia en el proceso de generación.

- Una estrategia de formación en tres fases: JanusFlow ha diseñado un minucioso programa de formación en tres fases:

- Etapa 1: Inicialización aleatoria Adaptación de los componentes - La capa lineal, el codificador generador y el decodificador se entrenan para trabajar con los codificadores LLM y SigLIP preentrenados como fase de inicialización para el entrenamiento posterior.

- Fase 2: Armonización de la formación previa - Entrenar todo el modelo excepto el codificador visual, fusionando la comprensión multimodal, la generación de imágenes y los datos de texto plano, para establecer inicialmente una capacidad unificada del modelo.

- Etapa 3: Seguimiento de la puesta a punto - Los datos de ajuste de comandos se utilizan para seguir entrenando el modelo con el fin de mejorar la respuesta a los comandos del usuario y descongelar los parámetros del codificador SigLIP en esta fase.

Características de los parámetros:

- Máster en Derecho: Arquitectura LLM ligera con 1,3B de parámetros.

- Codificador visual: SigLIP-Large-Patch/16 (comprensión), ConvNeXt (generación de codificadores y descodificadores).

- Resolución de imagen: 384 × 384 píxeles.

Rendimiento: JanusFlow logra un rendimiento significativo tanto en la generación de texto a imagen como en las tareas de comprensión multimodal, superando a muchos modelos especializados y demostrando la eficacia de su arquitectura unificada.

2. Janus-Pro: actualización completa de datos, modelos y estrategias

dirección del papel:: https://github.com/deepseek-ai/Janus/blob/main/janus_pro_tech_report.pdf

Janus-Pro Como versión mejorada de Janus, JanusFlow se ha actualizado en tres áreas principales:

- Estrategias de formación optimizadas: Janus-Pro perfecciona la estrategia de formación en tres fases de JanusFlow, con el objetivo de abordar los cuellos de botella de la eficacia y el rendimiento de la formación:

- Fase 1: Entrenamiento del conjunto de datos ImageNet ampliado - Aumentar el número de pasos de entrenamiento en el conjunto de datos ImageNet permite al modelo aprender las dependencias de los píxeles de forma más completa, mejorando las capacidades subyacentes de generación de imágenes.

- Etapa 2: Centrarse en la formación de datos de texto a imagen - En la fase 2 de entrenamiento, se eliminan los datos de ImageNet y se utiliza directamente el conjunto de datos normal de texto a imagen, lo que permite al modelo aprender de forma más eficaz a generar imágenes de alta calidad a partir de descripciones de texto densas.

- Etapa 3: Ampliación de los datos - En la fase de ajuste supervisado, se ajustaron las proporciones de los datos de comprensión multimodal, los datos de texto sin formato y los datos de texto a imagen (de 7:3:10 a 5:1:4) para mejorar aún más el rendimiento de la comprensión multimodal al tiempo que se garantizaba la capacidad de generación visual.

- Datos de entrenamiento ampliados: Janus-Pro escala drásticamente el tamaño y la diversidad de los datos de entrenamiento para mejorar la capacidad de generalización y la calidad de generación del modelo:

- Comprensión multimodal de los datos: En la fase de preentrenamiento de la Etapa 2, se añadieron unos 90 millones de muestras nuevas, que abarcaban una gama más amplia de datos de subtitulación de imágenes (por ejemplo, YFCC), así como datos de tablas, gráficos y comprensión de documentos (por ejemplo, Docmatix). En la fase 3 de perfeccionamiento, se introducen más muestras. DeepSeek-VL2 así como datos de comprensión MEME, datos de diálogo en chino, etc., lo que mejora significativamente la capacidad de diálogo y la capacidad multitarea del modelo.

- Datos generados visualmente: Para mejorar la calidad estética y la estabilidad de las imágenes generadas, Janus-Pro introduce unos 72 millones de datos estéticos sintéticos de alta calidad y ajusta la proporción entre datos reales y datos sintéticos a 1:1. Los experimentos demuestran que la adición de datos sintéticos acelera la convergencia del modelo y mejora significativamente la calidad estética y la estabilidad de las imágenes generadas.

- Tamaño del modelo ampliado: Janus-Pro no sólo conserva el modelo paramétrico de 1,5B de JanusFlow, sino que lo amplía aún más para incluir el 7B Parámetrosy proporciona Serie Janus-Pro en los modelos 1,5B y 7B.Los resultados experimentales muestran que los LLM de mayor escala pueden mejorar significativamente el rendimiento del modelo y acelerar la velocidad de convergencia. Los resultados experimentales muestran que los LLM de mayor escala pueden mejorar significativamente el rendimiento del modelo y acelerar la velocidad de convergencia, validando la escalabilidad de la arquitectura del modelo Janus.

Características de los parámetros:

- Dimensiones del modelo: Disponible en los modelos 1,5B y 7B.

- Arquitectura: Sigue la arquitectura del codificador visual desacoplado de JanusFlow.

- Datos de entrenamiento: Datos de entrenamiento significativamente ampliados y optimizados para la comprensión multimodal y la generación visual.

- Resolución de imagen: La resolución de imagen utilizada en los experimentos se mantuvo en 384 × 384 píxeles.

Rendimiento: Janus-Pro demostró la eficacia de las actualizaciones de datos, modelos y estrategias al lograr importantes mejoras de rendimiento en todas las pruebas de referencia, especialmente en la prueba de referencia de comprensión multimodal MMBench y en las pruebas de referencia de generación de texto a imagen GenEval y DPG-Bench, que superaron a JanusFlow y a otros modelos avanzados unificados y especializados.

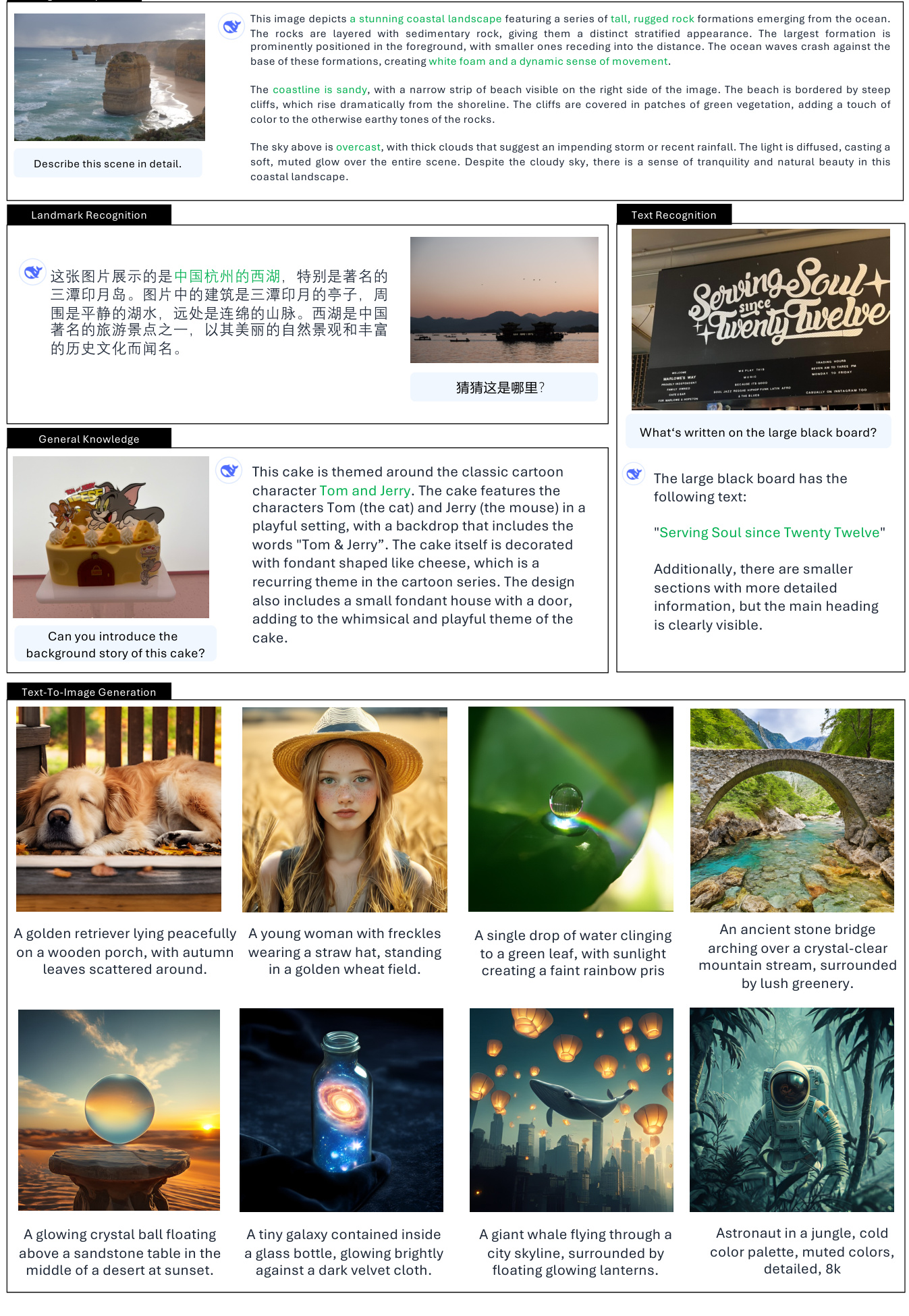

3.Escenarios de uso real de Janus

Funciones de comprensión visual:

- Descripción/titulación de la imagen.

- Descripción detallada de la escena: Puede generar descripciones de texto detalladas basadas en el contenido de la imagen, incluyendo elementos de la escena, objetos, atmósfera ambiental, etc. (Ejemplo: descripción de los tres estanques del Lago del Oeste, el paisaje costero, etc.) (Ejemplo: descripción de los tres estanques del Lago del Oeste, el paisaje costero, etc.)

- Descripción gráfica: Ser capaz de comprender y describir información en gráficos y diagramas, como la representación de datos y el análisis de tendencias de gráficos de barras. (Ejemplo: Interpretar el gráfico de barras "Las frutas favoritas de los niños").

- Reconocimiento/clasificación de objetos.

- Identificar tipos de objetos en una imagen: Ser capaz de identificar y enumerar categorías de objetos que aparecen en una imagen. (Ejemplo: Identificar el tipo de fruta en una imagen).

- Recuento de objetos.

- Contar con precisión el número de objetos de una imagen: Capacidad para contar con precisión el número de objetos específicos de una imagen. (Ejemplo: contar el número de pingüinos de la imagen).

- Reconocimiento de hitos.

- Identificar puntos de referencia famosos en imágenes: Ser capaz de identificar puntos de referencia o lugares que aparecen en una imagen. (Ejemplo: Identificar los tres estanques del lago del Oeste).

- Reconocimiento de texto/OCR.

- Reconocer el contenido de texto en imágenes: Ser capaz de reconocer el texto que aparece en una imagen y extraer la información del texto. (Ejemplo: Identificar en la pizarra "Serving Soul since Twenty Twelve").

- Respuesta visual a preguntas.

- Responder a preguntas basadas en el contenido de la imagen: Ser capaz de entender el contenido de una imagen y dar una respuesta razonable basada en la pregunta del usuario. (Ejemplo: Preguntar "¿Qué fruta hay en la imagen?" en respuesta a una imagen).

- Razonamiento visual/integración de conocimientos.

- Comprender los significados y las asociaciones que subyacen a las imágenes: ser capaz de razonar visualmente a un nivel más profundo y contextualizar los conocimientos. (Ejemplos: explicar el humor de la imagen del perro de la Mona Lisa, comprender el contexto temático de dibujos animados de la tarta).

- Generación de código (Python for Plotting).

- Generar código basado en comandos de usuario: Comprender los requisitos del usuario para la creación de gráficos y generar código Python en consecuencia. (Ejemplo: Generar código Python para dibujar un gráfico de barras).

Función de generación de texto a imagen:

- Generación de imágenes guiada por texto.

- Generar imágenes a partir de descripciones de texto: Puede generar imágenes semánticamente relacionadas a partir de indicaciones de texto introducidas por el usuario.

- Generación de imágenes creativas: Capacidad de comprender textos abstractos e imaginativos para generar imágenes creativas y artísticas. (Ejemplos: ballena voladora, corgi de nebulosa cósmica, etc.)

- Generación de imágenes estilizadas: Genere imágenes con estilos artísticos específicos según la descripción del estilo en las indicaciones de texto. (Ejemplos: iglesia renacentista, pueblo de montaña pintado con tinta china, etc.)

- Generación de texto simple sobre imágenes: Capacidad de generar imágenes con elementos de texto simple. (Ejemplo: escribir "Hola" en una pizarra).

Ejemplos de situaciones de aplicación práctica:

- Asistente inteligente: actúa como un asistente inteligente multimodal que entiende las imágenes subidas por el usuario y realiza preguntas y respuestas, descripciones, análisis, etc.

- Creación de contenidos: Ayude a los creadores de contenidos a generar rápidamente material gráfico de alta calidad, como gráficos para redes sociales, ilustraciones de artículos, etc.

- Aplicaciones educativas: Se utiliza para enseñar a reconocer imágenes, enseñar a interpretar diagramas, etc. para ayudar a los estudiantes a comprender la información visual.

- Recuperación de información: proporciona resultados de recuperación más ricos mediante la búsqueda de imágenes combinada con capacidades de comprensión y generación de texto.

- Creación artística: Como herramienta creativa, ayuda a los artistas a crear imágenes y explorar nuevas formas de expresión visual.

Características y limitaciones de los parámetros que hay que tener en cuenta:

- Limitaciones de la resolución de las imágenes: el entrenamiento y las pruebas actuales de los modelos se basan principalmente en imágenes de 384x384 de resolución, lo que puede presentar limitaciones para escenarios que requieran una resolución mayor.

- Fineza de los detalles: aunque la imagen es rica desde el punto de vista semántico, aún puede mejorarse la fineza de los detalles debido a la pérdida de resolución y reconstrucción del tokenizador de visión, por ejemplo, las zonas de la cara de pequeño tamaño pueden no ser lo suficientemente finas.

4. Resumen y perspectivas

La familia de modelos Janus, desde JanusFlow hasta Janus-Pro, demuestra el potencial de avances continuos en el campo de la comprensión y la generación multimodal unificada.Mientras que JanusFlow sentó las bases de una arquitectura unificada, Janus-Pro ofrece un salto cuántico en el rendimiento gracias a la optimización de la estrategia de entrenamiento, el aumento del tamaño de los datos y la mejora del tamaño del modelo.El éxito de Janus-Pro El éxito de Janus-Pro validaLos datos y las ampliaciones de modelos son clave para mejorar el rendimiento de los modelos unificadosLa evolución de la familia de modelos Janus no sólo impulsa el progreso de los modelos multimodales, sino que también sienta unas bases sólidas para construir sistemas de IA más versátiles e inteligentes.

Artículo completo "Janus-Pro: un modelo generativo y de comprensión multimodal unificado, habilitado por extensiones de datos y modelos".

autor: Xiaokang Chen, Zhiyu Wu, Xingchao Liu, Zizheng Pan, Wen Liu, Zhenda Xie, Xingkai Yu, Chong Ruan

página del proyecto: https://github.com/deepseek-ai/Janus

resúmenes

En este trabajo presentamos Janus-Pro, una versión mejorada del anterior modelo Janus. En concreto, Janus-Pro integra (1) una estrategia de entrenamiento optimizada, (2) datos de entrenamiento ampliados y (3) escalado a modelos de mayor tamaño. Con estas mejoras, Janus-Pro logra avances significativos en la comprensión multimodal y en las capacidades de seguimiento de comandos para imágenes generadas por texto, al tiempo que mejora la estabilidad de las imágenes generadas por texto. Esperamos que este trabajo estimule la exploración en este campo. El código y el modelo están a disposición del público.

1. Introducción

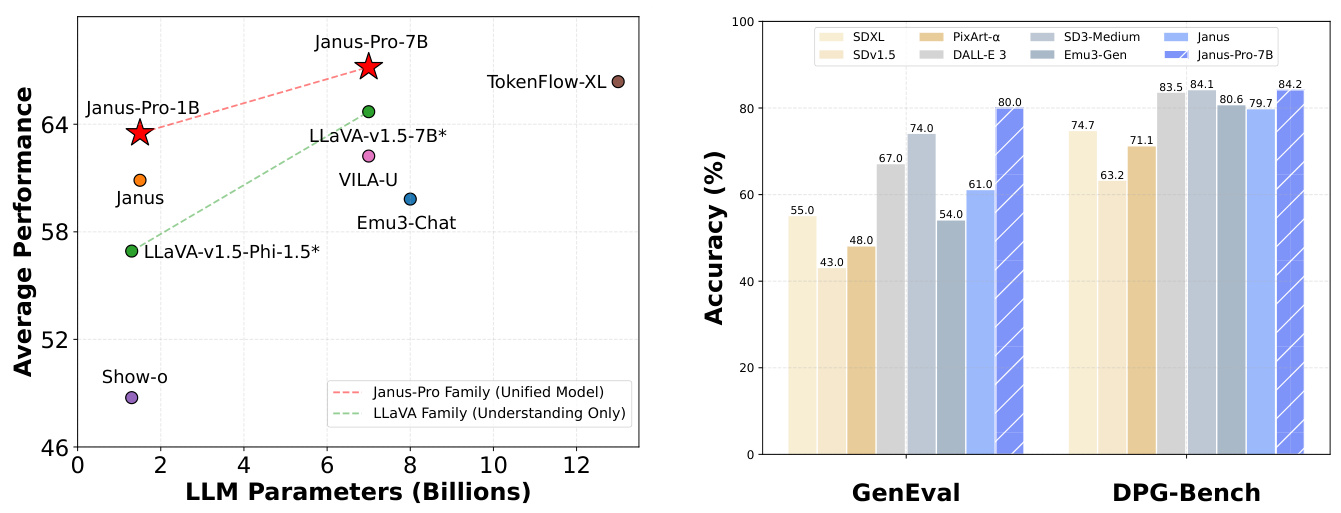

(a) Rendimiento medio de cuatro puntos de referencia de comprensión multimodal. (b) Desempeño de la instrucción de texto a imagen después del punto de referencia.

Figura 1 Resultados de comprensión multimodal y generación visual para Janus-Pro. Para la comprensión multimodal, promediamos la precisión de POPE, MME-Perception, GQA y MMMU. La puntuación de MME-Perception se dividió por 20 para escalarla al intervalo [0, 100]. Para la generación visual, evaluamos el rendimiento de las pruebas de referencia de seguimiento de comandos GenEval y DPG-Bench. En general, Janus-Pro supera a los modelos multimodales unificados más avanzados, así como a algunos modelos para tareas específicas. Los mejores resultados se obtuvieron en la visualización en pantalla.

1. una foto sencilla de una mandarina naranja 2. una pizarra limpia con una superficie verde y la palabra "Hola" escrita con precisión y claridad en tiza blanca 3. un primer plano de un girasol que simboliza la prosperidad, con tallos y hojas verdes, pétalos en plena floración y una abeja posada sobre él, con sus alas brillando a la luz del sol.

Figura 2 Comparación de las imágenes generadas por texto de Janus-Pro y su predecesor, Janus. Janus-Pro proporciona una salida más consistente para indicaciones cortas, con mayor calidad visual, detalles más ricos y la capacidad de generar texto simple. La resolución de la imagen es de 384x384 y se ve mejor en una pantalla.

Recientemente se han logrado avances significativos en la unificación de la comprensión multimodal y los modelos generativos [30, 40, 45, 46, 48, 50, 54, 55]. Se ha demostrado que estos enfoques mejoran la adherencia a las instrucciones en tareas de generación visual a la vez que reducen la redundancia de modelos. La mayoría de estos enfoques utilizan el mismo codificador visual para procesar las entradas de las tareas de comprensión y generación multimodal. El resultado suele ser un bajo rendimiento de la comprensión multimodal debido a las diferentes representaciones necesarias para ambas tareas. Para solucionar este problema, Janus [46] propuso la codificación visual desacoplada, que alivia el conflicto entre las tareas de comprensión multimodal y de generación, consiguiendo un rendimiento excelente en ambas tareas.

Como modelo pionero, Janus fue validado a escala de parámetros 1B. Sin embargo, debido a las limitaciones de los datos de entrenamiento y a la capacidad relativamente pequeña del modelo, presenta varios inconvenientes, como un rendimiento deficiente en la generación de imágenes de pistas cortas y una calidad inconsistente de las imágenes generadas por texto. En este artículo, presentamos Janus-Pro, una versión mejorada de Janus que mejora tres aspectos: la estrategia de entrenamiento, los datos y el tamaño del modelo.La familia Janus-Pro consta de dos tamaños de modelo: 1B y 7B, lo que demuestra la escalabilidad del método de codificación-descodificación visual.

Hemos evaluado Janus-Pro en múltiples pruebas de referencia y los resultados muestran una comprensión multimodal superior y un rendimiento significativamente mejorado en la adherencia a instrucciones de imágenes generadas por texto. En concreto, Janus-Pro-7B obtiene una puntuación de 79,2 en la prueba de comprensión multimodal MMBench [29], superando a modelos multimodales unificados de última generación como Janus [46] (69,4), TokenFlow [34] (68,9) y MetaMorph [42] (75,2). Además, Janus-Pro-7B obtiene una puntuación de 0,80 en la directiva texto-generar-imágenes según la tabla de clasificación GenEval [14], superando a Janus [46] (0,61), DALL-E 3 (0,67) y Stable Diffusion 3 Medium [11] (0,74).

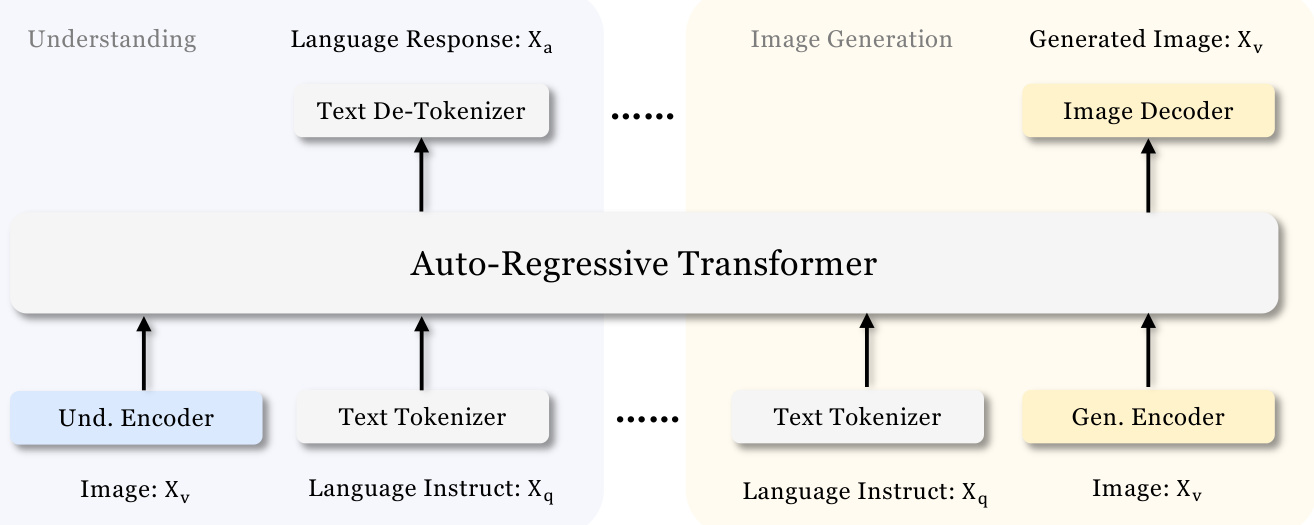

Figura 3 Arquitectura de Janus-Pro. Desacoplamos la codificación visual para la comprensión multimodal y la generación visual. "Codificador Und." y "Codificador Gen." son abreviaturas de "Codificador de comprensión" y "Codificador de generación", respectivamente. "Und. Encoder" y "Gen. Encoder" son abreviaturas de "Understanding Encoder" y "Generation Encoder" respectivamente. Se ve mejor en pantalla.

2. Metodología

2.1.

La arquitectura de Janus-Pro se muestra en la Figura 3 y es la misma que la de Janus [46]. El principio básico de diseño de la arquitectura general es desacoplar la codificación visual para la comprensión y generación multimodal. Aplicamos métodos de codificación independientes para convertir las entradas brutas en características, que luego son procesadas por un transformador autorregresivo unificado. Para la comprensión multimodal, utilizamos el codificador SigLIP [53] para extraer características semánticas de alta dimensión de las imágenes. Estos rasgos se extienden desde una malla bidimensional a una secuencia unidimensional, y estos rasgos de imagen se mapean al espacio de entrada del LLM utilizando un adaptador de comprensión. Para la tarea de generación visual, utilizamos el etiquetador VQ de [38] para convertir las imágenes en ID discretos. Después de aplanar las secuencias de ID a 1-D, utilizamos el adaptador de generación para mapear los embeddings del libro de códigos correspondientes a cada ID al espacio de entrada del LLM. A continuación, concatenamos estas secuencias de características para formar una secuencia de características multimodal, que posteriormente se introduce en el LLM para su procesamiento. Además de la cabecera de predicción incorporada en el LLM, utilizamos una cabecera de predicción inicializada aleatoriamente para la predicción de imágenes en tareas de generación visual. Todo el modelo sigue un marco autorregresivo.

2.2 Estrategias de formación optimizadas

La versión anterior de Janus utilizaba un proceso de formación en tres etapas. La primera fase se centraba en el entrenamiento de los adaptadores y los cabezales de imagen. La segunda fase se ocupa del preentrenamiento uniforme, en el que todos los componentes, salvo el codificador de comprensión y el codificador de generación, actualizan sus parámetros. La tercera fase es el ajuste fino supervisado, que se basa en la segunda fase desbloqueando aún más los parámetros del codificador de comprensión durante el proceso de entrenamiento. Esta estrategia de entrenamiento plantea algunos problemas. En la segunda fase, Janus divide el entrenamiento de la capacidad texto-imagen en dos partes, siguiendo a PixArt [4]. La primera parte se entrenó con datos de ImageNet [9], utilizando nombres de categorías de imágenes como pistas para imágenes generadas por texto, con el objetivo de modelar dependencias de píxeles. La segunda parte se entrenó con datos de imágenes generadas por texto plano. En la implementación, 66,67% de los pasos de entrenamiento de imágenes generadas por texto en la segunda fase se asignaron a la primera parte. Sin embargo, en experimentos posteriores, descubrimos que esta estrategia no es óptima y genera importantes ineficiencias computacionales.

Se han introducido dos cambios para solucionar este problema.

- Formación más larga en la primera faseEl modelo: Hemos añadido una primera fase de entrenamiento que permite realizar un entrenamiento completo en el conjunto de datos ImageNet. Nuestros resultados muestran que, incluso con parámetros LLM fijos, el modelo puede modelar eficazmente las dependencias de los píxeles y generar imágenes sensibles basadas en nombres de categorías.

- Formación centrada en la Fase IIEn la segunda fase, abandonamos los datos de ImageNet y utilizamos directamente datos de imágenes generadas por texto plano para entrenar el modelo de generación de imágenes basado en descripciones densas. Este enfoque rediseñado permite que la segunda fase utilice los datos de imágenes generadas por texto de forma más eficiente, mejorando así la eficacia del entrenamiento y el rendimiento general.

También ajustamos las proporciones de datos de los distintos tipos de conjuntos de datos en la tercera fase del proceso de ajuste supervisado, cambiando la proporción de datos multimodales, datos de sólo texto y datos de imágenes generadas por texto de 7:3:10 a 5:1:4. Al disminuir ligeramente la proporción de datos de imágenes generadas por texto, observamos que este ajuste nos permitía lograr un mejor rendimiento de la comprensión multimodal, manteniendo al mismo tiempo una gran capacidad de generación visual.

2.3 Ampliación de datos

Ampliamos los datos de entrenamiento utilizados por Janus en la comprensión multimodal y la generación de visión.

- comprensión multimodalPara los datos de preentrenamiento de la segunda etapa, nos referimos a DeepSeekVL2 [49] y añadimos unos 90 millones de muestras. Estos incluyen conjuntos de datos de subtitulado de imágenes (por ejemplo, YFCC [31]), así como datos para la comprensión de tablas, gráficos y documentos (por ejemplo, Docmatix [20]). Para la tercera etapa de datos supervisados de ajuste fino, también añadimos conjuntos de datos adicionales de DeepSeek-VL2, como la comprensión MEME, datos de diálogo en chino y conjuntos de datos diseñados para mejorar la experiencia de diálogo. Estas adiciones amplían significativamente las capacidades del modelo, enriqueciendo su capacidad para manejar una variedad de tareas al tiempo que mejora la experiencia de diálogo en general.

- producción visualJanus-Pro: Hemos observado que los datos reales utilizados en la versión anterior de Janus carecían de calidad y contenían mucho ruido, lo que solía dar lugar a imágenes inestables generadas por texto que producían resultados estéticamente pobres. En Janus-Pro, hemos incluido aproximadamente 72 millones de muestras de datos estéticos sintéticos para que la proporción entre datos reales y sintéticos sea de 1:1 en la fase de preentrenamiento unificado.Las pistas para estas muestras de datos sintéticos están disponibles públicamente, como las de [43]. Los experimentos han demostrado que cuando se entrena con datos sintéticos, el modelo converge más rápidamente y produce no sólo un resultado de imagen generada por texto más estable, sino también una calidad estética significativamente mejor.

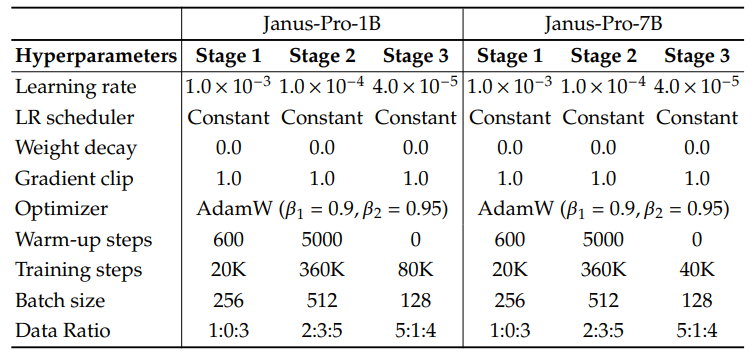

2.4 Ampliación de modelos

Una versión anterior de Janus verificó la eficacia de utilizar el LLM de 1,5B para el desacoplamiento de la codificación visual. En Janus-Pro, ampliamos el modelo a 7B, y los hiperparámetros de los LLM de 1,5B y 7B se detallan en la Tabla 1. Observamos un aumento significativo en la velocidad de convergencia de la comprensión multimodal y la pérdida de generación visual al utilizar LLMs más grandes en comparación con modelos más pequeños. Este hallazgo valida aún más la escalabilidad robusta de este enfoque.

Cuadro 1 Configuración de la arquitectura de Janus-Pro. Enumeramos los hiperparámetros de la arquitectura.

| Janus-Pro-1B | Janus-Pro-7B | |

| Tamaño del vocabulario | 100K | 100K |

| Tamaño de incrustación | 2048 | 4096 |

| ventana contextual | 4096 | 4096 |

| capacidad de atención | 16 | 32 |

| piso | 24 | 30 |

Cuadro 2 Hiperparámetros detallados para el entrenamiento de Janus-Pro. La proporción de datos se refiere a la proporción de datos de comprensión multimodal, datos de texto sin formato y datos generados visualmente.

3. Experimentos

3.1 Detalles de la aplicación

En nuestros experimentos, utilizamos DeepSeek-LLM (1.5B y 7B) [3] como modelo lingüístico base con una longitud de secuencia máxima soportada de 4.096. Para el codificador visual utilizado en la tarea de comprensión, elegimos SigLIP-Large-Patch16-384 [53]. El codificador de generación tiene un libro de códigos de tamaño 16.384 y reduce la muestra de la imagen 16 veces. Tanto el adaptador de comprensión como el de generación son MLP de dos capas. En la Tabla 2 se detallan los hiperparámetros de cada etapa. Todas las imágenes se redimensionaron a 384x384 píxeles. Para los datos de comprensión multimodal, redimensionamos el lado largo de la imagen a 384 y rellenamos el lado corto con el color de fondo (RGB: 127, 127, 127) para llegar a 384. Para los datos de generación visual, redimensionamos el lado corto a 384 y recortamos el lado largo a 384. utilizamos empaquetamiento de secuencias durante el proceso de entrenamiento para mejorar la eficiencia del entrenamiento. Mezclamos todos los tipos de datos según proporciones especificadas en un único paso de entrenamiento. Nuestro Janus se entrena y evalúa utilizando HAI-LLM [15], un marco de entrenamiento distribuido ligero y eficiente construido sobre PyTorch. El proceso de entrenamiento completo duró aproximadamente 7/14 días en un clúster de 16/32 nodos equipado con 8 GPUs Nvidia A100 (40GB) para modelos de 1,5B/7B.

3.2 Evaluación de la configuración

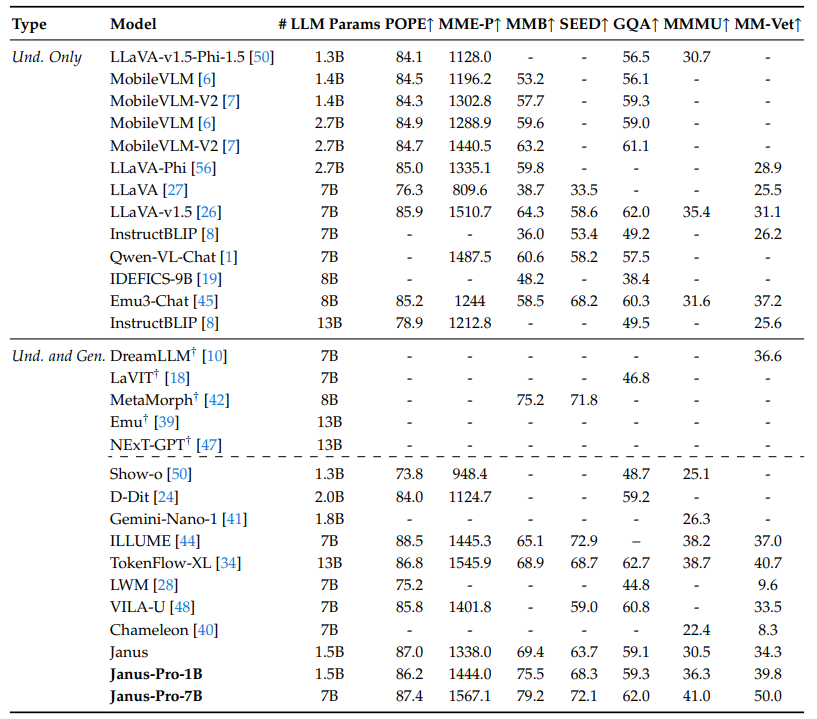

Comprensión multimodal: Para evaluar la comprensión multimodal, evaluamos nuestro modelo en pruebas de referencia visuales-verbales basadas en imágenes ampliamente reconocidas, como GQA [17], POPE [23], MME [12], SEED [21], MMB [29], MM-Vet [51] y MMMU [52].

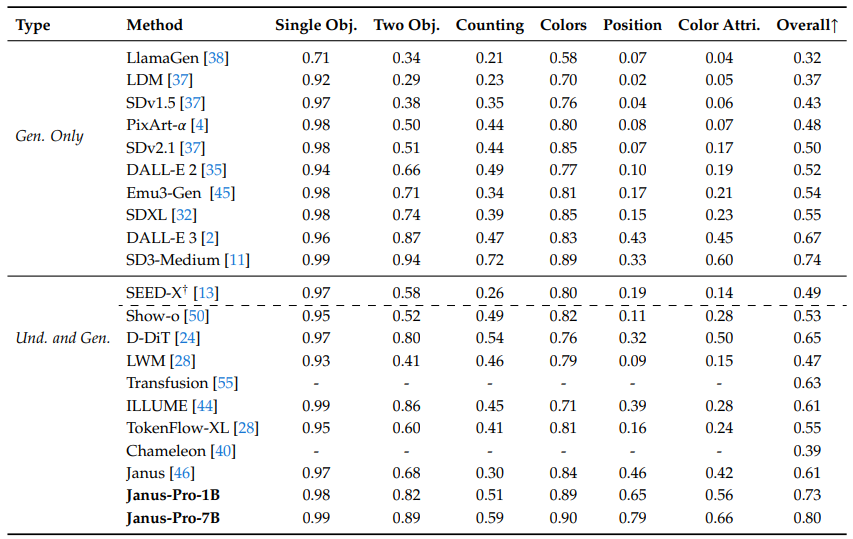

Cuadro 3 Comparación con las técnicas más avanzadas en la evaluación comparativa de la comprensión multimodal. "Und." y "Gen." denotan "Comprensión" y "Generación" respectivamente. Los modelos que utilizan modelos de difusión externos preentrenados se marcan con †.

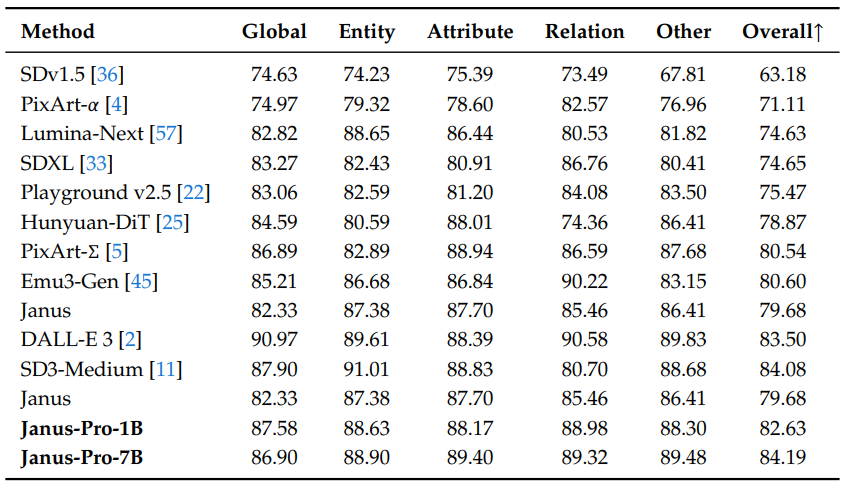

Generación visual: Para evaluar las capacidades de generación visual, utilizamos GenEval [14] y DPG-Bench [16].GenEval es una exigente prueba comparativa de generación de imagen a texto diseñada para reflejar todas las capacidades generativas de un modelo de generación visual mediante un análisis detallado a nivel de instancia de sus capacidades combinatorias.DPG-Bench (Dense Prompted Graph Benchmark) es un amplio conjunto de datos que contiene 1065 pistas largas y densas en un amplio conjunto de datos diseñado para evaluar las complejas capacidades de alineación semántica de los modelos texto-imagen.

3.3 Comparación con el estado de la técnica

Rendimiento de la comprensión multimodal: En la Tabla 3 comparamos el enfoque propuesto con los modelos unificados y de comprensión del estado de la técnica. Esto puede atribuirse a la disociación de la comprensión multimodal y la codificación visual generada, que alivia el conflicto entre estas dos tareas. Janus-Pro sigue siendo muy competitivo cuando se compara con modelos mucho más grandes. Por ejemplo, Janus-Pro-7B supera a TokenFlow-XL (13B) en todas las pruebas de referencia excepto en GQA.

Cuadro 4 Evaluación de la generación de texto a imagen en la prueba GenEval. "Und." y "Gen." denotan "Comprensión" y "Generación" respectivamente. Los modelos que utilizan modelos de difusión externos preentrenados se marcan con †.

Cuadro 5 rendimiento en DPG-Bench. A excepción de Janus y Janus-Pro, todos los métodos de esta tabla son específicos del modelo utilizado para generar la tarea.

Rendimiento de la generación visual: Informamos del rendimiento de la generación visual en GenEval y DPG-Bench. Como se muestra en la Tabla 4, nuestro Janus-Pro-7B obtiene una precisión global de 80% en GenEval, que supera a todos los demás métodos unificados o que sólo admiten generación, por ejemplo, Transfusion [55] (63%), SD3-Medium (74%) y DALL-E 3 (67%). Esto demuestra que nuestro método tiene una mejor capacidad de seguimiento de instrucciones. Como muestra la Tabla 5, Janus-Pro obtiene una puntuación de 84,19 en el DPG-Bench, superando a todos los demás métodos. Esto demuestra que Janus-Pro es bueno en el seguimiento de instrucciones densas para la generación de texto a imagen.

3.4 Resultados cualitativos

Mostramos los resultados de la comprensión multimodal en la Fig. 4. Janus-Pro muestra una comprensión impresionante al procesar entradas de diferentes contextos, lo que demuestra su potencia. También mostramos algunos resultados de generación de imágenes generadas por texto en la parte inferior de la Fig. 4. Las imágenes generadas por Janus-Pro-7B son muy realistas y contienen una gran cantidad de detalles a pesar de que la resolución es de sólo $384\times384$. Para escenarios imaginativos y creativos, Janus-Pro-7B capta con precisión la información semántica de las indicaciones y genera imágenes sensatas y coherentes.

Figura 4 Resultados cualitativos de la comprensión multimodal y la capacidad de generación visual. El modelo es Janus-Pro-7B, y la salida de imagen generada visualmente tiene una resolución de $384\times384$. se ve mejor en una pantalla.

4. Conclusión

En este trabajo se introducen mejoras en Janus en cuanto a la estrategia de entrenamiento, los datos y el tamaño del modelo. Estas mejoras se traducen en mejoras significativas en la comprensión multimodal y en el seguimiento de comandos de imágenes de generación de texto. Sin embargo, Janus-Pro sigue teniendo algunas limitaciones. Para la comprensión multimodal, la resolución de entrada está limitada a $384\times384$, lo que afecta a su rendimiento en tareas de grano fino como el OCR. En el caso de las imágenes generadas por texto, la baja resolución unida a la pérdida de reconstrucción introducida por el etiquetador visual da como resultado imágenes ricas desde el punto de vista semántico, pero carentes de detalle. Por ejemplo, las regiones faciales pequeñas que ocupan un espacio de imagen limitado pueden parecer no tener suficiente detalle. Aumentar la resolución de la imagen puede aliviar estos problemas.

bibliografía

[1] J. Bai, S. Bai, S. Yang, S. Wang, S. Tan, P. Wang, J. Lin, C. Zhou y J. Zhou. qwen-vl: a cutting-edge large-scale visual language model with versatility. arXiv preprint arXiv:2308.12966, 2023.[2] J. Betker, G. Goh, L. Jing, T. Brooks, J. Wang, L. Li, L. Ouyang, J. Zhuang, J. Lee, Y. Guo, et al. Mejora de la generación de imágenes mediante un mejor subtitulado. Computer Science. https://cdn.openai.com/papers/dall-e-3.pdf, 2(3):8, 2023.

[3] X. Bi, D. Chen, G. Chen, S. Chen, D. Dai, C. Deng, H. Ding, K. Dong, Q. Du, Z. Fu, et al. DeepSeek LLM: Extending open source language models using long-termism. arXiv preprint arXiv:2401.02954, 2024.

[4] J. Chen, J. Yu, C. Ge, L. Yao, E. Xie, Y. Wu, Z. Wang, J. Kwok, P. Luo, H. Lu, et al. PixArtℎ: fast training diffusion transformer for photo-realistic text generation image synthesis. arXiv preprint arXiv:2310.00426, 2023.

[5] J. Chen, C. Ge, E. Xie, Y. Wu, L. Yao, X. Ren, Z. Wang, P. Luo, H. Lu y Z. Li. PixArt-Sigma: weak-to-strong diffusion transformer training for 4K text generation image generation. arXiv preprint arXiv:2403.04692, 2024.

[6] X. Chu, L. Qiao, X. Lin, S. Xu, Y. Yang, Y. Hu, F. Wei, X. Zhang, B. Zhang, X. Wei, et al. Mobilevlm: a fast, reproducible and powerful visual language assistant for mobile devices. arXiv preprint arXiv:2312.16886, 2023.

[7] X. Chu, L. Qiao, X. Zhang, S. Xu, F. Wei, Y. Yang, X. Sun, Y. Hu, X. Lin, B. Zhang, et al. Mobilevlm v2: A faster and more powerful basis for visual language modelling. arXiv preprint arXiv:2402.03766, 2024.

[8] W. Dai, J. Li, D. Li, A. M. H. Tiong, J. Zhao, W. Wang, B. Li, P. Fung y S. Hoi. Instructblip: towards a generalised visual language model with command fine-tuning, 2023.

[9] J. Deng, W. Dong, R. Socher, L.-J. Li, K. Li y L. Fei-Fei. Imagenet: a large-scale hierarchical image database. En Proceedings of the 2009 IEEE Conference on Computer Vision and Pattern Recognition, páginas 248-255. Institute of Electrical and Electronics Engineers, 2009.

[10] R. Dong, C. Han, Y. Peng, Z. Qi, Z. Ge, J. Yang, L. Zhao, J. Sun, H. Zhou, H. Wei, et al. Dreamllm: multimodal collaborative understanding and creation. arXiv preprint arXiv:2309.11499, 2023.

[11] P. Esser, S. Kulal, A. Blattmann, R. Entezari, J. Mller, H. Saini, Y. Levi, D. Lorenz, A. Sauer, F. Boesel, D. Podell, T. Dockhorn, Z. English, K. Lacey A. Goodwin, Y. Marek y R. Rombach. scaling-corrected stream transformer for high-resolution image synthesis, 2024. URL https://arxiv.org/abs/2403.03206.

[12] C. Fu, P. Chen, Y. Shen, Y. Qin, M. Zhang, X. Lin, J. Yang, X. Zheng, K. Li, X. Sun, et al. MME: a comprehensive evaluation benchmark for multimodal large language models. arXiv preprint arXiv:2306.13394, 2023.

[13] Y. Ge, S. Zhao, J. Zhu, Y. Ge, K. Yi, L. Song, C. Li, X. Ding, and Y. Shan. SEED-X: a multimodal model with unified multi-granularity understanding and generation. arXiv preprint arXiv:2404.14396, 2024.

[14] D. Ghosh, H. Hajishirzi, y L. Schmidt. GenEval: an object-oriented framework for evaluating text-generated image alignment. Advances in Neural Information Processing Systems, 36, 2024.

[15] High-flyer. HAI-LLM: An Efficient and Lightweight Large Model Training Tool, 2023. URL https://www.high-flyer.cn/en/blog/hai-llm.

[16] X. Hu, R. Wang, Y. Fang, B. Fu, P. Cheng y G. Yu. ELLA: Equipping diffusion models for enhanced semantic alignment. arXiv preprint arXiv:2403.05135, 2024.

[17] D. A. Hudson y C. D. Manning. gqa: a new dataset for real-world visual reasoning and combinatorial quizzing. En Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, páginas 6700-6709, 2019.

[18] Y. Jin, K. Xu, L. Chen, C. Liao, J. Tan, B. Chen, C. Lei, A. Liu, C. Song, X. Lei, et al. Dynamic discrete visual tokenisation for visual pre-training in unified language. arXiv preprint arXiv:2309.04669, 2023.

[19] H. Laurenon, D. van Strien, S. Bekman, L. Tronchon, L. Saulnier, T. Wang, S. Karamcheti, A. Singh, G. Pistilli, Y. Jernite, y et al. Introducing IDEFICS: an open model for reproducing state-of-the-art visual language models, 2023. URL https://huggingface.co/blog/id efics.

[20] H. Laurenon, A. Marafioti, V. Sanh y L. Tronchon, Building and better understanding visual language models: insights and future directions, 2024.

[21] B. Li, R. Wang, G. Wang, Y. Ge, Y. Ge, and Y. Shan. SEED-Bench: benchmarking multimodal LLMs using generative understanding. arXiv preprint arXiv:2307.16125, 2023.

[22] D. Li, A. Kamko, E. Akhgari, A. Sabet, L. Xu y S. Doshi. Parque infantil v2.5: Three-point insights for enhancing the aesthetic quality of text-generated image generation. arXiv preprint arXiv:2402.17245, 2024.

[23] Y. Li, Y. Du, K. Zhou, J. Wang, W. X. Zhao, y J.-R. Wen. Evaluating object illusions in large-scale visual language models. arXiv preprint arXiv:2305.10355, 2023.

[24] Z. Li, H. Li, Y. Shi, A. B. Farimani, Y. Kluger, L. Yang y P. Wang. double diffusion for unified image generation and understanding. arXiv preprint arXiv:2501.00289, 2024.

[25] Z. Li, J. Zhang, Q. Lin, J. Xiong, Y. Long, X. Deng, Y. Zhang, X. Liu, M. Huang, Z. Xiao, et al. Hunyuan-DiT: a powerful multi-resolution diffusion transformer with fine Chinese understanding. arXiv preprint arXiv:2405.08748, 2024.

[26] H. Liu, C. Li, Y. Li, and Y. J. Lee. Improved fine-tuning baselines for visual commands. En Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, páginas 26296-26306, 2024.

[27] H. Liu, C. Li, Q. Wu y Y. J. Lee. visual command fine-tuning. Advances in Neural Information Processing Systems, 36, 2024.

[28] H. Liu, W. Yan, M. Zaharia y P. Abbeel. world model on million-length videos and languages using ring attention. arXiv preprint arXiv:2402.08268, 2024.

[29] Y. Liu, H. Duan, Y. Zhang, B. Li, S. Zhang, W. Zhao, Y. Yuan, J. Wang, C. He, Z. Liu, et al. MMBench: is your multimodal model an all-rounder? arXiv preprint arXiv:2307.06281, 2023.

[30] Y. Ma, X. Liu, X. Chen, W. Liu, C. Wu, Z. Wu, Z. Pan, Z. Xie, H. Zhang, X. yu, L. Zhao, Y. Wang, J. Liu y C. Ruan. Janusflow: reconciling autoregressive and corrective flows for unified multimodal understanding and generation, 2024.

[31] mehdidc. yfcc-huggingface. https://huggingface.co/datasets/mehdidc/yfcc15 m, 2024.

[32] D. Podell, Z. English, K. Lacey, A. Blattmann, T. Dockhorn, J. Mller, J. Penna y R. Rombach. sdxl: improving potential diffusion models for high-resolution image synthesis. arXiv preprint arXiv:2307.01952,. 2023.

[33] D. Podell, Z. English, K. Lacey, A. Blattmann, T. Dockhorn, J. Mller, J. Penna y R. Rombach. sdxl: improving potential diffusion models for high resolution image synthesis. 2024.

[34] L. Qu, H. Zhang, Y. Liu, X. Wang, Y. Jiang, Y. Gao, H. Ye, D. K. Du, Z. Yuan y X. Wu. Tokenflow: a unified image tagger for multimodal understanding and generation. arXiv preprint arXiv:2412.03069, 2024.

[35] A. Ramesh, P. Dhariwal, A. Nichol, C. Chu y M. Chen. hierarchical text-conditional image generation using CLIP latent values. arXiv preprint arXiv:2204.06125, 1(2):3, 2022.

[36] R. Rombach, A. Blattmann, D. Lorenz, P. Esser y B. Ommer. Síntesis de imágenes de alta resolución mediante un modelo de difusión latente. 2022.

[37] R. Rombach, A. Blattmann, D. Lorenz, P. Esser y B. Ommer, High-resolution image synthesis using latent diffusion models. En Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, páginas 10684-10695, 2022.

[38] P. Sun, Y. Jiang, S. Chen, S. Zhang, B. Peng, P. Luo y Z. Yuan. Autoregressive models beat diffusion: the LLama for scalable image generation. arXiv preprint arXiv:2406.06525, 2024.

[39] Q. Sun, Q. Yu, Y. Cui, F. Zhang, X. Zhang, Y. Wang, H. Gao, J. Liu, T. Huang y X. Wang. multimodal generative pretraining. arXiv preprint arXiv:2307.05222, 2023.

[40] C. Team. Chameleon: A basic model for early fusion of mixed modes. arXiv preprint arXiv:2405.09818, 2024.

[41] G. Team, R. Anil, S. Borgeaud, Y. Wu, J.-B. Alayrac, J. Yu, R. Soricut, J. Schalkwyk, A. M. Dai, A. Hauth, et al. Géminisa family of capable multimodal models. arXiv preprint arXiv:2312.11805, 2023.

[42] S. Tong, D. Fan, J. Zhu, Y. Xiong, X. Chen, K. Sinha, M. Rabbat, Y. LeCun, S. Xie y Z. Liu. Metamorph: multimodal understanding and generation through instruction fine-tuning. arXiv preprint arXiv:2412.14164,. 2024.

[43] Vivym. A mitad de camino Prompt dataset. https://huggingface.co/datasets/vivym/midjourney-prompts, 2023. Fecha de la visita: [inserte la fecha de la visita, por ejemplo 2023-10-15].

[44] C. Wang, G. Lu, J. Yang, R. Huang, J. Han, L. Hou, W. Zhang y H. Xu. Illume: illuminating your LLMs to see, draw, and self-enhance. arXiv preprint arXiv:2412.06673, 2024.

[45] X. Wang, X. Zhang, Z. Luo, Q. Sun, Y. Cui, J. Wang, F. Zhang, Y. Wang, Z. Li, Q. Yu, et al. Emu3: the next tag prediction is all you need. arXiv preprint arXiv:2409.18869, 2024.

[46] C. Wu, X. Chen, Z. Wu, Y. Ma, X. Liu, Z. Pan, W. Liu, Z. Xie, X. Yu, C. Ruan, et al. Janus: decoupling visual coding for unified multimodal understanding and generation. arXiv preprint arXiv:2410.13848, 2024.

[47] S. Wu, H. Fei, L. Qu, W. Ji y T.-S. Chua. next-gpt: any-to-any multimodal LLM. arXiv preprint arXiv:2309.05519, 2023.

[48] Y. Wu, Z. Zhang, J. Chen, H. Tang, D. Li, Y. Fang, L. Zhu, E. Xie, H. Yin, L. Yi, et al. VILA-U: a foundational model for integrating visual understanding and generation. arXiv preprint arXiv:2409.04429, 2024.

[49] Z. Wu, X. Chen, Z. Pan, X. Liu, W. Liu, D. Dai, H. Gao, Y. Ma, C. Wu, B. Wang, et al. DeepSeek-VL2: hybrid expert visual language model for advanced multimodal understanding. arXiv preprint arXiv:2412.10302, 2024.

[50] J. Xie, W. Mao, Z. Bai, D. J. Zhang, W. Wang, K. Q. Lin, Y. Gu, Z. Chen, Z. Yang y M. Z. Shou. show-o: a single converter for unified multimodal understanding and generation. arXiv preprint arXiv:2408.12528,. 2024.

[51] W. Yu, Z. Yang, L. Li, J. Wang, K. Lin, Z. Liu, X. Wang y L. Wang. MM-Vet: assessing the integrative power of large multimodal models. arXiv preprint arXiv:2308.02490, 2023.

[52] X. Yue, Y. Ni, K. Zhang, T. Zheng, R. Liu, G. Zhang, S. Stevens, D. Jiang, W. Ren, Y. Sun, et al. MMMU: A large-scale multidisciplinary multimodal understanding and inference benchmark for expert AGI. in Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, pages 9556-9567, 2024.

[53] X. Zhai, B. Mustafa, A. Kolesnikov y L. Beyer. sigmoid loss for language image pretraining. En Proceedings of the IEEE/CVF International Conference on Computer Vision, páginas 11975-11986, 2023.

[54] C. Zhao, Y. Song, W. Wang, H. Feng, E. Ding, Y. Sun, X. Xiao y J. Wang. Monoformer: a single converter for diffusion and autoregression. arXiv preprint arXiv:2409.16280, 2024.

[55] C. Zhou, L. Yu, A. Babu, K. Tirumala, M. Yasunaga, L. Shamis, J. Kahn, X. Ma, L. Zettlemoyer y O. Levy. Transfusion: predicting the next labelled and diffused image using a multimodal model. arXiv Preprint. arXiv:2408.11039, 2024.

[56] Y. Zhu, M. Zhu, N. Liu, Z. Ou, X. Mou y J. Tang. lLAVA-Phi: Efficient multimodal assistant with small language models. arXiv preprint arXiv:2401.02330, 2024.[57] L. Zhuo, R. Du, H. Xiao, Y. Li, D. Liu, R. Huang, W. Liu, L. Zhao, F.-Y. Wang, Z. Ma, et al. Lumina-Next: making Lumina-T2X more powerful and faster with Next-DiT. arXiv preprint arXiv:2406.18583, 2024.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...