Debate DeepSeek: liderazgo chino en costes, costes reales de formación e impacto en los beneficios de los modelos de código cerrado

Palabras clave: picos de precios del h100, precios inferidos subvencionados, controles a la exportación, MLAs

La narrativa de DeepSeek arrasa en todo el mundo

DeepSeek Tomando el mundo por asalto. Desde hace una semana, DeepSeek es el único tema del que todo el mundo quiere hablar. Actualmente, DeepSeek tiene mucho más tráfico diario que Claude, Perplexity o incluso Gemini.

Pero para quienes siguen de cerca este campo, no se trata exactamente de una noticia "nueva". Llevamos meses hablando de DeepSeek (cada enlace es un ejemplo). La empresa no es nueva, pero el bombo publicitario sí lo es, y SemiAnalysis lleva mucho tiempo argumentando que DeepSeek tiene mucho talento y que al público estadounidense en general no le importa. Cuando el mundo finalmente prestó atención, lo hizo en un frenético bombo que no reflejaba la realidad.

Nos gustaría subrayar que esta afirmación ha cambiado con respecto al mes pasado, cuando se rompieron las leyes de escalado y disipamos la idea errónea de que los algoritmos están mejorando ahora demasiado rápido, lo que en cierto modo también es malo para Nvidia y las GPU.

Antecedentes: 11 de diciembre de 2024 Leyes de ampliación - Arquitectura de O1 Pro, infraestructura de formación de inferencias, Orion y Claude 3,5 Opus "fallos"

La narrativa ahora es que DeepSeek es tan eficiente que no necesitamos más cálculos y que ahora hay una enorme sobrecapacidad en todo debido a los cambios de modelo. Aunque la paradoja de Jevons también está sobrevalorada, Jevons está más cerca de la realidad, y estos modelos han inducido una demanda que ha tenido un impacto tangible en el precio del H100 y el H200.

DeepSeek y High-Flyer

High-Flyer es un fondo de cobertura chino y uno de los primeros en utilizar la IA en sus algoritmos de negociación. Se dieron cuenta muy pronto del potencial de la IA fuera de las finanzas y de las claves del escalado. Como resultado, han ido aumentando su suministro de GPU. Tras experimentar con modelos que utilizaban clusters de miles de GPU, High Flyer invirtió en 10.000 GPU A100 en 2021 * antes de que se impusieran restricciones a la exportación. * Esto dio sus frutos. A medida que High-Flyer mejoraba, se dieron cuenta de que había llegado el momento de escindir "DeepSeek" en mayo de 2023, con el objetivo de desarrollar más capacidades de IA de una forma más centrada. High-Flyer autofinanció la empresa, ya que en aquel momento había poco interés en la IA por parte de inversores externos, siendo la falta de un modelo de negocio la principal preocupación. En la actualidad, High-Flyer y DeepSeek comparten a menudo recursos, tanto humanos como informáticos.

DeepSeek se ha convertido en una empresa seria y colaborativa que dista mucho de ser el "negocio paralelo" que muchos medios de comunicación proclaman. Creemos que su inversión en GPU supera los 500 millones de dólares, incluso teniendo en cuenta los controles de exportación.

Fuente: SemiAnalysis, Lennart Heim.

Situación de la GPU

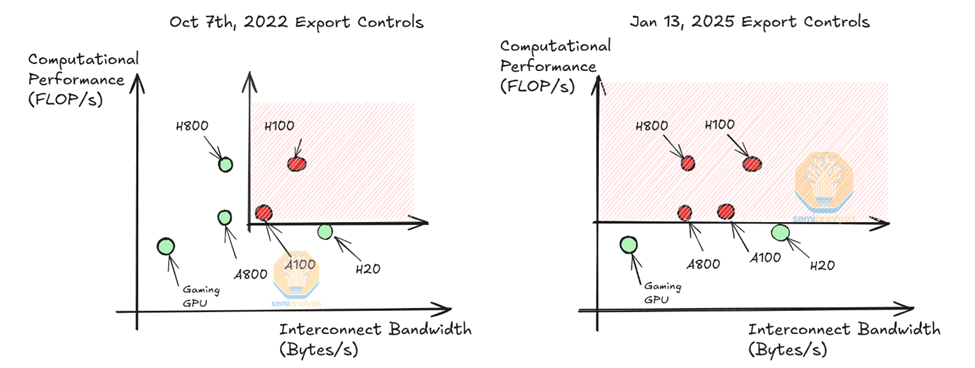

Creemos que les vendrían bien unos 50.000. Tolva GPUEsto no es lo mismo que los 50.000 H100 que algunas personas están reclamando, Nvidia hace diferentes modelos de H100 para cumplir con diferentes regulaciones (H800, H20) y actualmente sólo el H20 está disponible para los proveedores de modelos en China. Hay que tener en cuenta que el H800 tiene la misma potencia de cálculo que el H100, pero con menor ancho de banda de red.

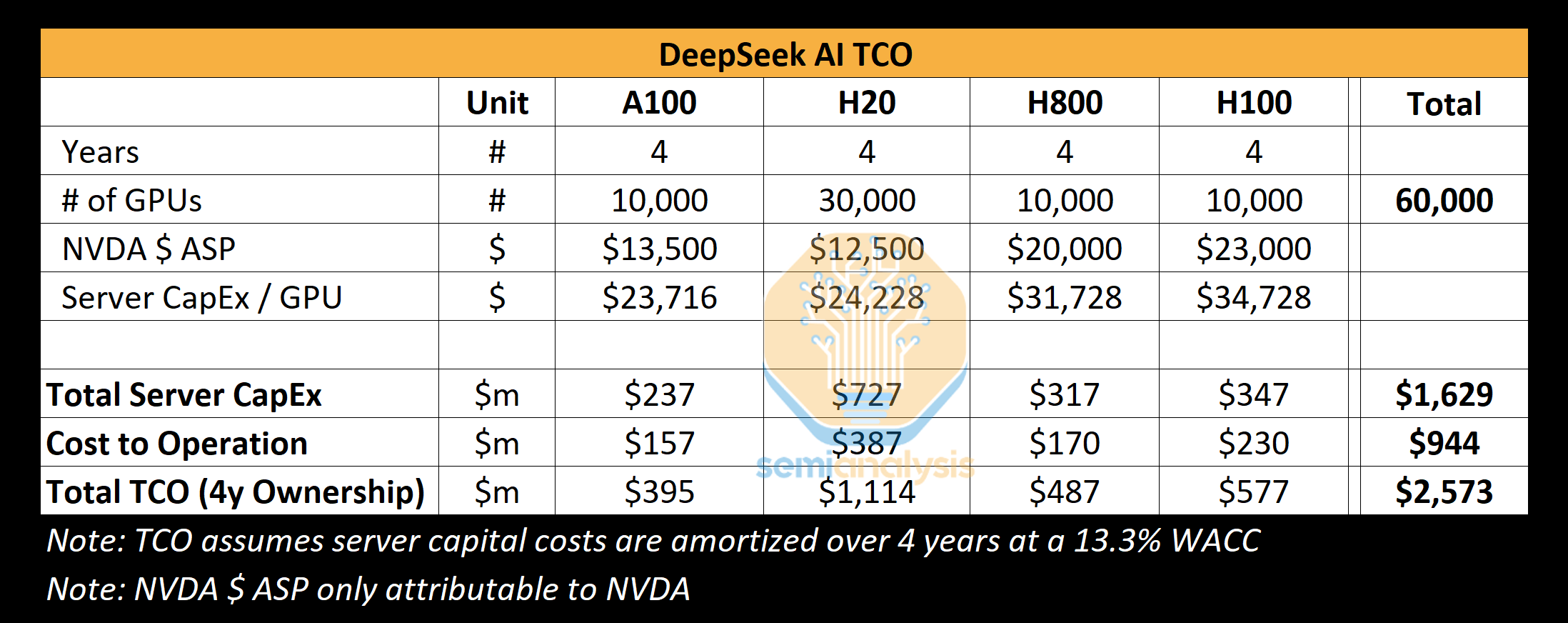

Creemos que DeepSeek podría utilizar unas 10.000 H800 y unas 10.000 H100. Además, han encargado más H20, y Nvidia ha producido más de 1 millón de GPU específicas para China en los últimos 9 meses. estas GPU se comparten entre High-Flyer y DeepSeek, y están en cierto modo geodistribuidas. Se utilizan para el comercio, la inferencia y el entrenamiento. Se utilizan para el comercio, la inferencia, la formación y la investigación. Para un análisis más específico y detallado, véase nuestro modelo de aceleradores.

Fuente: SemiAnalysis

Nuestro análisis muestra que el capex total en servidores de DeepSeek es de aproximadamente 1.600 millones de dólares, con unos costes asociados al funcionamiento de dichos clusters que ascienden a 944 millones de dólares. Del mismo modo, todos los laboratorios e hiperescaladores de IA disponen de más GPU para diversas tareas, incluidas la investigación y la formación, que las que destinan a una sola ejecución de entrenamiento, ya que la puesta en común de recursos es un reto. x.AI es un laboratorio de IA único con todas sus GPU en 1 ubicación.

DeepSeek se especializa en la búsqueda de talentos en China, independientemente de su cualificación previa, con un fuerte enfoque en la competencia y la curiosidad, y organiza regularmente eventos de reclutamiento en las mejores universidades como Pekín y Zhejiang, donde muchos de sus empleados se han graduado. Los puestos no están necesariamente predefinidos y se ofrece flexibilidad a los reclutadores, con anuncios de trabajo que incluso presumen de acceso a más de 10.000 GPU sin límite de uso. La empresa es muy competitiva y, según sus informes, ofrece sueldos superiores a 1,3 millones de dólares a los candidatos más prometedores, una cifra muy superior a la de otras grandes empresas tecnológicas chinas y laboratorios de inteligencia artificial como Moonshot.

DeepSeek carece de la burocracia de una empresa como Google y, al autofinanciarse, puede hacer avanzar las ideas con rapidez. Sin embargo, al igual que Google, DeepSeek (en su mayor parte) gestiona su propio centro de datos y no depende de partes o proveedores externos. Esto abre más espacio para la experimentación y les permite innovar en toda la pila.

Creemos que son el mejor laboratorio de "pesos abiertos" de la actualidad, superando a Meta's Llama, Mistral y otros.

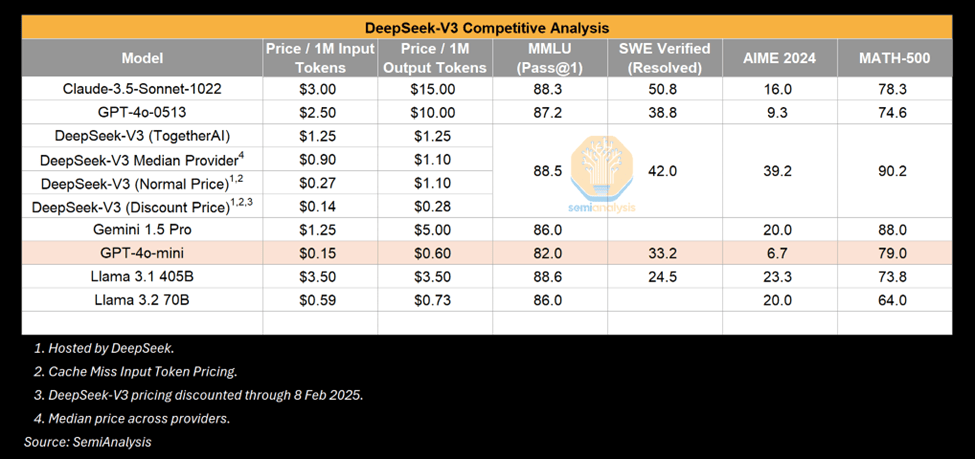

Coste y rendimiento de DeepSeek

Los precios y la eficacia de DeepSeek han provocado un frenesí esta semana, con el titular principal del coste de formación de "6 millones de dólares" de DeepSeek V3. Esto es erróneo. Es similar a señalar una parte específica de la lista de materiales de un producto y atribuirle todo el coste. Los costes de formación previa son una parte muy pequeña del coste total.

Costes de formación

Creemos que las cifras de preentrenamiento distan mucho del gasto real en el modelo. Creemos que han gastado mucho más de 500 millones de dólares en hardware a lo largo de la historia de la empresa. Para desarrollar nuevas innovaciones arquitectónicas, hay un gasto considerable en pruebas de nuevas ideas, nuevas ideas arquitectónicas y ablación durante el desarrollo del modelo. La atención latente multicabeza, una innovación clave de DeepSeek, tardó meses en desarrollarse y costó a todo el equipo mano de obra y tiempo de GPU.

El coste de 6 millones de dólares que aparece en el artículo se atribuye únicamente al coste de GPU de las ejecuciones de preentrenamiento, que es sólo una fracción del coste total del modelo. No incluye partes importantes del rompecabezas, como la I+D y el coste total de propiedad del propio hardware. Como referencia, el entrenamiento de Claude 3.5 Sonnet costó decenas de millones de dólares, y si eso fuera todo lo que Anthropic necesitaba, no estarían recaudando miles de millones de dólares de Google y decenas de miles de millones de Amazon. Esto se debe a que tienen que experimentar, idear nuevas arquitecturas, recopilar y limpiar datos, pagar a sus empleados, etc.

Entonces, ¿cómo es que DeepSeek tiene un cluster tan grande? El retraso en los controles de exportación es clave y se analizará en la sección de exportación más adelante.

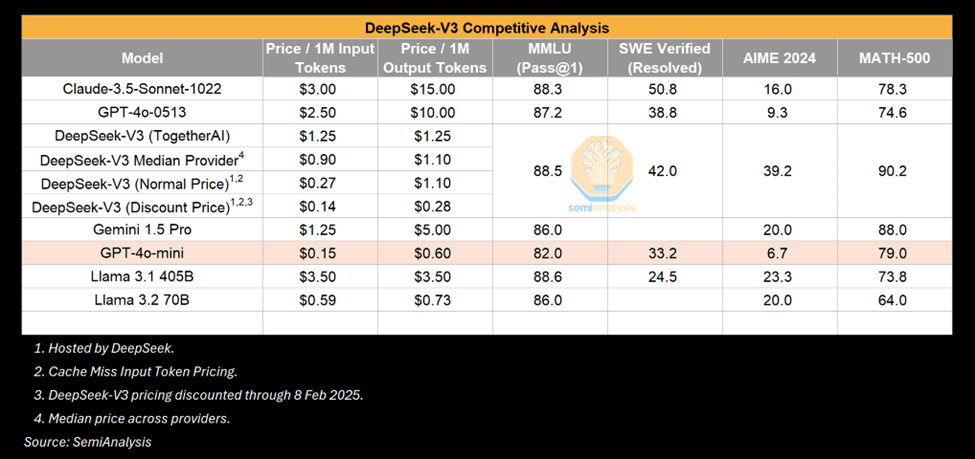

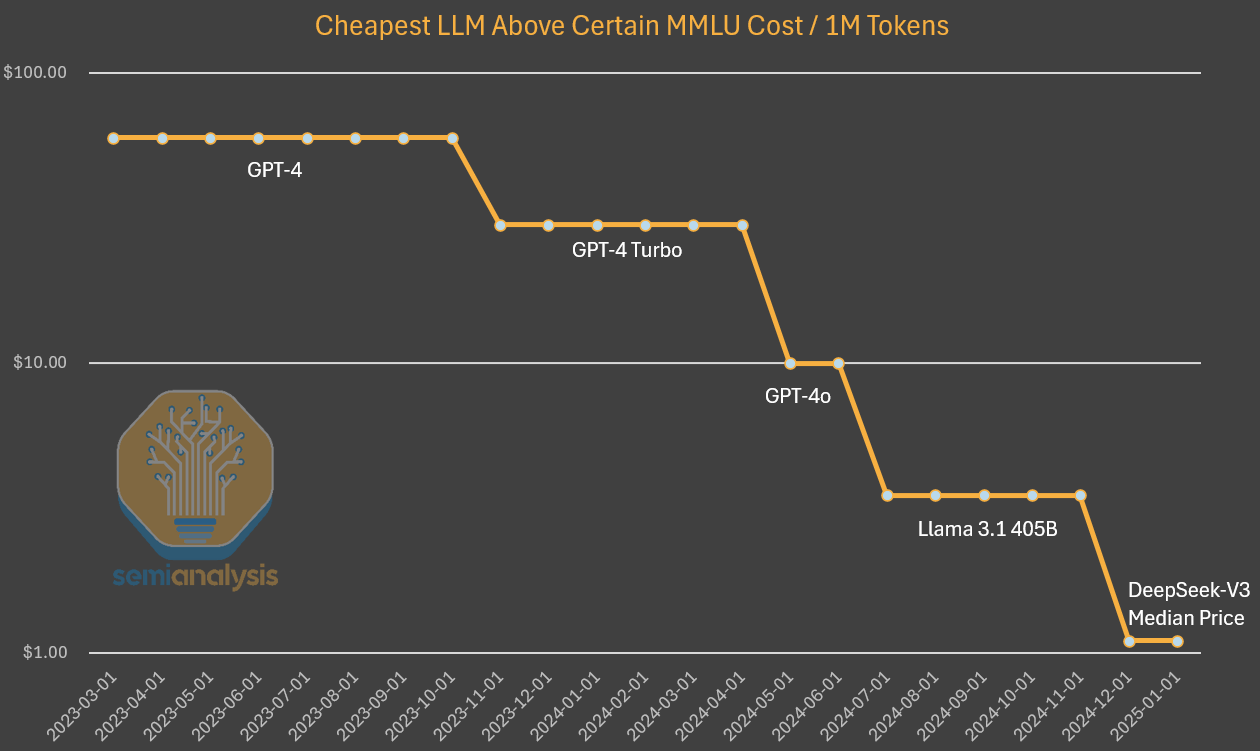

Cerrar la brecha - Rendimiento V3

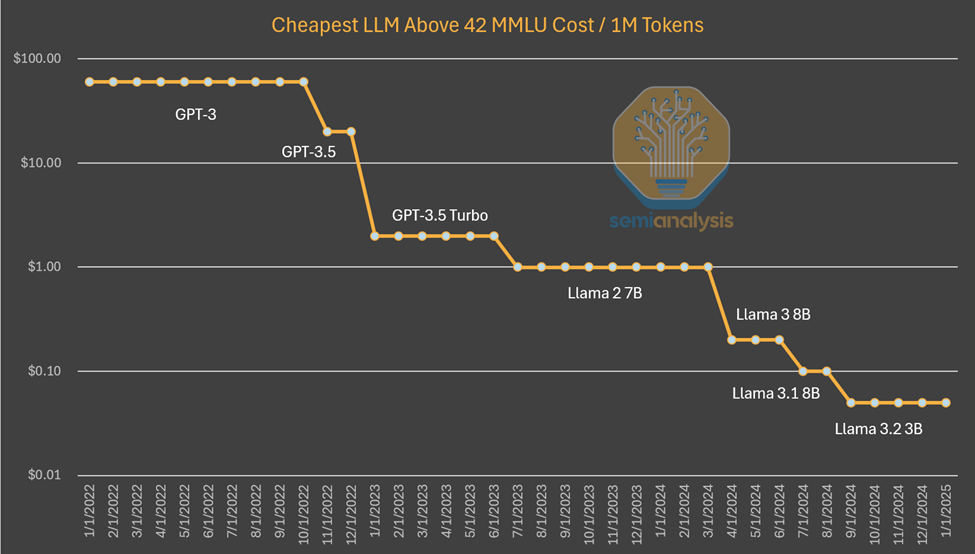

El V3 es sin duda un modelo impresionante, pero conviene subrayar que A diferencia de lo que es impresionante.Muchos han comparado el V3 con el GPT-4o. Muchos han comparado el V3 con el GPT-4o y han destacado cómo el V3 supera el rendimiento del 4o. Esto es cierto, pero el GPT-4o está en el Mayo de 2024liberada.La IA evoluciona rápidamente y mayo de 2024 será otra era en términos de mejoras algorítmicas. Además, no nos sorprende ver cómo se consigue una potencia comparable o mayor con menos cálculos al cabo de un tiempo determinado. El desplome de los costes de inferencia es un signo de mejora de la IA.

Fuente: SemiAnalysis

Un ejemplo es que los modelos pequeños que pueden ejecutarse en ordenadores portátiles tienen un rendimiento comparable al de GPT-3, que requiere un superordenador para el entrenamiento y múltiples GPU para la inferencia. En otras palabras, las mejoras algorítmicas permiten realizar menos cálculos para entrenar y razonar modelos con las mismas capacidades, y el patrón funciona una y otra vez. Esta vez el mundo se dio cuenta porque procedía del sino de un laboratorio. Pero que los modelos más pequeños mejoren no es nada nuevo.

Fuentes: SemiAnalysis, Artificialanalysis.ai, Anakin.ai, a16z

Este patrón que hemos presenciado hasta ahora es que los laboratorios de IA están gastando más dólares absolutos para conseguir más La inteligencia de Anthropic. Se estima que el progreso algorítmico es de 4 veces al año, lo que significa que cada año que pasa sólo se necesitan 4 veces menos cálculos para lograr la misma capacidad.Dario, CEO de Anthropic, cree que el progreso algorítmico es aún más rápido, lo que supone una mejora de 10 veces. En el caso del precio de la inferencia de calidad GPT-3, el coste se ha multiplicado por 1200.

Al investigar los costes de GPT-4, observamos un descenso similar de los costes, aunque más temprano en la curva. Aunque la disminución de la diferencia de costes a lo largo del tiempo puede explicarse porque ya no se mantiene constante la capacidad como en el gráfico anterior. En este caso, vemos que las mejoras y optimizaciones algorítmicas han permitido multiplicar por 10 el coste y por 10 la capacidad.

Fuentes: SemiAnalysis, OpenAI, Juntos.ai

Para ser claros, DeepSeek es único por haber alcanzado este nivel de coste y capacidad en primer lugar. Son únicos en la liberación de pesos abiertos, pero el anterior Mistral DeepSeek ha alcanzado este nivel de coste, pero no se sorprenda si el coste se reduce otras 5 veces a finales de año.

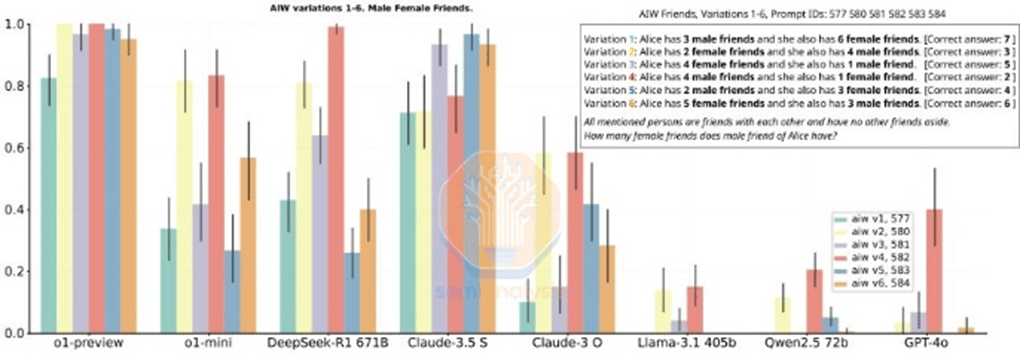

¿Es el rendimiento de R1 comparable al de o1?

Por otra parte, R1 logró resultados comparables a los de o1, que no se anunció hasta septiembre. ¿cómo pudo DeepSeek ponerse a la altura tan rápidamente?

La respuesta es que la inferencia es un nuevo paradigma con tasas de iteración más rápidas y objetivos más fáciles de alcanzar, en el que una pequeña cantidad de cálculo puede producir ganancias significativas en comparación con los paradigmas anteriores. Como se describe en nuestro informe Scaling Laws, los paradigmas anteriores se basaban en el preentrenamiento, que es cada vez más caro y difícil de conseguir.

El nuevo paradigma se centra en habilitar capacidades de inferencia mediante la generación de datos sintéticos y el aprendizaje por refuerzo en el post-entrenamiento sobre modelos existentes, lo que se traduce en ganancias más rápidas a un precio más bajo. La menor barrera de entrada, unida a unas optimizaciones sencillas, hace que DeepSeek pueda replicar el enfoque o1 más rápido de lo habitual. A medida que los participantes descubran cómo escalar más en este nuevo paradigma, esperamos que aumente la brecha temporal en las capacidades de emparejamiento.

Tenga en cuenta que el documento R1 No se menciona cálculos utilizados. Esto no es casualidad: se necesitan muchos cálculos para generar los datos sintéticos utilizados para el postentrenamiento de R1, sin incluir el aprendizaje por refuerzo. Esto no incluye el aprendizaje por refuerzo. r1 es un modelo muy bueno, eso no lo discutimos, y ponerse al día con la ventaja de la inferencia tan rápidamente es objetivamente impresionante. el hecho de que DeepSeek sea chino y se haya puesto al día con menos recursos lo hace aún más impresionante.

Pero algunos de los puntos de referencia que menciona R1 también engañosa. Comparar R1 con o1 es complicado porque R1 no menciona específicamente los puntos de referencia en los que no es líder. Aunque R1 iguala en rendimiento de inferencia, no es un claro ganador en todas las métricas, y en muchos casos es peor que o1.

Fuente: (Otra) historia de Ascenso y Caída. DeepSeek R1

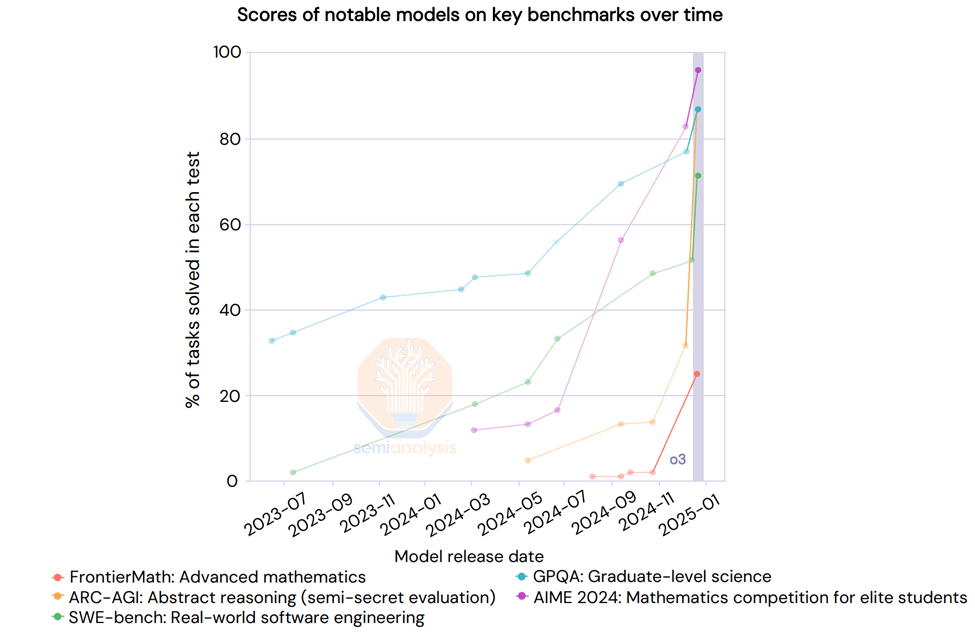

Aún no hemos mencionado o3. o3 es significativamente más capaz que R1 u o1. de hecho, OpenAI compartió recientemente resultados para o3 donde el benchmark Scaling era vertical. "El aprendizaje profundo ha chocado contra la pared", pero de una manera diferente.

Fuente: AI Action Summit

El modelo de inferencia de Google es tan bueno como el R1

Mientras se producía una oleada de frenética expectación en torno a R1, una empresa estadounidense de 2,5 billones de dólares lanzó hace un mes un modelo de inferencia más barato: Google's Géminis Flash 2.0 Pensando. el modelo está disponible y es accesible a través de la API Mucho más barato que el R1.aunque la longitud del contexto del modelo sea mayor.

Flash 2.0 Thinking supera al R1 en los puntos de referencia comunicados, aunque los puntos de referencia no cuentan toda la historia.Google sólo publicó 3 puntos de referencia, por lo que es una imagen incompleta. No obstante, creemos que el modelo de Google es sólido y puede competir con el R1 en muchos aspectos, pero no está sujeto a ninguna exageración. Esto podría deberse a la falta de estrategia de entrada en el mercado de Google y a la mala experiencia de usuario, pero el R1 también fue una sorpresa en China.

Fuente: SemiAnalysis

Para ser claros, nada de esto resta mérito a la excelencia de DeepSeek, cuya estructura como startup de rápido crecimiento, bien financiada, inteligente y centrada es tal que supera los pronósticos en términos de publicación de modelos de inferencia Meta y otros gigantes por una razón encomiable.

Logros técnicos

DeepSeek ha descifrado el código y desbloqueado innovaciones aún no realizadas por los principales laboratorios. Esperamos que todas las mejoras de DeepSeek que se publiquen sean reproducidas por los laboratorios occidentales casi de inmediato.

¿En qué consisten estas mejoras? La mayoría de los logros arquitectónicos están específicamente relacionados con la V3, que es también el modelo base de la R1. Describamos estas innovaciones con más detalle.

Formación (previa y posterior)

DeepSeek V3 aprovecha la escala sin precedentes de múltiples Ficha Predicción (MTP), se trata de módulos de atención añadidos que predicen las siguientes fichas en lugar de una sola, lo que mejora el rendimiento del modelo durante el entrenamiento y puede descartarse durante la inferencia. Se trata de un ejemplo de innovación algorítmica que consigue mejorar el rendimiento con un menor esfuerzo computacional.

Hay otras advertencias, como la precisión de FP8 en la formación, pero los principales laboratorios de EE.UU. llevan tiempo haciendo formación en FP8.

DeepSeek v3 es también un modelo experto híbrido, es decir, un gran modelo compuesto por muchos otros expertos más pequeños que se especializan en cosas diferentes, una especie de comportamiento emergente. uno de los retos a los que se enfrenta el modelo MoE es cómo determinar qué Token va a cada submodelo o "experto". DeepSeek implementa una "red cerrada" que enruta el Token al experto correcto de forma equilibrada sin afectar al rendimiento del modelo. Esto significa que el enrutamiento es muy eficiente y que cada token cambia sólo unos pocos parámetros durante el entrenamiento en relación con el tamaño total del modelo. Esto aumenta la eficacia del entrenamiento y reduce los costes de inferencia.

A pesar de la preocupación de que el aumento de la eficiencia de los expertos híbridos (ME) pueda reducir la inversión, Darío señala que la economía de los modelos de IA más potentes es tan grande que cualquier ahorro se reinvierte rápidamente en la construcción de modelos más grandes. la mejora de la eficiencia de los ME no reduce la inversión global, sino que acelera los esfuerzos de escalado de la IA. Estas empresas se centran en escalar los modelos a más cómputos y hacerlos más eficientes mediante algoritmos.

En el caso de R1, se ha beneficiado de contar con un modelo base sólido (v3), en parte gracias al aprendizaje por refuerzo (RL). Esto se debe en parte al aprendizaje por refuerzo (RL), que tiene dos objetivos principales: el formateo (para garantizar que proporciona una salida coherente) y la utilidad e inocuidad (para garantizar que el modelo es útil). La capacidad de razonamiento surge en un conjunto de datos sintéticos durante el ajuste fino del modelo. Esto.Como se describe en nuestro artículo Leyes de escaladoEsto es lo que ocurrió con o1. Obsérvese que en el artículo R1 no se menciona la computación, ya que mencionar la cantidad de computación utilizada indicaría que disponían de más GPU de lo que su narrativa da a entender. RL a esta escala requiere mucho cálculo, especialmente para generar datos sintéticos.

Además, algunos de los datos utilizados por DeepSeek parecen proceder de los modelos de OpenAI, lo que creemos que repercutirá en la estrategia de extracción de los resultados. Esto ya es ilegal en los Términos de Servicio, pero de cara al futuro, una nueva tendencia puede ser una forma de KYC (Know Your Customer) para bloquear las extracciones.

Hablando de extracción, quizá la parte más interesante del documento de R1 sea la posibilidad de afinar los minimodelos que no son de inferencia utilizando las salidas de los modelos de inferencia para transformarlos en modelos de inferencia. La gestión del conjunto de datos contiene un total de 800.000 muestras, y ahora cualquiera puede hacer sus propios conjuntos de datos utilizando las salidas de CoT de R1 y hacer modelos de inferencia con la ayuda de esas salidas. Es probable que veamos más modelos pequeños que demuestren su capacidad de inferencia, mejorando así el rendimiento de los modelos pequeños.

Atención Multinivel (AMN)

MLA es una innovación clave que ha permitido reducir significativamente el precio de inferencia de DeepSeek. La razón es que, en comparación con la atención estándar, MLA reduce la cantidad de memoria caché KV necesaria por consulta en aproximadamente 1.000 millones de euros. 93.3%La caché KV es Transformador Un mecanismo de memoria en el modelo para almacenar datos que representan el contexto de un diálogo, reduciendo así los cálculos innecesarios.

Como ya comentamos en nuestro artículo Leyes de escalado, la caché KV crece a medida que crece el contexto de diálogo y crea un límite de memoria considerable. Reducir significativamente la cantidad de caché KV necesaria por consulta reduciría la cantidad de hardware necesario por consulta, reduciendo así los costes. Sin embargo, creemos que DeepSeek está ofreciendo la inferencia a precio de coste para ganar cuota de mercado sin ganar realmente dinero. google Gemini Flash 2 Thinking sigue siendo más barato y es poco probable que Google lo ofrezca a precio de coste. el MLA, en particular, ha atraído la atención de muchos de los principales laboratorios estadounidenses. el MLA está en el mayo de 2024 El MLA está incluido en DeepSeek V2, cuyo lanzamiento está previsto para mayo de 2024. DeepSeek también disfruta de una mayor eficiencia de la carga de trabajo de inferencia con el H20 en comparación con el H100 debido al mayor ancho de banda y capacidad de memoria del H20. También anunciaron una asociación con Huawei, pero hasta ahora se ha trabajado muy poco en la computación Ascend.

Las implicaciones que nos parecen más interesantes son, sobre todo, el impacto en los márgenes y lo que esto significa para el ecosistema en su conjunto. A continuación echamos un vistazo a la futura estructura de precios en el sector de la IA y explicamos por qué creemos que DeepSeek está subvencionando los precios y por qué estamos viendo los primeros signos de la paradoja de Jevons. Comentamos las implicaciones para el control de las exportaciones, cómo podrían reaccionar las contrapartes centrales a medida que aumente el dominio de DeepSeek, etc.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...