Mistral AI lanza los modelos Codestral 25.01: más grandes, más rápidos y más potentes para programación específica

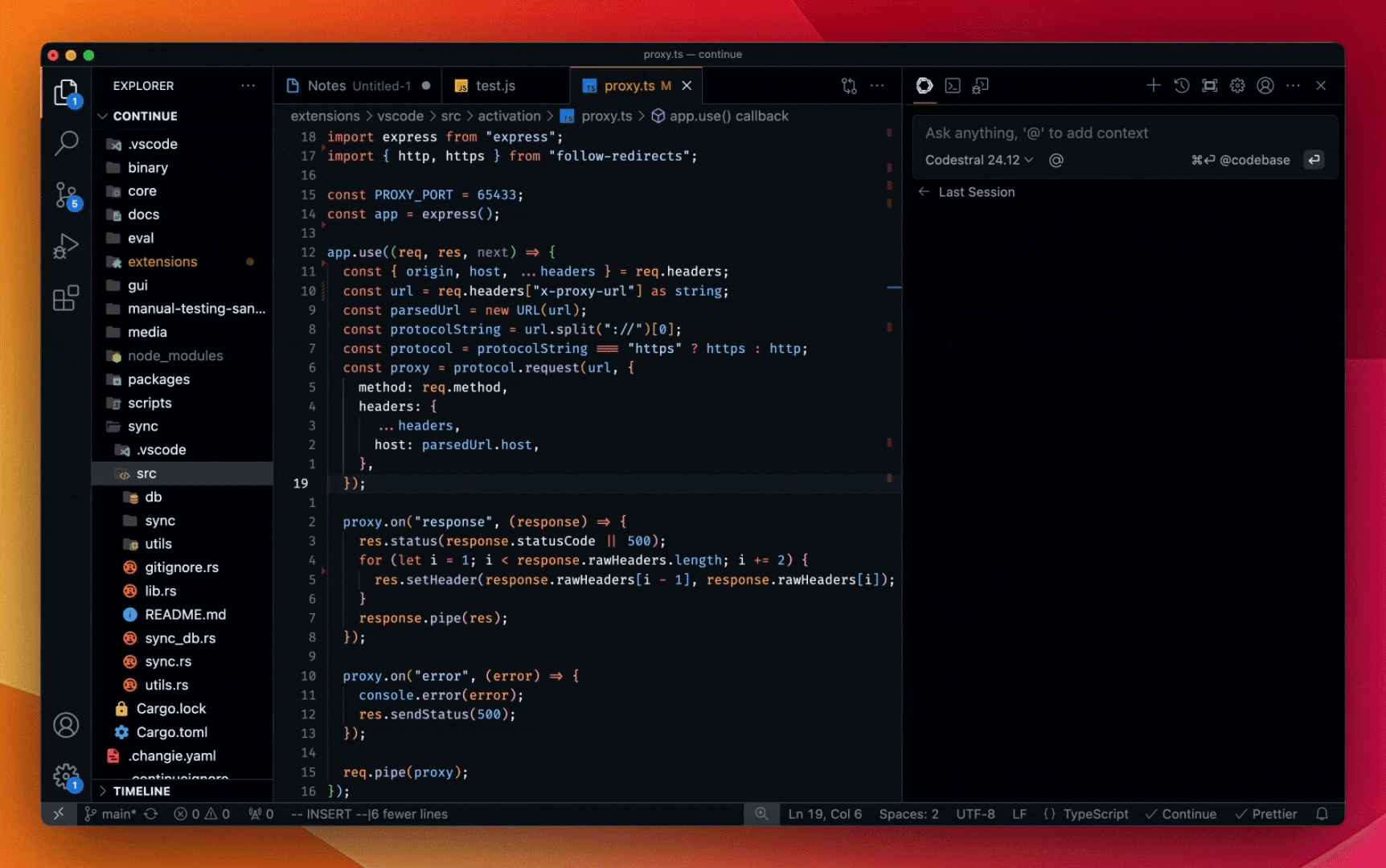

Código a la velocidad del tabulador. Hoy en Continuar y pronto estará disponible en otros asistentes de código de IA líderes.

De todas las innovaciones en IA del año pasado, la generación de código ha sido sin duda la más importante. Al igual que las cadenas de montaje simplificaron la fabricación y las calculadoras transformaron las matemáticas, los modelos de codificación representan un cambio significativo en el desarrollo de software.

Mistral AI Codestral ha estado a la vanguardia de este cambio con el lanzamiento de Codestral, un modelo de codificación (SOTA) de última generación lanzado a principios de este año. ligero, rápido y competente en más de 80 lenguajes de programación, Codestral está optimizado para casos de uso de baja latencia y alta frecuencia y admite tareas como Fill-in-the-Middle (FIM), corrección de código y generación de pruebas. codestral Codestral ha sido utilizado por miles de desarrolladores como un potente asistente de codificación, a menudo aumentando la productividad varias veces. En la actualidad, Codestral está experimentando una importante actualización.

Codestral 25.01 Con una arquitectura más eficiente y un Tokeniser mejorado que la versión original, el código se genera y se completa aproximadamente 2 veces más rápido. El modelo es ahora el líder indiscutible en la escritura de código en su clase de peso y es SOTA en todos los ámbitos en los casos de uso FIM.

evaluación comparativa

Hemos evaluado el nuevo Codestral utilizando el principal modelo de codificación con parámetros inferiores a 100B, considerado el mejor para la tarea FIM.

esbozado

| Python | SQL | Promedios multilingües | |||

|---|---|---|---|---|---|

| modelización | Longitud del contexto | HumanEval | MBPP | CruxEval | LiveCodeBench |

| Codestral-2501 | 256k | 86.6% | 80.2% | 55.5% | 37.9% |

| Codestral-2405 22B | 32k | 81.1% | 78.2% | 51.3% | 31.5% |

| Codellama 70B instruir | 4k | 67.1% | 70.8% | 47.3% | 20.0% |

| DeepSeek Codificador 33B instruir | 16k | 77.4% | 80.2% | 49.5% | 27.0% |

| DeepSeek Coder V2 lite | 128k | 83.5% | 83.2% | 49.7% | 28.1% |

Por idioma

| modelización | HumanEval Python | HumanEval C++ | HumanEval Java | HumanEval Javascript | HumanEval Bash | HumanEval Tipo de documento | HumanEval C# | HumanEval (media) |

|---|---|---|---|---|---|---|---|---|

| Codestral-2501 | 86.6% | 78.9% | 72.8% | 82.6% | 43.0% | 82.4% | 53.2% | 71.4% |

| Codestral-2405 22B | 81.1% | 68.9% | 78.5% | 71.4% | 40.5% | 74.8% | 43.7% | 65.6% |

| Codellama 70B instruir | 67.1% | 56.5% | 60.8% | 62.7% | 32.3% | 61.0% | 46.8% | 55.3% |

| Instrucción DeepSeek Coder 33B | 77.4% | 65.8% | 73.4% | 73.3% | 39.2% | 77.4% | 49.4% | 65.1% |

| DeepSeek Coder V2 lite | 83.5% | 68.3% | 65.2% | 80.8% | 34.2% | 82.4% | 46.8% | 65.9% |

FIM (coincidencia exacta de una línea)

| modelización | HumanEvalFIM Python | HumanEvalFIM Java | HumanEvalFIM JS | HumanEvalFIM (media) |

|---|---|---|---|---|

| Codestral-2501 | 80.2% | 89.6% | 87.96% | 85.89% |

| Codestral-2405 22B | 77.0% | 83.2% | 86.08% | 82.07% |

| API FIM de OpenAI*. | 80.0% | 84.8% | 86.5% | 83.7% |

| API de chat de DeepSeek | 78.8% | 89.2% | 85.78% | 84.63% |

| DeepSeek Coder V2 lite | 78.7% | 87.8% | 85.90% | 84.13% |

| Instrucción DeepSeek Coder 33B | 80.1% | 89.0% | 86.80% | 85.3% |

Pase FIM@1.

| modelización | HumanEvalFIM Python | HumanEvalFIM Java | HumanEvalFIM JS | HumanEvalFIM (media) |

|---|---|---|---|---|

| Codestral-2501 | 92.5% | 97.1% | 96.1% | 95.3% |

| Codestral-2405 22B | 90.2% | 90.1% | 95.0% | 91.8% |

| API FIM de OpenAI*. | 91.1% | 91.8% | 95.2% | 92.7% |

| API de chat de DeepSeek | 91.7% | 96.1% | 95.3% | 94.4% |

- GPT 3.5 Turbo es la última API FIM de OpenAI.

Disponible a partir de hoy

Codestral 25.01 se está desplegando a los desarrolladores de todo el mundo a través de nuestros socios IDE / IDE plugin. Usted puede sentir la diferencia en la calidad de respuesta y la velocidad de finalización de código seleccionando Codestral 25.01 en su respectivo selector de modelo.

Para casos de uso empresarial, especialmente los que requieren residencia de datos y modelos, Codestral 25.01 puede desplegarse localmente en sus instalaciones o dentro de una VPC.

Echa un vistazo a la demostración a continuación, y añadir el Continúe en de prueba gratuita en VS Code o JetBrains.

* :: Codestral 25.01 chat demo

Ty Dunn, cofundador de Continue, ha declarado: "Para los asistentes de código de IA, la finalización de código constituye la mayor parte del trabajo, lo que requiere modelos que destaquen en Fill-in-the-Middle (FIM).Codestral 25.01 marca un avance significativo en esta área. -- un componente clave para un desarrollo de software preciso y eficaz. Por eso Codestral es el modelo de autocompletado que recomendamos a los desarrolladores".

Para crear su propia integración utilizando la API de Codestral, vaya a la Plataforma y utilizando codestral-latestLa API también está disponible en Vertex AI de Google Cloud. La API también está disponible en Vertex AI para Google Cloud, en vista previa privada en Azure AI Foundry y próximamente en Amazon Bedrock.Para obtener más información, lea Documentación de Codestral.

Codestral 25.01 in LMsyscopiloto Debutó en el número 1 de las listas de éxitos. Estamos deseando que nos cuentes tu experiencia.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...