Claude 3.7 Sonnet y Claude Code: el razonamiento de vanguardia se une a la codificación Agentic

Antrópico La empresa ha publicado hoy Claude 3.7 Sonnet ^1^ , que no sólo es el modelo más inteligente de Anthropic hasta la fecha, sino que también es el primer modelo de razonamiento híbrido del mercado. claude 3.7 Sonnet proporciona tanto respuestas casi instantáneas como un pensamiento más profundo, paso a paso, y el proceso de pensamiento está a disposición del usuario. el usuario de la API también tiene un control detallado de lo que el modelo está pensando. duración.

Claude 3.7 Sonnet muestra mejoras especialmente significativas en la codificación y el desarrollo web front-end. El modelo va acompañado de Claude Code, una herramienta de línea de comandos para la codificación agéntica, actualmente disponible en una versión preliminar de investigación limitada, que permite a los desarrolladores delegar en Claude una amplia gama de tareas de ingeniería directamente desde el terminal.

Claude 3.7 Sonnet es ahora compatible con todos los planes de Claude (incluidos Free, Pro, Team y Enterprise), así como con Anthropic API, Amazon Bedrock y Google Cloud Vertex AI. El modo Thinking extendido está disponible en todas las plataformas excepto en la versión gratuita de Claude. El modo Thinking ampliado está disponible en todas las plataformas excepto en la versión gratuita de Claude.

El precio de Claude 3.7 Sonnet sigue siendo el mismo que el de su predecesor, tanto en el modo de pensamiento estándar como en el ampliado: por millón de entradas. fichas 3 por millón de fichas de salida y 15 por millón de fichas de salida, incluidas las fichas de pensamiento.

Claude 3.7 Soneto: el razonamiento de vanguardia se vuelve práctico

Anthropic desarrolló Claude 3.7 Sonnet con una filosofía diferente a la de otros modelos de razonamiento. Al igual que los seres humanos utilizan el mismo cerebro para reaccionar con rapidez y pensar con profundidad, Anthropic cree que el razonamiento debe ser una capacidad inherentemente integrada en un modelo de vanguardia, en lugar de un modelo completamente separado. Este enfoque unificado también crea una experiencia más fluida para los usuarios.

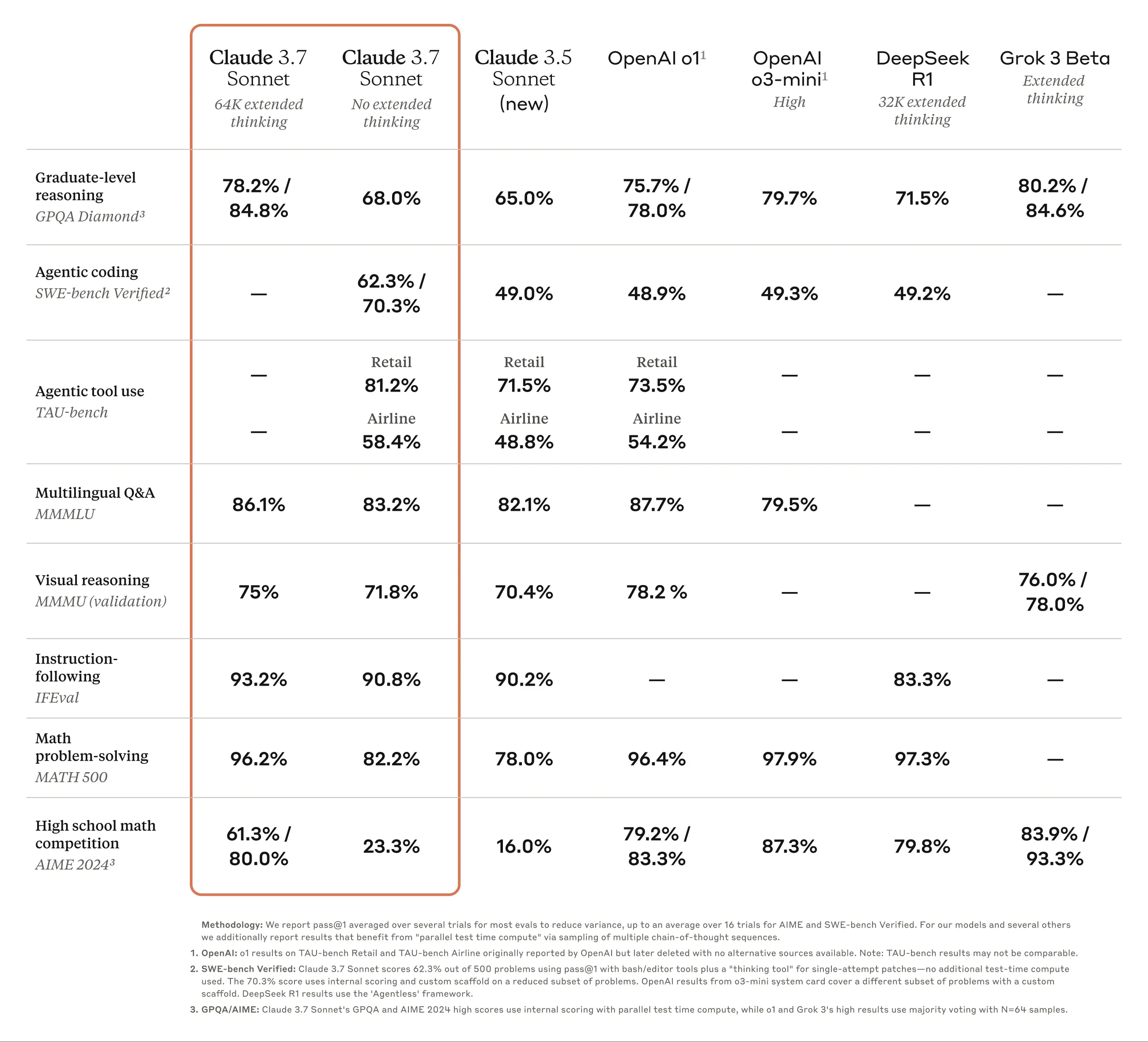

Claude 3.7 Sonnet encarna esta idea de varias maneras. En primer lugar, Claude 3.7 Sonnet combina un LLM normal con un modelo de inferencia: el usuario puede elegir cuándo el modelo responde rápidamente en modo estándar y cuándo piensa más tiempo antes de responder. En modo estándar, Claude 3.7 Sonnet es una versión mejorada de Claude 3.5 Sonnet. En el modo Extended Thinking, el modelo reflexiona sobre sí mismo antes de responder, lo que mejora su rendimiento en matemáticas, física, seguimiento de órdenes, codificación y muchas otras tareas.

En segundo lugar, cuando se utiliza Claude 3.7 Sonnet a través de la API, el usuario también tiene el control sobre el pensamiento de la presupuestoEl usuario puede decirle a Claude que piense hasta en N tokens, y el valor de N puede establecerse en un límite de salida de hasta 128K tokens. De este modo, el usuario tiene la flexibilidad necesaria para compensar la velocidad (y el coste) con la calidad de la respuesta.

En tercer lugar, durante el desarrollo del modelo de inferencia, Anthropic redujo ligeramente su atención a los temas de las competiciones de matemáticas e informática en la dirección de la optimización, y en su lugar se centró más en escenarios de aplicación del mundo real para reflejar mejor cómo utilizan realmente el LLM los usuarios empresariales.

Las primeras pruebas han demostrado que Claude es líder en todos los aspectos de la codificación: Cursor señala que Claude vuelve a ser líder en las tareas de codificación del mundo real, con mejoras significativas en áreas que van desde el trabajo con bases de código complejas hasta la creación de herramientas avanzadas, y Cognition considera que Claude supera a cualquier otro modelo cuando se trata de planificar cambios de código y gestionar actualizaciones de pila completa. Vercel destaca la precisión superior de Claude en flujos de trabajo de agentes complejos, mientras que el Replit Tras implantar con éxito Claude para crear aplicaciones web complejas y cuadros de mando desde cero, algo difícil de conseguir con otros modelos, la evaluación de Canva demostró que Claude produce sistemáticamente código listo para producción que no sólo está mejor diseñado, sino que también reduce drásticamente los errores.

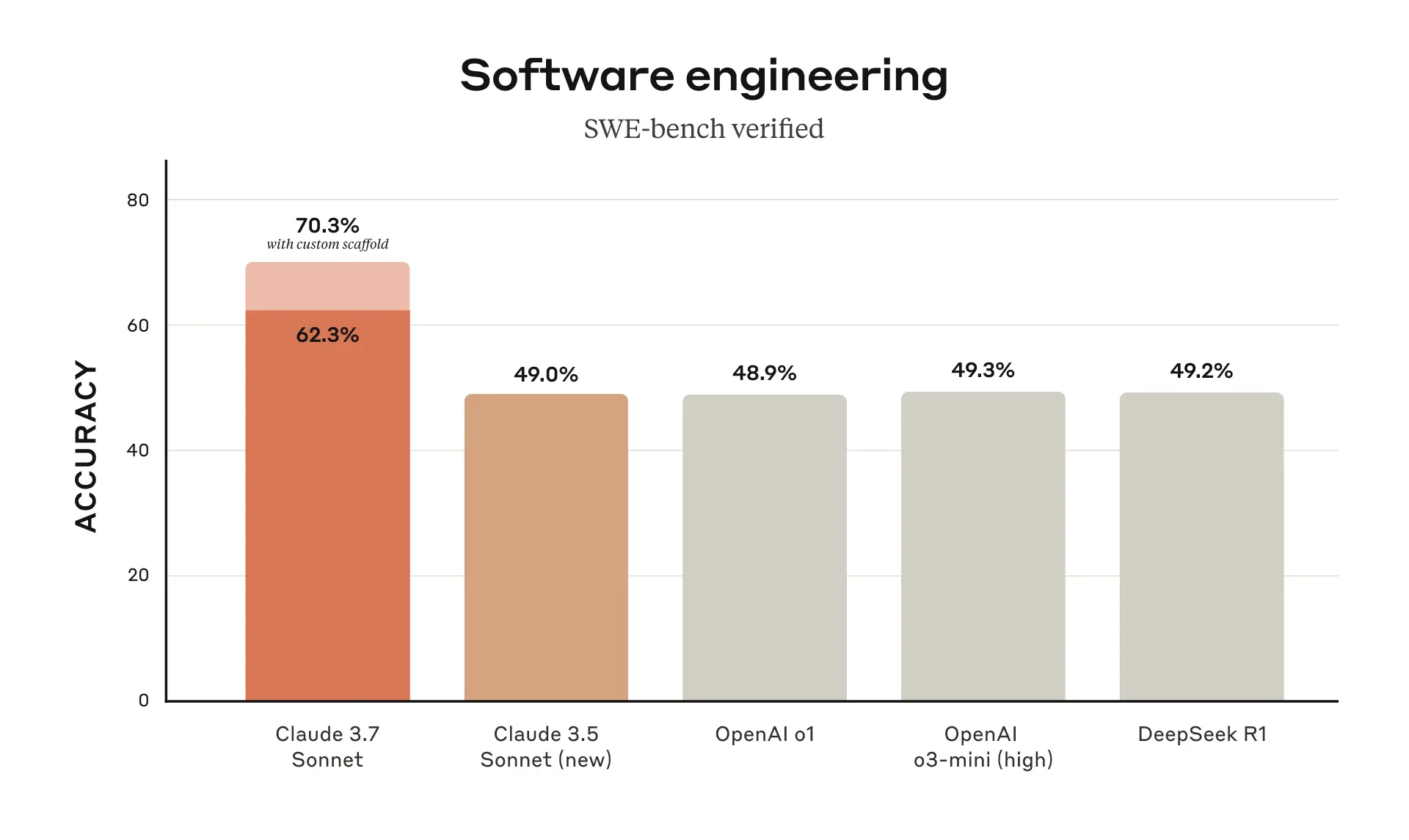

Claude 3.7 Sonnet obtuvo el mejor rendimiento en SWE-bench Verified, una prueba que mide la capacidad de los modelos de IA para resolver problemas reales de software. Para más información sobre el andamiaje, véase el Apéndice.

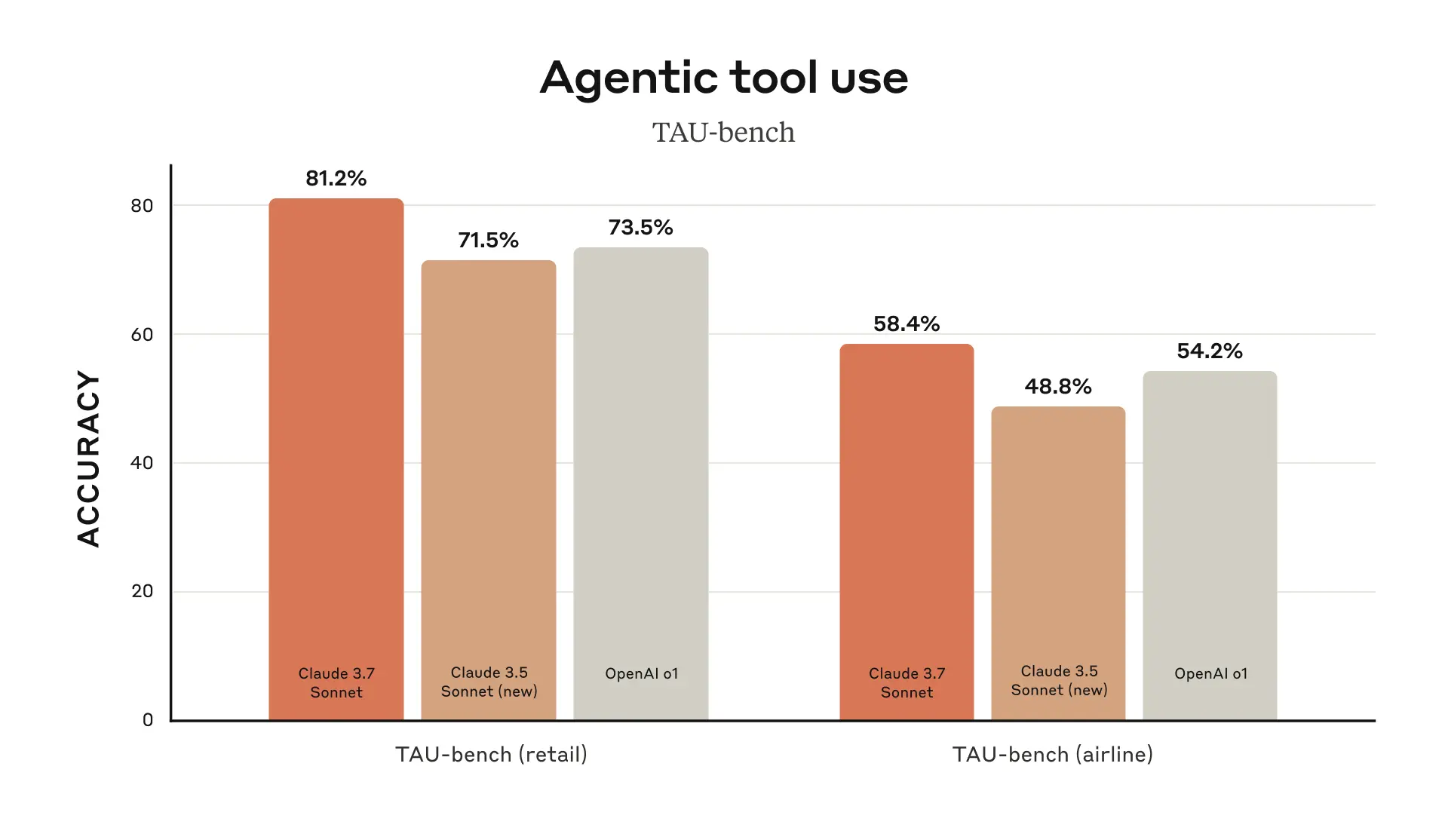

Claude 3.7 Sonnet obtuvo el mejor rendimiento en TAU-bench, un marco para probar el rendimiento de los agentes de IA en tareas complejas del mundo real que implican interacciones entre usuarios y herramientas. Para más información sobre el andamiaje, véase el Apéndice.

Claude 3.7 Sonnet destaca en el seguimiento de instrucciones, el razonamiento generalizado, las capacidades multimodales y la codificación agéntica, y el modo de pensamiento ampliado mejora significativamente su rendimiento en matemáticas y ciencias. Además de las pruebas de referencia tradicionales, Claude 3.7 Sonnet supera incluso a todos los modelos anteriores en las pruebas del juego Pokémon.

Claude Code: un nuevo asistente para desarrolladores

Desde junio de 2024, Sonnet ha sido el modelo elegido por los desarrolladores de todo el mundo. Ahora, Anthropic está disponible en una versión preliminar de investigación limitada Código Claude -- La primera herramienta de codificación agéntica de Anthropic para potenciar aún más a los desarrolladores.

Claude Code es un colaborador activo que busca y lee código, edita archivos, escribe y ejecuta pruebas, confirma código y lo envía a GitHub, y utiliza herramientas de línea de comandos, manteniendo a los usuarios informados en cada paso.

Claude Code está aún en sus primeras fases, pero se ha convertido en una herramienta indispensable para el equipo de Anthropic, especialmente para el desarrollo basado en pruebas, la depuración de problemas complejos y la refactorización a gran escala. En las primeras pruebas, Claude Code fue capaz de realizar en una sola operación tareas que normalmente llevarían más de 45 minutos de forma manual, reduciendo significativamente el tiempo de desarrollo y los costes administrativos.

En las próximas semanas, Anthropic planea realizar mejoras continuas basadas en el uso de los usuarios, incluida la mejora de la fiabilidad de la llamada a la herramienta, la adición de soporte para comandos de larga duración, la mejora de la renderización en la aplicación y la mejora de la propia comprensión de Claude de sus capacidades.

El objetivo de Anthropic al lanzar Claude Code es comprender mejor cómo los desarrolladores codifican con Claude para informar sobre futuras mejoras del modelo. Al unirse a esta vista previa, los usuarios tendrán acceso a las mismas potentes herramientas que Anthropic utiliza para construir y mejorar Claude, y los comentarios de los usuarios influirán directamente en su desarrollo futuro.

Trabajar con Claude en el código base

Anthropic también ha mejorado la experiencia de codificación en Claude.ai, y la integración de GitHub de Anthropic ya está disponible en todos los planes de Claude, lo que permite a los desarrolladores conectar sus repositorios de código directamente a Claude.

Claude 3.7 Sonnet es el mejor modelo de codificación de Anthropic hasta la fecha. Con un conocimiento más profundo de los proyectos personales, de trabajo y de código abierto de los usuarios, se convierte en un socio aún más fuerte para corregir errores, desarrollar nuevas funciones y crear documentación para los proyectos más importantes de GitHub.

Construcción responsable

Anthropic realizó pruebas y evaluaciones exhaustivas de Claude 3.7 Sonnet y colaboró con expertos externos para garantizar que cumplía las normas de Anthropic en materia de seguridad, fiabilidad y protección. Claude 3.7 Sonnet también distingue mejor que su predecesor entre las solicitudes dañinas y las benignas, con 45% menos rechazos innecesarios.

Esta versión de la tarjeta del sistema cubre los últimos hallazgos en materia de seguridad en múltiples categorías, detallando la evaluación de la Política de Extensión Responsable de Anthropic, que otros laboratorios e investigadores de IA pueden aplicar a su propio trabajo. La tarjeta del sistema también explora los riesgos emergentes que plantea el uso de ordenadores, en concreto los ataques de inyección puntual, y explica cómo Anthropic evalúa estas vulnerabilidades y forma a Claude para resistirlas y mitigarlas. Además, la ficha del sistema examina las posibles ventajas para la seguridad que pueden aportar los modelos de inferencia: la capacidad de comprender cómo los modelos toman decisiones y si la inferencia de modelos es realmente digna de confianza y fiable. Para más información, lea la ficha completa del sistema.

mirando hacia delante

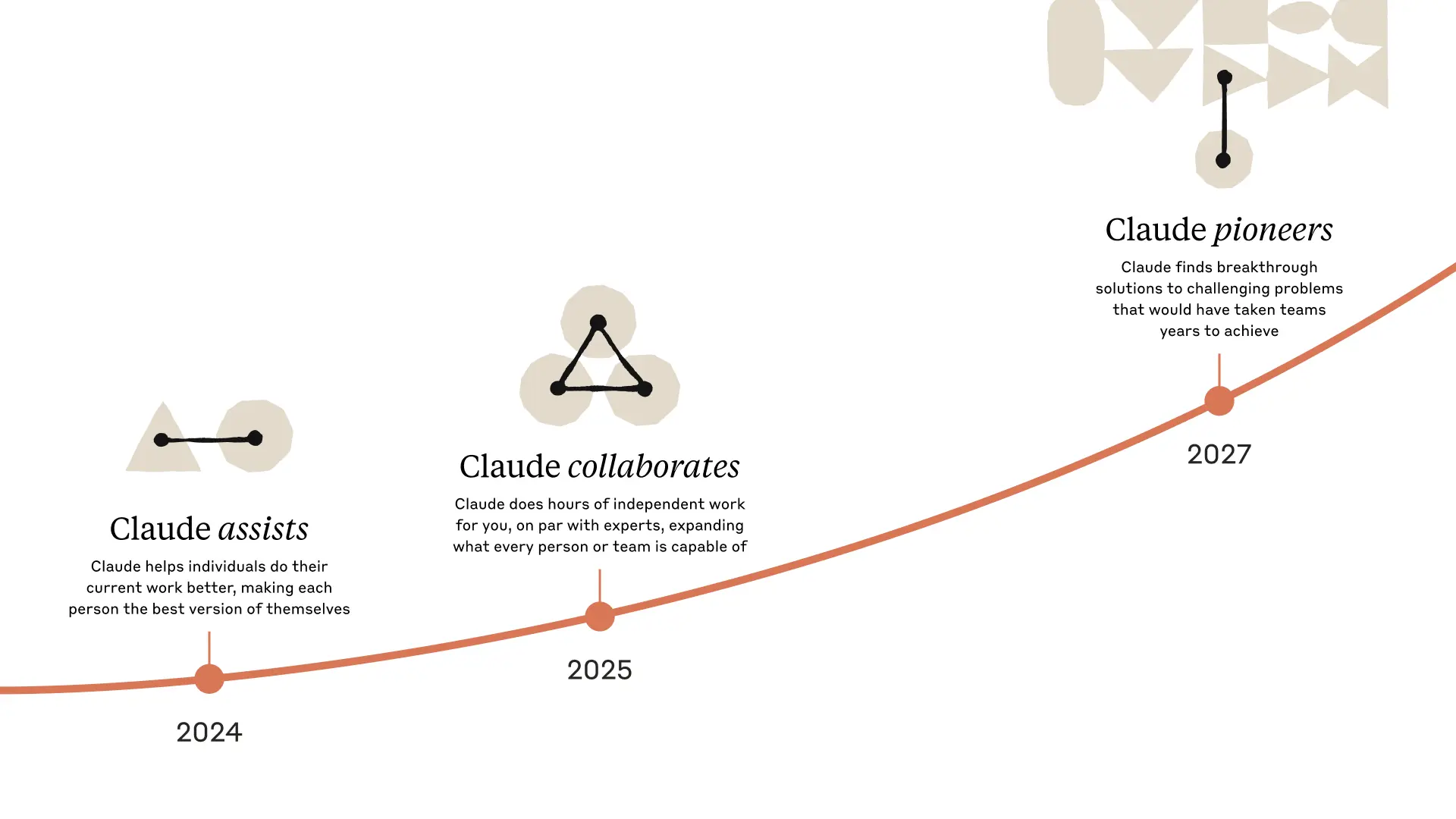

El lanzamiento de Claude 3.7 Sonnet y Claude Code supone un paso importante hacia la potenciación de los sistemas de IA. Con su capacidad para razonar en profundidad, trabajar de forma autónoma y colaborar eficazmente, nos conducen a un futuro en el que la IA puede enriquecer y ampliar los logros humanos.

Anthropic está encantado de que los usuarios exploren estas nuevas funciones y está deseando ver lo que crearán.Anthropic siempre agradece [feedback](mailto: feedback@anthropic.com) de los usuarios para que Anthropic pueda seguir mejorando y desarrollando los modelos de Anthropic.

apéndice

^1 ^ Lecciones sobre cómo nombrar.

Evaluación de las fuentes de datos

- Grok

- Géminis 2 Pro

- o1 y o3-mini

- Suplemento o1

- o1 TAU-bench

- Suplemento o3-mini

- Búsqueda profunda R1

Banco TAU

Información sobre andamios

Estas puntuaciones se obtuvieron añadiendo un apéndice a la Política de Agente de Aerolíneas que indicaba a Claude que utilizara mejor la herramienta de "planificación". En este modo, Anthropic anima al modelo a escribir su proceso de pensamiento durante múltiples rondas de interacción en la resolución de problemas para utilizar plenamente sus habilidades de razonamiento, lo que supone una desviación del modo de pensamiento habitual de Anthropic. Para acomodar el consumo adicional de fichas de Claude debido al uso de más pasos de pensamiento, Anthropic aumentó el número máximo de pasos (en términos de finalización del modelo) de 30 a 100 (la mayoría de las interacciones se completaron en 30 pasos, y sólo una interacción superó los 50 pasos).

Además, las puntuaciones TAU-bench de Claude 3.5 Sonnet (nuevo) difieren de las comunicadas por Anthropic en el momento de la publicación original debido a algunas pequeñas mejoras introducidas en el conjunto de datos desde entonces. Anthropic volvió a realizar la prueba con el conjunto de datos actualizado para compararlo con mayor precisión con Claude 3.7 Sonnet. para compararlo con mayor precisión con Claude 3.7 Sonnet.

SWE-bench Verificado

Información sobre andamios

Existen muchos enfoques para resolver tareas agenticas abiertas como SWE-bench. Algunos enfoques trasladan gran parte de la complejidad (por ejemplo, decidir qué archivos investigar o editar, y qué pruebas ejecutar) a un software más tradicional, dejando sólo el modelo de lenguaje central para generar código en ubicaciones predefinidas, o para elegir entre un conjunto más limitado de operaciones.Agentless (Xia et al., 2024) es un enfoque de la Búsqueda Profunda R1 Se trata de un marco popular utilizado habitualmente en la evaluación de Aide y otros modelos, que mejora las capacidades del agente mediante mecanismos de recuperación de documentos, localización de parches y muestreo de rechazo al mejor de 40 para pruebas de regresión. Otros andamiajes (por ejemplo, Aide) aumentan aún más el modelo con cálculos adicionales en tiempo de prueba en forma de reintentos, mejor de N o búsqueda en árbol Monte Carlo (MCTS).

Para Claude 3.7 Sonnet y Claude 3.5 Sonnet (nuevo), Anthropic utiliza un enfoque más sencillo con un andamiaje mínimo. En este enfoque, el modelo decide qué comandos ejecutar y qué archivos editar en una sola sesión.El principal resultado del pass@1 "sin pensamiento extendido" de Anthropic es simplemente equipar al modelo con dos de las herramientas descritas aquí - la utilidad - utilidad bash y una herramienta de edición de archivos que funciona mediante sustitución de cadenas-, así como la "herramienta de planificación" que Anthropic menciona en los resultados de TAU-bench. Debido a limitaciones de infraestructura, sólo 489/500 problemas pudieron resolverse realmente en la infraestructura interna de Anthropic (es decir, la solución gold superó la prueba). Para la puntuación vainilla pass@1, Anthropic contabilizó 11 problemas irresolubles como fallos para alinearlos con la clasificación oficial. En aras de la transparencia, Anthropic ha publicado por separado los casos de prueba que no funcionaron en la infraestructura de Anthropic.

Para los números de "alto cómputo", Anthropic utiliza una complejidad adicional y cálculos paralelos en tiempo de prueba, como se muestra a continuación:

- Muestras antrópicas múltiples intentos paralelos utilizando el andamiaje anterior

- Anthropic descarta los parches que corrompen las pruebas de regresión visibles en el repositorio, de forma similar al método de muestreo de rechazo utilizado por Agentless; tenga en cuenta que Anthropic no utiliza información de pruebas ocultas.

- A continuación, Anthropic clasificó los intentos restantes utilizando un modelo de puntuación similar a los resultados GPQA y AIME de Anthropic descritos en el artículo de investigación y seleccionó los mejores intentos para su presentación.

Esto arroja una puntuación de 70,3% en el subconjunto de n=489 tareas verificadas que funcionan en la infraestructura de Anthropic. Sin este andamiaje, Claude 3.7 Sonnet obtuvo una puntuación de 63,7% en SWE-bench Verified utilizando el mismo subconjunto. A continuación se enumeran los 11 casos de prueba con los que la infraestructura interna de Anthropic no es compatible:

- scikit-learn__scikit-learn-14710

- django__django-10097

- psf__solicitudes-2317

- sphinx-doc__sphinx-10435

- sphinx-doc__sphinx-7985

- sphinx-doc__sphinx-8475

- matplotlib__matplotlib-20488

- astropy__astropy-8707

- astropy__astropy-8872

- sphinx-doc__sphinx-8595

- sphinx-doc__sphinx-9711

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...