AssemblyAI: plataforma de análisis de voz a texto y audio inteligente de alta precisión

Últimos recursos sobre IAPublicado hace 1 año Círculo de intercambio de inteligencia artificial 63.9K 00

Introducción general

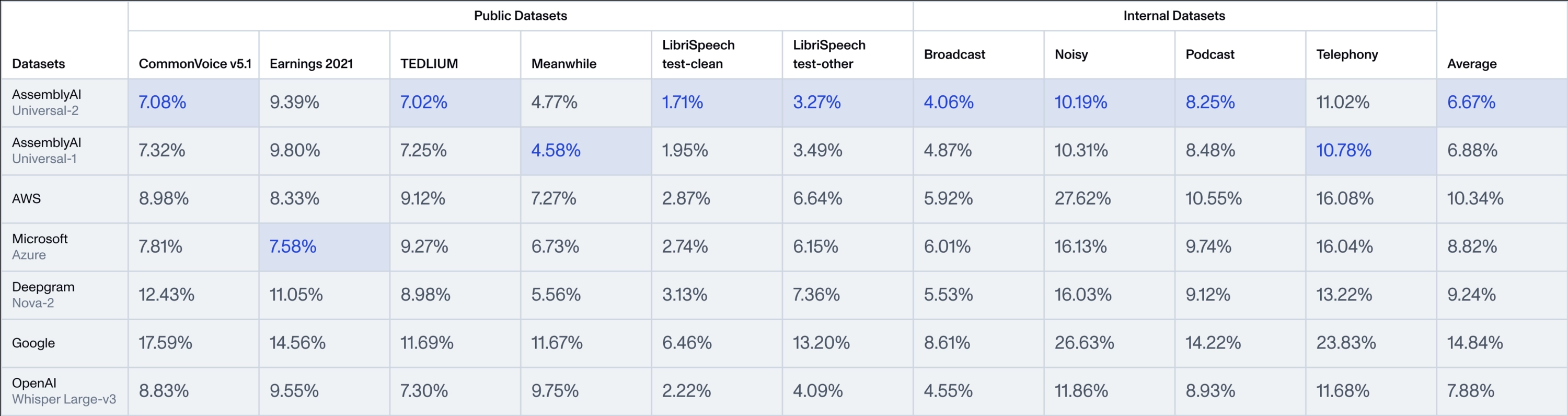

AssemblyAI es una plataforma centrada en la tecnología de IA del habla, que proporciona a desarrolladores y empresas eficaces herramientas de análisis de voz a texto y audio. Lo más destacado es la serie de modelos Universal, especialmente el recién lanzado Universal-2, que es el modelo de voz a texto más avanzado de AssemblyAI hasta la fecha. universal-2 se basa en Universal-1, con más de 12,5 millones de horas de datos de entrenamiento de audio multilingüe, y es capaz de capturar con precisión la complejidad de las conversaciones reales y proporcionar datos de audio de alta precisión. Universal-2 se basa en Universal-1, con más de 12,5 millones de horas de datos de entrenamiento de audio multilingüe, para captar con precisión la complejidad de los diálogos reales y proporcionar datos de audio de gran exactitud. En comparación con Universal-1, Universal-2 mejora 241 TP3T en reconocimiento de nombres propios (por ejemplo, nombres, marcas), 211 TP3T en contenido mixto numérico-alfabético (por ejemplo, números de teléfono, buzones de correo) y 151 TP3T en formato de texto (por ejemplo, puntuación, mayúsculas), reduciendo significativamente la precisión de "última milla" del modelo tradicional. "AssemblyAI abre estas tecnologías de vanguardia a usuarios de todo el mundo a través de API fáciles de usar, y ha sido utilizada por Spotify, Fireflies y otras empresas para crear productos de voz inteligentes que cubren áreas como la grabación de reuniones y el análisis de contenidos.

Lista de funciones

- voz a textoConvierte archivos de audio o secuencias de audio en directo en texto de alta precisión, compatible con varios idiomas y formatos de audio.

- Detección de altavoces: Identifica automáticamente a los distintos interlocutores en el audio para escenarios de diálogo entre varias personas.

- Análisis del sentimiento: Analiza las tendencias emocionales en el habla, como positivas, negativas o neutras, para mejorar la experiencia del usuario.

- transcripción en tiempo real: Proporciona funciones de conversión de voz a texto en tiempo real de baja latencia adecuadas para agentes de voz o subtitulación en directo.

- Modelización de la inteligencia sonora: Incluye funciones avanzadas como revisión de contenidos, detección de temas, búsqueda por palabras clave, etc.

- Marco LeMUR: Procesamiento de texto transcrito mediante un modelo lingüístico a gran escala, con soporte para la generación de resúmenes, preguntas y respuestas, etc.

- Generación de subtítulos: Admite la exportación de archivos de subtítulos en formato SRT o VTT para facilitar la creación de contenidos de vídeo.

- Protección de datos personales: Identifica y bloquea automáticamente la información sensible en el audio, como nombres o números de teléfono.

Utilizar la ayuda

AssemblyAI es un servicio API basado en la nube que no requiere instalación local para utilizar sus potentes funciones. Aquí tienes una guía detallada que te ayudará a empezar y a profundizar en sus capacidades.

Registro y obtención de claves API

- Visite el sitio web oficialAbre tu navegador y escribe

https://www.assemblyai.com/Ir a la página de inicio. - Registrar una cuentaHaga clic en "Registrarse" en la esquina superior derecha e introduzca su dirección de correo electrónico y contraseña para completar el proceso de registro. Una vez registrado, accederá automáticamente al panel de control.

- Obtener la llaveClave de API: Busque el área "Clave de API" en el panel de control y haga clic en "Copiar" para copiar la clave. Esta es la única credencial para llamar a la API y debe mantenerse a salvo.

- Prueba gratuita: Crédito gratuito para nuevos usuarios, sin necesidad de vincular métodos de pago inmediatamente.

Función principal Operación

El núcleo de AssemblyAI es su integración API, y lo que sigue es un ejemplo de cómo utilizar la familia Universal de modelos en Python. También puede utilizar otros lenguajes (por ejemplo, Java, Node.js) consultando la documentación en el sitio web.

Voz a texto (Universal-2)

- preliminar: Asegúrese de que hay un archivo de audio (por ejemplo

sample.mp3) o enlace URL. - Instalación del SDK: Se ejecuta en el terminal:

pip install assemblyai

- ejemplo de código::

import assemblyai as aai

aai.settings.api_key = "你的API密钥" # 替换为你的密钥

transcriber = aai.Transcriber()

transcript = transcriber.transcribe("sample.mp3")

print(transcript.text) # 输出文本,如“今天天气很好。”

- Universal-2 Puntos fuertesPor defecto, se utiliza el modelo Universal-2, que reconoce los nombres propios (por ejemplo, "Zhang Wei") y los números formateados (por ejemplo, "6 de marzo de 2025") con mayor precisión que Universal-1, a menudo en cuestión de segundos. El tiempo de procesamiento suele ser de sólo unos segundos.

transcripción en tiempo real

- Escenarios aplicables: Transmisión en directo, teleconferencias y otras necesidades en tiempo real.

- ejemplo de código::

from assemblyai import RealtimeTranscriber import asyncio async def on_data(data): print(data.text) # 实时输出文本 transcriber = RealtimeTranscriber( api_key="你的API密钥", sample_rate=16000, on_data=on_data ) async def start(): await transcriber.connect() await transcriber.stream() # 开始接收音频流 asyncio.run(start()) - flujo de trabajoLa función de baja latencia del Universal-2 garantiza resultados rápidos y precisos.

Detección de altavoces

- Método de activación::

config = aai.TranscriptionConfig(speaker_labels=True) transcript = transcriber.transcribe("sample.mp3", config=config) for utterance in transcript.utterances: print(f"说话人 {utterance.speaker}: {utterance.text}") - Ejemplos de resultados::

说话人 A: 你好,今天会议几点? 说话人 B: 下午两点。 - llamar la atención sobre algoEl sistema Universal-2 funciona de forma más coherente en conversaciones entre varias personas y reduce la confusión.

Análisis del sentimiento

- Método de activación::

config = aai.TranscriptionConfig(sentiment_analysis=True) transcript = transcriber.transcribe("sample.mp3", config=config) for result in transcript.sentiment_analysis: print(f"文本: {result.text}, 情感: {result.sentiment}") - Ejemplos de resultados::

文本: 我很喜欢这个产品, 情感: POSITIVE 文本: 服务有点慢, 情感: NEGATIVE

Generación de subtítulos

- código operativo::

transcript = transcriber.transcribe("sample.mp3") with open("captions.srt", "w") as f: f.write(transcript.export_subtitles_srt()) - al final: Generar

.srtque puede importarse directamente a un programa de edición de vídeo.

Características: Marco LeMUR

- Función IntroducciónLeMUR: LeMUR procesa los resultados de la transcripción junto con un gran modelo lingüístico, por ejemplo, para generar resúmenes.

- procedimiento::

- Obtener una identificación de transcripción:

transcript = transcriber.transcribe("sample.mp3") transcript_id = transcript.id - Generar un resumen:

from assemblyai import Lemur lemur = Lemur(api_key="你的API密钥") summary = lemur.summarize(transcript_id) print(summary.response) - Ejemplo de salida: "En la reunión se habló de los avances del proyecto, que está previsto que finalice la semana que viene."

- Obtener una identificación de transcripción:

advertencia

- Formatos admitidosCompatible con 33 formatos de audio/vídeo como MP3, WAV, etc.

- Ajustes de idiomaMás de 99 idiomas compatibles a los que se puede acceder a través de

language_code="zh"Especifique chino. - facturación: Se factura por hora de audio, consulte el sitio web oficial para conocer los precios.

Siguiendo estos pasos, podrá aprovechar al máximo las potentes funciones de Universal-2 para crear aplicaciones de voz eficaces.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...