Snowflake lanza el modelo vectorial multilingüe Arctic Embed 2.0 para búsquedas de alta calidad en chino

Snowflake se complace en anunciar el lanzamiento de Arctic Embed L 2.0 responder cantando Arctic Embed M 2.0 Arctic Embed 2.0, que es la siguiente iteración de nuestro vanguardista modelo de incrustación, es ahora compatible con la búsqueda multilingüe. Si bien nuestras versiones anteriores han sido bien recibidas por clientes, socios y la comunidad de código abierto, y han alcanzado millones de descargas, hemos estado recibiendo una petición: ¿podéis hacer este modelo multilingüe? Arctic Embed 2.0 se basa en la sólida base de nuestras versiones anteriores, añadiendo soporte multilingüe sin sacrificar el rendimiento en inglés o la escalabilidad para satisfacer las necesidades de una comunidad de usuarios más amplia, que abarca una amplia gama de idiomas y aplicaciones. comunidad de usuarios, que abarca una amplia gama de idiomas y aplicaciones.

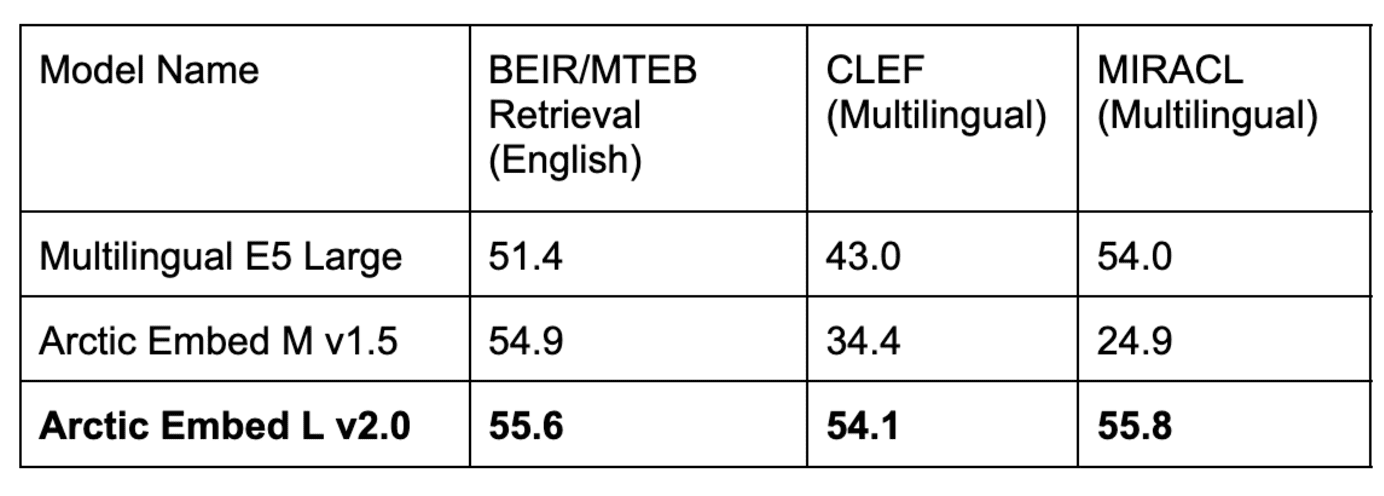

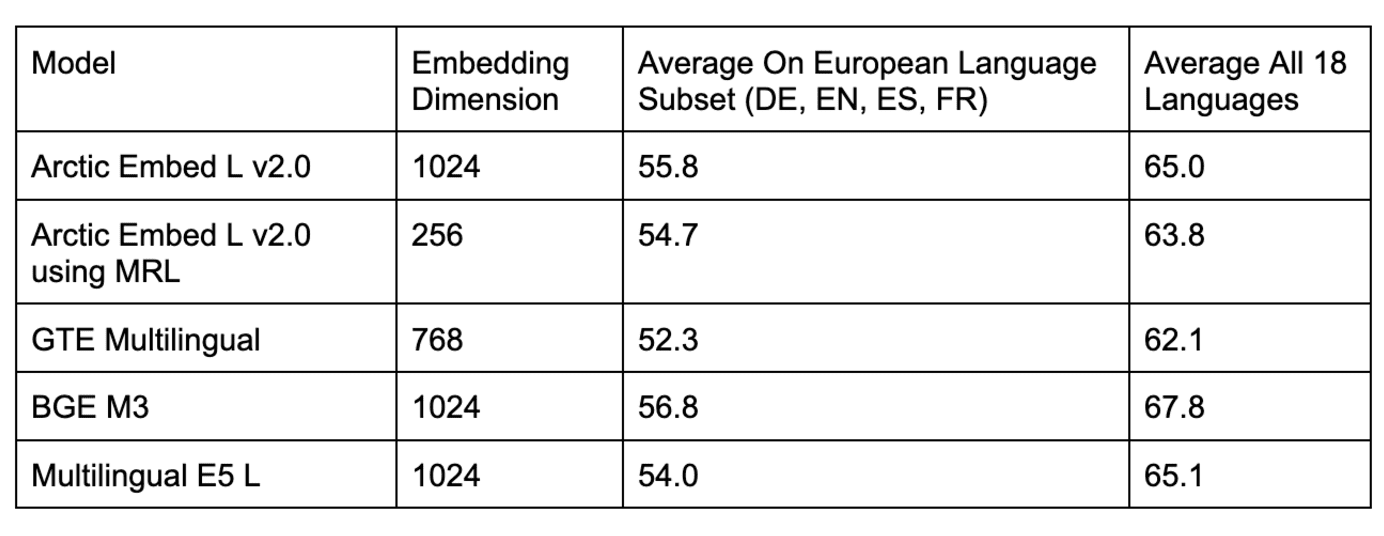

Fig. 1. Rendimiento de recuperación unidireccional intensiva en volumen de un modelo de incrustación multilingüe de código abierto con menos de 1.000 millones de parámetros. Las puntuaciones son MTEB Recuperación y la media nDCG@10 en el subconjunto CLEF (ELRA, 2006) (que abarca inglés, francés, español, italiano y alemán).

Multilingüismo sin concesiones

En esta versión 2.0 de Arctic Embed, lanzamos dos variantes disponibles, una variante media centrada en la eficacia de la inferencia, que se basa en la solución de Alibaba GTE-multilingüe Además, con 305 millones de parámetros (de los cuales 113 millones no están integrados), otra gran variante se centra en la calidad de la recuperación y se basa en la tecnología de Facebook. XMLR-Grande además de la variante de contexto largo con 568 millones de parámetros (de los cuales 303 millones son no incrustados). Ambos tamaños admiten hasta 8.192 Ficha longitud del contexto. Al crear Arctic Embed 2.0, nos dimos cuenta del problema al que se enfrentan muchos de los modelos multilingües existentes: la optimización para varios idiomas a menudo acaba sacrificando la calidad de la recuperación en inglés. Esto ha llevado a muchos modelos del sector a tener dos variantes para cada versión: inglesa y multilingüe.Los modelos Arctic Embed 2.0 son diferentes. Ofrecen el máximo rendimiento en idiomas distintos del inglés, como el alemán, el español y el francés, al tiempo que superan a sus predecesores en la recuperación en inglés. Arctic Embed M 1.5.

Al equilibrar cuidadosamente la necesidad de multilingüismo con el compromiso de Snowflake con la excelencia en la recuperación en inglés, hemos creado Arctic Embed 2.0 para que sea un modelo de trabajo universal para una amplia gama de casos de uso global. A lo largo de este documento, todas las evaluaciones cualitativas se refieren a las puntuaciones medias de NDCG@10 en todas las tareas, a menos que se indique lo contrario.

Tabla 1. Nuestro modelo Arctic Embed L v2.0 obtiene puntuaciones altas en la popular prueba de referencia inglesa MTEB Retrieval, así como una alta calidad de recuperación en varias pruebas de referencia multilingües. las iteraciones anteriores de Arctic Embed han obtenido buenos resultados en inglés, pero malos en multilingüe, mientras que los modelos multilingües de código abierto más populares han disminuido su rendimiento en inglés. El rendimiento en inglés ha disminuido. Todas las puntuaciones de modelos y conjuntos de datos reflejan la media de NDCG@10. Las puntuaciones de CLEF y MIRACL reflejan la media de alemán (DE), inglés (EN), español (ES), francés (FR) e italiano (IT).

El variado y potente conjunto de funciones de Arctic Embed 2.0

- Rendimiento y eficiencia de clase empresarial: El modelo Arctic Embed 2.0 está diseñado para satisfacer las necesidades de las grandes empresas. Incluso nuestro modelo "grande" tiene parámetros muy por debajo de mil millones y ofrece una incrustación rápida y de alto rendimiento. Según las pruebas internas, procesa fácilmente más de 100 documentos por segundo (de media) en las GPU NVIDIA A10 y alcanza menos de 10 milisegundos de latencia de incrustación de consultas, lo que permite la implantación en el mundo real con hardware asequible.

- Calidad de búsqueda sin concesiones en inglés y en otros idiomas: A pesar de su tamaño compacto, ambos modelos Arctic Embed 2.0 obtuvieron impresionantes puntuaciones NDCG@10 en diversos conjuntos de datos de referencia en inglés y otros idiomas, lo que demuestra su buena capacidad de generalización incluso para idiomas no incluidos en la solución de entrenamiento. Estas impresionantes puntuaciones de referencia hacen de Arctic Embed L 2.0 un líder entre los modelos de recuperación de vanguardia.

- Scalable Retrieval via Matryoshka Representation Learning (MRL): La versión 2.0 de Arctic Embed incluye la misma funcionalidad MRL de cuantificación sencilla introducida en Arctic Embed 1.5, lo que permite a los usuarios reducir costes y optimizar el tamaño al realizar búsquedas en grandes conjuntos de datos. Con dos tamaños de modelo, los usuarios pueden lograr búsquedas de alta calidad utilizando sólo 128 bytes por vector (96 veces menos que la incrustación sin comprimir del popular modelo text-embedding-3-large de OpenAI ^1^). Al igual que Arctic Embed 1.5, el modelo Arctic Embed 2.0 también supera a varios de sus homólogos habilitados para MRL en estado comprimido, con una degradación de la calidad significativamente menor y puntuaciones de referencia más altas.

- Verdadero código abierto: El modelo Arctic Embed 2.0 se publica bajo la generosa licencia Apache 2.0.

La flexibilidad del código abierto se une a la fiabilidad empresarial

Al igual que sus predecesores, los modelos Arctic Embed 2.0 se publican bajo la generosa licencia Apache 2.0, lo que permite a las organizaciones modificarlos, implantarlos y ampliarlos con licencias conocidas. Estos modelos funcionan de forma inmediata, son compatibles con aplicaciones verticales gracias a una incrustación multilingüe fiable y tienen una gran capacidad de generalización.

Clément Delangue, consejero delegado de Hugging Face, ha declarado: "Los modelos de incrustación multilingües son fundamentales para que personas de todo el mundo, no sólo angloparlantes, puedan convertirse en constructores de IA. Al publicar estos modelos de vanguardia como código abierto en Hugging Face, Snowflake está haciendo una enorme contribución a la IA y al mundo."

De hecho, especialmente entre las opciones de código abierto, la familia Arctic Embed 2.0 merece especial atención por su capacidad de generalización observada en las pruebas de búsqueda multilingüe. Con la licencia Conjunto de pruebas del Foro de evaluación multilingüe (CLEF) 2000-2003nuestro equipo pudo medir la calidad de la recuperación fuera del dominio de varios modelos de código abierto y descubrió una desafortunada tendencia con respecto a la recuperación dentro del dominio. MIRACL en comparación con las puntuaciones obtenidas en el conjunto de evaluación. Nuestra hipótesis es que algunos de los primeros desarrolladores de modelos de código abierto pueden haber sobreajustado inadvertidamente sus escenarios de entrenamiento para mejorar el rendimiento de MIRACL a expensas de mejorar el rendimiento de MIRACL, y por lo tanto pueden haber sobreajustado los datos de entrenamiento de MIRACL. Esté atento a un próximo informe técnico sobre cómo se entrenó el modelo Arctic Embed 2.0 y qué aprendimos durante el proceso de entrenamiento.

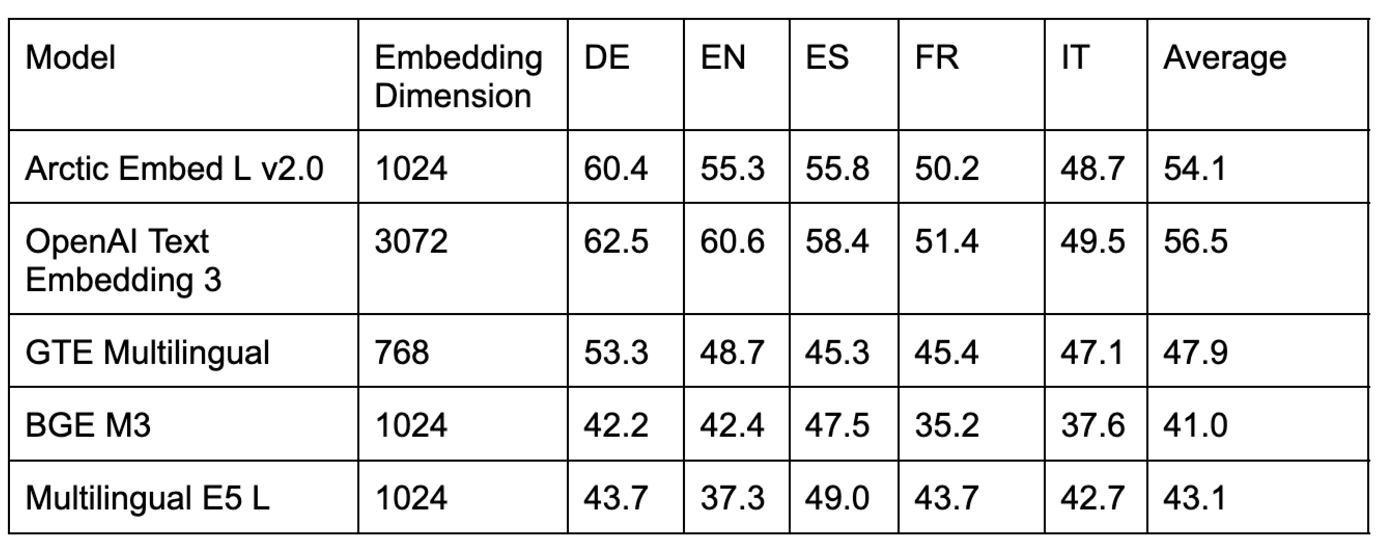

Tabla 2. Comparación de los modelos de recuperación multilingüe en varios conjuntos de datos de la evaluación comparativa CLEF fuera del dominio.

Tabla 3. Comparación de varios modelos de recuperación multilingüe de código abierto en la evaluación comparativa MIRACL en el dominio.

Como se muestra en las tablas 2 y 3, se comparan varios modelos populares de código abierto para la evaluación MIRACL intradominio con el modelo Arctic Embed L 2.0 son comparables, pero obtiene peores resultados en las evaluaciones CLEF fuera del dominio. También hemos evaluado modelos de código cerrado muy conocidos (por ejemplo, el modelo text-embedding-3-large de OpenAI) y hemos comprobado que el rendimiento de Arctic L 2.0 está en línea con el de los principales modelos patentados.

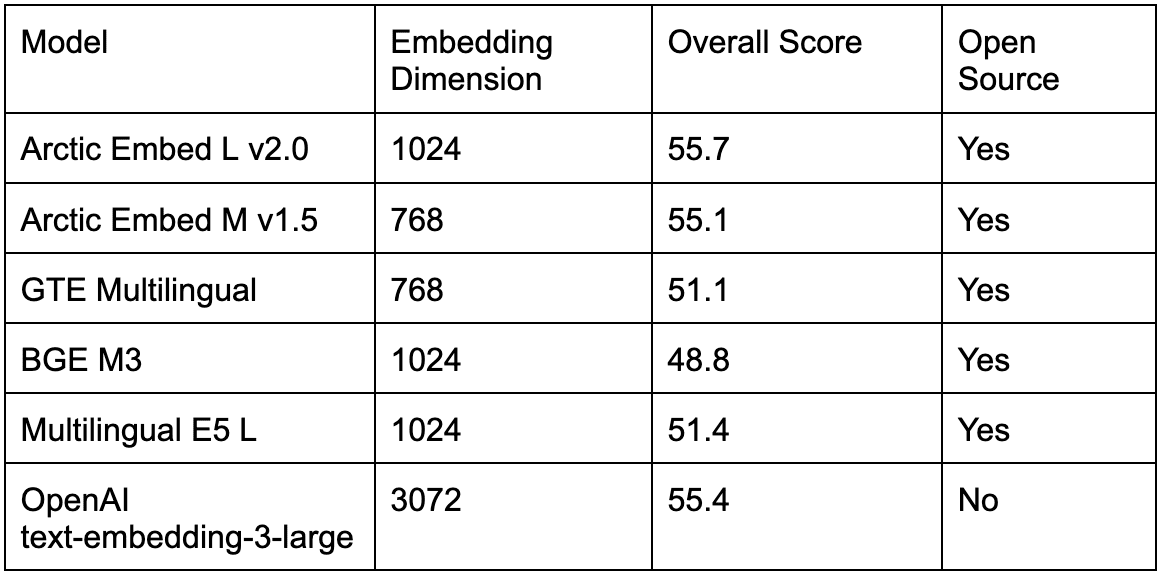

Como se muestra en la Tabla 4, los modelos multilingües de código abierto existentes también son mejores en la popular prueba de referencia English MTEB Retrieval que el Arctic Embed L 2.0 El resultado fue aún peor, ya que los usuarios que deseaban utilizar varios idiomas se veían obligados a elegir entre una menor calidad de recuperación en inglés o la mayor complejidad operativa de utilizar un segundo modelo para la recuperación en inglés. Con el lanzamiento de Arctic Embed 2.0, los profesionales pueden cambiar a un único modelo de código abierto sin sacrificar la calidad de la recuperación en inglés.

Tabla 4. Comparación de varios de los mejores modelos de recuperación multilingüe de código abierto y de código cerrado en la prueba comparativa de recuperación MTEB en el dominio.

Compresión y eficacia sin concesiones

Snowflake sigue dando prioridad a la eficiencia y la escala en el diseño de sus modelos integrados. Con la ayuda de Arctic Embed L 2.0Esto permite a los usuarios comprimir las características de calidad de grandes modelos en incrustaciones compactas que sólo requieren 128 bytes de almacenamiento por vector. Esto permite ofrecer servicios de recuperación de millones de documentos a bajo coste en hardware de gama baja. También hemos mejorado el rendimiento de la incrustación comprimiendo la impresionante calidad de recuperación de Arctic Embed 2.0 en 100 millones y 300 millones de parámetros no incrustados para sus dos tamaños (mediano y grande), respectivamente, lo que supone un ligero aumento con respecto a nuestra versión anterior en inglés.

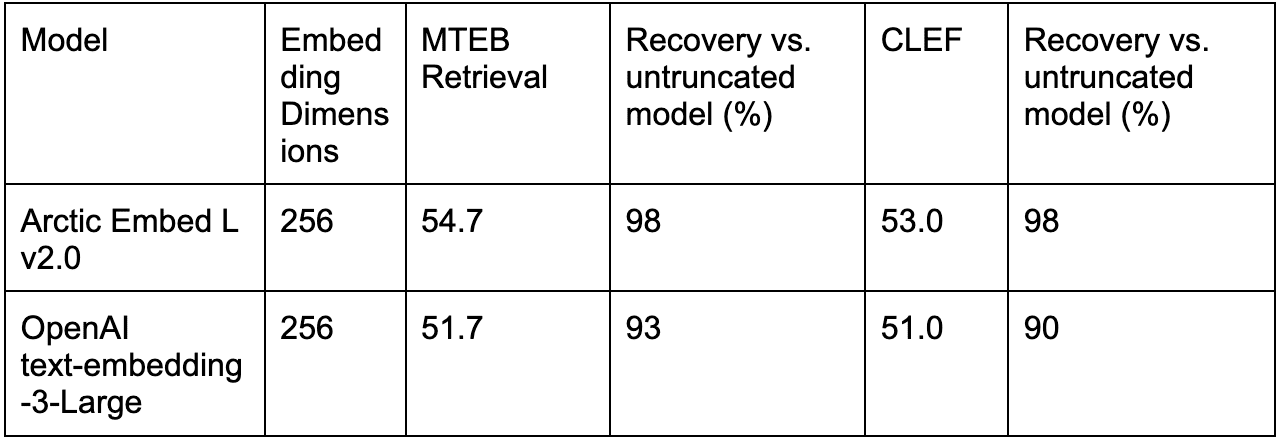

De hecho, los mecanismos centrados en la escala Arctic Embed L 2.0 Donde realmente brilla, es en la calidad bajo compresión, en comparación con otros modelos entrenados con MRL (por ejemplo, text-embedding-3-large de OpenAI).

La Tabla 5. compara el rendimiento de la incrustación de texto-3-large de OpenAI con la incrustación truncada con Arctic Embed L 2.0 para inglés solamente (MTEB Retrieval) y multilingüe (CLEF).

Conclusión: un nuevo estándar para búsquedas multilingües y eficientes

Con Arctic Embed 2.0, Snowflake ha establecido un nuevo estándar para los modelos de incrustación multilingües y eficientes. Además, hemos hecho que las fronteras de la calidad de la incrustación de texto no sólo sean eficientes, sino que también se hayan ganado el código abierto suelto. Tanto si su objetivo es ampliar su alcance a usuarios multilingües, reducir los costes de almacenamiento o incrustar documentos en hardware accesible, Arctic Embed 2.0 le ofrece las funciones y la flexibilidad necesarias para satisfacer sus necesidades.

Nuestros próximos informes técnicos profundizarán en las innovaciones de Arctic Embed 2.0. Mientras tanto, le invitamos a empezar a incrustar con Snowflake hoy mismo.

^1^ Este cálculo utiliza el formato float32 para la línea de base sin comprimir, es decir, 3.072 números de 32 bits cada uno, para un total de 98.304 bits por vector, que es exactamente 96 veces mayor que los 1.024 bits por vector (equivalentes a 128 bytes por vector) utilizados al almacenar vectores de 256 dimensiones truncados por MRL en el modelo Arctic Embed 2.0 en formato int4.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...