Archon: un marco de desarrollo para construir y optimizar de forma autónoma inteligencias artificiales

Últimos recursos sobre IAPublicado hace 12 meses Círculo de intercambio de inteligencia artificial 110.7K 00

Introducción general

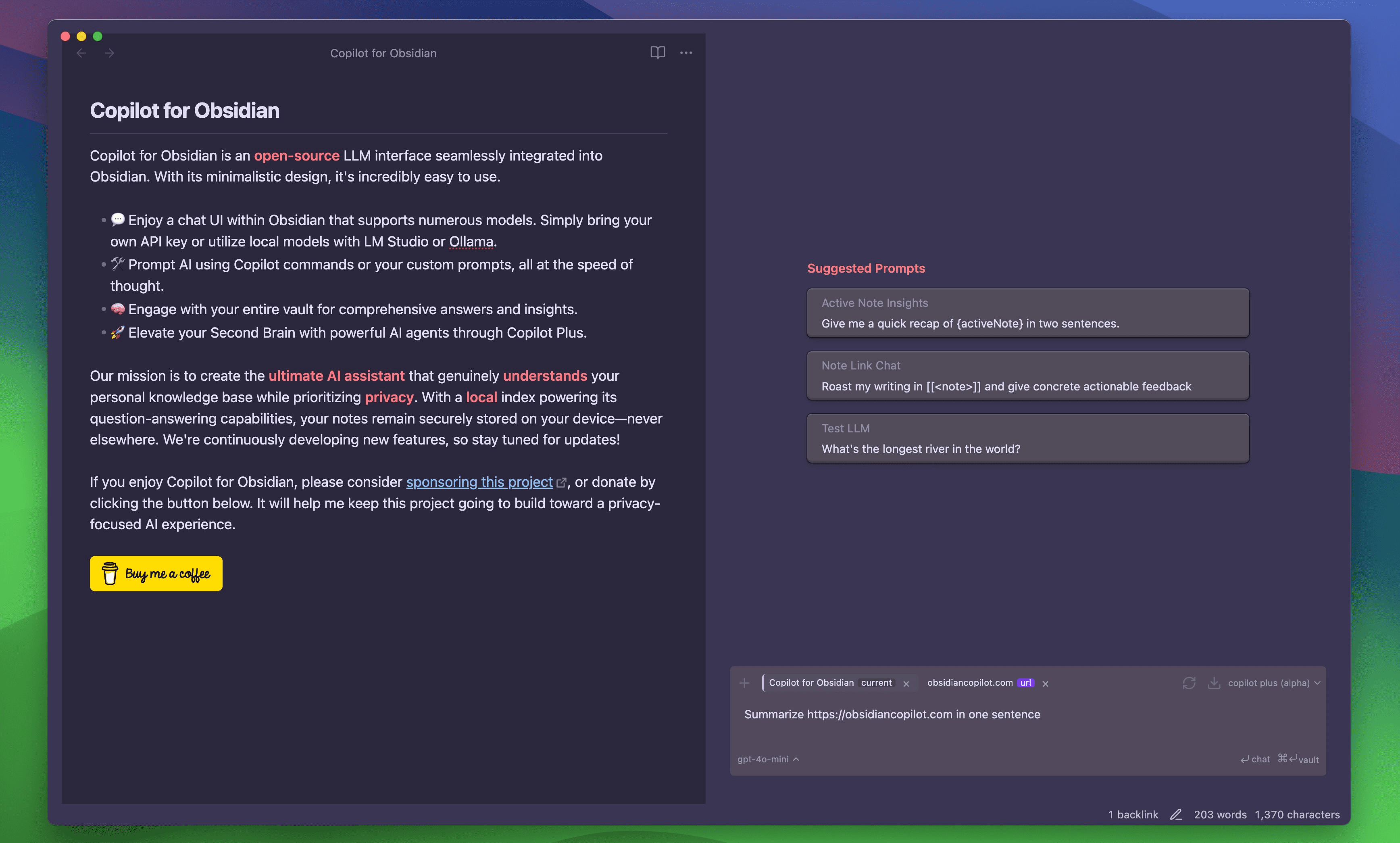

Archon es el primer proyecto "Agenteer" del mundo construido por el desarrollador Cole Medin (nombre de usuario en GitHub coleam00): un marco de código abierto centrado en construir, optimizar e iterar de forma autónoma sobre inteligencias de IA. Se trata de un marco de código abierto centrado en la construcción autónoma y la iteración de inteligencias de IA. Es a la vez una herramienta práctica para desarrolladores y una plataforma educativa para demostrar la evolución de los sistemas corporales inteligentes.Archon, actualmente en la versión V4, utiliza una interfaz de usuario Streamlit totalmente optimizada para proporcionar una interfaz de gestión intuitiva. Desarrollado en Python, el proyecto integra tecnologías como Pydantic AI, LangGraph y Supabase para evolucionar desde la simple generación de inteligencia hasta la colaboración en flujos de trabajo complejos.Archon demuestra los tres principios del desarrollo moderno de IA: razonamiento inteligente, incrustación de conocimientos y arquitectura extensible mediante planificación, bucles de retroalimentación e integración de conocimientos de dominio.

Archon es lo que a mí me gusta llamar un "parásito" de otros marcos de desarrollo de inteligencia. Archon puede construir y optimizar otros marcos de desarrollo de inteligencia, pero también es él mismo una inteligencia.

Lista de funciones

- Generación automática de inteligenciasGeneración de códigos de inteligencia AI personalizados basados en los requisitos de entrada del usuario.

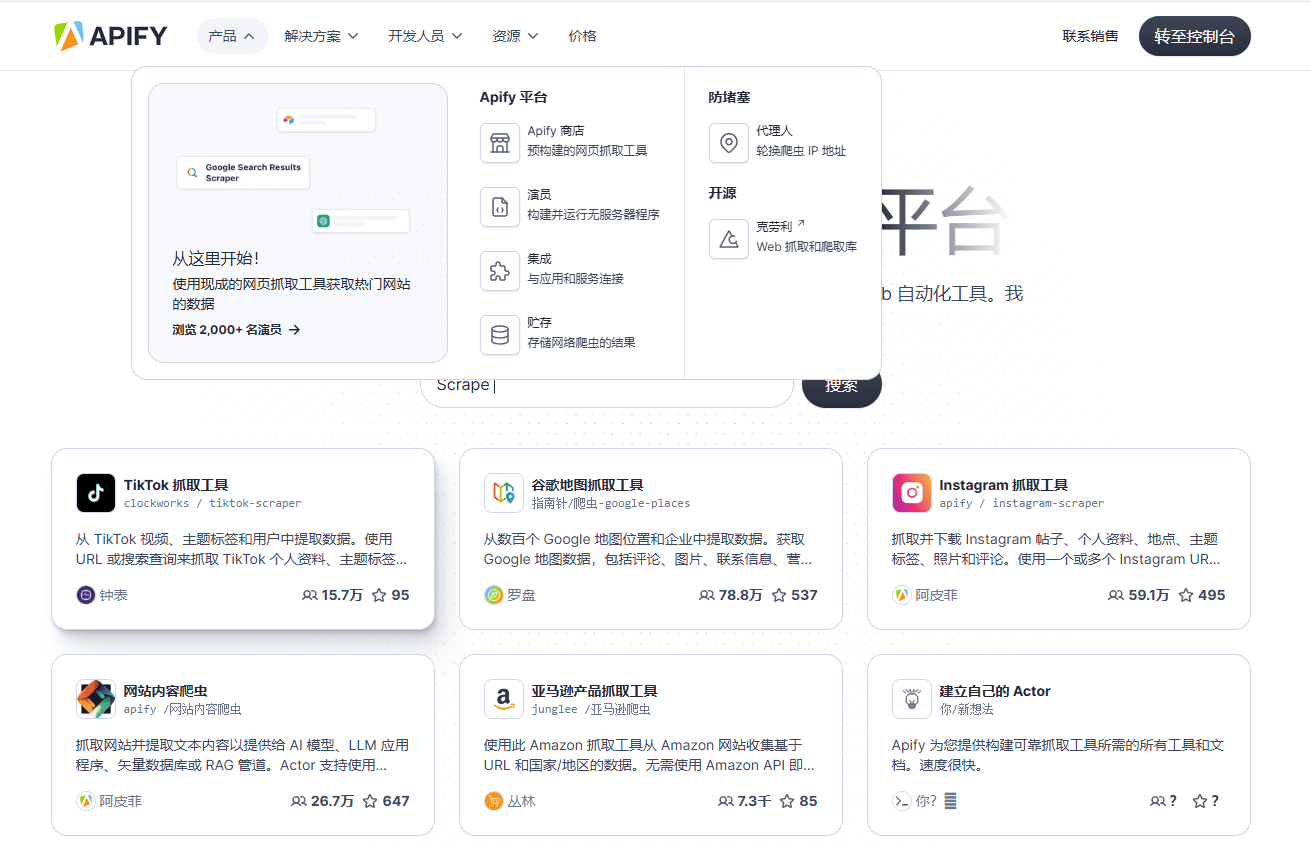

- Rastreo e indexación de documentos: Rastreo de documentos como Pydantic AI, generación de incrustaciones vectoriales y almacenamiento en Supabase.

- Soporte del sistema RAG: Aprovechamiento de técnicas de generación mejoradas por búsqueda para proporcionar sugerencias y optimizaciones de código precisas.

- Gestión de la interfaz de usuario Streamlit: Configure variables de entorno, bases de datos y servicios del cuerpo inteligente a través de una interfaz visual.

- colaboración multiinteligencia: Basado en LangGraph Habilitación de flujos de trabajo coordinados para el razonamiento, la codificación y el encaminamiento de tareas.

- Compatibilidad local y en la nubeSoporte para OpenAI, Anthropic, OpenRouter APIs o nativo Ollama Modelos.

- Despliegue en contenedores Docker: Proporciona el contenedor principal y MCP Containers para garantizar que los entornos de producción estén listos para su uso nada más sacarlos de la caja.

- Integración MCPSoporte para la integración con AI IDEs (por ejemplo, Windsurf, Cursor) para gestionar archivos y dependencias.

- Apoyo comunitario: Proporcionar una plataforma para la comunicación de los usuarios a través del foro oTTomator Think Tank.

Utilizar la ayuda

Archon es un framework de código abierto rico en funcionalidades diseñado para ayudar a los usuarios a desarrollar y gestionar rápidamente inteligencias de IA. Aquí tienes una guía detallada de instalación y uso para asegurarte de que puedes empezar fácilmente.

Proceso de instalación

Archon V4 soporta dos métodos de instalación: Docker (recomendado) e instalación local en Python. Estos son los pasos:

Forma 1: Instalación Docker (recomendada)

- Preparar el entorno

- Asegúrese de que Docker y Git están instalados.

- Obtén una cuenta Supabase (para bases de datos vectoriales).

- Prepare la clave API de OpenAI/Anthropic/OpenRouter, o ejecute Ollama localmente.

- almacén de clones

Se ejecuta en el terminal:git clone https://github.com/coleam00/archon.git cd archon

- Ejecutar un script Docker

Ejecute el siguiente comando para construir e iniciar el contenedor:python run_docker.py- El script construye automáticamente dos contenedores: el contenedor principal Archon (que ejecuta la interfaz de usuario Streamlit y los servicios Graph) y el contenedor MCP (que soporta la integración AI IDE).

- si está presente

.envlas variables de entorno se cargarán automáticamente.

- interfaz de acceso

Abra su navegador y visitehttp://localhost:8501Para ello, vaya a la interfaz de usuario de Streamlit.

Forma 2: Instalación local de Python

- Preparar el entorno

- Asegúrese de que Python 3.11+ está instalado.

- Obtén la cuenta Supabase y la clave API.

- almacén de clones

git clone https://github.com/coleam00/archon.git cd archon - Creación de un entorno virtual e instalación de dependencias

python -m venv venv source venv/bin/activate # Windows: venv\Scripts\activate pip install -r requirements.txt - Iniciar Streamlit UI

streamlit run streamlit_ui.py - interfaz de acceso

Abra su navegador y visitehttp://localhost:8501.

Configuración de variables de entorno

La primera vez que ejecutes Docker o una instalación local, deberás configurar las variables de entorno. Cree una .env con contenidos de muestra:

OPENAI_API_KEY=your_openai_api_key

SUPABASE_URL=your_supabase_url

SUPABASE_SERVICE_KEY=your_supabase_service_key

PRIMARY_MODEL=gpt-4o-mini

REASONER_MODEL=o3-mini

Esta información está disponible en el panel de Supabase y a través del proveedor de la API.

Función Flujo de operaciones

Una vez instalado, Streamlit UI ofrece cinco módulos funcionales principales que le guiarán paso a paso a través de la configuración y el uso.

1. Medio ambiente

- procedimiento::

- Vaya a la pestaña "Entorno".

- Introduzca la clave API (por ejemplo, OpenAI u OpenRouter) y la configuración del modelo (por ejemplo.

gpt-4o-mini). - Haga clic en "Guardar" y la configuración se guardará en la carpeta

env_vars.json.

- tenga en cuentaSi está utilizando Ollama local, debe asegurarse de que el servicio se ejecuta en la carpeta

localhost:11434La transmisión de IU sólo es compatible con OpenAI.

2. Configuración de la base de datos (Base de datos)

- procedimiento::

- Vaya a la pestaña "Base de datos".

- Introduzca la URL de Supabase y la clave de servicio.

- Haga clic en "Inicializar base de datos", el sistema creará automáticamente la base de datos.

site_pagesMesa. - Compruebe el estado de la conexión para confirmar el éxito.

- estructura de la tabla::

CREATE TABLE site_pages ( id UUID PRIMARY KEY DEFAULT uuid_generate_v4(), url TEXT, chunk_number INTEGER, title TEXT, summary TEXT, content TEXT, metadata JSONB, embedding VECTOR(1536) );

3. Rastreo e indexación de la documentación (Documentación)

- procedimiento::

- Vaya a la pestaña "Documentación".

- Introduzca la URL del documento de destino (por ejemplo, documento Pydantic AI).

- Haga clic en "Iniciar rastreo" y el sistema troceará el documento, generará una incrustación y la almacenará en Supabase.

- Puede ver el progreso de la indexación en la interfaz de usuario cuando haya terminado.

- utilicepara RAG El sistema proporciona la base de conocimientos.

4. Servicio de Cuerpo Inteligente (Servicio de Agente)

- procedimiento::

- Vaya a la pestaña "Servicio de agentes".

- Haga clic en Iniciar servicio para ejecutar el flujo de trabajo LangGraph.

- Supervise el estado del servicio a través de los registros.

- funcionalidad: Coordinar el razonamiento, la codificación y el encaminamiento de tareas para garantizar que la lógica central de generación de inteligencias funcione correctamente.

5. Creación de un cuerpo inteligente (Chat)

- procedimiento::

- Ve a la pestaña "Chat".

- Introduzca un requisito, como "Generar una inteligencia que analice archivos JSON".

- El sistema combina los conocimientos recuperados por el sistema GAR para generar códigos y mostrarlos.

- Copie el código para ejecutarlo localmente o despliéguelo a través de un servicio.

- ejemplo típico::

Entrada: 'Generar un cuerpo inteligente que consulte el tiempo en tiempo real'.

Ejemplo de salida:from pydantic_ai import Agent, OpenAIModel agent = Agent(OpenAIModel("gpt-4o-mini"), system_prompt="查询实时天气") result = agent.run("获取北京今天的天气") print(result.data)

Opcional: Configuración MCP

- procedimiento::

- Vaya a la pestaña "MCP".

- Configurar la integración con un IDE de IA como Cursor.

- Inicie el contenedor MCP y conéctese al servicio Graph.

- utilice: Soporte para la creación automatizada de archivos y gestión de dependencias en el IDE para código smartbody.

ejemplo de uso

Supongamos que desea desarrollar un "Log Analysis Intelligence":

- En Chat, escriba: "Generar una inteligencia Pydantic AI que analiza los registros de Nginx".

- Archon recupera la documentación pertinente y genera el código:

from pydantic_ai import Agent, OpenAIModel

agent = Agent(OpenAIModel("gpt-4o-mini"), system_prompt="解析Nginx日志")

result = agent.run("分析access.log并提取IP地址")

print(result.data)

- Guarde el código localmente y asegúrese de configurar la clave API antes de ejecutarlo.

advertencia

- Compatibilidad de modelosSólo OpenAI admite la salida en streaming desde la interfaz de usuario de Streamlit, otros modelos (por ejemplo, Ollama) sólo admiten la salida sin streaming.

- requisitos de la redEl rastreo de documentos y la llamada a las API requieren una red estable.

- ajustar los componentes durante las pruebasSi algo va mal, comprueba el registro de la interfaz de usuario o la salida del terminal.

Con estos pasos, podrá aprovechar al máximo la capacidad de Archon para generar y gestionar rápidamente inteligencias de IA, tanto para el aprendizaje como para el desarrollo real.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...