Las 5 mejores plataformas de inferencia de IA que utilizan una versión completa y gratuita de DeepSeek-R1

Debido al exceso de tráfico y a un ciberataque, el sitio web y la aplicación de DeepSeek llevan unos días sin funcionar y la API no funciona.

Anteriormente hemos compartido el método para desplegar DeepSeek-R1 localmente (verDespliegue local de DeepSeek-R1), pero el usuario medio está limitado a una configuración de hardware que hace difícil ejecutar incluso un modelo 70b, por no hablar de un modelo 671b completo.

Por suerte, las principales plataformas tienen acceso a DeepSeek-R1, así que puedes probarlo como sustituto plano.

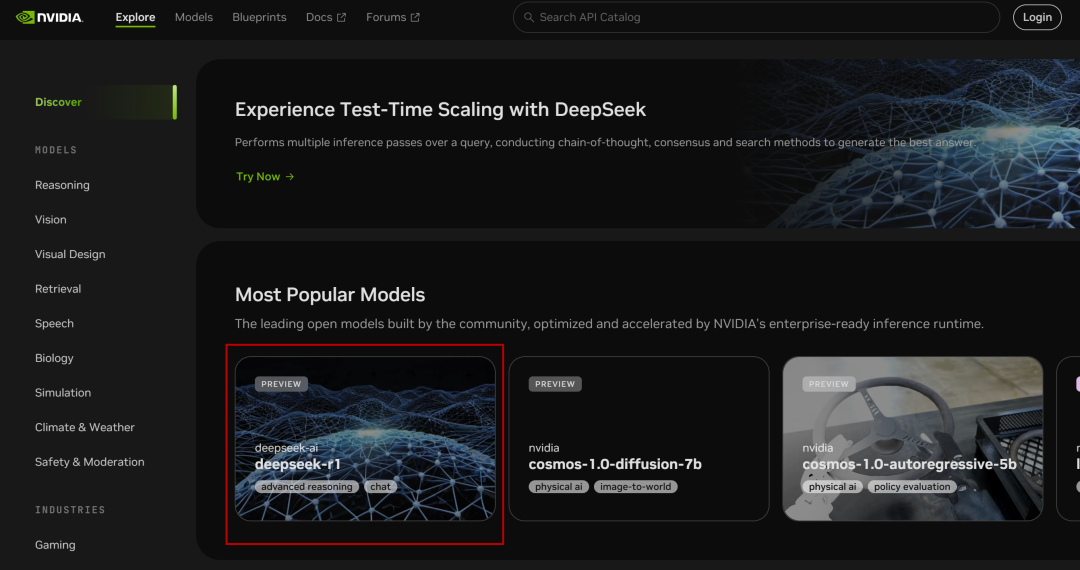

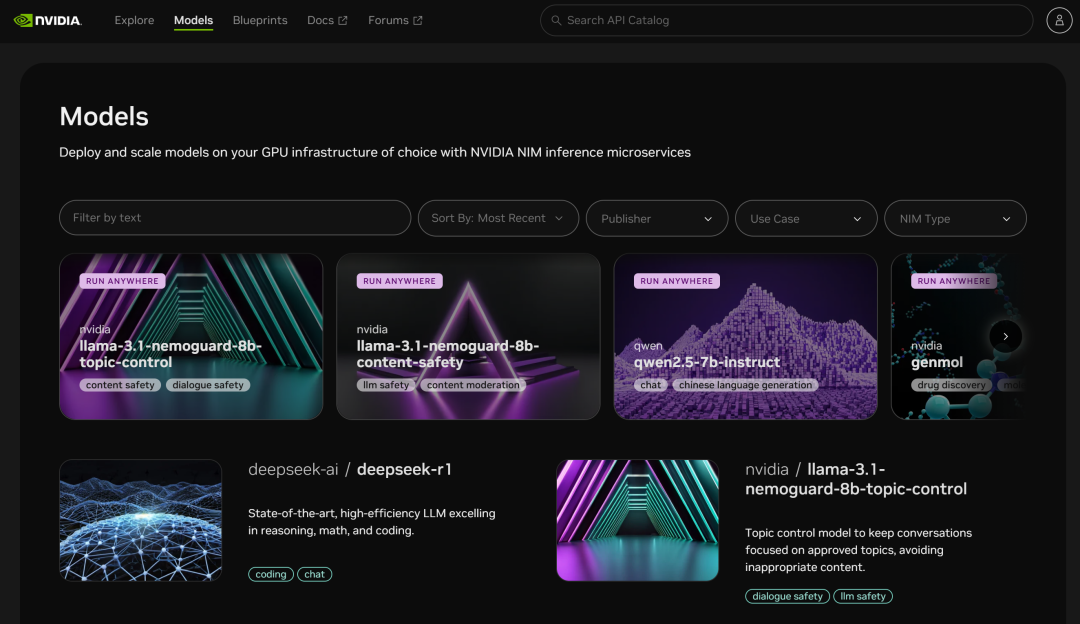

I. Microservicios NVIDIA NIM

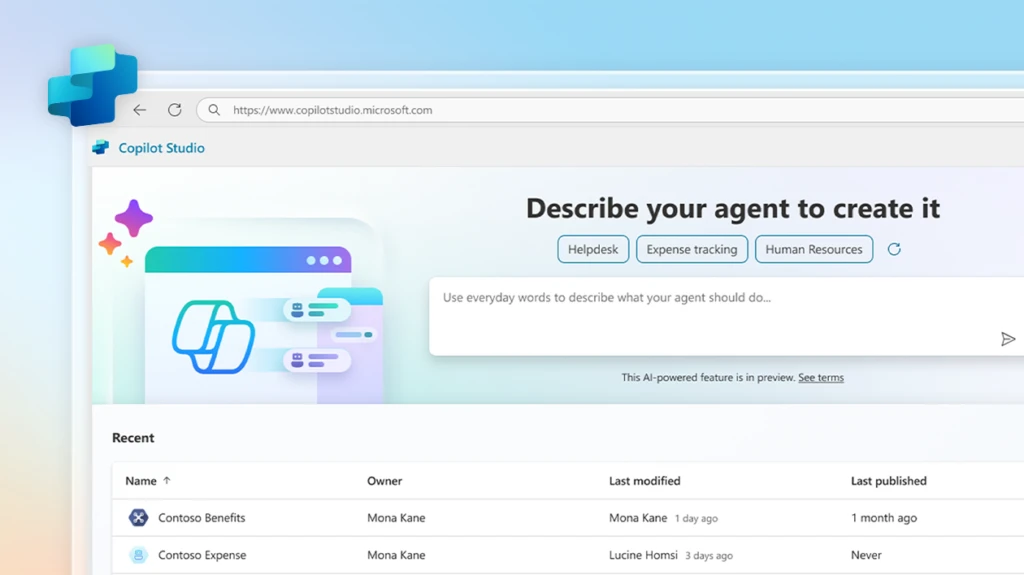

NVIDIA Build: integra varios modelos de IA y experiméntalos gratis

Página web: https://build.nvidia.com/deepseek-ai/deepseek-r1

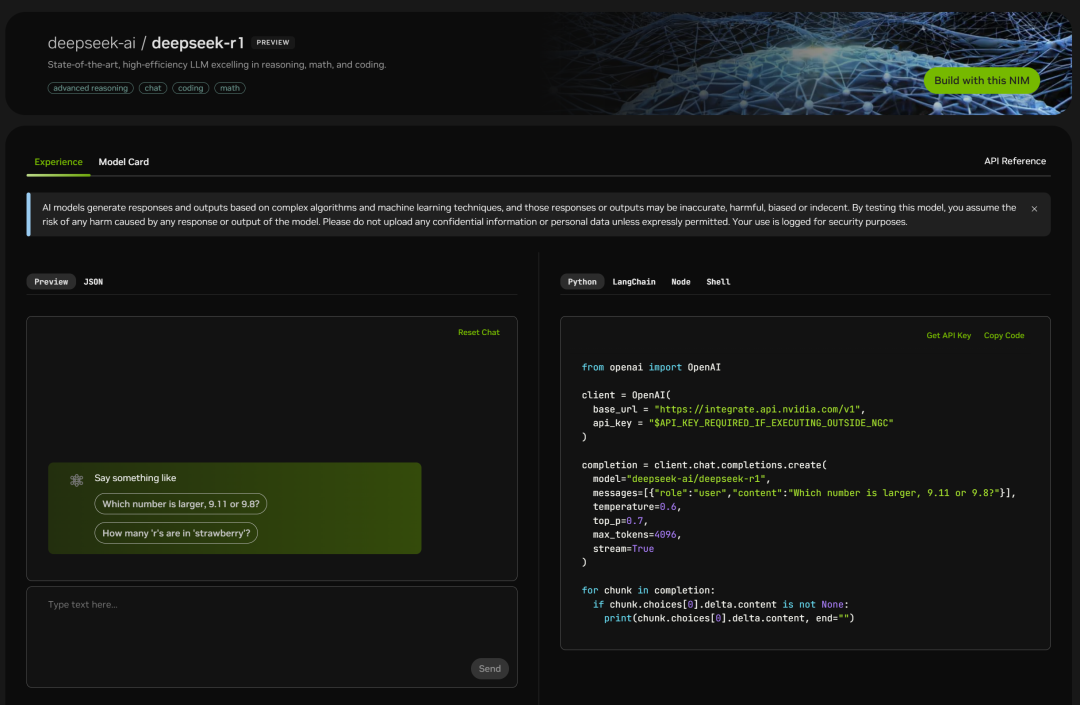

NVIDIA desplegó el parámetro de volumen completo 671B del DeepSeek-R1 Modelos, la versión web es fácil de usar, y puedes ver la ventana de chat cuando haces clic en ella:

A la derecha aparece también la página de códigos:

Simplemente pruébalo:

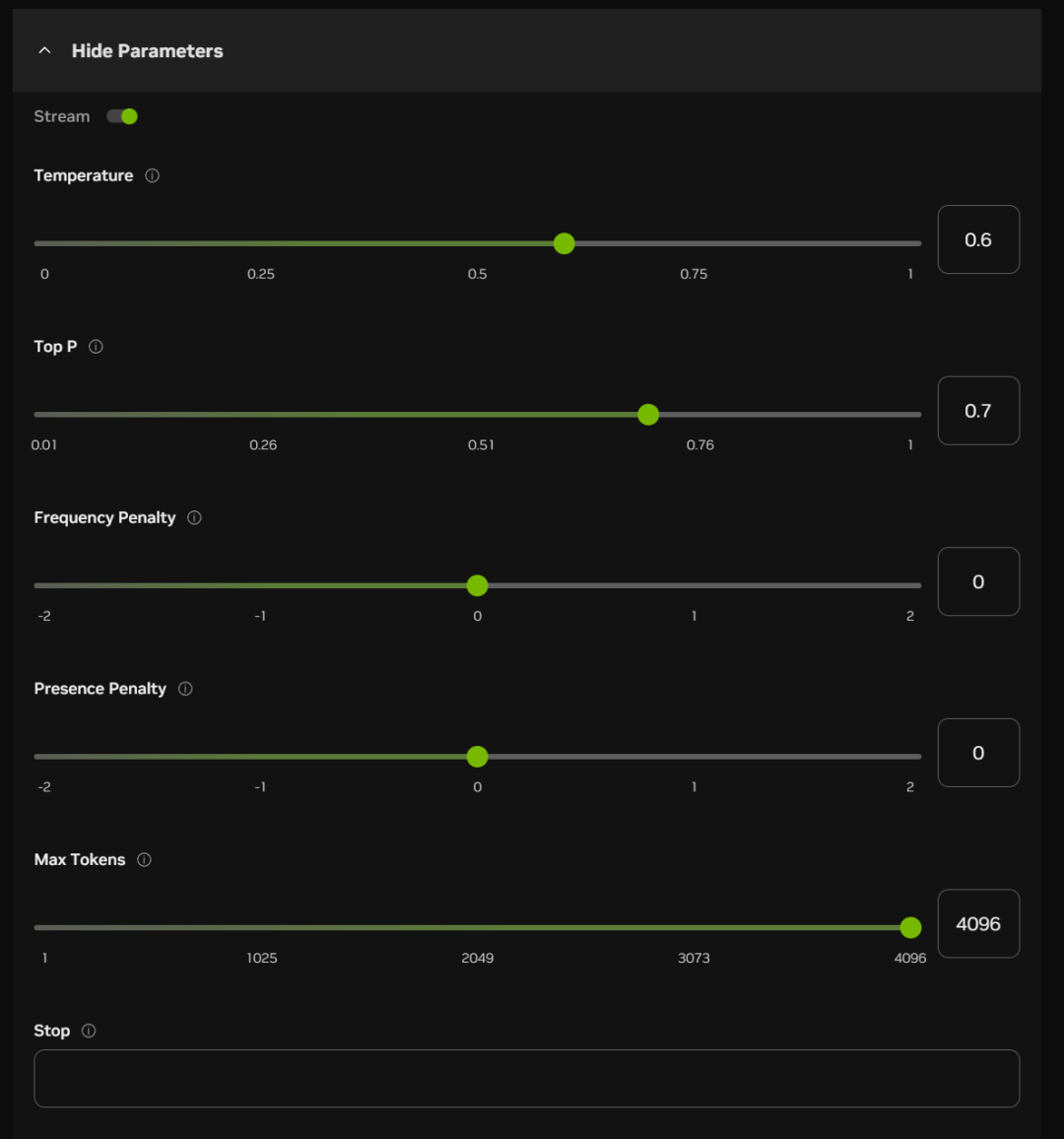

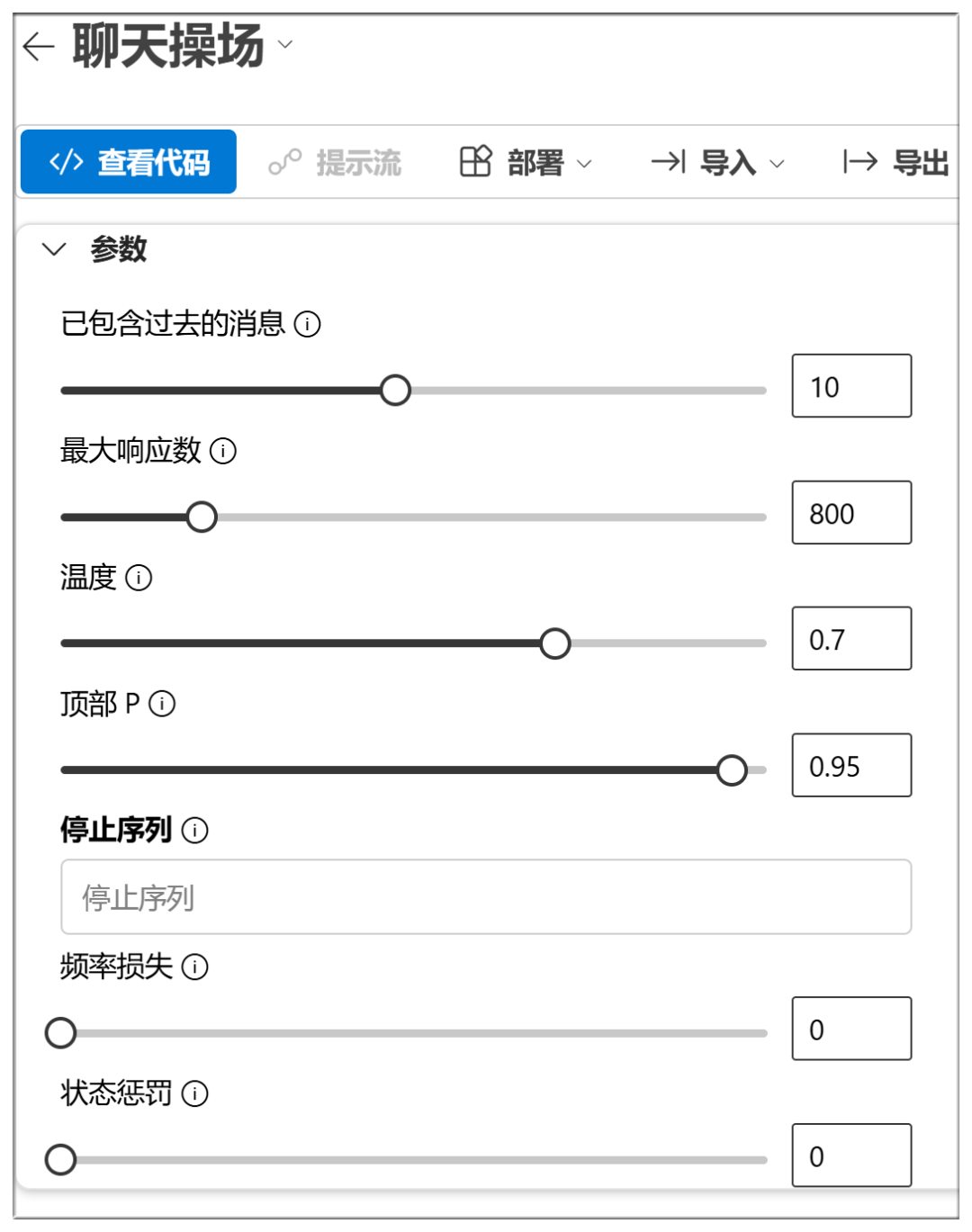

Debajo del cuadro de chat, también puede activar algunos elementos de los parámetros (que pueden ser predeterminados en la mayoría de los casos):

A continuación se indican los significados y funciones aproximados de estas opciones:

Temperatura:

Cuanto mayor sea el valor, más aleatoria será la salida y más respuestas creativas se podrán generar

Top P (muestreo nuclear):

Los valores más altos retienen más fichas de calidad probabilística y generan más diversidad

Penalización por frecuencia:

Los valores más altos penalizan más las palabras de alta frecuencia y reducen la verbosidad o la repetición

Sanción de presencia:

Cuanto mayor sea el valor, más inclinado estará el modelo a probar palabras nuevas

Máximo de fichas:

Cuanto mayor sea el valor, mayor será la duración potencial de la respuesta

Para:

Detener la salida al generar determinados caracteres o secuencias, para evitar que se genere demasiado tiempo o se agoten los temas.

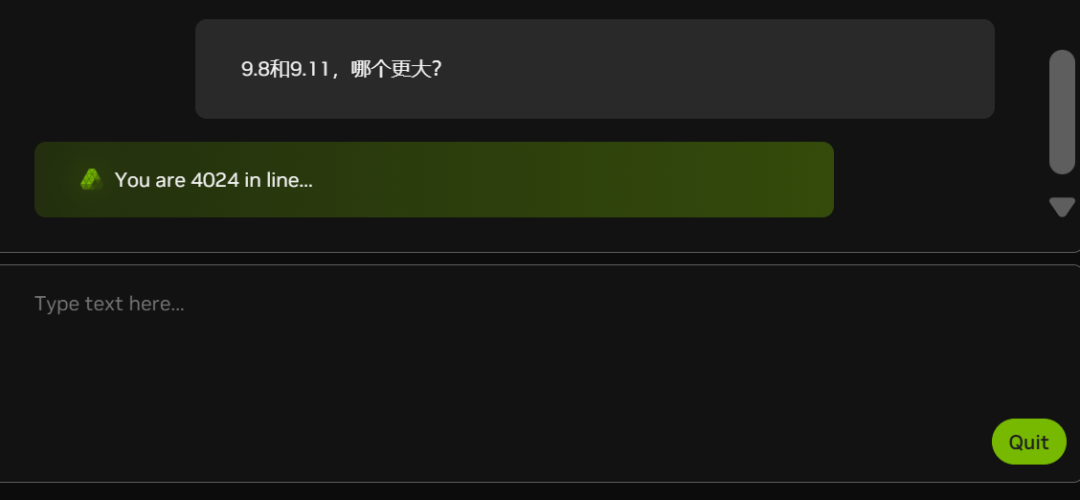

En la actualidad, debido al creciente número de blancos (fíjese en el número de personas en la cola del gráfico inferior), el NIM se está quedando atrás en algunos momentos:

¿A NVIDIA también le faltan tarjetas gráficas?

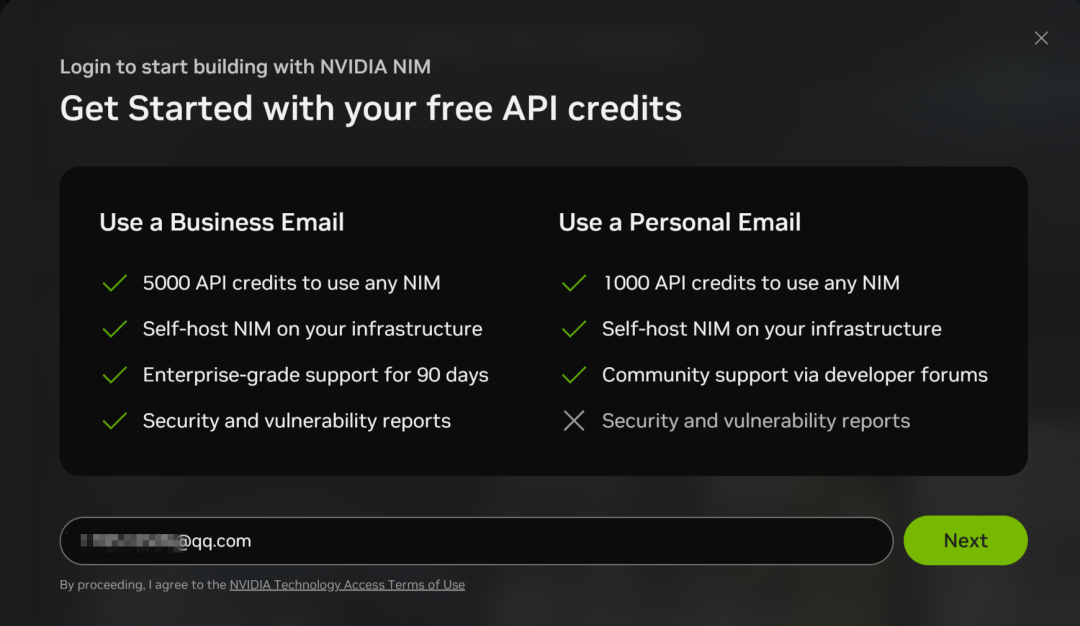

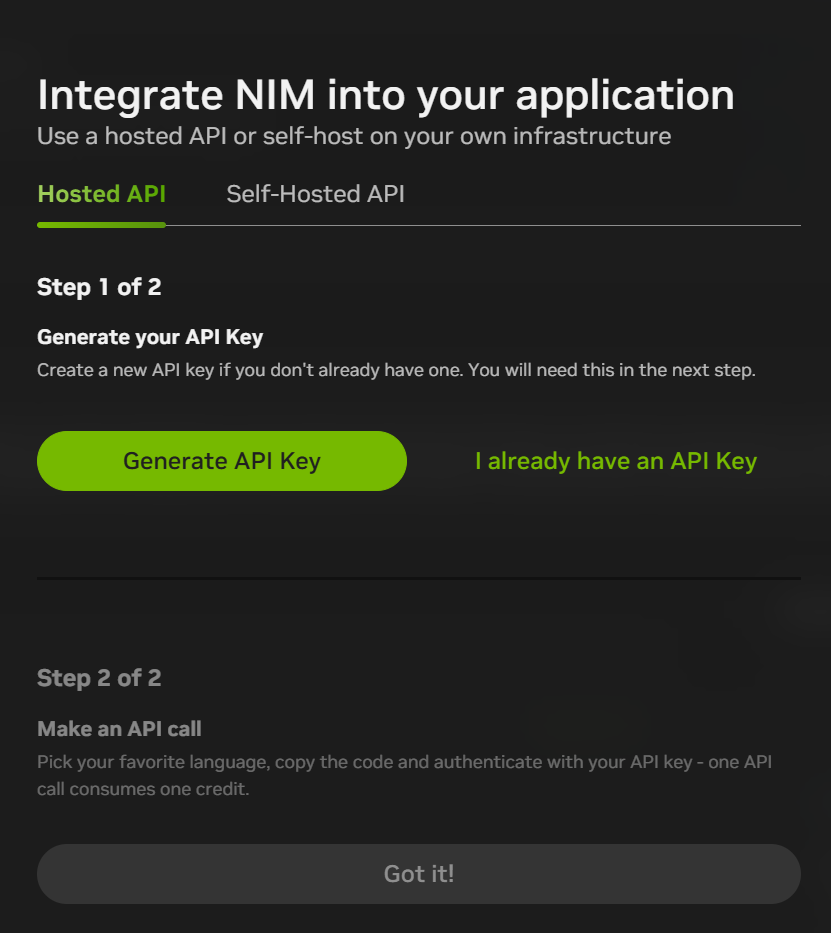

Los microservicios NIM también admiten llamadas API a DeepSeek-R1, pero es necesario registrarse para obtener una cuenta con una dirección de correo electrónico:

El proceso de registro es relativamente sencillo, ya que sólo se utiliza la verificación por correo electrónico:

Después de registrarte, puedes hacer clic en "Construir con este NIM" en la parte superior derecha de la interfaz de chat para generar una CLAVE API, y en la actualidad, obtendrás 1.000 puntos (1.000 interacciones) por registrarte, así que puedes utilizarlo todo y luego registrarte de nuevo con una nueva dirección de correo electrónico.

La plataforma de microservicios NIM también proporciona acceso a muchos otros modelos:

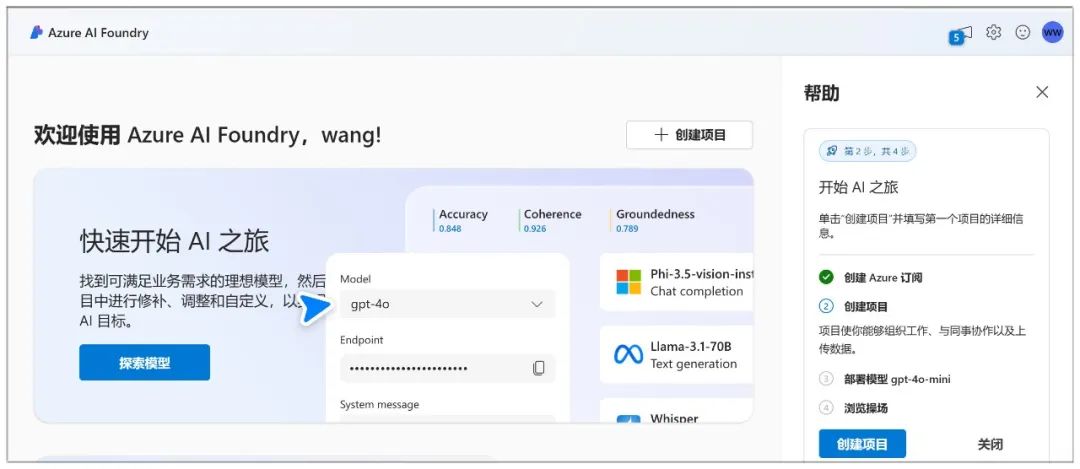

II. Microsoft Azure

Página web:

https://ai.azure.com

Microsoft Azure permite crear un chatbot e interactuar con el modelo a través de una zona de juego de chat.

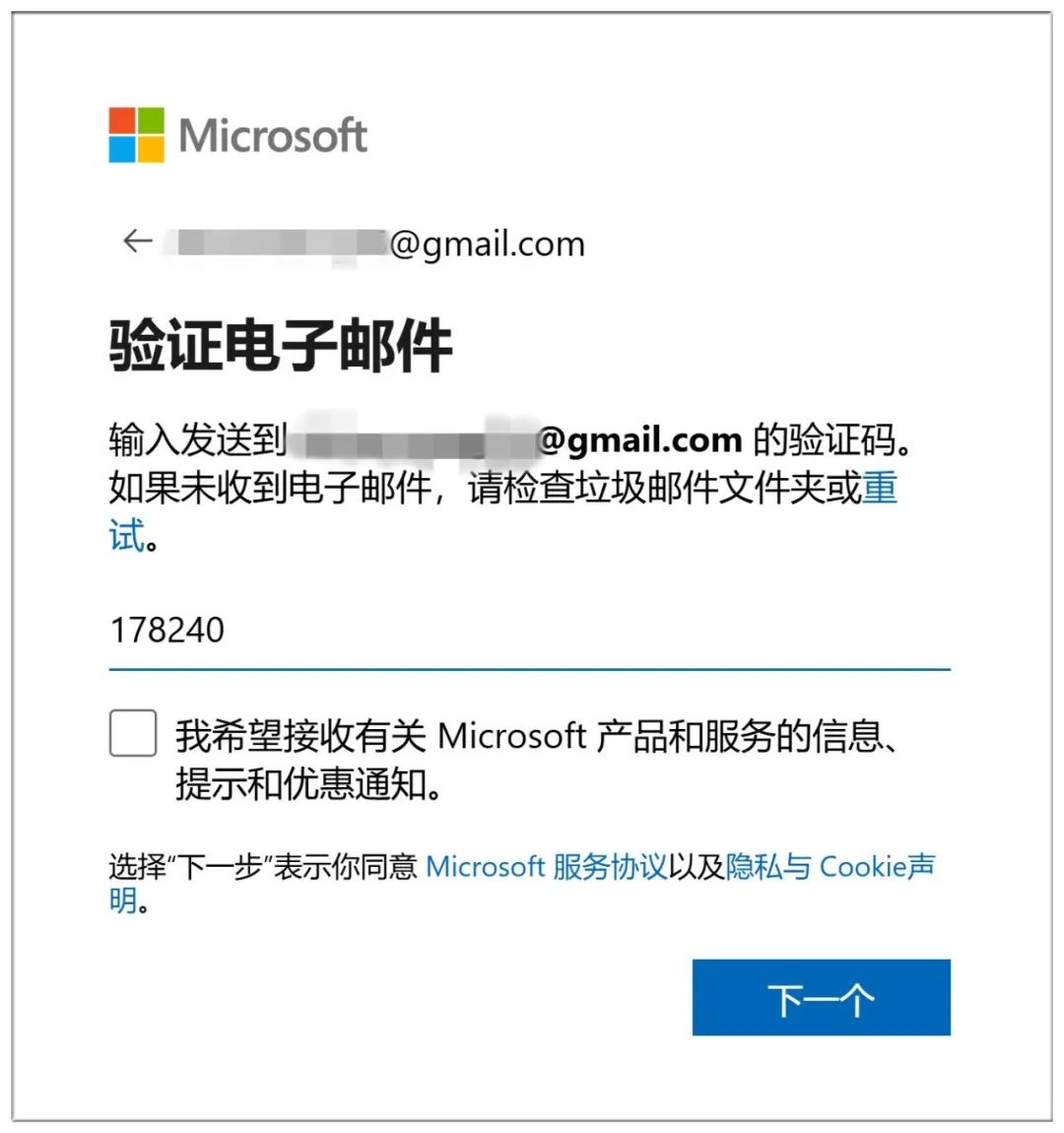

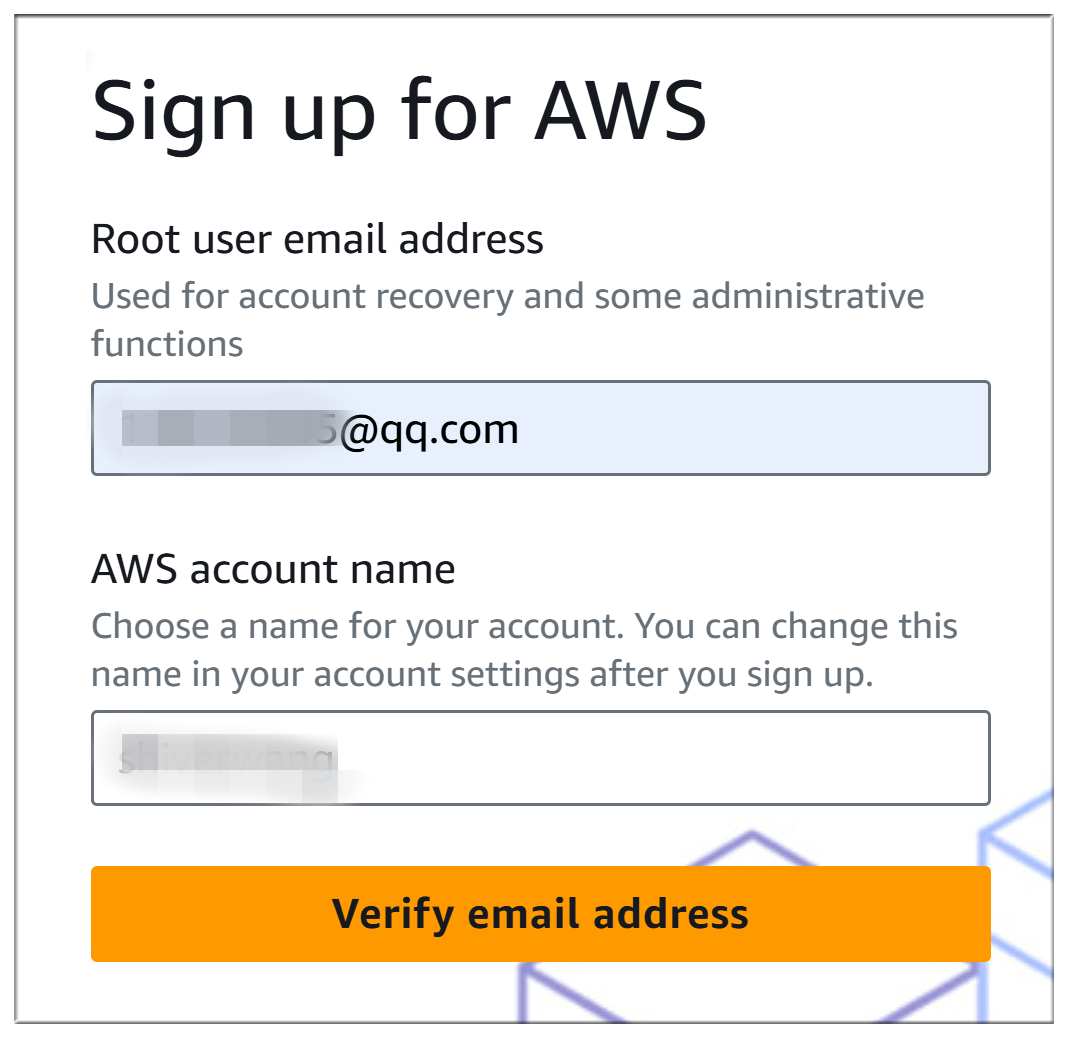

Azure es muy complicado de contratar, primero tienes que crear una cuenta Microsoft (sólo tienes que iniciar sesión si ya tienes una):

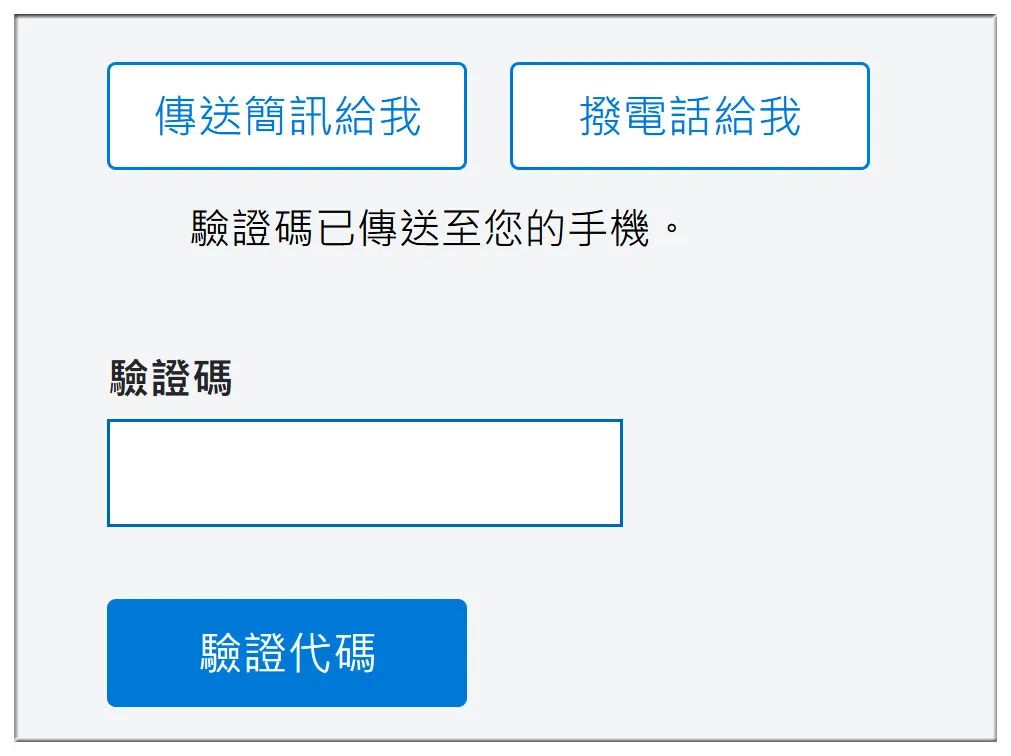

Para crear una cuenta también es necesario verificar el correo electrónico:

Acaba demostrando que eres humano respondiendo a 10 preguntas consecutivas del inframundo:

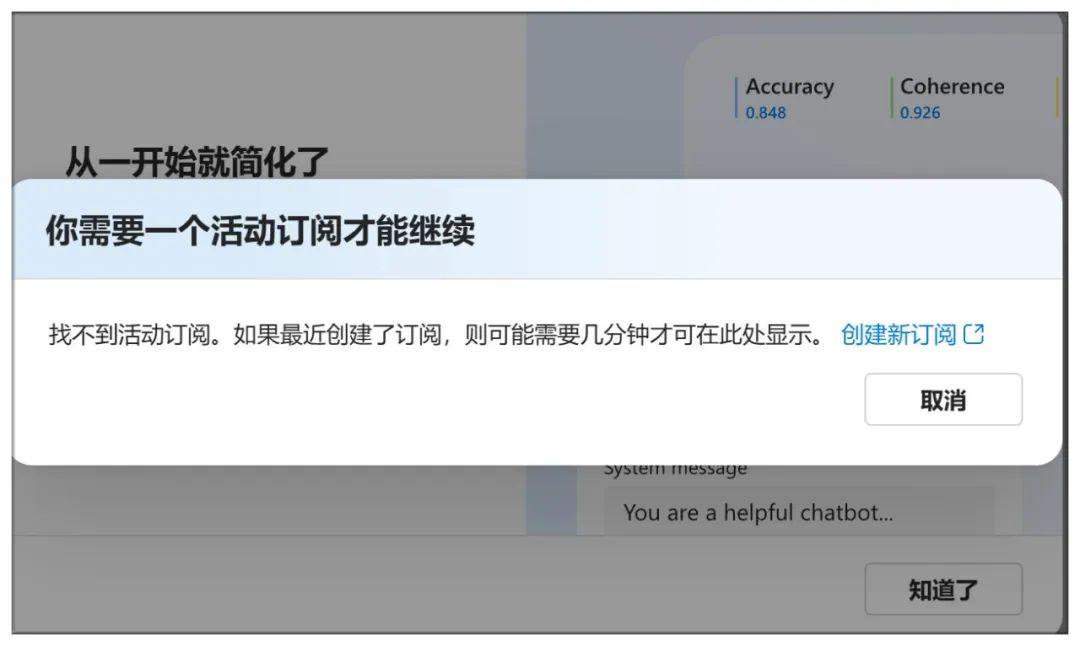

Llegar aquí no basta para crear una suscripción:

Verifique el número de teléfono móvil, así como el número de cuenta bancaria y otros datos:

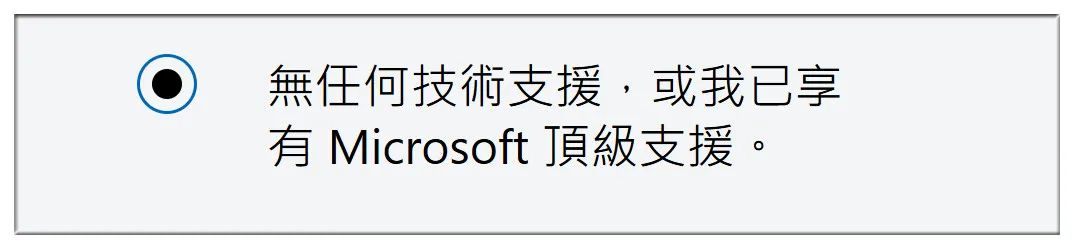

A continuación, seleccione "Sin asistencia técnica":

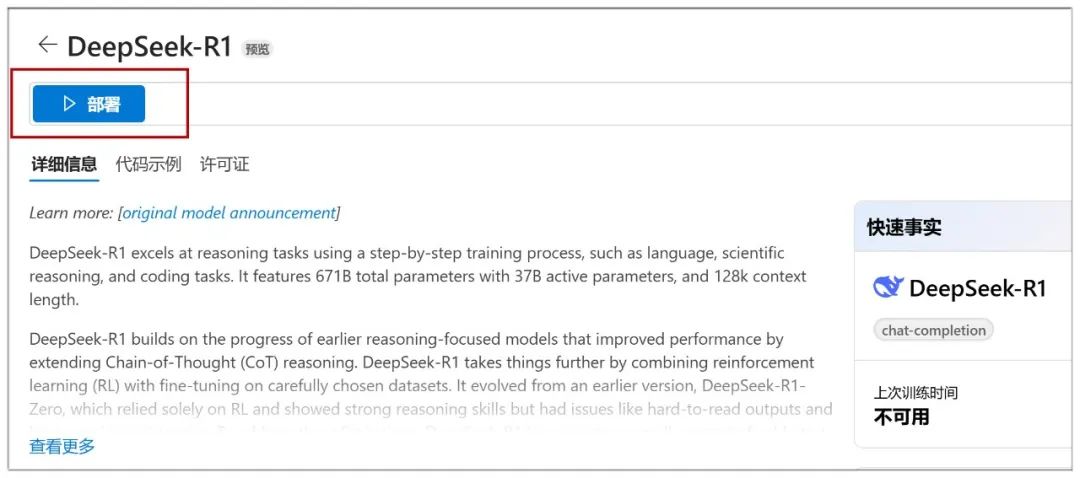

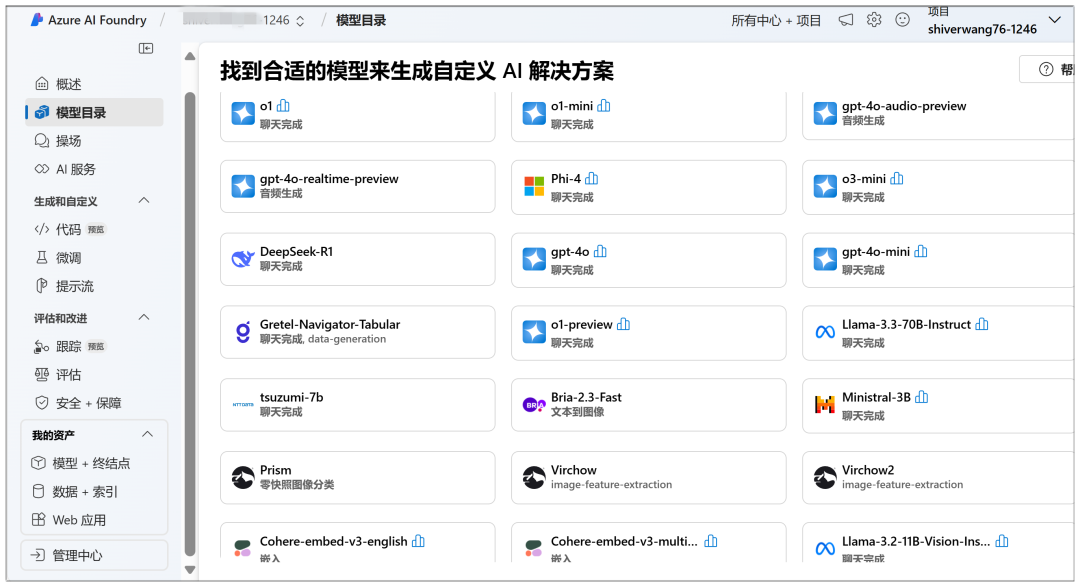

Aquí puede iniciar el despliegue en la nube, en el "Catálogo de modelos" puede ver el modelo DeepSeek-R1 de forma destacada:

Una vez hecho clic, pulse "Desplegar" en la página siguiente:

A continuación, seleccione "Crear nuevo proyecto":

A continuación, defínalos todos y haga clic en "Siguiente":

A continuación, haga clic en "Crear":

Se inicia la creación en esta página, y se tarda un poco en esperar:

Cuando hayas terminado, llegarás a esta página, donde puedes hacer clic en "Desplegar" para pasar al siguiente paso:

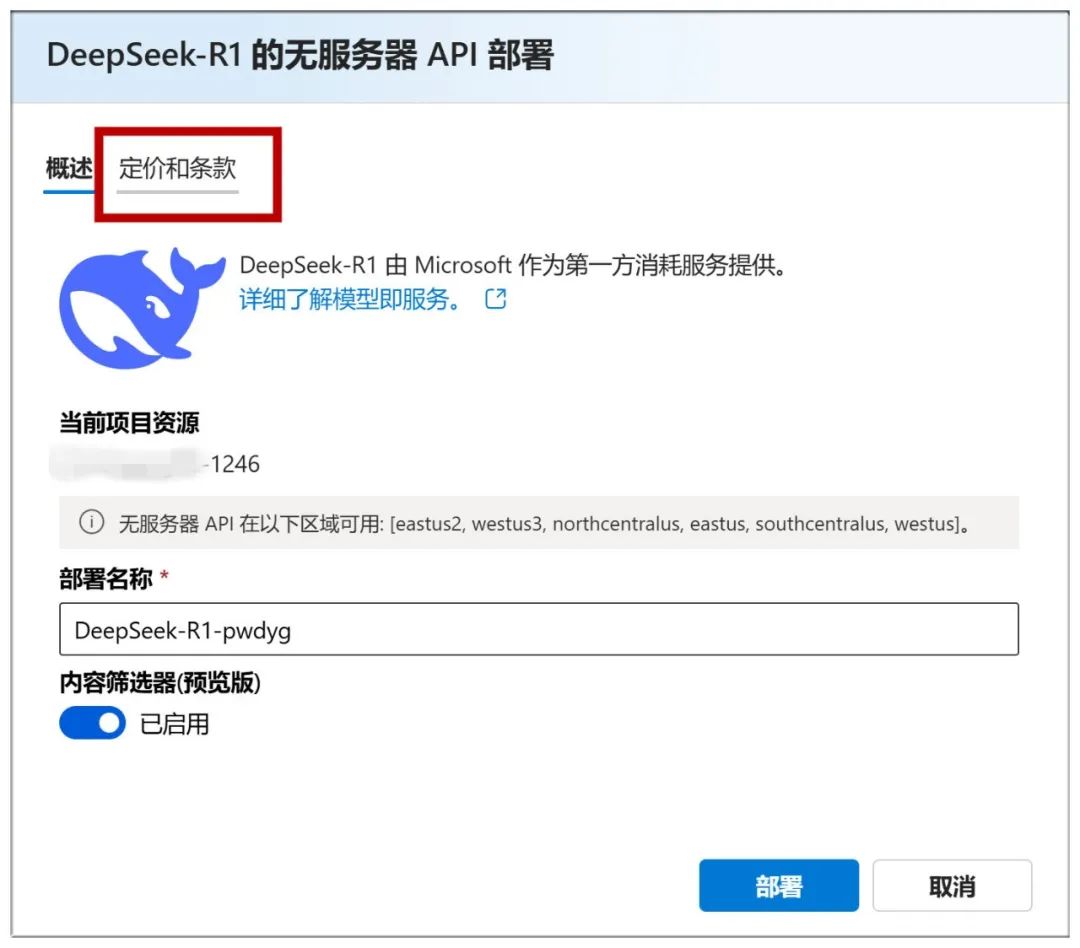

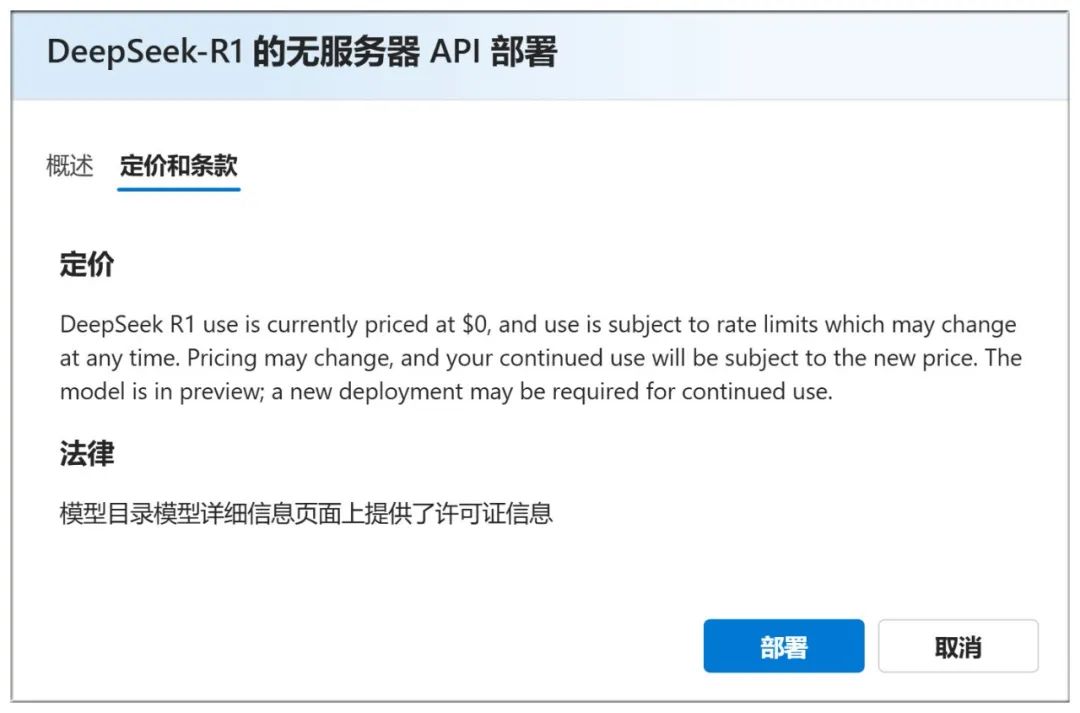

También puedes consultar la sección "Precios y condiciones" para comprobar que su uso es gratuito:

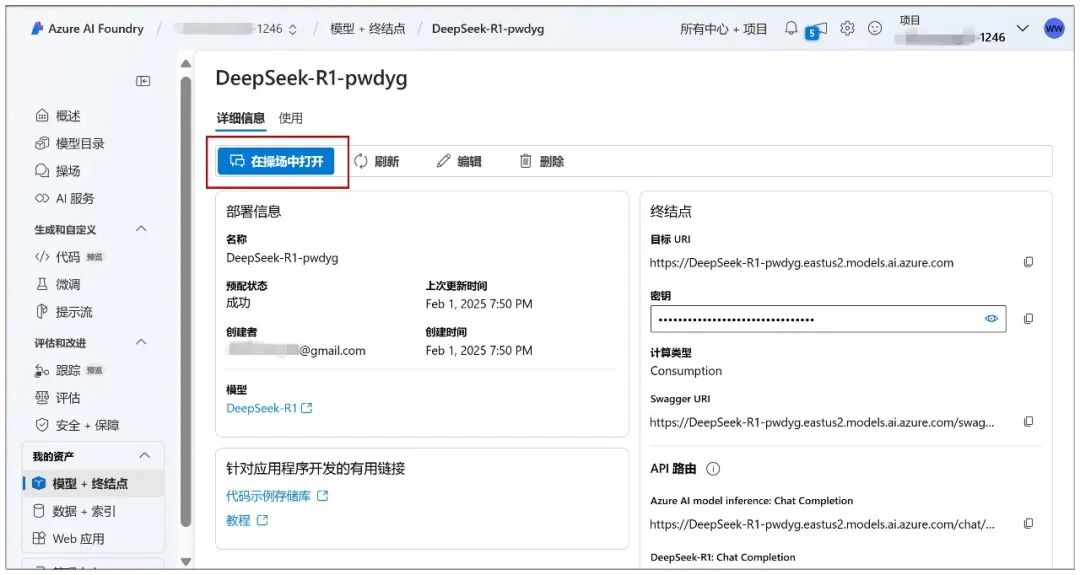

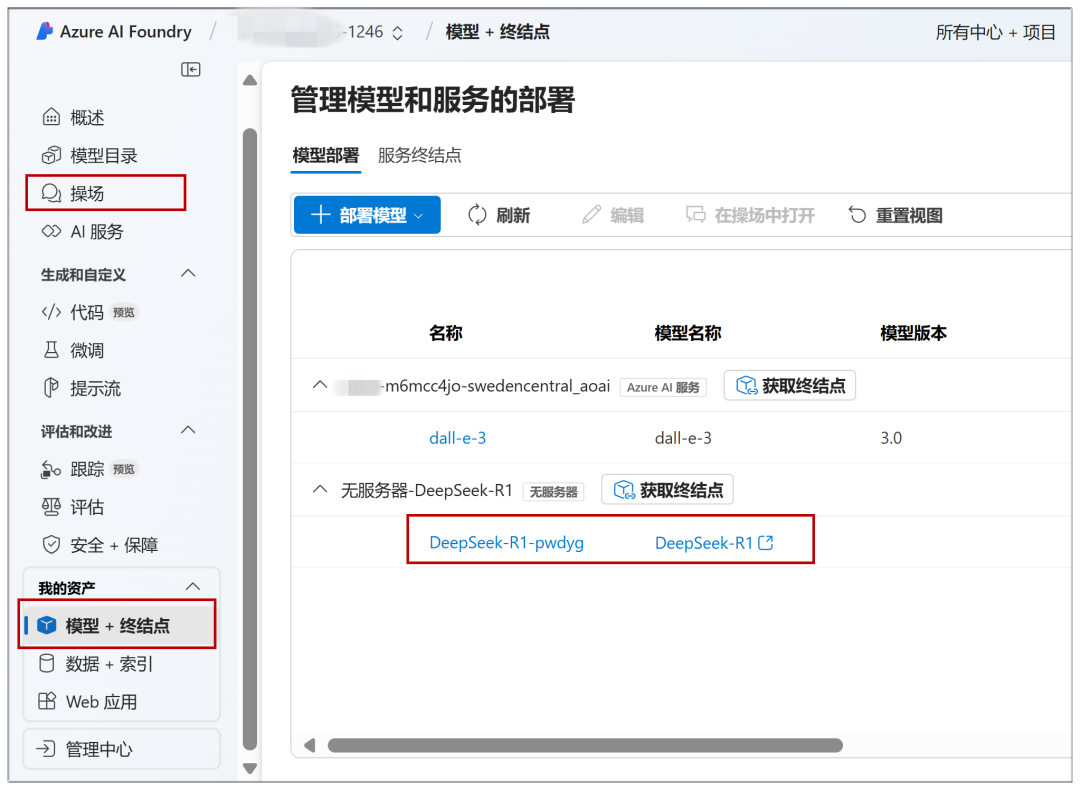

Continúe en esta página haciendo clic en "Despliegue" y podrá hacer clic en "Abrir en Playground":

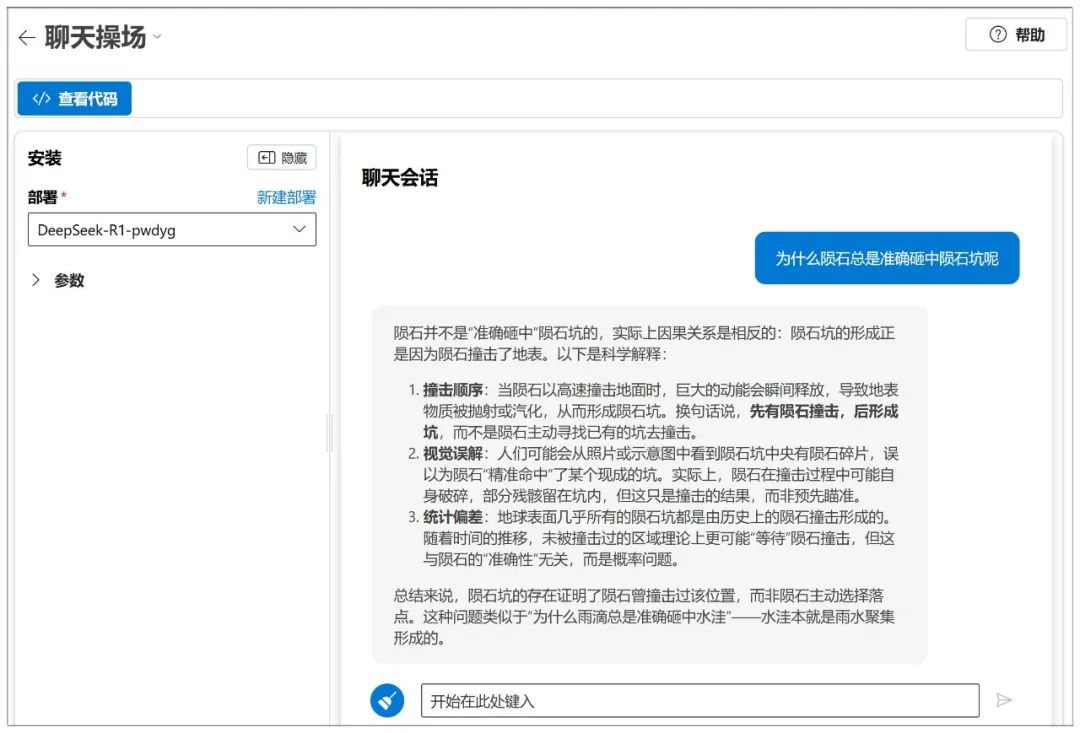

Entonces podrá comenzar el diálogo:

Azure también dispone de un ajuste de parámetros similar al de NIM:

Como plataforma, hay muchos modelos que pueden desplegarse:

Se puede acceder rápidamente a los modelos ya desplegados en el futuro a través de "Playground" o "Modelo + Endpoint" en el menú de la izquierda:

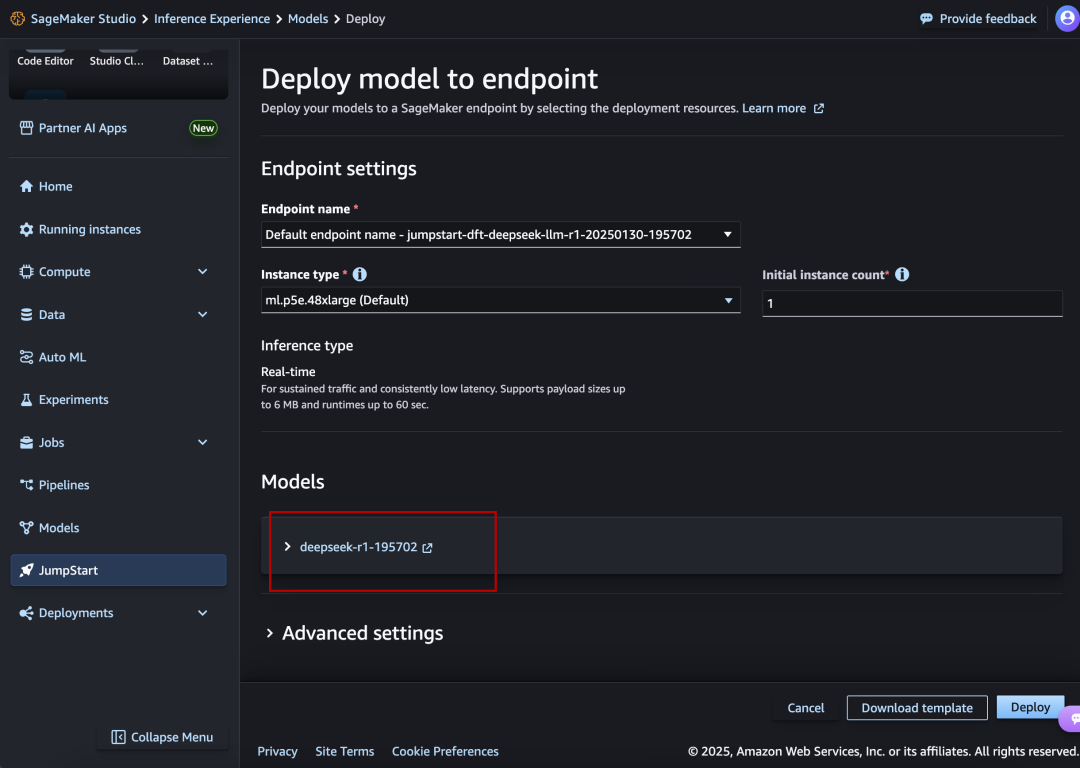

III. Amazon AWS

Página web:

https://aws.amazon.com/cn/blogs/aws/deepseek-r1-models-now-available-on-aws

DeepSeek-R1 también ocupa un lugar destacado.

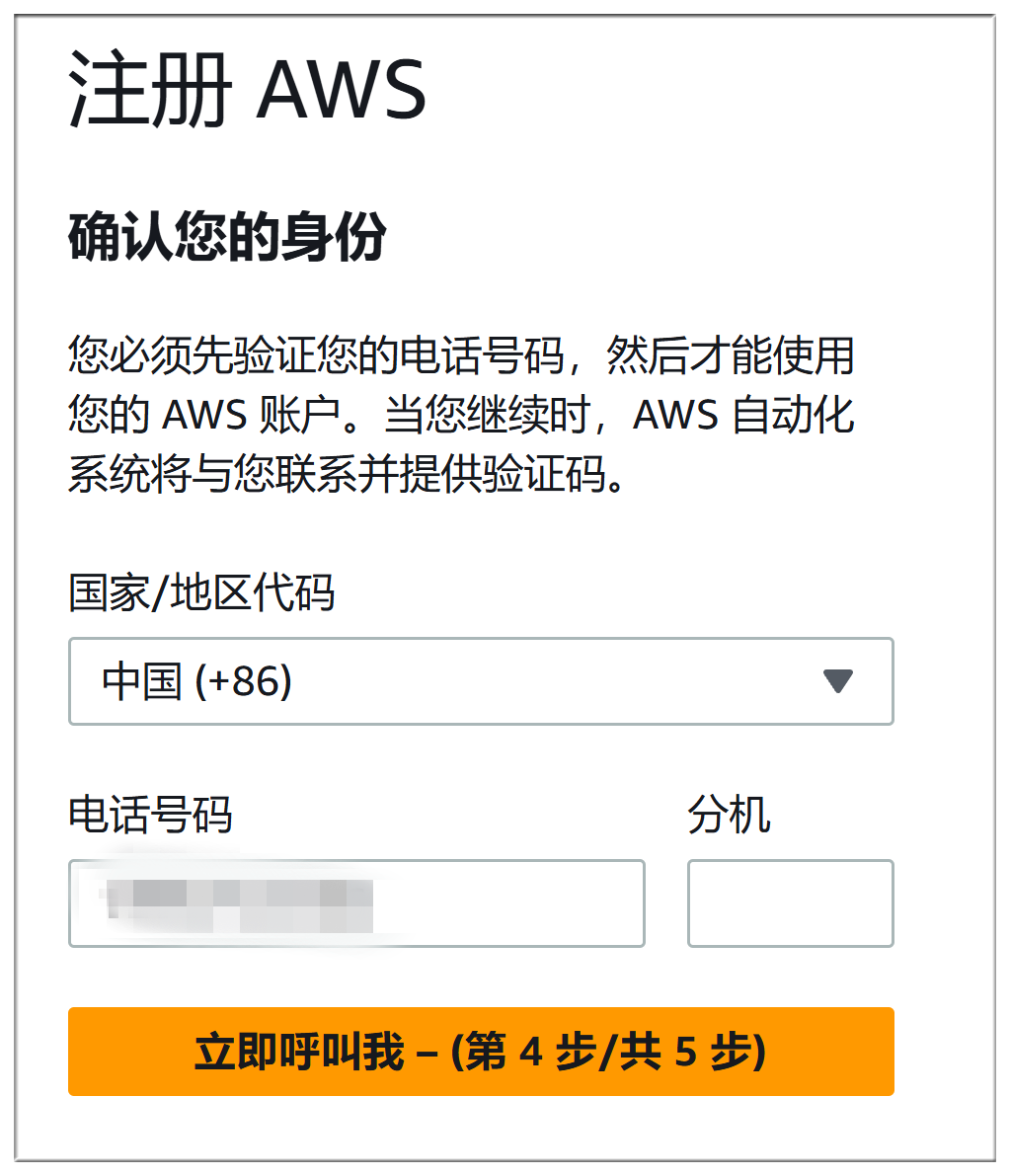

Amazon AWS proceso de registro y Microsoft Azure es casi tan problemático, ambos tienen que rellenar el método de pago, sino también la verificación telefónica + verificación de voz, aquí no se describirá en detalle:

El proceso exacto de despliegue es muy parecido al de Microsoft Azure:

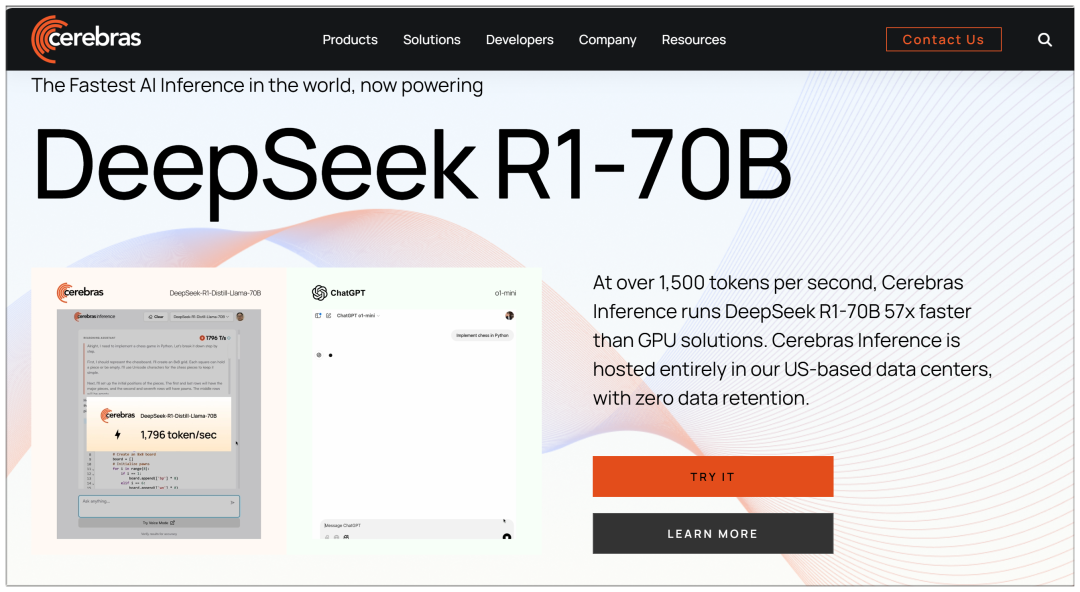

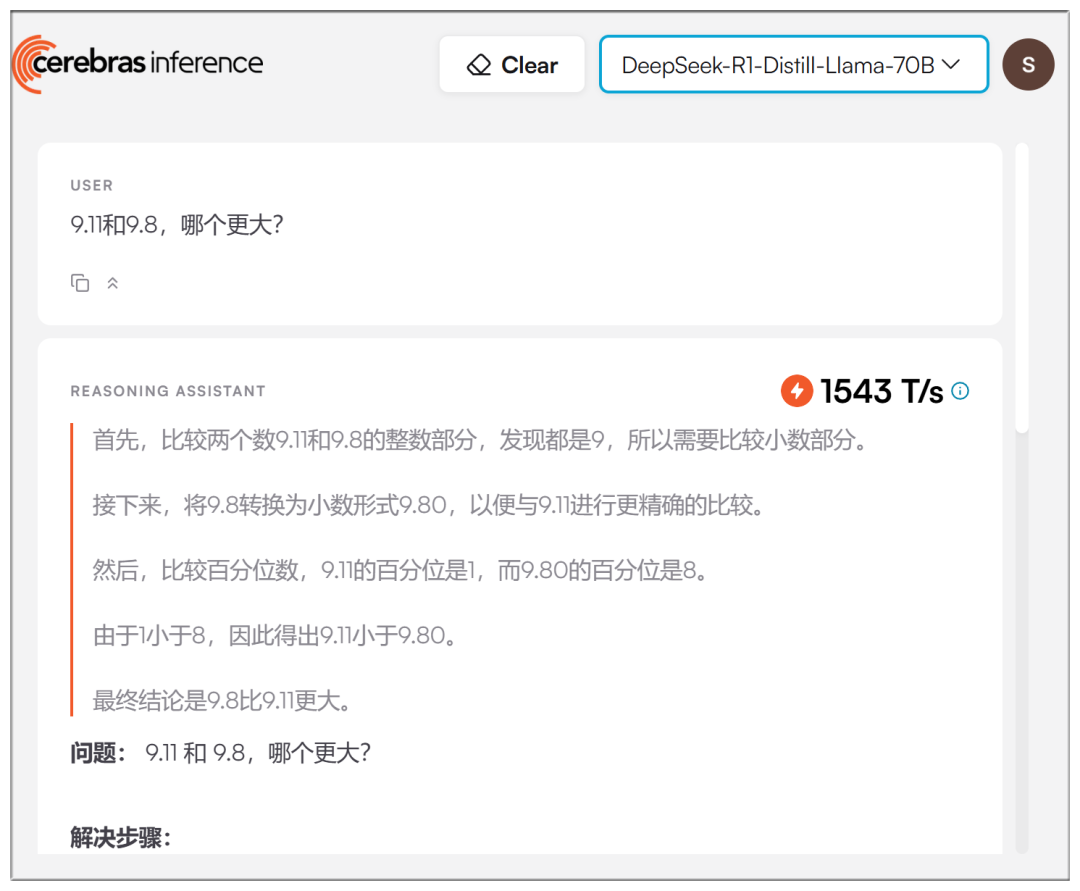

IV. Cerebras

Cerebras: la plataforma de cálculo de alto rendimiento e inferencia de IA más rápida del mundo disponible en la actualidad

Página web: https://cerebras.ai

A diferencia de otras grandes plataformas, Cerebras utiliza un modelo de 70b y afirma ser "57 veces más rápido que las soluciones de GPU":

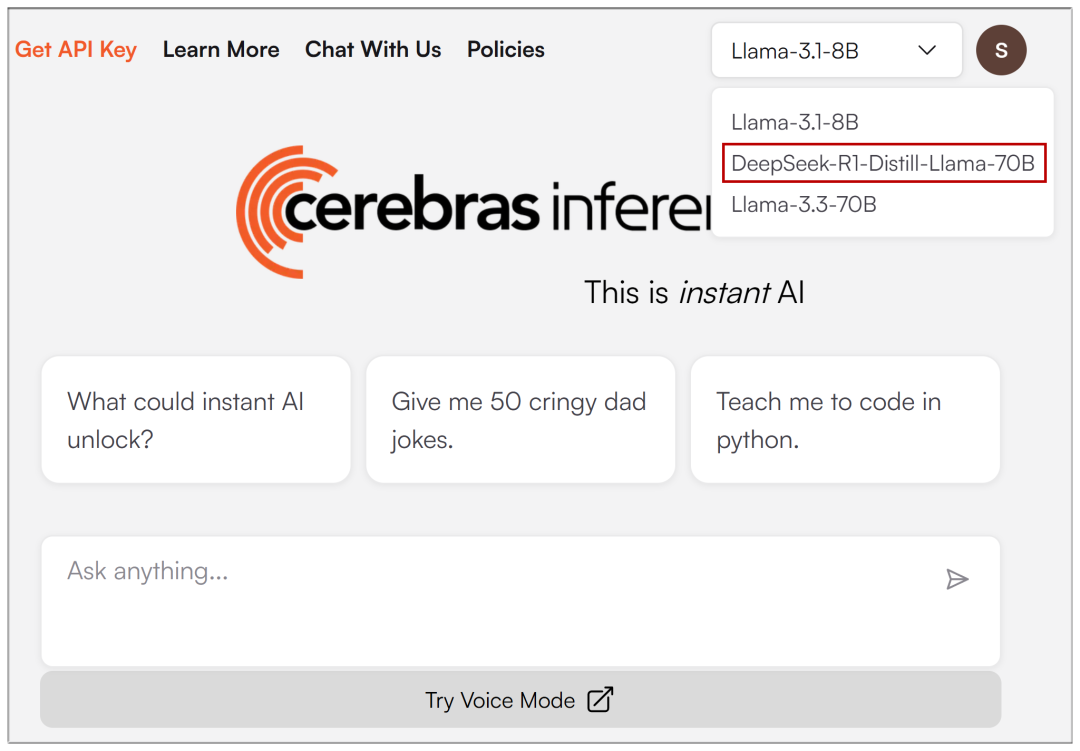

Una vez introducido el correo electrónico de registro, el menú desplegable de la parte superior permite seleccionar DeepSeek-R1:

Las velocidades en el mundo real son efectivamente más rápidas, aunque no tan exageradas como se afirma:

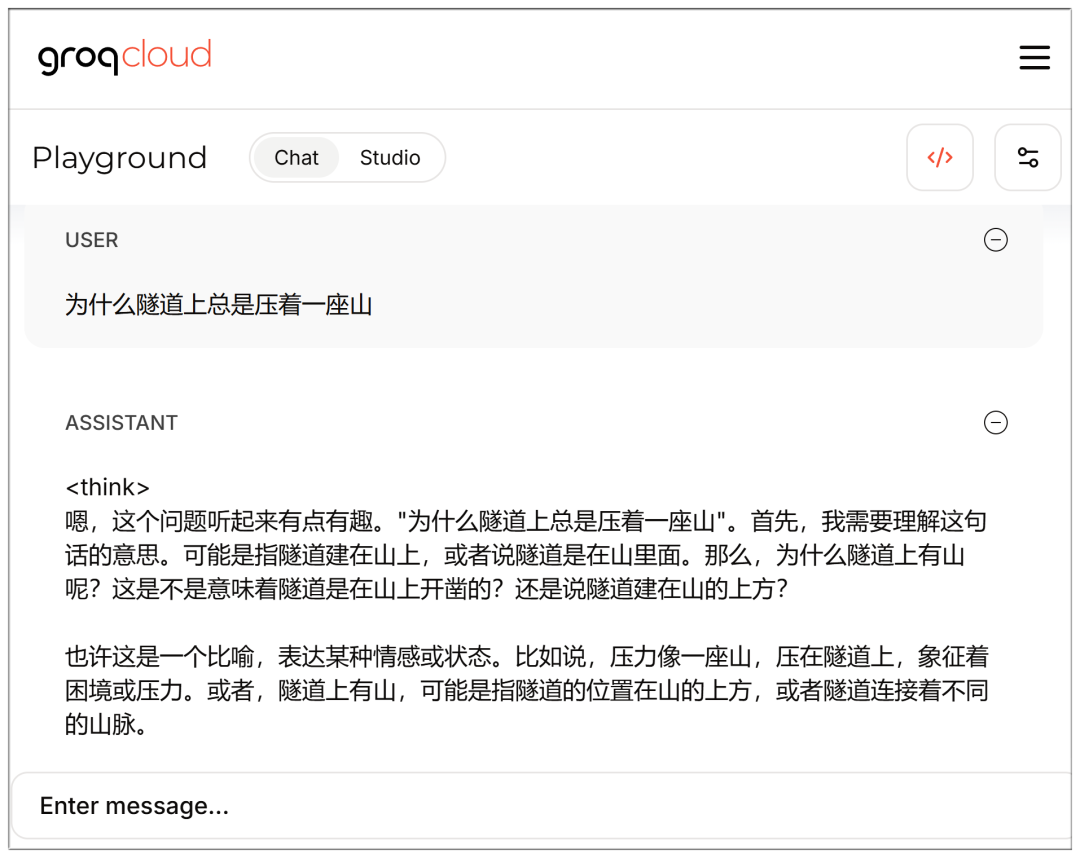

V. Groq

Groq: proveedor de soluciones de aceleración de inferencia de grandes modelos de IA, interfaz de grandes modelos gratuita y de alta velocidad

Página web: https://groq.com/groqcloud-makes-deepseek-r1-distill-llama-70b-available

Los modelos también están disponibles para su selección una vez registrado e introducido el correo electrónico:

También es rápido, pero de nuevo, 70b parece un poco más retrasado que el Cerebras?

Tenga en cuenta que puede acceder directamente a la interfaz de chat mientras está conectado:

https://console.groq.com/playground?model=deepseek-r1-distill-llama-70b

Lista completa de DeepSeek V3 y R1:

AMD

Las GPU AMD Instinct™ impulsan DeepSeek-V3: revolucionando el desarrollo de la IA con SGLang (Las GPU AMD Instinct™ impulsan DeepSeek-V3: revolucionando el desarrollo de inteligencia artificial con SGLang)

NVIDIA

Tarjeta modelo NVIDIA DeepSeek-R1 (Tarjeta modelo DeepSeek-R1 NVIDIA)

Microsoft Azure

Ejecución de DeepSeek-R1 en una única máquina virtual NDv5 MI300X (ejecutando DeepSeek-R1 en una única máquina virtual NDv5 MI300X)

Baseten

https://www.baseten.co/library/deepseek-v3/

Novita AI

Novita AI utiliza SGLang con DeepSeek-V3 para OpenRouter (Novita AI utiliza SGLang para ejecutar DeepSeek-V3 para OpenRouter)

ByteDance Volcengine

Un modelo completo de DeepSeek aterriza en Volcano Engine.

DataCrunch

Implantación de DeepSeek-R1 671B en 8x NVIDIA H200 con SGLang (Implementación de DeepSeek-R1 671B en 8x NVIDIA H200 utilizando SGLang)

Hiperbólica

https://x.com/zjasper666/status/1872657228676895185

Vultr

Cómo desplegar Deepseek V3 Large Language Model (LLM) mediante SGLang (Cómo desplegar con SGLang) Búsqueda profunda V3 Large Language Modelling (LLM))

RunPod

¿Qué hay de nuevo en el uso de LLM sin servidor en RunPod en 2025? (¿Cuáles son las nuevas características utilizadas por Serverless LLM en RunPod en 2025?)

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...