Informe de evaluación comparativa de grandes modelos chinos 2024 (SuperCLUE)

contextos

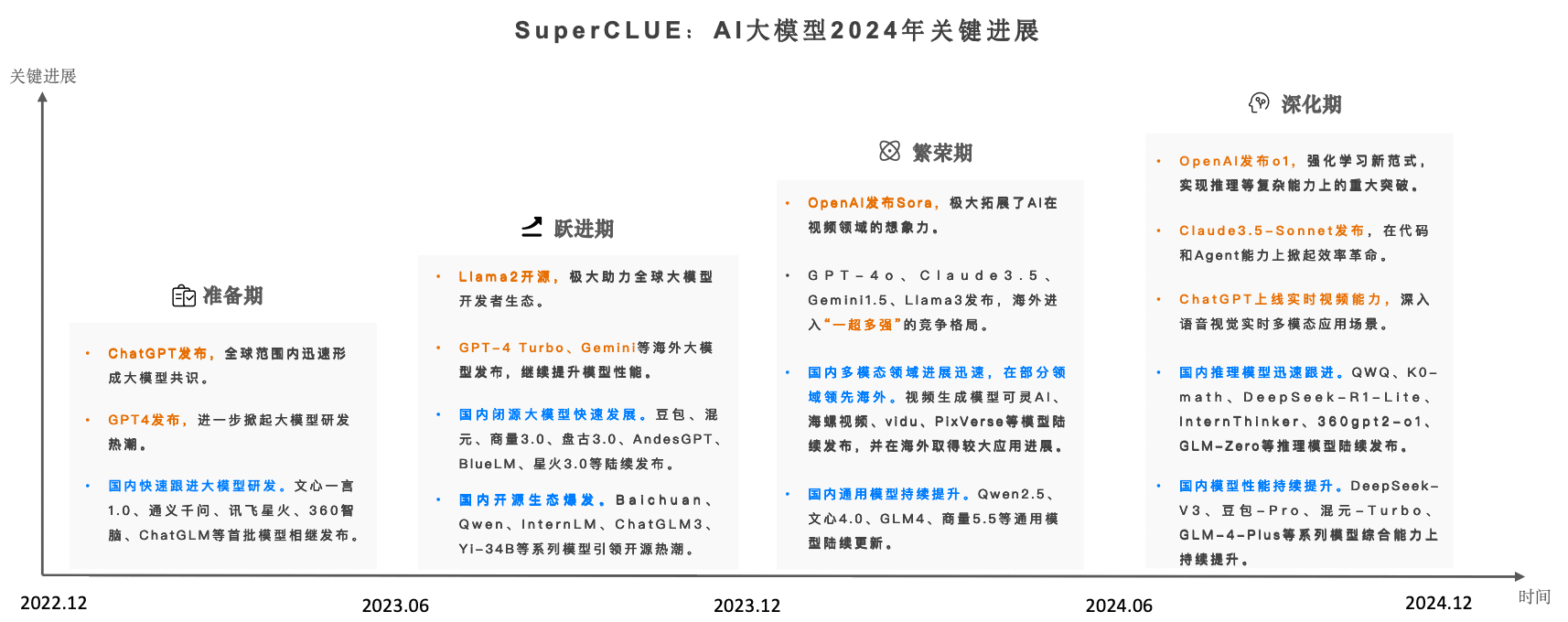

Desde 2023, los Big Models de IA han estado creando la mayor oleada de IA jamás vista a escala mundial. A medida que nos adentramos en 2024, la dinámica competitiva de la Big Model global está aumentando yCon el lanzamiento del Sora, el GPT-4o y el o1, los grandes modelos nacionales tuvieron una persecución de grandes modelos en 2024.

SuperCLUE, la referencia de evaluación de grandes modelos chinos, ha realizado un seguimiento continuo en tiempo real de la tendencia de desarrollo y el efecto global de los grandes modelos nacionales e internacionales, y se ha publicado oficialmente.Informe anual de evaluación comparativa de grandes modelos chinos 2024.

El informe completo consta de 89 páginas, este artículo sólo muestra el contenido clave del informe, la dirección completa del informe en línea (descargable):

www.cluebenchmarks.com/superclue_2024

SuperCLUE Leaderboard Dirección:

www.superclueai.com

Elementos clave del informe

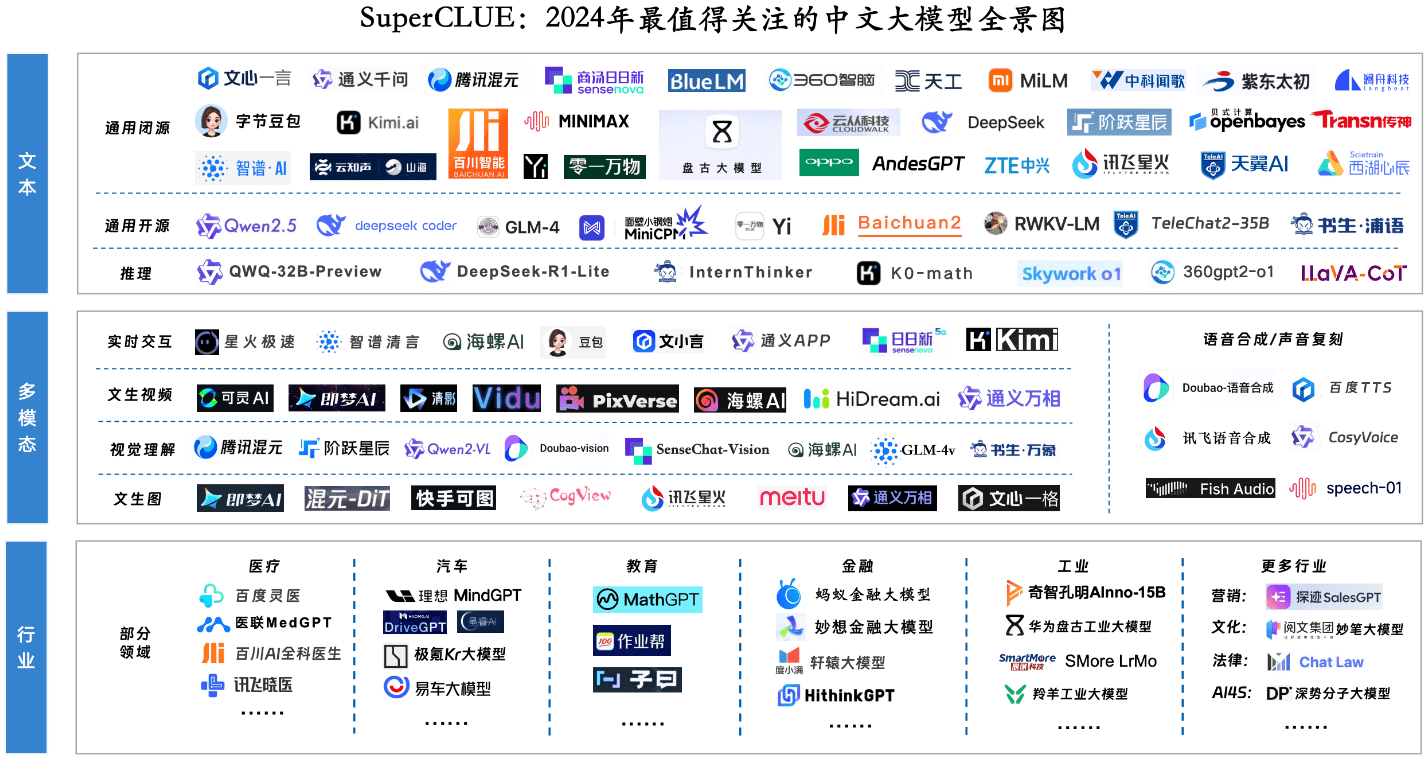

Componente clave 1: Panorama de los grandes modelos más destacados para 2024

Componente clave 2: Clasificación general anual y cuadrante de modelización

Introducción a la evaluación

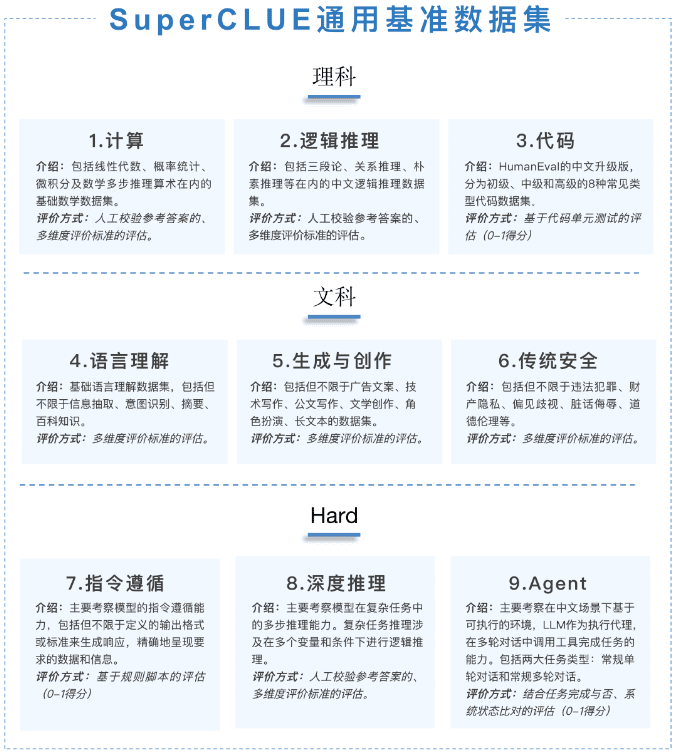

Este informe anual se centra en la Evaluación de Competencias Generales (GCA), que consta de tres dimensiones: Ciencias, Artes y Destrezas.Todas las preguntas son nuevas y originalescon un total de 1 325 preguntas de respuesta corta en varias rondas.

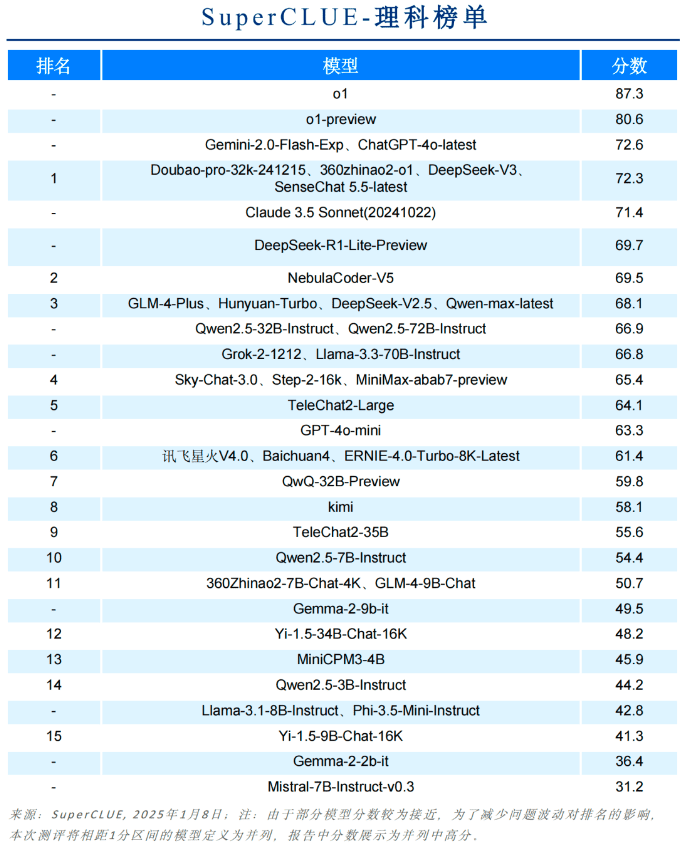

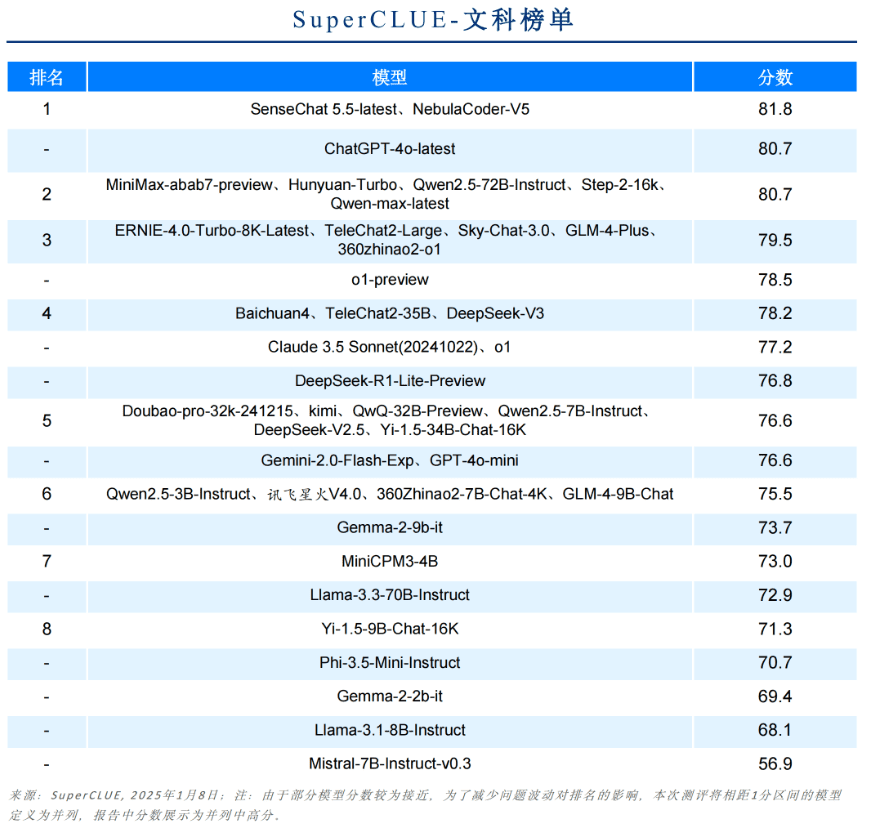

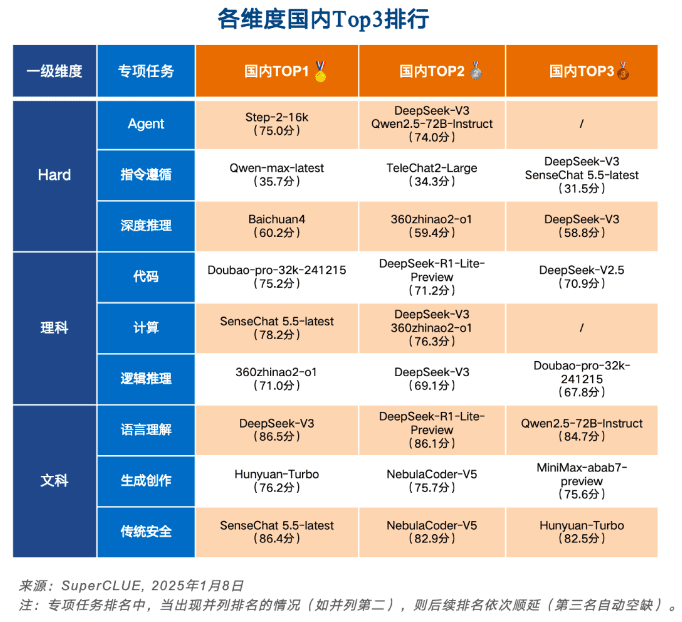

Las [Tareas Científicas] se dividen en conjuntos de Computación, Razonamiento Lógico y Evaluación de Códigos; las [Tareas Artísticas] se dividen en conjuntos de Comprensión del Lenguaje, Creación Generativa y Evaluación de la Seguridad; y las [Tareas Difíciles] se dividen en conjuntos de Seguimiento de Instrucciones, Razonamiento Profundo y Evaluación de Agentes.

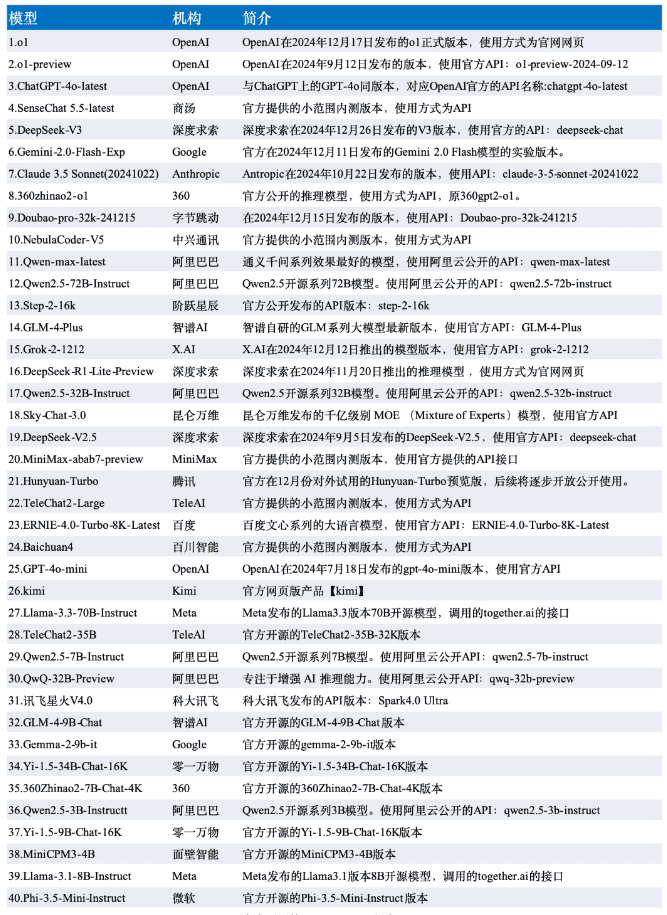

Los datos de esta evaluación se seleccionan a partir de los resultados de la evaluación SuperCLUE-diciembre, y el modelo se selecciona entre los 42 grandes modelos representativos nacionales y extranjeros de la versión de diciembre.

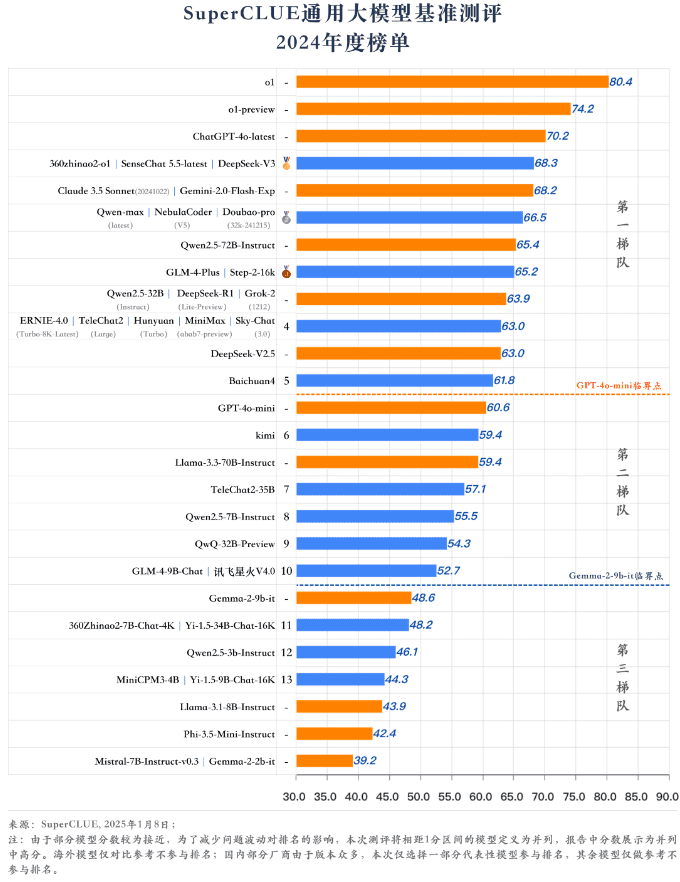

tabla clasificatoria

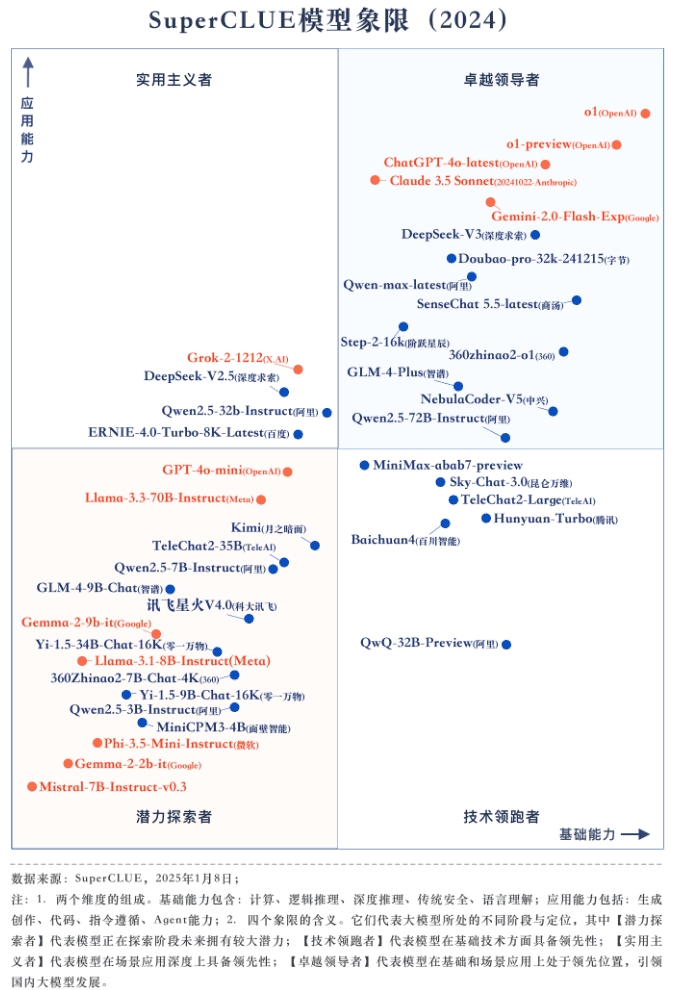

Modelo anual cuadrante

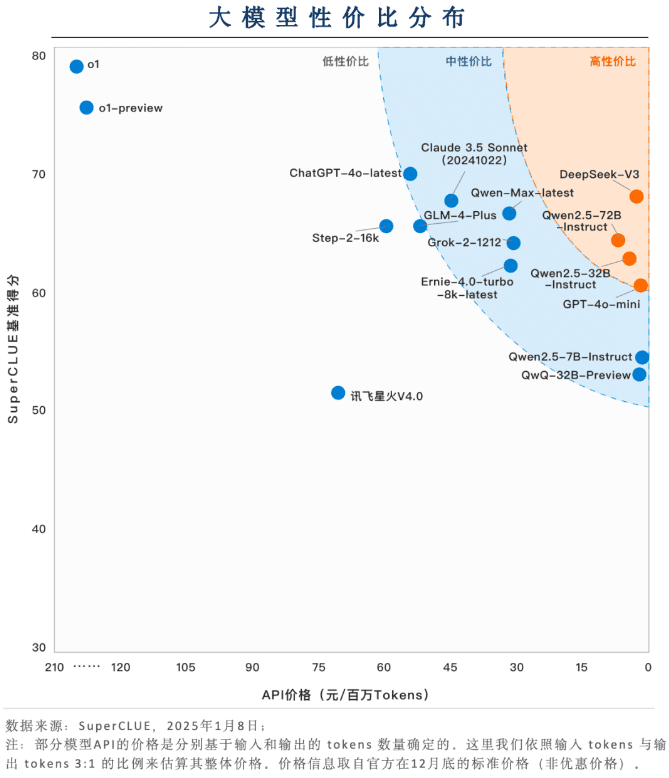

Elemento clave 3: Distribución de zonas de rentabilidad

Los grandes modelos nacionales tienen una gran ventaja en cuanto a relación calidad-precio (precio + eficacia)

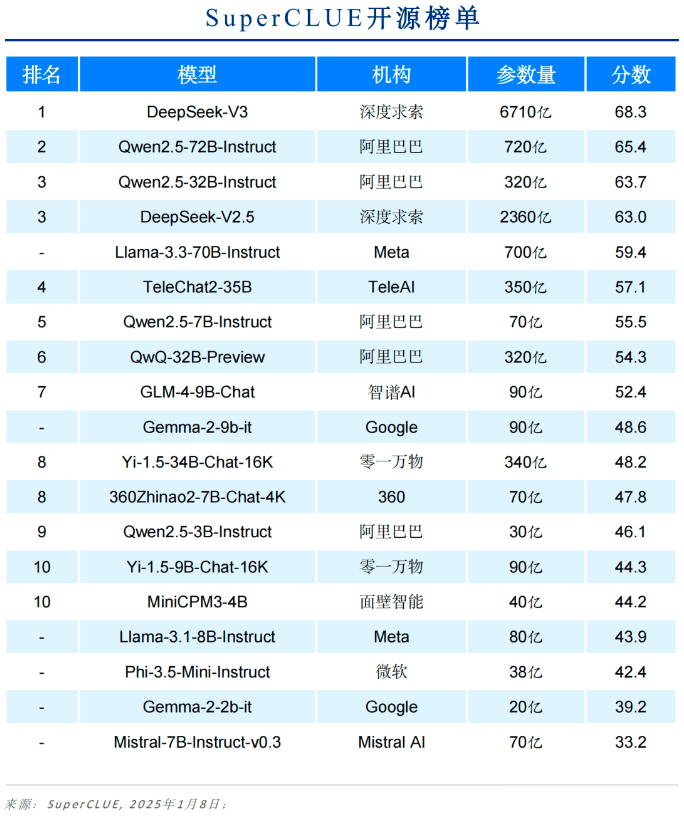

Los grandes modelos nacionales como DeepSeek-V3, Qwen2.5-72B-Instruct y Qwen2.5-32B-Instruct muestran una gran competitividad en términos de relación calidad-precio. Sobre la base de un nivel relativamente alto de capacidad puede mantener un coste de aplicación muy bajo, en la aplicación de aterrizaje para mostrar una facilidad de uso amigable.

La mayoría de los modelos tienen una relación calidad-precio media

La mayoría de los modelos siguen teniendo un precio elevado para mantener un alto nivel de capacidad. Por ejemplo, GLM-4-Plus, Qwen-Max-latest, Claude 3.5 Sonnet y Grok-2-1212 tienen un precio superior a 30 dólares por millón de fichas.

o1 y otros modelos de inferencia tienen más margen de optimización en términos de rentabilidad

Aunque o1 y o1-preview muestran un alto nivel de capacidad, son varias veces más caros que otros modelos en términos de precio. Cómo reducir el coste podría convertirse en un requisito previo para el uso generalizado de los modelos de inferencia.

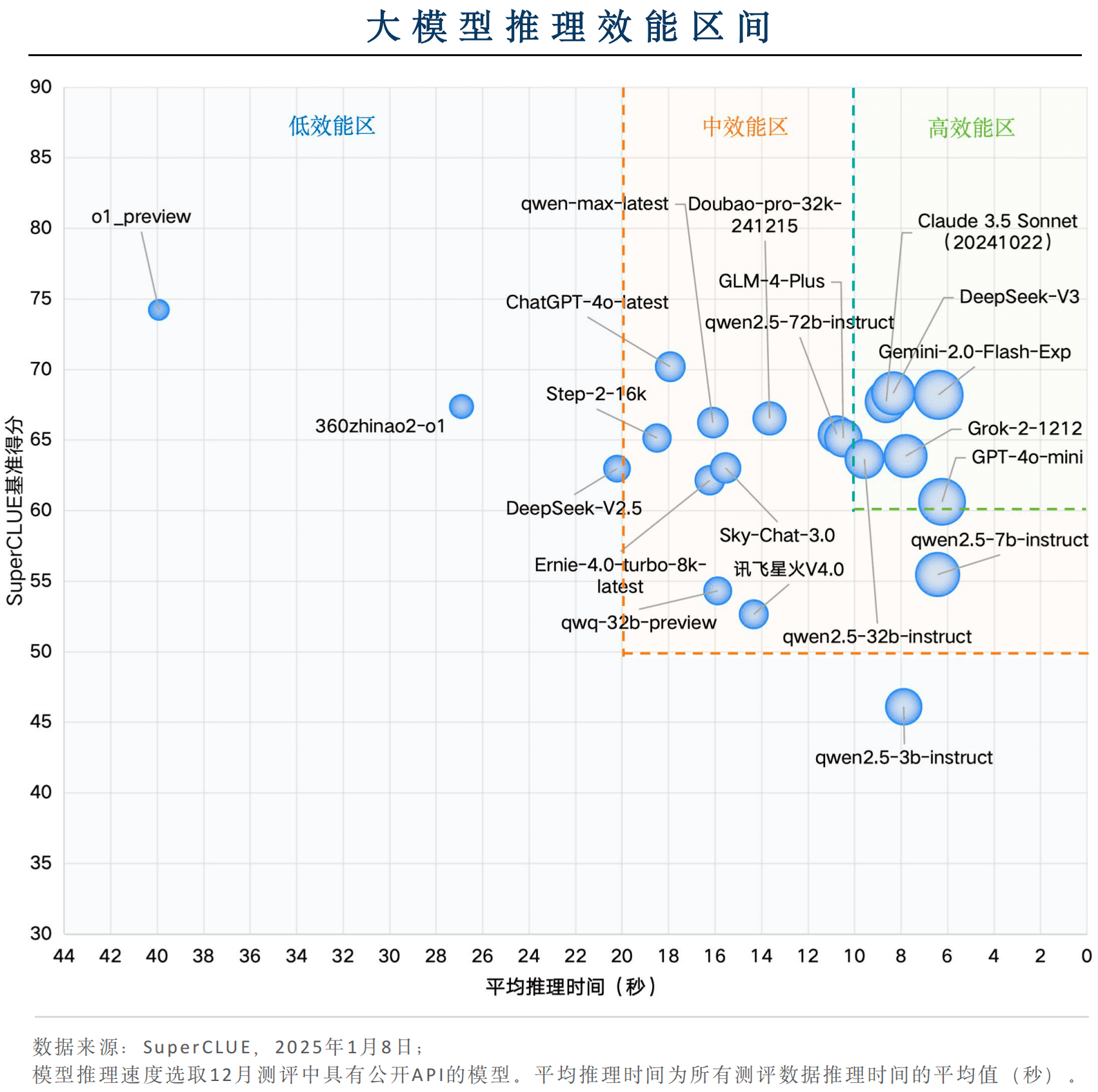

Componente clave 4: Razonamiento sobre la distribución de los intervalos de eficiencia

Algunos modelos nacionales son competitivos en términos de eficacia general

Entre los modelos nacionales, DeepSeek-V3 y Qwen2.5-32B-Instruct tienen una velocidad de inferencia excelente, con un tiempo medio de inferencia inferior a 10 s por pregunta, y al mismo tiempo, las puntuaciones de los benchmarks son superiores a 60, lo que está en línea con la "zona de alto rendimiento" y muestra una gran eficacia de la aplicación.

Gemini-2.0-Flash-Exp lidera el rendimiento mundial de las aplicaciones de grandes modelos

Los modelos de ultramar Gemini-2.0-Flash-Exp, Claude 3.5 Sonnet (20241022), Grok-2-1212 y GPT-4o-mini se clasifican en la "zona de alto rendimiento", siendo Gemini-2.0-Flash-Exp el que obtiene los mejores resultados en términos de eficacia combinada en cuanto a tiempo de inferencia y puntuación de referencia. GPT-4o-mini obtiene los mejores resultados en términos de velocidad de inferencia.

modelo de inferenciaHay mucho margen de optimización en términos de rendimiento.

Aunque el modelo de inferencia representado por o1-preview obtiene buenos resultados en la puntuación de referencia, el tiempo medio de inferencia por pregunta es de unos 40s, y el rendimiento global es coherente con la "zona de bajo rendimiento". Para disponer de una amplia gama de escenarios de aplicación, el modelo de inferencia debe centrarse en mejorar su velocidad de inferencia.

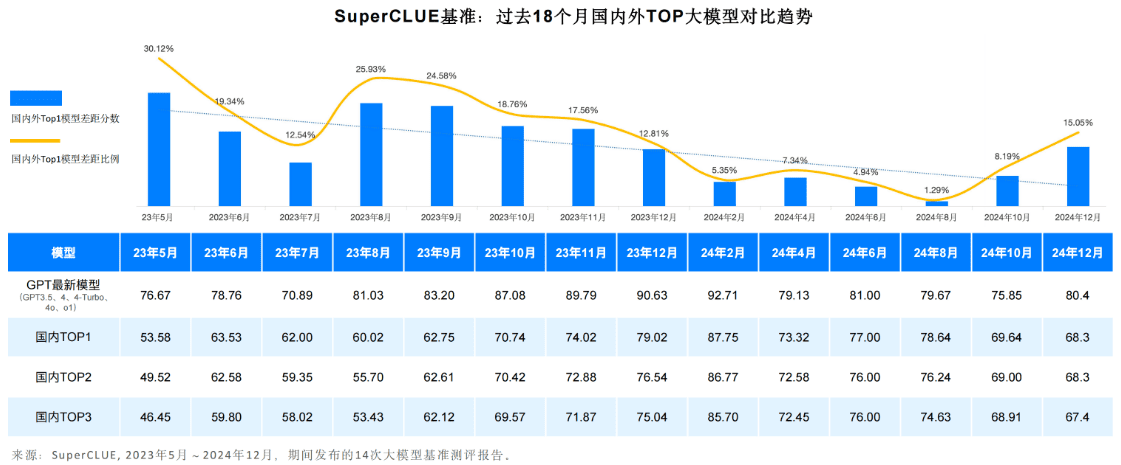

Componente clave 5: Grandes lagunas y tendencias en la modelización nacional e internacional, 2024

La tendencia general es que la brecha entre las capacidades genéricas del primer nivel de grandes modelos nacionales y extranjeros en el ámbito chino es cada vez mayor.

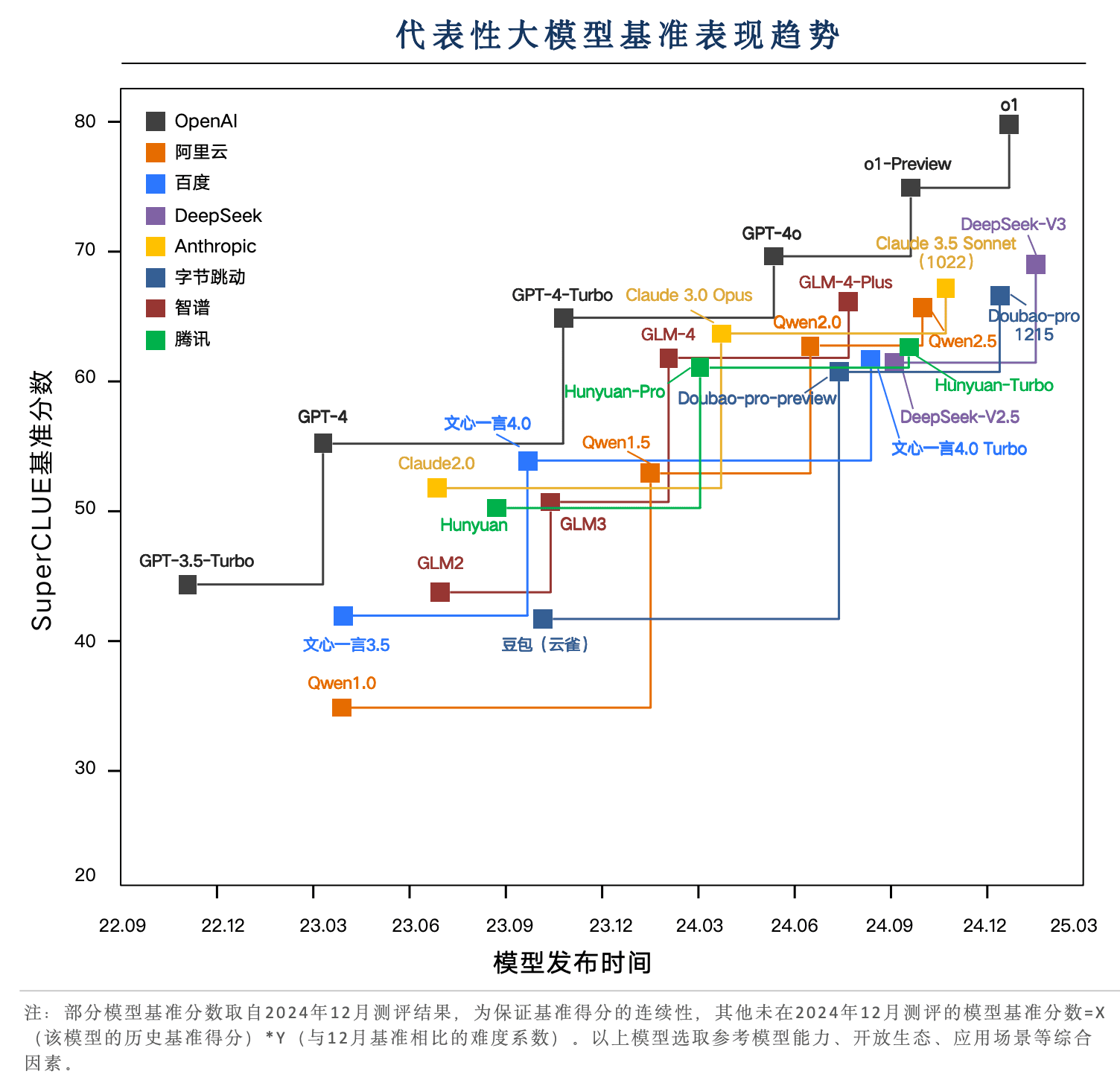

Desde mayo de 2023 hasta la actualidad, las capacidades de los grandes modelos nacionales y extranjeros han seguido desarrollándose. Entre ellos, los mejores modelos de ultramar representados por la serie GPT de modelos han pasado por múltiples iteraciones de GPT3 . 5, GPT4, GPT4 - Turbo, GPT4o, o1 de múltiples versiones de actualizaciones iterativas.

El modelo nacional también pasó por un ciclo de iteración agitado de 1 8 meses, reduciendo la diferencia de 0,121 TP3T en mayo de 2 0 2 3 a 1,291 TP3T en agosto de 2024. pero con la publicación de o1, la diferencia se amplió de nuevo a 15,051 TP3T.

Los modelos nacionales representados por DeepSeek-V3 se acercan mucho a GPT-4o-latest

En los últimos 2 años, los modelos representativos nacionales han sido iterados en varias versiones, DeepSeek-V3, Doubao-pro, GLM-4-Plus, y Qwen2.5 han estado cerca de GPT-4o en las tareas chinas, entre los cuales DeepSeek-V3 ha tenido un buen rendimiento, superando el rendimiento de Claude 3.5 Sonnet en la evaluación de diciembre.

o1 Modelo de razonamiento basado en el nuevo paradigma del aprendizaje por refuerzo, que supera los 80 puntos y amplía la diferencia entre los mejores modelos nacionales y extranjeros.

En la evaluación SuperCLUE de diciembre, los principales modelos de gran cabeza nacionales y extranjeros en las puntuaciones de referencia SuperCLUE se concentran en 60-70 puntos. o1 y o1-preview basado en el nuevo paradigma de modelo de inferencia de aprendizaje por refuerzo se convierten en una importante tecnología representativa del avance del cuello de botella de 70 puntos, especialmente la versión formal de o1 del avance de la marca de 80 puntos, mostrando una gran ventaja de liderazgo.

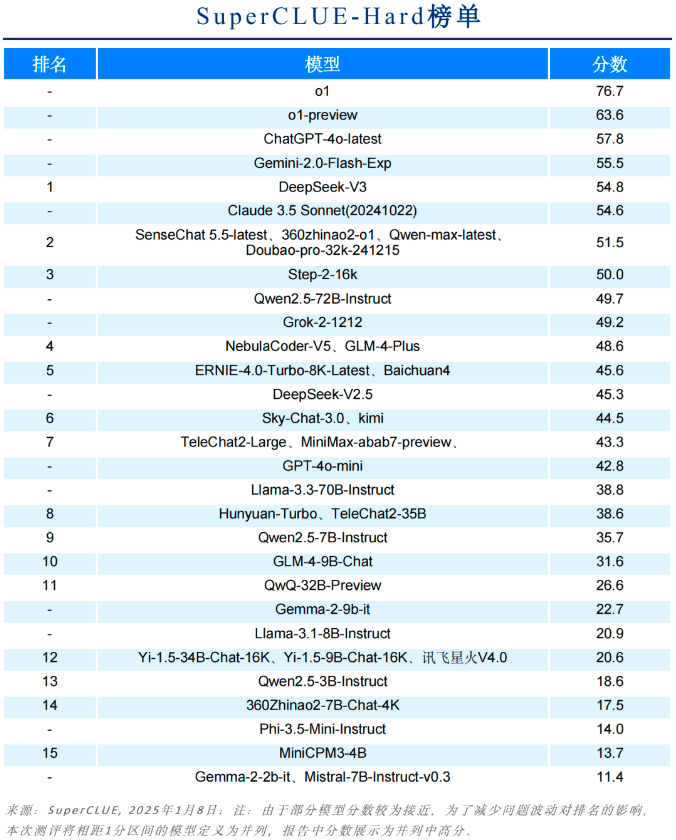

Elemento clave 6: Otras listas de subdimensiones

Lista dura

Lista de materias científicas

Lista de Artes Liberales

Los 3 primeros de China en cada dimensión

Lista de modelos de código abierto

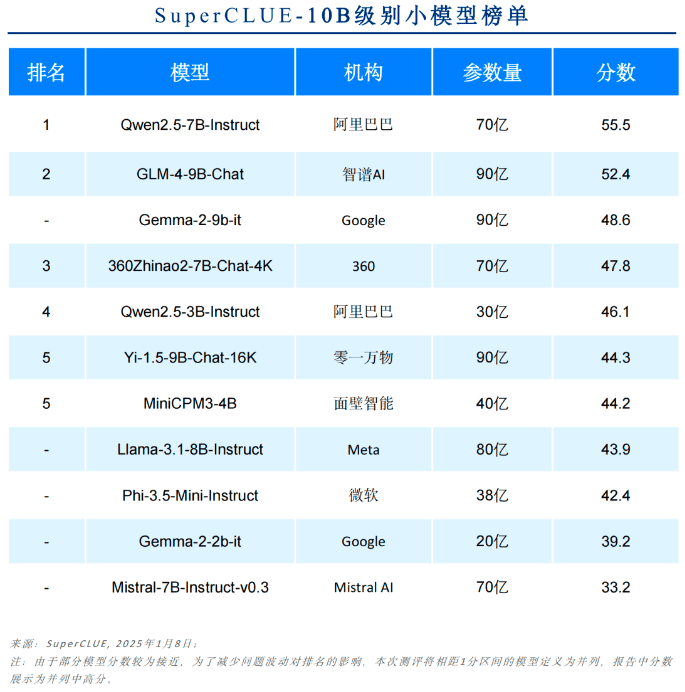

Lista de modelos hasta 10B

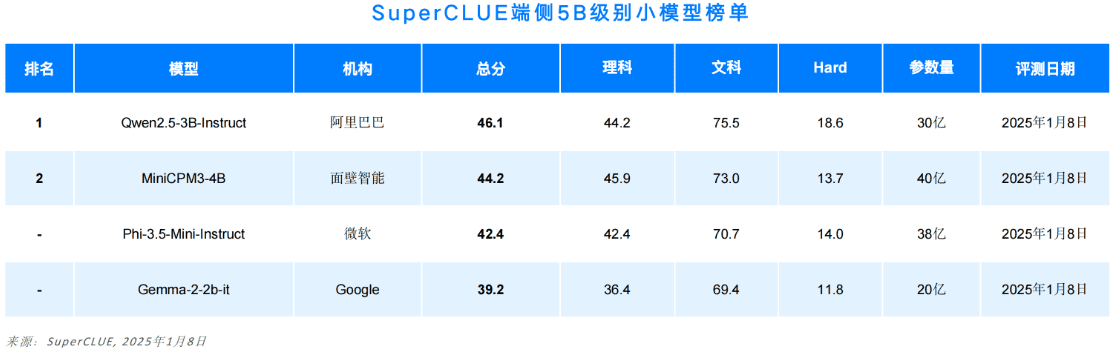

Lista de modelos de terminales hasta 5B

Lista de puntuaciones finas secundarias

Debido a la limitación de espacio, este documento sólo muestra una parte del informe. El contenido completo incluye la metodología de evaluación, ejemplos de evaluación, listas de subtareas, multimodalidad, aplicaciones e introducción a los parámetros de inferencia.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...