2024 Los 10 mejores frameworks RAG de Github

La generación mejorada por recuperación (RAG) se ha revelado como una potente técnica para mejorar las capacidades de los grandes modelos lingüísticos.

RAG Los marcos combinan las ventajas de los sistemas basados en la recuperación y los modelos generativos para producir respuestas más precisas, conscientes del contexto y oportunas. A medida que crece la demanda de soluciones de IA sofisticadas, han surgido en GitHub varios marcos de GAR de código abierto, cada uno con características y funcionalidades únicas. ¿Cuáles son las características de los marcos RAG?

Flujo de trabajo RAG excesivamente simplificado

Búsqueda Generación mejorada(RAG) es un marco de inteligencia artificial que mejora las capacidades de los modelos lingüísticos a gran escala (LLM) mediante la integración de fuentes de conocimiento externas.

El GAR recupera información relevante de la base de conocimientos y la utiliza para aumentar las entradas del LLM, lo que permite al modelo generar respuestas más precisas, actualizadas y contextualmente relevantes.

Este enfoque ayuda a superar limitaciones como los plazos de conocimiento y reduce el riesgo de alucinaciones en el resultado del LLM.

¿Por qué no puedo utilizar LangChain?

Aunque LangChain es una potente herramienta para construir aplicaciones LLM, no es un sustituto directo de RAG; más bien, LangChain puede utilizarse para implementar un sistema RAG. He aquí algunas razones por las que necesitas RAG además de LangChain:

- Conocimientos externosEl GAR permite incorporar a los datos de entrenamiento del LLM información específica del dominio o actualizada que de otro modo no existiría.

- Mayor precisiónLa GAR, al reaccionar a partir de la información recuperada, puede reducir significativamente los errores y las ilusiones.

- personalizaciónRAG: permite personalizar las respuestas para conjuntos de datos o bases de conocimientos específicos, lo que es fundamental para muchas aplicaciones empresariales.

- transparenciaEl RAG facilita el seguimiento de la fuente de información utilizada para generar la respuesta, mejorando así la auditabilidad.

Esencialmente, LangChain proporciona las herramientas y abstracciones para construir aplicaciones LLM, mientras que RAG es una técnica específica que puede implementarse utilizando LangChain para mejorar la calidad y fiabilidad de la salida LLM.

Los 10 mejores marcos RAG de GitHub

En este artículo, exploraremos los 10 mejores frameworks RAG disponibles actualmente en GitHub. Estos frameworks representan la vanguardia de la tecnología RAG y merece la pena que los desarrolladores, investigadores y organizaciones que buscan implementar o mejorar sus aplicaciones impulsadas por IA los investiguen.

1. Pajar

Clasificación por estrellas en GitHub: 14,6k estrellas

Haystack es un marco potente y flexible para crear sistemas integrales de búsqueda y respuesta a preguntas. Tiene una arquitectura modular que permite a los desarrolladores crear fácilmente canalizaciones para diversas tareas de PLN, como la recuperación de documentos, la respuesta a preguntas y el resumen:

- Compatibilidad con varios almacenes de documentos (Elasticsearch, FAISS, SQL, etc.)

- Integración con modelos lingüísticos populares (BERT, RoBERTa, DPR, etc.)

- Arquitectura escalable para gestionar un gran número de archivos

- API fácil de usar para crear canalizaciones de PLN personalizadas

La versatilidad de Haystack y su amplia documentación lo convierten en una opción excelente para principiantes y desarrolladores experimentados que implanten sistemas RAG.

https://github.com/deepset-ai/haystack

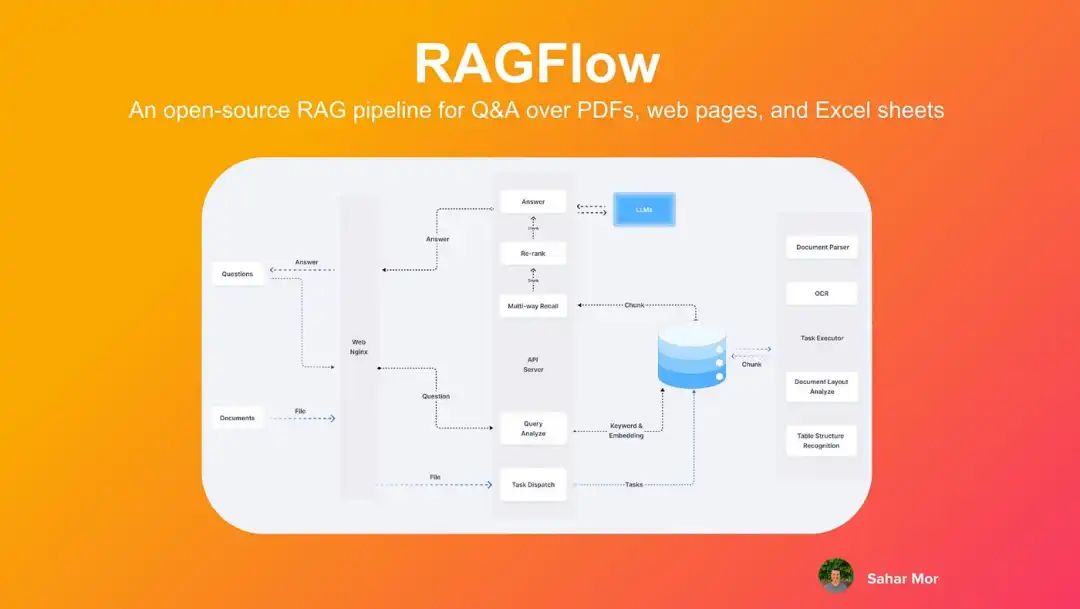

2. RAGFlow

Puntuación en GitHub: 11.6k

RAGFlow es relativamente nuevo en el ámbito de las aplicaciones RAG, pero está ganando adeptos rápidamente gracias a su enfoque en la simplicidad y la eficiencia. El objetivo del marco es simplificar el proceso de creación de aplicaciones basadas en RAG proporcionando un conjunto de componentes y flujos de trabajo predefinidos:

- Interfaz intuitiva de diseño del flujo de trabajo

- Canalización RAG preconfigurada para casos de uso comunes

- Integración con bases de datos vectoriales populares

- Compatibilidad con modelos integrados personalizados

La facilidad de uso de RAGFlow lo convierte en una opción atractiva para los desarrolladores que desean crear e implantar rápidamente prototipos de aplicaciones RAG sin tener que profundizar en la complejidad subyacente.

https://github.com/infiniflow/ragflow

3. Txtai

Estrellas de GitHub: 7.5k

txtai es una plataforma de datos de IA versátil que va más allá del marco tradicional de RAG. Ofrece un completo conjunto de herramientas para crear búsquedas semánticas, flujos de trabajo de modelado lingüístico y canales de procesamiento de documentos:

- Base de datos integrada para una búsqueda eficaz de similitudes

- API para integrar modelos lingüísticos y otros servicios de IA

- Arquitectura extensible para flujos de trabajo personalizados

- Compatibilidad con varios idiomas y tipos de datos

El enfoque "todo en uno" de txtai lo convierte en una opción excelente para las organizaciones que desean implantar una amplia gama de capacidades de IA dentro de un único marco.

https://github.com/neuml/txtai

4. TORMENTA

Puntuación en GitHub: 5.000 estrellas

Modelos RAG de código abierto de Stanford

Modelos RAG de código abierto de Stanford

STORM (Stanford Open Source RAG Model) es un marco RAG orientado a la investigación desarrollado en la Universidad de Stanford. Puede que STORM tenga menos estrellas que otros marcos, pero su formación académica y su enfoque en tecnologías punteras lo convierten en un valioso recurso para investigadores y desarrolladores interesados en los últimos avances de la tecnología GAR:

- Aplicación de nuevos algoritmos y técnicas de GAR

- Centrarse en mejorar la precisión y eficacia del mecanismo de recuperación

- Integración con los modelos lingüísticos más avanzados

- Numerosos documentos y trabajos de investigación

Para quienes deseen explorar las fronteras de la tecnología RAG, STORM ofrece una base sólida respaldada por el rigor académico.

https://github.com/stanford-oval/storm

5. LLM-App

Puntuación en GitHub: 3,4K

LLM-App es una colección de plantillas y herramientas para construir aplicaciones RAG dinámicas.Las principales características de LLM-App incluyen

- Contenedores Docker listos para usar para una rápida implantación

- Compatibilidad con fuentes de datos dinámicas y actualizaciones en tiempo real

- Integración con bases de datos vectoriales y LLM populares

- Plantillas personalizables para distintos casos de uso del GAR

El enfoque de LLM-App en los aspectos operativos y la funcionalidad en tiempo real la convierten en una opción atractiva para las organizaciones que desean implantar un sistema GAR listo para la producción.

https://github.com/pathwaycom/llm-app

6. Cognita

Clasificación por estrellas en GitHub: 3.000 estrellas

Cognita es una nueva adición al espacio de marcos RAG, centrada en proporcionar una plataforma unificada para crear e implantar aplicaciones de IA. Aunque su puntuación es inferior a la de otros marcos, su enfoque integral y su énfasis en los principios de MLOps hacen que merezca la pena tenerlo en cuenta:

- Plataforma integral para el desarrollo de aplicaciones RAG

- Integración con los marcos y herramientas de ML más conocidos

- Funciones integradas de supervisión y observación

- Soporte para el versionado de modelos y el seguimiento experimental

El enfoque holístico de Cognita para el desarrollo de aplicaciones de IA la convierte en una opción convincente para las organizaciones que buscan agilizar todo el ciclo de vida de ML.

https://github.com/truefoundry/cognita

7. R2R

Puntuación en GitHub: 2,5K estrellas

R2R (Retrieval-to-Retrieval) es un marco RAG especializado que se centra en mejorar el proceso de recuperación mediante mejoras iterativas. Aunque tenga menos estrellas, su enfoque innovador de la recuperación lo convierte en un marco digno de mención:

- Aplicación de nuevos algoritmos de búsqueda

- Admite el proceso de búsqueda en varios pasos

- Integración con varios modelos de incrustación y almacenes de vectores

- Herramientas de análisis y visualización del rendimiento de las búsquedas

R2R ofrece un conjunto único y potente de herramientas para desarrolladores e investigadores interesados en ampliar los límites de la tecnología de recuperación.

8. Neurita

Puntuación en GitHub: 909 estrellas

Neurita

Neurita

Neurite es un marco RAG emergente diseñado para simplificar el proceso de creación de aplicaciones basadas en IA. Aunque su base de usuarios es menor que la de otros frameworks, su enfoque en la experiencia del desarrollador y la creación rápida de prototipos hace que merezca la pena explorarlo:

- API intuitiva para crear canalizaciones RAG

- Compatibilidad con múltiples fuentes de datos y modelos integrados

- Mecanismos de caché y optimización integrados

- Arquitectura extensible para componentes personalizados

El énfasis de Neurite en la simplicidad y la flexibilidad lo convierte en una opción atractiva para los desarrolladores que buscan implementar rápidamente la funcionalidad RAG en sus aplicaciones.

https://github.com/satellitecomponent/Neurite

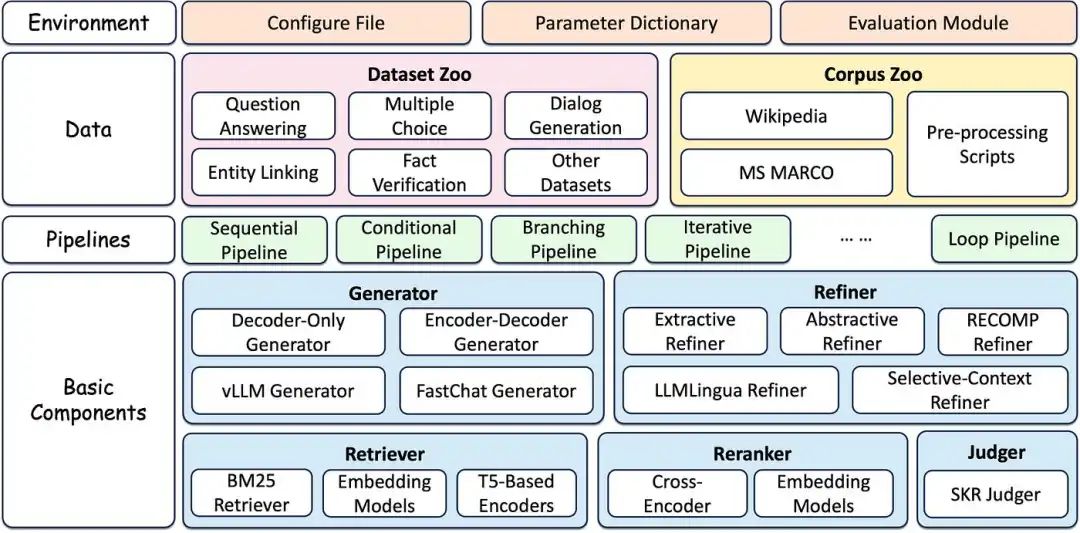

9. FlashRAG

Puntuación en GitHub: 905 estrellas

FlashRAG del Laboratorio de Procesamiento del Lenguaje Natural y Recuperación de Información de la Universidad Renmin de China

FlashRAG del Laboratorio de Procesamiento del Lenguaje Natural y Recuperación de Información de la Universidad Renmin de China

FlashRAG es un marco RAG ligero y eficaz desarrollado por el Laboratorio de Procesamiento del Lenguaje Natural y Recuperación de la Información de la Universidad Renmin de China.

- Optimizar los algoritmos de búsqueda para mejorar su velocidad

- Soporte para procesamiento distribuido y escalado

- Integración con modelos lingüísticos y almacenes de vectores populares

- Herramientas de evaluación comparativa y análisis del rendimiento

Para aplicaciones en las que la velocidad y la eficacia son fundamentales, FlashRAG ofrece un conjunto específico de herramientas y soluciones de optimización.

https://github.com/RUC-NLPIR/FlashRAG

10. Marquesina

Puntuación en GitHub: 923 estrellas

Canopy es un marco RAG desarrollado por Pinecone, empresa conocida por su tecnología de bases de datos vectoriales. Aprovecha la experiencia de Pinecone en la búsqueda vectorial eficiente para ofrecer una solución RAG potente y escalable:

- Estrecha integración con la base de datos de vectores de Pinecone

- Soporte para streaming y actualizaciones en tiempo real

- Funciones avanzadas de procesamiento y reordenación de consultas

- Herramientas de gestión y versionado de bases de conocimientos

Centrado en la escalabilidad y la integración con el ecosistema de Pinecone, Canopy es una opción excelente para las organizaciones que ya utilizan Pinecone o están pensando en utilizarlo para sus necesidades de búsqueda vectorial.

https://github.com/pinecone-io/canopy

escribir al final

El mundo de los marcos RAG es diverso y evoluciona rápidamente, y cada uno de los diez marcos que exploramos ofrece ventajas y capacidades únicas. Desde el completo y maduro Haystack hasta marcos especializados emergentes como FlashRAG y R2R, hay una solución para cada necesidad y caso de uso:

- Requisitos específicos del proyecto

- El nivel de personalización y flexibilidad que necesita

- Características de escalabilidad y rendimiento del marco

- Escala comunitaria y actividades en torno al marco

- Calidad de la documentación y la asistencia disponibles

Si evalúa detenidamente estos factores y experimenta con diferentes marcos, podrá encontrar la solución de GAR que mejor se adapte a sus necesidades y le ayude a crear aplicaciones de IA más inteligentes y conscientes del contexto. Mantenerse al día de los últimos avances en tecnología RAG es esencial para los desarrolladores y las organizaciones que buscan aprovechar el poder de la IA en sus aplicaciones y servicios.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...