Qwen3-VL-Reranker - 阿里巴巴推出的多模态重排序模型

Qwen3-VL-Reranker是什么

Qwen3-VL-Reranker是阿里巴巴推出的多模态重排序模型,专门用于提升跨模态检索的精准度。与Qwen3-VL-Embedding协同工作:前者负责快速召回候选结果,后者通过深度跨模态交互(如交叉注意力机制)对结果进行精细打分重排序。模型支持文本、图像、视频等混合模态输入,采用单塔架构输出相关性概率,解决了传统方法中"相似但不相关"内容的区分难题。在电商、科研文献等实际场景中,其性能显著优于同类模型,尤其在MMEB-V2基准测试中8B版本达到86.3%的准确率。

Qwen3-VL-Reranker的功能特色

- 单塔交叉注意力架构:采用单塔交叉注意力架构,将查询与候选文档联合编码,通过交叉注意力机制逐层剖析二者在语义、细节甚至上下文逻辑上的深层关联,最终输出精确的相关性分数。

- 高精度重排序:在多模态检索任务中,对Embedding初步召回的结果进行深度重排序,显著提升检索结果的准确率与相关性。

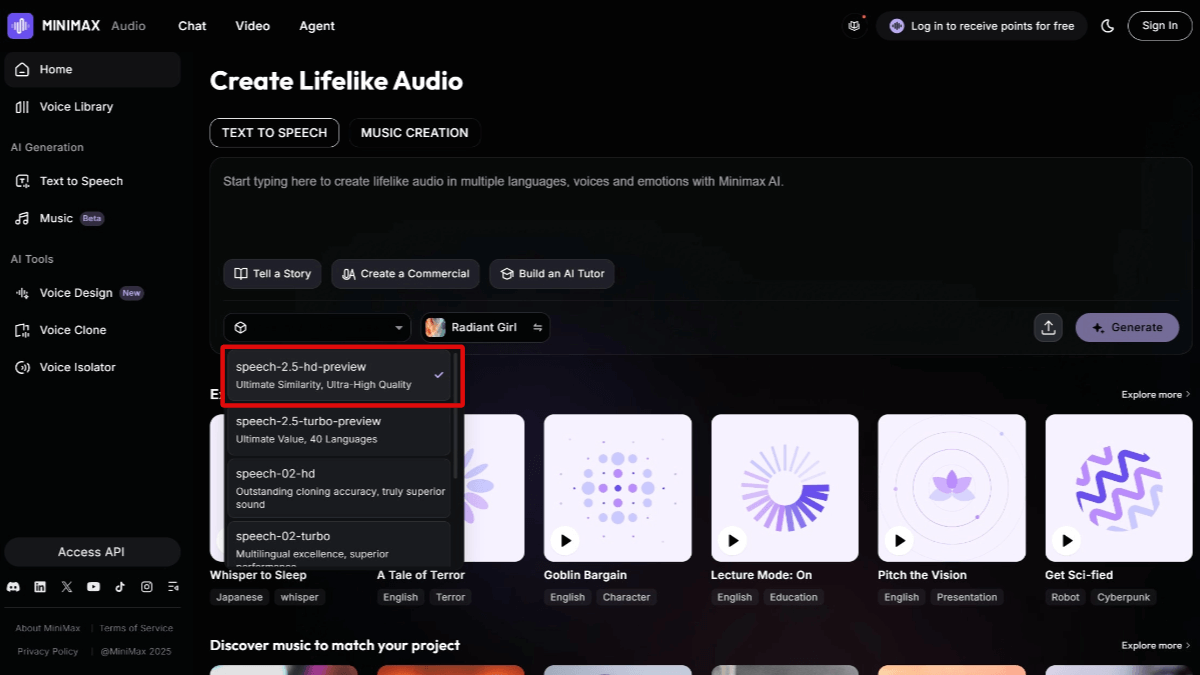

- multimodal support:支持文本、图像、可视化文档(如代码截图、数据图表、App界面)乃至视频等异构内容的输入,能处理图文查询匹配图文文档、视频片段检索相关文章等复杂任务。

- Multi-language support:继承了Qwen3-VL的多语言基因,支持超过30种语言。

- 灵活的向量维度选择:提供灵活的向量维度选择,方便开发者根据具体需求进行优化。

- 指令微调能力:支持自定义指令模板,可针对特定任务或领域优化性能,实测精度提升3%-5%,特别适合金融、法律等专业场景。

- 性能表现优异:在MMEB-v2和MMTEB等权威多模态基准测试中,Qwen3-VL-Reranker表现亮眼,其8B版本在多数子项中领先,在视觉文档检索任务中,如JinaVDR、ViDoRe v3等,持续领先。

Qwen3-VL-Reranker的核心优势

- 高精度重排序:在多模态检索任务中,对 Embedding 初步召回的结果进行深度重排序,显著提升检索结果的准确率与相关性。

- multimodal support:支持文本、图像、可视化文档(如代码截图、数据图表、App 界面)乃至视频等异构内容的输入,能处理图文查询匹配图文文档、视频片段检索相关文章等复杂任务。

- Multi-language support:继承了 Qwen3-VL 的多语言基因,支持超过 30 种语言。

- 灵活的向量维度选择:提供灵活的向量维度选择,方便开发者根据具体需求进行优化。

- 指令微调能力:支持自定义指令模板,可针对特定任务或领域优化性能,实测精度提升 3%-5%,特别适合金融、法律等专业场景。

Qwen3-VL-Reranker官网是什么

- HuggingFace Model Library

- https://huggingface.co/Qwen/Qwen3-VL-Reranker-8B

- https://huggingface.co/Qwen/Qwen3-VL-Reranker-2B

Qwen3-VL-Reranker的适用人群

- 多模态内容开发者:适用于需要处理文本、图像、视频等多种模态数据的开发者,可以用模型进行跨模态检索和内容推荐系统的开发。

- 搜索引擎工程师:对于从事搜索引擎开发的工程师来说,Qwen3-VL-Reranker能提升搜索结果的准确性和相关性,尤其在多模态内容检索方面具有显著优势。

- 金融与法律行业专业人士:金融分析师、律师等专业人士可以通过指令微调功能,将模型应用于金融文本分析、法律文档检索等专业领域,提高工作效率和准确性。

- Data scientists and researchers:在多模态数据研究领域,数据科学家可以用模型进行实验和研究,探索多模态数据的深度语义关联和应用潜力。

- Enterprise Application Developers:企业内部开发团队可以将Qwen3-VL-Reranker集成到企业知识管理系统、智能客服等应用中,提升企业内部信息检索和客户服务的质量。

- Practitioners in the field of education:教育工作者和在线教育平台开发者可以用模型优化教育资源的检索和推荐,为学生提供更精准的学习内容。

© Copyright notes

Article copyright AI Sharing Circle All, please do not reproduce without permission.

Related posts

No comments...