Think&Cite: Verbesserung der Genauigkeit von Textzitaten mit Hilfe von Baumsuchtechniken

Abstracts

Obwohl große Sprachmodelle (Large Language Models, LLMs) gute Leistungen erbringen, neigen sie dazu, zu halluzinieren und faktisch ungenaue Informationen zu erzeugen. Diese Herausforderung hat zu Bemühungen im Bereich der attributiven Textgenerierung geführt, die LLMs dazu veranlassen, Inhalte zu generieren, die unterstützende Beweise enthalten. In diesem Beitrag schlagen wir einen neuen Rahmen namens Think&Cite vor und formulieren die Generierung von Attributtexten als ein mehrstufiges Argumentationsproblem mit integrierter Suche. Konkret schlagen wir eine selbstgesteuerte Monte-Carlo-Baumsuche (SG-MCTS) vor, die die Selbstreflexionsfähigkeit von LLMs nutzt, um über die Zwischenzustände von MCTS nachzudenken und so den Baumerweiterungsprozess zu steuern. Um ein zuverlässiges und umfassendes Feedback zu geben, haben wir das Progress Reward Model (PRM) eingeführt, das den Fortschritt der Baumsuche vom Wurzelknoten bis zum aktuellen Zustand sowohl aus generativer als auch aus attributiver Sicht misst. Wir haben umfangreiche Experimente mit drei Datensätzen durchgeführt und die Ergebnisse zeigen, dass unsere Methode die Basismethode deutlich übertrifft.

1 Einleitung

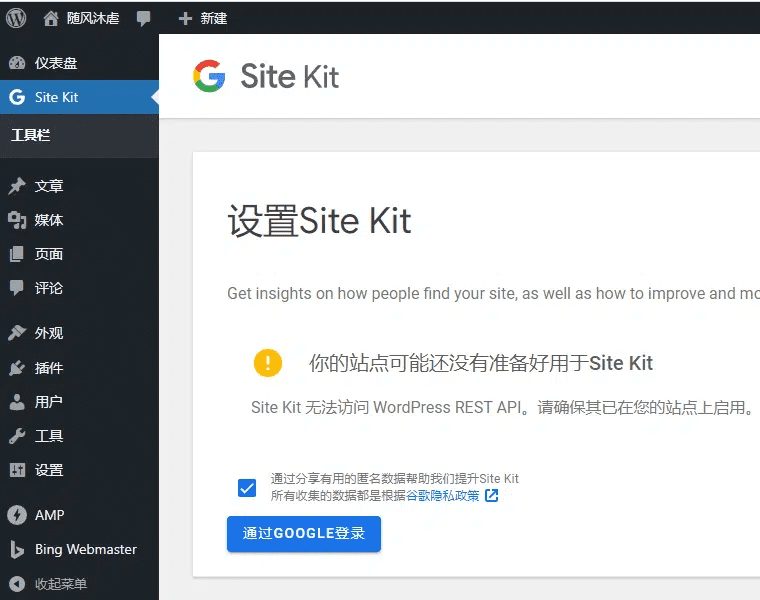

Groß angelegte Sprachmodelle (LLMs) (Zhao et al., 2023) erbringen bei vielen Aufgaben der natürlichen Sprachverarbeitung gute Leistungen. Trotz dieser Fortschritte erzeugen LLMs oft Antworten, die illusorische und ungenaue Informationen enthalten (Ji et al., 2023; Huang et al., 2023; Zhang et al., 2023). Dieses Problem beeinträchtigt ihre Zuverlässigkeit und, was noch wichtiger ist, das Vertrauen der Nutzer in LLMs. Um die Zuverlässigkeit von LLMs zu verbessern, wurde ein neues Generierungsparadigma, die Attributtextgenerierung, vorgeschlagen, das es LLMs ermöglicht, Antworten zu generieren, die In-Text-Zitate enthalten, um Beweise zu liefern (Gao et al., 2023b), wie in Abbildung 1 dargestellt.

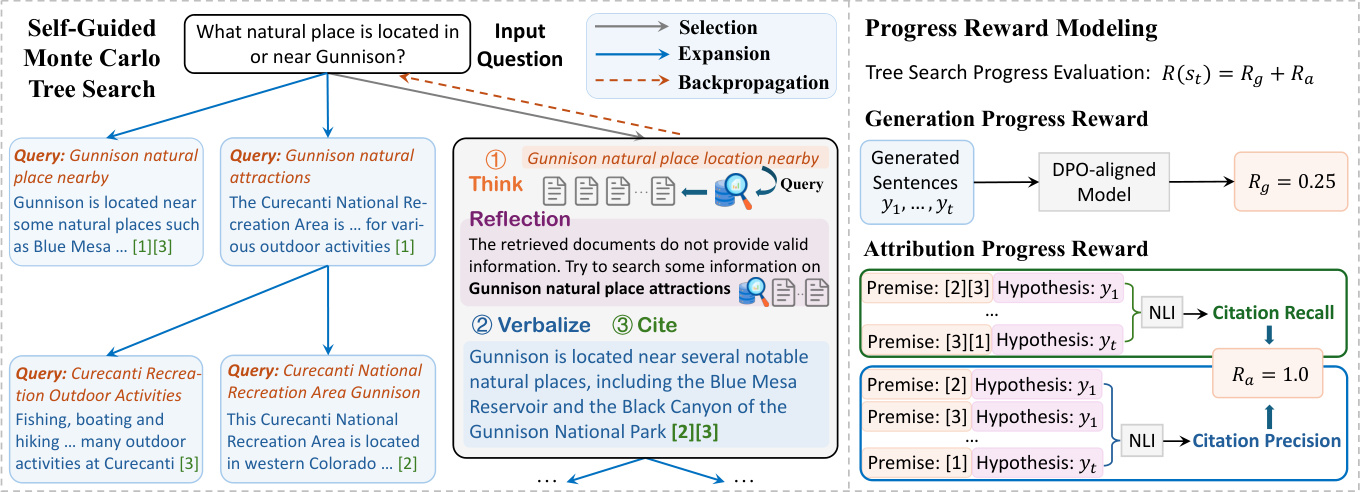

Abbildung 1: Bei einer Frage generiert das Modell Text, indem es Passagen aus dem Korpus als unterstützende Beweise zitiert.

Die meisten bestehenden Arbeiten (Slobodkin et al., 2024; Sun et al., 2024; Fierro et al., 2024) fordern LLMs lediglich dazu auf, bei der Texterstellung Zitate anzugeben. Darüber hinaus wird in anderen Arbeiten (Li et al., 2024; Huang et al., 2024) versucht, LLMs anhand großer Mengen überwachter Trainingsdaten, die Text mit kommentierten Zitaten enthalten, feinabzustimmen.Trotz dieser jüngsten Bemühungen bleibt die Entwicklung von LLMs, die lernen, getreue Inhalte mit zuverlässigen Zitaten zu erzeugen, eine offene Herausforderung. Erstens verwenden die bestehenden Methoden ein autoregressives Generierungsparadigma, das als "System 1" charakterisiert werden kann, eine schnelle und instinktive Denkweise, die jedoch nicht genau genug ist (Kahneman, 2011). Infolgedessen kann jeder zwischengeschaltete generative Fehler (z. B. eine falsche Darstellung oder ein falsches Zitat) zu einer falschen endgültigen Antwort führen. In Anlehnung an die Forschung zum komplexen Denken (Zhang et al., 2024; Wang et al., 2024) wollten wir ein Modell für das "System 2"-Paradigma für das Zitieren externer Belege entwickeln, das ein tiefergehendes, sorgfältiges und logisches Denken erfordert (Kahneman, 2011). Zweitens beinhaltet die Generierung von Attributstexten oft eine lange Texterstellung. liu et al. (2023) fanden heraus, dass lange Antworten auf bestehende LLMs oft ungestützte Aussagen und ungenaue Zitate enthalten. Wir argumentieren, dass das Fehlen einer expliziten Generierungsplanung in früheren Arbeiten den Fortschritt solcher Systeme behindert hat.

In diesem Beitrag stellen wir Think&Cite vor, einen neuen Rahmen für die Integration von Suchalgorithmen in die Generierung von attributiven Texten. Wir konzeptualisieren die Generierungsaufgabe als ein mehrstufiges Inferenzproblem, bei dem das Modell in jedem Schritt einen Satz durch ein iteratives Think-Express-Reference-Paradigma generiert. Um diesen generativen Prozess zu verbessern, schlagen wir die selbstgesteuerte Monte-Carlo-Baumsuche (SG-MCTS) vor, die das klassische MCTS um zwei Innovationen erweitert. Erstens nutzt unser Ansatz die Selbstreflexionsfähigkeit von LLMs, um die Zwischenzustände des MCTS in Echtzeit zu reflektieren und so den Baumexpansionsprozess zu steuern und unangemessene Inferenzpfade aktiv zu vermeiden. Dies steht im Gegensatz zu früheren Arbeiten, die hauptsächlich über das Endergebnis oder die vollständige Trajektorie reflektieren. Zweitens schlagen wir das Progress Reward Model (PRM) vor, das den Fortschritt der Baumsuche vom Wurzelknoten bis zum aktuellen Zustand sowohl aus generativer als auch aus attributiver Sicht misst. Im Gegensatz zur Bewertung einzelner Schritte bietet das fortschrittsbasierte Belohnungsmodell eine zuverlässige und umfassende Bewertung zur Steuerung des MCTS-Suchprozesses.

Soweit wir wissen, sind wir die ersten, die einen Baumsuchalgorithmus auf die Aufgabe der Attributtextgenerierung anwenden. Wir haben umfangreiche Experimente mit drei Datensätzen durchgeführt, um die Effektivität unseres Ansatzes zu validieren. Die Ergebnisse zeigen, dass unser Modell deutlich besser abschneidet als frühere Hinweise und fein abgestimmte Baselines.

2 Verwandte Arbeiten

Texterzeugung mit Zuschreibung. Große Sprachmodelle (Large Language Models, LLMs) wurden aufgrund ihrer hervorragenden Sprachgenerierungsfähigkeiten für die Textgenerierung mit Attribution verwendet (Gao et al., 2023b; Huang et al., 2024; Sun et al., 2024; Li et al., 2024; Slobodkin et al., 2024). LLMs für die Textgenerierung mit Attribution lassen sich grob in zwei Kategorien einteilen. Die generierte Arbeit lässt sich grob in zwei Kategorien einteilen. Die erste Kategorie umfasst die Feinabstimmung des LLM mit Hilfe von Präferenzlernen (Li et al., 2024) und Verstärkungslernen (Huang et al., 2024), das dem LLM beibringt, unterstützende und relevante Zitate zu erzeugen, um höhere Belohnungen zu erhalten. Allerdings ist dieser Ansatz darauf angewiesen, dass Menschen hochwertige Datensätze mit kommentierten In-Text-Zitaten zusammenstellen. Eine andere Klasse von Arbeiten weist den LLM direkt an, Text mit Zuschreibungen zu generieren, und zwar durch die Planung der Zuschreibung-dann-Generierung (Slobodkin et al., 2024) oder durch die Verwendung eines externen Validators zur Steuerung der Generierung (Sun et al., 2024). Dieser Ansatz generiert jedoch Text und Zitate auf autoregressive Weise, wobei jede ungenaue Zwischengenerierung zu Fehlern im nachfolgenden Prozess führen kann. Im Gegensatz dazu schlägt unser Ansatz eine selbstgesteuerte Baumsuche mit progressiven Belohnungen vor, um mehrere Pfade zu berücksichtigen.

LLM mit Baumsuche: Die Integration von Baumsuchalgorithmen in LLM hat große Aufmerksamkeit erregt. Jüngste Studien haben die Verwendung von Baumsuchmethoden untersucht, um die Leistung von LLM während der Inferenz zu verbessern (Zhang et al., 2024; Wang et al., 2024; Ye und Ng, 2024).Sutton (2019) betonte die Überlegenheit der Skalierung beim Lernen und Suchen gegenüber anderen Methoden. Empirische Belege deuten außerdem darauf hin, dass eine erweiterte Inferenzzeitberechnung die LLM-Leistung erheblich verbessern kann, ohne dass zusätzliches Training erforderlich ist (Brown et al., 2024; Snell et al., 2024).A-Suche (Hart et al., 1968) und Monte Carlo Tree Search (MCTS) (Browne et al., 2012) werden als Planungstechniken verwendet um die Leistung von LLMs bei der Lösung komplexer Inferenzprobleme zu verbessern. Diese Suchalgorithmen werden häufig beim Reinforcement Learning (Silver et al., 2017) und in vielen realen Anwendungen wie AlphaGo (Silver et al., 2016) eingesetzt. Unsere Arbeit ist die erste, die einen Baumsuchalgorithmus (d. h. Monte-Carlo-Baumsuche) zur Lösung der Aufgabe der Textgenerierung mit Attribution einsetzt. Darüber hinaus schlagen wir ein selbstgesteuertes MCTS vor, das sich auf die Reflexionskraft des LLM stützt, um die Baumexpansion zu verbessern.

3 Formulierung des Problems

Der von uns vorgeschlagene Rahmen zielt darauf ab, dass vortrainierte LLM Mθ Die Generierung von Antworten mit In-Text-Zitaten, die als Nachweis für den Inhalt der Ausgabe dienen, wird als Textgenerierung mit Attribution bezeichnet (Slobodkin et al., 2024; Gao et al., 2023a).

Bei einer Eingangsfrage x und einem Korpus von Textpassagen D wird das Modell Mθ Erforderlich ist die Erstellung einer Antwort y = (y 1 , ... , y T ), besteht die Antwort aus T Sätzen, wobei jeder Satz yt Verweise auf die Liste der Absätze von D, bezeichnet als Ct = {C t,1 , ... , C t,m } Aufgrund des marginalen Vorteils der Kombination mehrerer Zitate (Gao et al., 2023b) lassen wir in dieser Arbeit bis zu drei Zitate pro Satz zu (m ≤ 3), die in eckige Klammern gesetzt werden, z. B. [1][2]. Wir konzentrieren uns auch auf wissensintensive Szenarien, bei denen das Problem Weltwissen umfasst und die meisten Sätze im LLM mehrere Fakten enthalten und unterstützende Zitate als Beweismittel erfordern. In Anlehnung an frühere Arbeiten (Gao et al., 2023b; Piktus et al., 2021) unterteilen wir den Korpus D für das Retrieval in Absätze mit 100 Wörtern, was die Überprüfung durch Menschen erleichtert und nicht zu viele irrelevante Informationen einbringt.

Um diesen generativen Prozess zu verbessern, schlagen wir die selbstgesteuerte Monte-Carlo-Baumsuche (Self-Guided Monte Carlo Tree Search, SG-MCTS) vor, die das klassische MCTS durch zwei Innovationen erweitert. Um diesen generativen Prozess zu verbessern, schlagen wir eine selbstgesteuerte Monte-Carlo-Baumsuche (SG-MCTS) vor, die das klassische MCTS durch zwei Innovationen erweitert. Erstens nutzt unser Ansatz die selbstreflexive Fähigkeit des LLM, um in Echtzeit über die Zwischenzustände des MCTS zu reflektieren und so den Baumerweiterungsprozess zu steuern und proaktiv unzureichende Inferenzpfade zu vermeiden. Dies steht im Gegensatz zu früheren Arbeiten, die sich in erster Linie auf das Endergebnis oder die vollständige Trajektorie beziehen. Zweitens schlagen wir das Progress Reward Model (PRM) vor, um den Fortschritt der Baumsuche vom Wurzelknoten bis zum aktuellen Zustand in Bezug auf zwei Aspekte zu messen, nämlich den Generierungsfortschritt und den Attributionsfortschritt. Im Vergleich zur Bewertung einzelner Schritte kann das fortschrittsbasierte Belohnungsmodell eine zuverlässige und umfassende Bewertung zur Steuerung des MCTS-Suchprozesses liefern.

Unseres Wissens nach sind wir die ersten, die einen Baumsuchalgorithmus auf die Aufgabe der Texterstellung mit Attribution anwenden. Wir haben umfangreiche Experimente mit drei Datensätzen durchgeführt, um die Effektivität unseres Ansatzes zu validieren. Die Ergebnisse zeigen, dass unser Modell frühere cue-basierte und fein abgestimmte Baselines deutlich übertrifft.

Abbildung 2: Der Gesamtrahmen des von uns vorgeschlagenen Think&Cite-Ansatzes.

4 Methodik

Der vorgeschlagene THINK&CITE-Rahmen basiert auf einem Sprachagenten für die Generierung von Attributtexten, der die selbstgesteuerte Monte-Carlo-Baumsuche (SG-MCTS) zur Planung und Suche nach mehreren Generierungspfaden und die Progress Reward Modelling (PRM) zur Bereitstellung asymptotisch feinkörniger Signale für den Suchprozess verwendet. Abbildung 2 zeigt die Gesamtarchitektur unseres Ansatzes.

4.1 Agent zur Erzeugung von Attributtexten

In Anlehnung an frühere Arbeiten (Yao et al., 2022; Chen et al., 2023) entwickeln wir einen linguistischen Agenten zur Lösung der Aufgabe der Textgenerierung mit Attribution, der einen iterativen Think-Verbalise-Cite-Prozess durchführt, der die Inferenz- und Planungsfähigkeiten des LLM nutzt.

Iteratives Denken-Verbalisieren-Zitieren: Um den t-ten Satz zu generieren, denkt der Agent zunächst aktiv über den nächsten zu generierenden Entwurf (z. B. ein inhaltliches Thema oder eine Zusammenfassung) als Suchanfrage q t Der Agent verwendet dann das Suchwerkzeug, um die relevantesten Top-K-Absätze D aus dem gegebenen Korpus D durch die Suchoperation (d. h. "Suche: {Abfrage}") abzurufen. Dann verwendet der Agent das Suchwerkzeug, um die relevantesten Top-K-Absätze D aus dem gegebenen Korpus D durch die Operation "Suchen" (d. h. "Suche: {Abfrage}") abzurufen. t . Auf der Grundlage der abgerufenen Passagen referenziert der Agent über die Operation Generate (d. h. "Generate: {sentence}") den Text aus dem Dt Liste der Paragraphen Ct um einen Satz y auszudrücken t . Die historische Anfrage, die abgerufenen Absätze, die generierten Sätze und die Zitate (bezeichnet als H = {(q i , D i , y i , C i )}^t^ i=1 ) wird als Kontext für den nächsten Schritt des Denkens und Ausdrückens verwendet. Wenn der Agent die Aufgabe als gelöst betrachtet, kann er "End" ausgeben, um den Prozess zu beenden. Auf diese Weise kann der Agent verschiedene Informationen durchdacht planen und abrufen, was im Gegensatz zu früheren Arbeiten, die sich auf statische Referenzkorpora stützten (Slobodkin et al., 2024; Huang et al. ..., 2024) anders ist. Darüber hinaus ähnelt dieses Paradigma neueren Arbeiten zur iterativen abrufgestützten Generierung (Jiang et al., 2023; Shao et al., 2023), unterscheidet sich aber insofern, als unsere Arbeit erfordert, dass das Modell inhaltliche Entwürfe für die nächste Generation vorhersagt, um relevante Informationen abzurufen und geeignete Referenzen sorgfältig auszuwählen, um sie an den entsprechenden Stellen im generierten Text zusammenzuführen.

4.2 Selbstgesteuerte Monte-Carlo-Baumsuche

Wir formulieren die Texterzeugung mit Attribution als ein mehrstufiges Inferenzproblem, bei dem das Modell über die Attribution von Text nachdenkt. Die Monte-Carlo-Baumsuche hat sich zu einem effektiven Suchalgorithmus für viele Entscheidungsaufgaben entwickelt (Silver et al., 2016; Ye et al., 2021). In dieser Arbeit schlagen wir die selbstgesteuerte Monte-Carlo-Baumsuche (SG-MCTS) vor, die die selbstreflexive Fähigkeit des LLM nutzt, um den Suchprozess der MCTS zu steuern. Frühere Arbeiten (Shinn et al., 2023; Zhou et al., 2024; Yu et al., 2024) reflektieren typischerweise das Endergebnis oder die vollständige Trajektorie, was ineffizient und spärlich ist. Im Gegensatz dazu zielt unser Ansatz darauf ab, den Zwischenzustand von MCTS zu kritisieren und zu reflektieren, um die Baumerweiterung in Echtzeit zu steuern und fehlerhafte Generierungspfade aktiv zu ignorieren.

Typischerweise basiert MCTS auf einem Strategiemodell πθ Konstruieren Sie den Suchbaum T, der normalerweise LLM M ist θ . In diesem Baum ist der Knoten st = [q t , D t , y t , C t ] bezeichnet den Zustand der t-ten Baumebene, einschließlich der Suchanfrage q t D t Ausdruckssätze yt und die zitierten Paragraphen C t . Der Wurzelknoten s0 = [x] bezeichnet das Eingabeproblem. In jeder Iteration durchläuft SG-MCTS vier Schritte, d.h. Auswahl, reflexionsgeleitete Erweiterung, Bewertung und Backpropagation.

Auswahlphase. Ziel der Auswahlphase ist die Identifizierung eines Knotens s aus dem Suchbaum Tt für die anschließende Erweiterung. Der auf Bäume angewandte Algorithmus der oberen Konfidenzgrenze (UCT) (Kocsis und Szepesvári, 2006) wird verwendet, um den besten Knoten mit der höchsten UCT-Punktzahl auszuwählen:

UCT(s) t ) = V(s t ) + w √(ln N(p) / N(s)) t )) (1)

wobei V(s t ) wird in der Bewertungsphase geschätzt st Die Wertfunktion (erwartete Belohnung), N(s t ) ist st die Anzahl der Besuche, w ist das Gewicht der Kontrolluntersuchung und p ist die st des übergeordneten Knotens.

Phase der reflexionsgesteuerten Erweiterung . In der Erweiterungsphase werden durch die Erzeugung mehrerer Nachfolgeknoten s t+1 Die ausgewählten Knoten werden durch den Prozess think-verbalize-cite erweitert. s t Der Think-Schritt generiert zunächst eine Blaupause als Suchanfrage q̂ t+1 Er extrahiert den Betreff und den Inhalt des nächsten Satzes, der zum Abrufen des Absatzes D̂ verwendet wird. t+1 . Das Strategiemodell kann jedoch in der Erweiterungsphase fehlschlagen, z. B. durch die Generierung unspezifischer oder irrelevanter Abfragen, was die anschließende Suche nach Beweisen behindern und letztlich zu einer falschen Satzgenerierung führen kann. Daher führen wir das Reflexion Schritt, wobei das Strategiemodell auf der Frage x und der abgerufenen Passage D̂ basiertt+1 Reflektierende Befragung q̂t+1 um Fehler zu erkennen:

u = M θ (q̂ t+1 , D̂ t+1 , x), (2)

wobei der Reflexionstext u Vorschläge zu bestimmten Aspekten der Suche enthält, z. B. dass die Anfrage stärker auf das Suchthema ausgerichtet werden sollte. Auf der Grundlage der Reflexion formuliert das Strategiemodell eine neue Anfrage qt+1 um den entsprechenden Absatz D abzurufen t+1 ::

q t+1 , Dt+1 = M θ (u, q̂ t+1 , D̂ t+1 , H), (3)

wobei H die Verlaufsspur ist. Beachten Sie, dass der obige Prozess so lange wiederholt werden kann, bis das Modell feststellt, dass die abgerufenen Beweise stützend sind oder die maximale Anzahl von Iterationen erreicht ist. Schließlich werden die Verbalisierungs- und Zitierschritte aus Dt+1 Erzeugen Sie den nächsten Satz y t+1 und mit genauen Zitaten C t+1 ::

y t+1 , Ct+1 = M θ (q t+1 , D t+1 , H). (4)

Der neue Knoten besteht aus der Anfrage, dem abgerufenen Korpus, dem generierten Satz und dem zitierten Absatz, bezeichnet mit st+1 = [q t+1 , D t+1 , y t+1 , C t+1 ] Im Vergleich zu einfachen Expansionen in typischen MCTS verbessert unser Ansatz defekte Expansionsknoten, um eine qualitativ schlechte Generierung zu vermeiden. Da MCTS-Bäume inkrementell aufgebaut werden, kann das Modell durch die Verbesserung der Qualität der nächsten Operation günstigere Pfade durch einen großen Suchraum navigieren und so die Suchqualität des Baums insgesamt verbessern.

Bewertungsphase. In der Bewertungsphase wird das Modell der Fortschrittsbelohnung (siehe Abschnitt 4.3) verwendet, um den neuen Erweiterungsknoten st+1 Die erwartete Belohnung von R(s t+1 ). Die Fortschrittsbewertung umfasst zwei Aspekte: die Schaffung und die Zurechnung von Fortschritten. Generierung von Fortschrittsanreizen Rg Messung der bisher generierten Sätze y 1 , ... , yt+1 die Qualität des Textes. Freizügigkeit Fortschritt Belohnung Ra Auswertung der generierten Sätze y 1 , ... , yt+1 und die zitierten Paragraphen C 1 , ... , Ct+1 Attributionskonsistenz zwischen ihnen. Schließlich wird die Gesamtbelohnung als die Summe der beiden berechnet: R(s t+1 ) = R g + R a .

Backpropagation-Phase. In der Backpropagation-Phase wird der neue Knoten st+1 Die Belohnung für R(s t+1 ) wird zurück zu seinem übergeordneten Knoten s t die jeden Knoten auf dem Pfad vom Wurzelknoten zu seinem Elternteil s aktualisiert 0 , s 1 , ... , st Die Wertfunktion des

N neu (s i ) = N alt (s i ) + 1, 0 ≤ i ≤ t (5)

V neu (s i ) = (V alt (s i )N alt (s i ) + R(s t+1 )) / N neu (s i ) (6)

wobei N alt (s i ) und V alt (s i ) sind die Knotenpunkte si der zuvor aufgerufenen Zähl- und Wertfunktionen.

4.3 Modell der Fortschrittsprämie

Bisherige Ergebnis-Belohnungsmodelle (Cobbe et al., 2021; Hosseini et al., 2024) und Prozess-Belohnungsmodelle (Lightman et al., 2024; Dai et al., 2024) haben sich auf die Bewertung des Endergebnisses oder der Zwischenschritte konzentriert. In dieser Arbeit schlagen wir vor, dass nach dem nächsten Schritt die Messbaumsuche von der Wurzel s0 zum Zustand st+1 Der Fortschritt. Da ein Text mit Quellenangabe sowohl Textinhalte als auch Zitate enthält, haben wir zwei Aspekte von Fortschrittsbelohnungen entwickelt, nämlich Fortschrittsbelohnungen für die Generierung und Fortschrittsbelohnungen für die Quellenangabe, um die Qualität der generierten Textinhalte bzw. die Relevanz der Zitate zu bewerten.

4.3.1 Schaffung von Fortschrittsanreizen

Bei der direkten Präferenzoptimierung (DPO) (Rafailov et al., 2023) können die logarithmischen Verhältnisse auf Markerebene wie folgt interpretiert werden

implizite Belohnung auf Markerebene im Rahmen des Maximum Entropy Reinforcement Learning (RL). Daher schlagen wir vor, das bestehende DPO-Alignment-Modell zu verwenden, um die Generierung des nächsten Satzes y zu messent+1 Nacherstellte Sätze y1:t+1 = y 1 , ... , yt+1 Die Qualitätsbewertung von R g .

Konkret definieren wir einen Markov-Entscheidungsprozess (MDP) auf Satzebene, bei dem der Zustand st = (x, y 1 , ... , y t ) bezeichnet die bisher erzeugten Eingaben und Sätze, und der Ausgangszustand s0 = x ist ein Eingabeproblem. Die Aktion at = yt+1 bezeichnet den nächsten zu generierenden Satz. Somit kann das RLHF-Optimierungsziel als RL-Problem mit maximaler Entropie auf Satzebene umgeschrieben werden:

E unterπθ(-|st)~ [∑^T^t=1 r'(s t , a t )] + βE s0x~ [H(π θ (-|s 0 ))],

wobei die Belohnungsfunktion r' auf Satzebene wie folgt berechnet werden kann:

r'(s t , a t ) = { βlog π ref (a t |s t ), wenn st+1 das ist nicht das Ende der Fahnenstange

{ r'(y|x) + βlog π ref (a t |s t ) Wenn s t+1 Das ist das Ende der Fahnenstange.

Die Formel der maximalen Entropie RL leitet die optimale Wertfunktion V und die Q-Funktion Q wie folgt ab:

Q(s t , a t ) = r'(s t , a t ) + V(s t+1 ),

V(s t ) = log ∑a exp(Q(s t , a)), wenn t ≤ T .

Daher wird die optimale Politik π wie folgt abgeleitet:

⇒ βlog π(a t |s t ) = Q(s t , a t ) - V(s t ),

⇒ βlog (π(a t |s t ) / π ref (a t |s t )) = V(s t+1 ) - V(s t ).

Dies hat uns dazu veranlasst, die DPO-Strategie zur Ableitung der Teilsumme der Belohnungen zu verwenden, um Teilantworten y zu formulieren1:t+1 Fortschrittsanreize R g ::

∑^t^k=0 βlog (π(a k |s k ) / π ref (a k |s k )) = V(s t+1 ) - V(s 0 ),

⇒ R g (y 1:t+1 ) = ∑^t^k=0 wk log (π(y k+1 |x, y 1:k ) / π ref (y k+1 |x, y 1:k )),

wobei y1:k kennzeichnet y 1 , ... , y k wk = 1 / (t+1) ist die Gewichtung der einzelnen Log-Likelihood-Verhältnisse auf Satzebene.

4.3.2 Attribut Fortschrittsprämien

Wir verwenden zwei Zitationsmetriken aus früheren Arbeiten (Gao et al., 2023b), nämlich die Zitationserinnerung und die Zitationsgenauigkeit, um den Zuordnungsfortschritt R a .

Im Einzelnen misst der Zitationsabruf die Teilantwort y1:t+1 von Sätzen, die durch die entsprechende zitierte Passage gestützt werden konnten. Wir haben das NLI-Modell (Honovich et al., 2022) verwendet, um zu prüfen, ob sich aus den zitierten Passagen Modellantworten ableiten lassen. Für jeden Satz yi (1 ≤ i ≤ t + 1), so erhalten wir Ci Die zitierten Passagen in werden als Prämisse und der erzeugte Satz yi als Annahmen für das NLI-Modell. Wir setzen die Zitiergenauigkeit auf 1, wenn die Prämisse eine Annahme enthält, und andernfalls auf 0. Wir verwenden dasselbe NLI-Modell wie oben, um den Präzisionswert zu berechnen. Für jedes Zitat c i,j Wenn (1) Ci Alle Zitate in y enthalten den generierten Satz yi und (2) Ci \ {c i,j } ohne den Satz y i Andernfalls wird der Präzisionswert auf 0 gesetzt. Wir berechnen den Präzisionswert (0 oder 1) für jedes Zitat und den Durchschnitt über alle Zitate. Schließlich berechnen wir die F1-Punktzahl als die zugewiesene Fortschrittsbelohnung R a (y 1:t+1 , C 1 , ... , C t+1 ), um einen ausgewogenen Qualitätsmaßstab für die Zuordnung zwischen generierten Sätzen und zitierten Passagen zu schaffen.

5 Experimente

5.1 Versuchsaufbau

Datensätze. Für die Bewertung verwenden wir den ALCE-Benchmark-Test (Gao et al., 2023b), der aus drei Datensätzen besteht: (1) ASQA (Stelmakh et al., 2022), ein langer QS-Datensatz mit mehrdeutigen Fragen, die mehrere Antworten erfordern, um verschiedene Aspekte abzudecken; (2) QAMPARI (Amouyal et al. 2022), ein faktischer QA-Datensatz, bei dem die Antwort auf jede Frage eine Liste von Entitäten ist, die aus verschiedenen Passagen extrahiert wurden; und (3) ELI5 (Fan et al., 2019), ein langer QA-Datensatz mit Wie/Warum/Was-Fragen. Bei ASQA und QAMPARI können die meisten Fragen über Wikipedia beantwortet werden, daher verwenden wir den Wikipedia-Snapshot 2018/12/20 als Korpus. Für ELI5 verwenden wir, da die Fragen thematisch vielfältig sind, Sphere (Piktus et al., 2021) (eine gefilterte Version von Common Crawl) als Korpus. Gao et al. (2023b) folgend, verwenden wir GTR (Ni et al., 2022) für Wikipedia und Sphere BM25 (Robertson et al., 2009), um die ersten 100 Passagen als Korpus für jede Frage abzurufen. Siehe Anhang A für weitere Einzelheiten.

Bewertungsmetriken. Wir verwenden die Bewertungsmetriken aus dem ursprünglichen ALCE-Benchmark-Test. Um die Korrektheit der Ausgabe zu bewerten, verwenden wir Exact Match (EM) Recall von ASQA, Recall-5 von QAMPARI und Statement Recall von ELI5, um den Prozentsatz der goldenen Antworten (Schlüsselinformationen) in der Ausgabe zu messen. Außerdem berechnen wir Precision als Korrektheitsmetrik für den QAMPARI-Datensatz, um den Prozentsatz der richtigen Antworten in den generierten Antworten zu messen. Um die Zitierqualität der Ausgabe zu bewerten, berechnen wir Citation Recall, das den Prozentsatz der Sätze in der Ausgabe misst, die aus den zitierten Passagen abgeleitet werden können, und Citation Precision, das den Prozentsatz der Zitate misst, die die Sätze in der Ausgabe unterstützen können.

Ausgangslage. Wir vergleichen unseren Ansatz mit dem, der auf ChatGPT und GPT-40 werden mit den folgenden Basiswerten verglichen:

Vanille RAG Das Modell wurde direkt angewiesen, Antworten auf der Grundlage der vorgegebenen ersten 5 Absätze zu generieren und diese entsprechend zu zitieren. Wir verwenden Kontextlernen mit zwei Präsentationen (Brown et al., 2020).

Die Zusammenfassung/Schnipsel-RAG liefert eine Zusammenfassung oder einen Schnipsel des Absatzes und nicht den vollständigen Text. Das Modell generiert Antworten mit Zitaten auf der Grundlage der ersten 10 Absatzzusammenfassungen oder -auszüge.

Interact ermöglicht dem Modell einen weiteren Zugriff auf den Volltext bestimmter Absätze in der Summary/Snippet RAG Methode. Das Modell kann eine Aktion "Prüfen: Dokument [1] [2]" präsentieren, um den vollständigen Text des entsprechenden Dokuments zu erhalten.

Mit der Inline-Suche kann das Modell eine Aktion "Suche: {Abfrage}" anfordern, um die relevantesten Absätze aus den Top 100 abzurufen. Diese Methode ist unserer insofern ähnlich, als sie als direkter Vergleich fungiert.

ReRank zieht nach dem Zufallsprinzip vier Antworten für jede Frage und wählt die beste Antwort auf der Grundlage einer Zitate-Recall-Metrik aus.

Die obige Grundlinie wurde im ursprünglichen ALCE-Benchmark-Test (Gao et al., 2023b) angewendet und bewertet. FG-Reward (Huang et al., 2024) schlägt vor, feinkörnige Belohnungen als Trainingssignale für die Feinabstimmung von LLaMA-2-7B (Touvron et al., 2023) zu verwenden, um zurechenbare Antworten zu generieren.VTG (Sun et al., 2024) verwendet wechselnde Speicher und einen zweischichtigen Überprüfer, um zurechenbare Antworten zu generieren. VTG (Sun et al., 2024) verwendet wechselnde Erinnerungen und einen zweischichtigen Validator, um das generative Modell (d.h. text-davinci-003) zu steuern.APO (Li et al., 2024) sammelte einen Präferenzpaar-Datensatz und wendete Präferenzoptimierung auf LLaMA-2-13B für die Textgenerierung mit Attribution an.

Details zur Implementierung. Wir verwenden LLaMA-3.1-8B-Instruct und GPT-40 als unsere Strategiemodelle, um die Leistung unseres Ansatzes zu bewerten. Für die Belohnungsmodelle verwenden wir das DPO-Modell, Llama-3-8B-SFR-Iterative-DPO-R¹, zur Berechnung von generativen Fortschrittsbelohnungen und das NLI-Modell, T5-XXL-TRUE-NLI-Mixture (Honovich et al., 2022), zur Berechnung von attributiven Fortschrittsbelohnungen. Für jede Suchanfrage werden die 3 besten Passagen aus dem Korpus als Referenzkandidaten abgerufen D t . Im UCT-Algorithmus (Gleichung 1) wird das Gewicht w auf 0,2 gesetzt. Für das SG-MCTS erweitern wir drei Kindknoten für jeden Elternknoten und setzen die maximale Baumebene auf 6 und die maximale Anzahl der Iterationen für das MCTS auf 30.

5.2 Wichtigste Ergebnisse

Tabelle 1 zeigt die Ergebnisse unserer Methode und der Baseline für die drei Datensätze.

Erstens ist festzustellen, dass die drei Retrieval Augmented Generation (RAG)-Methoden eine mäßige Leistung aufweisen, obwohl die Verwendung von Zusammenfassungen oder Snippets die Korrektheit verbessern kann. ReRank führt zu einer konsistenten Verbesserung der Zitierqualität in allen drei Datensätzen (z.B. verbessert Vanilla RAG die Zitierhäufigkeit von 73,61 TP3T auf 84,81 TP3T in ASQA). Im direkten Vergleich ist die Inline-Suche unserem Ansatz ähnlich, schneidet aber im Vergleich zu den anderen Cue-Baselines schlechter ab. Dies ist darauf zurückzuführen, dass einfach Suchanfragen gestellt werden, ohne die Qualität und Relevanz der Nachweise zu berücksichtigen.

Zweitens zeigen FG-Reward und APO durch die Feinabstimmung des LLM auf überwachten Trainingsdaten mit annotierten Zitaten eine verbesserte Zitierqualität in den ASQA- und ELI5-Datensätzen, aber keine verbesserte Leistung in QAMPARI. Darüber hinaus setzt VTG einen generativen Validator und einen In-Memory-Validator ein, um die logische Unterstützung der Belege zu bewerten, was zu einer hohen Zitierqualität führt (z. B. Zitieraufruf von 86,71 TP3T in ASQA). Allerdings sind fein abgestimmte LLMs durch die Qualität und Quantität der überwachten Trainingsdaten begrenzt, bei denen die Verknüpfung von Belegen mit der richtigen Quelle erhebliche Kosten verursacht. Außerdem beruhen diese Methoden immer noch auf der autoregressiven Generierung, einer schnellen, aber weniger genauen Denkweise. Folglich führt jeder zwischenzeitliche Generierungsfehler (z. B. falsche Darstellungen oder unzureichende Zitate) zu Problemen bei der endgültigen Antwort.

| ASQA | QAMPARI | ELI5 | |

|---|---|---|---|

| Korrektheit | Zitat | Korrektheit | Zitat |

| EM Rec. | Rec. | Genau. | Rückruf-5 |

| ChatGPT | |||

| Vanille RAG | 40.4 | 73.6 | 72.5 |

| mit ReRank | 40.2 | 84.8 | 81.6 |

| Zusammenfassung RAG | 43.3 | 68.9 | 61.8 |

| w/ Interact | 39.1 | 73.4 | 66.5 |

| Schnipsel RAG | 41.4 | 65.3 | 57.4 |

| mit/Interaktion | 41.2 | 64.5 | 57.7 |

| Inline-Suche | 32.4 | 58.3 | 58.2 |

| GPT-40 | |||

| Vanille RAG | 41.3 | 68.5 | 75.6 |

| mit ReRank | 42.1 | 83.4 | 82.3 |

| Zusammenfassung RAG | 46.5 | 70.2 | 67.2 |

| w/ Interact | 48.1 | 73.1 | 72.8 |

| Schnipsel RAG | 45.1 | 68.9 | 66.5 |

| mit/Interaktion | 45.2 | 67.8 | 66.7 |

| Inline-Suche | 40.3 | 65.7 | 66.9 |

| FG-Belohnung | 40.1 | 77.8 | 76.3 |

| VTG | 41.5 | 86.7 | 80.0 |

| APO | 40.5 | 72.8 | 69.6 |

| Unsere (LLaMA) | 45.2 | 82.3 | 80.6 |

| Unserer (GPT-40) | 50.1 | 89.5 | 87.1 |

Tabelle 1: Evaluierungsergebnisse der Generierung von Attributtexten auf drei Datensätzen. "Rec." und "Prec." sind Abkürzungen für Recall und Precision. Die fettgedruckten und unterstrichenen Schriftzeichen kennzeichnen die besten bzw. zweitbesten Ergebnisse in jedem Datensatz.

Think&Cite formuliert die Aufgabe der Attributtexterzeugung als ein mehrstufiges Argumentationsproblem und führt einen langsamen und bewussten Reflexionsmodus ein, um die beste Lösung zu finden. Durch den Vorschlag eines selbstgesteuerten MCTS-Algorithmus nutzt Think&Cite die selbstreflexive Fähigkeit von LLMs, um den Baumerweiterungsprozess zu steuern. Darüber hinaus kann das vorgeschlagene Modell der Fortschrittsbelohnung ein umfassendes und zuverlässiges Feedback liefern, das dem Modell hilft, bessere Antworten zu finden.

5.3 Weitere Analysen

Wir berichten über weitere Analysen unserer Methode bei ASQA unter Verwendung von GPT-40, da wir bei anderen Datensätzen ähnliche Ergebnisse erzielt haben.

Ablationsstudie. Um die Wirksamkeit unseres vorgeschlagenen Rahmens zu validieren, analysierten wir seine wichtigsten Gestaltungselemente für die Ablation. Wir haben vier Varianten entwickelt: (1) ohne SG-MCTS ohne das selbstgesteuerte MCTS und mit direkter schrittweiser Generierung von Antworten; (2) ohne Reflection ohne den Reflection-Schritt und mit dem Vanilla-MCTS-Algorithmus; (3) ohne GP Reward ohne die Notwendigkeit der Generierung von Fortschrittsbelohnungen R g (4) ohne AP-Belohnung Unverfallbare Fortschrittsbelohnungen wurden entfernt R a Die Ergebnisse sind in Tabelle 2 dargestellt. Wir zeigen die Ergebnisse in Tabelle 2. Alle Varianten schneiden schlechter ab als die ursprüngliche Methode, was auf die Wirksamkeit der einzelnen Komponenten hinweist. Insbesondere die Leistung von ohne SG-MCTS ist deutlich schlechter, was darauf hindeutet, dass die Integration eines Suchalgorithmus in die Texterstellung mit Attribution sehr vorteilhaft ist. Die Verwendung von Vanilla MCTS (ohne Reflection) führt zu einer schlechteren Zitierqualität, da falsche Referenzen eingeführt werden, ohne dass die gefundenen Ergebnisse reflektiert werden. Ebenso führen sowohl ohne GP Reward als auch ohne AP Reward zu einer schlechteren Leistung, was darauf hindeutet, dass sowohl die Generierung als auch die Überprüfung der Zitierqualität wesentlich sind.

| Methode | Korrektheit | Zitat |

|---|---|---|

| EM Rec. | Rec. | Genau. |

| Denken&Zeigen | 50.1 | 89.5 |

| mit OSG-MCTS | 42.1 | 78.2 |

| w/oReflection | 46.5 | 83.6 |

| w/oGPReward | 47.1 | 86.2 |

| w/oAPReward | 46.7 | 81.3 |

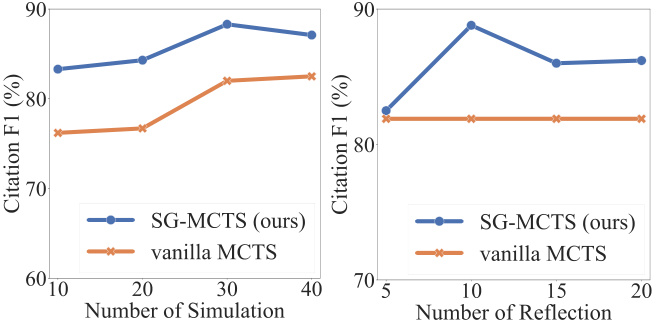

Selbstreflexion und Simulation. In jeder Simulation folgt SG-MCTS vier Schlüsselschritten und setzt Selbstreflexion ein, um die Qualität der Zwischenzustände in der Erweiterung durch Kritik und Verbesserung der Fehlerabfragen zu verbessern. Um die Wirksamkeit der Reflexion zu überprüfen, haben wir die Leistung zwischen der Erhöhung der maximalen Anzahl von Simulationen und der Erhöhung der maximalen Anzahl von Reflexionsoperationen verglichen. Zunächst änderten wir die maximale Anzahl der Simulationen auf {10, 20, 30, 40} und legten die maximale Anzahl der Reflexionen auf 10 fest. In ähnlicher Weise änderten wir die maximale Anzahl der Reflexionen auf {5, 10, 15, 20} und legten die maximale Anzahl der Simulationen auf 30 fest. In Abbildung 3 zeigen wir die F1-Ergebnisse auf der Grundlage des Recall und der Präzision der Zitate. Die Abbildung zeigt, dass eine Erhöhung sowohl der Anzahl der Simulationen als auch der Anzahl der Reflexionen die Leistung der Textgenerierung mit Namensnennung verbessert. Dies ist zu erwarten, da eine umfangreichere Exploration die Wahrscheinlichkeit erhöht, die richtige Generation zu finden. SG-MCTS übertrifft Vanilla MCTS ohne Reflexion, da es zu fehlerhaften Suchvorgängen im Elternknoten kommen kann, die dazu führen, dass der Schlussfolgerungsprozess im erweiterten Kindknoten auf dem falschen Weg fortgesetzt wird. Der Reflexionsschritt verbessert fehlerhafte Abrufe aufgrund unzureichender Abfragen, so dass die anschließende Exploration genauer ablaufen kann.

Abbildung 3: Ergebnisse zu ASQA in Bezug auf die Anzahl der Simulationen (linke Seite) oder die Anzahl der Reflexionsschritte (rechte Seite).

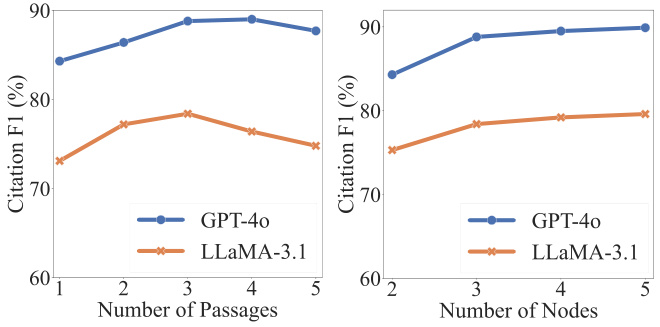

Analyse der Hyperparameter. Zwei Hyperparameter sind für die Korrektheit und Zitierqualität entscheidend: jede Abfrage qt Anzahl der abgerufenen Absätze |D t | und erweiterte Kindknoten in der Baumsuche st+1 Die Anzahl der abgerufenen Absätze. Wie aus Abbildung 4 hervorgeht, kann die Qualität der Zitate zunächst durch eine Erhöhung der Anzahl der abgerufenen Absätze verbessert werden. Eine weitere Erhöhung über einen bestimmten Schwellenwert hinaus führt jedoch zu einer schlechteren Leistung, vor allem weil die Zusammenführung von mehr Absätzen Rauschen verursacht, das sich negativ auf die Zuverlässigkeit des generierten Inhalts auswirkt. Andererseits stellen wir fest, dass eine Erhöhung der Anzahl der expandierten Knoten zu einer konsistenten Verbesserung führt, obwohl sich die Verbesserung später stabilisiert. Da die Erweiterung von mehr Knoten zu höheren Rechenkosten führt, extrahieren wir drei Kinder für jeden übergeordneten Knoten.

Abbildung 4: Ergebnisse zu ASQA in Bezug auf die Anzahl der Absätze (linke Seite) oder die Anzahl der erweiterten Knoten (rechte Seite).

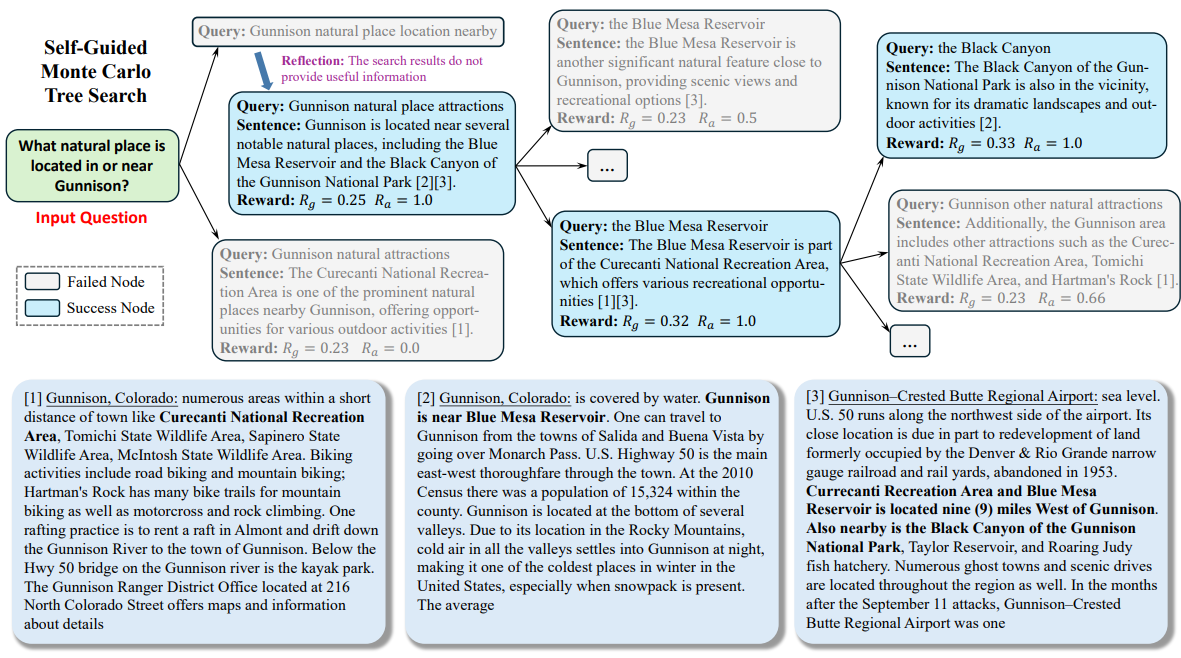

5.4 Fallstudien

Um das Verständnis für den gesamten Arbeitsablauf unserer Methode zu erleichtern, haben wir eine qualitative Analyse in ASQA durchgeführt. Wir zeigen ein Beispiel in Anhang C. Während des gesamten Suchprozesses behandelt LLM das Eingabeproblem als Wurzelknoten und erweitert den Suchbaum schrittweise, bis der Endzustand erreicht ist. Wie gezeigt, generiert das Modell zunächst eine Anfrage (z. B. "Lage der nahegelegenen Naturattraktionen von Gunnison"), um Passagen abzurufen. Da die Passage keine gültigen Informationen enthält, die zur Beantwortung der Frage benötigt werden, überlegt das Modell und schlägt eine neue Abfrage (d.h. "Gunnison natural attraction sites") zum Abruf vor. Auf der Grundlage der abgerufenen Absätze generiert das Modell Sätze und verweist auf den zweiten und dritten Absatz (d. h. "[2][3]"). Durch einen mehrstufigen Generierungsprozess kann das Modell tief in das Thema eintauchen und zuverlässige Inhalte mit genauen Zitaten ausgeben.

6 Schlussfolgerung

In dieser Arbeit stellen wir Think&Cite vor, ein neues Framework für die Generierung von Attributtexten mit integrierter Baumsuche. Think&Cite baut auf dem iterativen Think-Express-Cite-Generierungsparadigma auf. Um den Generierungsprozess zu verbessern, schlagen wir eine selbstgesteuerte Monte-Carlo-Baumsuche vor, die die selbstreflexive Fähigkeit von LLMs ausnutzt, um die Zwischenzustände von MCTSs zu kritisieren und zu korrigieren, um die Baumexpansion zu steuern. Darüber hinaus schlagen wir das Progress Reward Model vor, um den Fortschritt der Baumsuche zu messen und zuverlässiges Feedback zu geben. Ausführliche Experimente an drei Datensätzen zeigen, dass die von uns vorgeschlagene Think&Cite die traditionellen Hinting- und Fine-Tuning-Methoden übertrifft.

Einschränkungen

Der Umfang unserer Experimente ist durch die erheblichen Rechenkosten der baumbasierten Suchmethoden begrenzt. Zukünftige Arbeiten könnten ein breiteres Spektrum von Datensätzen zur Generierung von Attributtexten untersuchen. In unserem Modell wird die Monte-Carlo-Baumsuche für die selbstgesteuerte Generierung verwendet. Zukünftige Arbeiten könnten weitere Suchalgorithmen untersuchen, um die Allgemeingültigkeit und Robustheit des von uns vorgeschlagenen Rahmens zu evaluieren.

anhang

Ein Datensatz

Wir bewerten unseren Ansatz anhand des ALCE-Benchmarks, der aus drei Datensätzen besteht. Der ASQA-Datensatz (Stelmakh et al., 2022) enthält 948 Fragen mit Antworten aus Wikipedia; der QAMPARI-Datensatz (Amouyal et al., 2022) enthält 1.000 Fragen aus Wikipedia; und der ELI5-Datensatz (Fan et al., 2019) enthält 1.000 Fragen und die Antworten können in Sphere (Piktus et al., 2021) gefunden werden. Einzelheiten zu diesen drei Datensätzen finden Sie in Tabelle 3.

| Datensatz | Korpus (#-Passagen) | Art des Problems |

|---|---|---|

| ASQA | Wikipedia (21 Millionen) | sachlich |

| QAMPARI | Wikipedia (21 Millionen) | Faktisch (Tabellierung) |

| ELI5 | Sphäre (899 Millionen) | Warum/Wie/Was |

B Tipps

Die Hinweise zum Kontextlernen für die Datensätze ASQA, QAMPARI und ELI5 sind in den Tabellen 4, 5 bzw. 6 aufgeführt. In diesen Hinweisen haben wir zunächst vier Operationen im iterativen Think-Express-Reference-Paradigma für LLM definiert. Dann konstruierten wir vier kontextuelle Beispiele, die so ausgewählt wurden, dass sie mit dem ALCE-Benchmark übereinstimmen (Gao et al., 2023b).

C Fallstudien

Ein Beispiel aus ASQA ist in Abbildung 5 dargestellt.

Ihr Ziel ist es, eine genaue, interessante und prägnante Antwort auf eine vorgegebene Frage zu verfassen und dabei nur die angegebenen Suchergebnisse zu verwenden und diese korrekt zu zitieren. Verwenden Sie einen fairen und journalistischen Ton. Geben Sie immer ein Zitat für jede Tatsache an. Sie können vier Aktionen verwenden:

- """Suche: Schlüsselwörter""", die einige Schlüsselwörter abfragt und die relevantesten Dokumente auf der Grundlage des Such- und Generierungsverlaufs abruft.

- """Nachdenken: Ideen"""" und Nachdenken über die Suchergebnisse, wenn kein gültiges Dokument zur Beantwortung der Frage gefunden wurde.

- """Ausgabe: Satz """der eine lange Antwort auf der Grundlage des abgerufenen Dokuments ausgibt. In der Antwort wird es korrekt zitiert, indem [1][2][3] verwendet wird. Zitieren Sie mindestens ein Dokument und bis zu drei Dokumente pro Satz. Wenn mehrere Dokumente den Satz unterstützen, wird nur die am wenigsten ausreichende Teilmenge von Dokumenten zitiert.

- """Ende""", so wird die Quizaufgabe beendet.

Hier sind einige Beispiele:

Frage : Wer hat den Rekord für den weitesten Weitwurf aufgestellt?

Suche : Rekord im Weitschießen

Document[1] (Bildunterschrift: David Akers) stellte einen Rekord für das längste Field Goal auf, indem er ein 63-Yard-Field Goal über die Latte schoss.

Dokumentation[2] (Titel: Dirk Borgognone) Dirk Borgognone, Dirk Ronald Borgognone (geboren am 9. Januar 1968) ist ein ehemaliger Nationalspieler...

Dokument[3] (Titel: Russell Elkseben) gegen die University of Colorado. Trotz anfänglicher Schwierigkeiten im Spiel, darunter...

Reflexion: Die Suchergebnisse lieferten keine gültigen Informationen zur Beantwortung der Frage. Es ist besser, nach dem Rekord für das längste Field Goal in der NFL zu suchen.

Suche : Rekord für das längste Field Goal in der NFL

Dokument[4] (Titel: Field Goal) in Richtung der eigenen Endzone. Das längste Field Goal in der Geschichte der NFL ist 64 Yards lang, ein Rekord, der von...

Dokument [5] (Titel: Field Goal Range) Endzone an beiden Enden) war nur 66 Yards. Scaccia, der Hallenfußball spielte, versuchte einen 64-Yard-Versuch...

Dokument[6] (Titel: Range of Shots) Diese Leistung ist kein offizieller Rekord. Alle oben genannten Schüsse waren erfolgreich...

Ergebnis: Der Rekord für das längste Field Goal in einem NFL-Spiel liegt bei 64 Yards, aufgestellt von Matt Prater[4].

Suche : Rekord für den längsten Schuss in einem beliebigen Wettbewerb, College

Dokument[7] (Titel: Field Goal) in Richtung der eigenen Endzone. Das längste Field Goal in der Geschichte der NFL ist 64 Yards, ein Rekord, der von...

Dokumentation[8] (Titel: Range of Shots) Von der 35 bis 40 Yard-Linie (bei Seitenwind näher) werden in der Regel die riskanteren...

Dokument[9] (Titel: Field Goal Range) NFL, und ist von der NCAA seit 1989 verboten) ist 68 Yards, gehalten von Fabrizio Scaccia...

Ergebnis: Der Rekord für das längste Field Goal auf allen Wettbewerbsebenen liegt jedoch bei 69 Yards, geschossen von College-Kicker Ove Johansson in einem Footballspiel zwischen der Abilene Christian University und der East Texas State University im Jahr 1976[8]. Das Ende.

Ihr Ziel ist es, eine genaue, interessante und prägnante Antwort auf eine vorgegebene Frage zu verfassen und dabei nur die angegebenen Suchergebnisse zu verwenden und diese korrekt zu zitieren. Verwenden Sie einen fairen und journalistischen Ton. Geben Sie immer ein Zitat für jede Tatsache an. Sie können vier Aktionen verwenden:

- """Suche: Schlüsselwörter""", die einige Schlüsselwörter abfragt und die relevantesten Dokumente auf der Grundlage des Such- und Generierungsverlaufs abruft.

- """Nachdenken: Ideen"""" und Nachdenken über die Suchergebnisse, wenn kein gültiges Dokument zur Beantwortung der Frage gefunden wurde.

- """Ausgabe: Satz """der eine lange Antwort auf der Grundlage des abgerufenen Dokuments ausgibt. In der Antwort wird es korrekt zitiert, indem [1][2][3] verwendet wird. Zitieren Sie mindestens ein Dokument und bis zu drei Dokumente pro Satz. Wenn mehrere Dokumente den Satz unterstützen, wird nur die am wenigsten ausreichende Teilmenge von Dokumenten zitiert.

- """Ende""", so wird die Quizaufgabe beendet.

Hier sind einige Beispiele:

Frage: Welche Bücher hat Nevil Shute geschrieben?

Suche : Neville Shute Themen Soziale Unruhen

Dokument[1] (Titel: Nevil Shute) Frühes Stadium. Meine Glückwünsche." Sein Ruf als Schriftsteller veranlasste das Informationsministerium, ihn in die...

Dokument [2] (Titel: Nevil Shute) Das Thema ist das Überschreiten sozialer Grenzen wie Klasse ("The Lonely Road" und "The Landing"), Ethnie...

Dokument[3] (Titel: Nevil Shute) Flugzeugbauunternehmen, Airspeed Ltd. Seine Romane wurden immer beliebter, aber er wurde noch berühmter...

Output : Beyond the Black Stump [2], Lonely Road [2], Chessboard [2], In the Damp [2], Toolroom Trustee [2], Around the Bend [2].

Suche : Nevil Shute Einfach lesbarer Stil

Dokumente[4] (Nevil Shute) Flugzeugbauunternehmen, Airspeed Ltd. Seine Romane wurden immer beliebter, aber er wurde noch berühmter...

Document[5] (Checkerboard) People of Burma", die beide eine zentrale Rolle in der Geschichte des Buches spielen. Schutt ist besorgt über die Verkaufszahlen des Buches...

Dokumentation[6] (wet) Er verwendete die Idee der Abstimmung mehrmals in der Kurzgeschichte "Die seltsame Republik Gondor"...

Reflexion: Die Suchergebnisse lieferten keine nützlichen Informationen zur Beantwortung der Frage. Suchen Sie lieber nach Büchern von Nevil Shute aus den 1950er Jahren.

Suche : 1950er Bücher von Nevil Shute

Dokument[7] (Nevil Shute) Frühes Stadium. Meine Glückwünsche." Sein Ruf als Schriftsteller veranlasste das Informationsministerium, ihn in die...

Dokument [8] (Nevil Shute) Das Thema ist das Überschreiten sozialer Grenzen wie Klasse ("The Lonely Road" und "The Landing"), Ethnie ("The Chessboard")...

Dokumente[9] (Nevil Shute) Flugzeugbauunternehmen, Airspeed Ltd. Seine Romane wurden immer beliebter, aber er wurde noch berühmter...

Ausgabe: Malazan [7], Stephen Morris [7].

schließen

Ihr Ziel ist es, eine genaue, interessante und prägnante Antwort auf eine vorgegebene Frage zu verfassen und dabei nur die angegebenen Suchergebnisse zu verwenden und diese korrekt zu zitieren. Verwenden Sie einen fairen und journalistischen Ton. Geben Sie immer ein Zitat für jede Tatsache an. Sie können vier Aktionen verwenden:

- """Suche: Schlüsselwörter""", die einige Schlüsselwörter abfragt und die relevantesten Dokumente auf der Grundlage des Such- und Generierungsverlaufs abruft.

- """Nachdenken: Ideen"""" und Nachdenken über die Suchergebnisse, wenn kein gültiges Dokument zur Beantwortung der Frage gefunden wurde.

- """Ausgabe: Satz """der eine lange Antwort auf der Grundlage des abgerufenen Dokuments ausgibt. In der Antwort wird es korrekt zitiert, indem [1][2][3] verwendet wird. Zitieren Sie mindestens ein Dokument und bis zu drei Dokumente pro Satz. Wenn mehrere Dokumente den Satz unterstützen, wird nur die am wenigsten ausreichende Teilmenge von Dokumenten zitiert.

- """Ende""", so wird die Quizaufgabe beendet.

Hier sind einige Beispiele:

Frage: Was verursacht eine bipolare Störung?

Suche : Was ist eine bipolare Störung?

Dokument [1] (Titel: Bipolare Störung Typ II) Forschung zur Festlegung persönlicher Wahrnehmungs- und Verhaltensgrenzen. Die Forschung legt Folgendes nahe...

Dokument [2] (Titel: Biologie der bipolaren Störung) Hirnregionen, die in diesen Bereichen liegen, werden als Mechanismus der bipolaren Störung vermutet...

Dokument [3] (Titel: Biologie der bipolaren Störung) unabhängig von der Polarität. Bei der bipolaren Störung wurde über Entzündungen berichtet...

Reflexion: Die Suchergebnisse lieferten keine gültigen Informationen zur Beantwortung der Frage. Es ist besser, nach Symptomen einer bipolaren Störung zu suchen.

Suche : Welche Symptome treten bei einer bipolaren Störung auf? Wie lange dauern sie an?

Dokument [4] (Titel: Bipolare Störung | Definition im medizinischen Wörterbuch) Bipolare Störung | Definition der bipolaren Störung...

Dokument [5] (Titel: Manie und bipolare Störung) kann von depressiv bis "sehr glücklich" reichen, und das an einem einzigen Tag oder sogar innerhalb weniger Tage, was...

Dokument [6] (Titel: Für Einzelpersonen - Adam Schwartz) Für Einzelpersonen 2014 Adam Schwartz Die Informationen sind umfangreich und decken...

Ausgangssituation: Die bipolare Störung ist eine Stimmungsstörung, die extreme Stimmungsschwankungen verursacht, die von Euphorie bis hin zu Depression reichen [4]. Die Stimmungsschwankungen können von Tagen bis zu Monaten reichen [5].

Suche : Was verursacht eine bipolare Störung?

Dokument [7] (Titel: Bipolare Störung) Bei der bipolaren Störung handelt es sich in der Regel um eine zyklische Störung, bei der der Betroffene Depressionen...

Dokument [8] (Titel: Depression - Bipolare Störung - Symptome 2019 | Depression besiegen) Depression - Bipolare Störung - Symptome 2019.

Die Dokumentation[9] (Titel: Psychische Störungen) kann elterliche Faktoren beinhalten, einschließlich elterlicher Ablehnung, fehlender elterlicher Wärme...

AUSGANGSLAGE: Die genauen Faktoren, die zu dieser Krankheit beitragen, sind noch nicht bekannt, aber es wird vermutet, dass die Genetik ein wichtiger Faktor ist [7].

schließen

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...