Tarsier: ein quelloffenes Videoverstehensmodell zur Erstellung hochwertiger Videobeschreibungen

Allgemeine Einführung

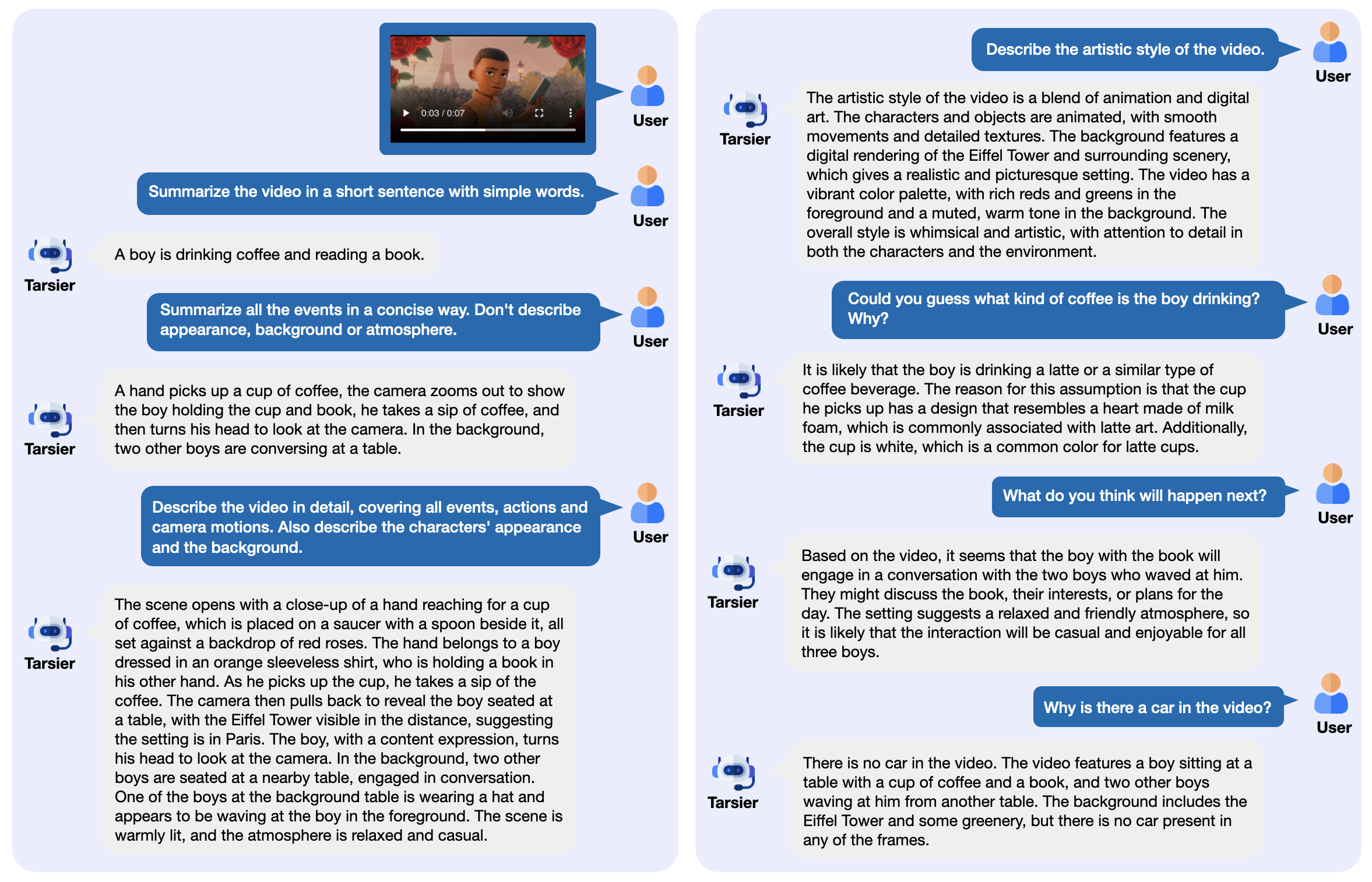

Tarsier ist eine Familie von Open-Source-Videosprachmodellen, die von ByteDance entwickelt wurden und hauptsächlich zur Erstellung hochwertiger Videobeschreibungen verwendet werden. Es besteht aus einer einfachen Struktur: CLIP-ViT verarbeitet die Videobilder und analysiert die zeitlichen Beziehungen in Kombination mit einem Large Language Model (LLM). Die neueste Version, Tarsier2-7B (veröffentlicht im Januar 2025), erreichte in 16 öffentlichen Benchmarks den Spitzenwert und kann mit Modellen wie GPT-4o konkurrieren. Tarsier unterstützt Videobeschreibungen, Q&A und die Erzeugung von Untertiteln ohne Stichproben, und der Code, die Modelle und die Daten sind auf GitHub öffentlich zugänglich. Das Projekt hat auch den DREAM-1K-Benchmark zur Bewertung von Videobeschreibungsfähigkeiten gestartet, der 1000 verschiedene Videoclips enthält.

Funktionsliste

- Generieren Sie detaillierte Videobeschreibungen: Analysieren Sie den Videoinhalt und geben Sie einen detaillierten Text aus.

- Video-Q&A-Unterstützung: Beantworten Sie videorelevante Fragen, z. B. zu Ereignissen oder Details.

- Zero-Sample-Untertitel-Generierung: Generierung von Untertiteln für Videos ohne Training.

- Multitasking-Videoverständnis: zeichnet sich durch mehrere Aufgaben aus, z. B. Quizzing und Untertitelung.

- Open-Source-Bereitstellung: Bereitstellung von Modellgewichten und Code zur lokalen Ausführung oder in der Cloud.

- Bereitstellung von Bewertungsinstrumenten: Umfasst den DREAM-1K-Datensatz und die AutoDQ-Bewertungsmethodik.

Hilfe verwenden

Tarsier eignet sich für Benutzer mit technischem Hintergrund, z. B. Entwickler oder Forscher. Ausführliche Anweisungen zur Installation und Verwendung finden Sie weiter unten.

Einbauverfahren

- Vorbereiten der Umgebung

Erfordert Python 3.9 oder höher. Eine virtuelle Umgebung wird empfohlen:

conda create -n tarsier python=3.9

conda activate tarsier

- Klon-Lager

Laden Sie den Code des Tarsier-Projekts herunter:

git clone https://github.com/bytedance/tarsier.git

cd tarsier

git checkout tarsier2

- Installation von Abhängigkeiten

Führen Sie das Installationsskript aus:

bash setup.sh

Dadurch werden alle notwendigen Bibliotheken, wie PyTorch und die Tools von Hugging Face, installiert.

- GPU-Unterstützung (optional)

Wenn Sie eine NVIDIA GPU haben, installieren Sie PyTorch mit CUDA:

pip install torch torchvision --index-url https://download.pytorch.org/whl/cu118

- Modelle herunterladen

Laden Sie Modelle von Hugging Face herunter, z. B. Tarsier2-7B:

huggingface-cli download omni-research/Tarsier2-7b

Andere Modelle wie Tarsier-34b oder Tarsier2-Recap-7b sind ebenfalls über die offiziellen Links erhältlich.

- Überprüfen der Installation

Führen Sie das Schnelltest-Skript aus:

python3 -m tasks.inference_quick_start --model_name_or_path path/to/Tarsier2-7b --input_path assets/videos/coffee.gif

Die Ausgabe sollte eine Beschreibung des Videos sein, z. B. "Ein Mann nimmt eine Kaffeetasse mit herzförmigem Schaum und nimmt einen Schluck".

Hauptfunktionen

Videobeschreibung generieren

- umziehen

- Bereiten Sie eine Videodatei vor (unterstützt Formate wie MP4, GIF, usw.).

- Befehl ausführen:

python3 -m tasks.inference_quick_start --model_name_or_path path/to/Tarsier2-7b --instruction "Describe the video in detail." --input_path your/video.mp4

- Die Ausgabe wird auf dem Terminal angezeigt, z. B. mit einer Beschreibung der Aktionen und Szenen im Video.

- zur Kenntnis nehmen

- Zu lange Videos benötigen möglicherweise mehr Speicherplatz, daher empfehlen wir, zunächst mit einem kurzen Video zu testen.

- Einstellbare Parameter wie die Bildrate (siehe

configs/tarser2_default_config.yaml).

Video-Fragen und Antworten

- umziehen

- Geben Sie Fragen und Videos an:

python3 -m tasks.inference_quick_start --model_name_or_path path/to/Tarsier2-7b --instruction "视频里的人在做什么?" --input_path your/video.mp4

- Geben Sie eine direkte Antwort aus, z. B. "Er trinkt Kaffee".

- auf etw. aufmerksam machen

- Die Fragen sollten spezifisch sein und Zweideutigkeiten vermeiden.

- Unterstützt Chinesisch und andere Sprachen, wobei Chinesisch am besten funktioniert.

Erzeugung von Untertiteln ohne Beispiel

- umziehen

- Ändern Sie die Konfigurationsdatei, um den Untertitelmodus zu aktivieren (

configs/tarser2_default_config.yamlaufstellentask: caption). - Laufen:

python3 -m tasks.inference_quick_start --model_name_or_path path/to/Tarsier2-7b --config configs/tarser2_default_config.yaml --input_path your/video.mp4

- Gibt kurze Untertitel aus, z. B. "Allein Kaffee trinken".

Bereitstellung lokaler Dienste

- umziehen

- Installieren Sie vLLM (empfohlene Version 0.6.6):

pip install vllm==0.6.6

- Starten Sie den Dienst:

python -m vllm.entrypoints.openai.api_server --model path/to/Tarsier2-7b

- Aufgerufen mit einer API:

curl http://localhost:8000/v1/completions -H "Content-Type: application/json" -d '{"prompt": "描述这个视频", "video_path": "your/video.mp4"}'

- Blickwinkel

- Videos können in Stapeln verarbeitet werden.

- Einfache Integration in andere Systeme.

Featured Function Bedienung

DREAM-1K-Bewertung

- umziehen

- Laden Sie den DREAM-1K-Datensatz herunter:

wget https://tarsier-vlm.github.io/DREAM-1K.zip

unzip DREAM-1K.zip

- Operative Bewertung:

bash scripts/run_inference_benchmark.sh path/to/Tarsier2-7b output_dir dream

- Die Ausgabe enthält Metriken wie F1-Scores, die die Qualität der Beschreibung anzeigen.

AutoDQ-Auswertung

- umziehen

- Sicherstellung der Installation ChatGPT Abhängigkeiten (Azure OpenAI-Konfiguration erforderlich).

- Führen Sie das Auswertungsskript aus:

python evaluation/metrics/evaluate_dream_gpt.py --pred_dir output_dir/dream_predictions

- Gibt eine automatische Bewertungsnote aus, die die Genauigkeit der Beschreibung misst.

Häufig gestellte Fragen

- InstallationsfehlerÜberprüfen Sie die Python-Version und das Netzwerk, aktualisieren Sie pip (

pip install -U pip). - Langsames Laden von ModellenVergewissern Sie sich, dass Sie über genügend Speicherplatz verfügen, empfohlen werden mindestens 50 GB.

- Keine GPU-Ausgabe: Lauf

nvidia-smiÜberprüfen Sie, ob CUDA ordnungsgemäß funktioniert.

Online-Erfahrung

- Interviews Tarsier2-7B Online-DemoWenn Sie die Beschreibung und die Frage- und Antwortfunktion testen möchten, laden Sie ein Video hoch.

Mit diesen Schritten können Sie Videoaufgaben mit Tarsier leicht bewältigen. Ganz gleich, ob Sie Beschreibungen erstellen oder Dienste einrichten, es ist einfach und effizient.

Anwendungsszenario

- Zusammenstellung von Videoinhalten

Medienschaffende können mit Tarsier Videozusammenfassungen erstellen und das Filmmaterial schnell organisieren. - Video-Assistenz für Bildungszwecke

Lehrkräfte können Untertitel oder Quizfragen für Kursvideos erstellen, um das Lehren und Lernen zu verbessern. - Kurze Videoanalyse

Vermarkter können den Inhalt von Kurzvideos wie TikTok analysieren und Schlüsselbotschaften für die Werbung extrahieren.

QA

- Welche Videoformate werden unterstützt?

Unterstützt MP4, GIF, AVI, usw., sofern FFmpeg diese dekodieren kann. - Welche Hardware-Anforderungen gibt es?

Mindestens 16 GB RAM und 4 GB Videospeicher, NVIDIA-GPU empfohlen (z. B. 3090). - Ist sie im Handel erhältlich?

Ja, Tarsier verwendet die Apache 2.0 Lizenz und die kommerzielle Nutzung ist unter bestimmten Bedingungen erlaubt.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...