RunPod: GPU-Cloud-Service für KI mit schnellem Cold Start SD und Pay per Second

Allgemeine Einführung

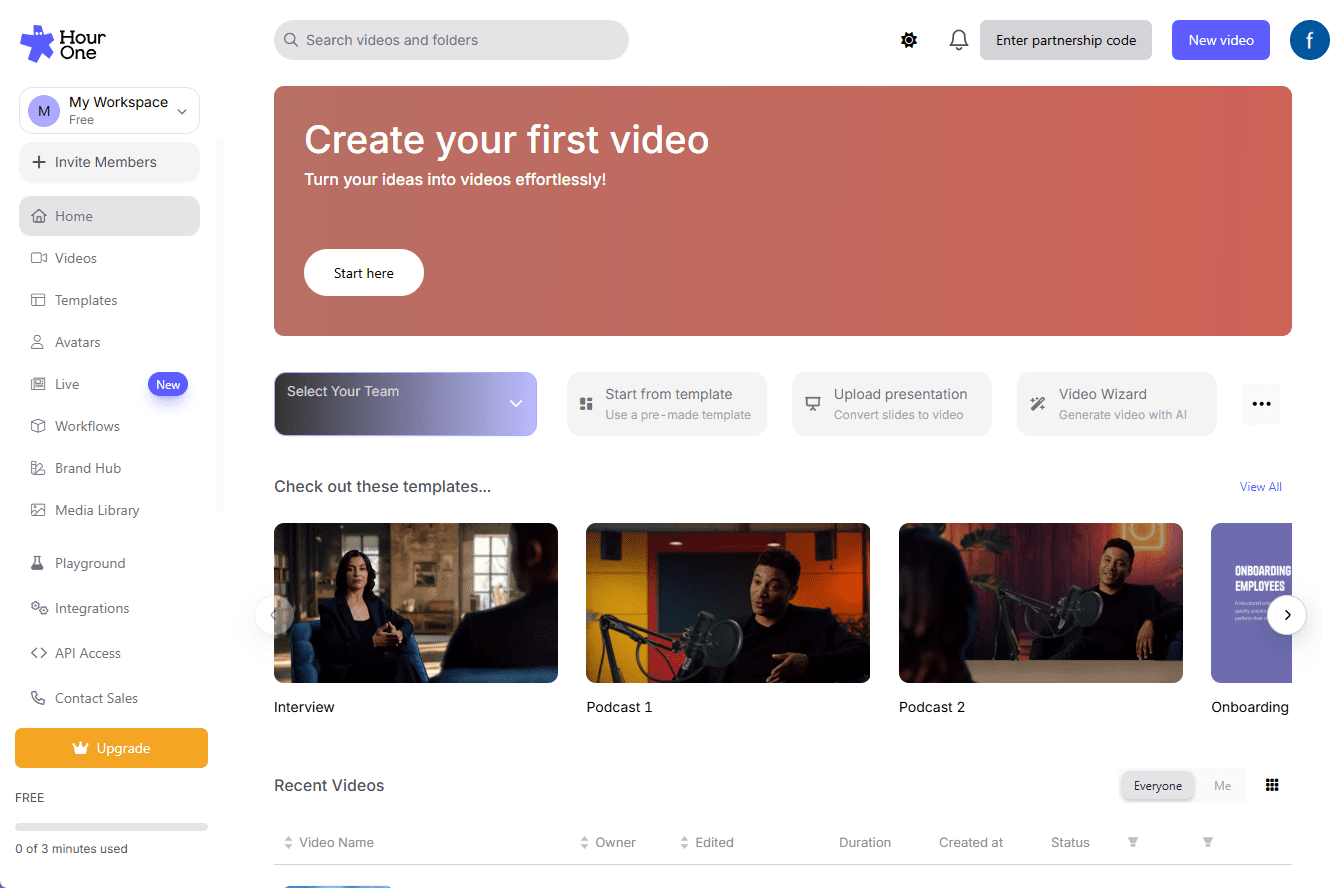

RunPod ist eine Cloud-Computing-Plattform speziell für KI, die Entwicklern, Forschern und Unternehmen eine Komplettlösung für die Entwicklung, das Training und die Skalierung von KI-Modellen bieten soll. Die Plattform integriert On-Demand-GPU-Ressourcen, Serverless Reasoning, automatische Skalierung und vieles mehr, um alle Phasen von KI-Projekten zu unterstützen. Die Kernphilosophie von RunPod ist es, den KI-Entwicklungsprozess zu vereinfachen, damit sich die Nutzer auf die Modellinnovation konzentrieren können, ohne sich zu sehr um Infrastrukturfragen kümmern zu müssen.

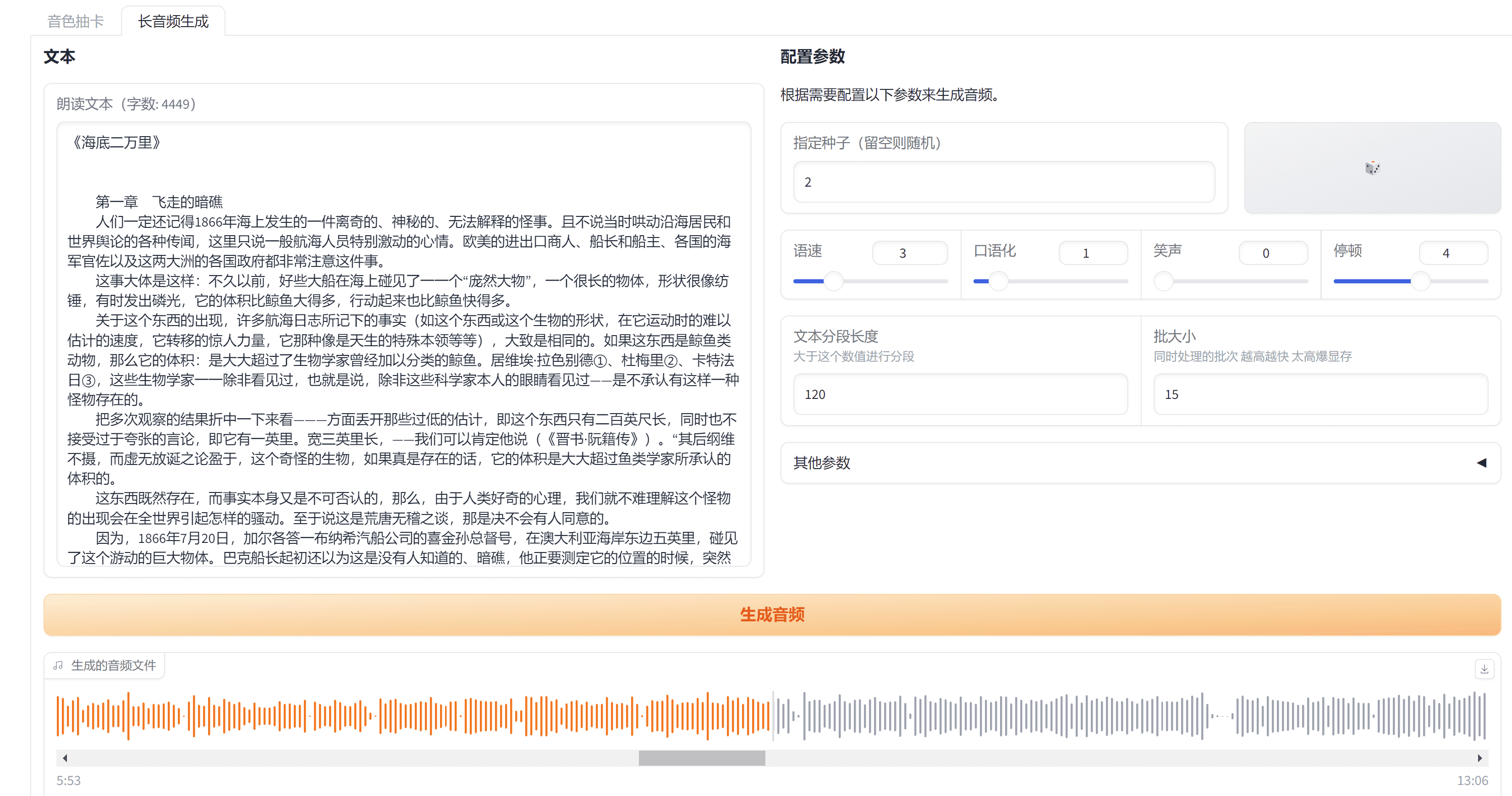

Zahlung nur zum Zeitpunkt der Anfrage und schneller Kaltstart, geeignet für niedrigfrequente Dienste und erfordert qualitativ hochwertigen Betrieb. In der Zwischenzeit unterstützt die Klasse der natürlichen Sprachverarbeitung von großen Sprachmodellen die Bezahlung pro Token.

Funktionsliste

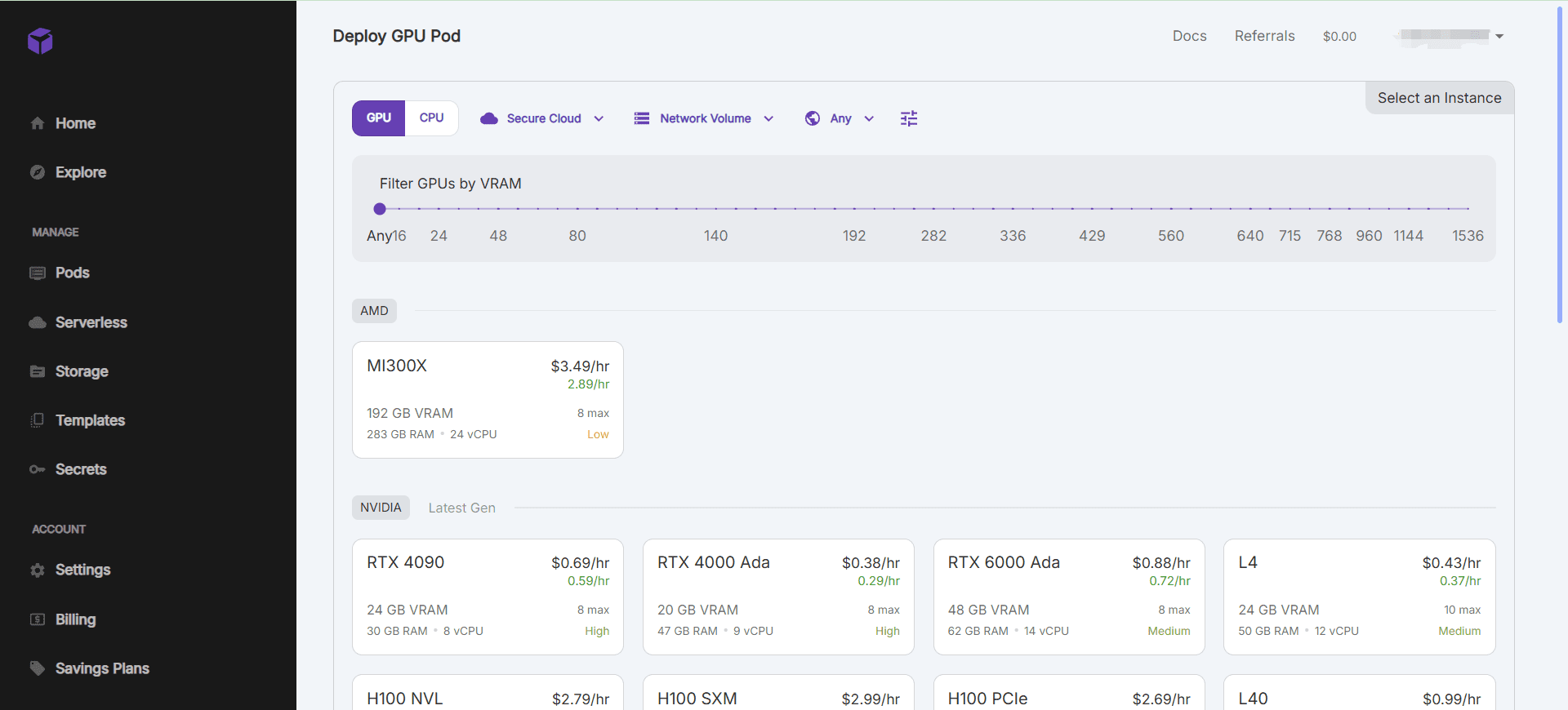

- GPU-Ressourcen auf AbrufSchnelles Starten von GPU-Instanzen und Unterstützung für mehrere GPU-Modelle, um unterschiedliche arithmetische Anforderungen zu erfüllen.

- Serverlose ArgumentationAutomatische Skalierung der Argumentationsfähigkeiten zur effizienten Bewältigung wechselnder Arbeitsbelastungen.

- Integration der EntwicklungsumgebungVorkonfigurierte KI-Entwicklungsumgebung mit Unterstützung für gängige Deep-Learning-Frameworks und -Tools.

- Datenverwaltung und -speicherungIntegrierte Datenspeicherlösung mit effizienten Datenübertragungs- und Zugriffsmechanismen.

- Zusammenarbeit und VersionskontrolleUnterstützt die gemeinsame Entwicklung im Team und bietet Funktionen zur Modellversionierung.

Hilfe verwenden

Installation und Nutzung

- Erstellen einer GPU-Instanz::

- Wenn Sie angemeldet sind, gehen Sie auf die Konsolenseite und klicken Sie auf "Pod erstellen".

- Wählen Sie das gewünschte GPU-Modell und die Konfiguration und klicken Sie auf "Erstellen", um die Instanz zu starten.

- Sobald die Instanz gestartet ist, kann sie über eine SSH- oder Webterminal-Verbindung bedient werden.

- Verwendung vorkonfigurierter Umgebungen::

- RunPod bietet eine breite Palette an vorkonfigurierten KI-Entwicklungsumgebungen wie PyTorch, TensorFlow und mehr.

- Bei der Erstellung einer Instanz können Sie die gewünschte Umgebungsvorlage auswählen und schnell mit der Projektentwicklung beginnen.

- Datenverwaltung::

- RunPod bietet eine integrierte Datenspeicherlösung zur Verwaltung von Datensätzen in der Konsole.

- Unterstützt das Hoch- und Herunterladen sowie die gemeinsame Nutzung von Daten, um die Sicherheit der Daten und den Schutz der Privatsphäre zu gewährleisten.

- Zusammenarbeit und Versionskontrolle::

- Unterstützt die kollaborative Teamentwicklung: Teammitglieder können eingeladen werden, gemeinsam an Projekten zu arbeiten.

- Bieten Sie eine Funktion zur Verwaltung von Modellversionen an, mit der sich verschiedene Versionen von Modellen leicht verfolgen und verwalten lassen.

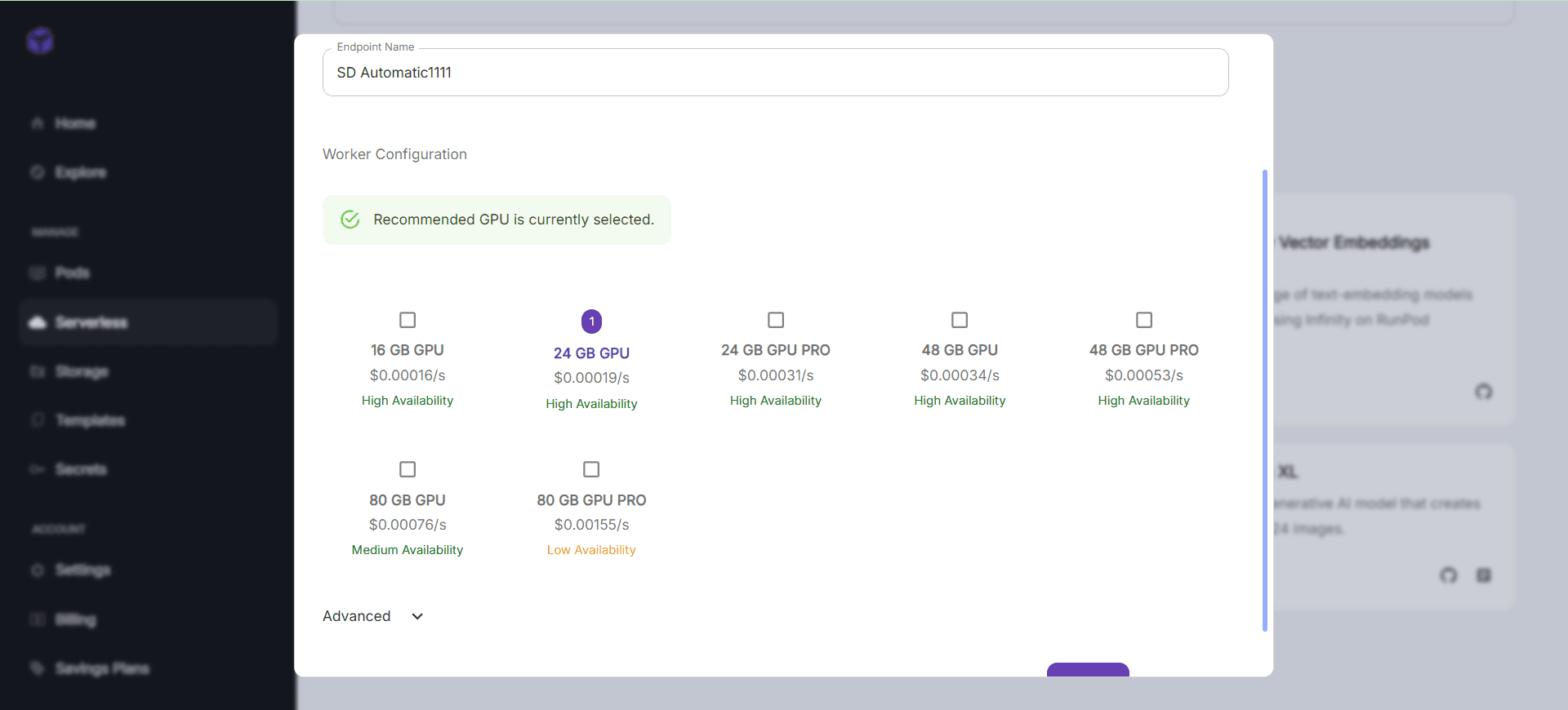

- Serverlose Argumentation::

- RunPod unterstützt eine serverlose Architektur und skaliert automatisch die Inferenzfunktionen.

- API-Endpunkte können in der Konsole konfiguriert werden, um Online-Inferenzdienste für Modelle zu aktivieren.

Arbeitsablauf

- Schnellstart GPU Beispiel::

- Melden Sie sich an der Konsole an und wählen Sie "Pod erstellen".

- Wählen Sie das gewünschte GPU-Modell und die Konfiguration und klicken Sie auf "Erstellen".

- Nach dem Start der Instanz wird diese über eine SSH- oder Webterminalverbindung bedient.

- Verwendung vorkonfigurierter Umgebungen::

- Wählen Sie bei der Erstellung einer Instanz die gewünschte Umgebungsvorlage aus.

- Nachdem Sie die Instanz verbunden haben, können Sie die vorkonfigurierte Entwicklungsumgebung direkt für die Projektentwicklung nutzen.

- Datenverwaltung::

- Verwalten Sie Datensätze in der Konsole, um das Hochladen, Herunterladen und Teilen von Daten zu unterstützen.

- Gewährleistung der Datensicherheit und des Schutzes der Privatsphäre.

- Zusammenarbeit und Versionskontrolle::

- Laden Sie Teammitglieder ein, gemeinsam an Projekten zu arbeiten, und verwenden Sie Versionierungsfunktionen, um Modellversionen zu verfolgen und zu verwalten.

- Serverlose Argumentation::

- Konfigurieren Sie API-Endpunkte in der Konsole, um Online-Inferenzdienste für Modelle zu aktivieren.

- Automatische Skalierung der Inferenzfunktionen zur effizienten Bewältigung wechselnder Arbeitslasten.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...