Wie die Bots von OpenAI "wie ein DDoS-Angriff" agierten, um die Website des siebenköpfigen Unternehmens zu zerstören

Am Samstag wurde der CEO von Triplegangers, Oleksandr Tomchuk, benachrichtigt, dass die E-Commerce-Website seines Unternehmens nicht mehr erreichbar sei. Es sah aus wie eine Art verteilter Denial-of-Service-Angriff.

Bald findet er heraus, dass es sich bei dem Übeltäter um einen der Bots von OpenAI handelt, der unablässig versucht, seine gesamte umfangreiche Website zu crawlen.

"Wir haben über 65.000 Produkte, und jedes Produkt hat eine Seite", sagte Tomchuk gegenüber TechCrunch. "Jede Seite hat mindestens drei Fotos."

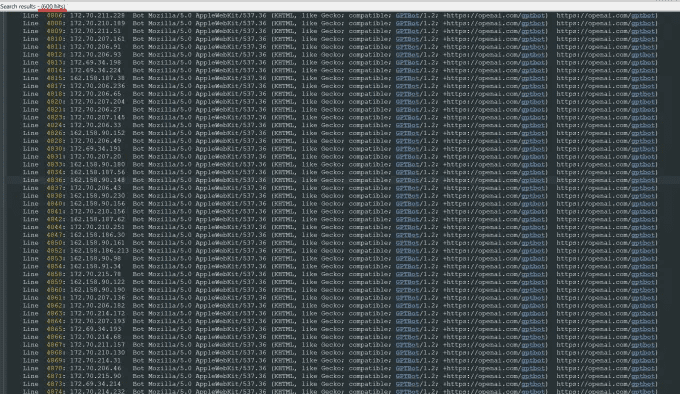

OpenAI schickte "Zehntausende" von Serveranfragen, um all diese Inhalte herunterzuladen, darunter Hunderttausende von Fotos und deren detaillierte Beschreibungen.

"OpenAI hat 600 IPs verwendet, um die Daten zu crawlen, und wir analysieren immer noch die Logs der letzten Woche, so dass die Zahl vielleicht noch höher ist", sagte er über die IP-Adressen, die der Bot verwendet hat, um auf seine Website zuzugreifen.

"Ihre Crawler zerstörten unsere Website", sagte er, "es war im Grunde ein DDoS-Angriff".

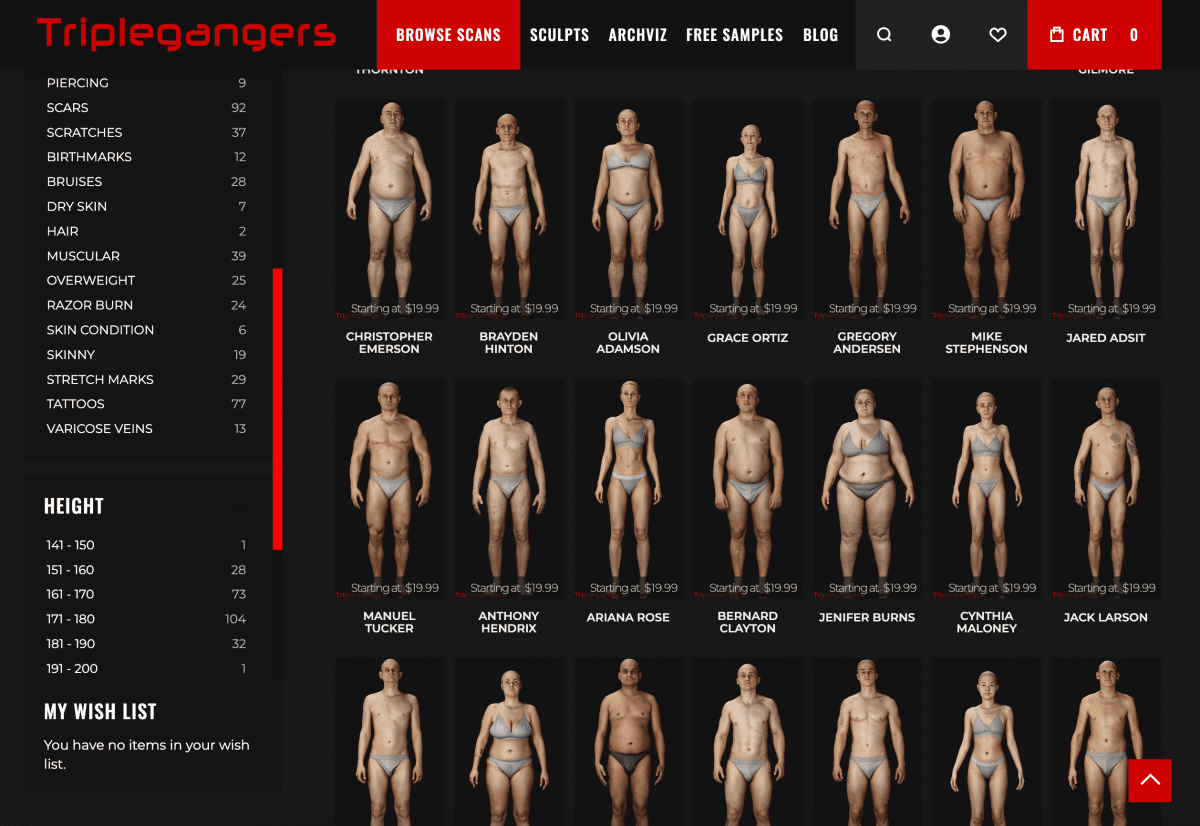

Die Website von Triplegangers ist das eigentliche Geschäft. Das Unternehmen, das sieben Mitarbeiter beschäftigt, hat mehr als ein Jahrzehnt damit verbracht, die nach eigenen Angaben größte Datenbank mit "digitalen menschlichen Doppelgängern" im Internet aufzubauen, d. h. 3D-Bilddateien, die von echten Schaufensterpuppen gescannt wurden.

Das Unternehmen verkauft 3D-Objektdateien und Fotos an 3D-Künstler, Hersteller von Videospielen und alle, die die Merkmale des echten menschlichen Körpers digital rekonstruieren müssen - von den Händen über die Haare und die Haut bis hin zum gesamten Körper.

Tomtschuks Team hat seinen Sitz in der Ukraine, ist aber auch in Tampa, Florida, USA, lizenziert, und seine Website hat eine Seite mit Nutzungsbedingungen, die Bots den Zugriff auf seine Bilder ohne Erlaubnis verbietet. Aber das allein hilft nicht weiter. Die Website muss eine ordnungsgemäß konfigurierte robot.txt-Datei verwenden, die Tags enthält, die dem Robot von OpenAI, GPTBot, ausdrücklich den Zugriff auf die Website verbieten. (OpenAI hat mehrere andere Robots, ChatGPT-User und OAI-SearchBot, die ihre eigenen Tags haben, basierend auf ihren Informationsseiten über den Crawler).

Robot.txt, auch bekannt als Robots Exclusion Protocol, wurde entwickelt, um Suchmaschinen-Websites mitzuteilen, was sie nicht crawlen sollen, weil sie das Web indizieren. openAI sagt auf seiner Informationsseite, dass es solche Dateien befolgt, wenn es mit seinem eigenen no-crawl-Tag konfiguriert ist, obwohl es auch warnt, dass seine Robots bis zu 24 Stunden brauchen, um eine aktualisierte robot.txt-Datei zu erkennen.

Wie Tomchuk erfahren hat, gehen OpenAI und andere davon aus, dass sie Inhalte nach Belieben crawlen können, wenn eine Website robot.txt nicht korrekt verwendet. Es handelt sich nicht um ein Opt-in-System.

Erschwerend kommt hinzu, dass nicht nur Tripleganger während der Geschäftszeiten in den USA von OpenAIs Bot offline geschaltet werden, sondern Tomchuk erwartet auch einen erheblichen Anstieg der AWS-Rechnungen aufgrund der gesamten CPU- und Download-Aktivität des Bots.

Robot.txt ist auch nicht narrensicher. KI-Unternehmen halten sich freiwillig daran. Ein anderes KI-Startup, Perplexity, erlangte letzten Sommer aufgrund einer Untersuchung des Wired Magazine Berühmtheit, als einige der Beweise andeuteten, dass Perplexität Es bleibt keine Zeit, ihr nachzukommen.

Es kann nicht festgestellt werden, worauf zugegriffen wird

Am Mittwoch, einige Tage nach der Rückkehr des OpenAI-Bots, hatten die Triplegangers die Datei robot.txt richtig konfiguriert und ein Cloudflare-Konto eingerichtet, um den GPTBot und einige andere Bots zu blockieren, die er gefunden hatte, wie Barkrowler (ein SEO-Crawler) und Bytespider ( Tomchuk hofft auch, dass er Crawler von anderen KI-Modellierungsunternehmen blockiert hat. Er sagte, die Website sei am Donnerstagmorgen nicht abgestürzt.

Aber Tomchuk hat immer noch keinen vernünftigen Weg, um herauszufinden, auf was genau OpenAI zugreifen oder das Material entfernen konnte. OpenAI hat auf die Anfrage von TechCrunch nach einem Kommentar nicht reagiert. OpenAI reagierte nicht auf die Anfrage von TechCrunch nach einem Kommentar, und OpenAI hat es bisher versäumt, sein lange versprochenes Opt-out-Tool zu liefern, wie TechCrunch kürzlich berichtete.

Für Triplegangers ist dies ein besonders heikles Thema. "Rechte sind ein ernstes Thema in unserer Branche, weil wir echte Menschen scannen", sagt er. Nach Gesetzen wie der europäischen Datenschutz-Grundverordnung (GDPR) "können sie nicht einfach ein Foto von irgendjemandem im Internet machen und es verwenden".

Die Website von Triplegangers ist auch ein besonders schmackhafter Fund für KI-Crawler. Es wurden milliardenschwere Startups wie Scale AI gegründet, bei denen Menschen Bilder akribisch taggen, um KI zu trainieren. Die Website von Triplegangers enthält detaillierte getaggte Fotos: Ethnie, Alter, Tattoos und Narben, alle Körpertypen und mehr.

Ironischerweise ist es die Gier des OpenAI-Bots, die die Tripleganger daran erinnert, wie gefährdet sie sind. Er sagt, wenn er sanfter gekratzt hätte, hätte Tomchuk es nie erfahren.

"Es ist beängstigend, denn diese Unternehmen scheinen ein Schlupfloch auszunutzen, um Daten zu crawlen, und sie sagen: 'Wenn Sie Ihre robot.txt mit unseren Tags aktualisieren, können Sie aussteigen'", sagte Tomchuk, aber das legt die Verantwortung auf die Unternehmern, wie sie das verhindern können.

Er möchte, dass andere kleine Online-Unternehmen wissen, dass die einzige Möglichkeit, herauszufinden, ob ein KI-Bot auf die urheberrechtlich geschützten Inhalte einer Website zugreift, darin besteht, aktiv danach zu suchen. Er ist sicherlich nicht der einzige, der von ihnen terrorisiert wird. Andere Website-Besitzer berichteten kürzlich Business Insider, wie die Bots von OpenAI ihre Websites zerstören und ihre AWS-Rechnungen in die Höhe treiben.

Im Jahr 2024 wird das Problem exponentiell wachsen. Eine neue Studie des digitalen Werbeunternehmens DoubleVerify hat ergeben, dass KI-Crawler und Crawling-Tools im Jahr 2024 zu einem Anstieg des "allgemeinen ungültigen Datenverkehrs" um 861 TP3T geführt haben - also des Datenverkehrs, der nicht von echten Nutzern stammt.

Dennoch "wissen die meisten Websites immer noch nicht, dass sie von diesen Bots gecrawlt werden", warnt Tomchuk. "Jetzt müssen wir die Log-Aktivitäten täglich überwachen, um diese Bots zu entdecken.

Wenn man darüber nachdenkt, funktioniert das ganze Modell ein bisschen wie die Erpressung durch die Mafia: Wenn man nicht geschützt ist, nehmen sich die KI-Bots, was sie wollen.

"Sie sollten um Erlaubnis bitten und nicht nur Daten abgreifen", sagte Tomchuk.

Weiterführende Lektüre.

OpenAI hat ein neues Web-Crawler-Tool namens GPTBot auf den Markt gebracht, um Fragen des Datenschutzes und des geistigen Eigentums zu klären, die durch die Datenerfassung auf öffentlichen Websites entstehen. Die Technologie zielt darauf ab, öffentliche Webdaten transparent zu sammeln und sie zum Trainieren von KI-Modellen zu verwenden, alles unter dem Banner von OpenAI.

2. openAI verwendet Web-Crawler ("Bots") und User-Agents, um Aktionen für seine Produkte auszuführen, die entweder automatisiert oder durch Benutzeranfragen ausgelöst werden. openAI verwendet das folgende robots.txt-Tag, um es Webmastern zu ermöglichen, zu verwalten, wie ihre Websites und Inhalte mit AI funktionieren . Jede Einstellung ist unabhängig von den anderen - zum Beispiel kann ein Website-Administrator zulassen, dass OAI-SearchBot in den Suchergebnissen erscheint, während er GPTbot deaktiviert, um anzugeben, dass gecrawlte Inhalte nicht zum Trainieren des generativen KI-Basismodells von openAI verwendet werden sollen. Bitte beachten Sie, dass es bei Suchergebnissen etwa 24 Stunden dauern kann, bis Anpassungen von der robots.txt einer Website in unser System übernommen werden.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...

![[转]Deepseek R1可能找到了超越人类的办法](https://aisharenet.com/wp-content/uploads/2025/01/5caa5299382e647.jpg)