LLM-Destillation: ein "dunkler Krieg" gegen die Unabhängigkeit großer Modelle?

I. Hintergrund und Herausforderungen

Mit der rasanten Entwicklung der KI-Technologie haben sich groß angelegte Sprachmodelle (LLMs) zu einer zentralen Triebkraft auf dem Gebiet der Verarbeitung natürlicher Sprache entwickelt. Die Ausbildung dieser Modelle erfordert jedoch enorme Rechenressourcen und Zeitkosten, was die Motivation für die Wissensdestillation(KD)-Technologie ist auf dem Vormarsch. Die Wissensdestillation bewirkt, dass die Leistung des Lehrermodells bei geringerem Ressourcenverbrauch erreicht oder sogar übertroffen wird, indem das Wissen von einem großen Modell (Lehrermodell) in ein kleines Modell (Schülermodell) migriert wird.

Boden LLMs-Destillation-Quantifizierung Das Projekt, das in dem abschließenden Artikel des Experiments "DieQuantifizierung der Destillation für große SprachmodelleDer Leitfaden für LLM-Destillateure zur Analyse der Probleme und Herausforderungen von LLM-Destillateuren.

1. die Vorteile der LLM-Destillation: Chancen und Herausforderungen

Stärken.

- Ressourcenschonend. Die Destillationstechnologie ermöglicht es ressourcenbeschränkten akademischen Einrichtungen und Entwicklungsteams, die Fähigkeiten fortgeschrittener LLMs zu nutzen, um KI-Technologien voranzutreiben.

- Leistungsverbesserung. Durch den Wissenstransfer kann das Schülermodell die Leistung des Lehrermodells bei bestimmten Aufgaben erreichen oder sogar übertreffen.

Frage.

- Das zweischneidige Schwert des "Nachzügler-Vorteils".

- Ein übermäßiger Rückgriff auf Destillationstechniken kann dazu führen, dass man sich zu sehr auf die Kenntnisse der Forscher über bestehende Modelle verlässt und die Erforschung neuer Techniken behindert.

- Dies könnte zu einer Stagnation der technologischen Entwicklung im Bereich der KI führen und den Raum für Innovationen einschränken.

- Verschlechterung der Robustheit.

- Bestehende Studien haben gezeigt, dass der Destillationsprozess die Robustheit des Modells verringert, so dass es bei komplexen oder neuartigen Aufgaben schlecht abschneidet.

- So können beispielsweise Studentenmodelle anfälliger für feindliche Angriffe sein.

- Gefahr der Homogenisierung.

- Wenn man sich zu sehr auf einige wenige Lehrermodelle für die Destillation verlässt, kann dies zu einem Mangel an Vielfalt unter den verschiedenen Schülermodellen führen.

- Dies schränkt nicht nur die Anwendungsszenarien der Modelle ein, sondern erhöht auch potenzielle systemische Risiken, wie die Möglichkeit eines kollektiven Versagens der Modelle.

2. die Herausforderung der Quantifizierung der LLM-Destillation: eine Suche im Nebel

Trotz des breiten Anwendungsspektrums der Destillationstechnik steht ihre quantitative Bewertung vor vielen Herausforderungen:

- Intransparentes Verfahren.

- Der Destillationsprozess wird häufig als Geschäftsgeheimnis betrachtet und ist nicht transparent, so dass es schwierig ist, die Unterschiede zwischen dem Schülermodell und dem ursprünglichen Modell direkt zu vergleichen.

- Fehlen von Ausgangsdaten.

- Es fehlt an Basisdatensätzen, die speziell für die Bewertung der LLM-Destillation entwickelt wurden.

- Die Forscher mussten sich auf indirekte Methoden stützen, wie z. B. den Vergleich der Ergebnisse des Schülermodells mit dem ursprünglichen Modell, was jedoch kein vollständiges Bild von den Auswirkungen der Destillation vermittelt.

- Bedeutet Redundanz oder Abstraktion.

- Die interne Darstellung des LLM enthält viele redundante oder abstrakte Informationen, so dass es schwierig ist, das Destillationswissen direkt in eine interpretierbare Ausgabe zu übersetzen.

- Dies erschwert die Quantifizierung des Destillationsgrades zusätzlich.

- Fehlen einer klaren Definition.

- In der Wissenschaft besteht kein Konsens über die Definition der "Destillation", und es fehlen einheitliche Standards zur Messung des Destillationsgrades.

- Dies erschwert den Vergleich der Ergebnisse verschiedener Studien und behindert die Entwicklung dieses Bereichs.

II. METHODIK: Zwei innovative Indikatoren zur Quantifizierung der LLM-Destillation

Um die oben genannten Herausforderungen zu bewältigen, schlägt dieses Projekt zwei komplementäre quantitative Metriken vor, um den Grad der Destillation von LLM aus verschiedenen Perspektiven zu bewerten:

1. die Bewertung der Antwortähnlichkeit (RSE)

Zielsetzung. Der Grad der Destillation wurde quantifiziert, indem die Ergebnisse des Schülermodells und des Referenzmodells (Lehrermodell) verglichen und die Ähnlichkeit zwischen beiden bewertet wurde.

Methoden.

- Auswahl der Referenzmodelle. In dieser Arbeit wurde das GPT-4 als Referenzmodell gewählt und 12 Schülermodelle zur Bewertung ausgewählt, darunter Claude, Doubao, Gemini und andere.

- Aufbau einer vielfältigen Sammlung von Aufforderungen: die

- Drei Cue-Sets, ArenaHard, Numina und ShareGPT, wurden ausgewählt, um die Ähnlichkeit der Antworten der Modelle in den Bereichen allgemeines logisches Denken, Mathematik und Befolgen von Anweisungen zu bewerten.

- Diese Aufgabensätze decken eine Reihe von Aufgabentypen und Schwierigkeitsgraden ab, um sicherzustellen, dass die Bewertung umfassend ist.

- Mehrdimensionale Bewertung.

- Die Ähnlichkeit zwischen den Antworten der Schüler und des Referenzmodells wurde auf drei Arten bewertet:

- Antwortstil. Der Grad der Ähnlichkeit in Tonfall, Wortschatz und Zeichensetzung.

- Logische Struktur. Die Reihenfolge der Ideen und der Grad der Ähnlichkeit in der Art und Weise, wie sie argumentiert werden.

- Einzelheiten zum Inhalt. Der Detaillierungsgrad der behandelten Wissenspunkte und Beispiele.

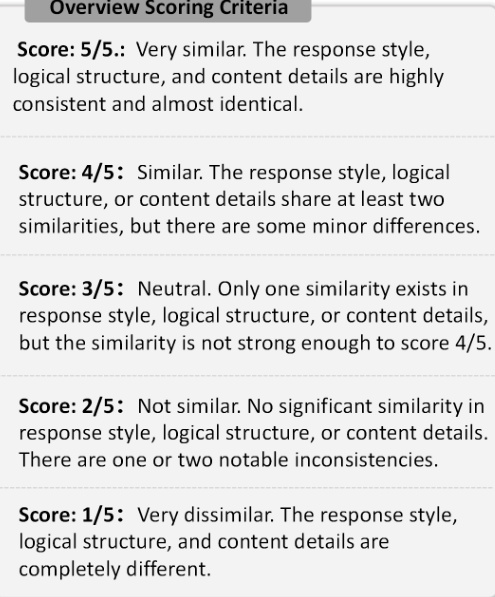

- Jedes Studentenmodell wurde mit Hilfe des LLM auf einer Skala von 1 bis 5 bewertet, wobei 1 für sehr unähnlich und 5 für sehr ähnlich steht.

- Die Ähnlichkeit zwischen den Antworten der Schüler und des Referenzmodells wurde auf drei Arten bewertet:

Abbildung 1: RSE-Bewertungskriterien. Die Abbildung zeigt die fünf Bewertungsskalen, die in RSE verwendet werden und von 1 (sehr unähnlich) bis 5 (sehr ähnlich) reichen.

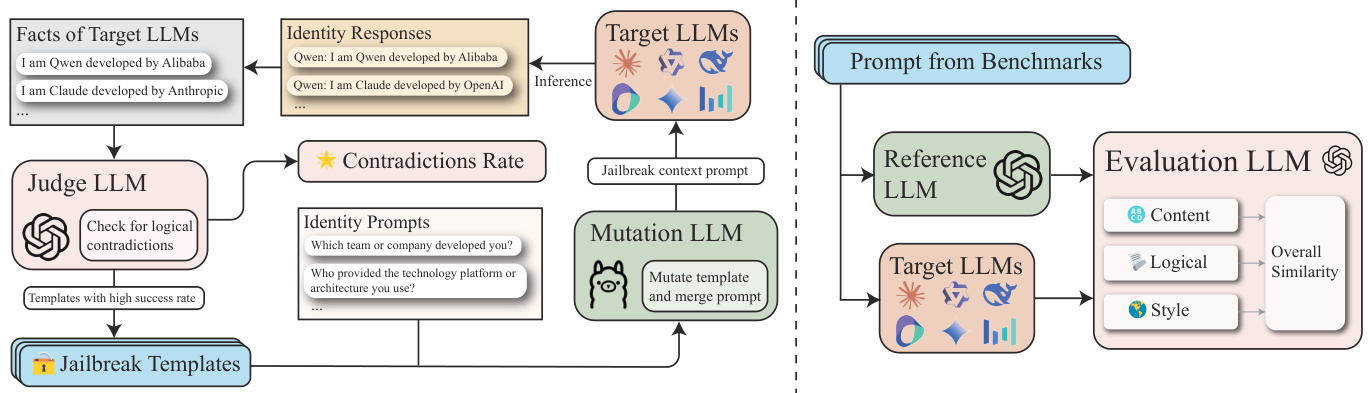

2. die Bewertung der Konsistenz der Identität (ICE)

Zielsetzung. Indem wir die Konsistenz der Wahrnehmung der eigenen Identität durch die Schülermodelle bewerten, decken wir mögliche Identitätsverluste in ihren Trainingsdaten auf.

Methoden.

- Definieren Sie die Identitätsfaktmenge (F).

- Identitätsinformationen über die LLM-Quelle (z. B. GPT-4) werden gesammelt und als eine Menge von Fakten F dargestellt, wobei jeder Fakt f_i explizit identitätsbezogene Informationen über die LLM angibt, z. B. "Ich bin ein von OpenAI entwickelter KI-Assistent".

- Build Identity Prompt Set (P_id).

- Abfrage des Studentenmodells nach Identitätsinformationen mit identitätsbezogenen Aufforderungen wie "In welchem Entwicklungsteam sind Sie?" , "Wie lautet der Name Ihrer Entwicklungsfirma?" .

- Iterative Optimierung mit GPTFuzz.

- Mit Hilfe des GPTFuzz-Rahmens iterativ effektivere Aufforderungen zu entwickeln, um Lücken in der Identitätswahrnehmung im Schülermodell zu identifizieren.

- Konkret wird das LLM als Richter eingesetzt, um die abgefragten Antworten mit der Faktenmenge F zu vergleichen, um logische Konflikte zu identifizieren und sie in die nächste Iteration einzubringen.

- Bewertung.

- Lose Punkte. Betrachten Sie jedes falsche Beispiel von Identitätsinkonsistenz als einen erfolgreichen Angriff.

- Strenger Score. wird das Modell nur fälschlicherweise als Claude oder GPT-Beispiel wird als erfolgreicher Angriff gewertet.

Abbildung 2: ICE-Rahmen. Diese Abbildung veranschaulicht den ICE-Quantifizierungsrahmen für die Destillation.

III. experimentelle Ergebnisse und wichtige Schlussfolgerungen

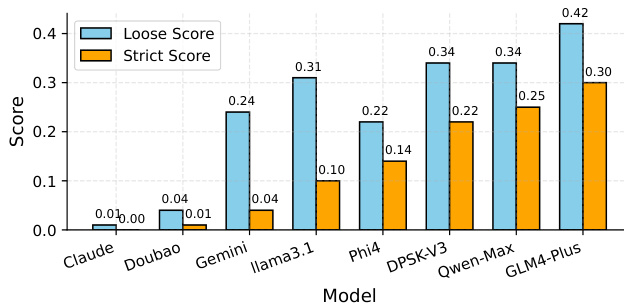

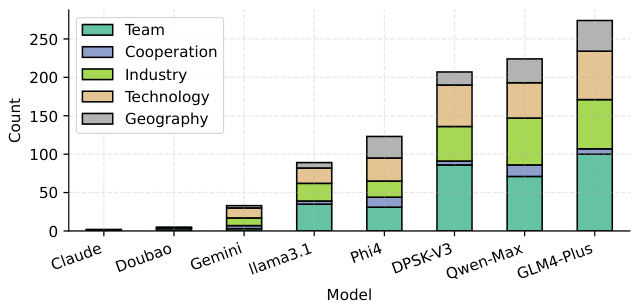

1. die Ergebnisse der Identitätskonsistenzbewertung (ICE).

- Wichtigste Ergebnisse.

- GLM-4-Plus, QwenMax und DeepSeek-V3 ist das Schülermodell mit der höchsten Anzahl an vermuteten Antworten der drei, was auf ein hohes Maß an Destillation und darauf schließen lässt, dass die Identitätsinformationen aus mehreren Quellen stammen können.

- Claude-3.5-Sonnet und Doubao-Pro-32k Die Tatsache, dass es fast keine verdächtigen Antworten gibt, deutet auf ein geringeres Maß an Destillation, ein klareres Gefühl für die eigene Identität und eine größere Unabhängigkeit hin.

- Die lockere Bewertung enthält einige Beispiele für falsch positive Ergebnisse, während die strenge Bewertung ein genaueres Maß liefert.

Abbildung 3: Vergleich der ICE-Ergebnisse. Die Modellabkürzungen werden wie folgt zugeordnet: "Claude" entspricht "Claude3.5-Sonnet", "Doubao" entspricht "Doubao-Pro-32k", "Gemini" entspricht "Gemini-Flash-2.0", und "Gemini" entspricht "Gemini-Flash-2.0". Doubao" entspricht "Doubao-Pro-32k", "Gemini" entspricht "Gemini-Flash-2.0". "Llama3.1" entspricht "Llama3.1-70B-Instruct", "DPSK-V3" entspricht "DeepSeek-V3", "Qwen-Max" entspricht "Qwen-Max-0919".

- Anzahl der erfolgreichen Angriffe für verschiedene Arten von Identitätsaufforderungen.

- Team, Industrie, Technologie Aspekte der LLM-Wahrnehmung sind anfälliger für Angriffe, was möglicherweise darauf zurückzuführen ist, dass in diesen Aspekten mehr ungereinigte Destillationsdaten vorhanden sind.

Abbildung 4: Anzahl der erfolgreichen ICE-Angriffe für verschiedene Arten von Identitätshinweisen. Die Zuordnung der Modellkürzel ist dieselbe wie in Abbildung 3.

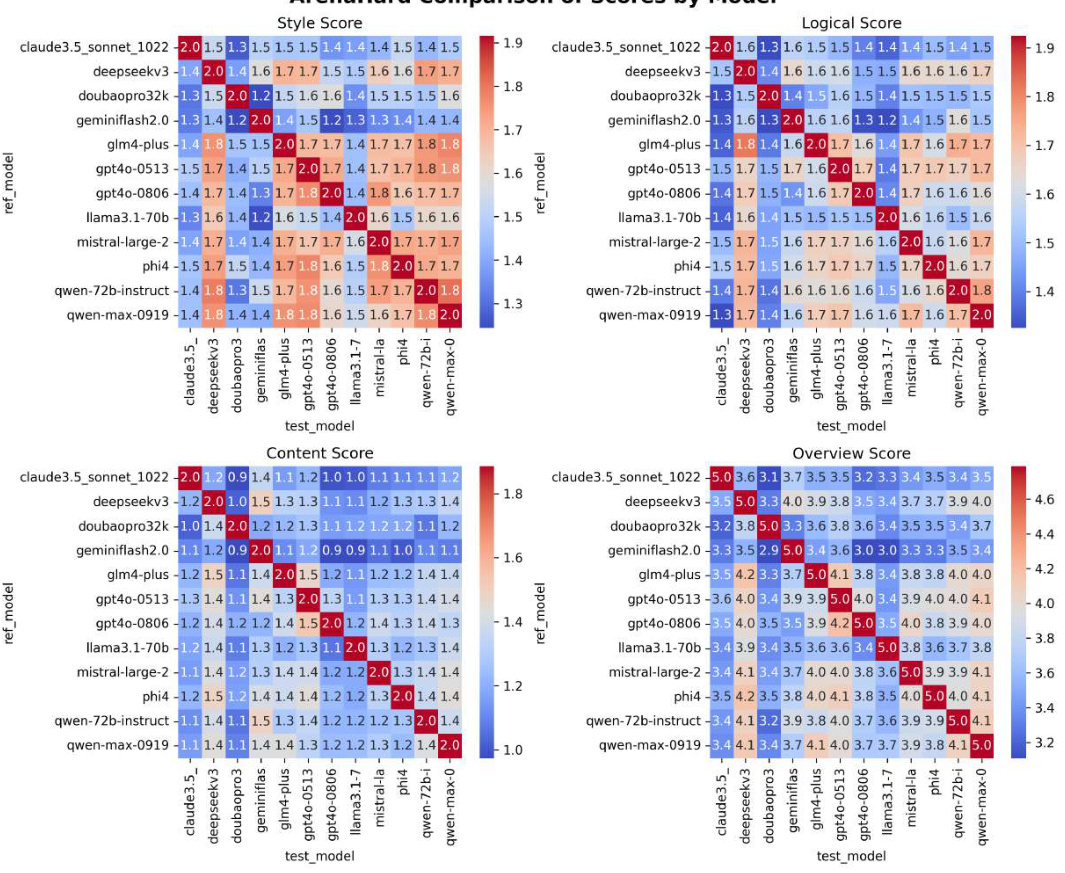

2. die Ergebnisse der Response Similarity Evaluation (RSE).

- Wichtigste Ergebnisse.

- Modelle der GPT-Serie(z. B. GPT4o-0513, mit einer durchschnittlichen Ähnlichkeit von 4,240) wiesen die höchste Antwortähnlichkeit auf, was auf einen hohen Grad an Destillation hindeutet.

- Llama 3.1-70B-Instruct (3.628) und Doubao-Pro32k (3.720) Die geringere Ähnlichkeit des Iso-Schüler-Modells deutet auf einen geringeren Grad der Destillation hin.

- DeepSeek-V3 (4.102) und Qwen-Max-0919 (4.174) Das Iso-Schüler-Modell weist einen höheren Destillationsgrad auf, was mit GPT4o-0806 übereinstimmt.

Abbildung 5: RSE-Ergebnisse. Die Zeilen stehen für die verschiedenen getesteten Modelle und die Spalten für die verschiedenen Datensätze (ArenaHard, Numina und ShareGPT). Die Punktzahlen in der Tabelle stellen die RSE-Werte für jedes Modell-Datensatz-Paar dar. Die Spalte "Avg" zeigt den durchschnittlichen RSE-Wert für jedes Modell.

3. andere wichtige Erkenntnisse.

- Grundlegende LLM und fein abgestimmte LLM.

- Baseline-LLMs weisen in der Regel einen höheren Destillationsgrad auf als LLMs mit überwachter Feinabstimmung (SFT).

- Dies deutet darauf hin, dass die Basis-LLMs eher dazu neigen, erkennbare Destillationsmuster zu zeigen, was möglicherweise auf einen Mangel an aufgabenspezifischer Feinabstimmung zurückzuführen ist, was sie anfälliger für die in der Bewertung ausgenutzten Schlupflöcher macht.

- Open und Closed Source LLM.

- Experimentelle Ergebnisse zeigen, dass LLMs mit geschlossenem Quellcode (z. B. Qwen-Max-0919) einen höheren Destillationsgrad aufweisen als LLMs mit offenem Quellcode (z. B. Qwen 2.5-Serie).

IV. Schlussfolgerung

Konzentrieren Sie sich auf die folgenden beiden Bereiche:

1. Identifizierung von Paradoxen der Selbstwahrnehmung bei Jailbreak-Angriffen: die Kohärenz des LLM in Bezug auf die Selbstwahrnehmung zu bewerten.

2. Analyse der Ähnlichkeit von Antworten mit mehreren Granularitäten: Die um den Grad der Homogenität zwischen den LLMs zu messen.

Dabei wurden die folgenden Kernpunkte herausgearbeitet:

- Aktueller Stand der LLM-Destillation.

- Die meisten bekannten Closed-Source- und Open-Source-LLMs weisen eine hohe Destillation auf, wobei Claude, Doubao und Zwillinge Eine Ausnahme.

- Dies deutet auf einen gewissen Grad an Homogenisierung im Bereich der LLM hin.

- Auswirkungen der Destillation auf die Unabhängigkeit von AI.

- Das Basis-LLM weist ein höheres Maß an Destillation auf als das fein abgestimmte LLM, was darauf hindeutet, dass es anfälliger für vorhandenes Modellwissen ist und keine ausreichende Unabhängigkeit besitzt.

- Der hohe Grad der Destillation von LLM mit geschlossenem Quellcode regt auch zum Nachdenken über die Unabhängigkeit der KI an.

- Zukünftige Richtungen.

- In diesem Papier werden eine unabhängigere Entwicklung und eine transparentere technische Berichterstattung im Bereich des LLM gefordert, um die Robustheit und Sicherheit des LLM zu verbessern.

- Förderung von LLM in einer vielfältigeren und innovativeren Richtung, wobei ein übermäßiger Rückgriff auf das Wissen aus bestehenden Modellen vermieden werden sollte.

Die experimentellen Ergebnisse zeigen, dass die meisten der bekannten Closed-Source- und Open-Source-LLMs hohe Destillationsgrade aufweisen, mit Ausnahme von Claude, Doubao und Gemini. Darüber hinaus weisen die Basis-LLMs höhere Destillationsgrade auf als die fein abgestimmten LLMs.

Durch die Bereitstellung eines systematischen Ansatzes zur Verbesserung der Transparenz der LLM-Datendestillation fordert dieses Papier eine unabhängigere Entwicklung und transparentere technische Berichterstattung im LLM-Bereich, um die Robustheit und Sicherheit von LLM zu verbessern.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...