Replizieren von DeepSeek-R1: 8K mathematische Beispiele verhelfen kleinen Modellen durch Verstärkungslernen zu einem Durchbruch bei der Inferenz

Github. https://github.com/hkust-nlp/simpleRL-reason

Einführung

Dynamische Variationen des Qwen2.5-SimpleRL-Zero-Trainings, ausgehend vom Qwen2.5-Math-7B-Basismodell, ohne Durchführung von SFT oder Verwendung des Belohnungsmodells. Die durchschnittliche Benchmark-Genauigkeit und -Länge basieren auf 8 komplexen mathematischen Reasoning-Benchmarks. Wir haben in der Anfangsphase eine Verringerung der Länge beobachtet, da wir festgestellt haben, dass das Qwen2.5-Math-7B-Basismodell dazu neigt, sowohl Sprache als auch Code in der Antwort zu generieren, was zu einer langen Ausgabe führt. Dieses Standardmuster wurde in der RL-Phase schnell unterdrückt, als das Modell lernte, in einem angemesseneren Format auszugeben, und dann begann die Länge regelmäßig zuzunehmen. Nach nur wenigen Trainingsschritten erlebten wir auch, was im DeepSeek-R1-Papier als "Epiphanie-Moment" beschrieben wird - eine Selbstreflexion in der Modellantwort.

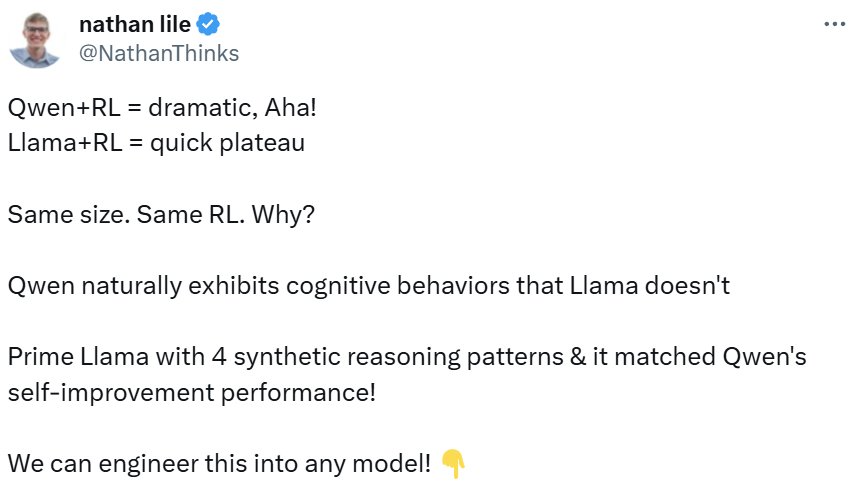

Viele Forscher erforschen mögliche Wege zum Erlernen von O-Typ-Modellen wie Destillation, MCTS, prozessbasierte Belohnungsmodelle und Verstärkungslernen. Kürzlich.DeepSeek-R1im Gesang antwortenKimi-k1.5Auf dem Weg zu diesem Ziel wurde ein extrem einfaches Rezept für die Verwendung einfacher RL-Algorithmen zum Erlernen von emergenten Mustern des verlängerten verketteten Denkens (CoT) und der Selbstreflexion mit starken Ergebnissen demonstriert, ohne MCTS und Belohnungsmodelle zu verwenden. Allerdings basierten ihre Experimente auf riesigen Modellen in einem groß angelegten RL-Setup. Es ist nicht klar, ob kleinere Modelle in der Lage wären, ein ähnliches Verhalten zu zeigen, wie viele Daten erforderlich wären und wie die quantitativen Ergebnisse im Vergleich zu anderen Methoden ausfallen würden. In diesem Blog wird das Training von DeepSeek-R1-Zero und DeepSeek-R1 für komplexes mathematisches Denken wiederholt, beginnend mit Qwen-2.5-Math-7B (dem Basismodell) und unter Verwendung von nur 8K (Abfrage, endgültige Antwort) Beispielen aus dem originalen MATH-Datensatz für RL mit regelbasierter Belohnungsmodellierung.Wir waren überrascht, dass die Verwendung von nur 8K MATH-Beispiele das 7B-Basismodell ohne weitere externe Signale so stark anheben können:

Alle Ergebnisse sind pass@1 genau

| AIME 2024 | MATH 500 | AMC | Minerva Mathematik | OlympiadeBench | Avg. | |

|---|---|---|---|---|---|---|

| Qwen2.5-Math-7B-Base | 16.7 | 52.4 | 52.5 | 12.9 | 16.4 | 30.2 |

| Qwen2.5-Math-7B-Base + 8K MATH SFT | 3.3 | 54.6 | 22.5 | 32.7 | 19.6 | 26.5 |

| Qwen-2.5-Mathe-7B-Anleitung | 13.3 | 79.8 | 50.6 | 34.6 | 40.7 | 43.8 |

| Llama-3.1-70B-Instruct | 16.7 | 64.6 | 30.1 | 35.3 | 31.9 | 35.7 |

| rStar-Math-7B | 26.7 | 78.4 | 47.5 | - | 47.1 | - |

| Eurus-2-7B-PRIME | 26.7 | 79.2 | 57.8 | 38.6 | 42.1 | 48.9 |

| Qwen2.5-7B-EinfachRL-Null | 33.3 | 77.2 | 62.5 | 33.5 | 37.6 | 48.8 |

| Qwen2.5-7B-EinfacheRL | 26.7 | 82.4 | 62.5 | 39.7 | 43.3 | 50.9 |

Qwen2.5-7B-SimpleRL-Zero ist ein einfaches RL-Training direkt aus dem Basismodell, das nur 8K MATH-Beispiele verwendet. Es erreicht im Vergleich zum Basismodell durchschnittlich fast 20 absolute Wachstumspunkte. Im Vergleich zu Qwen2.5-Math-7B-Base, das dieselben 8K Daten-SFTs verwendet, genießt RL eine bessere Generalisierungsfähigkeit, die in absoluten Zahlen 22% höher ist. Qwen2.5-7B-SimpleRL-Zero übertrifft außerdem im Durchschnitt Qwen-2.5-Math-7B-Instruct und vergleicht sich günstig mit dem kürzlich veröffentlichtenEurus-2-7B-PRIMEim Gesang antwortenrStar-Math-7B(Sie beruhen ebenfalls auf Qwen-2.5-Math-7B) sind in etwa gleichwertig. Diese Baselines enthalten komplexere Komponenten, wie z. B. Belohnungsmodelle, und verwenden mindestens 50 Mal mehr fortgeschrittene Daten:

Vergleichende Daten zu verschiedenen Methoden

| Qwen2.5-Mathe-7B-Instruct | rStar-Math-7B | Eurus-2-7B-PRIME | Qwen2.5-7B-EinfachRL-Null | |

|---|---|---|---|---|

| Basismodell | Qwen2.5-Math-7B | Qwen2.5-Math-7B | Qwen2.5-Math-7B | Qwen2.5-Math-7B |

| SFT-Daten | 2,5 Millionen (Open-Source und intern) | ~7.3 M (MATH, NuminaMath, usw.) | 230K | 0 |

| RM-Daten | 618K (intern) | ~7 k (intern) | 0 | 0 |

| RM | Qwen2.5-Mat-RM (72B) | Keine | Eurus-2-7B-SFT | Keine |

| RL-Daten | 66K Abfragen × 32 Stichproben | ~3.647 M × 16 | 150K Abfragen × 4 Stichproben | 8K Abfragen × 8 Stichproben |

Wir sind sowohl begeistert als auch überrascht über den signifikanten Zuwachs, der mit nur 8K MATH-Beispielen erreicht wurde. Obwohl MATH-Abfragen viel einfacher durchzuführen sind als viele anspruchsvolle Benchmarks wie AIME und AMC, zeigt diese einfache RL-Formulierung eine signifikante Generalisierungskraft, die die Leistung um mindestens 10 absolute Punkte im Vergleich zum Basismodell verbessert. **Dieser leicht nachvollziehbare Generalisierungseffekt ist etwas, das wir nicht hätten vorhersehen können, wenn wir ein Standard-SFT-Training auf demselben Datensatz durchgeführt hätten. Wir haben unseren Trainingscode und die Details vollständig offengelegt, in der Hoffnung, dass er der Community als leistungsfähige Ausgangsbasis für die weitere Erforschung des Potenzials von RL für Inferenzen dienen wird.

Als Nächstes werden wir uns mit den Details unseres Aufbaus und den Vorgängen während des RL-Trainings befassen, z. B. mit der langen CoT und der Entstehung selbstreflektierender Muster.

Einfaches RL-Rezept

Ähnlich wie bei DeepSeek R1 ist unsere RL-Formulierung sehr einfach und verwendet keine Belohnungsmodelle oder MCTS-ähnliche Techniken. Wir verwenden den PPO-Algorithmus mit einer regelbasierten Belohnungsfunktion, die Belohnungen basierend auf dem Format und der Korrektheit der generierten Antworten zuweist:

- Wenn die Antwort die endgültige Antwort im vorgegebenen Format liefert und richtig ist, wird ein Bonus von +1 vergeben.

- Wenn die Antwort die endgültige Antwort liefert, aber falsch ist, wird die Belohnung auf -0,5 gesetzt.

- Wenn die Antwort keine endgültige Antwort liefert, wird die Belohnung auf -1 gesetzt.

Die Implementierung basiert aufOpenRLHF. Unsere ersten Experimente zeigen, dass diese Belohnungsfunktion dazu beiträgt, dass das Strategiemodell schnell konvergiert und Antworten im gewünschten Format erzeugt.

Experimenteller Aufbau

In unseren Experimenten lernten wir von denQwen2.5-Math-7B-BaseDie Modelle wurden in anspruchsvollen Benchmarks wie AIME2024, AMC23, GSM8K, MATH-500, Minerva Math und OlympiadBench gestartet und evaluiert. Das Training wurde mit ca. 8.000 Abfragen aus dem MATH-Trainingsdatensatz in den Schwierigkeitsstufen 3-5 durchgeführt. Wir führten Experimente mit den folgenden zwei Einstellungen durch: DeepSeek-R1-Zero und DeepSeek-R1:

- EinfacheRL-NullWir führen RL direkt vom Basismodell aus, ohne vorher SFT durchzuführen. Wir verwenden nur 8K MATH (Anfrage, Antwort) Paare.

- SimpleRLDie SFT-Daten sind 8K MATH-Abfragen mit aus QwQ-32B-Preview destillierten Antworten. Anschließend verwenden wir die gleichen 8K MATH-Beispiele für unsere RL-Formulierung.

Teil I: SimpleRL-Zero - Intensives Lernen von Grund auf

In der Einleitung haben wir über die wichtigsten Ergebnisse von SimpleRL-Zero berichtet, das Qwen2.5-Math-7B-Instruct übertrifft und vergleichbare Ergebnisse mit PRIME und rStar-Math erzielt, obwohl es nur 8K MATH-Beispiele verwendet. Im Folgenden teilen wir die Trainingsdynamik und einige interessante auftauchende Muster mit.

Dynamik der Ausbildung

Ausbildungsanreize und Entfaltung der Antwortdauer

Bewertung der Genauigkeit (pass@1) und der Antwortlänge bei 8 Benchmarks

Wie in der obigen Abbildung zu sehen ist, steigt die Genauigkeit bei allen Benchmarks während des Trainings stetig an, während die Länge zunächst abnimmt und dann allmählich zunimmt. Bei weiteren Untersuchungen haben wir festgestellt, dass das Basismodell Qwen2.5-Math-7B dazu neigt, zu Beginn eine große Menge an Code zu generieren, was auf die ursprüngliche Trainingsdatenverteilung des Modells zurückzuführen sein könnte. Wir haben festgestellt, dass die Länge zunächst abnimmt, weil das RL-Training dieses Muster allmählich eliminiert und lernt, in normaler Sprache zu denken. Danach nimmt die Generierungslänge wieder zu, und das selbstreflexive Muster beginnt zu entstehen, wie das folgende Beispiel zeigt.

Das Aufkommen der Selbstreflexion

Etwa bei Schritt 40 beginnt das Modell, selbstreflexive Muster zu erzeugen, die "Epiphanie-Momente" aus dem DeepSeek-R1-Papier. Wir zeigen unten ein Beispiel.

Teil II: SimpleRL - Intensives Lernen mit imitativen Aufwärmübungen

Wie bereits erwähnt, haben wir uns mit einem SFT mit langem Chainthinking aufgewärmt, bevor wir mit RL fortgefahren sind; der SFT-Datensatz bestand aus 8K MATH-Beispielen mit Antworten, die aus QwQ-32B-Preview destilliert wurden. Der potenzielle Vorteil dieses Kaltstarts besteht darin, dass das Modell von einem langen Chain-Thinking-Modus ausgeht und bereits selbstreflektierend ist, wodurch es in der RL-Phase schneller und besser lernen kann.

Wichtigste Ergebnisse

| AIME 2024 | MATH 500 | AMC | Minerva Mathematik | OlympiadeBench | Avg. | |

|---|---|---|---|---|---|---|

| Qwen2.5-Math-7B-Base | 16.7 | 52.4 | 52.5 | 12.9 | 16.4 | 30.2 |

| Qwen2.5-Math-7B-Base + 8K QwQ Destillation | 16.7 | 76.6 | 55.0 | 34.9 | 36.9 | 44.0 |

| Eurus-2-7B-PRIME | 26.7 | 79.2 | 57.8 | 38.6 | 42.1 | 48.9 |

| Qwen2.5-7B-EinfachRL-Null | 36.7 | 77.4 | 62.5 | 34.2 | 37.5 | 49.7 |

| Qwen2.5-7B-EinfacheRL | 26.7 | 82.4 | 62.5 | 39.7 | 43.3 | 50.9 |

Im Vergleich zu Qwen2.5-Math-7B-Base + 8K QwQ-Destillation verbesserte das Modell Qwen2.5-7B-SimpleRL um durchschnittlich 6,91 TP3T in absoluten Zahlen vor dem RL-Training. Darüber hinaus übertrifft Qwen2.5-7B-SimpleRL Eurus-2-7B-PRIME in 3 von 5 Benchmarks und übertrifft Qwen2.5-7B-SimpleRL-Zero. Obwohl die Ergebnisse gut sind, sind wir etwas überrascht, dass die QwQ-Destillationsphase keine größeren Gewinne als die Null-Einstellung hervorgebracht hat, da QwQ ein 32B leistungsstarkes Modell für langkettig denkende Lehrer ist.

Dynamik der Ausbildung

Ausbildungsanreize und Entfaltung der Antwortdauer

Ausbildungsstand

Bewertung der Genauigkeit (pass@1) und der Antwortlänge bei 8 Benchmarks

Die Trainingsdynamik von Qwen2.5-SimpleRL sieht ähnlich aus wie Qwen2.5-SimpleRL-Zero. Interessanterweise beobachten wir immer noch eine Verringerung der Länge zu Beginn von RL, trotz unseres fortgeschrittenen Langzeit-Kettendenkens SFT. Wir vermuten, dass dies darauf zurückzuführen ist, dass das destillierte QwQ-Inferenzmuster von kleinen Strategiemodellen nicht bevorzugt wird oder deren Kapazität übersteigt. Infolgedessen lernt es, es aufzugeben und entwickelt selbständig neue lange Schlussfolgerungen.

Schlussbemerkungen

Die Einfachheit ist die höchste Komplexität.

- Leonardo da Vinci (1452-1519), italienischer Renaissancemaler

Danksagungen und Zitate

Der von uns implementierte Verstärkungslernalgorithmus basiert aufOpenRLHFErweitert von. Wir verwenden dievLLMFührt eine Inferenz durch und entwickelt einen Algorithmus auf der Grundlage derQwen2.5-Matheder Bewertungsskripte. Insbesondere danken wir den Entwicklern von DeepSeek-R1 und Kimi-k1.5 für ihre Innovationen und Beiträge zur Open-Source-Community.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...