Cursor erfreut sich wachsender Beliebtheit, aber Cursor ist nicht der Ausweg für die KI-Programmierung im Inland

Im Jahr 2021 brachte Microsoft den GitHub Copilot auf den Markt, der sich auf Anhieb zum begehrtesten KI-Tool der Programmierwelt entwickelte.

GitHub Copilot kann automatisch vollständige Codefunktionen auf der Grundlage der vom Benutzer bereitgestellten Kontextinformationen wie Funktionsnamen, Kommentare, Codeschnipsel usw. generieren und ist in der Welt der Programmierung als "Game Changer" bekannt.

Das Erstaunliche daran ist der zugrunde liegende Zugriff auf das Codex-Modell von OpenAI, das eine Parametergröße von 12 Milliarden hat und eine frühe Version von GPT-3 ist, die speziell für Codierungsaufgaben optimiert wurde. Dies ist das erste Mal, dass ein großes Parametermodell, das auf der Transformer-Architektur basiert, wirklich in der Code-Domäne "auftaucht".

GitHub Copilot entfachte bei Entwicklern auf der ganzen Welt die Leidenschaft für die KI-Programmierung, und vier MIT-Studenten taten sich mit dem Traum zusammen, die Softwareentwicklung zu verändern, um 2022 ein Unternehmen namens Anysphere zu gründen.

Der Mitbegründer von Anysphere, der Microsoft als seinen Hauptkonkurrenten bezeichnete, machte deutlich, dass Microsoft mit Visual Studio Code zwar den IDE-Markt dominiert, Anysphere aber die Chance sieht, ein anderes Produkt anzubieten. Anysphere sah die Chance, ein anderes Produkt anzubieten.

Michael Truell (ganz rechts)

Microsoft hätte sich vielleicht nicht vorstellen können, dass dieses wenig bekannte Team in weniger als drei Jahren eine schwere "Bombe" in die Branche werfen und eine neue Runde des KI-Programmierfiebers in der Welt auslösen würde, und das Unternehmen sprang mit einer Bewertung von 2,5 Milliarden Dollar in vier Monaten zum Einhorn.

1. was macht Cursor zu einem Hit?

Im August 2024 lobte Andrej Karpathy, Teslas ehemaliger Leiter der KI-Abteilung, in mehreren Tweets auf X einen Code-Editor namens Cursor, der GitHub Copilot in den Schatten gestellt habe.

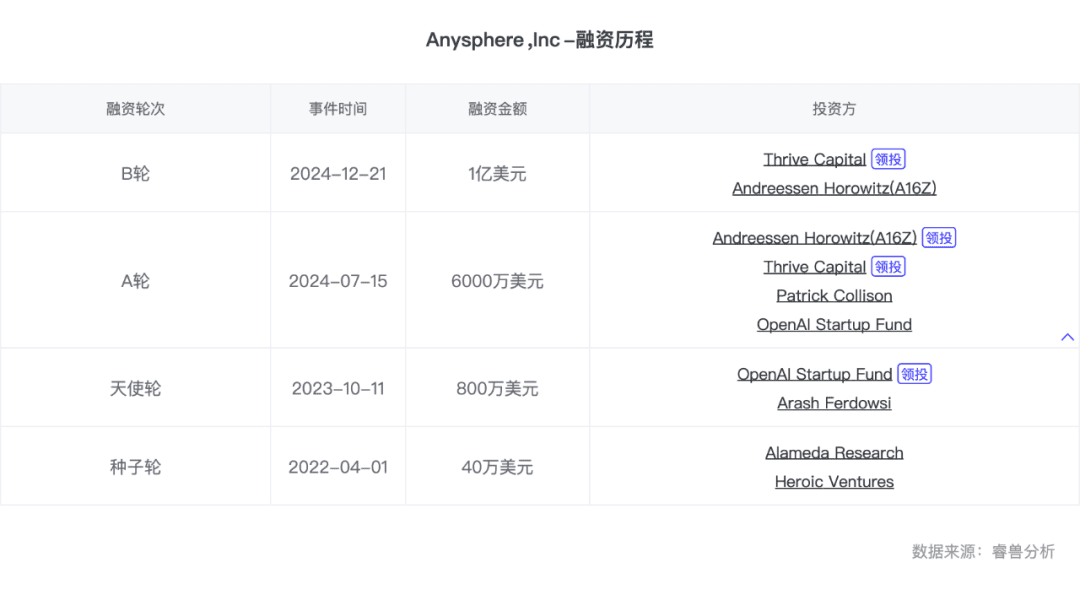

Im selben Monat schloss Anysphere, das Unternehmen hinter Cursor, eine Serie-A-Finanzierungsrunde in Höhe von 60 Millionen Dollar bei einer Bewertung von 400 Millionen Dollar ab.

Zu den erstaunlichen Funktionen von Cursor gehören die mehrzeilige Bearbeitung, die dateiübergreifende kontextbezogene Vervollständigung, die Befragung, die Vorhersage der nächsten Aktion und vieles mehr. Entwickler können einfach die Tabulatortaste drücken, um Codeänderungen in der gesamten Datei zu automatisieren, und die Verarbeitungsergebnisse von Cursor sind genauer und schneller, mit geringer bis keiner wahrnehmbaren Latenz.

Jeder, der etwas vom Programmieren versteht, weiß, wie tief das geht.

"Die Vervollständigung und Vorhersage über mehrere Dateien hinweg ist eine sehr subtile Anforderung, die für die Entwickler selbst schwer auszudrücken sein mag, aber sehr 'cool' ist, wenn man sie tatsächlich nutzt."

Tom Yedwab, ein Entwickler mit jahrzehntelanger Erfahrung, schrieb ebenfalls einen Artikel, in dem er mitteilte, dass die Funktion "Tab Completion" am besten zu seinen täglichen Programmiergewohnheiten passt und ihm am meisten Zeit spart. "Es ist, als würde das Tool meine Gedanken lesen und vorhersagen, was ich als Nächstes tun werde, so dass ich mich weniger auf Code-Details und mehr auf den Aufbau der Gesamtarchitektur konzentrieren kann". Tom Yedwab schreibt.

Der Schlüssel zum Erfolg von Cursor liegt nicht so sehr in den hohen technischen Hürden, sondern in der Tatsache, dass das Unternehmen als erstes einen subtilen neuen Bedarf erkannte und es wagte, einen Weg einzuschlagen, der noch nie zuvor beschritten worden war.

Cursor ist ein Parasit auf VS Code, Visual Studio Code, einem kostenlosen, plattformübergreifenden Open-Source-Code-Editor, der von Microsoft entwickelt wurde und einige grundlegende Funktionen zur Codevervollständigung bietet.

In der Vergangenheit haben Entwickler alle Arten von Plug-ins erstellt, um die funktionalen Grenzen von VS Code zu erweitern, aber der eigene Plug-in-Mechanismus von VS Code hat viele Einschränkungen. Zum Beispiel können einige Plug-ins bei großen Projekten zu einer langsameren Code-Indizierung und -Analyse führen; bei einigen komplexen Plug-ins ist der Konfigurationsprozess umständlicher und erfordert, dass die Benutzer die Konfigurationsdatei manuell ändern, was unweigerlich die Schwelle der Nutzung erhöht.

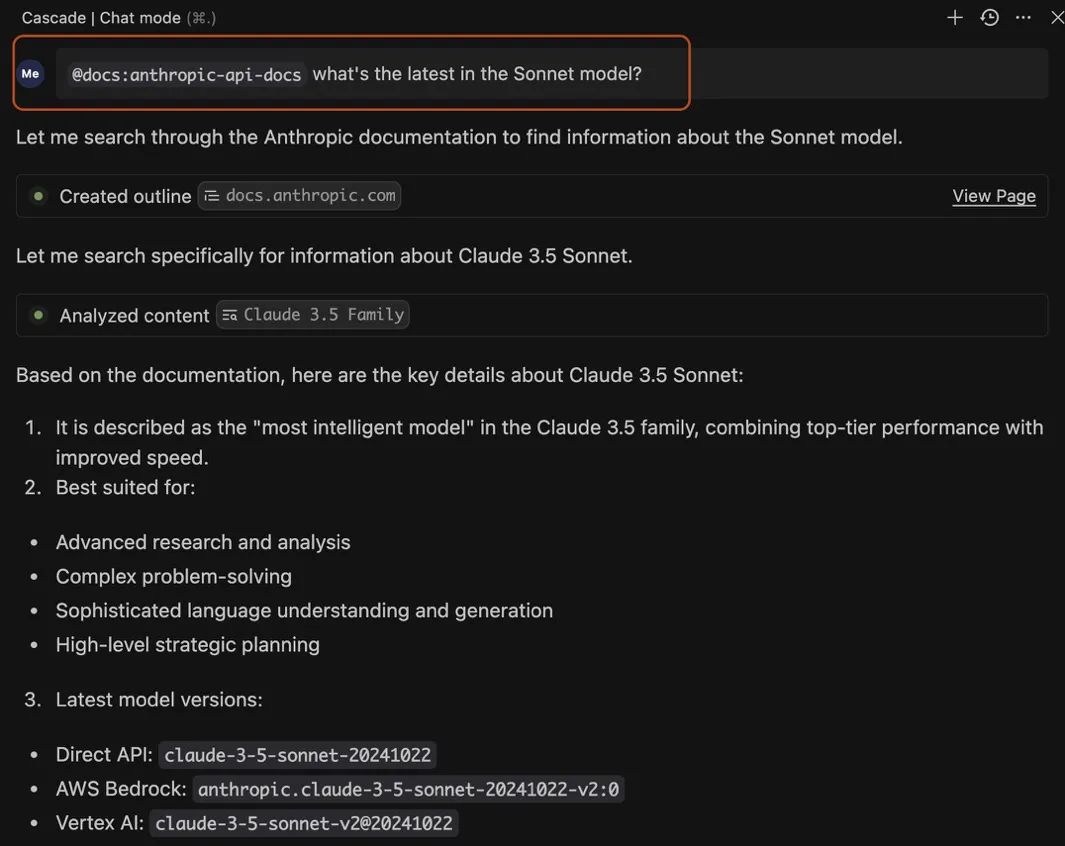

Um diese Einschränkungen zu beseitigen, wählte das Cursor-Team einen sehr kühnen Ansatz: Sie folgten nicht dem traditionellen Weg, Plug-ins für VS Code zu entwickeln, sondern änderten auf magische Weise den Code von VS Code, der mit einer Reihe von KI-Modellen kompatibel ist, und verbesserten durch eine Menge technischer Optimierungen die Benutzerfreundlichkeit der gesamten IDE.

Zu Beginn der Entwicklung von Cursor, viele Praktiker, einschließlich ihm, sind nicht optimistisch über diesen Weg ist schwierig, ist eine riesige "Nicht-Konsens". VS Code interne Architektur ist komplex, mit Code-Bearbeitung, Syntax-Analyse, Code-Indizierung, Plug-in-System und andere Module, und verschiedene Versionen von VS Code kann Unterschiede haben, "magische" Prozess, um die Kompatibilität zu berücksichtigen. Die Kompatibilität sollte im Prozess der "magischen Modifikation" berücksichtigt werden. Darüber hinaus, wenn mehrere AI-Modelle in VS Code gebaut werden, ist es notwendig, um die Interaktion Probleme zwischen dem Modell und dem Editor zu lösen, zum Beispiel, wie man effektiv den Code-Kontext an das Modell übergeben? Wie lässt sich die Ausgabe des Modells verarbeiten und auf den Code anwenden? Und wie kann die Latenzzeit bei der Codegenerierung minimiert werden?

Die Lösung einer Reihe von Problemen erfordert ein schwerfälliges System der technischen Optimierung. Allein im Jahr 2023 wurde Cursor dreimal in einer neuen Version aktualisiert und fast 40 Mal überarbeitet.Dies ist eine große Geduldsprobe für das gesamte Forschungs- und Entwicklungsteam und die Investoren des Unternehmens.

Der Erfolg von Cursor ist ein sehr klassisches Beispiel für ein Silicon-Valley-Unternehmen: eine Gruppe paranoider Technologiefreaks mit einer großen Vision, die von dem ausgereiften VC-System des Silicon Valley unterstützt wird, um in das Niemandsland einzudringen, vor dem Hintergrund zahlloser Herausforderungen, um als Erster Krabben zu essen und sich schließlich darauf zu verlassen, dass das Produkt den Durchbruch schafft.

"Das ist das Faszinierende am Unternehmertum, ein solches 'No-Brainer'-Projekt und sie haben es durchgezogen".

Vor kurzem gab Anysphere den Abschluss einer Serie-B-Finanzierungsrunde in Höhe von 100 Millionen US-Dollar bekannt und wurde mit 2,6 Milliarden US-Dollar bewertet. Sacra schätzt den jährlichen wiederkehrenden Umsatz (ARR) von Cursor auf 65 Millionen US-Dollar im November 2024, was einem Anstieg von 64.001 TP3T im Vergleich zum Vorjahr entspricht. und seit seiner Gründung im Jahr 2022 hat Anysphere nur 12 Mitarbeiter.

2: Copilot klar, Agent verwirrt

Cursor ist nicht das erste Produkt, das auf dem Gebiet der KI-Programmierung aus dem Ring steigt.

Im März 2024 wird der "erste KI-Programmierer der Welt", der sich als der Devin kam aus dem Nichts und entfachte zum ersten Mal die Leidenschaft der Branche für die KI-Programmierung.

Devin ist ein autonomer Agent, der über umfassende Fähigkeiten verfügt, selbständig zu lernen, Anwendungen zu erstellen und bereitzustellen, Fehler zu beheben und sogar seine eigenen KI-Modelle zu trainieren und zu optimieren. Das Unternehmen dahinter, Cognition AI, ist ebenfalls ein schillerndes KI-"Dreamteam".

Allerdings wurde Devin zunächst als Demo veröffentlicht, und die Entwickler konnten nicht an die Software herankommen. Erst am 11. Dezember 2024 ging Devin mit einer monatlichen Abonnementgebühr von satten 500 Dollar in Betrieb. Im Vergleich dazu erscheint die monatliche Abonnementgebühr von Cursor mit 20 Dollar sogar erschwinglicher.

Im Gegensatz zu Cursors allgemeinem Favoriten sind die Kritiken der Entwickler zu Devin kontrovers. Einige sind der Meinung, dass Devin hervorragend für die Code-Migration und die Erstellung von PRs (Pull Requests, Code-Änderungsanfragen, die von Entwicklern während der Code-Zusammenarbeit zur Überprüfung und Zusammenführung durch andere Teammitglieder eingereicht werden) geeignet ist, was die sich wiederholende Arbeit der Entwickler erheblich reduzieren kann; einige Benutzer weisen jedoch darauf hin, dass Devin immer noch viele manuelle Eingriffe erfordert, wenn es um komplexe Geschäftslogik geht. Einige Benutzer haben jedoch festgestellt, dass Devin immer noch viele manuelle Eingriffe erfordert, wenn es um komplexe Geschäftslogik geht, insbesondere wenn das Projekt nicht ausreichend dokumentiert ist oder eine schlechte Codequalität aufweist.

Der Hauptgrund für den Unterschied in der "Beliebtheit" von Cursor und Devin ist der Unterschied in der Fehlerquote und den Fehlerkosten für Entwickler, die das Produkt verwenden.

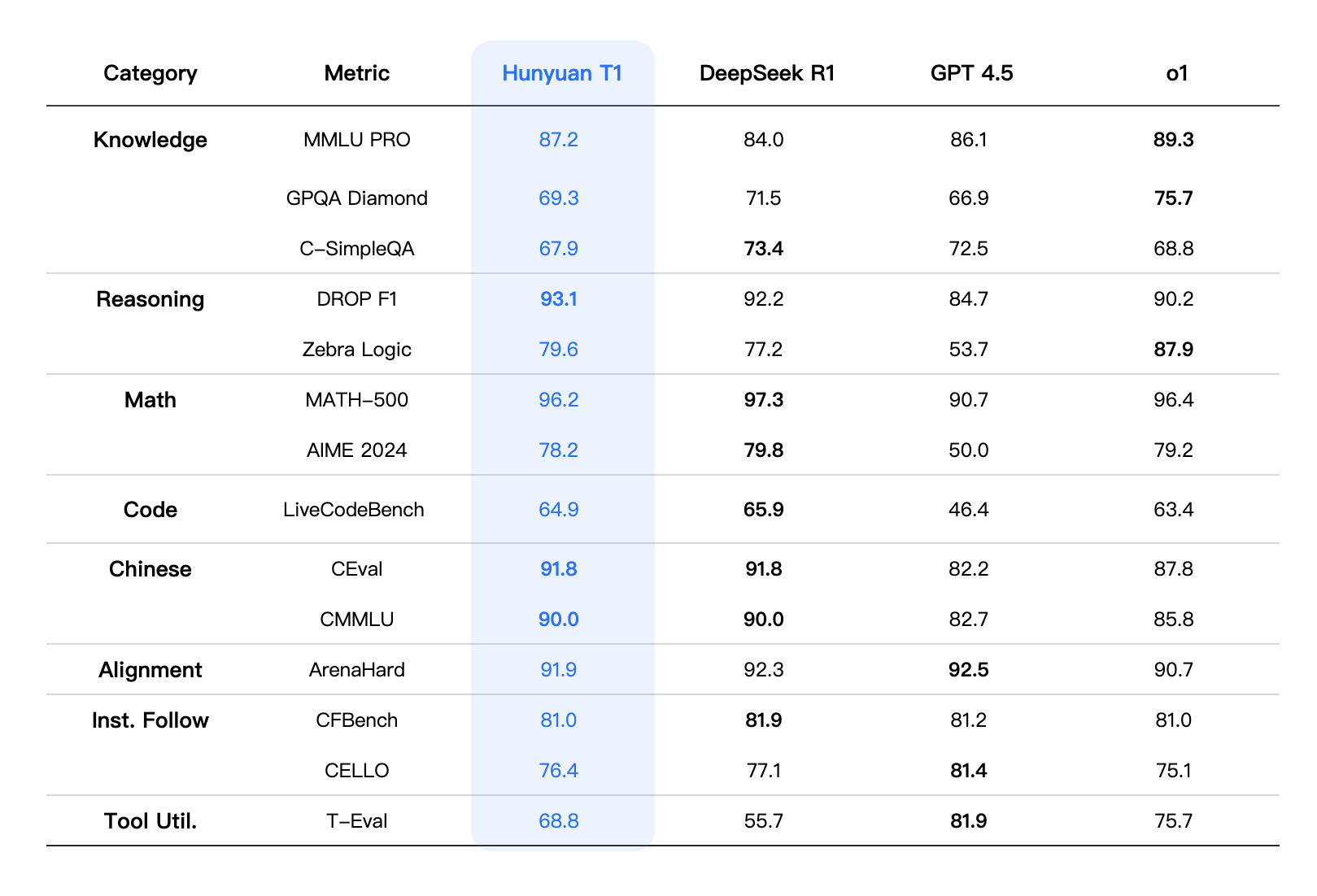

Derzeit ist die Ausfallrate des Copilot-Szenarios relativ gering, und die Genauigkeit der entsprechenden Messung HumanEval konvergiert auf 100%, während die Genauigkeit der entsprechenden Messung SWE Benchmark für Agent-Szenario ist derzeit weniger als 60%.

Außerdem müssen die Ergebnisse der KI vom Menschen akzeptiert und bestätigt werden, und die Interaktionsmethode von Copilot-Produkten führt dazu, dass die Kosten für den Entwickler, die von der KI generierten Ergebnisse zu sehen, sehr niedrig sind, und die Kosten für den Benutzer, sie zu ändern oder nicht zu übernehmen, wenn sie fehlgeschlagen sind, sind ebenfalls sehr niedrig. Bei Produkten vom Typ Agent sind die Kosten für die Bestätigung durch den Benutzer jedoch wesentlich höher als bei Copilot, und die Kosten für die Änderung nach einem Fehlschlag sind ebenfalls höher.

Die beiden Richtungen von Cursor und Devin spiegeln auch weitgehend den aktuellen Stand der Produktformen Copilot und Agent in generischen Szenarien wider.

Cursor steht für Copilot und erfordert, dass KI und Mensch synchron arbeiten, wobei der Mensch die Führung übernimmt und die KI assistiert.

Im Moment ist es Copilot, der das PMF wirklich leitet.Copilot kann parasitär in IDEs wie VS Code, in Form von Plug-Ins, die Unterstützung der menschlichen Entwickler, um alle Arten von Coding-Aktionen zu vervollständigen, und nach der Entstehung von GitHub Copilot, haben die Nutzer allmählich daran gewöhnt, die Form der Zusammenarbeit in Copilot, und die Entstehung von GPT-3.5, Copilot aus der Demo hat sich zu einem echten nutzbaren Produkt.

Ich habe jedoch über die "versteckten Bedenken" der Copilot-Produktkategorie geschrieben. "Der wahre Graben ist VS Code, das sich von einem einfachen Editor zu einer Plattform entwickelt hat. Der Grund, warum Benutzer leicht von GitHub Copilot zu Cursor wechseln können, ist, dass beide auf VS Code aufsetzen und die Gewohnheiten, Erfahrungen und Funktionen/Plugins des Benutzers alle genau gleich sind. Die großen Modelle erhalten und sind bereits Teil des Modells."

Im Gegensatz dazu ist Agent eine neue Spezies, die von GPT-3.5 hervorgebracht wurde, ein neues Konzept, das eher in der Lage ist, die sensiblen Nerven von Unternehmern und VCs zu stimulieren.Devin ist ein Vertreter der Agentenform, die von der KI verlangt, asynchron mit dem Menschen zu arbeiten, und von der KI mehr Initiative, um einige der Entscheidungen und die Ausführung autonom zu treffen.

Agent ist die Chance für Unternehmer. Aber er ist nicht überzeugt von der Rundum-Agent-Vision, die Devin vertritt, dem"Alles zu tun bedeutet, nichts zu tun, und der Wert von Agent-Anwendungen in Nischenbereichen ist viel höher.

Da das Agentenkonzept jedoch noch in den Kinderschuhen steckt und alle noch am Forschen sind, sind die parasitäre Umgebung des Agenten und die Grenzen seiner Fähigkeiten noch unklar, und es gibt Leute, die das Feld in Richtung Codegenerierung, Codevervollständigung, Unit-Test-Generierung und Fehlererkennung betreten.

Gru entschied sich, mit Unit-Tests zu beginnen. Vor der offiziellen Markteinführung des Produkts, Gru hatte auch eine Zeit der Versuch und Irrtum intern, automatische Generierung von Dokumenten, Fehlerbehebung, E2E-Tests und andere Richtungen wurden versucht, aber durch Modell Fähigkeiten, Software-Iteration und Wartung und andere Schmerzpunkte begrenzt kann nicht fortgeschritten sein.

Schließlich entdeckte Gru das Bedürfnis nach Unit-Tests, das häufig, aber nicht unbedeutend, besteht. Viele Entwickler schreiben nicht gerne Unit-Tests, weil sie langweilig sind. Darüber hinaus sind Unit-Tests bei weniger anspruchsvollen Projekten keine notwendige Voraussetzung für die Softwareentwicklung. Gru ist jedoch der Ansicht, dass die Landung von KI-Produkten aus der Perspektive der technischen Fähigkeiten das Problem der Kohärenz von Geschäftskontext und technischem Kontext lösen muss, wobei Unit-Tests am wenigsten von den beiden Kontexten abhängen, aber auch am relevantesten für die aktuellen Modellfähigkeiten der Verbindung sind.

Allerdings.Ob Copilot oder Agent ist eher ein Mittel als ein Zweck, sie sind nicht "entweder/oder", sondern werden nebeneinander existieren und unterschiedliche Probleme lösen.

Für viele einzelne Entwickler und einige kleine und mittlere Unternehmen können generische Produkte wie Cursor oder einige Open-Source-Modelle ausreichen, um die meisten Anforderungen zu erfüllen. Für viele große Unternehmen und komplexe Geschäftsszenarien in verschiedenen Bereichen ist es jedoch schwierig, den Bedarf einfach durch ein "Copilot"- oder "Agent"-Produkt in Form eines generischen Produkts zu decken, so dass Technologieanbieter über stärkere domänenspezifische Servicefähigkeiten verfügen müssen. Für viele große Unternehmen und komplexe Geschäftsszenarien in verschiedenen Bereichen ist es jedoch schwierig, die Nachfrage durch ein generisches Produkt in Form eines "Copiloten" oder "Agenten" zu befriedigen, so dass Technologieanbieter über stärkere domänenspezifische Dienstleistungskapazitäten verfügen müssen.

In letzterem liegt die Chance für inländische KI-Programmierunternehmen.

3. die inländischen Möglichkeiten liegen in den vertikalen Bereichen

Wenn wir auf das Jahr 2024 zurückblicken, ist die KI-Programmierung zweifellos eine der heißesten VC-Richtungen im Silicon Valley, mit Einhörnern wie Cursor, Poolside, Cognition, Magic, Codeium, Replit und anderen, die bereits aktiv sind.

Im Gegensatz dazu haben inländische Internetanbieter und große Modellhersteller im Grunde ihre eigenen "Code-Modelle" auf den Markt gebracht, aber es gibt nur sehr wenige gut entwickelte Start-ups. Nach Angaben von Silicon Star People investierte Qiji Chuangtan im vergangenen Jahr in sechs Start-ups im Bereich der KI-Programmierung, und seitdem sind fast alle von ihnen verschwunden, während im vergangenen Jahr mehr als 10 Code-basierte Teams, die kurz aufgetaucht waren, die meisten von ihnen in diesem Jahr bereits aufgegeben haben.

Nach dem Auftauchen von ChatGPT hat Clearstream Capital Dutzende von Projekten im Bereich der KI-Programmierung geprüft, aber das einzige, das schließlich einen Schritt gemacht hat, ist Silicon Heart Technology (kurz "aiXcoder").

Bei inländischen KI-Programmierprojekten sind viele der Ansicht, dass das Produkt "seichter" gemacht wird. "Es gibt Entwickler in der Community, die sich darüber beschweren, dass viele Produkte jetzt Code für ein paar Minuten generieren, aber sie müssen einen halben Tag oder mehr mit der Fehlersuche verbringen.

Hinter dem "seichten" Erscheinungsbild des Produkts verbirgt sich ein ökologischer Unterschied, der sich im Laufe der Jahre auf dem US-amerikanischen und dem chinesischen 2B-Markt entwickelt hat.. Analyse der Gründe sind drei: die Vereinigten Staaten Junior Programmierer Gruppe ist riesig, und die Kosten für die Arbeitskräfte ist höher, die Einführung von AI-Produkte können Unternehmen helfen, die Kosten deutlich zu senken; die Vereinigten Staaten SaaS-Markt wurde durch die PLG-Modell, das Unternehmen die Bereitschaft, für Allzweck-Produkte zu zahlen ist stärker; und der Exit-Pfad des ausländischen 2B-Markt ist klar, die Bereitschaft der Investoren zu investieren ist stark, und die Logik der ersten Ebene des Marktes, um das Geschäft zu übernehmen ist auch sehr klar, Angel-Investoren sind sehr viel und sehr aktiv. Start-ups können fast immer die erste Finanzierungsrunde erhalten, um ihre Ideen zu validieren.

Im September 2024 brachte Gru Gru.ai auf den Markt und belegte mit einer hohen Punktzahl von 45,2% den ersten Platz in der von OpenAI veröffentlichten Swe-Bench-Bewertung. Es gab ein klares Gefühl, dass ein Produkt zu haben, es im Silicon Valley akzeptabler machte.

Und für den inländischen Markt auf der B-Seite besteht immer noch das klischeehafte Problem. "Es ist schwieriger, B im Inland zu machen, die Verkaufskette ist länger, und am Ende sind diejenigen, die die Rechnung bezahlen können, immer noch meist große Unternehmen, aber manchmal sind große Unternehmen nicht diejenigen, die sie kaufen, wenn Ihr Zeug gut ist." "Viele Unternehmen haben eine große Anzahl von internen Sicherheits-Compliance-Anforderungen, zum Beispiel wegen der Besorgnis über das Risiko von Informationslecks, kann nicht die Wolke verwenden, um das Produkt zu nennen, die Notwendigkeit für lokal bereitgestellten Code-Tools."

Infolgedessen müssen die heimischen KI-Programmierunternehmen mit beiden Beinen im Dreck stehen, um spezifische Probleme in verschiedenen Branchen zu lösen.

"Das Modell sollte die Geschäftskontinuität in der tatsächlichen Landung Prozess zu berücksichtigen, der inländischen Code-Modell aus der Bewertung der Ergebnisse der Leistung verbessert werden, aber in den spezifischen Anwendungsszenarien, ist es notwendig, spezifische Szenarien zu analysieren." Nach Gesprächen mit einem Unternehmen der verarbeitenden Industrie wurde festgestellt, dass in einigen Softwaresystemen in industriellen Szenarien nicht das übliche Python oder C++ verwendet wird, sondern einige branchenspezifische Codierungstools, so dass die Technologieanbieter ihre Produkte gezielt anpassen müssen.

Jede Branche hat ihre eigenen Charakteristika und jedes Unternehmen verfügt über eine spezifische Geschäftslogik und ein spezifisches technisches System, so dass KI-Programmierunternehmen über stärkere domänenspezifische Servicefähigkeiten verfügen müssen.

Nach der Untersuchung von Dutzenden von Unternehmen wurde festgestellt, dass "für alle Arten von Softwareentwicklungsanforderungen die KI-Programmierfunktionen neben der Codegenerierung zumindest eine Reihe von Aufgaben wie Suche, Fehlererkennung und -behebung sowie Tests umfassen;Neben der Funktionalität muss auch berücksichtigt werden, wie diese Funktionen in die Geschäftslogik des Kunden integriert werden können, damit das Modell über ein tieferes Domänenwissen verfügt, was in der Tat eine hohe Hürde darstellt.

Infolgedessen ist Clearstream Capital von der Idee einer tiefen Kopplung von Modellen und Produkten mit internem privatem Wissen, Daten und Softwareentwicklungsrahmen innerhalb der Organisation überzeugt und investierte im September 2023 in aiXcoder.

"In diesem bewährten Bedarf ist aiXcoder das technisch und kaufmännisch am besten kompatible Team. Gleichzeitig verfügen einige der wichtigsten Mitglieder des kommerziellen Teams des Unternehmens über mehr als ein Jahrzehnt Vertriebserfahrung mit nationalen und internationalen Big-B-Kunden und haben tiefe Einblicke in Kunden und den Markt. Sie schlugen im zweiten Quartal 2023 eine 'Domainisierungs'-Landungslösung vor, d. h. die Strategie, dass die KI-Programmierung eng mit internem privatem Wissen, Daten und Softwareentwicklungs-Frameworks innerhalb des Unternehmens gekoppelt werden sollte, was auch von einer großen Anzahl von Hauptkunden des Unternehmens im Hinblick auf die tatsächlichen Landungsergebnisse des Projekts anerkannt wurde."

aiXcoder, das aus dem Institut für Softwaretechnik der Universität Peking hervorgegangen ist, ist das weltweit erste Team, das Deep-Learning-Technologien auf die Codegenerierung und das Codeverständnis anwendet, und auch das erste Team, das Deep Learning auf Programmierprodukte anwendet. Das Team hat mehr als 100 Beiträge in internationalen Spitzenzeitschriften und -konferenzen veröffentlicht, von denen viele zu den ersten und meistzitierten Beiträgen auf dem Gebiet der intelligenten Softwaretechnik gehören.

Der Geschäftspartner und Präsident von aiXcoder sagte, dass, wenn man mit den privaten B-End-Einsatzszenarien konfrontiert ist, weil das allgemeine große Modell die Daten der privaten Domäne nicht gelernt hat, dem Modell die tiefgehende Integration der internen Geschäftsanforderungen des Unternehmens, der Branchenspezifikationen, des Softwareentwicklungsrahmens und der Betriebsumgebung fehlt und es versäumt, das Hintergrundwissen der Unternehmensdomäne wie Anforderungsanalyse und Designdokumente in das Modelltraining einzubeziehen, was dazu führt, dass der generierte oder ergänzte Code auf der Geschäftslogikebene an Relevanz und Zuverlässigkeit mangelt.

Das Ergebnis ist, dass die Genauigkeit und Nutzbarkeit großer Modelle in Unternehmensanwendungen geringer ist als erwartet. "Viele große Modelle erbringen in allgemeinen Szenarien oder Mainstream-Bewertungssätzen bewundernswerte Leistungen mit einer Genauigkeit von bis zu 301 TP3T, aber wenn sie intern im Unternehmen eingesetzt werden, sinkt die Genauigkeit in der Regel auf unter 101 TP3T.Auch mit den herkömmlichen Mitteln der Feinabstimmung lassen sich die von den Unternehmen gewünschten Ergebnisse nur schwer erzielenDaher ist das Erlernen und Beherrschen von Domänenwissen der Schlüssel für die erfolgreiche Implementierung von KI-Programmiersystemen in Unternehmen. Daher ist das Erlernen und Beherrschen von "domänenspezifischem" Wissen der Schlüssel für die erfolgreiche Implementierung von KI-Programmiersystemen in Unternehmen. In der Lösung domänenspezifischer Probleme für Unternehmenskunden liegt unser Differenzierungsmerkmal."

Um die oben genannten Probleme zu beheben, führt aiXcoder gezielte inkrementelle Schulungen durch, die auf einer Vielzahl interner Daten basieren, die vom Unternehmen bereitgestellt werden - darunter Code, Geschäftsdokumente, Anforderungsdokumente, Designdokumente, Testdokumente sowie Geschäftsterminologie und Prozessspezifikationen der Branche, technische Industriestandards und -spezifikationen, Technologie-Stacks und Programmier-Frameworks des Unternehmens und anderes Fachwissen. . Zusätzlich zur Modellschulung wird es auch mit Multi-Agenten, RAG, Softwareentwicklungswerkzeugen und dem "Engineered Prompt System" kombiniert, das in den Rahmen der Unternehmenssoftwareentwicklung passt, um die Qualität der Codegenerierung und die Fähigkeit des gesamten Prozesses der Forschung und Entwicklung zu verbessern.

In Form einer Lieferung.Bereichsbasierte Lösungen sind nicht dasselbe wie die traditionelle, hochgradig kundenspezifische projektbasierte BereitstellungaiXcoder extrahiert aus den individuellen Bedürfnissen der Kunden Fähigkeiten und Werkzeuge mit gemeinsamem Wert und formt daraus standardisierte Produkte und Prozesse, die den Kunden zur Verfügung gestellt werden. Gleichzeitig pflegt aiXcoder eine hochfrequente Kommunikation mit den Kunden durch regelmäßige Meetings, die nicht nur die Kunden bei der Lösung zyklischer Probleme unterstützen, sondern auch die weitere Iteration der Produkte auf der Grundlage der gemeinsamen und realen Bedürfnisse der Kunden erfordern.

4. die KI-Industrie hat schon zu oft "den Wolf geheult".

Aus ergebnisorientierter Sicht gibt es keine optimale Antwort auf die Frage, ob es sich um ein kleines B oder ein großes B, ein "Schulungsmodell" oder ein "Nicht-Schulungsmodell", einen Copiloten oder einen Agenten handelt. Es gibt möglicherweise keine optimale Antwort.

Unabhängig davon, welchen Weg sie einschlagen, haben KI-Programmierunternehmen ein einfaches und geradliniges Ziel: die Effizienz der Softwareentwicklung zu verbessern. Der aktuelle Markt steht jedoch noch am Anfang, undDie korrekte Kanalisierung der Kundennachfrage ist ein Problem für jeden Marktteilnehmer.

Die größte Schwierigkeit besteht derzeit darin, die Kunden dazu zu bringen, den Wert von segmentierten Agenten zu erkennen."Selbst im Silicon Valley ist die erste Reaktion vieler potenzieller Kunden, wenn sie von einem neuen KI-Produkt hören, eine Frage und keine Begeisterung.. Denn eines der Probleme der KI-Branche ist, dass es in der Vergangenheit zu viele Geschichten gab, in denen "der Wolf schrie", und dass viele Demos gemacht wurden, die nicht funktionierten: "Im Moment wendet Gru viel Energie auf, um Kunden zu erreichen und Mundpropaganda von Startnutzern aufzubauen, die die Grundlage für eine spätere groß angelegte Kommerzialisierung bilden wird.

Für den heimischen Markt muss die Nachfrageseite von KI-Programmiersystemen auch die Grenzen ihrer eigenen Bedürfnisse und Modellfähigkeiten klären. "Derzeit haben große modellgesteuerte KI-Programmiersysteme eine vielversprechende Zukunft bei der Verbesserung der Softwareproduktivität. "Um den Wert dieser Technologie in einer Unternehmensumgebung wirklich zu nutzen, ist es notwendig, das Code-Big-Modell mit dem unternehmenseigenen Domänenwissen zu verbinden und es in spezifischen Geschäftsszenarien kontinuierlich zu iterieren und zu validieren."

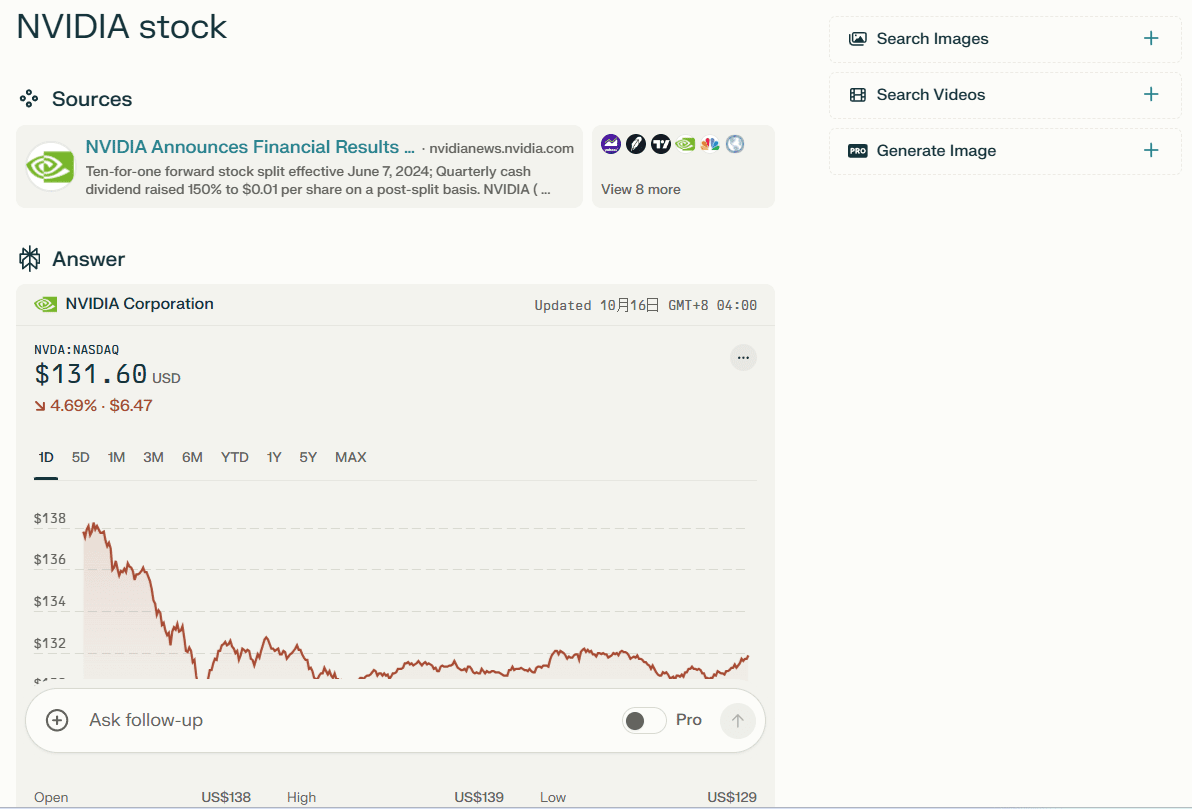

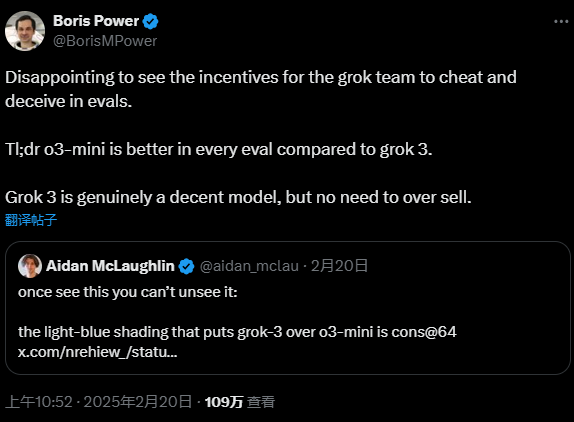

In der Tat.Die großen Modelle haben sich so weit entwickelt, dass die Marktstimmung weitgehend zur Rationalität zurückgekehrt ist, aber der Lärm ist immer noch daDas Jahr 2024 zum Beispiel ist ein Jahr, in dem große Modelle von Gebotsinformationen üblich sind, aber einige der Daten können "irreführend" sein. Im Jahr 2024 sind zum Beispiel große Modelle von Gebotsinformationen üblich, aber einige der Daten sind wahrscheinlich "irreführend".

"Die ökologische Arbeitsteilung ist im Ausland klarer, aber viele Projekte, die in China mit TO B durchgeführt werden, enden in Ausschreibungen, und viele Unternehmen drängen sich um die Aufträge." Im Bereich der KI-Programmierung haben jedoch, den öffentlichen Ausschreibungsinformationen nach zu urteilen, selbst einige große Hersteller nicht viele Aufträge erhalten.

Der Grund dafür ist, dassEin erfolgreiches Angebot ist nicht gleichbedeutend mit einem erfolgreichen Modell oder Produkt in der Praxis.

Zum einen liegen bei vielen Einkäufern, die für die Beschaffung verantwortlich sind, und die tatsächliche Nutzung des Produkts oft nicht auf einer Wellenlänge, was dazu führen kann, dass Beschaffungsentscheidungen und die tatsächlichen geschäftlichen Bedürfnisse der beiden Schichten auseinanderklaffen. Auf der anderen Seite, diese Landung oft auf standardisierte Produkte plus Feinabstimmung, nicht für das Unternehmen Geschäftsszenarien und interne Logik für eine eingehende Domain-Schulung und Anpassung, die zu Programmierern bei der Verwendung des Prozesses führen kann festgestellt, dass die Ergebnisse nicht zufriedenstellend sind.

Ein Brancheninsider verriet, dass die meisten Aufträge auf dem derzeitigen Ausschreibungsmarkt, die Hardware beinhalten, in die Millionen gehen, während reine Softwareaufträge, wie z. B. die Entwicklung intelligenter Software, Code-Assistenten und andere Projekte, meist im Bereich von 300.000 oder so liegen. Viele Unternehmen stellen fest, dass sie das Problem nach dem Kauf nicht lösen können, und sie können nur auf den Markt zurückgehen, um einen geeigneteren Hersteller zu finden, was zu einer Verschwendung von Ressourcen führt.

Allerdings zeichnet sich bei der Dekonstruktion ein gewisser Konsens ab.Immer mehr Unternehmen erkennen, dass der Trend zur "Entkopplung" von Produkt- und Modellfähigkeiten geht.

In der ersten Hälfte des Jahres 2024, wenn die Modellfähigkeiten stärker werden, werden die Modelle in Bezug auf die Programmierung konvergieren, und das Produkt sollte nicht mehr auf die Modellfähigkeiten zugeschnitten sein, sondern stattdessenMachen Sie das Produkt "modellunabhängig".. "Ab der ersten Hälfte des Jahres 2024 werden wir keine spezifischen Optimierungen für verschiedene Modelle mehr vornehmen, sondern die Fähigkeiten unserer Produktarchitektur verbessern, so dass jedes auf dem Markt befindliche Modell angeschlossen werden kann, solange es unsere Benchmarks erfüllt."

"Unternehmenskunden sollten der Geschäftskontinuität volle Aufmerksamkeit schenken und sich nicht an einen einzigen Anbieter großer Modelle binden. Derzeit ist es schwierig, die Anforderungen von Unternehmenskunden an Big-Model-Landungen wirklich zu erfüllen, wenn sie nur standardisierte Produkte kaufen. Unternehmen müssen eine architektonische Entkopplung in Bezug auf Big Models, Datenebene, Domänen und Technik erreichen und flexibel Modelle und Serviceanbieter wählen, die besser zu ihren Bedürfnissen passen. Vor allem aber muss das eigentliche Problem der Domänisierung der Softwareentwicklung im Unternehmen effektiv gelöst werden, um den Unternehmen zu helfen, Kosten zu senken und effizienter zu arbeiten."

Aus der Sicht eines Branchenfremden ist der Zugang zum Modell in Zukunft nur ein Teil der Landung der Branche. "Jetzt sind es noch 100 Kilometer vom Modell bis zur Anwendung. Wenn die Technologieanbieter die Fähigkeiten der ersten 95-99 Kilometer in der Infrastruktur standardisieren, können die verbleibenden letzten 1-5 Kilometer von der Anwendungsseite selbst erledigt werden.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...