Befehl R7B: Verbesserte Abfrage und Schlussfolgerungen, mehrsprachige Unterstützung, schnelle und effiziente generative KI

Das kleinste Modell unserer R-Familie bietet erstklassige Geschwindigkeit, Effizienz und Qualität für die Entwicklung leistungsstarker KI-Anwendungen auf gängigen GPUs und Edge-Geräten.

Wir freuen uns, heute Folgendes veröffentlichen zu können Befehl R7B, das kleinste, schnellste und letzte Modell unserer R-Serie von Large Language Models (LLMs), das speziell für Unternehmen entwickelt wurde. Command R7B bietet eine branchenführende Leistung in seiner Klasse von offen gewichteten Modellen, die in der Lage sind, reale Aufgaben zu bewältigen, die für die Benutzer wichtig sind. Das Modell ist für Entwickler und Unternehmen konzipiert, die Geschwindigkeit, Kosteneffizienz und Rechenressourcen optimieren müssen.

Wie die anderen Modelle der R-Familie bietet Command R7B eine Kontextlänge von 128k und zeichnet sich in mehreren wichtigen geschäftlichen Anwendungsszenarien aus. Es kombiniert starke Mehrsprachenunterstützung, referenzvalidierte Retrieval Augmented Generation (RAG), Reasoning, Werkzeugnutzung und Agentenverhalten. Dank ihrer kompakten Größe und Effizienz kann sie auf Low-End-GPUs, MacBooks und sogar CPUs laufen, was die Kosten für die Einführung von KI-Anwendungen in die Produktion drastisch reduziert.

Hohe Leistung in einem kleinen Paket

Ein umfassendes Modell

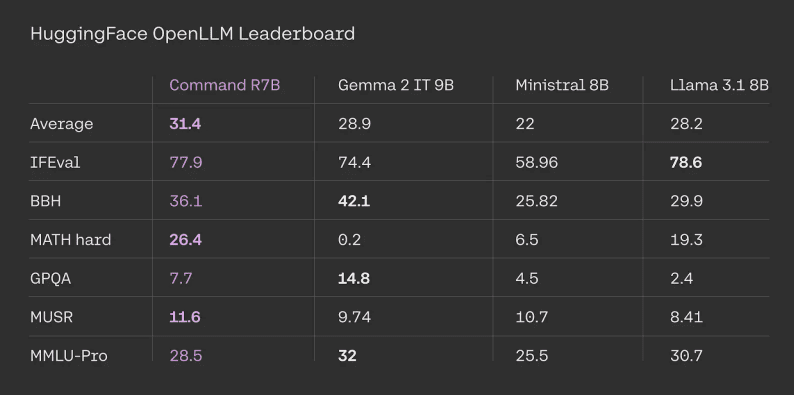

Command R7B schneidet bei standardisierten und extern überprüfbaren Benchmarks gut ab, z. B. bei HuggingFace Open LLM Bestenlisten. Der Befehl R7B belegte bei allen Aufgaben im Durchschnitt den ersten Platz mit einer starken Leistung im Vergleich zu anderen vergleichbaren offenen Gewichtungsmodellen.

HuggingFace Leaderboard-Bewertungsergebnisse. Die Zahlen der Konkurrenten stammen aus den offiziellen Leaderboards. Die Ergebnisse für Command R7B werden von uns auf der Grundlage der von der offiziellen HuggingFace bereitgestellten Tipps und Bewertungscodes berechnet.

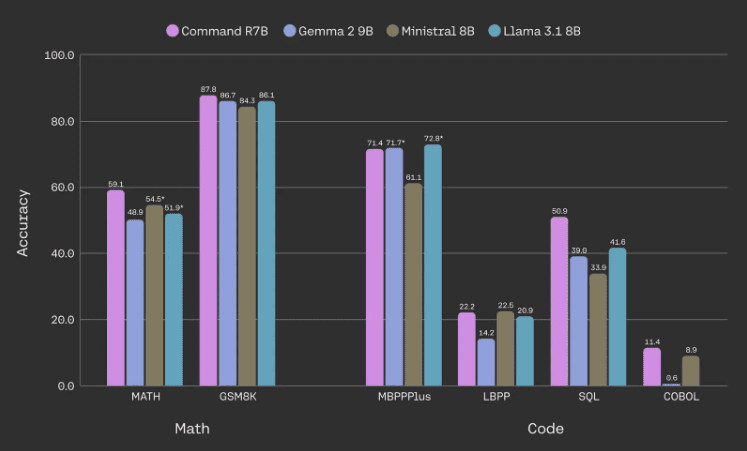

Effizienzsteigerungen bei Mathematik-, Code- und Argumentationsaufgaben

Ein Hauptaugenmerk des Befehls R7B liegt auf der Verbesserung der Leistung in den Bereichen Mathematik und logisches Denken, Schreiben von Code und mehrsprachige Aufgaben. Insbesondere ist das Modell in der Lage, die Leistung vergleichbarer offen gewichteter Modelle bei gängigen Mathematik- und Code-Benchmarks zu erreichen oder zu übertreffen, während es weniger Parameter benötigt.

Modellleistung in Mathematik und Code-Benchmarking. Alle Daten stammen aus internen Auswertungen, die mit einem Sternchen versehenen Zahlen stammen aus extern gemeldeten Ergebnissen, die höher sind. Wir verwenden die Basisversion von MBPPPlus, LBPP wird über 6 Sprachen gemittelt, SQL wird über 3 Datensätze gemittelt (höhere und superhohe Schwierigkeitsabschnitte von SpiderDev und Test only, BirdBench und ein interner Datensatz), und COBOL ist ein Datensatz, den wir intern entwickelt haben.

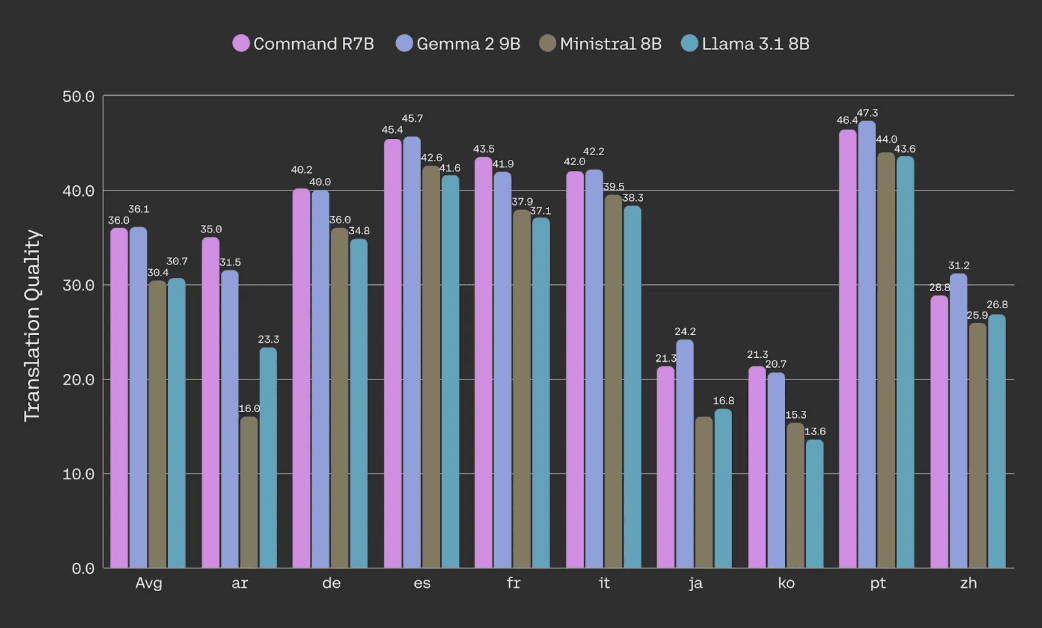

Bewertung der Übersetzungsqualität von Dokumenten (mittels Korpus-SpBLEU-Metriken) anhand des NTREX-Datensatzes.

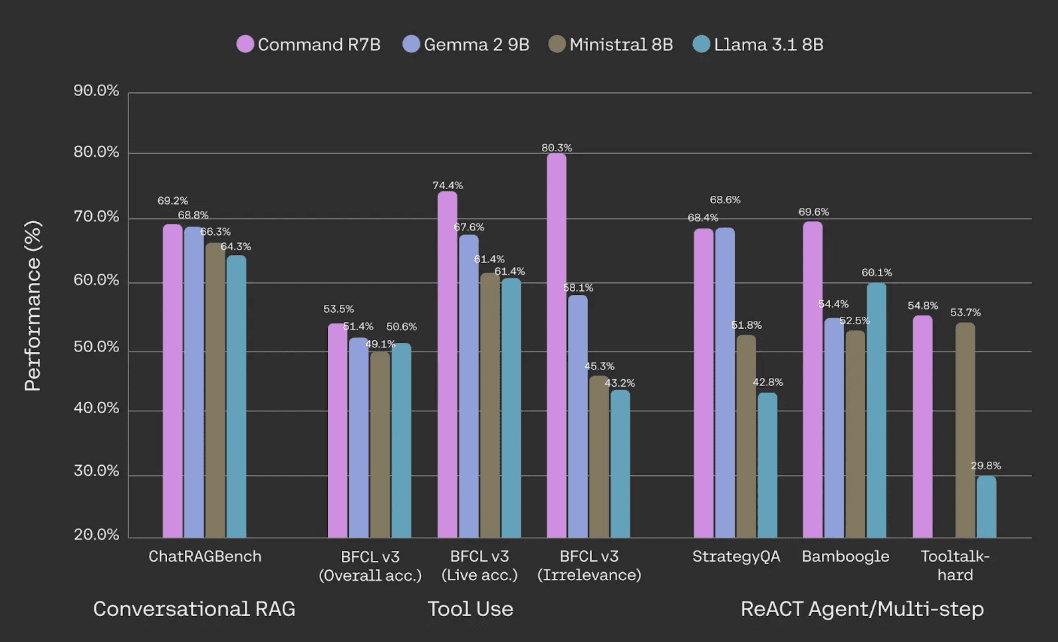

Erstklassige RAG, Werkzeugnutzung und Intelligenz

Command R7B übertrifft andere offene Gewichtungsmodelle vergleichbarer Größe bei der Handhabung von Kerngeschäftsanwendungen wie RAG, Werkzeugnutzung und KI-Intelligenz. Es ist ideal für Unternehmen, die ein kosteneffizientes, auf internen Dokumenten und Daten basierendes Modell suchen. Wie bei unseren anderen Modellen der R-Serie ist unser RAG Lokale Inline-Referenzen werden bereitgestellt, was die Illusionen verringert und die Überprüfung der Fakten erleichtert.

Leistungsbewertung auf ChatRAGBench (gemittelt über 10 Datensätze), BFCL-v3, StrategyQA, Bamboogle und Tooltalk-hard. Siehe Fußnote [1] unten für die Methodik und weitere Details.

In Bezug auf den Werkzeugeinsatz zeigt sich, dass der Command R7B im Vergleich zu vergleichbaren Modellen effizienter ist, was den Einsatz von Industriestandards angeht Berkeley-Funktionsaufruf-Rangliste Dies zeigt, dass der Befehl R7B besonders gut bei der Verwendung von Werkzeugen in verschiedenen und dynamischen Umgebungen in der realen Welt ist und in der Lage ist, unnötige Aufrufe von Werkzeugen zu vermeiden, ein wichtiger Aspekt der Werkzeugverwendung in realen Anwendungen. Dies zeigt, dass Command R7B besonders geschickt bei der Verwendung von Werkzeugen in verschiedenen und dynamischen Umgebungen in der realen Welt ist und in der Lage ist, unnötige Werkzeugaufrufe zu vermeiden, ein wichtiger Aspekt der Werkzeugverwendung in realen Anwendungen.Command R7Bs Fähigkeit, mehrstufige Werkzeuge zu verwenden, ermöglicht es, schnelle und effiziente KI-Intelligenzen zu unterstützen.

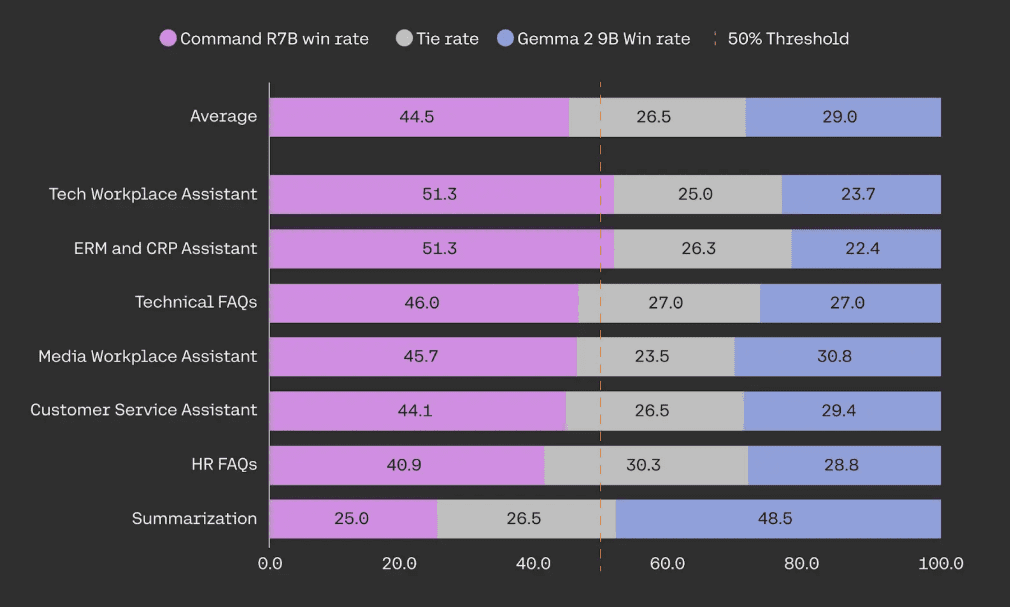

Optimierung für Unternehmensanwendungen

Unsere Modelle sind für die Fähigkeiten optimiert, die Unternehmen beim Einsatz von KI-Systemen in der realen Welt benötigen.Die R-Serie bietet ein konkurrenzloses Gleichgewicht zwischen Effizienz und robuster Leistung. Command R7B übertrifft ähnlich große, offen gewichtete Modelle in blinden Kopf-an-Kopf-Tests bei RAG-Anwendungsfällen für den Aufbau von KI-Assistenten, die den Kunden wichtig sind, wie z. B. Kundenservice, HR, Compliance und IT-Supportfunktionen.

In der menschlichen Bewertung wurde Command R7B gegen Gemma 2 9B in einer Stichprobe von 949 RAG-Anwendungsfällen in Unternehmen getestet. Alle Beispiele wurden mindestens dreimal von speziell geschulten menschlichen Annotatoren blind annotiert, um die Geläufigkeit, Genauigkeit und Nützlichkeit der Antworten zu bewerten.

Effizient und schnell

Die kompakte Größe des Command R7B bietet einen kleinen Service-Footprint für schnelles Prototyping und Iteration. Er eignet sich hervorragend für Echtzeit-Anwendungen mit hohem Durchsatz wie Chatbots und Code-Assistenten. Außerdem unterstützt er das geräteseitige Reasoning, indem er die Kosten für die Bereitstellung von Infrastrukturen wie Consumer-GPUs und CPUs drastisch reduziert.

Wir haben bei diesem Prozess keine Kompromisse bei unseren Sicherheits- und Datenschutzstandards auf Unternehmensebene gemacht, um den Schutz der Daten unserer Kunden zu gewährleisten.

Schnellstart

Command R7B ist ab heute erhältlich bei Cohere Plattform Es kann auch auf dem HuggingFace Zum Zugang. Wir freuen uns, die Gewichte des Modells freizugeben, um der KI-Forschungsgemeinschaft einen breiteren Zugang zu Spitzentechnologie zu ermöglichen.

| Cohere API-Preise | Einfuhr Token | Token ausgeben |

|---|---|---|

| Befehl R7B | $0,0375 / 1M | $0,15 / 1M |

[1] Conversational RAG: Ein durchschnittlicher Leistungstest auf dem ChatRAGBench-Benchmark mit 10 Datensätzen, bei dem die Fähigkeit zur Generierung von Antworten in einer Vielzahl von Umgebungen getestet wurde, darunter Konversationsaufgaben, die Verarbeitung langer Eingaben, die Analyse von Formularen und die Extraktion und Manipulation von Dateninformationen in einer Finanzumgebung. Wir verbesserten die Bewertungsmethodik durch die Verwendung der PoLL-Diskriminator-Integration (Verga et al., 2024) in Kombination mit Haiku, GPT3.5 und Command R, was zu einer höheren Konsistenz führte (Fleiss' kappa = 0,74 im Vergleich zu 0,57 in der ursprünglichen Version, basierend auf 20.000 manuellen Bewertungen). Verwendung des Tools: Leistung beim BFCL-v3-Benchmark vom 12. Dezember 2024. Alle verfügbaren Ergebnisse stammen aus öffentlichen Bestenlisten, ansonsten aus internen Bewertungen unter Verwendung der offiziellen Codebasis. Bei den Wettbewerbern geben wir den höheren Wert ihrer BFCL-"Prompted"- oder "Function-Calling"-Punktzahl an. Wir geben die Gesamtpunktzahl, die Punktzahl für die Echtzeit-Teilmenge (um die Verwendung von Tools in realen, vielfältigen und dynamischen Umgebungen zu testen) und die Punktzahl für die irrelevante Teilmenge (um zu testen, wie das Modell den unnötigen Aufruf von Tools vermeidet) an.REACT Agent/Multi-Step: Wir haben LangChain REACT Die Fähigkeit der mit dem Internet verbundenen Intelligenzen, komplexe Probleme zu zerlegen und Pläne für die erfolgreiche Durchführung von Forschungsarbeiten zu entwickeln, wurde mit Hilfe von Bamboogle und StrategyQA bewertet. Bamboogle wurde mit Hilfe der PoLL-Integration bewertet, und StrategyQA wurde bewertet, indem beurteilt wurde, ob das Modell den Anweisungen des Formats folgte und schließlich mit "Ja ' oder 'Nein' antwortete, um ein Urteil zu fällen. ToolTalk stellt das Modell vor die Herausforderung, komplexe Schlussfolgerungen zu ziehen und aktiv nach Informationen vom Benutzer zu suchen, um komplexe Benutzeraufgaben wie Kontoverwaltung, Versenden von E-Mails und Aktualisieren von Kalendern zu erledigen.ToolTalk-hard wird anhand der Soft-Erfolgsrate der offiziellen ToolTalk-Bibliothek bewertet. ToolTalk erfordert, dass das Modell eine Funktionsaufruf-API bereitstellt, über die Gemma 2 9B nicht verfügt.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...