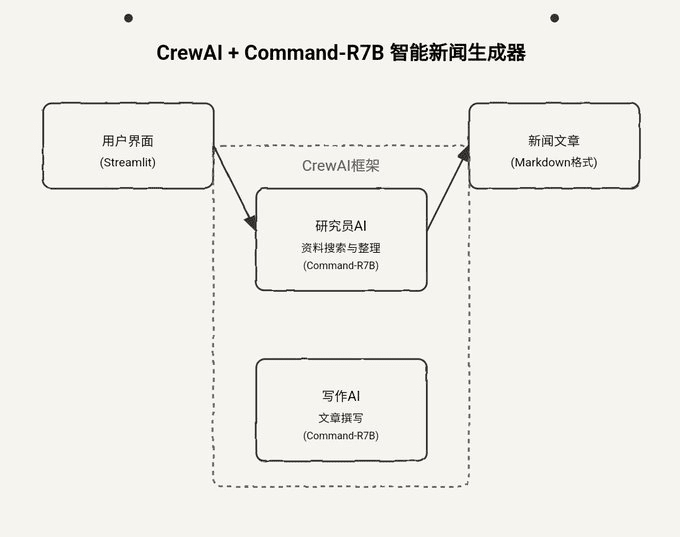

CoD: Chain of Density

Ursprünglicher Text:https://arxiv.org/pdf/2309.04269

Schnelles Lesen:Von spärlich zu dicht: GPT-4 Abstraktgenerierung mit verketteten Dichtehinweisen

Gesammelt in:Zusammenfassen der Kenntnisse über häufig verwendete Prompts

Abstracts

Die Bestimmung der "richtigen" Menge an Informationen, die in eine automatische Textzusammenfassung aufzunehmen sind, ist eine schwierige Aufgabe. Eine gute Zusammenfassung muss detailliert und entitätenzentriert sein, darf aber nicht zu lang und schwer verständlich sein. Um diesen Zielkonflikt besser zu verstehen, schlagen wir eine Cueing-Methode namens Chain of Density (CoD) vor, mit der GPT-4 in der Lage ist, immer dichtere Zusammenfassungen zu erstellen. Wir stellen fest, dass CoD-generierte Zusammenfassungen abstrakter und konvergenter sind und weniger Eröffnungsverzerrungen aufweisen als GPT-4-Zusammenfassungen, die mit normalen Hinweisen generiert werden. Anhand einer menschlichen Präferenzstudie mit 100 CNN/DailyMail-Artikeln finden wir heraus, dass Menschen dichtere Zusammenfassungen bevorzugen als GPT-4-Zusammenfassungen, die mit normalen Aufforderungen generiert wurden, und dass ihre Dichte fast mit der von manuell geschriebenen Zusammenfassungen vergleichbar ist.

1. einleitung

Automatisierte Zusammenfassungsverfahren haben in den letzten Jahren einen weiten Weg zurückgelegt, vor allem dank des Paradigmenwechsels von der überwachten Feinabstimmung zur stichprobenlosen Eingabeaufforderung unter Verwendung von groß angelegten Sprachmodellen (LLM). Beispielsweise kann GPT-4 eine feinkörnige Kontrolle über Zusammenfassungsmerkmale (z. B. Länge, Thema und Stil) mit gut konzipierten Hinweisen ohne zusätzliches Training erreichen.

Die Informationsdichte einer Zusammenfassung ist jedoch ein Aspekt, der häufig übersehen wird. Theoretisch sollte eine Zusammenfassung als Komprimierung eines anderen Textes eine höhere Informationsdichte aufweisen als das Ausgangsdokument. Die Dichte einer Zusammenfassung ist jedoch eine offene Frage. Enthält eine Zusammenfassung zu wenig Informationen, ist sie belanglos; enthält sie zu viele Informationen, kann sie schwer verständlich werden, ohne die Gesamtlänge zu erhöhen. Um mehr Informationen innerhalb eines festen Token-Budgets zu vermitteln, ist eine Kombination aus Abstraktion, Komprimierung und Verschmelzung erforderlich. Es gibt eine Grenze für die Menge an Platz, die für zusätzliche Informationen geschaffen werden kann, bevor sie unverständlich oder sogar sachlich falsch werden.

2. verkettete Dichtekennziffern (CoD)

2.1 Zielsetzungen

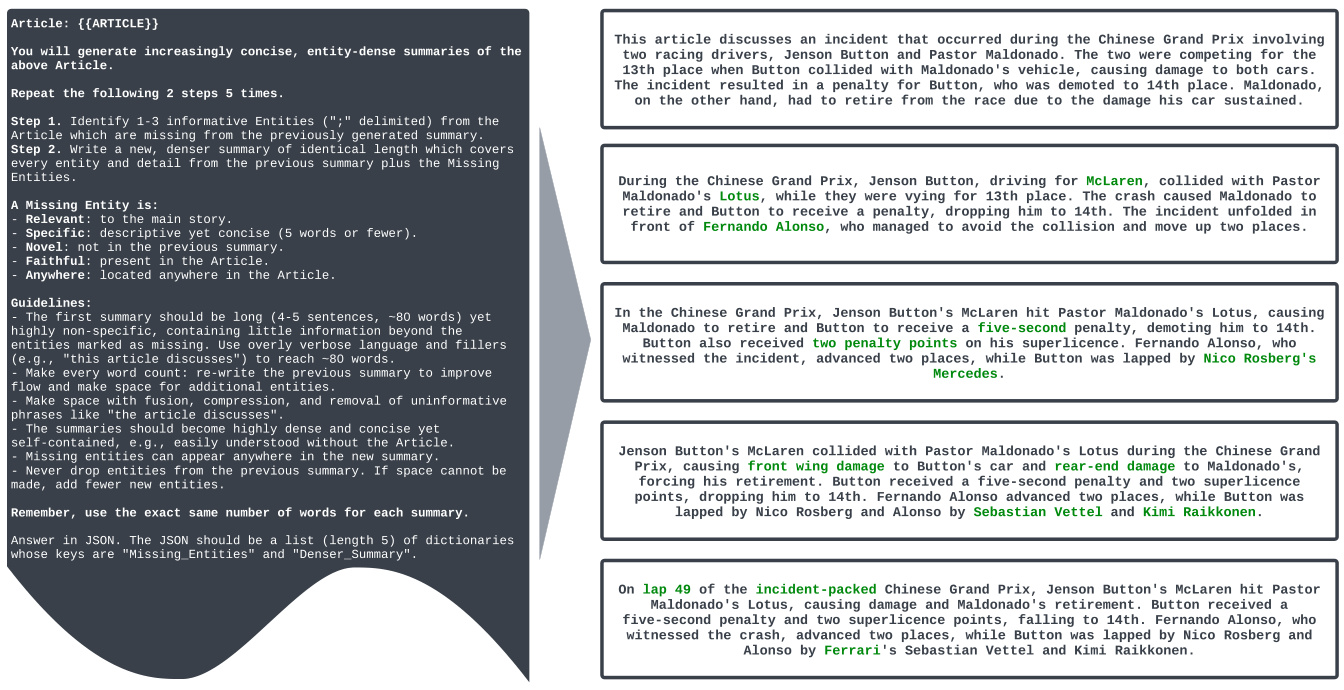

Unser Ziel war es, eine Reihe von GPT-4-Zusammenfassungen mit unterschiedlicher Informationsdichte zu erstellen und dabei die Länge zu kontrollieren, die sich bei der Bewertung von Zusammenfassungen als starker Störfaktor erwiesen hat. Zu diesem Zweck haben wir einen einzelnen Chained Density (CoD) Cue entwickelt, mit dem eine anfängliche Zusammenfassung generiert wird, die dann schrittweise in Entitäten verdichtet wird. Konkret wird für eine feste Anzahl von Runden eine eindeutige Gruppe hervorstechender Entitäten aus dem Ausgangstext identifiziert und mit der vorherigen Zusammenfassung verschmolzen, ohne deren Länge zu erhöhen. Die erste Zusammenfassung ist entitätenarm, da sie sich nur auf 1-3 anfängliche Entitäten konzentriert.

2.2 Daten

Für die Erstellung von CoD-Zusammenfassungen wurden 100 Artikel aus dem CNN/DailyMail-Zusammenfassungstest zufällig ausgewählt.

2.3 Referenzpunkte

Zum Vergleich haben wir die Statistiken der CoD-Abstracts mit manuell verfassten Bullet-Point-Referenz-Abstracts und mit GPT-4-Abstracts verglichen, die mit Hilfe allgemeiner Eingabeaufforderungen erstellt wurden:

- Gewöhnliche Tipps"Schreiben Sie eine kurze Zusammenfassung des Artikels in höchstens 70 Wörtern".

Wir stellen die erforderliche Tokenlänge so ein, dass sie mit der Länge des CoD-Digest übereinstimmt (wie in der Tabelle unten gezeigt).

2.4 Beispiele für Tipps

Nachstehend finden Sie ein Beispiel für eine CoD-Aufforderung:

请生成一个非常简短的摘要,不超过70个单词。然后,逐步添加1-3个缺失的重要实体,而不增加长度。

Beispiel für einen vollständigen CoD-Prompt (englisches Original).

Article: {{ ARTICLE }}

You will generate increasingly concise, entity-dense summaries of the above article.

Repeat the following 2 steps 5 times.

Step 1. Identify 1-3 informative entities (";" delimited) from the article which are missing from the previously generated summary.

Step 2. Write a new, denser summary of identical length which covers every entity and detail from the previous summary plus the missing entities.

A missing entity is:

- relevant to the main story,

- specific yet concise (5 words or fewer),

- novel (not in the previous summary),

- faithful (present in the article),

- anywhere (can be located anywhere in the article).

Guidelines:

- The first summary should be long (4-5 sentences, ~80 words) yet highly non-specific, containing little information beyond the entities marked as missing. Use overly verbose language and fillers (e.g., "this article discusses") to reach ~80 words.

- Make every word count: rewrite the previous summary to improve flow and make space for additional entities.

- Make space with fusion, compression, and removal of uninformative phrases like "the article discusses".

- The summaries should become highly dense and concise yet self-contained, i.e., easily understood without the article.

- Missing entities can appear anywhere in the new summary.

- Never drop entities from the previous summary. If space cannot be made, add fewer new entities.

Remember, use the exact same number of words for each summary.

Answer in JSON. The JSON should be a list (length 5) of dictionaries whose keys are "Missing_Entities" and "Denser_Summary".

Erläuterung der Stichwörter.

Dieses detaillierte CoD-Stichwort soll GPT-4 dazu anleiten, schrittweise dichtere Zusammenfassungen zu erstellen, wobei der Kerngedanke darin besteht, der Zusammenfassung in jeder Runde durch einen iterativen Prozess neue Schlüsselelemente hinzuzufügen, während die Länge der Zusammenfassung konstant bleibt. Schauen wir uns die Bestandteile dieses Stichworts an:

Article: {{ ARTICLE }}: Dies ist ein Platzhalter für den Inhalt des Artikels, den Sie zusammenfassen möchten.{{ ARTICLE }}.You will generate increasingly concise, entity-dense summaries of the above article.Dies ist der Kern der Direktive, die dem Modell mitteilt, dass das Ziel darin besteht, immer prägnantere und entitätsreichere Zusammenfassungen zu erstellen.Repeat the following 2 steps 5 times.Die Angabe der Anzahl der Iterationen mit 5 bedeutet, dass das Modell die nächsten beiden Schritte fünf Runden lang wiederholt und dabei die Dichte der Zusammenfassungen schrittweise erhöht.Step 1. Identify 1-3 informative entities (";" delimited) from the article which are missing from the previously generated summary.: Schritt 1: Identifizierung fehlender Einheiten. Das Modell muss ein bis drei informative Entitäten aus dem Originalartikel identifizieren, die in den zuvor erstellten Zusammenfassungen nicht vorkommen dürfen. Entitäten werden durch Semikolon getrennt;Abtrennung.Step 2. Write a new, denser summary of identical length which covers every entity and detail from the previous summary plus the missing entities.: Schritt 2: Erstellen Sie eine dichtere Zusammenfassung. Das Modell muss auf der Grundlage der vorherigen Zusammenfassung eine neue Zusammenfassung erstellen, in die die in Schritt 1 ermittelten fehlenden Einheiten aufgenommen werden. Es ist wichtig, dass die neue Zusammenfassung genau die gleiche Länge wie die vorherige Zusammenfassung hat, was das Modell zwingt, die Informationen zu komprimieren und zu verschmelzen, um die neuen Entitäten aufzunehmen.A missing entity is::: Definiert Kriterien für "fehlende Entitäten", um sicherzustellen, dass die ausgewählten Entitäten von hoher Qualität und Relevanz sind:- relevant to the main story: Bezieht sich auf die Hauptgeschichte des Artikels.- specific yet concise (5 words or fewer):: Spezifisch und prägnant, nicht mehr als fünf Wörter.- novel (not in the previous summary): In früheren Zusammenfassungen nicht vorhanden.- faithful (present in the article): Muss in dem Artikel echt sein.- anywhere (can be located anywhere in the article): Kann an einer beliebigen Stelle des Artikels stehen.

Guidelines:Eine Reihe von Leitfäden wird bereitgestellt, um das Modell detaillierter anzuweisen, wie die Aufgabe der Zusammenfassungserstellung auszuführen ist:- The first summary should be long (4-5 sentences, ~80 words) yet highly non-specific...: Leitfaden für die erste ZusammenfassungDie erste Zusammenfassung muss länger (~80 Wörter, 4-5 Sätze), aber weniger informativ sein und soll vor allem die Grundlage für die folgenden Durchgänge bilden. Redundante Formulierungen und Füllwörter können verwendet werden.- Make every word count: rewrite the previous summary to improve flow and make space for additional entities.: Straffung der Sprache:: Betonung der Notwendigkeit, frühere Zusammenfassungen umzuschreiben, um den sprachlichen Ausdruck zu optimieren und Platz für die Aufnahme neuer Einheiten zu schaffen.- Make space with fusion, compression, and removal of uninformative phrases like "the article discusses".: Raumskalierungstechnik:: Explizite Angabe des Einsatzes von Techniken wie Fusion, Komprimierung und Entfernung uninformativer Phrasen zur Komprimierung von Zusammenfassungen.- The summaries should become highly dense and concise yet self-contained, i.e., easily understood without the article.: Zusammenfassung der Qualitätsziele:: Die endgültige Zusammenfassung muss sehr dicht und prägnant, aber gleichzeitig in sich geschlossen sein, d.h. der Inhalt der Zusammenfassung kann verstanden werden, ohne den Originaltext zu lesen.- Missing entities can appear anywhere in the new summary.: physischer Standort:: Neu hinzugefügte Einheiten können überall in der neuen Zusammenfassung erscheinen.- Never drop entities from the previous summary. If space cannot be made, add fewer new entities.: Reservierungen von Entitäten:: Betonen Sie, dass Entitäten aus früheren Zusammenfassungen niemals gelöscht werden sollten. Wenn nicht genügend Platz vorhanden ist, können neue Einheiten sparsam hinzugefügt werden.- Remember, use the exact same number of words for each summary.: einheitlich:: Betonen Sie erneut, dass die Länge der in jeder Runde erstellten Zusammenfassungen einheitlich sein muss.Answer in JSON. The JSON should be a list (length 5) of dictionaries whose keys are "Missing_Entities" and "Denser_Summary".: AusgabeformatJSON: Das Modell muss die Ergebnisse im JSON-Format ausgeben. Das JSON sollte eine Liste von 5 Dictionaries sein, die jeweils die Schlüssel "Missing_Entities" (fehlende Entitäten, die in dieser Runde hinzugefügt wurden) und "Denser_Summary" (dichtere Zusammenfassung, die in dieser Runde erstellt wurde) enthalten.

Abbildung 1:: Hinweise zur verketteten Dichte (CoD) und Beispielausgabe. In jedem Schritt werden 1-3 zusätzliche Details (Entitäten) zu der vorherigen Zusammenfassung hinzugefügt, ohne die Länge zu erhöhen. Bestehende Inhalte werden umgeschrieben (z. B. komprimiert, verschmolzen), um Platz für neue Entitäten zu schaffen. Die Hälfte der Annotatoren (2/4) bevorzugte die vorletzte Zusammenfassung, der Rest die letzte.

Beispiel für die Verwendung von CoD-Stichwörtern in der Praxis:

Nehmen wir an, wir haben einen Nachrichtenartikel über den Besuch von US-Präsident Joe Biden in Polen" und möchten eine Reihe von Zusammenfassungen unterschiedlicher Dichte unter Verwendung von CoD-Stichwörtern erstellen.

Schritt 1: Vorbereitungen für die Eingabe des Artikels

Zunächst müssen wir zum Beispiel den Inhalt des Nachrichtenartikels vorbereiten:

美国总统乔·拜登 неожиданно 抵达波兰进行访问,与波兰总统安杰伊·杜达举行会晤。此次访问正值俄乌冲突一周年之际,预计两国领导人将讨论地区安全、对乌克兰的进一步支持以及加强北约东翼等议题。拜登的访问是对波兰在支持乌克兰难民和向乌克兰提供军事援助方面所做努力的肯定。此外,拜登还计划在华沙就俄乌冲突发表重要讲话,并会见在波兰的美军士兵。

Schritt 2: Erstellen Sie die API-Anfrage (OpenAI API als Beispiel)

Wir werden die OpenAI API (oder eine andere API, die das GPT-4-Modell unterstützt) verwenden, um die Anfrage zu senden. Der Hauptteil der Anfrage enthält unser CoD-Aufforderungswort und die {{ ARTICLE }} Ersetzen Sie ihn durch den Inhalt des vorbereiteten Artikels.

{

"model": "gpt-4",

"prompt": "Article: 美国总统乔·拜登 неожиданно 抵达波兰进行访问,与波兰总统安杰伊·杜达举行会晤。此次访问正值俄乌冲突一周年之际,预计两国领导人将讨论地区安全、对乌克兰的进一步支持以及加强北约东翼等议题。拜登的访问是对波兰在支持乌克兰难民和向乌克兰提供军事援助方面所做努力的肯定。此外,拜登还计划在华沙就俄乌冲突发表重要讲话,并会见在波兰的美军士兵。\nYou will generate increasingly concise, entity-dense summaries of the above article.\n\nRepeat the following 2 steps 5 times.\n\nStep 1. Identify 1-3 informative entities (\";\" delimited) from the article which are missing from the previously generated summary.\nStep 2. Write a new, denser summary of identical length which covers every entity and detail from the previous summary plus the missing entities.\n\nA missing entity is:\n- relevant to the main story, \n- specific yet concise (5 words or fewer), \n- novel (not in the previous summary), \n- faithful (present in the article), \n- anywhere (can be located anywhere in the article).\n\nGuidelines:\n\n- The first summary should be long (4-5 sentences, ~80 words) yet highly non-specific, containing little information beyond the entities marked as missing. Use overly verbose language and fillers (e.g., \"this article discusses\") to reach ~80 words.\n- Make every word count: rewrite the previous summary to improve flow and make space for additional entities.\n- Make space with fusion, compression, and removal of uninformative phrases like \"the article discusses\".\n- The summaries should become highly dense and concise yet self-contained, i.e., easily understood without the article. \n- Missing entities can appear anywhere in the new summary.\n- Never drop entities from the previous summary. If space cannot be made, add fewer new entities. \n\nRemember, use the exact same number of words for each summary.\nAnswer in JSON. The JSON should be a list (length 5) of dictionaries whose keys are \"Missing_Entities\" and \"Denser_Summary\".",

"max_tokens": 1000, // 确保模型有足够的token生成完整JSON输出

"temperature": 0.7// 可调整temperature控制生成结果的随机性

}

Schritt 3: API-Anfrage senden und JSON-Antwort erhalten

Senden Sie die obige JSON-Anfrage an den OpenAI-API-Endpunkt. Die API gibt eine Antwort im JSON-Format zurück, die eine Zusammenfassung der fünf verschiedenen Dichten und der fehlenden Entitäten enthält, die bei jedem Schritt hinzugefügt wurden.

Schritt 4: Parsing der JSON-Antwort und Verwendung des Digests

Analysiert die von der API zurückgegebene JSON-Antwort. Sie erhalten eine JSON-Liste, ähnlich der folgenden:

{

"Missing_Entities": [],

"Denser_Summary": "This article discusses a visit. It is about a president visiting a country. The president is American. The country is Poland. This is related to international relations. The visit is happening during a time of conflict. This conflict involves Russia and Ukraine. The visit aims to show support and discuss important matters. More details will be provided."

},

{

"Missing_Entities": ["Joe Biden"; "Andrzej Duda"],

"Denser_Summary": "U.S. President Joe Biden visited Poland and met with Polish President Andrzej Duda. This visit is about international relations and is happening during the Russia-Ukraine conflict. They will discuss support and security. More details are expected."

},

{

"Missing_Entities": ["one-year anniversary of the Russia-Ukraine conflict"; "regional security"; "support for Ukraine"],

"Denser_Summary": "U.S. President Joe Biden met Polish President Andrzej Duda in Poland on the one-year anniversary of the Russia-Ukraine conflict. They discussed regional security and support for Ukraine, focusing on international relations."

},

{

"Missing_Entities": ["strengthening NATO's eastern flank"; "support for Ukrainian refugees"; "military aid to Ukraine"],

"Denser_Summary": "On the Russia-Ukraine conflict's one-year anniversary, U.S. President Joe Biden visited Poland, meeting President Andrzej Duda to discuss regional security, support for Ukraine (including refugees and military aid), and strengthening NATO's eastern flank."

},

{

"Missing_Entities": ["Warsaw"; "major speech"; "U.S. troops in Poland"],

"Denser_Summary": "To mark the Russia-Ukraine conflict's one-year mark, U.S. President Joe Biden visited Warsaw, Poland, meeting President Andrzej Duda to discuss regional security, Ukrainian refugee and military aid support, strengthening NATO's eastern flank, and Biden's planned major speech and meeting with U.S. troops in Poland."

}

]

Sie können die richtige Dichte der Zusammenfassungen je nach Ihren Bedürfnissen wählen. Wenn Sie zum Beispiel eine sehr kurze Zusammenfassung benötigen, können Sie die erste oder zweite wählen; wenn Sie eine ausführlichere, aber dennoch knappe Zusammenfassung benötigen, können Sie die vierte oder fünfte wählen.

Praktische Anwendungsszenarien:

- Nachrichtenaggregation und Inhaltsempfehlungen: Bereitstellung von Zusammenfassungen in unterschiedlicher Dichte für verschiedene Nutzer oder Plattformen, um unterschiedliche Informationsbedürfnisse zu erfüllen.

- Information Retrieval: Anzeige von Zusammenfassungen in unterschiedlicher Dichte in den Suchergebnissen, um den Nutzern eine schnelle Beurteilung der Relevanz von Artikeln zu ermöglichen.

- Leseverständnishilfe: Hilft dem Leser, den Inhalt des Textes von Anfang bis Ende zu verstehen, indem die Dichte der Zusammenfassungen schrittweise erhöht wird.

- Generierung von Social Media-Inhalten: Generieren Sie Zusammenfassungen unterschiedlicher Länge und Dichte für verschiedene Social Media-Plattformen (z. B. Twitter, Facebook).

Mit den oben genannten Schritten können Sie CoD-Stichwörter in der Praxis effektiv einsetzen, um mit GPT-4 hochwertige Textzusammenfassungen mit hoher Dichte zu erstellen.

3. statistische Daten

3.1 Direkte Statistiken

In Tabelle 1 berechnen wir die Token mithilfe von NLTK, messen die eindeutigen Entitäten mithilfe von Spacy und berechnen die Entitätsdichten als Quotienten Der CoD-Cue folgt weitgehend einem festen Token-Budget. Tatsächlich führt der zweite Schritt zu einer durchschnittlichen Reduktion von 5 Token (von 72 auf 67), da unnötige Wörter aus der ursprünglich langen Zusammenfassung entfernt werden. Die Entitätsdichte stieg - ausgehend von einer anfänglichen Dichte von 0,089, die niedriger war als die der menschlichen und der regulären GPT-4 (0,151 bzw. 0,122) - auf 0,167 nach fünf Verdichtungsschritten.

| CoD-Schritte | Token | Ding, das eine materielle Existenz hat (im Gegensatz zu einer konzeptionellen, virtuellen oder Online-Existenz) | Dichte (E/T) |

|---|---|---|---|

| 1 | 72 | 6.4 | 0.089 |

| 2 | 67 | 8.7 | 0.129 |

| 3 | 67 | 9.9 | 0.148 |

| 4 | 69 | 10.8 | 0.158 |

| 5 | 72 | 12.1 | 0.167 |

| die Menschheit | 60 | 8.8 | 0.151 |

| Allgemein GPT-4 | 70 | 8.5 | 0.122 |

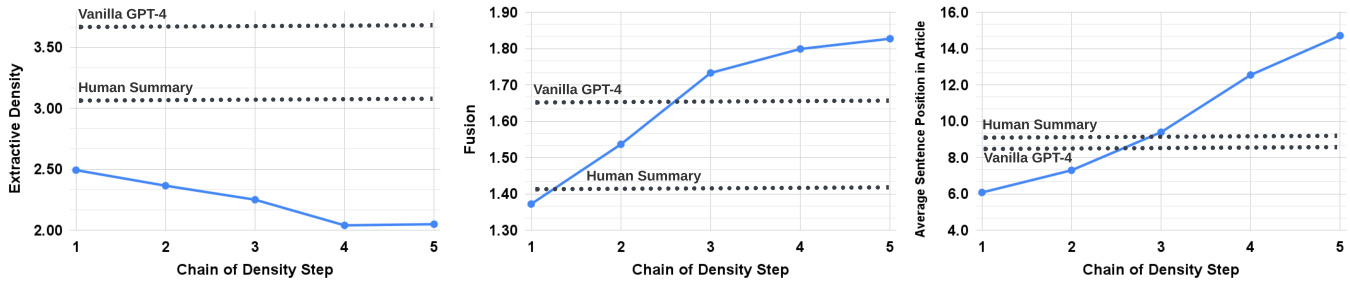

3.2 Indirekte Statistiken

Mit jedem Schritt des CoD sollte die Abstraktion zunehmen, da die Zusammenfassung iterativ umgeschrieben wird, um Platz für jede zusätzliche Entität zu schaffen. Wir messen die Abstraktion anhand der Extraktionsdichte: die durchschnittliche quadrierte Länge der extrahierten Fragmente. In ähnlicher Weise sollte der Grad der Fusion monoton zunehmen, wenn Entitäten zu einem Abstract mit fester Länge hinzugefügt werden. Wir stellen die Fusion als die durchschnittliche Anzahl der Quellensätze dar, die für jeden abstrakten Satz abgeglichen wurden. Für das Alignment verwenden wir die Methode der relativen ROUGE-Verstärkung, die die Ausgangssätze an die Zielsätze anpasst, bis die relative ROUGE-Verstärkung der hinzugefügten Sätze nicht mehr positiv ist. Wir erwarten auch, dass sich die Inhaltsverteilung - die Position im Artikel, aus der die Zusammenfassung stammt - ändert. Insbesondere erwarten wir, dass CoD-Zusammenfassungen anfangs eine starke Verzerrung am Anfang aufweisen (Lead Bias), aber allmählich beginnen, Entitäten aus der Mitte und dem Ende des Artikels einzuführen. Um dies zu messen, verwenden wir das Alignment in der Fusion und messen den durchschnittlichen Satzrang aller alignierten Quellensätze. Abbildung 2 bestätigt diese Hypothesen: Mit zunehmender Umschreibestufe nimmt die Abstraktion zu (linkes Feld), die Fusionsrate steigt (mittleres Feld), und die Abstracts beginnen, Inhalte aus der Mitte und dem Ende des Artikels aufzunehmen (rechtes Feld). Interessanterweise sind alle CoD-Abstracts abstrakter als die handgeschriebenen und die Basis-Abstracts.

Abbildung 2CoD-generierte Zusammenfassungen werden immer abstrakter und weisen gleichzeitig mehr Konvergenz und weniger Anfangsverzerrungen auf.

4. ergebnisse

4.1 Menschliche Präferenzen

Um die Kompromisse, die die CoD-Abstracts darstellen, besser zu verstehen, haben wir eine präferenzbasierte Studie mit einer Bewertung des GPT-4 durchgeführt.

| CoD-Schritte | Prozentualer Anteil der Erstplatzierten (einzelne Kommentatoren) | die Summe zusammenzählen | ||

|---|---|---|---|---|

| 1 | 3.0 2.0 | 13.0 | 17.4 | 8.3 |

| 2 | 25.0 28.0 | 43.0 | 31.4 | 30.8 |

| 3 | 22.0 28.0 21.0 | 24.4 | 23.0 | |

| 4 | 29.0 25.0 13.0 | 26.7 | 22.5 | |

| 5 | 21.0 17.0 10.0 | 16.3 | 15.5 |

Tabelle 1CoD: Zusammenfassung der prozentualen Anteile der Erstplatzierten nach Stufen. Basierend auf den kombinierten Präferenzen hat die CoD-Stufe eine Mehrzahl von 2, einen Median von 3 und einen erwarteten Wert von 3,06.

Erstens berichten wir über einen niedrigen Wert von 0,112 für Fleiss' kappa (Fleiss, 1971), was darauf schließen lässt, dass subtile Unterschiede zwischen Zusammenfassungen und der Art der Aufgabe subjektiv sind. Neuere Studien haben auch eine geringe Übereinstimmung auf Instanzebene bei der Beurteilung von GPT-basierten Zusammenfassungen festgestellt (Goyal et al., 2022).

Auf der Systemebene zeichnen sich jedoch einige Trends ab. Für 3 der 4 Annotatoren erhielt CoD-Schritt 1 den größten Anteil der Erstplatzierten von 100 Beispielen (28%, 43% bzw. 31,4%). Zusammengenommen umfasste die erstplatzierte Zusammenfassung von 61% (23,0+22,5+15,5) jedoch ≥3 Verdichtungsschritte. Der Median der Anzahl der bevorzugten CoD-Schritte lag im mittleren Bereich (3), mit einem gewünschten Schritt von 3,06.

Anhand der durchschnittlichen Dichte der Abstracts aus Schritt 3 können wir grob ableiten, dass die Dichte der bevorzugten Entitäten unter den CoD-Kandidaten etwa 0,15 beträgt. Wie wir aus Tabelle 1 ersehen können, stimmt diese Dichte mit den manuell geschriebenen Abstracts (0,151) überein, ist aber deutlich höher als die Abstracts, die mit dem normalen GPT-4-Prompt erstellt wurden (0,122).

4.2 Automatische Anzeigen

Es hat sich gezeigt, dass der GPT-4 als Evaluator mit der menschlichen Beurteilung übereinstimmt (Fu et al., 2023; Liu et al., 2023a) und bei einigen Annotationsaufgaben sogar besser abschneidet als Crowdsourcer (Gilardi et al., 2023). Ergänzend zu unserer menschlichen Bewertung baten wir die GPT-4, CoD-Zusammenfassungen auf einer Skala von 1 bis 5 in den folgenden Dimensionen zu bewerten: Informationsmenge, Qualität, Kohärenz, Zuordenbarkeit und Gesamtbewertung. Die Definitionen von Informativität, Qualität und Zurechenbarkeit stammen von Aharoni et al. (2023), während die Kohärenz von Fabbri et al. (2021) stammt. Das allgemeine Ziel ist die Erfassung der gemeinsamen Qualität. Siehe Anhang A für die Tipps, die zur Erfassung der Werte für jede Dimension verwendet wurden. Tabelle 3 zeigt, dass die Verdichtung mit der Informativität korreliert ist, aber es gibt eine Grenze, die bei Stufe 4 (4,74) erreicht wird. Die Dimensionen "kein Artikel", "Qualität" und "Kohärenz", nahmen nach Schritt 2 bzw. 1 ab. Alle Zusammenfassungen wurden als dem Ausgangsartikel zurechenbar betrachtet. Die Gesamtpunktzahl war zugunsten dichterer und informativerer Zusammenfassungen verzerrt, wobei die höchste Punktzahl auf Stufe 4 erreicht wurde. Im Durchschnitt wurden der erste und der letzte CoD-Schritt am wenigsten bevorzugt, während die drei mittleren Schritte nahe beieinander lagen (4,78, 4,77 bzw. 4,76).

In Anhang A geben wir die höchste Korrelation der Gesamtmetriken mit der menschlichen Beurteilung auf der Ebene der Zusammenfassungen an (Pearson-Korrelation von 0,31), stellen aber fest, dass die Gesamtkorrelation niedrig bleibt - ein Phänomen, das auch in der Studie von Deutsch et al. (2022) beobachtet wurde, als die Zusammenfassungen von ähnlicher Qualität waren.

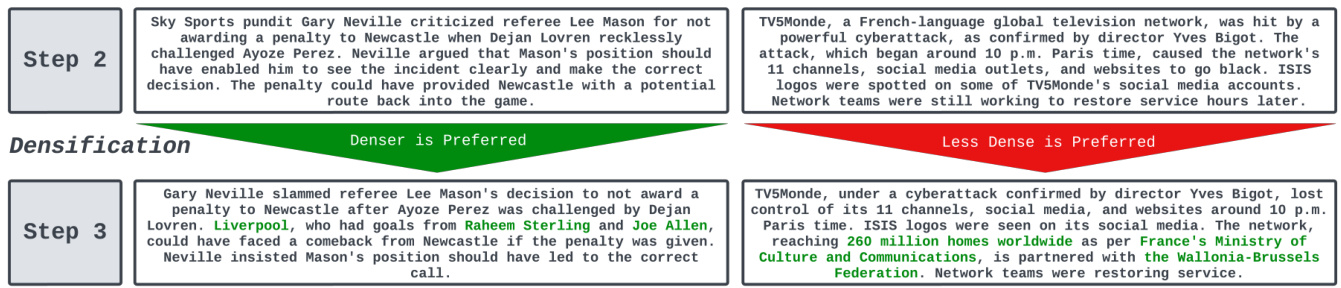

4.3 Qualitative Analyse

Es gibt einen klaren Kompromiss zwischen der Kohärenz/Lesbarkeit von Zusammenfassungen und der Menge an Informationen, die sie enthalten. Um dies zu veranschaulichen, zeigen wir in Abbildung 4 zwei CoD-Schritte: eine Zusammenfassung wird durch mehr Details verbessert, die andere wird beeinträchtigt. Im Durchschnitt erreicht die mittlere CoD-Zusammenfassung dieses Gleichgewicht am besten, aber wir überlassen es der zukünftigen Arbeit, diesen Kompromiss genau zu definieren und zu quantifizieren.

Abbildung 4Beispiele für vom Menschen bevorzugte Verdichtungsschritte (links) und ein Beispiel für nicht bevorzugte Verdichtungsschritte (rechts). Für die linke Seite wird die untere Zusammenfassung bevorzugt, da die Hinzufügung von "Liverpool" und dem Torschützen thematisch relevant ist. Die zweite Zusammenfassung bietet Raum für eine sinnvolle Komprimierung, z. B. die Zusammenfassung von "möglichen Wegen zurück ins Spiel" zu "Gegenangriffen". Auf der rechten Seite kompensiert das Hinzufügen von mehr Details über "TVMonde" nicht die ungeschickte Verschmelzung von Entitäten ("Cyber Attack" und "Yves Bigot"), die eine direkte Folge der Straffung der vorherigen Zusammenfassung war.

5. verwandte Arbeiten

GPT Zusammenfassung

Goyal et al. (2022) verglichen GPT-3 bei der Erstellung von Zusammenfassungen von Nachrichtenartikeln und stellten fest, dass Menschen GPT-3-Zusammenfassungen gegenüber einer früheren überwachten Basislinie bevorzugten, die nicht die vorhandenen referenzbasierten und referenzlosen Metriken widerspiegelte.Zhang et al. (2023) stellten fest, dass durch das Einholen hochwertiger Zusammenfassungen von Freiberuflern Null Stichproben-GPT-3-Zusammenfassungen mit der menschlichen Leistung vergleichbar waren.

Entitätsbasierte Zusammenfassung

Narayan et al. (2021) schlagen vor, Ketten von Entitäten als Planungsschritt für die überwachte Feinabstimmung des Zusammenfassungsmodells zu erzeugen, im Gegensatz zu Schlüsselwörtern (Li et al., 2020; Dou et al., 2021) oder rein extrahierten Einheiten (Dou et al., 2021; Adams et al., 2023a). Entitäten wurden auch als eine Form der Kontrolle in Auszüge integriert (Liu und Chen, 2021; He et al., 2022; Maddela et al., 2022), um die Wiedergabetreue zu erhöhen (Nan et al., 2021; Adams et al., 2022) und als Einheiten zur Bewertung (Cao et al., 2022; Adams et al., 2023b).

6. schlussfolgerung

Wir haben untersucht, wie sich die Verdichtung von Zusammenfassungen auf die Präferenzen der Menschen hinsichtlich der Gesamtqualität auswirkt. Wir fanden heraus, dass ein gewisses Maß an Verdichtung willkommen ist, es jedoch schwierig ist, die Lesbarkeit und Kohärenz aufrechtzuerhalten, wenn Abstracts zu viele Entitäten enthalten. Wir haben die Testmenge mit Annotationen sowie eine größere unannotierte Trainingsmenge zur Verfügung gestellt, um das Thema der Abstracts mit fester Länge und variabler Dichte weiter zu untersuchen.

7. beschränkungen

Wir haben die CoDs nur für einen einzigen Bereich analysiert, nämlich für Nachrichtenzusammenfassungen. Die Annotationen zeigen keine Konsistenz auf der hohen Ebene der Zusammenfassungen, aber sie beginnen, Trends auf Systemebene zu zeigen, was mit früheren Arbeiten zu LLM-basierten Bewertungen übereinstimmt (Goyal et al., 2022). Schließlich ist das GPT-4 ein Closed-Source-Modell, so dass wir die Modellgewichte nicht weitergeben konnten. Allerdings haben wir alle Bewertungsdaten, Anmerkungen und 5.000 unkommentierte CoDs für nachgelagerte Anwendungsfälle freigegeben, z. B. für die Extraktion von Dichten in Open-Source-Modelle wie LLAMA-2 (Touvron et al., 2023).

bibliographie

(Liste der Referenzen entfällt hier)

GPT-4-Indikatoren

Für die Bewertung des GPT-4 im Likert-Stil verwenden wir die folgende Aufforderungsvorlage.

摘要: {{摘要}} {{定义}}

Im Folgenden finden Sie Beispiele für die Definitionen der einzelnen Qualitätsindikatoren.

- Informationsmenge:: Informative Zusammenfassungen fassen wichtige Informationen aus dem Artikel zusammen und präsentieren sie in präziser und prägnanter Form.

- Masse (in der Physik):: Hochwertige Zusammenfassungen sind leicht verständlich und nachvollziehbar.

- KonsistenzKohärente Zusammenfassungen sind gut strukturiert und organisiert.

- zurechenbarSind alle Informationen in der Zusammenfassung vollständig dem Artikel zuzuordnen?

- GesamtpräferenzEine gute Zusammenfassung sollte die Hauptgedanken des Artikels in knapper, logischer und kohärenter Form wiedergeben.

Zu den Qualitäts- und Kohärenzmerkmalen gehören keine Merkmale in Artikeln. Diese Definitionen wurden aus früheren Arbeiten zur Annotation von Zusammenfassungen übernommen: (Fabbri et al., 2021; Aharoni et al., 2023).

| Dimension (math.) | Relevanz |

|---|---|

| Informationsmenge | 0.215 |

| Masse (in der Physik) | 0.120 |

| Konsistenz | 0.178 |

| zurechenbar | 0.245 |

| Regenschirm | 0.311 |

Tabelle 2Zusammenfassung der Pearson-Korrelationskoeffizienten zwischen menschlichen Präferenzen und GPT-4 Likert-Bewertungen.

Meta-Evaluierung

Um die Korrelationen auf der Ebene der Zusammenfassungen zu berechnen, haben wir zunächst die Präferenzdaten in einen Vektor umgewandelt, der angibt, wie oft diese Zusammenfassung eine Erstplatzierung erhalten hat. Tabelle 4 zeigt, dass - wenig überraschend - die Stichwörter, die zur Erfassung der Gesamtbewertung der Zusammenfassung entwickelt wurden, die höchste Pearson-Korrelation auf Gesamtebene mit den Gesamtpräferenzen aufweisen (0,31), aber die Gesamtkorrelation bleibt niedrig.

Zusammenfassungen

In diesem Beitrag wird untersucht, wie GPT-4 zur Erstellung immer dichterer Zusammenfassungen durch die Chained Density Cueing (CoD)-Methode verwendet werden kann. Es wird festgestellt, dass ein gewisses Maß an Verdichtung die Qualität von Zusammenfassungen verbessern kann, dass aber zu viel Dichte die Lesbarkeit und Kohärenz beeinträchtigen kann. Das Forschungsteam validierte diese Erkenntnis durch menschliche Präferenzstudien und automatische GPT-4-Bewertung und stellte die zugehörigen kommentierten und unkommentierten Zusammenfassungsdaten als Open-Source zur Verfügung, was eine wertvolle Ressource für künftige Forschung darstellt.

Zusammenfassung der wichtigsten Punkte:

- Verkettete Dichtemerkmale (CoD)Generierung dichterer Zusammenfassungen durch schrittweises Hinzufügen fehlender Entitäten, ohne die Länge zu erhöhen.

- physikalische DichteDie Verwendung der Entitätsdichte als Maß für die Informativität von Zusammenfassungen ergab, dass die menschlichen Präferenzen sich der Dichte von manuell geschriebenen Zusammenfassungen annähern.

- Abstraktheit und IntegrationCoD erzeugt Abstracts, die abstrakter und konvergenter sind und weniger einseitig sind.

- menschliche VorliebeMenschen bevorzugen dichtere als normale GPT-4-Zusammenfassungen, aber eine zu hohe Dichte verringert die Lesbarkeit.

- Automatisierte BewertungDie Ergebnisse der automatischen Bewertung des GPT-4 stimmten im Allgemeinen mit den menschlichen Präferenzen überein, aber die Gesamtkorrelation war gering.

Zukünftige Forschungsrichtungen:

- Eine genauere Definition von KompromissenKünftige Forschungsarbeiten könnten den Zielkonflikt zwischen Informationsgehalt und Lesbarkeit genauer definieren und quantifizieren.

- Multidisziplinäre Anwendungen:: Anwendung der CoD-Methode auf andere Bereiche, wie z. B. wissenschaftliche Arbeiten, technische Dokumentation usw., um ihre Verallgemeinerbarkeit zu prüfen.

- Verbesserungen der Modellierung:: Untersuchen Sie, wie die Modellierung verbessert werden kann, um die Lesbarkeit zu erhöhen und gleichzeitig ein hohes Maß an Informationen zu erhalten.

Anhand dieses Papiers können wir sehen, dass die KI beeindruckende Fortschritte bei der Textverarbeitung und -generierung gemacht hat, aber immer noch vor der Herausforderung steht, Informationsgehalt und Lesbarkeit in Einklang zu bringen. In Zukunft, wenn die Technologie weiter voranschreitet, haben wir Grund zu der Annahme, dass KI-generierte Zusammenfassungen noch intelligenter und benutzerfreundlicher sein werden.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...