Claude 3.7 Sonnet und Claude Code: Spitzentechnisches Denken trifft auf Agentic Coding

Anthropisch Das Unternehmen veröffentlichte heute Claude 3.7 Sonnet ^1^ , das nicht nur das bisher intelligenteste Modell von Anthropic ist, sondern auch das erste hybride Denkmodell auf dem Markt. claude 3.7 Sonnet bietet sowohl nahezu sofortige Antworten als auch tiefergehendes, schrittweises Denken, wobei der Denkprozess dem Benutzer zur Verfügung steht. der API-Benutzer hat auch eine feinkörnige Kontrolle darüber, worüber das Modell nachdenkt. Länge der Zeit.

Claude 3.7 Sonnet zeigt besonders deutliche Verbesserungen bei der Kodierung und der Front-End-Webentwicklung. Das Modell wird von Claude Code begleitet, einem Kommandozeilen-Tool für die agentenbasierte Codierung, das derzeit in einer begrenzten Forschungsvorschau verfügbar ist und es Entwicklern ermöglicht, eine breite Palette von technischen Aufgaben direkt vom Terminal aus an Claude zu delegieren.

Claude 3.7 Sonnet wird jetzt von allen Claude-Tarifen (einschließlich Free, Pro, Team und Enterprise) sowie von Anthropic API, Amazon Bedrock und Google Cloud Vertex AI unterstützt. Der erweiterte Denkmodus ist auf allen Plattformen außer der kostenlosen Version von Claude verfügbar. Der erweiterte Denkmodus ist auf allen Plattformen außer der kostenlosen Version von Claude verfügbar.

Die Preise für Claude 3.7 Sonnet bleiben sowohl im Standard- als auch im erweiterten Denkmodus gleich wie bei seinem Vorgänger: pro Million Eingaben Token 3 pro Million Output-Token und 15 $ pro Million Output-Token - einschließlich Denk-Token.

Claude 3.7 Sonnet: Spitzentechnische Überlegungen in der Praxis

Anthropic hat Claude 3.7 Sonnet mit einer anderen Philosophie als andere Denkmodelle entwickelt. So wie der Mensch dasselbe Gehirn benutzt, um schnell zu reagieren und tiefgründig zu denken, ist Anthropic der Ansicht, dass logisches Denken eine inhärent integrierte Fähigkeit eines hochmodernen Modells sein sollte und nicht ein völlig separates Modell. Dieser einheitliche Ansatz schafft auch eine reibungslosere Erfahrung für die Benutzer.

Claude 3.7 Sonnet verkörpert diese Idee in mehrfacher Hinsicht. Erstens kombiniert Claude 3.7 Sonnet ein normales LLM mit einem Inferenzmodell: Der Benutzer kann wählen, wann das Modell im Standardmodus schnell antwortet und wann es länger nachdenkt, bevor es antwortet. Im Standardmodus ist Claude 3.7 Sonnet eine verbesserte Version von Claude 3.5 Sonnet. Im Modus "Erweitertes Denken" denkt das Modell über sich selbst nach, bevor es antwortet, und verbessert so seine Leistung in Mathematik, Physik, Befehlsverfolgung, Codierung und vielen anderen Aufgaben.Anthropic fand heraus, dass das Modell in beiden Modi in etwa auf die gleiche Weise aufgefordert wird.

Zweitens hat der Nutzer bei der Verwendung von Claude 3.7 Sonnet über die API auch die Kontrolle darüber, wie er die HaushaltDer Benutzer kann Claude anweisen, an bis zu N Token zu denken, und der Wert von N kann auf eine Ausgabegrenze von bis zu 128K Token gesetzt werden. Dies gibt dem Benutzer die Flexibilität, je nach Bedarf Geschwindigkeit (und Kosten) gegen die Qualität der Antwort abzuwägen.

Drittens hat Anthropic während der Entwicklung des Inferenzmodells den Fokus auf mathematische und computerwissenschaftliche Wettbewerbsthemen in Richtung Optimierung leicht reduziert und sich stattdessen mehr auf reale Anwendungsszenarien konzentriert, um besser widerzuspiegeln, wie Geschäftsanwender LLM tatsächlich nutzen.

Erste Tests haben gezeigt, dass Claude in allen Aspekten der Codierung führend ist: Cursor stellt fest, dass Claude erneut führend bei realen Codierungsaufgaben ist, mit signifikanten Verbesserungen in Bereichen, die von der Arbeit mit komplexen Codebasen bis hin zu fortgeschrittenem Tooling reichen, und Cognition stellt fest, dass Claude jedes andere Modell übertrifft, wenn es um die Planung von Codeänderungen und die Handhabung von Full-Stack-Updates geht. Vercel hebt die überragende Genauigkeit von Claude bei komplexen Agenten-Workflows hervor, während die Replit Nachdem Claude erfolgreich eingesetzt wurde, um komplexe Webanwendungen und Dashboards von Grund auf neu zu erstellen, was mit anderen Modellen nur schwer möglich ist, zeigte die Evaluierung von Canva, dass Claude durchweg produktionsreifen Code produziert, der nicht nur besser gestaltet ist, sondern auch die Anzahl der Fehler drastisch reduziert.

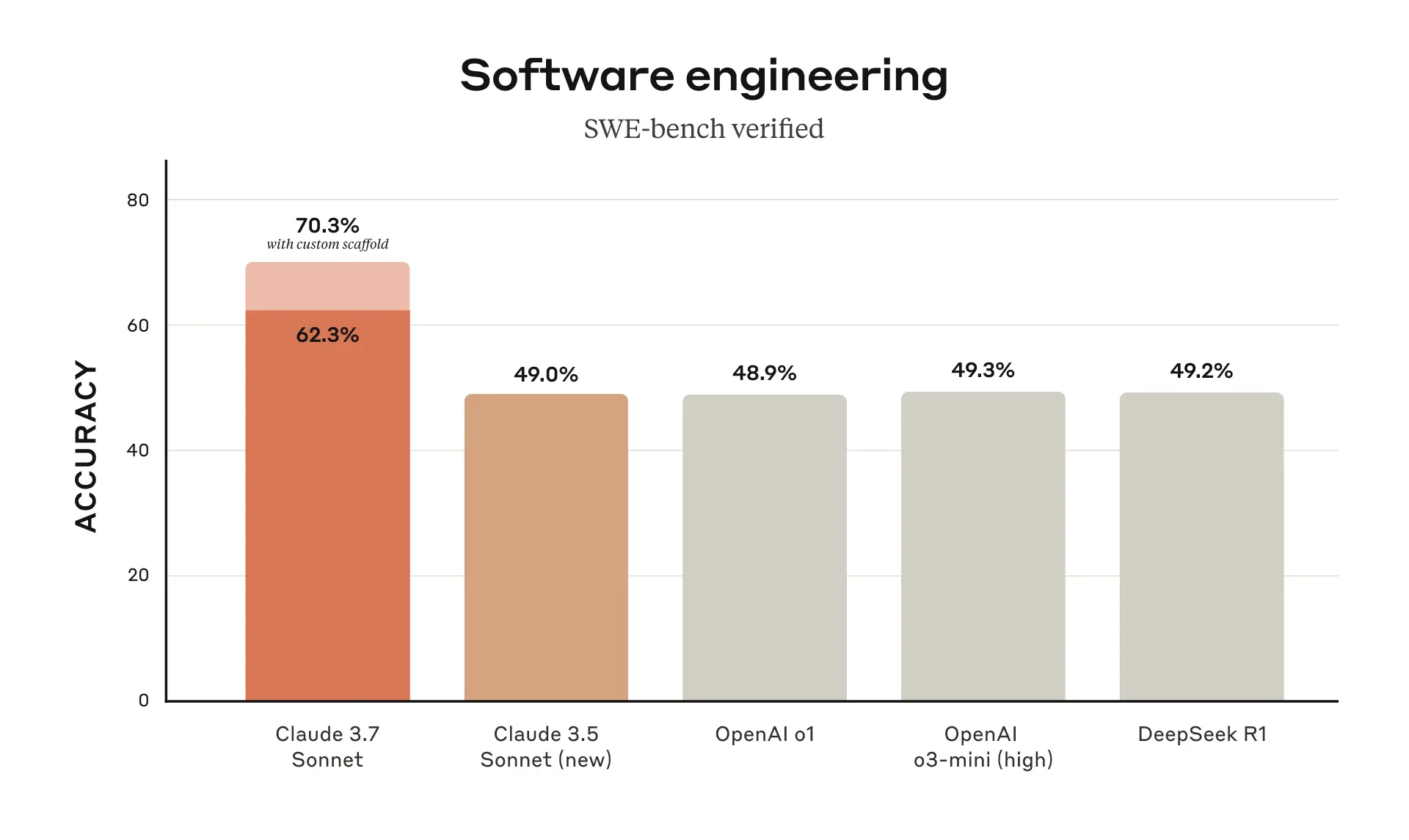

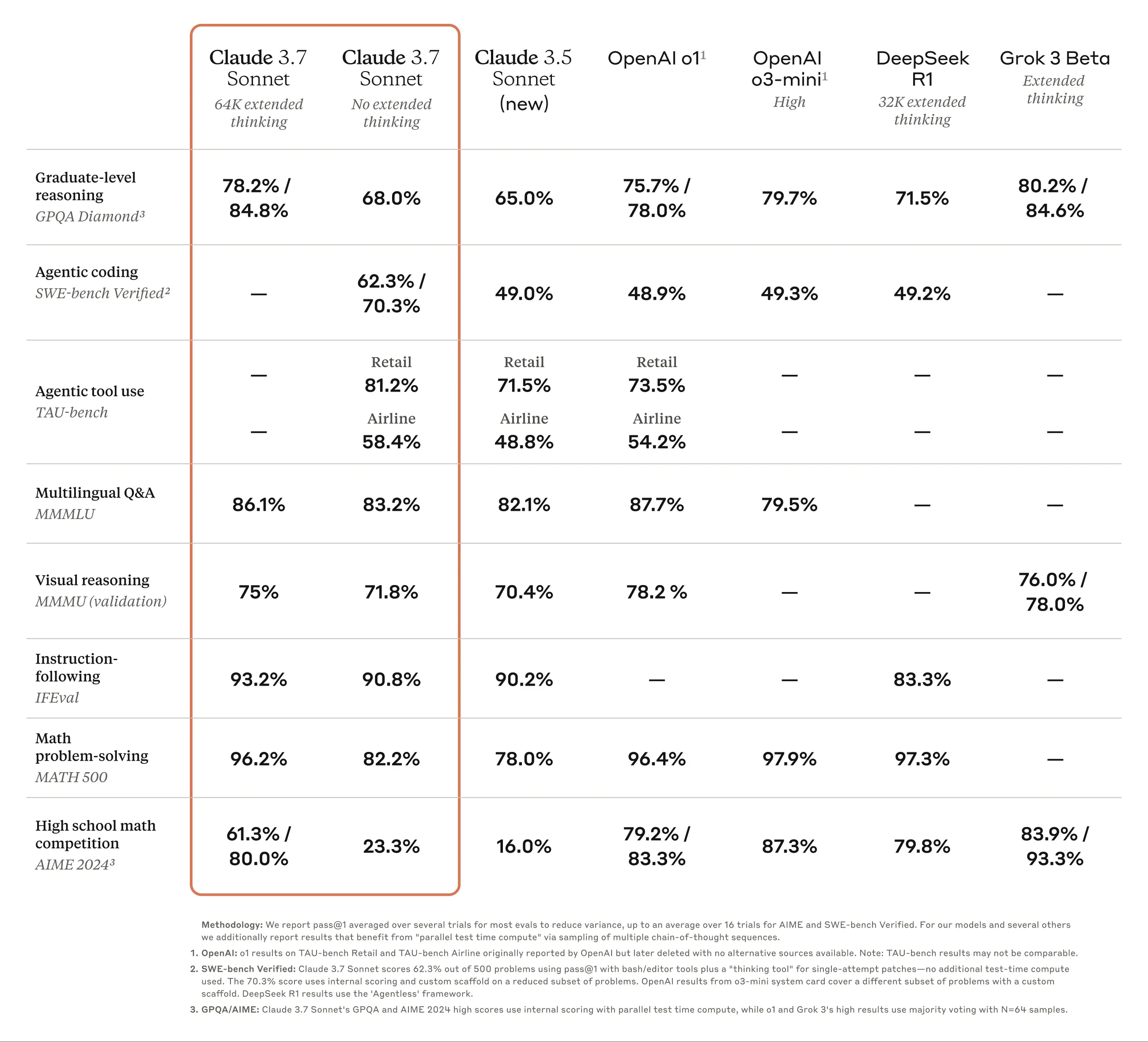

Claude 3.7 Sonnet erzielte die beste Leistung im SWE-Bench Verified, einem Benchmark, der die Fähigkeit von KI-Modellen misst, reale Softwareprobleme zu lösen. Weitere Informationen zum Scaffolding finden Sie im Anhang.

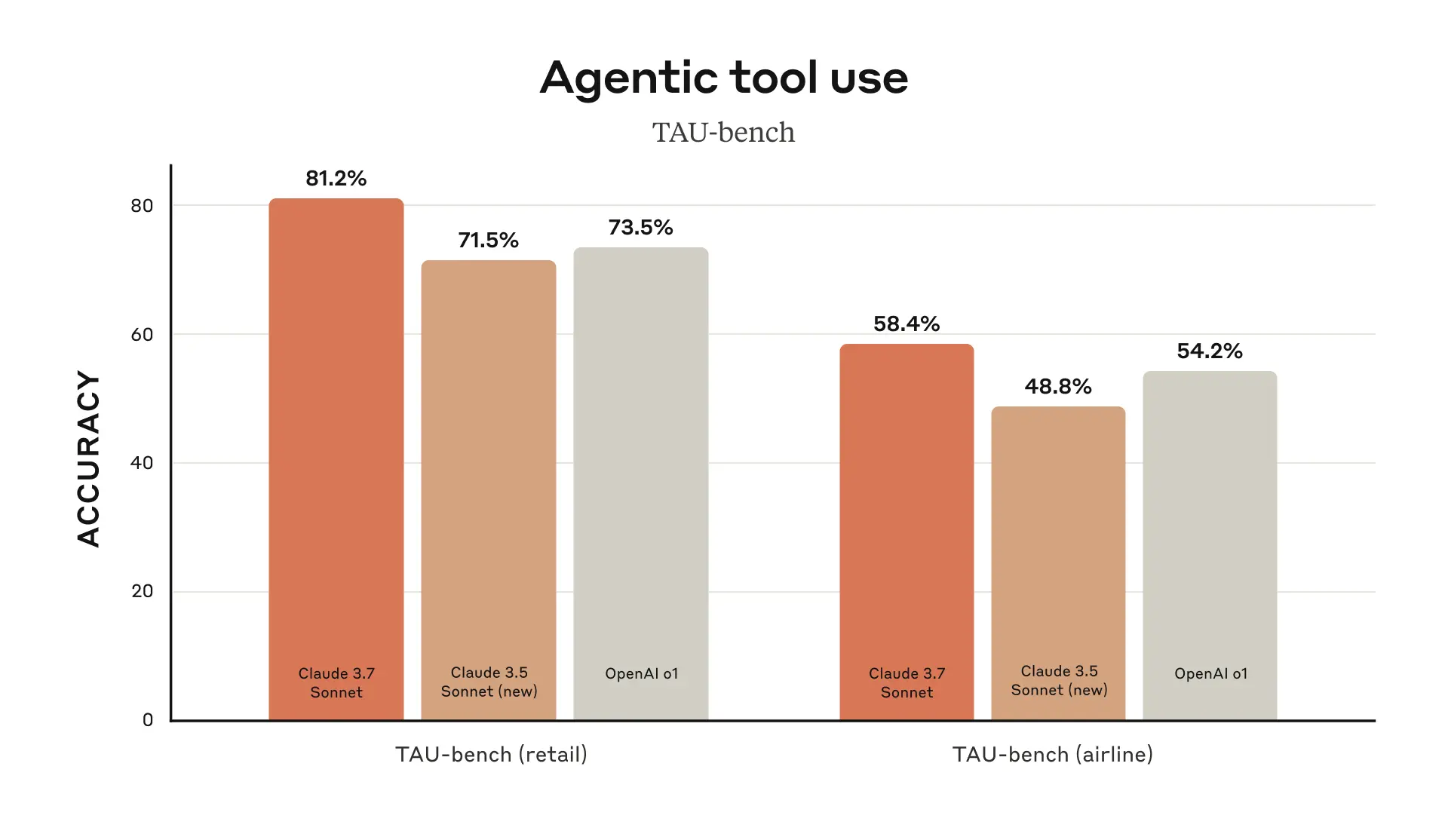

Claude 3.7 Sonnet erzielte die beste Leistung auf dem TAU-bench, einem Rahmenwerk zum Testen der Leistung von KI-Agenten bei komplexen realen Aufgaben mit Benutzer- und Werkzeuginteraktionen. Weitere Informationen zum Scaffolding finden Sie im Anhang.

Claude 3.7 Sonnet zeichnet sich durch die Befolgung von Anweisungen, allgemeines logisches Denken, multimodale Fähigkeiten und agentenbasiertes Kodieren aus, und der erweiterte Denkmodus verbessert seine Leistung in Mathematik und Naturwissenschaften erheblich. Zusätzlich zu den traditionellen Benchmarks übertrifft Claude 3.7 Sonnet sogar alle vorherigen Modelle in Pokémon-Spiel-Tests.

Claude Code: ein neuer Assistent für Entwickler

Seit Juni 2024 ist Sonnet das Modell der Wahl für Entwickler weltweit. Jetzt ist Anthropic in einer begrenzten Forschungsvorschauversion verfügbar Claude Code -- Anthropics erstes agentenbasiertes Kodierungswerkzeug, das Entwicklern mehr Möglichkeiten bietet.

Claude Code ist ein aktiver Kollaborateur, der Code sucht und liest, Dateien bearbeitet, Tests schreibt und ausführt, Code festschreibt und auf GitHub überträgt und Befehlszeilentools verwendet - und die Benutzer bei jedem Schritt auf dem Laufenden hält.

Claude Code befindet sich noch in der Anfangsphase, hat sich jedoch zu einem unverzichtbaren Werkzeug für das Anthropic-Team entwickelt, insbesondere für die testgetriebene Entwicklung, die Fehlersuche bei komplexen Problemen und das Refactoring in großem Maßstab. In ersten Tests konnte Claude Code Aufgaben in einem einzigen Arbeitsgang erledigen, für die man normalerweise mehr als 45 Minuten bräuchte, was die Entwicklungszeit und die Verwaltungskosten erheblich reduziert.

In den kommenden Wochen plant Anthropic kontinuierliche Verbesserungen, die auf der Nutzung durch die Nutzer basieren. Dazu gehören die Verbesserung der Zuverlässigkeit von Toolaufrufen, die Unterstützung von langlaufenden Befehlen, die Verbesserung des In-App-Renderings und die Verbesserung des Verständnisses der Fähigkeiten von Claude selbst.

Mit der Einführung von Claude Code möchte Anthropic besser verstehen, wie Entwickler mit Claude programmieren, um das Modell in Zukunft zu verbessern. Durch die Teilnahme an dieser Vorschau erhalten die Nutzer Zugang zu denselben leistungsstarken Werkzeugen, die Anthropic zur Entwicklung und Verbesserung von Claude einsetzt, und das Feedback der Nutzer wird die künftige Entwicklung direkt beeinflussen.

Zusammenarbeit mit Claude an der Codebasis

Anthropic hat auch die Coding-Erfahrung auf Claude.ai verbessert. Die GitHub-Integration von Anthropic ist jetzt für alle Claude-Pläne verfügbar und ermöglicht es Entwicklern, ihre Code-Repositories direkt mit Claude zu verbinden.

Claude 3.7 Sonnet ist das bisher beste Codierungsmodell von Anthropic. Mit einem tieferen Verständnis der persönlichen, beruflichen und Open-Source-Projekte der Nutzer wird es zu einem noch stärkeren Partner bei der Behebung von Fehlern, der Entwicklung neuer Funktionen und der Erstellung von Dokumentation für die wichtigsten GitHub-Projekte.

Verantwortungsvolle Konstruktion

Anthropic hat Claude 3.7 Sonnet ausgiebig getestet und bewertet und mit externen Experten zusammengearbeitet, um sicherzustellen, dass es die Anthropic-Standards für Sicherheit, Zuverlässigkeit und Schutz erfüllt. Claude 3.7 Sonnet unterscheidet außerdem differenzierter zwischen schädlichen und gutartigen Anfragen als sein Vorgänger und weist 45% weniger unnötige Anfragen zurück.

Diese Version der Systemkarte deckt die neuesten Sicherheitserkenntnisse in mehreren Kategorien ab und erläutert die Bewertung der verantwortungsvollen Erweiterungspolitik von Anthropic, die andere KI-Labors und Forscher auf ihre eigene Arbeit anwenden können. Die Systemkarte befasst sich auch mit neu aufkommenden Risiken bei der Computernutzung, insbesondere mit Prompt-Injection-Angriffen, und erklärt, wie Anthropic diese Schwachstellen bewertet und Claude darin schult, ihnen zu widerstehen und sie zu entschärfen. Darüber hinaus untersucht die Systemkarte die potenziellen Sicherheitsvorteile, die Inferenzmodelle mit sich bringen können: die Möglichkeit zu verstehen, wie Modelle Entscheidungen treffen, und ob Modellinferenzen wirklich vertrauenswürdig und zuverlässig sind. Lesen Sie die vollständige Systemkarte für weitere Informationen.

vorausschauend

Die Veröffentlichung von Claude 3.7 Sonnet und Claude Code markiert einen wichtigen Schritt in Richtung wirklich leistungsfähiger KI-Systeme. Mit ihrer Fähigkeit, tiefgründig zu denken, autonom zu arbeiten und effektiv zusammenzuarbeiten, führen sie uns in eine Zukunft, in der KI die menschliche Leistung bereichern und erweitern kann.

Anthropic freut sich darauf, dass die Benutzer diese neuen Funktionen erkunden und ist gespannt darauf, was die Benutzer kreieren werden. Anthropic freut sich immer über [Feedback] (mailto: feedback@anthropic.com) von den Benutzern, damit Anthropic die Modelle von Anthropic weiter verbessern und entwickeln kann.

anhang

^1 ^ Lektionen zur Namensgebung.

Bewertung der Datenquellen

TAU-Bank

Informationen zum Gerüstbau

Diese Ergebnisse wurden durch Hinzufügen eines Anhangs zu den Richtlinien für Fluglinienagenten erzielt, in dem Claude angewiesen wurde, das "Planungs"-Tool besser zu nutzen. In diesem Modus ermutigt Anthropic das Modell, seinen Denkprozess während mehrerer Interaktionsrunden bei der Problemlösung aufzuschreiben, um seine Argumentationsfähigkeiten voll auszuschöpfen, was eine Abweichung vom üblichen Denkmodus von Anthropic darstellt. Um den zusätzlichen Token-Verbrauch von Claude aufgrund der Verwendung von mehr Denkschritten zu berücksichtigen, erhöhte Anthropic die maximale Anzahl der Schritte (in Bezug auf Modellabschlüsse) von 30 auf 100 (die meisten Interaktionen wurden innerhalb von 30 Schritten abgeschlossen, und nur eine Interaktion überschritt 50 Schritte).

Darüber hinaus unterscheiden sich die TAU-Bench-Ergebnisse für Claude 3.5 Sonnet (neu) von denen, die Anthropic zum Zeitpunkt der ursprünglichen Veröffentlichung gemeldet hat, da der Datensatz seither geringfügig verbessert wurde. Anthropic hat den Test mit dem aktualisierten Datensatz erneut durchgeführt, um ihn genauer mit Claude 3.7 Sonnet vergleichen zu können. um einen genaueren Vergleich mit Claude 3.7 Sonnet zu ermöglichen.

SWE-Bank Geprüft

Informationen zum Gerüstbau

Es gibt viele Ansätze zur Lösung offener agentenbasierter Aufgaben wie SWE-bench. Einige Ansätze verlagern einen Großteil der Komplexität (z. B. die Entscheidung, welche Dateien zu untersuchen oder zu bearbeiten sind und welche Tests auszuführen sind) auf herkömmlichere Software und überlassen es nur dem Kern-Sprachmodell, Code an vordefinierten Stellen zu generieren oder aus einem begrenzten Satz von Operationen auszuwählen.Agentless (Xia et al., 2024) ist ein Ansatz zur Tiefensuche R1 Dieses weit verbreitete Gerüst, das häufig bei der Bewertung von Aide und anderen Modellen verwendet wird, erweitert die Fähigkeiten des Agenten durch Prompt- und Embedding-Mechanismen zur Dokumentensuche, Patch-Lokalisierung und Best-of-40-Rejection-Sampling für Regressionstests. Andere Gerüste (z. B. Aide) erweitern das Modell durch zusätzliche Berechnungen zur Testzeit in Form von Wiederholungen, Best-of-N oder Monte Carlo Tree Search (MCTS).

Für Claude 3.7 Sonnet und Claude 3.5 Sonnet (neu) verwendet Anthropic einen einfacheren Ansatz mit minimalem Gerüst. Bei diesem Ansatz entscheidet das Modell, welche Befehle es ausführt und welche Dateien es in einer einzigen Sitzung bearbeitet.Anthropic's wichtigstes "no extended thinking" pass@1 Ergebnis ist einfach, das Modell mit zwei der hier beschriebenen Werkzeuge auszustatten - dem - dem bash-Dienstprogramm und einem Dateibearbeitungswerkzeug, das über Stringsubstitution arbeitet - sowie dem "Planungswerkzeug", das Anthropic in den TAU-bench-Ergebnissen erwähnt. Aufgrund infrastruktureller Einschränkungen konnten nur 489/500 Probleme tatsächlich auf der hauseigenen Infrastruktur von Anthropic gelöst werden (d. h. die Gold-Lösung hat den Test bestanden). Für die Vanilla-Pass@1-Bewertung zählte Anthropic 11 unlösbare Probleme als Fehlschläge, um sie mit der offiziellen Rangliste in Einklang zu bringen. Aus Gründen der Transparenz hat Anthropic die Testfälle, die auf der Infrastruktur von Anthropic nicht funktionierten, separat veröffentlicht.

Für die "rechenintensiven" Zahlen verwendet Anthropic zusätzliche Komplexität und parallele Testzeitberechnungen, wie unten dargestellt:

- Anthropische Proben mehrere parallele Versuche unter Verwendung des oben genannten Gerüsts

- Anthropic verwirft Patches, die die sichtbaren Regressionstests im Repository beschädigen, ähnlich wie die Ablehnungsstichprobenmethode, die von Agentless verwendet wird; beachten Sie, dass Anthropic keine versteckten Testinformationen verwendet.

- Anthropic bewertete dann die verbleibenden Versuche anhand eines Bewertungsmodells, das den in dem Forschungsartikel beschriebenen GPQA- und AIME-Ergebnissen von Anthropic ähnelt, und wählte die besten Versuche für die Einreichung aus.

Dies führt zu einer Punktzahl von 70,3% auf der Teilmenge von n=489 verifizierten Aufgaben, die auf der Infrastruktur von Anthropic funktionieren. Ohne dieses Gerüst erreichte Claude 3.7 Sonnet eine Punktzahl von 63,7% auf der SWE-Bench Verified mit der gleichen Teilmenge. Die 11 Testfälle, mit denen die interne Infrastruktur von Anthropic nicht kompatibel ist, sind unten aufgeführt:

- scikit-learn__scikit-learn-14710

- django__django-10097

- psf__anfragen-2317

- sphinx-doc__sphinx-10435

- sphinx-doc__sphinx-7985

- sphinx-doc__sphinx-8475

- matplotlib__matplotlib-20488

- astropy__astropy-8707

- astropy__astropy-8872

- sphinx-doc__sphinx-8595

- sphinx-doc__sphinx-9711

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...